GTC Nvidia の待望の Hopper H100 アクセラレーターは、OEM 製の HGX システムで来月後半に出荷を開始する予定であると、シリコンの巨人は本日の GPU テクノロジ カンファレンス (GTC) イベントで述べました。

ただし、Nvidia の DGX H100 システムを手に入れるのを待っている人は、来年の第 1 四半期まで待たなければなりません。 DGX は GPU と相互接続を使用する Nvidia のワークステーションとサーバーのラインであり、HGX システムは Nv の技術を使用するパートナー製のサーバーです。

また、Nvidia がデータセンターでのホッパー アーキテクチャを宣伝している一方で、今週発表されたエンタープライズ キットのほとんどは、チップ大手の主力アーキテクチャをすぐに取得することはありません。

エッジでは、Nvidia はその Ampere アーキテクチャから完全な寿命を引き出すことに満足しているようです。

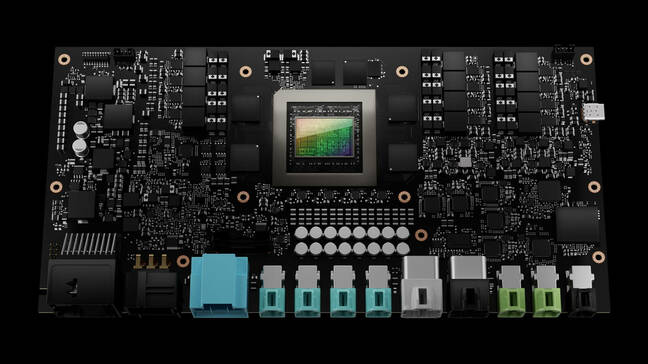

今日、Nvidia は、IGX と呼ばれる次世代のエッジ AI およびロボティクス プラットフォームについて詳しく説明しました。

IGX は、「リアルタイム インテリジェント マシンと医療機器の展開を加速するオールインワン コンピューティング プラットフォーム」であると、Nvidia の医療担当 Veep である Kimberly Powell 氏は述べています。 このシステムは本質的に、Nvidia が以前に発表した Jetson AGX Orin モジュールの拡張バージョンであり、これを発表しました。 春.

「IGX は、Nvidia Orin ロボティクス プロセッサ、Ampere tensor-core GPU、ConnectX ストリーミング I/O プロセッサ、機能安全アイランド、および安全マイクロコントローラ ユニットを備えた完全なシステムです。より多くのロボットと人間が同じ環境で作業するようになるためです。 、" 彼女は付け加えた。

パフォーマンスに関しては、ここにはあまり目新しいものはありません。 このプラットフォームは、今年初めに発売された AGX Orin モジュールに匹敵する 64 GB のメモリを搭載したモジュール上の Orin 産業用システムに基づいていると言われています。 そのシステムは、32GB のメモリ、オクタコア Arm Cortex A78AE CPU、および Ampere ベースの GPU を備えていました。

IGX は、7 つの 200Gbps インターフェイスによる高速接続用の統合 ConnectX-2 NIC を獲得します。 このボードは、M.XNUMX ストレージ、PCIe スロット、および拡張用の少なくとも XNUMX つのレガシー PCI スロットを完全に補完しているようにも見えます。

Nvidia は、IGX プラットフォームを、ヘルスケア、製造、ロジスティクスにおけるさまざまなエッジ AI およびロボティクスのユースケースに向けて目指しています。これらのユースケースでは、機密性や遅延により、より集中化されたシステムが実用的ではなくなります。

AGX Orin と同様に、このシステムは Nvidia の AI Enterprise ソフトウェア スイートと配備および管理用の Fleet Command プラットフォームによって補完されます。

IGX プラットフォームの最初のアプリケーションの XNUMX つは、Nvidia のロボティクス イメージング プラットフォームを使用することです。

「Nvidia Clara Holoscan は、医療機器や画像ロボティクス パイプライン用の IGX の上にある当社のアプリケーション フレームワークです」と Powell 氏は説明します。

医療機器ベンダー XNUMX 社 (Activ Surgical、Moon Surgical、Proximinie) は、IGX と Clara Holoscan を使用して、手術ロボットとテレプレゼンス プラットフォームを強化する予定です。 IGX Orin 開発者キットは、ADLink、Advantech、Dedicated Computing、Kontron、MBX、Onyx などから入手可能なプロダクション システムと共に来年初めに出荷される予定です。

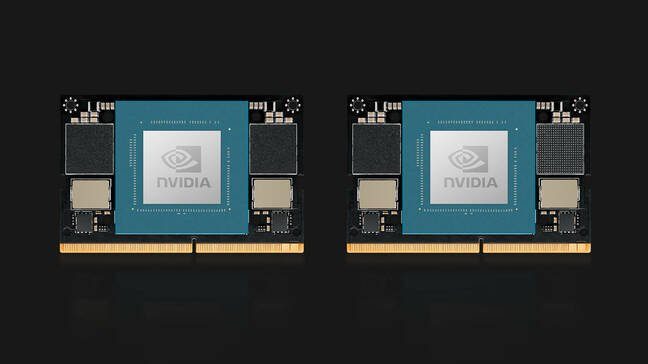

Orin のトピックでは、Nvidia は Jetson Orin Nano コンピューティング モジュールも発表しました。 Orin Nano は、8 TOPS の AI 推論が可能な 40GB バージョンと、4 TOPS が可能な 20GB のメモリを備えたカットダウン バージョンの XNUMX つの構成で、発売時に利用できます。

以前の Jetson モジュールと同様に、Orin Nano は、ラップトップの SODIMM メモリに使用されるものを連想させるピン互換のエッジ コネクタを使用し、アプリケーションと SKU に応じて 5W から 15W を消費します。 Nvidia の Jetson Orin Nano モジュールは、199 月に XNUMX ドルから入手できます。

OVX の更新

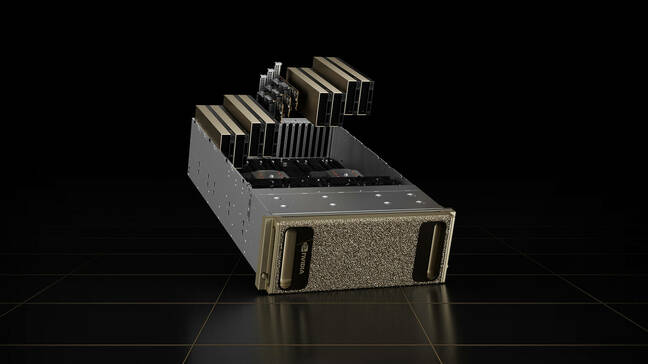

Omniverse プラットフォームを実行するように設計された Nvidia の OVX サーバーも、Hopper 上では実行されません。

同社の第 40 世代のビジュアライゼーションおよびデジタル ツイン システムには、代わりに XNUMX つの LXNUMX GPU が搭載されています。 カードは、同社の次世代 Ada Lovelace アーキテクチャに基づいており、Nvidia の第 XNUMX 世代レイ トレーシング コアと第 XNUMX 世代 Tensor コアを備えています。

GPU には、最大 8362 GHz で合計 128 のプロセッサ スレッドのために、Ice Lake Intel Xeon Platinum 3.6 CPU のペアが付属しています。

コンピューティング システムには、それぞれ 7 Gbps のスループットと 400 TB の NVMe ストレージに対応する 16 つの ConnectX-32 NIC が付属しています。 システムは個々のノードとして利用可能ですが、Nvidia は、同社の 51.2Tbps Spectrum-3 スイッチを使用して接続された XNUMX のシステムを組み込んだ OVX SuperPod と呼ばれるものの一部として展開されるシステムを想定しています。

第 2023 世代システムは、XNUMX 年から Lenovo、Supermicro、および Inspur から入手可能になります。将来、Nvidia は、システムの可用性を他のパートナーに拡大する予定です。

ドライブトールに飛び乗った

今週の GTC で発表された、Nvidia のホッパー アーキテクチャを利用する唯一のキットは、Drive Thor 自動運転車コンピューター システムです。

Drive Thor は、2025 年のロードマップで Nvidia の Atlan プラットフォームに取って代わり、発売時に 2,000 TOPS の推論パフォーマンスを提供することを約束します。

「Drive Thor には、当社の Grace CPU、Hopper GPU、および次世代 GPU アーキテクチャで導入された最先端の機能が満載です」と、Nvidia の自動車担当副社長である Danny Shapiro 氏は記者会見で述べました。 彼によると、Drive Thor は、現代の自動車を動かしている多数のコンピューター システムを単一の中央プラットフォームに統合するように設計されています。

「今日の高度な運転支援システムを見てください。パーキング、ドライバー モニタリング、カメラ ミラー、デジタル インストルメント クラスター、インフォテインメント システムなどです。これらはすべて、車両全体に分散されたさまざまなコンピューター上にあります」と彼は言いました。 「しかし、2025 年には、これらの機能は個別のコンピューターではなくなります。 むしろ、Drive Thor は、メーカーがこれらの機能を単一のシステムに効率的に統合することを可能にします。」

自動車センサーからのすべての情報ストリーミングに対処するために、このチップはマルチコンピューティング ドメインの分離を特徴としており、Nvidia によると、チップは中断することなく同時に重要なプロセスを実行できます。

この技術により、チップは複数のオペレーティングシステムを同時に実行して、さまざまな車両アプリケーションに適合させることもできます。 たとえば、自動車のコア オペレーティング システムは Linux で実行され、インフォテインメント システムは QNX または Android で実行される場合があります。

ただし、この技術が実際に稼働しているのをいつ見られるかは不明です。 現状では、Nvidia のローンチ パートナーである Zeekr、Xpeng、QCraft の XNUMX 社はすべて中国を拠点としています。 ®