概要

機械学習において、バイアスと分散のトレードオフは、あらゆる予測モデルのパフォーマンスに影響を与える基本的な概念です。 これは、モデルのバイアス誤差と分散誤差の微妙なバランスを指します。両方を同時に最小化することは不可能です。 最適なモデルのパフォーマンスを達成するには、適切なバランスをとることが重要です。

この短い記事では、バイアスと分散を定義し、それらが機械学習モデルにどのような影響を与えるかを説明し、実際にそれらに対処する方法について実践的なアドバイスを提供します。

バイアスと分散を理解する

バイアスと分散の関係に入る前に、機械学習においてこれらの用語が何を表すかを定義しましょう。

バイアス誤差は、モデルの予測と、モデルが予測しようとする正しい値 (グラウンド トゥルース) との差を指します。 言い換えれば、バイアスとは、基礎となるデータ分布に関する誤った仮定によってモデルが犯してしまうエラーのことです。 高バイアス モデルは単純すぎることが多く、データの複雑さを捉えることができず、アンダーフィッティングにつながります。

一方、分散誤差は、トレーニング データの小さな変動に対するモデルの感度を指します。 高分散モデルは過度に複雑で、基礎となるパターンではなくデータ内のノイズに適合する傾向があり、過剰適合につながります。 これにより、新しい未確認データのパフォーマンスが低下します。

バイアスが高いと、モデルが単純すぎてデータの複雑さを捉えることができないアンダーフィッティングにつながる可能性があります。 データに関して強い仮定を置き、入力変数と出力変数の間の真の関係を捉えることができません。 一方、分散が大きいと、モデルが複雑すぎて、入力変数と出力変数の間の基礎的な関係ではなく、データ内のノイズを学習する過学習につながる可能性があります。 したがって、過適合モデルはトレーニング データに近似しすぎる傾向があり、新しいデータにうまく一般化できませんが、過小適合モデルはトレーニング データを正確に適合することさえできません。

前述したように、バイアスと分散には関連性があり、優れたモデルではバイアス誤差と分散誤差のバランスが取れています。 バイアスと分散のトレードオフは、これら XNUMX つの誤差の原因間の最適なバランスを見つけるプロセスです。 バイアスと分散が低いモデルは、トレーニング データと新しいデータの両方で良好なパフォーマンスを発揮し、合計誤差を最小限に抑える可能性があります。

バイアスと分散のトレードオフ

モデルの複雑さと、未知のデータに一般化する能力との間のバランスを達成することが、バイアスと分散のトレードオフの中核です。 一般に、より複雑なモデルのバイアスは低くなりますが、分散は高くなります。一方、単純なモデルのバイアスは高くなりますが、分散は低くなります。

バイアスと分散を同時に最小化することは不可能であるため、堅牢な機械学習モデルを構築するには、それらの間の最適なバランスを見つけることが重要です。 たとえば、モデルの複雑さが増すと、分散も増加します。 これは、より複雑なモデルほどトレーニング データのノイズに適合する可能性が高く、過剰適合につながるためです。

一方、モデルを単純にしすぎると、バイアスが増加します。 これは、単純なモデルではデータ内の基礎的な関係を捉えることができず、アンダーフィッティングが発生するためです。

目標は、トレーニング データ内の基礎的な関係をキャプチャできるほど複雑ではあるが、トレーニング データ内のノイズに適合するほど複雑ではないモデルをトレーニングすることです。

実際のバイアスと分散のトレードオフ

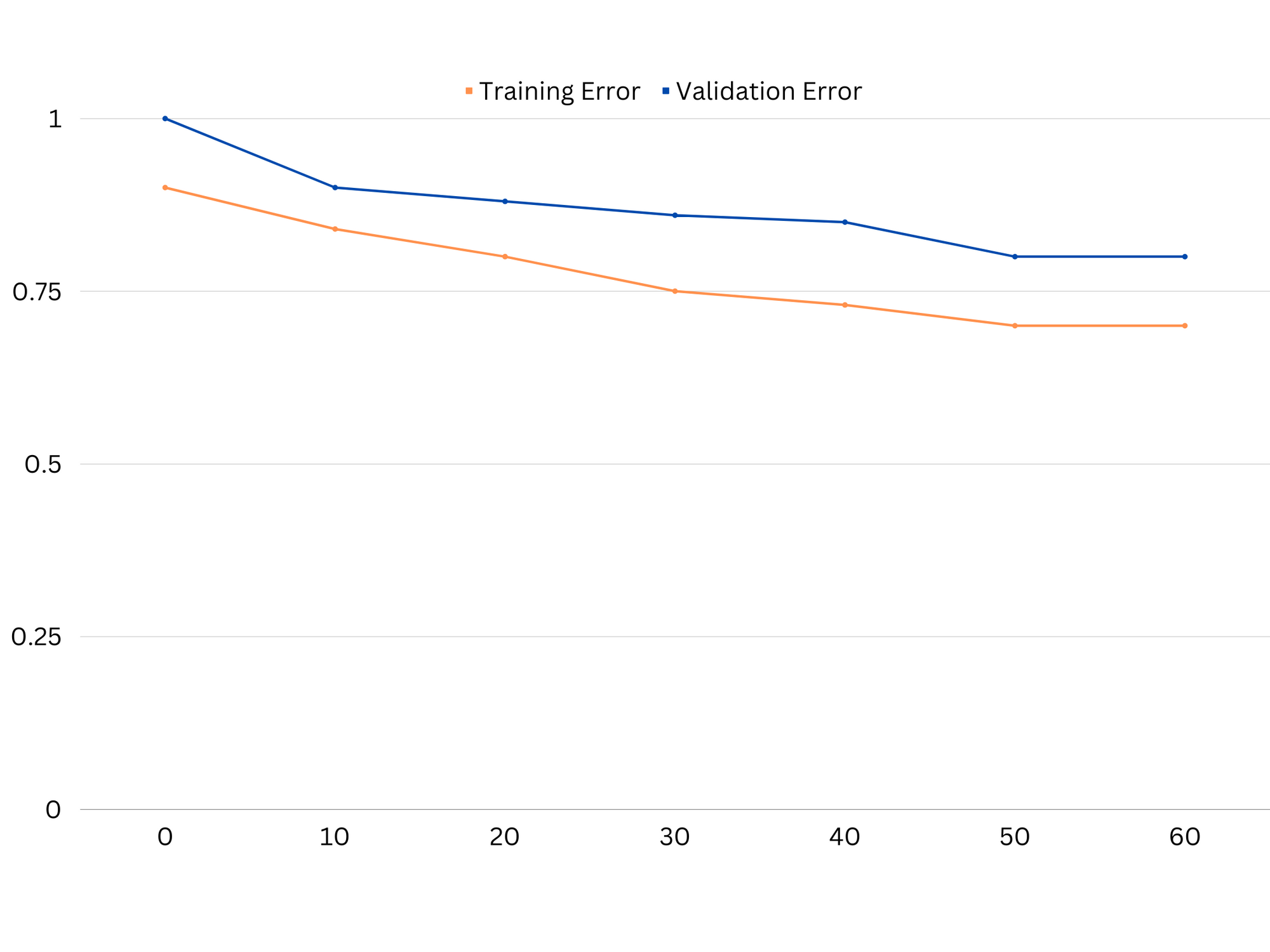

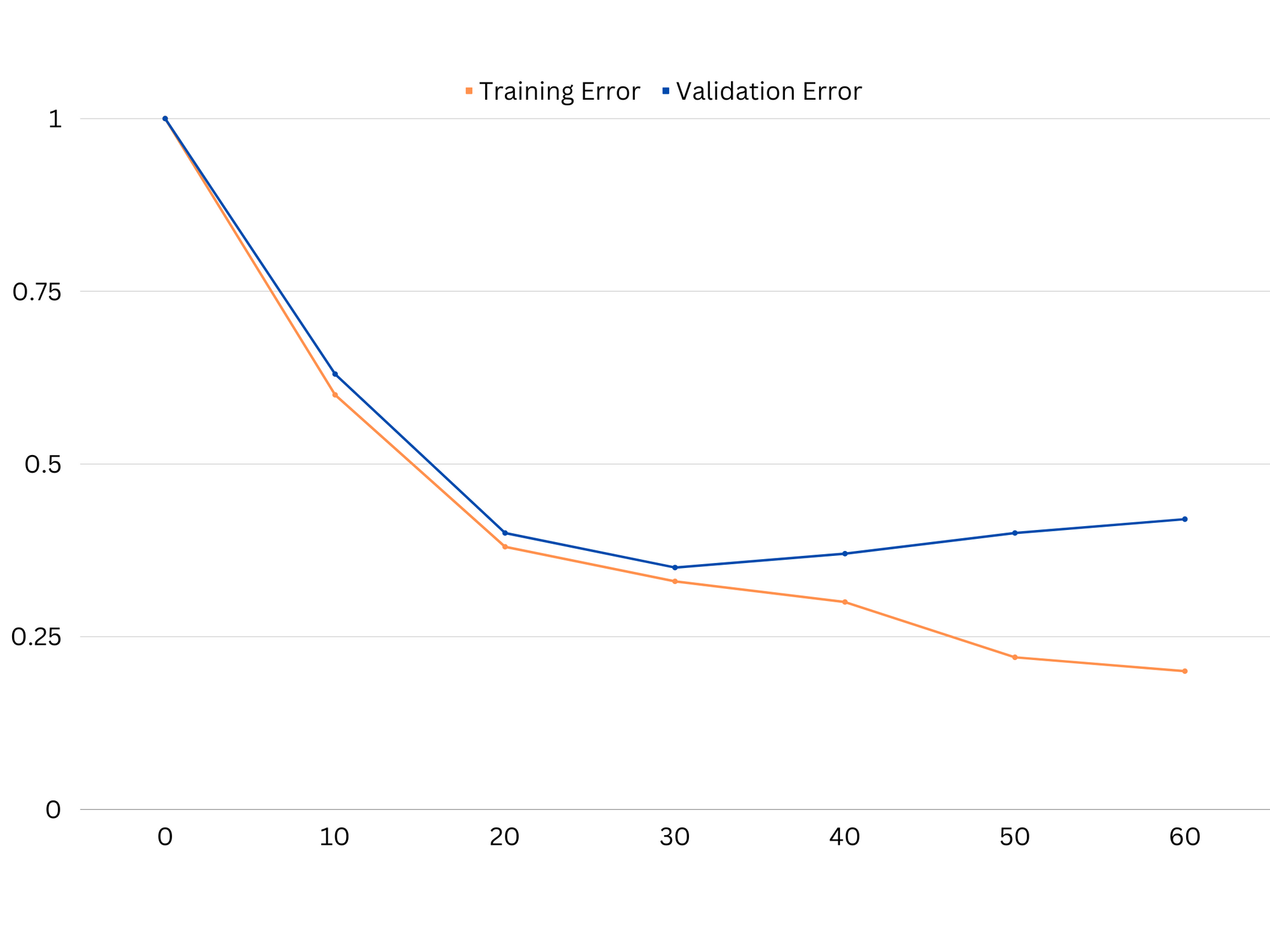

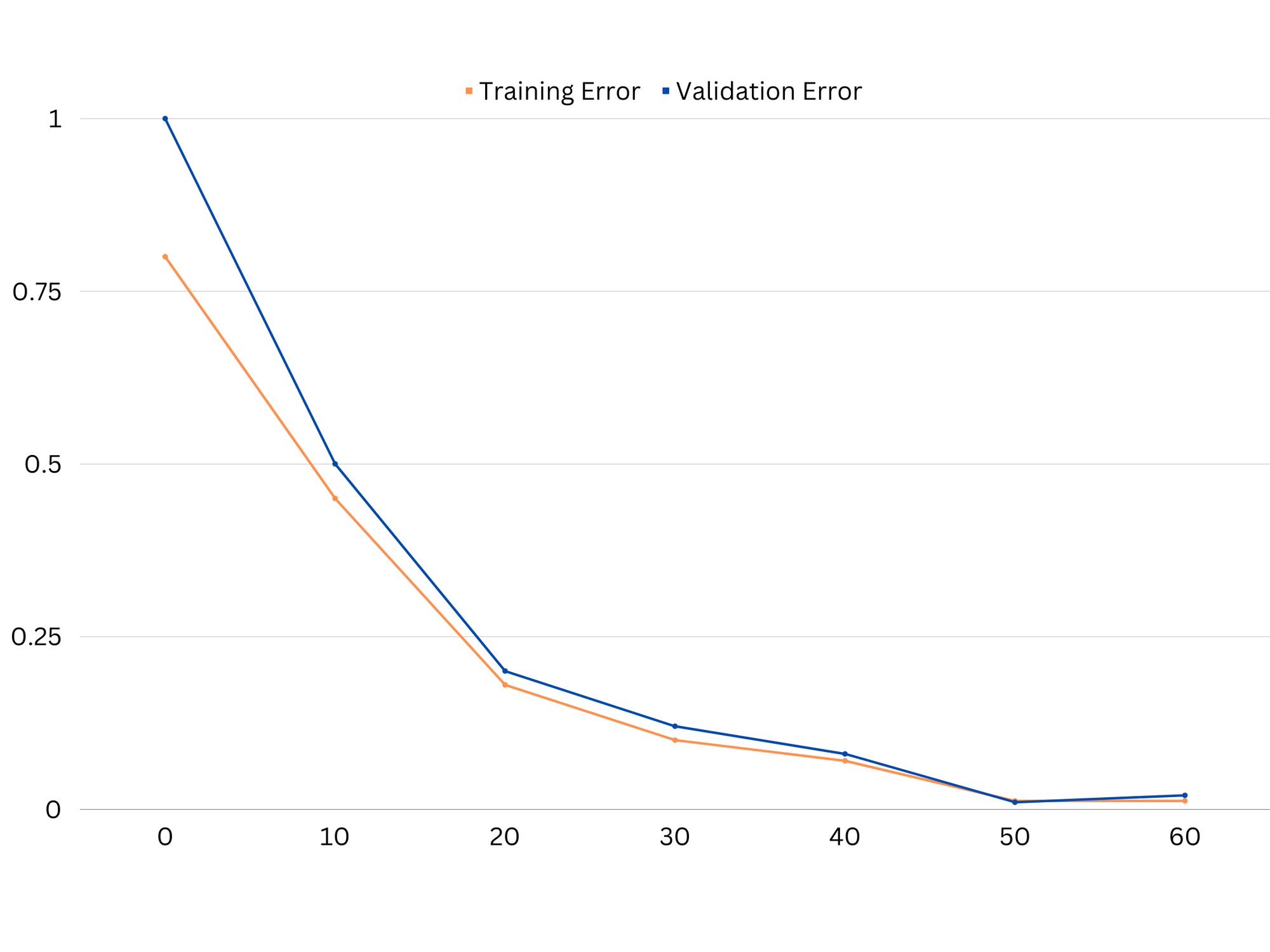

モデルのパフォーマンスを診断するには、通常、トレーニング エラーと検証エラーを計算して比較します。 これを視覚化するのに役立つツールは、学習曲線のプロットです。これは、トレーニング プロセス全体を通じて、トレーニング データと検証データの両方でのモデルのパフォーマンスを表示します。 これらの曲線を調べることで、モデルが過適合 (高い分散)、過小適合 (高いバイアス)、または良好な適合 (バイアスと分散の最適なバランス) であるかどうかを判断できます。

アンダーフィッティングモデルの学習曲線の例。 トレイン エラーと検証エラーの両方が高くなります。

実際には、トレーニング データと検証データの両方でパフォーマンスが低い場合は、モデルが単純すぎて過小適合につながることを示しています。 一方、モデルがトレーニング データでは非常に優れたパフォーマンスを発揮するが、テスト データではパフォーマンスが低い場合は、モデルの複雑さが高すぎる可能性があり、結果として過剰適合が発生します。 アンダーフィッティングに対処するには、機能を追加したり、学習アルゴリズムを変更したり、別のハイパーパラメーターを選択したりして、モデルの複雑さを増やすことができます。 過学習の場合は、モデルを正規化するか、交差検証などの手法を使用して一般化機能を向上させることを検討する必要があります。

過学習モデルの学習曲線の例。 トレーニング エラーは減少しますが、検証エラーは増加し始めます。 このモデルは一般化できません。

正則化は、機械学習モデルの分散エラーを削減するために使用できる手法であり、バイアスと分散のトレードオフに対処するのに役立ちます。 さまざまな正則化手法があり、それぞれに独自の長所と短所があります。 一般的な正則化手法には、リッジ回帰、ラッソ回帰、エラスティック ネット正則化などがあります。 これらの手法はすべて、モデルの目的関数にペナルティ項を追加することで過学習を防止するのに役立ちます。これにより、極端なパラメーター値が抑制され、より単純なモデルが促進されます。

リッジ回帰は、L2 正則化とも呼ばれ、モデル パラメーターの XNUMX 乗に比例するペナルティ項を追加します。 この手法では、モデルのパラメーター値が小さくなる傾向があり、分散の減少と汎化の向上につながる可能性があります。 ただし、特徴の選択は実行されないため、すべての特徴がモデル内に残ります。

ベストプラクティス、業界で認められた標準、および含まれているチートシートを含む、Gitを学習するための実践的で実用的なガイドを確認してください。 グーグルGitコマンドを停止し、実際に 学ぶ それ!

ラッソ回帰、または L1 正則化では、モデル パラメーターの絶対値に比例するペナルティ項が追加されます。 この手法を使用すると、パラメーター値がまばらなモデルが作成され、一部のパラメーターをゼロに設定することで特徴選択が効果的に実行されます。 これにより、解釈しやすい単純なモデルが得られます。

弾性ネットの正則化 これは、L1 正則化と L2 正則化の両方を組み合わせたもので、リッジ回帰となげなわ回帰のバランスをとることができます。 XNUMX つのペナルティ項の比率を制御することにより、Elastic Net は、一般化や機能選択の向上など、両方の手法の利点を実現できます。

適切な適合モデルの学習曲線の例。

結論

バイアスと分散のトレードオフは、モデルの有効性と良さを決定する機械学習における重要な概念です。 高いバイアスはアンダーフィッティングにつながり、高い分散はオーバーフィッティングにつながりますが、新しいデータに適切に一般化する堅牢なモデルを構築するには、この XNUMX つの最適なバランスを見つけることが必要です。

学習曲線の助けを借りて、過学習または過小学習の問題を特定することができ、モデルの複雑さを調整するか正則化手法を実装することにより、テスト データだけでなくトレーニング データと検証データの両方のパフォーマンスを向上させることができます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- プラトアイストリーム。 Web3 データ インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- 未来を鋳造する w エイドリエン・アシュリー。 こちらからアクセスしてください。

- PREIPO® を使用して PRE-IPO 企業の株式を売買します。 こちらからアクセスしてください。

- 情報源: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :は

- :not

- :どこ

- 1

- 12

- 20

- 8

- a

- 能力

- できる

- 私たちについて

- 絶対の

- 正確にデジタル化

- 達成する

- 達成する

- 実際に

- 追加

- 住所

- 追加

- 利点

- アドバイス

- 影響を及ぼす

- 影響

- アルゴリズム

- すべて

- 許可

- また

- an

- および

- どれか

- です

- 記事

- AS

- バランス

- BE

- なぜなら

- 利点

- の間に

- バイアス

- 国境

- 両言語で

- 建物

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- by

- 計算する

- 缶

- 機能

- キャプチャー

- 場合

- 変化

- 選択する

- 密接に

- 組み合わせ

- 比較します

- 複雑な

- 複雑さ

- コンセプト

- 検討

- 制御

- 基本

- 正しい

- 重大な

- データ

- 取引

- 減少

- 決定する

- 決定する

- 違い

- 異なります

- ディスプレイ

- ディストリビューション

- ありません

- 原因

- 各

- 前

- 容易

- 効果的に

- 有効

- 励ます

- 十分な

- エラー

- エラー

- さらに

- 調べる

- 例

- 説明する

- 極端な

- 失敗

- 失敗

- 特徴

- 特徴

- 発見

- フィット

- フィッティング

- 変動

- フォーカス

- function

- 基本的な

- Gitの

- 目標

- 良い

- 陸上

- ガイド

- ハンド

- 実践的な

- 持ってる

- 助けます

- 助け

- ハイ

- より高い

- ホバー

- 認定条件

- How To

- しかしながら

- HTTPS

- 識別する

- if

- 実装

- 不可能

- 改善します

- 改善されました

- in

- その他の

- include

- 含まれました

- 増える

- の増加

- に

- 概要

- IT

- ITS

- キープ

- 既知の

- L1

- l2

- つながる

- 主要な

- リード

- 学習

- う

- LG

- ような

- 可能性が高い

- ll

- ロー

- 下側

- 機械

- 機械学習

- 作る

- 言及した

- 最小化

- モデル

- 他には?

- 必要

- net

- 新作

- ノイズ

- 数

- 客観

- of

- 頻繁に

- on

- 最適な

- or

- その他

- 私たちの

- でる

- 出力

- 自分の

- パラメーター

- パラメータ

- パターン

- 実行する

- パフォーマンス

- 実行

- 実行する

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 貧しいです

- 人気

- 可能

- 実用的

- 練習

- 予測する

- 予測

- 防ぐ

- 問題

- プロセス

- 提供します

- むしろ

- 比

- 減らします

- 電話代などの費用を削減

- 指し

- 関連する

- 関係

- の関係

- 残る

- 表す

- 結果

- 結果として

- 結果

- 右

- リング

- 堅牢な

- s

- 選択

- 感度

- 設定

- Shadow

- シート

- ショート

- すべき

- 簡単な拡張で

- 同時に

- 小さい

- より小さい

- So

- 一部

- ソース

- 広場

- スタックアバス

- 規格

- Force Stop

- 強い

- そのような

- 提案する

- テクニック

- 期間

- 条件

- test

- より

- それ

- アプリ環境に合わせて

- それら

- そこ。

- ボーマン

- 彼ら

- この

- 全体

- 〜へ

- あまりに

- ツール

- トータル

- トレーニング

- トレーニング

- 遷移

- true

- 真実

- 試します

- 2

- 一般的に

- できません

- 根本的な

- 未知の

- 中古

- 値

- 価値観

- 非常に

- we

- WELL

- この試験は

- かどうか

- which

- while

- 意志

- 言葉

- ゼファーネット

- ゼロ