アマゾンセージメイクr データラングラー は UI ベースのデータ準備ツールであり、データの分析、前処理、および視覚化を実行するのに役立ち、データをより迅速にクリーニング、変換、および準備する機能を備えています。 Data Wrangler の事前構築済みフロー テンプレートは、共通のデータセットを使用してデータ フローのベスト プラクティス パターンを加速および理解できるようにすることで、データ サイエンティストや機械学習 (ML) 実践者のデータ準備を迅速化するのに役立ちます。

Data Wrangler フローを使用して、次のタスクを実行できます。

- データの視覚化 –データセットの各列の統計プロパティの調査、ヒストグラムの作成、外れ値の調査

- データクリーニング –重複の削除、エントリの削除または欠落した値の入力、外れ値の削除

- データエンリッチメントと機能エンジニアリング –列を処理してより表現力豊かな特徴を構築し、トレーニング用の特徴のサブセットを選択します

この投稿は、次のビルド済みフローのサンプルを使用して、Data Wrangler を理解するのに役立ちます。 GitHubの. リポジトリは、表形式のデータ変換、時系列データの変換、および結合されたデータセットの変換を示しています。 それぞれが基本的な性質のため、異なるタイプの変換を必要とします。 標準的な表形式または断面データは、特定の時点で収集されます。 対照的に、時系列データは時間の経過とともに繰り返し取得され、連続する各データ ポイントは過去の値に依存します。

表形式データのサンプル データ フローを使用する方法の例を見てみましょう。

前提条件

データラングラーは アマゾンセージメーカー 内で利用可能な機能 Amazon SageMakerスタジオ、そのため、Studio のオンボーディング プロセスに従って、Studio 環境とノートブックをスピンアップする必要があります。 いくつかの認証方法から選択できますが、Studio ドメインを作成する最も簡単な方法は、 クイックスタート 指示。 クイック スタートは、 標準スタジオ設定. を使用してオンボーディングを選択することもできます AWS IAM アイデンティティ センター (AWS Single Sign-On の後継) 認証用 (参照 IAM Identity Center を使用して Amazon SageMaker ドメインにオンボード).

Studio を使用してデータセットとフロー ファイルを Data Wrangler にインポートする

次の手順は、データを SageMaker にインポートして Data Wrangler で使用する方法の概要を示しています。

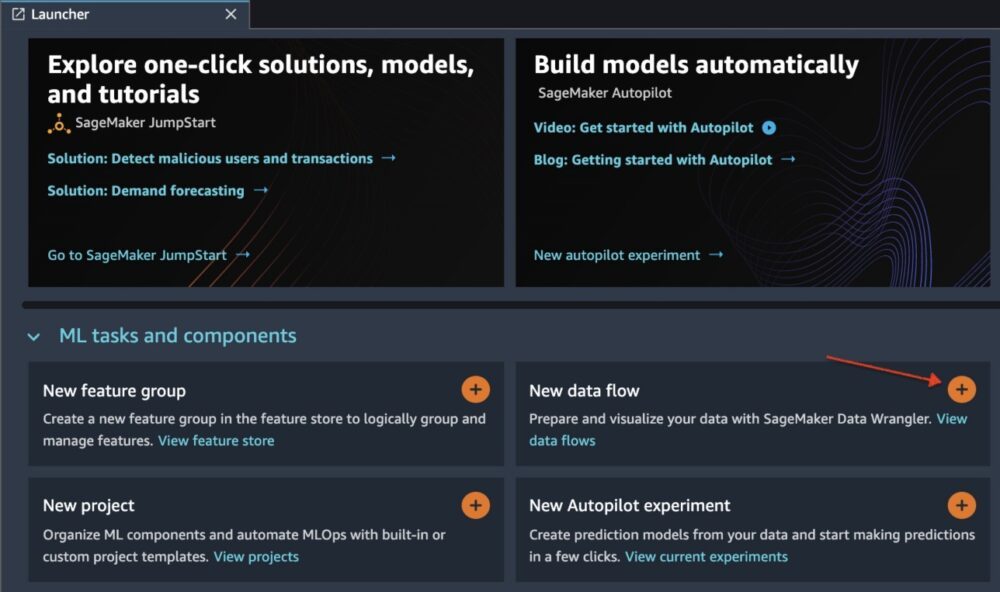

を選択して、Studio UI を介して Data Wrangler を初期化します。 新しいデータフロー.

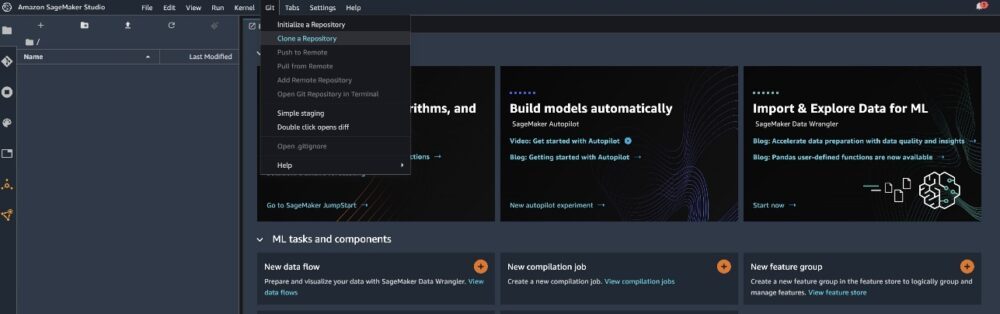

クローン GitHubレポ フロー ファイルを Studio 環境にダウンロードします。

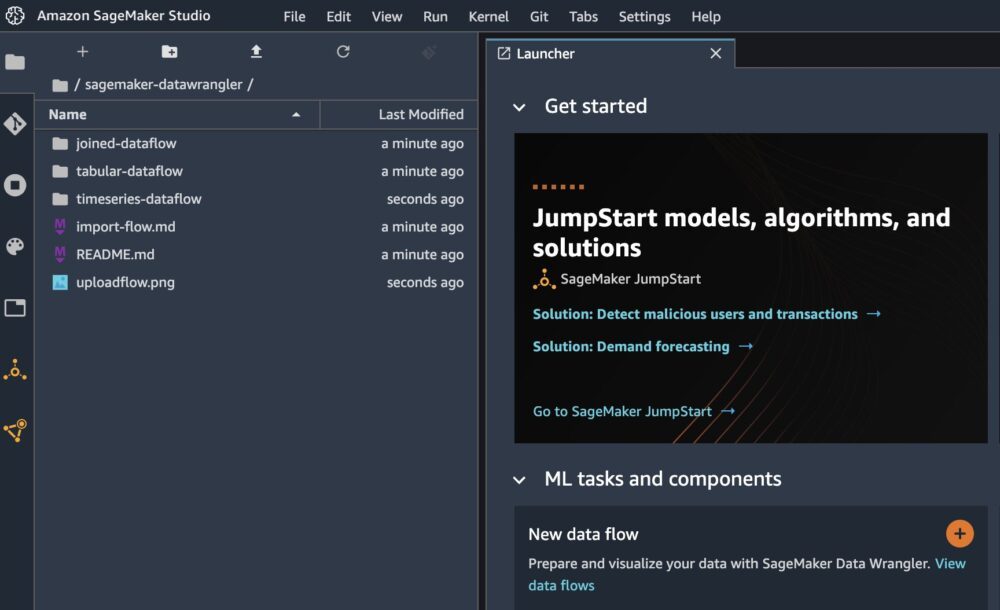

クローンが完了すると、左側のペインにリポジトリの内容が表示されるはずです。

ファイルを選択 ホテル予約分類フロー フロー ファイルを Data Wrangler にインポートします。

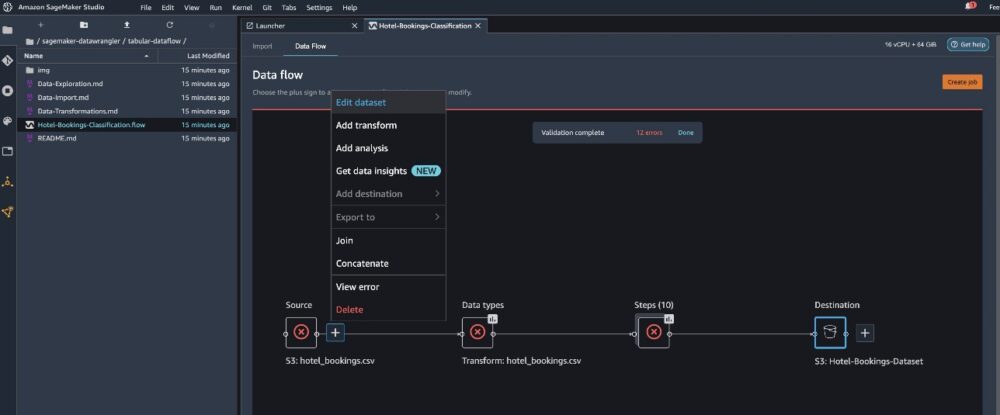

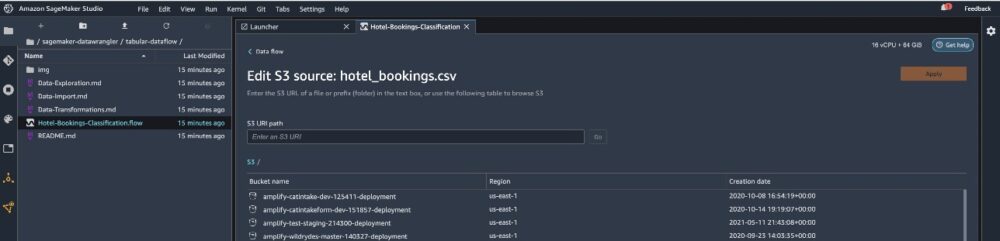

時系列または結合されたデータ フローを使用する場合、フローは別の名前で表示されます。フローがインポートされると、次のスクリーンショットが表示されます。 フロー ファイルが正しいデータ ソースを指していることを確認する必要があるため、これはエラーを示しています。 Amazon シンプル ストレージ サービス (Amazon S3)。

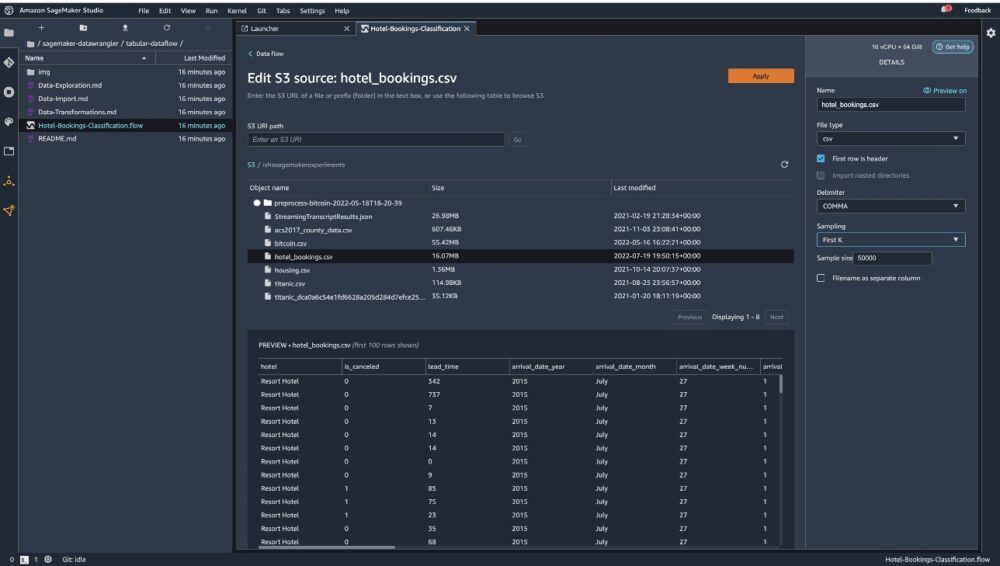

選択する データセットを編集 すべての S3 バケットを起動します。 次に、データセットを選択します hotel_bookings.csv S3 バケットから 表形式のデータ フロー.

を使用している場合は、 結合されたデータ フロー、複数のデータセットを Data Wrangler にインポートする必要がある場合があります

右側のペインで、 段落 区切り文字として選択され、 サンプリング に設定されています 最初のK. 私たちのデータセットは、完全なデータセットで Data Wrangler 変換を実行するのに十分小さいですが、データセットをインポートする方法を強調したかったのです。 大規模なデータセットがある場合は、サンプリングの使用を検討してください。 選ぶ インポート このデータセットを Data Wrangler にインポートします。

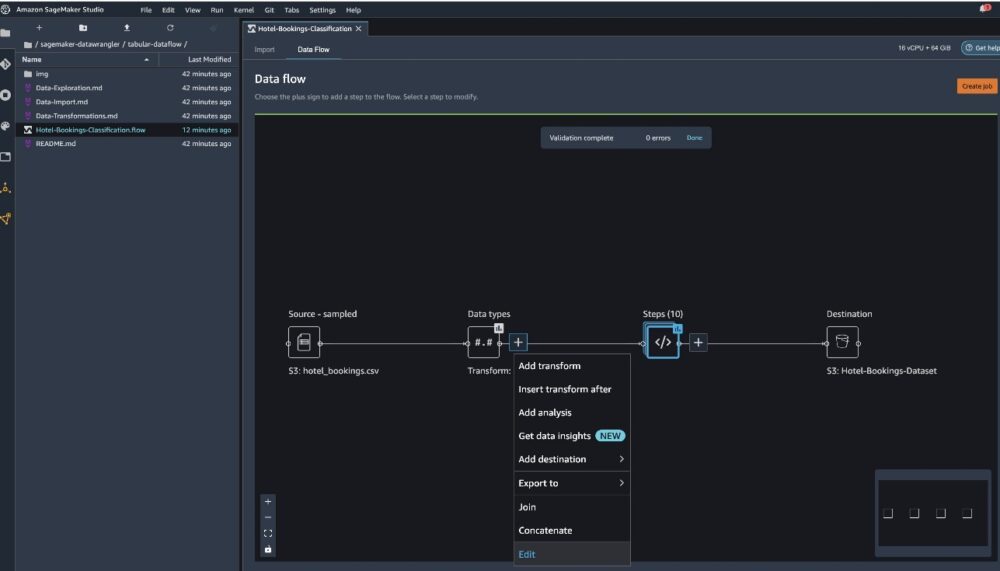

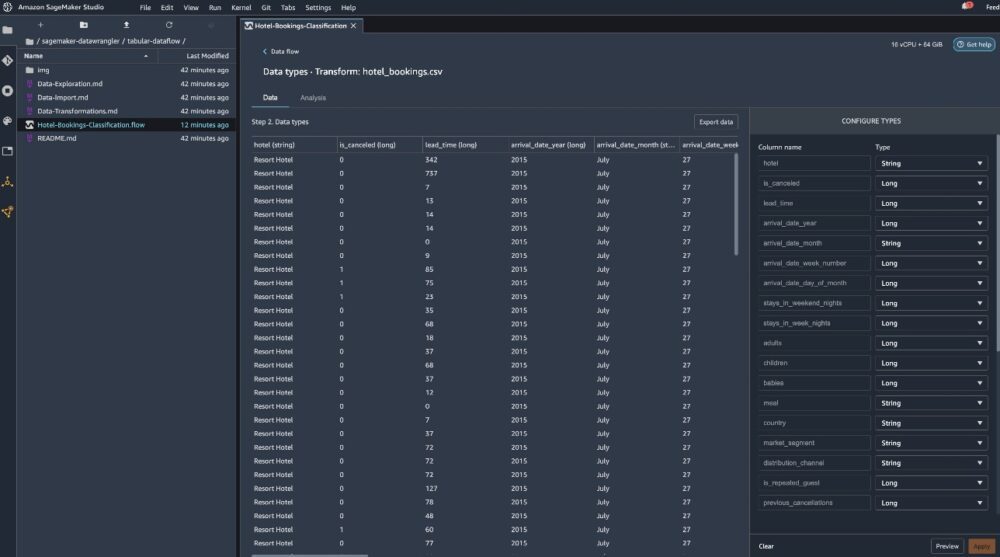

データセットがインポートされると、Data Wrangler は自動的にデータセットを検証し、データ型を検出します。 正しいデータセットを指しているため、エラーがなくなっていることがわかります。 フロー エディターには、データがソースからインポートされ、データ型が認識されたことを示す XNUMX つのブロックが表示されるようになりました。 必要に応じて、データ型を編集することもできます。

次のスクリーンショットは、データ型を示しています。

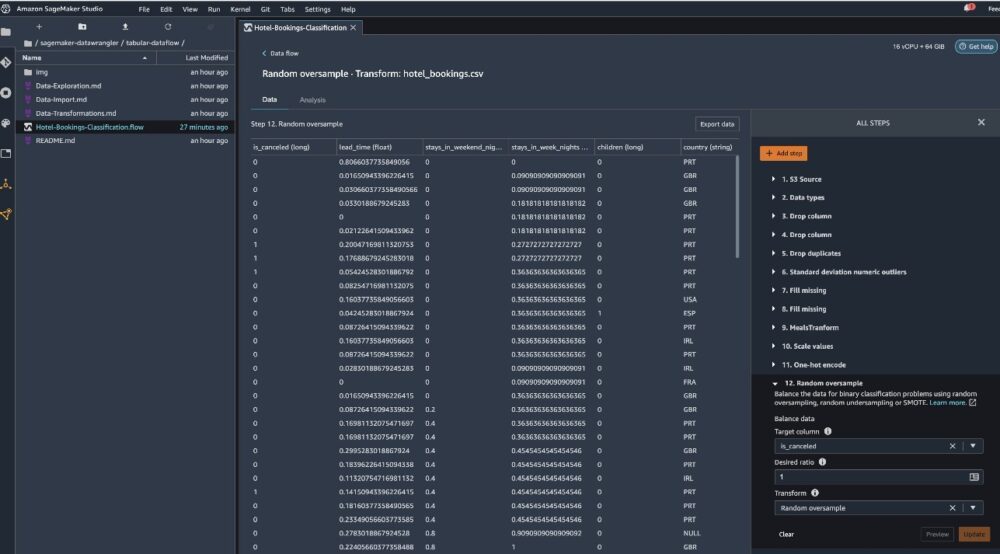

この表形式のフローの一部として行われる変換のいくつかを見てみましょう。 を使用している場合 時系列 or 参加した データ フローの一般的な変換を確認してください。 GitHubレポ. データセット内のターゲット リークと特徴の共線性を調査したデータ インサイト レポート、テーブル サマリー分析、および迅速なモデリング機能を使用して、いくつかの基本的な探索的データ分析を実行しました。 の手順を調べる GitHubレポ.

ここで、Data Insights and Quality Report によって提供される推奨事項に基づいて列を削除します。

- 対象漏れの場合はドロップ 予約状況.

- 冗長な列の場合はドロップします days_in_waiting_list、ホテル、reserved_room_type、arrival_date_month、reservation_status_date、赤ちゃん、 & Arrival_date_day_of_month.

- 線形相関の結果に基づいて、列を削除します 到着日_週番号 & 到着日_年 これらの特徴 (列) ペアの相関値は、推奨されるしきい値の 0.90 よりも大きいためです。

- 非線形相関結果に基づいて、ドロップ 予約状況. この列は、ターゲットの漏れ分析に基づいて、削除するように既にマークされています。

- の処理数値 (最小 - 最大スケーリング) Lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, & required_car_parking_spaces.

- 次のようなカテゴリ変数のワンホット エンコード 食事、is_repeated_guest、market_segment、assigned_room_type、deposit_type、 & 顧客タイプ.

- クラスの不均衡に対してターゲット変数のランダム オーバーサンプルのバランスをとります。クイック モデリング機能を使用して、外れ値と欠損値を処理します。

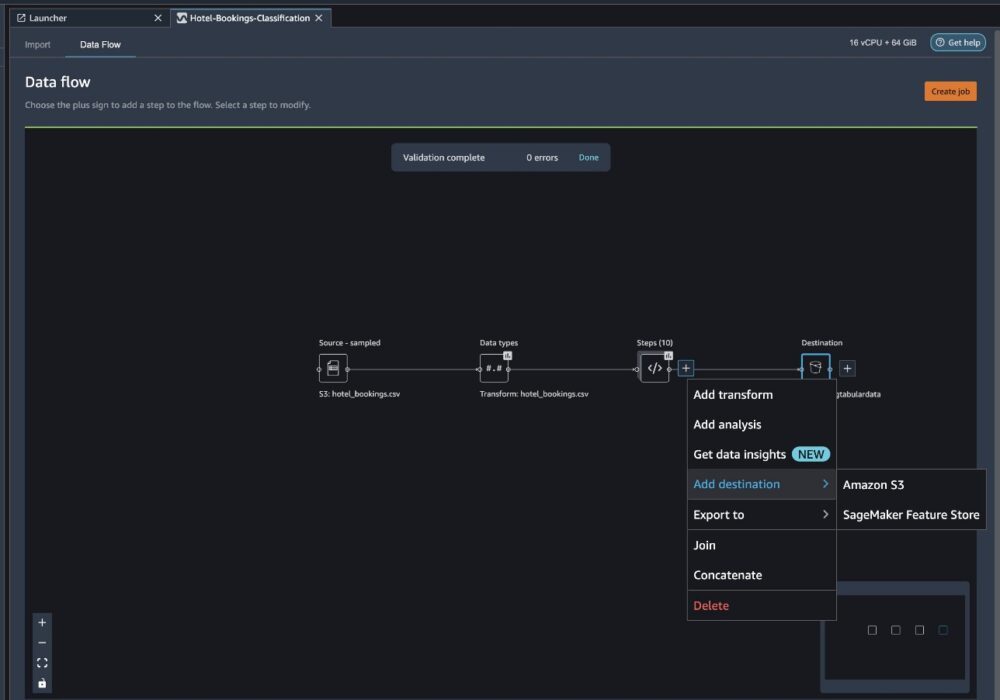

AmazonS3にエクスポートする

これで、さまざまな変換が完了し、データを Amazon S3 にエクスポートする準備が整いました。 このオプションは、Data Wrangler 処理フローを実行し、結果のデータセットを指定された S3 バケットに保存する SageMaker 処理ジョブを作成します。 次の手順に従って、Amazon S3 へのエクスポートを設定します。

変換要素のコレクションの横にあるプラス記号を選択し、 宛先を追加をタップし、その後、 アマゾンS3.

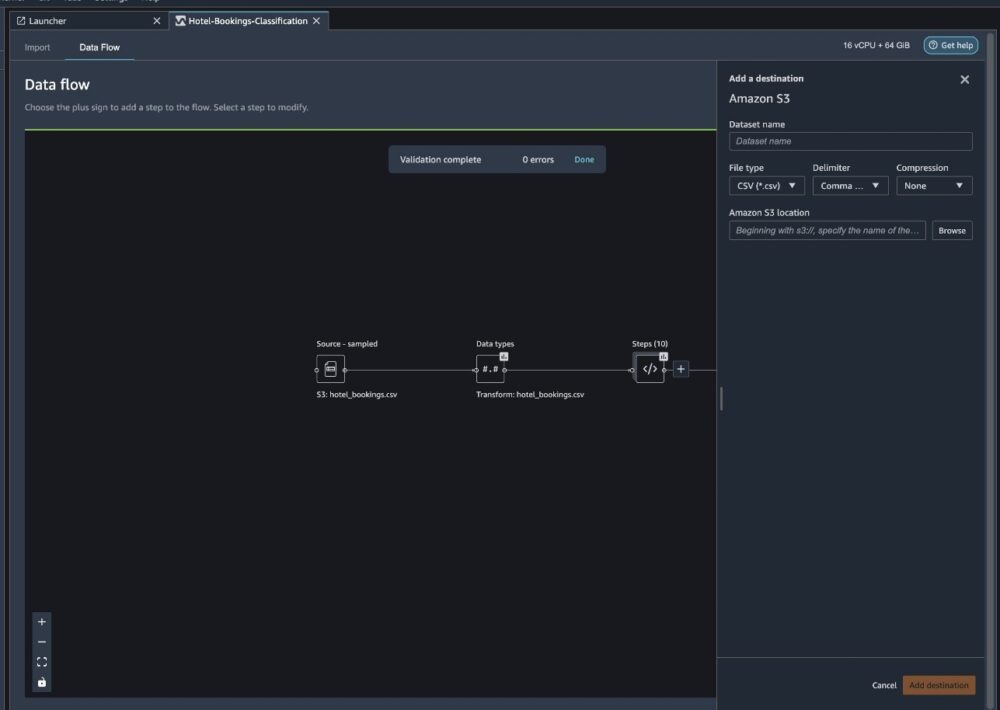

- データセット名、新しいデータセットの名前を入力します。たとえば、

NYC_export. - ファイルの種類、選択する CSV.

- デリミタ、選択する コンマ.

- 圧縮、選択する なし.

- AmazonS3の場所、前に作成したものと同じバケット名を使用します。

- 選択する 宛先を追加.

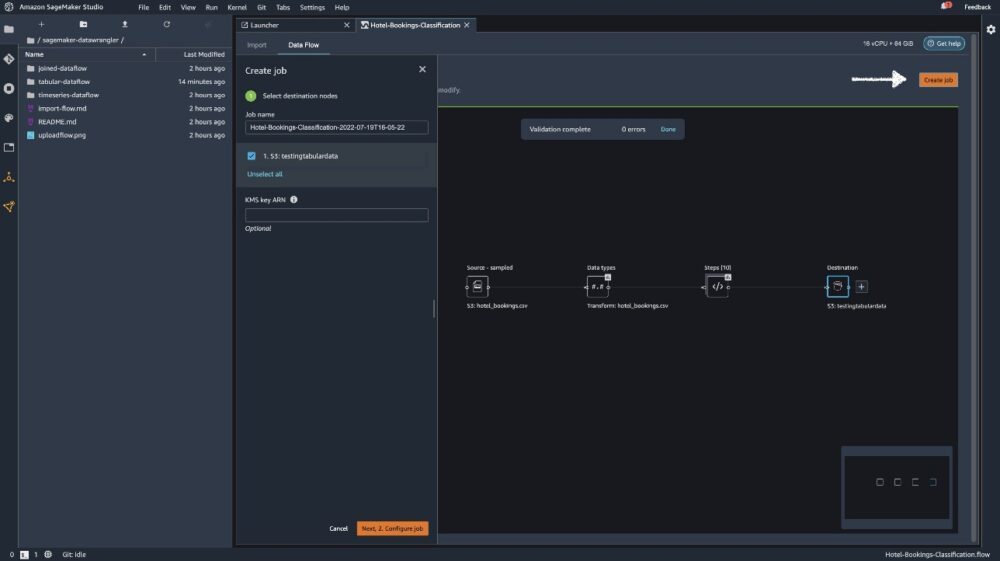

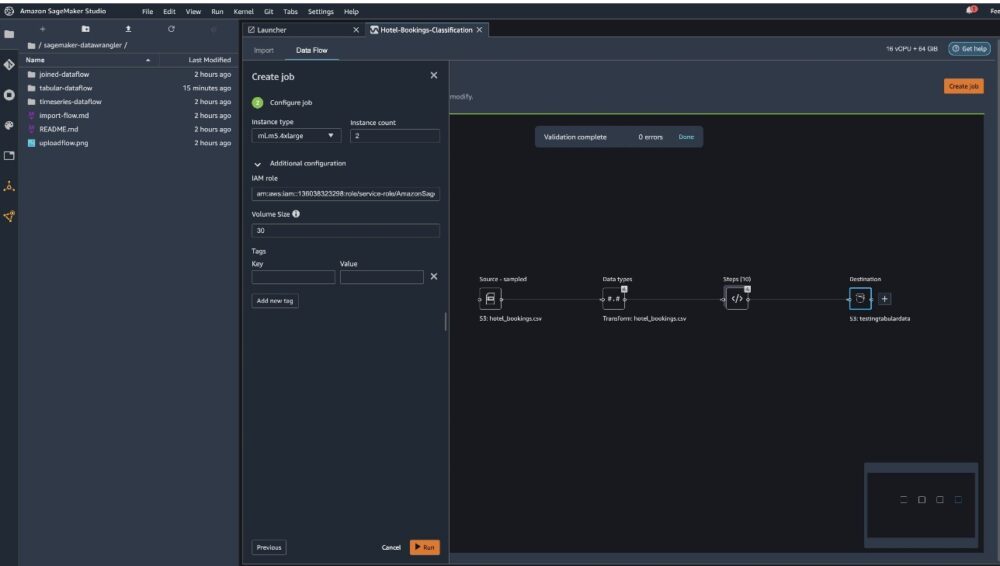

選択する ジョブを作成.

職種名、名前を入力するか、自動生成されたオプションを保持して選択します デスティネーション. 目的地はただ一つ、 S3:testingtabulardataですが、ワークフローのさまざまなステップから複数の宛先がある場合があります。 出て KMS キー ARN フィールドを空にして選択 Next.

ここで、ジョブのコンピューティング容量を構成する必要があります。 この例では、すべてのデフォルト値をそのまま使用できます。

- インスタンスタイプ、ml.m5.4xlargeを使用します。

- インスタンス数、2 を使用します。

- あなたは探検することができます 追加の構成、ただしデフォルト設定のままにします。

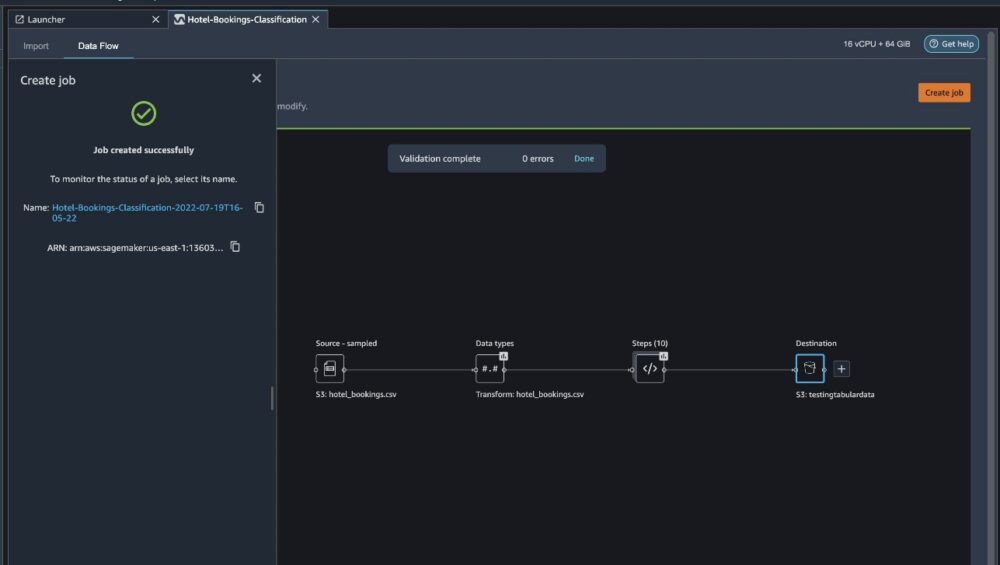

- 選択する ラン.

これでジョブが開始されました。Data Wrangler の処理フローに従って 6 GB のデータを処理するには時間がかかります。 ml.m2xlarge のコストは 5.4 時間あたり 0.922 米ドルで、そのうちの XNUMX つを使用しているため、このジョブのコストは約 XNUMX 米ドルになります。

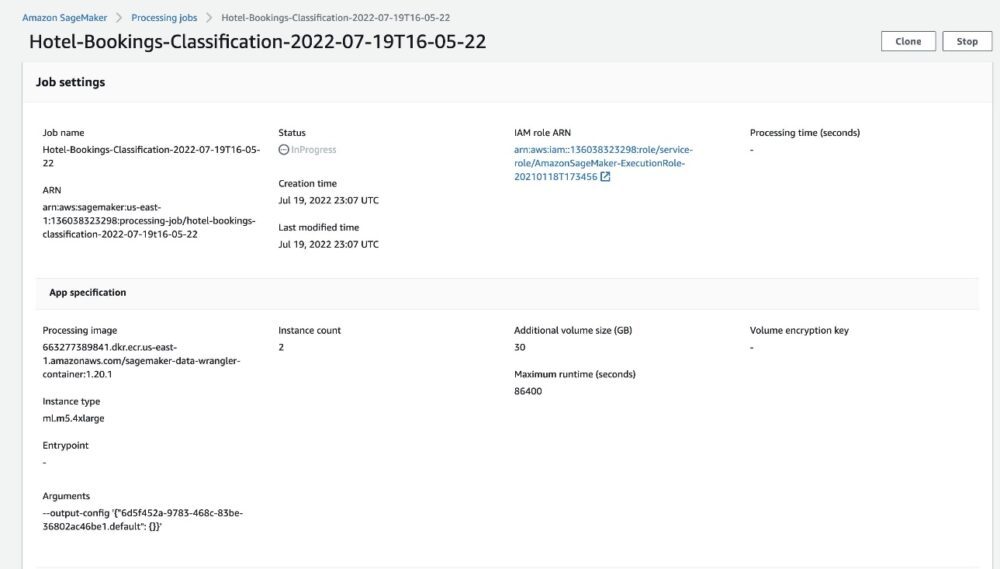

ジョブ名を選択すると、ジョブの詳細が表示された新しいウィンドウにリダイレクトされます。

ジョブの詳細ページで、前の手順のすべてのパラメーターを確認できます。

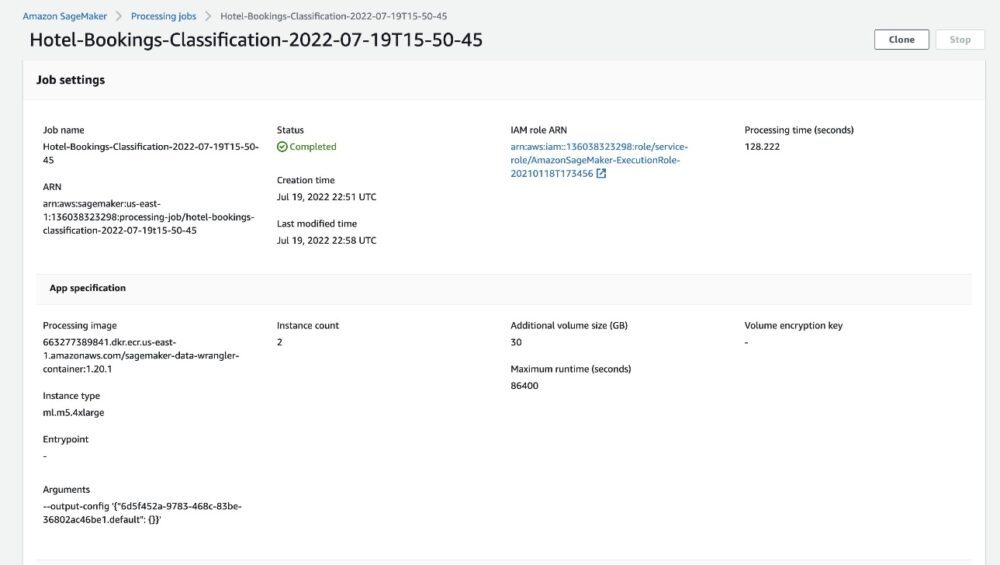

ジョブのステータスが [完了] に変わると、次のことも確認できます。 処理時間 (秒) 価値。 この処理ジョブが完了するまでに約 5 ~ 10 分かかります。

ジョブが完了すると、トレーニングとテストの出力ファイルが対応する S3 出力フォルダーで使用可能になります。 処理ジョブ構成から出力場所を見つけることができます。

Data Wrangler 処理ジョブが完了したら、S3 バケットに保存された結果を確認できます。 を更新することを忘れないでください job_name 変数をジョブ名に置き換えます。

このエクスポートされたデータを使用して、ML モデルを実行できるようになりました。

クリーンアップ

S3 バケットを削除する とは データラングラーフロー 基盤となるリソースを削除し、実験終了後に不要なコストが発生しないようにするため。

まとめ

この投稿では、事前に構築された表形式のデータ フローを Data Wrangler にインポートし、データセットにプラグインして、結果を Amazon S3 にエクスポートする方法を示しました。 ユース ケースで時系列データの操作や複数のデータセットの結合が必要な場合は、 GitHubレポ.

事前構築済みのデータ準備ワークフローをインポートしたら、それを Amazon SageMaker Processing と統合できます。 AmazonSageMakerパイプライン, Amazon SageMaker フィーチャーストア ML トレーニング データの処理、共有、保存のタスクを簡素化します。 また、このサンプル データ フローを Python スクリプトにエクスポートし、カスタム ML データ準備パイプラインを作成して、リリース速度を加速することもできます。

私たちはあなたが私たちをチェックすることをお勧めします GitHubリポジトリ 実践的な練習を行い、モデルの精度を向上させる新しい方法を見つけてください! SageMaker の詳細については、次の Web サイトをご覧ください。 AmazonSageMaker開発者ガイド.

著者について

イシャドゥア サンフランシスコ ベイエリアを拠点とするシニア ソリューション アーキテクトです。 彼女は、AWS Enterprise のお客様の目標と課題を理解することで成長を支援し、クラウドネイティブな方法でアプリケーションを構築する方法を指導しながら、それらの回復力とスケーラビリティを確保しています。 彼女は、機械学習技術と環境の持続可能性に情熱を注いでいます。

イシャドゥア サンフランシスコ ベイエリアを拠点とするシニア ソリューション アーキテクトです。 彼女は、AWS Enterprise のお客様の目標と課題を理解することで成長を支援し、クラウドネイティブな方法でアプリケーションを構築する方法を指導しながら、それらの回復力とスケーラビリティを確保しています。 彼女は、機械学習技術と環境の持続可能性に情熱を注いでいます。