“코드에 집중하는 대신 기업은 신뢰할 수 있고 효율적이며 체계적인 방식으로 데이터를 개선하기 위한 체계적인 엔지니어링 관행을 개발하는 데 집중해야 합니다. 즉, 기업은 모델 중심 접근 방식에서 데이터 중심 접근 방식으로 전환해야 합니다.” – 앤드류 응

데이터 중심 AI 접근 방식에는 데이터 준비 및 기능 엔지니어링과 관련된 고품질 데이터로 AI 시스템을 구축하는 것이 포함됩니다. 이는 데이터 수집, 검색, 프로파일링, 정리, 구조화, 변환, 강화, 유효성 검사 및 데이터의 안전한 저장과 관련된 지루한 작업일 수 있습니다.

Amazon SageMaker 데이터 랭글러 의 서비스입니다 아마존 세이지 메이커 스튜디오 코딩을 거의 또는 전혀 사용하지 않고 데이터 가져오기, 준비, 변환, 기능화 및 분석을 위한 종단 간 솔루션을 제공합니다. Data Wrangler 데이터 준비 흐름을 기계 학습(ML) 워크플로에 통합하여 데이터 전처리 및 기능 엔지니어링을 간소화하고 PySpark 코드를 작성하거나 Apache Spark를 설치하거나 클러스터를 스핀업할 필요 없이 데이터 준비를 프로덕션으로 더 빠르게 진행할 수 있습니다.

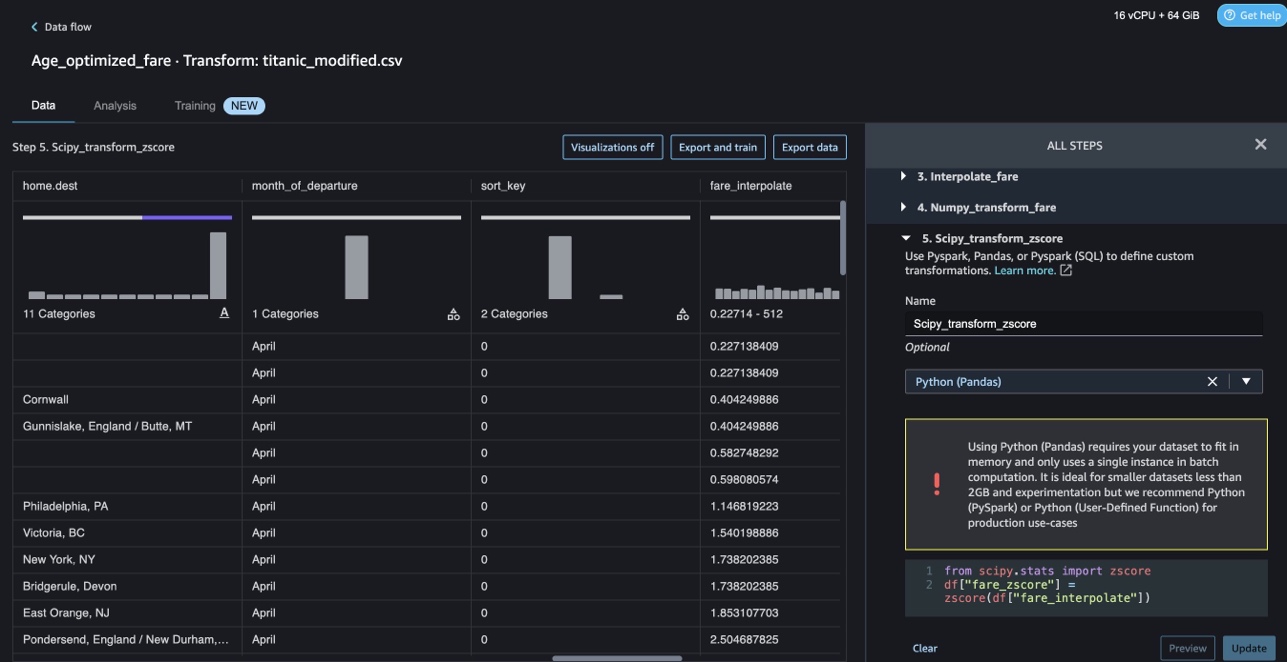

데이터 변환을 위한 고유한 사용자 지정 스크립트를 추가해야 하는 시나리오의 경우 Pandas, PySpark, PySpark SQL에서 변환 논리를 작성할 수 있습니다. Data Wrangler는 이제 ML용 텍스트 데이터를 준비하고 제약 조건 최적화를 수행하기 위해 사용자 지정 변환을 작성하기 위한 NLTK 및 SciPy 라이브러리를 지원합니다.

데이터 변환을 위해 고유한 사용자 지정 스크립트를 추가해야 하는 시나리오가 발생할 수 있습니다. Data Wrangler 사용자 지정 변환 기능을 사용하면 Pandas, PySpark, PySpark SQL에서 변환 논리를 작성할 수 있습니다.

이 게시물에서는 ML용 텍스트 데이터를 준비하기 위해 NLTK에서 사용자 지정 변환을 작성하는 방법에 대해 설명합니다. 또한 NLTK, NumPy, SciPy, scikit-learn 및 AWS AI Services와 같은 다른 일반적인 프레임워크를 사용하여 몇 가지 사용자 지정 코드 변환 예제를 공유합니다. 이 연습의 목적을 위해 다음을 사용합니다. 타이타닉 데이터 세트, ML 커뮤니티에서 인기 있는 데이터 세트로 이제 샘플 데이터 세트 데이터 랭글러 내에서.

솔루션 개요

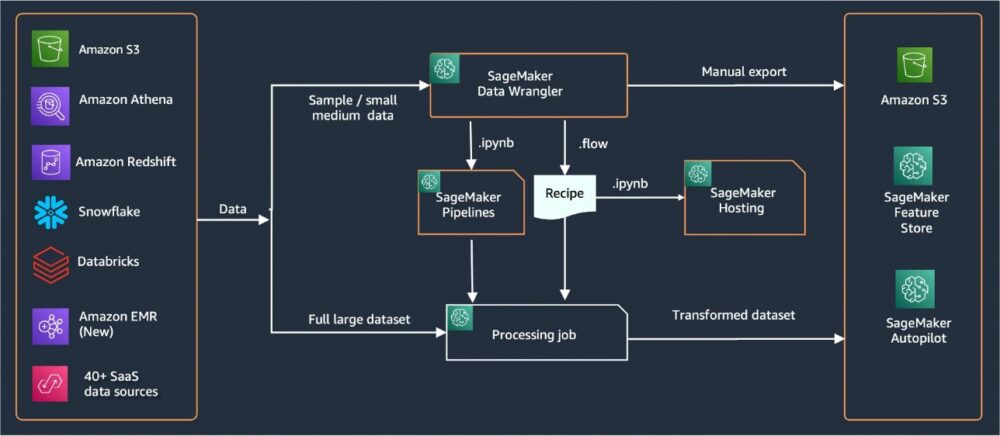

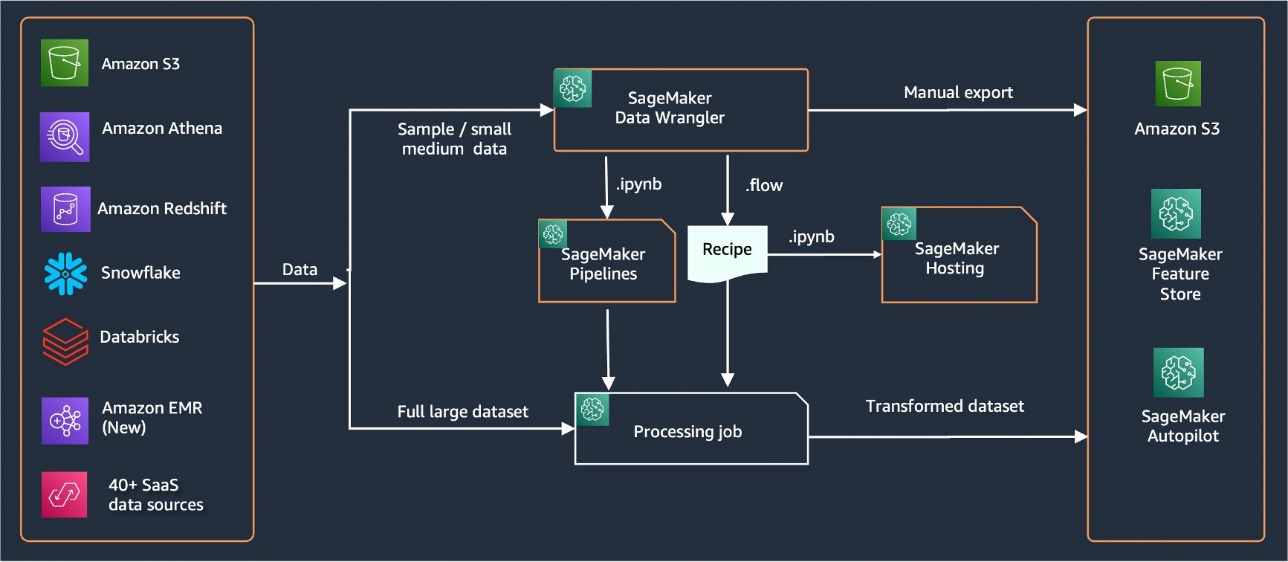

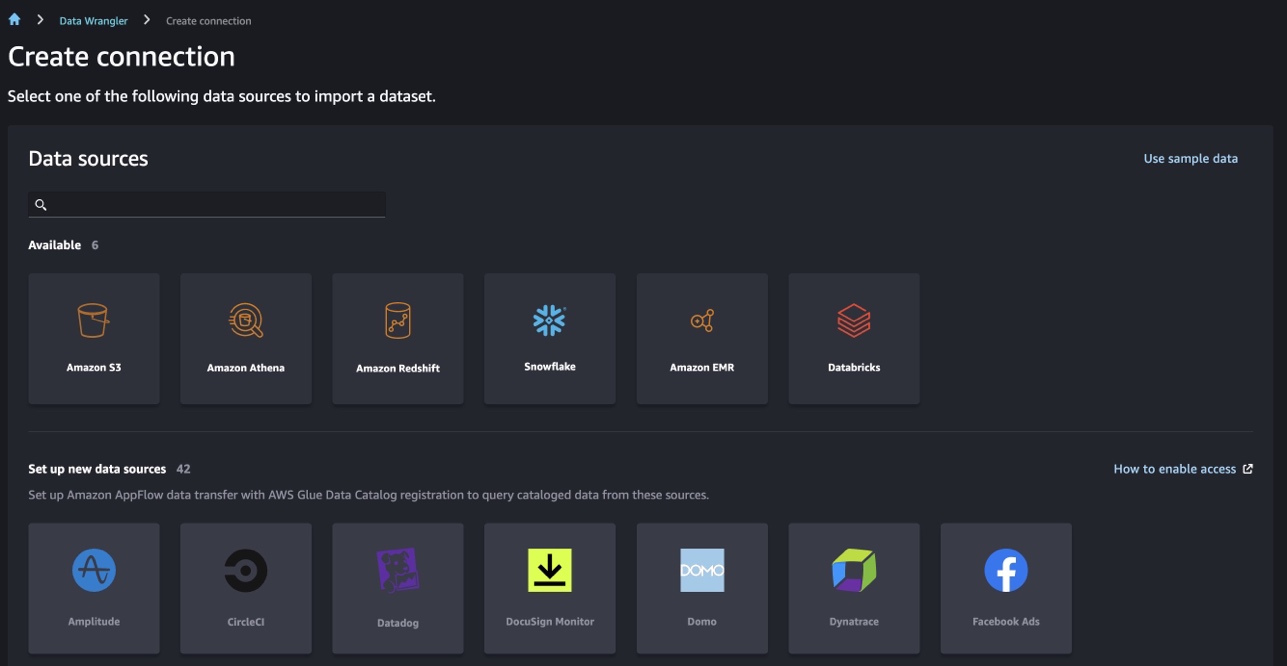

Data Wrangler는 데이터 가져오기를 위한 40개 이상의 기본 제공 커넥터를 제공합니다. 데이터를 가져온 후 300개 이상의 기본 제공 변환을 사용하여 데이터 분석 및 변환을 작성할 수 있습니다. 그런 다음 산업화된 파이프라인을 생성하여 기능을 푸시할 수 있습니다. 아마존 단순 스토리지 서비스 (Amazon S3) 또는 Amazon SageMaker 기능 스토어. 다음 다이어그램은 종단 간 상위 수준 아키텍처를 보여줍니다.

사전 조건

Data Wrangler는 SageMaker에서 사용할 수 있는 기능입니다. 아마존 세이지 메이커 스튜디오. 당신은 따를 수 있습니다 Studio 온보딩 프로세스 Studio 환경과 노트북을 가동합니다. 몇 가지 인증 방법 중에서 선택할 수 있지만 Studio 도메인을 만드는 가장 간단한 방법은 다음을 따르는 것입니다. 빠른 시작 지침. 빠른 시작은 표준 Studio 설정과 동일한 기본 설정을 사용합니다. 다음을 사용하여 온보딩하도록 선택할 수도 있습니다. AWS IAM 자격 증명 센터 (AWS Single Sign-On의 후속) 인증(참조 IAM Identity Center를 사용하여 Amazon SageMaker 도메인에 온보딩).

Titanic 데이터 세트 가져오기

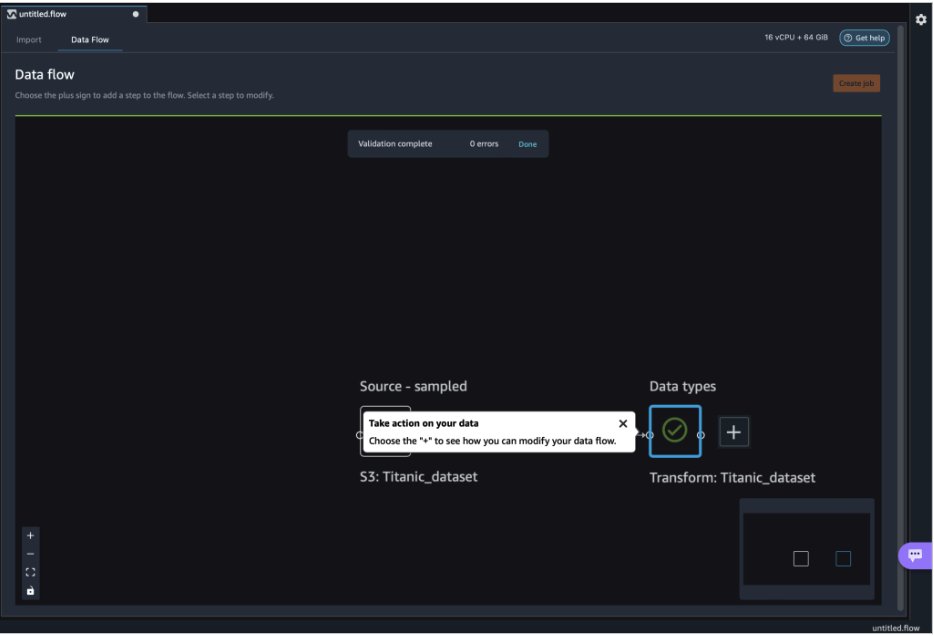

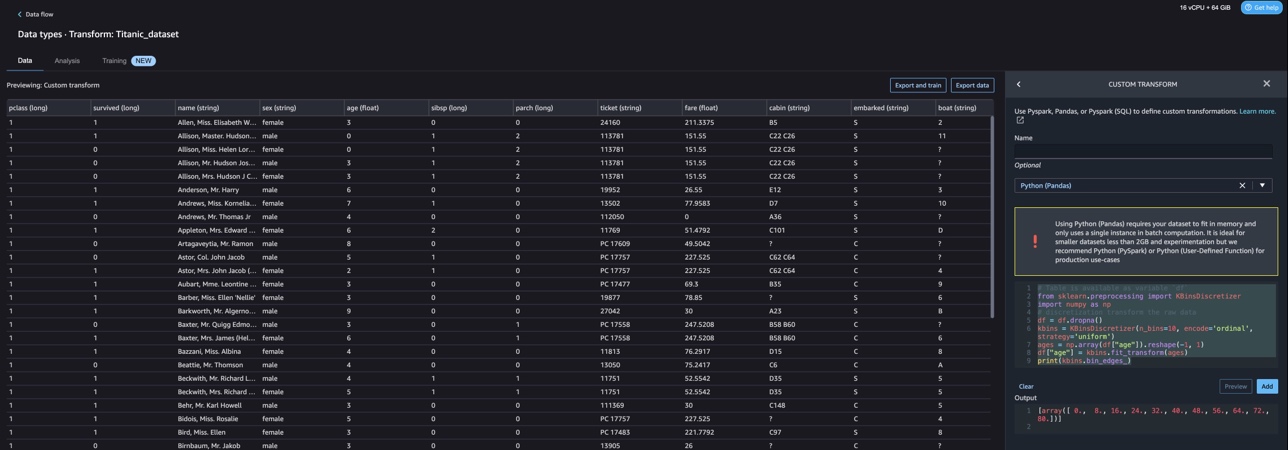

Studio 환경을 시작하고 새 데이터 랭글러 흐름. 다음 스크린샷과 같이 자신의 데이터 세트를 가져오거나 샘플 데이터 세트(Titanic)를 사용할 수 있습니다. Data Wrangler를 사용하면 다양한 데이터 소스에서 데이터 세트를 가져올 수 있습니다. 사용 사례의 경우 S3 버킷에서 샘플 데이터 세트를 가져옵니다.

가져온 후에는 데이터 흐름에 두 개의 노드(소스 노드 및 데이터 유형 노드)가 표시됩니다. Data Wrangler는 데이터 세트의 모든 열에 대한 데이터 유형을 자동으로 식별합니다.

NLTK를 사용한 사용자 정의 변환

Data Wrangler를 사용한 데이터 준비 및 기능 엔지니어링을 위해 300개 이상의 기본 제공 변환을 사용하거나 고유한 사용자 지정 변환을 구축할 수 있습니다. 맞춤 변환 Data Wrangler 내에서 별도의 단계로 작성할 수 있습니다. Data Wrangler 내에서 .flow 파일의 일부가 됩니다. 사용자 정의 변환 기능은 Python, PySpark 및 SQL을 코드 스니펫의 다른 단계로 지원합니다. .flow 파일에서 노트북 파일(.ipynb)이 생성되거나 .flow 파일이 레시피로 사용된 후 사용자 지정 변환 코드 스니펫은 변경할 필요 없이 유지됩니다. 이러한 데이터 랭글러 설계를 통해 사용자 정의 변환을 통해 대규모 데이터 세트를 처리하기 위해 사용자 정의 변환이 SageMaker 처리 작업의 일부가 될 수 있습니다.

Titanic 데이터 세트에는 텍스트 정보가 포함된 몇 가지 기능(이름 및 home.dest)이 있습니다. 우리는 사용 NLTK 이름 열을 분할하고 성을 추출하고 성의 빈도를 인쇄합니다. NLTK는 인간 언어 데이터로 작업하는 Python 프로그램을 구축하기 위한 선도적인 플랫폼입니다. 에 사용하기 쉬운 인터페이스를 제공합니다. 50개 이상의 말뭉치 및 어휘 리소스 분류, 토큰화, 형태소 분석, 태깅, 파싱, 의미론적 추론을 위한 텍스트 처리 라이브러리 제품군 및 강력한 자연어 처리(NLP) 라이브러리용 래퍼와 함께 WordNet과 같은

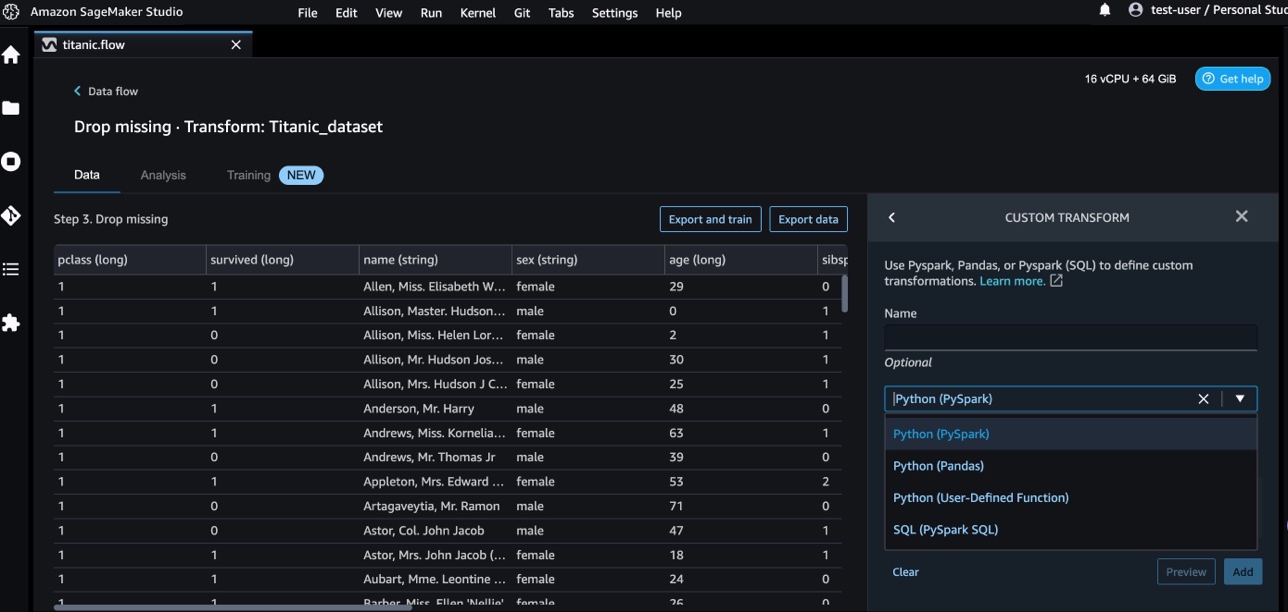

새 변환을 추가하려면 다음 단계를 완료하십시오.

- 더하기 기호를 선택하고 변형 추가.

- 왼쪽 메뉴에서 단계 추가 선택하고 사용자 지정 변환.

Pandas, PySpark, Python 사용자 정의 함수 및 SQL PySpark를 사용하여 사용자 지정 변환을 생성할 수 있습니다.

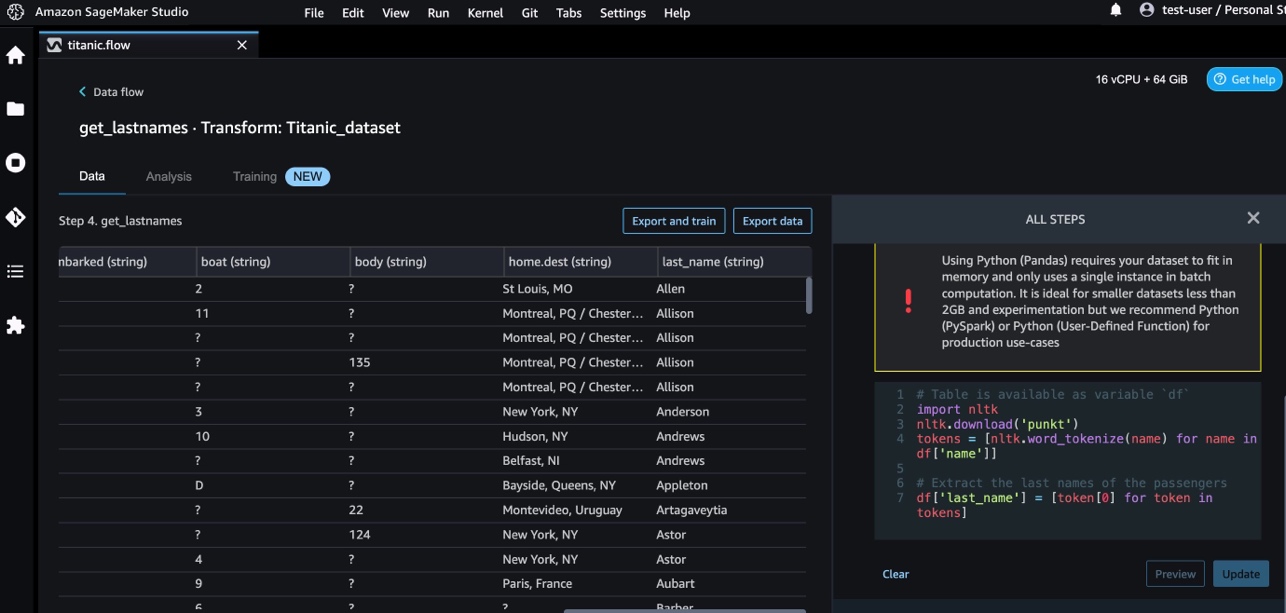

- 왼쪽 메뉴에서 Python (팬더) 다음 코드를 추가하여 이름 열에서 성을 추출합니다.

- 왼쪽 메뉴에서 시사 결과를 검토합니다.

다음 스크린 샷은 last_name 열이 추출되었습니다.

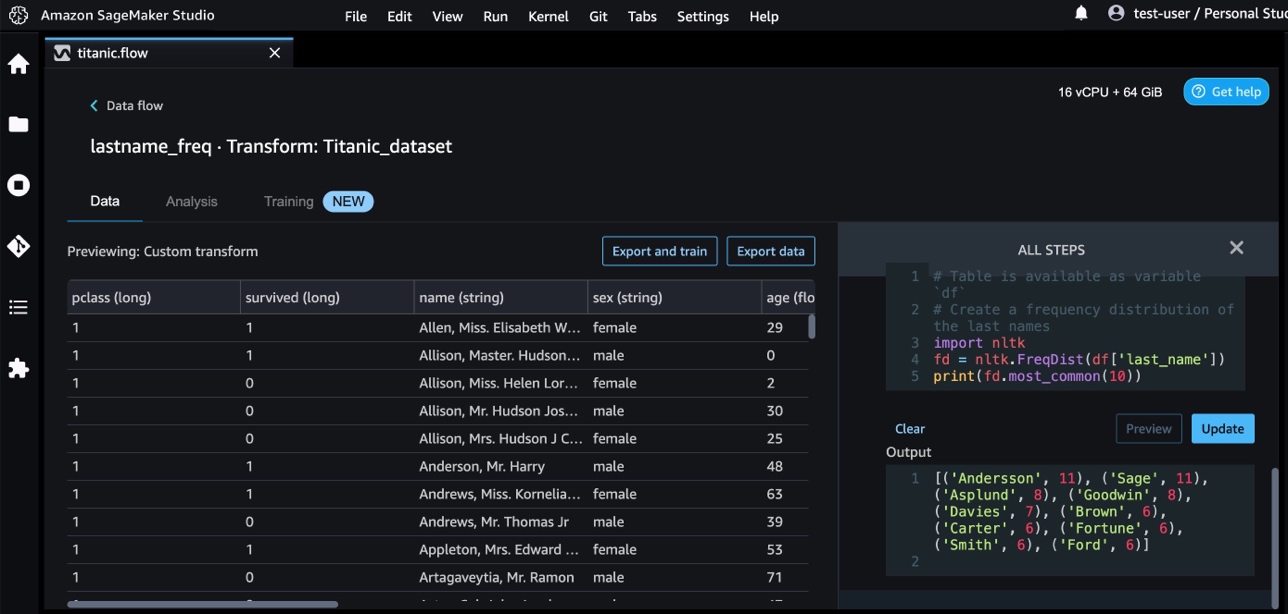

- 다음 코드를 사용하여 성의 빈도 분포를 식별하는 또 다른 사용자 지정 변환 단계를 추가합니다.

- 왼쪽 메뉴에서 시사 빈도의 결과를 검토합니다.

AWS AI 서비스를 사용한 사용자 지정 변환

사전 훈련된 AWS AI 서비스는 애플리케이션 및 워크플로를 위한 기성 인텔리전스를 제공합니다. AWS AI 서비스는 애플리케이션과 쉽게 통합되어 많은 일반적인 사용 사례를 처리합니다. 이제 AWS AI 서비스의 기능을 Data Wrangler의 사용자 지정 변환 단계로 사용할 수 있습니다.

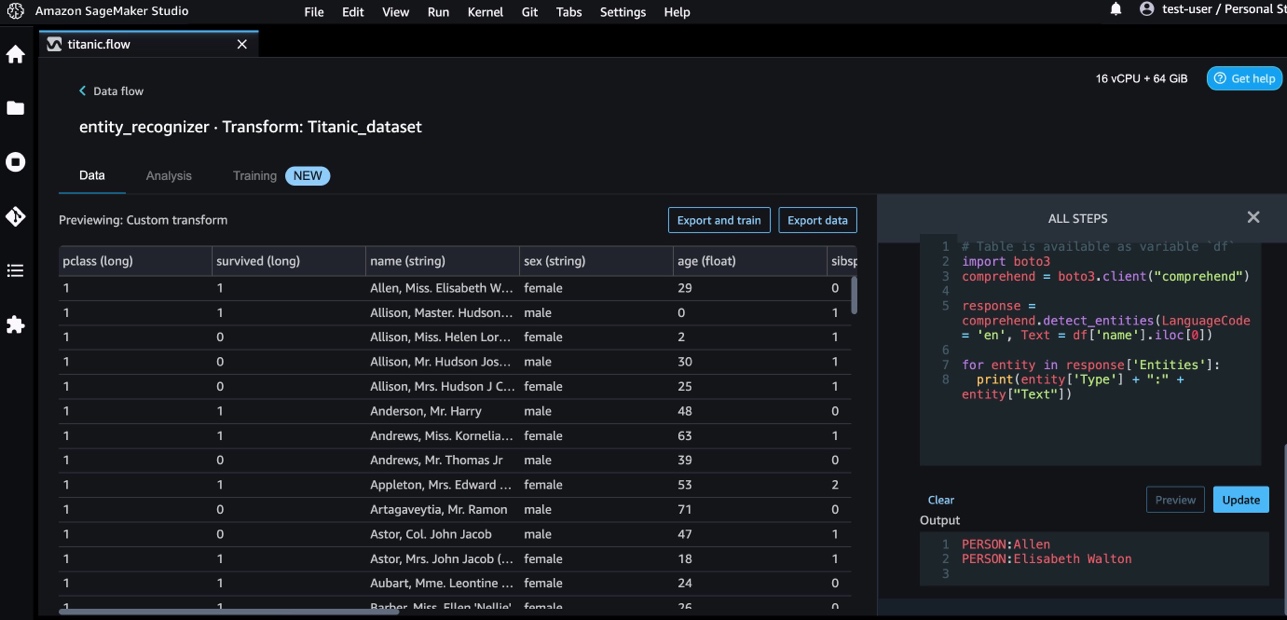

아마존 이해 NLP를 사용하여 문서 내용에 대한 통찰력을 추출합니다. 문서의 엔터티, 핵심 구, 언어, 감정 및 기타 공통 요소를 인식하여 통찰력을 개발합니다.

Amazon Comprehend를 사용하여 이름 열에서 엔터티를 추출합니다. 다음 단계를 완료하십시오.

- 사용자 지정 변환 단계를 추가합니다.

- 왼쪽 메뉴에서 Python (팬더).

- 엔티티를 추출하려면 다음 코드를 입력하십시오.

- 왼쪽 메뉴에서 시사 결과를 시각화합니다.

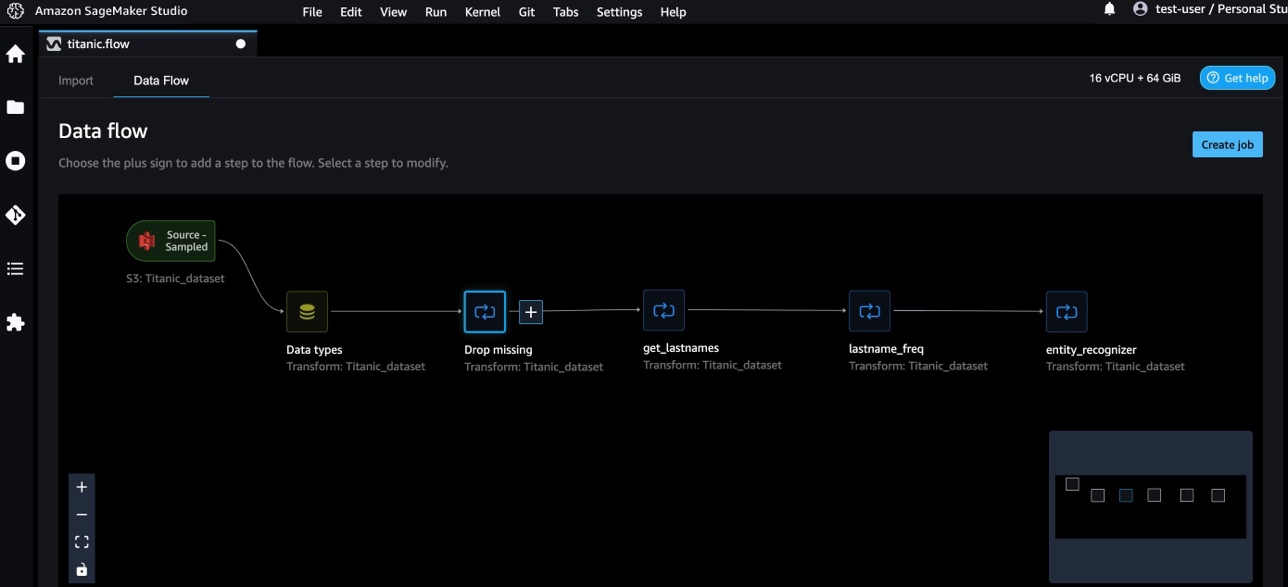

이제 Data Wrangler에 세 가지 사용자 지정 변환을 추가했습니다.

- 왼쪽 메뉴에서 데이터 흐름 종단 간 데이터 흐름을 시각화합니다.

NumPy 및 SciPy를 사용한 사용자 정의 변환

눔 파이 포괄적인 수학 함수, 난수 생성기, 선형 대수 루틴, 푸리에 변환 등을 제공하는 Python용 오픈 소스 라이브러리입니다. SciPy 최적화, 선형 대수, 적분, 보간, 특수 함수, 고속 푸리에 변환(FFT), 신호 및 이미지 처리, 솔버 등을 위한 모듈을 포함하는 과학 컴퓨팅 및 기술 컴퓨팅에 사용되는 오픈 소스 Python 라이브러리입니다.

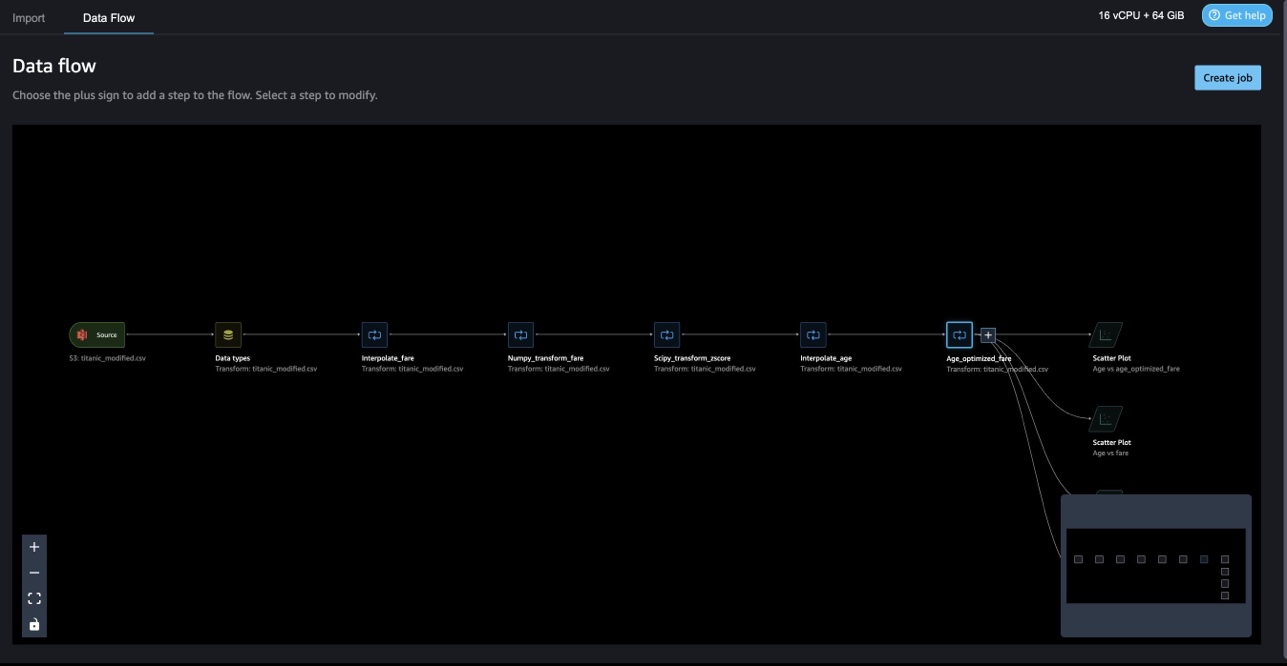

Data Wrangler 사용자 지정 변환을 사용하면 Python, PySpark 및 SQL을 서로 다른 단계로 결합할 수 있습니다. 다음 데이터 랭글러 흐름에서 Python 패키지, NumPy 및 SciPy의 다양한 기능이 Titanic 데이터 세트에 여러 단계로 적용됩니다.

NumPy 변환

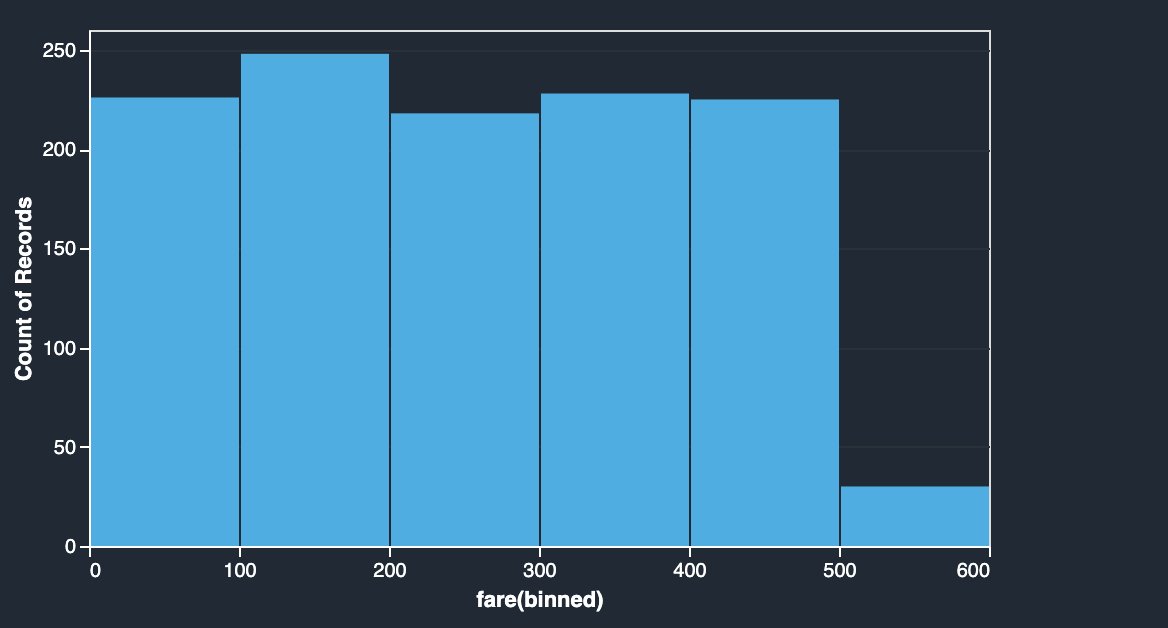

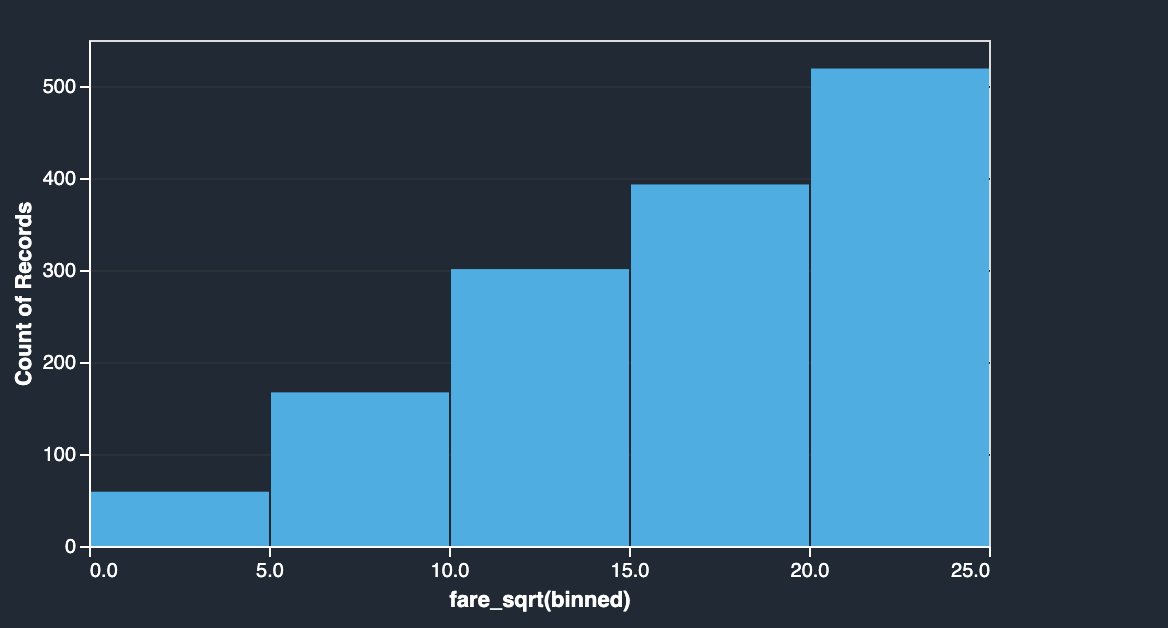

Titanic 데이터 세트의 요금 열에는 다양한 승객의 탑승 요금이 있습니다. 운임 열의 히스토그램은 마지막 구간을 제외하고 균일한 분포를 보여줍니다. 로그 또는 제곱근과 같은 NumPy 변환을 적용하여 분포를 변경할 수 있습니다(제곱근 변환으로 표시됨).

|

|

다음 코드를 참조하십시오.

SciPy 변환

z-score와 같은 SciPy 함수는 평균 및 표준 편차로 운임 분포를 표준화하기 위해 사용자 지정 변환의 일부로 적용됩니다.

다음 코드를 참조하십시오.

NumPy 및 SciPy를 사용한 제약 조건 최적화

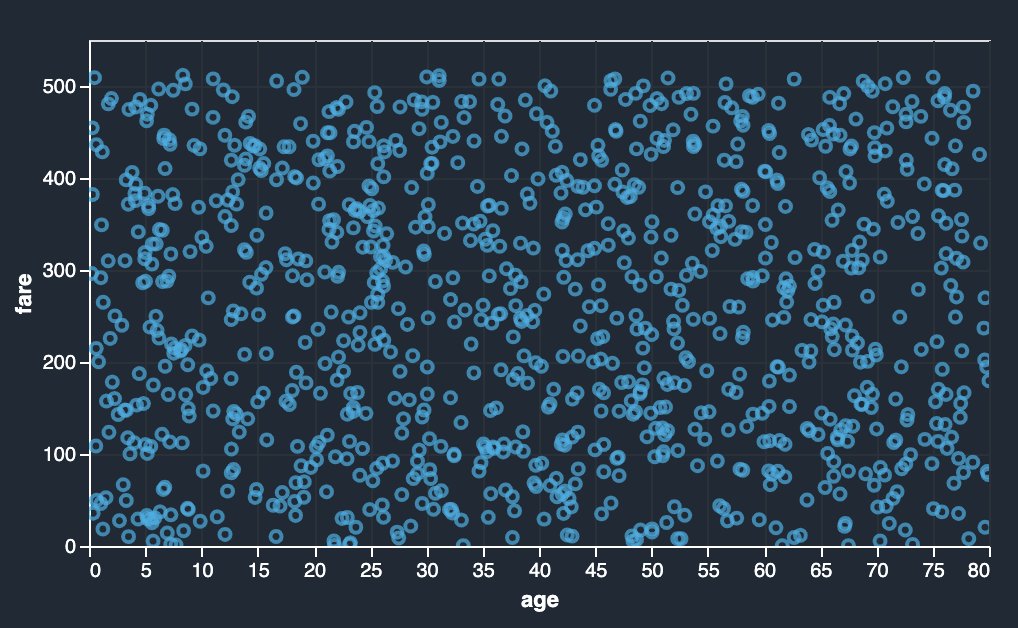

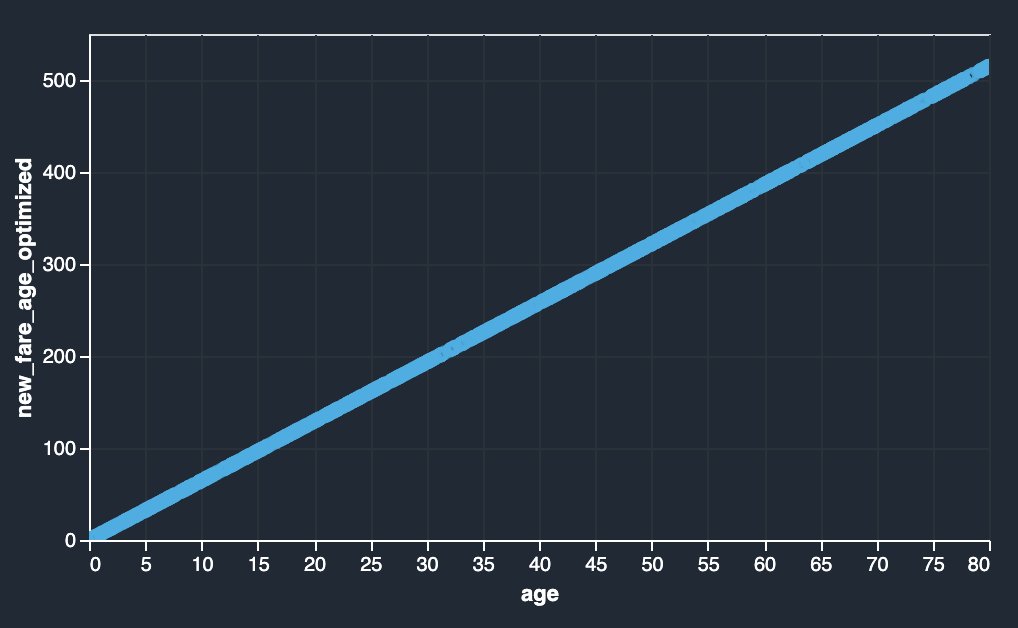

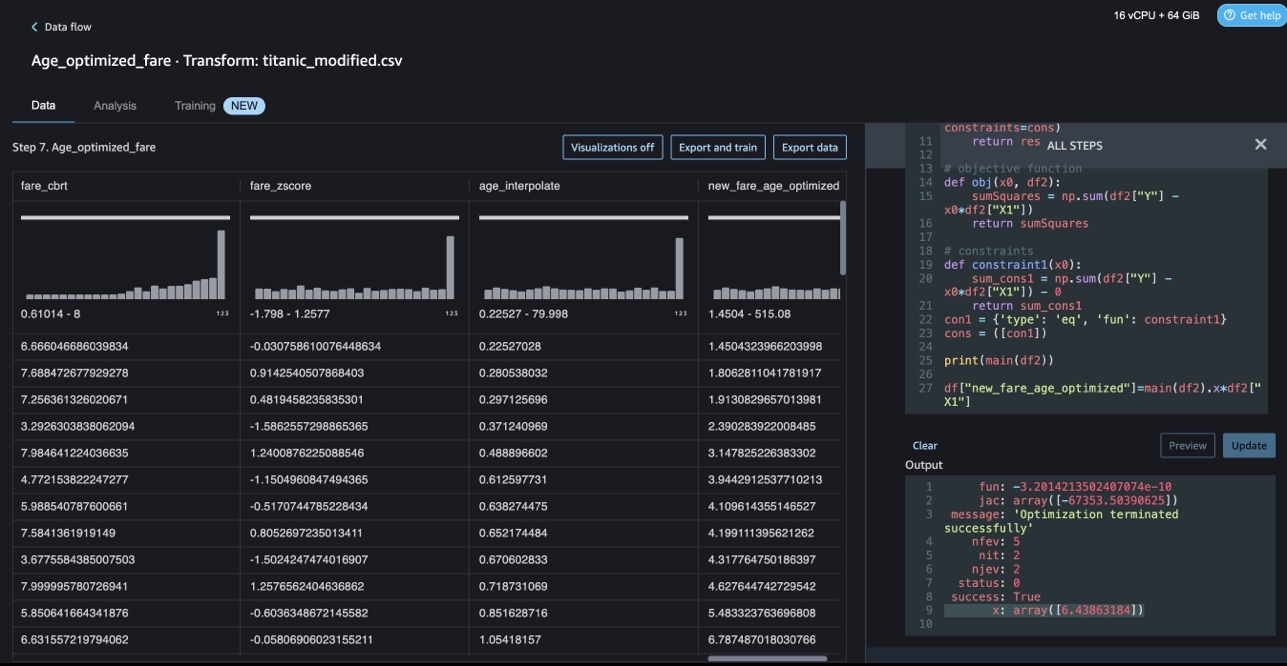

Data Wrangler 사용자 지정 변환은 SciPy 최적화 기능을 적용하고 SciPy를 NumPy와 결합하는 제약 조건 최적화와 같은 고급 변환을 처리할 수 있습니다. 다음 예에서 나이 함수로서의 운임은 관찰 가능한 추세를 보여주지 않습니다. 그러나 제약 조건 최적화는 요금을 나이의 함수로 변환할 수 있습니다. 이 경우 제약 조건은 새 총 요금이 이전 총 요금과 동일하게 유지된다는 것입니다. 데이터 랭글러 사용자 지정 변환을 사용하면 SciPy 최적화 기능을 실행하여 제약 조건에서 요금을 나이 함수로 변환할 수 있는 최적의 계수를 결정할 수 있습니다.

|

|

SciPy 및 NumPy를 사용하여 Data Wrangler 사용자 지정 변환에서 제약 조건 최적화를 공식화하는 동안 최적화 정의, 목표 정의 및 여러 제약 조건을 다른 함수로 언급할 수 있습니다. 사용자 지정 변환은 SciPy 최적화 패키지의 일부로 사용할 수 있는 다양한 해결 방법을 가져올 수도 있습니다. 데이터 랭글러의 기존 열에 원래 열에 최적의 계수를 곱하여 새로운 변환 변수를 생성할 수 있습니다. 다음 코드를 참조하십시오.

Data Wrangler 사용자 지정 변환 기능에는 최적 계수 값(또는 여러 계수)과 같은 SciPy 최적화 함수의 결과를 표시하는 UI 기능이 있습니다.

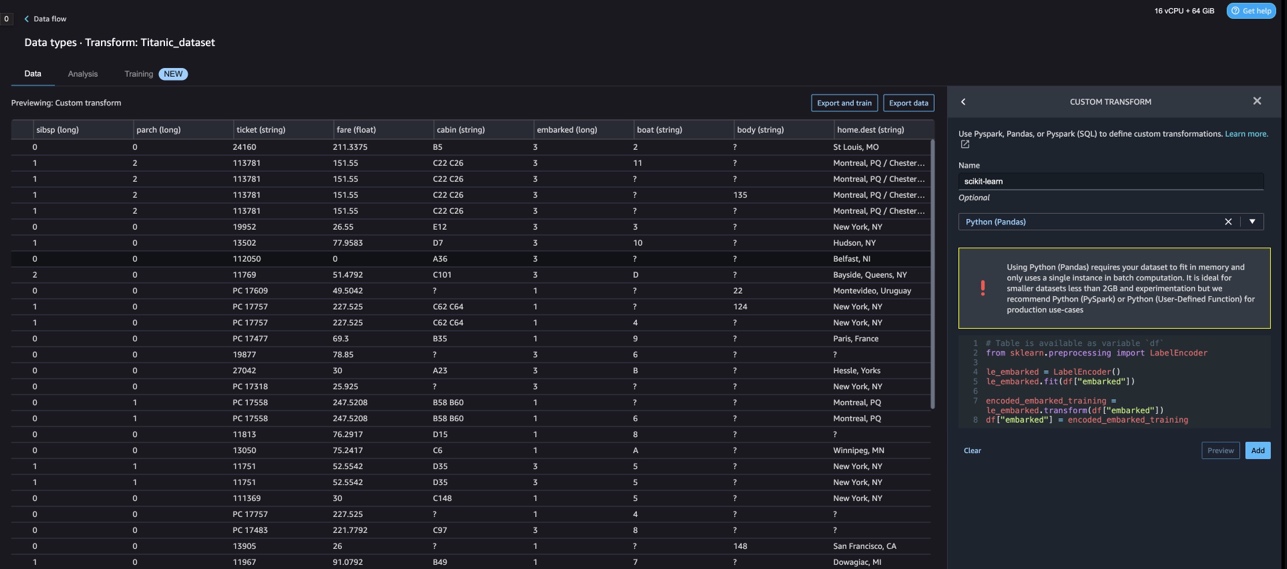

scikit-learn을 사용한 사용자 정의 변환

사이 킷 학습 SciPy 위에 구축된 기계 학습용 Python 모듈입니다. 지도 및 비지도 학습을 지원하는 오픈 소스 ML 라이브러리입니다. 또한 모델 피팅, 데이터 전처리, 모델 선택, 모델 평가 및 기타 여러 유틸리티를 위한 다양한 도구를 제공합니다.

이산화

이산화 (또는 양자화 or 비닝) 연속 기능을 불연속 값으로 분할하는 방법을 제공합니다. 연속 특성이 있는 특정 데이터 세트는 이산화를 통해 이점을 얻을 수 있습니다. 이산화는 연속 속성의 데이터 세트를 명목 속성만 있는 데이터 세트로 변환할 수 있기 때문입니다. 원-핫 인코딩된 이산 기능은 해석 가능성을 유지하면서 모델을 더욱 표현력 있게 만들 수 있습니다. 예를 들어 이산기를 사용한 전처리는 선형 모델에 비선형성을 도입할 수 있습니다.

다음 코드에서 우리는 KBinsDiscretizer 연령 열을 10개의 빈으로 이산화하려면 다음을 수행하십시오.

다음 스크린샷에서 빈 가장자리가 인쇄된 것을 볼 수 있습니다.

원-핫 인코딩

Embarked 열의 값은 범주형 값입니다. 따라서 모델로 분류를 수행하려면 이러한 문자열을 숫자 값으로 나타내야 합니다. 원-핫 인코딩 변환을 사용하여 이 작업을 수행할 수도 있습니다.

Embarked에는 S, C, Q의 세 가지 값이 있습니다. 이를 숫자로 나타냅니다. 다음 코드를 참조하십시오.

정리

Data Wrangler를 사용하지 않을 때는 추가 요금이 발생하지 않도록 Data Wrangler가 실행되는 인스턴스를 종료하는 것이 중요합니다.

Data Wrangler는 60초마다 데이터 흐름을 자동으로 저장합니다. 작업 손실을 방지하려면 Data Wrangler를 종료하기 전에 데이터 흐름을 저장하십시오.

- Studio에서 데이터 흐름을 저장하려면 입양 부모로서의 귀하의 적합성을 결정하기 위해 미국 이민국에다음을 선택 데이터 랭글러 흐름 저장.

- Data Wrangler 인스턴스를 종료하려면 Studio에서 다음을 선택합니다. 인스턴스 및 커널 실행.

- $XNUMX Million 미만 실행 중인 앱, sagemaker-data-wrangler-1.0 앱 옆에 있는 종료 아이콘을 선택합니다.

- 왼쪽 메뉴에서 모두 종료 확인.

Data Wrangler는 ml.m5.4xlarge 인스턴스에서 실행됩니다. 이 인스턴스는 다음에서 사라집니다. 실행 중인 인스턴스 데이터 랭글러 앱을 종료할 때.

Data Wrangler 앱을 종료한 후에는 다음에 Data Wrangler 흐름 파일을 열 때 다시 시작해야 합니다. 몇 분 정도 걸릴 수 있습니다.

결론

이 게시물에서는 Data Wrangler에서 사용자 정의 변환을 사용하는 방법을 시연했습니다. 내장된 데이터 변환 기능을 확장하기 위해 Data Wrangler 컨테이너 내의 라이브러리와 프레임워크를 사용했습니다. 이 게시물의 예제는 사용된 프레임워크의 하위 집합을 나타냅니다. 이제 Data Wrangler 흐름의 변환을 DataOps용 파이프라인으로 확장할 수 있습니다.

Data Wrangler에서 데이터 흐름을 사용하는 방법에 대한 자세한 내용은 다음을 참조하십시오. 데이터 랭글러 흐름 생성 및 사용 및 Amazon SageMaker 요금. Data Wrangler를 시작하려면 다음을 참조하세요. Amazon SageMaker Data Wrangler로 ML 데이터 준비. SageMaker의 Autopilot 및 AutoML에 대해 자세히 알아보려면 다음을 방문하십시오. Amazon SageMaker Autopilot으로 모델 개발 자동화.

저자 소개

미낙시순다람 탄다바라얀 AWS의 수석 AI/ML 전문가입니다. 그는 AI 및 ML 여정에서 하이테크 전략 계정을 돕습니다. 그는 데이터 기반 AI에 대해 매우 열정적입니다.

미낙시순다람 탄다바라얀 AWS의 수석 AI/ML 전문가입니다. 그는 AI 및 ML 여정에서 하이테크 전략 계정을 돕습니다. 그는 데이터 기반 AI에 대해 매우 열정적입니다.

소빅 쿠마르 나트 AWS의 AI/ML 솔루션 아키텍트입니다. 그는 기계 학습을 위한 종단 간 설계 및 솔루션에 대한 광범위한 경험을 가지고 있습니다. 재무, 운영 및 마케팅 분석 내의 비즈니스 분석; 보건 의료; 공급망; 그리고 IoT. 업무 외에는 여행과 영화 감상을 즐깁니다.

소빅 쿠마르 나트 AWS의 AI/ML 솔루션 아키텍트입니다. 그는 기계 학습을 위한 종단 간 설계 및 솔루션에 대한 광범위한 경험을 가지고 있습니다. 재무, 운영 및 마케팅 분석 내의 비즈니스 분석; 보건 의료; 공급망; 그리고 IoT. 업무 외에는 여행과 영화 감상을 즐깁니다.

애비 게일 Amazon SageMaker의 소프트웨어 개발 엔지니어입니다. 그녀는 고객이 DataWrangler에서 데이터를 준비하도록 돕고 분산 기계 학습 시스템을 구축하는 데 열정적입니다. 여가 시간에 Abigail은 여행, 하이킹, 스키, 베이킹을 즐깁니다.

애비 게일 Amazon SageMaker의 소프트웨어 개발 엔지니어입니다. 그녀는 고객이 DataWrangler에서 데이터를 준비하도록 돕고 분산 기계 학습 시스템을 구축하는 데 열정적입니다. 여가 시간에 Abigail은 여행, 하이킹, 스키, 베이킹을 즐깁니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- 플라토 블록체인. Web3 메타버스 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 미래 만들기 w Adryenn Ashley. 여기에서 액세스하십시오.

- 출처: https://aws.amazon.com/blogs/machine-learning/authoring-custom-transformations-in-amazon-sagemaker-data-wrangler-using-nltk-and-scipy/

- :있다

- :이다

- $UP

- 1

- 10

- 100

- 7

- 8

- 9

- a

- 소개

- 계정

- 추가

- 추가

- 주소

- 많은

- 후

- 시대

- AI

- AI 서비스

- AI / ML

- All

- 수

- 따라

- 이기는하지만

- 아마존

- 아마존 이해

- 아마존 세이지 메이커

- Amazon SageMaker 데이터 랭글러

- 분석

- 분석

- 분석하다

- 및

- 앤드류

- 다른

- 어떤

- 아파치

- 앱

- 어플리케이션

- 적용된

- 적용

- 접근

- 아키텍처

- 있군요

- AS

- At

- 속성

- 인증

- 저자

- 저작

- 자동적으로

- AutoML

- 가능

- AWS

- BE

- 때문에

- 가

- 된

- 전에

- 이익

- BIN

- 탑승

- 가져

- 빌드

- 건물

- 내장

- 내장

- 사업

- by

- CAN

- 기능

- 케이스

- 가지 경우

- 어떤

- 체인

- 이전 단계로 돌아가기

- 변경

- 왼쪽 메뉴에서

- 분류

- 암호

- 코딩

- 수집

- 단

- 열

- 결합

- 결합

- 공통의

- 커뮤니티

- 기업

- 완전한

- 이해하다

- 포괄적 인

- 컴퓨팅

- 조건

- 조건

- 확인하기

- 단점

- 제약

- 포함하는

- 컨테이너

- 함유량

- 끊임없는

- 수

- 두

- 만들

- 관습

- 고객

- 데이터

- 데이터 분석

- 데이터 준비

- 데이터 중심

- 데이터 세트

- 태만

- 시연

- 디자인

- 디자인

- 결정

- 개발

- 개발

- 개발

- 일탈

- 다른

- 발견

- 토론

- 분산

- 분포

- 문서

- 서류

- 하지 않습니다

- 도메인

- 아래 (down)

- 용이하게

- 사용하기 쉬운

- 효율적인

- 중

- 요소

- 끝으로 종료

- 기사

- 엔지니어링

- 우리의 영적인 행로를

- 엔티티

- 실재

- 환경

- 평가

- 모든

- 예

- 예

- 외

- 운동

- 현존하는

- 경험

- 나타내는

- 확장

- 광대 한

- 광범위한 경험

- 추출물

- FAST

- 빠른

- 특색

- 특징

- 지우면 좋을거같음 . SM

- 를

- 입양 부모로서의 귀하의 적합성을 결정하기 위해 미국 이민국에

- 파일

- 금융

- 입어 보기

- 흐름

- 흐름

- 초점

- 초점

- 따라

- 수행원

- 럭셔리

- 공식화

- 뼈대

- 프레임 워크

- 무료

- 진동수

- 에

- 장난

- 기능

- 기능

- 생성

- 생성

- 발전기

- 얻을

- 핸들

- 있다

- he

- 건강 관리

- 도움이

- 도움이

- 고도 첨단 기술

- 고수준

- 홈

- 방법

- 그러나

- HTML

- HTTP

- HTTPS

- 사람의

- ICON

- 식별하다

- 확인

- 통합 인증

- 영상

- import

- 중대한

- 가져 오기

- 개선

- in

- 기타의

- 정보

- 통찰력

- 설치

- 예

- 통합

- 완성

- 인텔리전스

- 인터페이스

- 소개

- IOT

- IT

- 일

- 여행

- JPG

- 키

- 알려진

- 언어

- 성

- 지도

- 배우다

- 배우기

- 도서관

- 도서관

- 처럼

- 작은

- 지는

- 기계

- 기계 학습

- 유지 보수

- 확인

- .

- 마케팅

- 거대한

- 수학의

- XNUMX월..

- 말하는

- 방법

- 수도

- 회의록

- ML

- 모델

- 모델

- 모듈

- 모듈

- 배우기

- 움직임

- 영화 산업

- 여러

- 곱하기

- name

- 이름

- 자연의

- 자연 언어 처리

- 필요

- 신제품

- 다음 것

- nlp

- 노드

- 노드

- 수첩

- 번호

- 숫자

- numpy

- 목표

- of

- 제공

- 낡은

- on

- 온보드

- 온 보딩

- ONE

- 열 수

- 오픈 소스

- 운영

- 최적의

- 최적화

- 최적화

- 주문

- 실물

- 기타

- 그렇지 않으면

- 우리의

- 외부

- 위에

- 자신의

- 꾸러미

- 패키지

- 팬더

- 부품

- 열렬한

- 수행

- 구문

- 관로

- 플랫폼

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- ...을 더한

- 인기 문서

- 게시하다

- 사례

- Prepare

- 인쇄

- 처리

- 생산

- 프로파일 링

- 프로그램

- 제공

- 제공

- 목적

- 푸시

- Python

- 품질

- 빠른

- 닥치는대로의

- 살갗이 벗어 진

- 신뢰할 수있는

- 유적

- 대표

- 응답

- 결과

- return

- 리뷰

- 뿌리

- 달리기

- s

- 현자

- 같은

- 샘플 데이터세트

- 찜하기

- 시나리오

- 과학적인

- 사이 킷 학습

- 스크립트

- 초

- 안전하게

- 선택

- 연장자

- 별도의

- 서비스

- 서비스

- 설정

- 설치

- 공유

- 영상을

- 표시

- 표시

- 쇼

- 종료

- 종료

- 기호

- 신호

- 단순, 간단, 편리

- 단순화

- 단일

- 소프트웨어

- 소프트웨어 개발

- 해결책

- 솔루션

- 일부

- 출처

- 지우면 좋을거같음 . SM

- 불꽃

- 특별한

- 전문가

- 회전

- 분열

- 광장

- 표준

- 스타트

- 시작

- 통계

- 단계

- 단계

- 저장

- 저장

- 전략의

- 구조화

- 스튜디오

- 이러한

- 스위트

- 공급

- 공급망

- 지원

- 시스템은

- 테이블

- 받아

- 복용

- 태스크

- 테크니컬

- 그

- XNUMXD덴탈의

- 소스

- 그들의

- 따라서

- Bowman의

- 세

- 시간

- 에

- 토큰

- 토큰 화

- 토큰

- 검색을

- 상단

- 금액

- 변환

- 변환

- 변환

- 변환

- 변화

- 여행

- 경향

- ui

- 아래에

- 사용

- 유스 케이스

- 익숙한

- 유용

- 가치

- 마케팅은:

- 여러

- 방문

- 시청

- 방법..

- 방법

- 잘

- 어느

- 동안

- 의지

- 과

- 이내

- 없이

- 말

- 작업

- 워크 플로우

- 쓰다

- 쓴

- 자신의

- 너의

- 제퍼 넷