데이터는 모든 분야와 모든 비즈니스를 변화시키고 있습니다. 그러나 데이터가 대부분의 회사가 추적할 수 있는 것보다 빠르게 증가함에 따라 데이터를 수집하고 해당 데이터에서 가치를 얻는 것은 어려운 일입니다. ㅏ 최신 데이터 전략 데이터로 더 나은 비즈니스 성과를 창출하는 데 도움이 될 수 있습니다. AWS는 다음을 위한 가장 완벽한 서비스 세트를 제공합니다. 엔드 투 엔드 데이터 여정 당신을 도우 려고요 데이터에서 가치 창출 그리고 그것을 통찰로 바꾸십시오.

데이터 과학자는 기계 학습(ML) 프로젝트를 위해 데이터를 준비하는 데 시간의 최대 80%를 사용할 수 있습니다. 이 준비 프로세스는 대체로 차별화되지 않고 지루한 작업이며 여러 프로그래밍 API 및 사용자 정의 라이브러리를 포함할 수 있습니다. Amazon SageMaker 데이터 랭글러 데이터 과학자와 데이터 엔지니어가 시각적 인터페이스를 통해 표 형식 및 시계열 데이터 준비와 기능 엔지니어링을 단순화하고 가속화할 수 있도록 지원합니다. 다음과 같은 여러 데이터 소스에서 데이터를 가져올 수 있습니다. 아마존 단순 스토리지 서비스 (아마존 S3), 아마존 아테나, 아마존 레드 시프트또는 다음과 같은 타사 솔루션 눈송이 or 데이터브릭, 300개 이상의 내장 데이터 변환 및 코드 조각 라이브러리로 데이터를 처리하므로 코드를 작성하지 않고도 기능을 신속하게 정규화, 변환 및 결합할 수 있습니다. PySpark, SQL 또는 Pandas에서 사용자 지정 변환을 가져올 수도 있습니다.

이 게시물은 데이터 준비 작업이 자동으로 실행되도록 예약하는 방법을 보여줍니다. 또한 매개 변수화된 URI를 통해 데이터 흐름에 포함할 파일을 지정할 수 있는 매개 변수화된 데이터 세트의 새로운 Data Wrangler 기능을 살펴봅니다.

솔루션 개요

Data Wrangler는 이제 매개변수화된 URI를 사용한 데이터 가져오기를 지원합니다. 이제 URI에서 String, Number, Datetime 및 Pattern 유형일 수 있는 지정된 매개 변수와 일치하는 모든 데이터 세트를 가져올 수 있으므로 더 많은 유연성이 허용됩니다. 또한 이제 일정에 따라 데이터 랭글러 변환 작업을 트리거할 수 있습니다.

이 게시물에서는 Titanic 데이터 세트로 샘플 흐름을 생성하여 이 두 가지 새로운 Data Wrangler의 기능으로 실험을 시작할 수 있는 방법을 보여줍니다. 데이터 세트를 다운로드하려면 다음을 참조하십시오. Titanic - 재해로부터 머신 러닝.

사전 조건

이 게시물에 설명된 모든 기능을 사용하려면 최신 커널 버전의 Data Wrangler를 실행해야 합니다. 자세한 내용은 다음을 참조하십시오. 데이터 랭글러 업데이트. 또한 실행 중이어야 합니다. 아마존 세이지 메이커 스튜디오 JupyterLab 3. 현재 버전을 보고 업데이트하려면 다음을 참조하십시오. JupyterLab 버전 관리.

파일 구조

이 데모에서는 이 게시물에 설명된 단계를 재현하기 위해 복제해야 하는 간단한 파일 구조를 따릅니다.

- 스튜디오에서, 새 노트북 만들기.

- 다음 코드 스니펫을 실행하여 사용하는 폴더 구조를 만듭니다(파일 트리에서 원하는 폴더에 있는지 확인).

- 복사

train.csv와test.csv원본 타이타닉 데이터세트의 파일을 폴더로titanic_dataset/train와titanic_dataset/test각각. - 다음 코드 스니펫을 실행하여 필요한 파일로 폴더를 채웁니다.

우리는 분할 train.csv Titanic 데이터세트의 파일을 이름이 지정된 XNUMX개의 다른 파일로 part_x, 여기서 x는 부품의 번호입니다. 파트 0에는 처음 100개의 레코드가 있고, 파트 1에는 다음 100개의 레코드가 있으며, 파트 8까지 계속됩니다. 파일 트리의 모든 노드 폴더에는 train 와 test 포함하는 폴더 train.csv 와 test.csv.

매개변수화된 데이터세트

Data Wrangler 사용자는 이제 Amazon S3에서 가져온 데이터 세트에 대한 매개변수를 지정할 수 있습니다. 데이터세트 매개변수는 리소스의 URI에 지정되며 해당 값을 동적으로 변경할 수 있으므로 가져오려는 파일을 더 유연하게 선택할 수 있습니다. 매개변수는 네 가지 데이터 유형일 수 있습니다.

- 번호 – 모든 정수의 값을 취할 수 있습니다.

- 끈 – 모든 텍스트 문자열의 값을 취할 수 있습니다.

- 무늬 – 모든 정규 표현식의 값을 사용할 수 있습니다.

- 날짜 시간 – 지원되는 날짜/시간 형식의 값을 사용할 수 있습니다.

이 섹션에서는 이 새로운 기능에 대한 연습을 제공합니다. 이는 데이터 세트를 현재 흐름으로 가져온 후에만 사용할 수 있으며 Amazon S3에서 가져온 데이터 세트에만 사용할 수 있습니다.

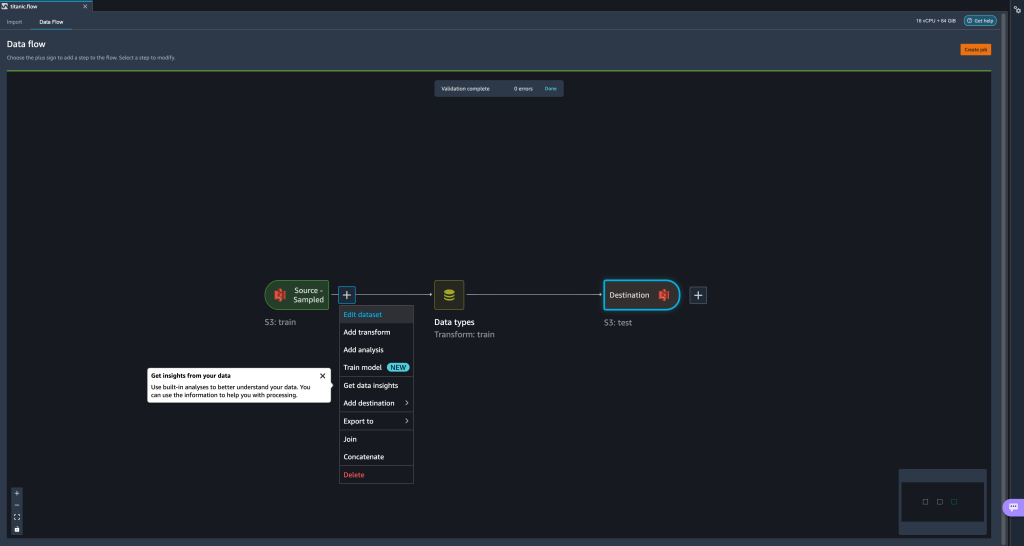

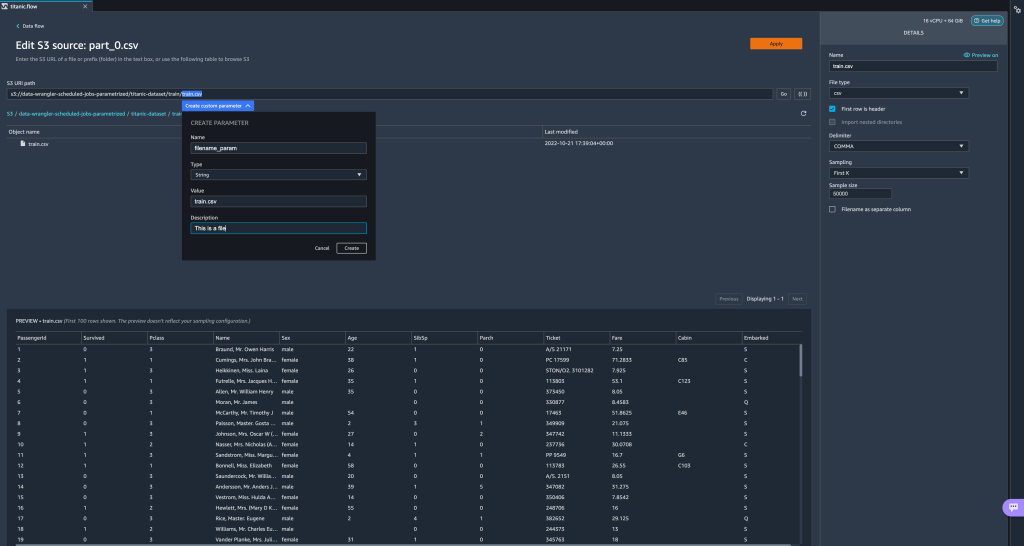

- 데이터 흐름에서 가져오기 단계 옆에 있는 더하기(+) 기호를 선택하고 데이터 세트 수정.

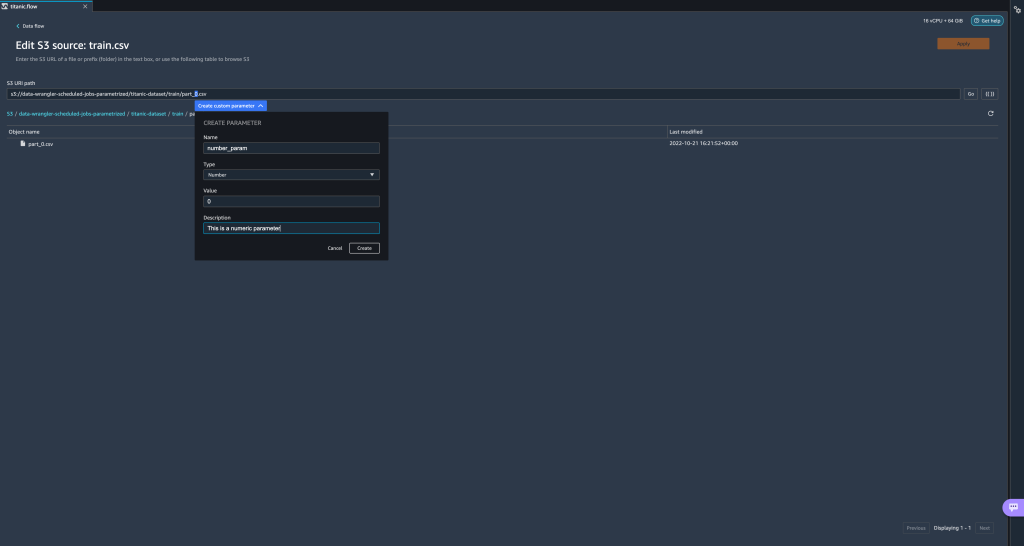

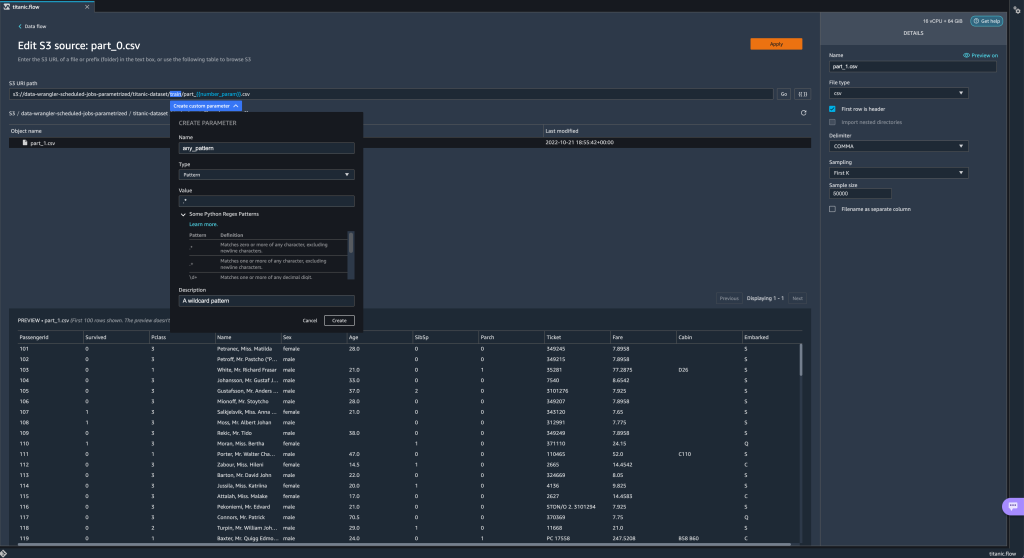

- 새 매개변수를 만드는 가장 선호되는(가장 쉬운) 방법은 URI 섹션을 강조 표시하고 선택하는 것입니다. 맞춤 매개 변수 만들기 드롭다운 메뉴에서 만들려는 각 매개변수에 대해 다음 네 가지를 지정해야 합니다.

- 성함

- 타입

- 기본값

- 상품 설명

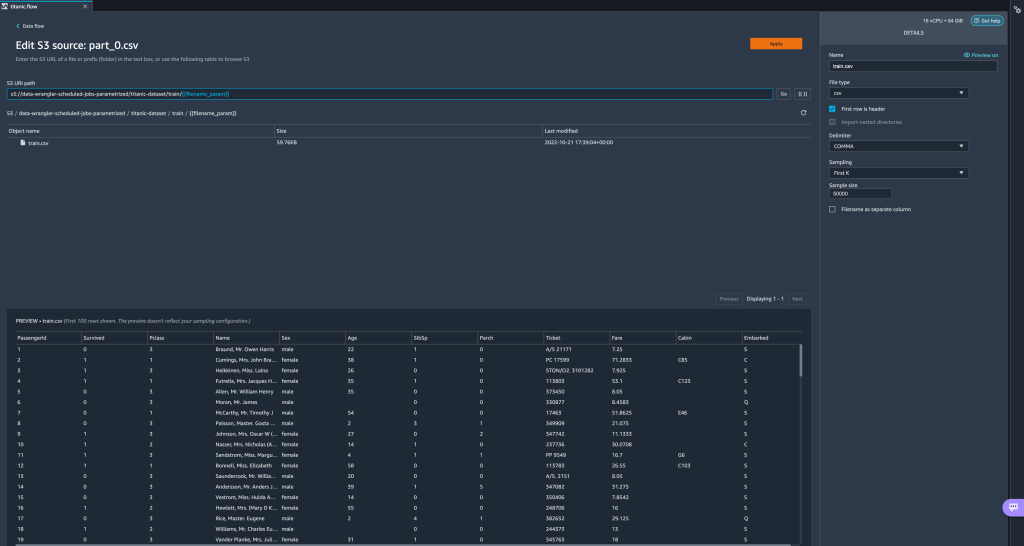

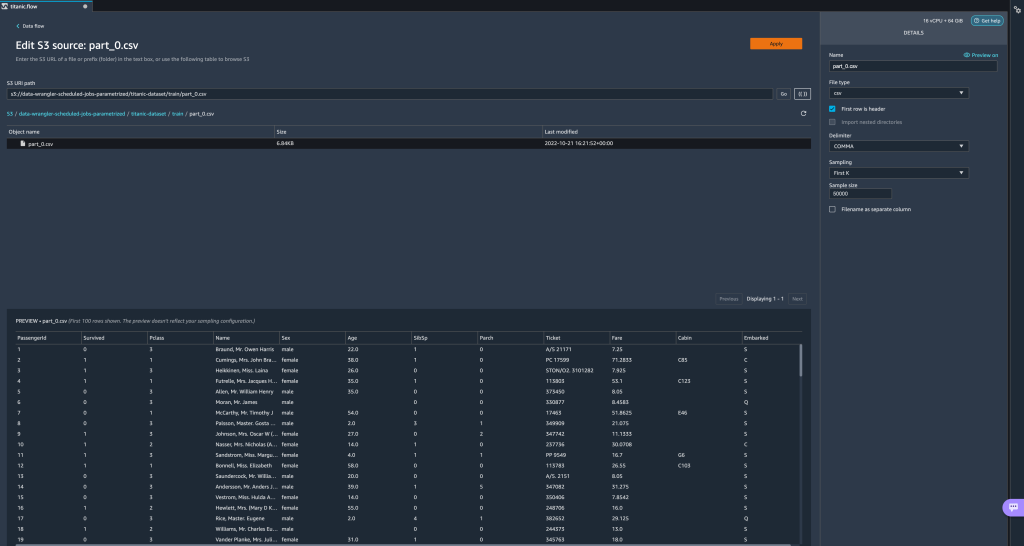

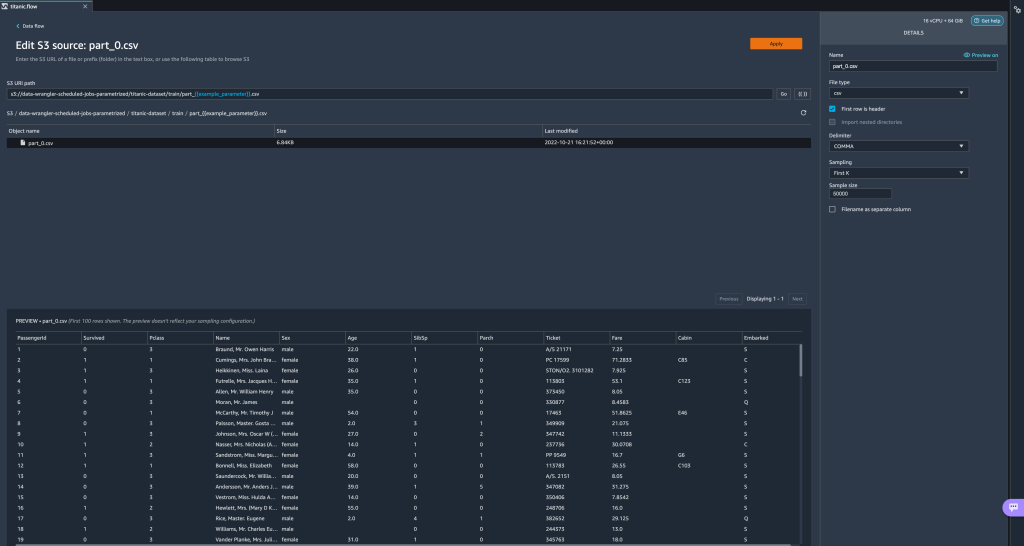

여기에서 라는 문자열 유형 매개변수를 만들었습니다.filename_param기본값 :train.csv. 이제 이전에 강조 표시한 URI 부분을 대체하는 이중 괄호로 묶인 매개 변수 이름을 볼 수 있습니다. 이 매개변수에 대해 정의된 값이train.csv, 이제 파일이 표시됩니다.train.csv가져오기 테이블에 나열됩니다.

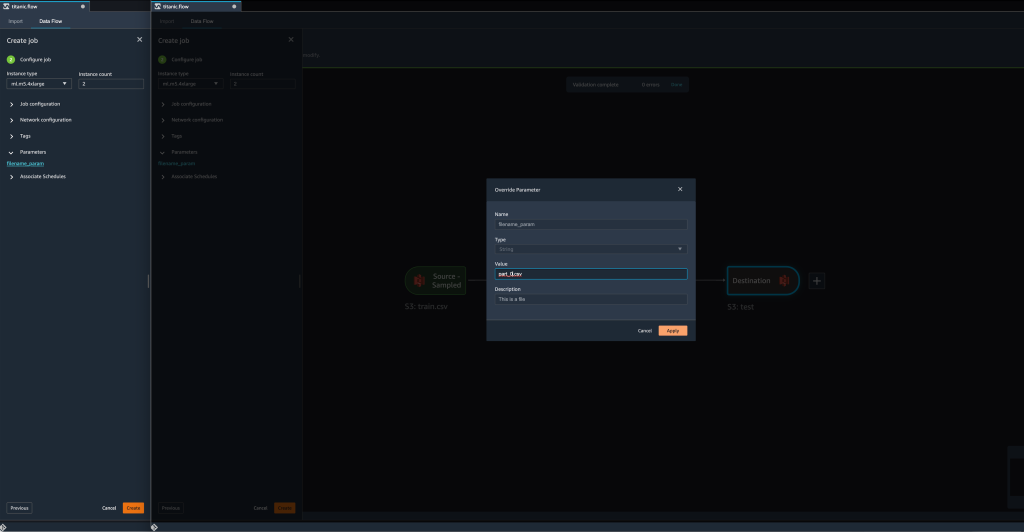

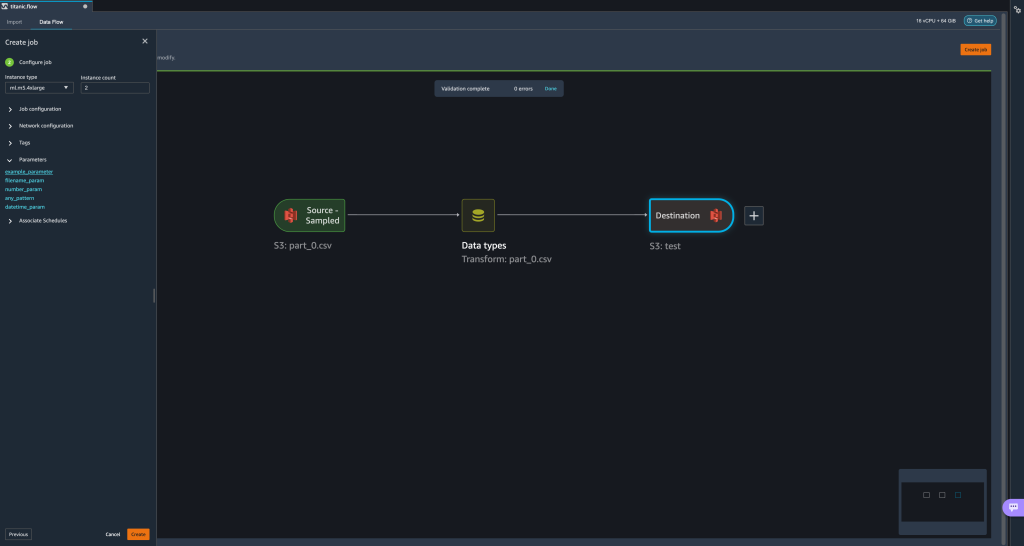

- 변환 작업을 만들려고 하면 작업 구성 단계, 우리는 이제 파라미터 섹션에서 정의된 모든 매개변수 목록을 볼 수 있습니다.

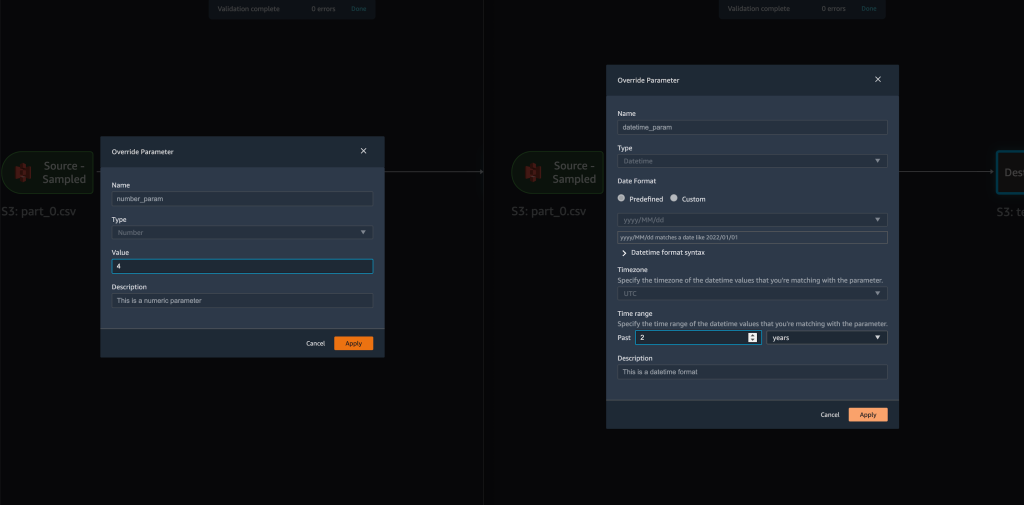

- 매개변수를 선택하면 매개변수 값을 변경할 수 있는 옵션이 제공됩니다. 이 경우 정의된 흐름에 따라 변환할 입력 데이터 세트를 변경합니다.

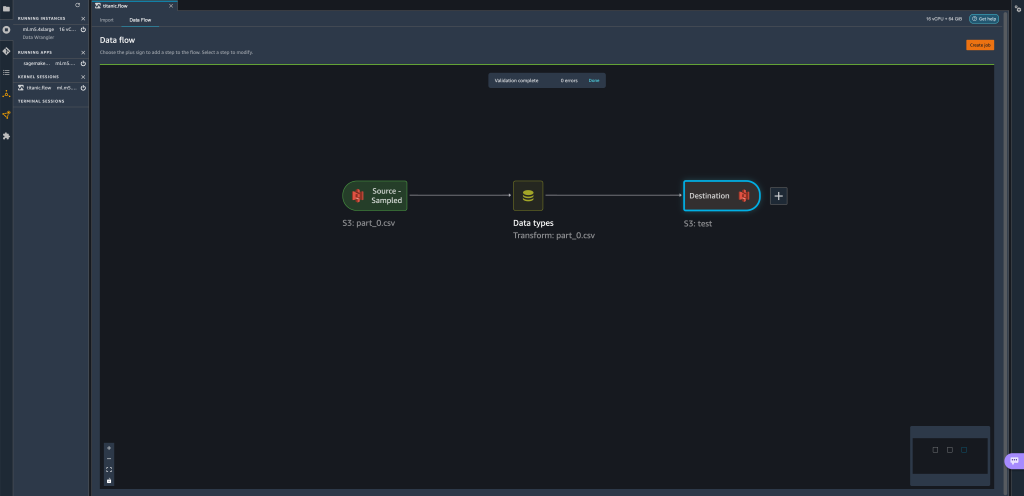

의 값을 변경한다고 가정합니다.filename_param에train.csv에part_0.csv, 변환 작업은 이제part_0.csv(이름이 있는 파일인 경우part_0.csv새 입력 데이터와 동일한 폴더에 있음).

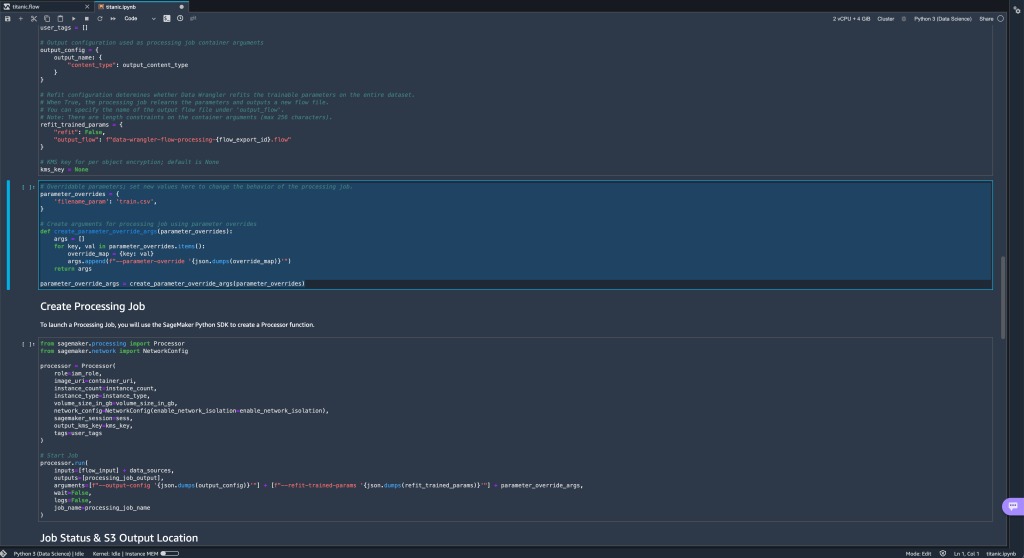

- 또한 Jupyter 노트북을 통해 흐름을 Amazon S3 대상으로 내보내려고 하면 이제 정의한 매개변수가 포함된 새 셀이 표시됩니다.

매개변수는 기본값을 사용하지만parameter_overrides사전(사전의 키는 변경하지 않고 그대로 둡니다).

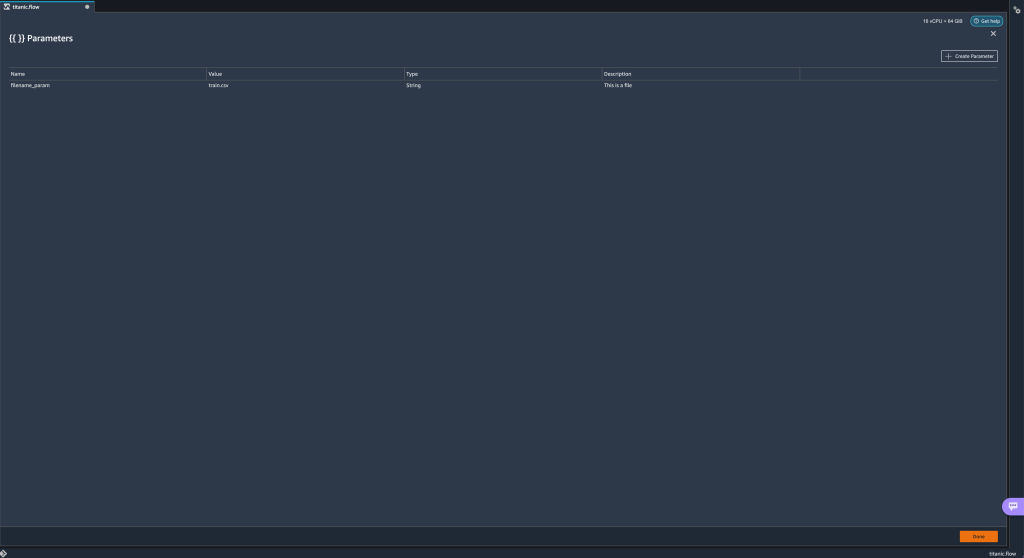

또한 다음에서 새 매개변수를 생성할 수 있습니다. 파라미터 UI. - 매개변수 아이콘({{}}) 옆에 위치 Go 옵션; 둘 다 URI 경로 값 옆에 있습니다.

흐름 파일(

흐름 파일(filename_param이 지점에서). - 다음을 선택하여 흐름에 대한 새 매개변수를 생성할 수 있습니다. 매개 변수 생성.

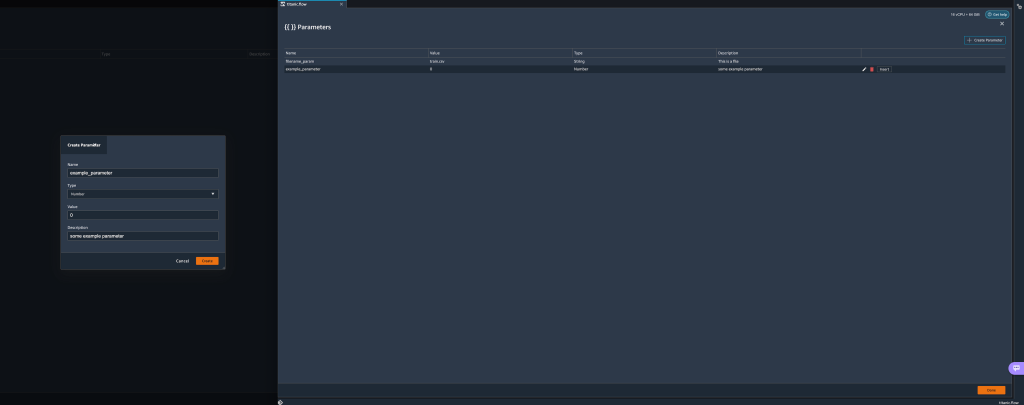

새 맞춤 매개변수를 만들 수 있는 팝업 창이 열립니다. - 여기에서 우리는 새로운

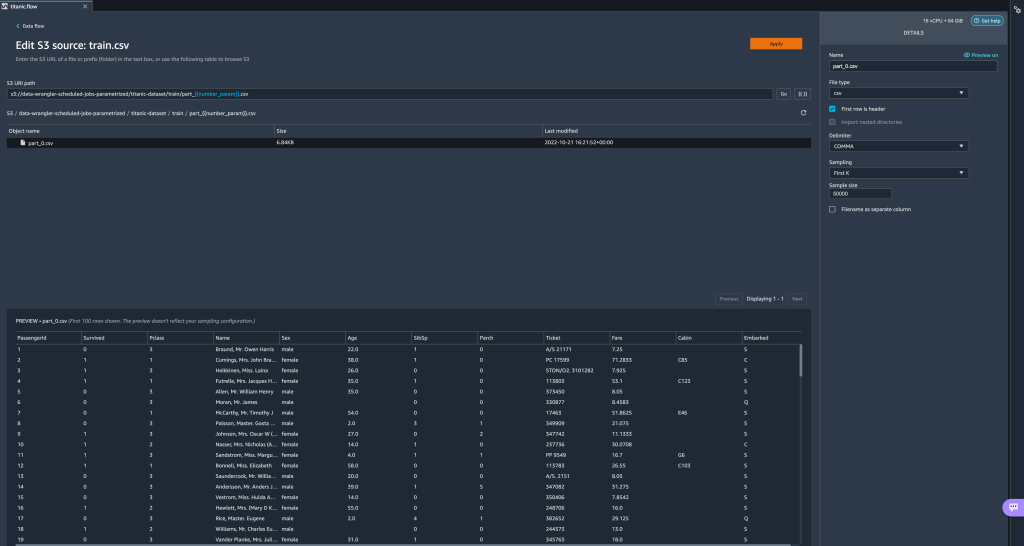

example_parameter기본값이 0인 숫자 유형으로. 새로 생성된 이 매개변수는 이제 파라미터 테이블. 매개변수 위로 마우스를 가져가면 옵션이 표시됩니다. 편집, .및 끼워 넣다.

- 내에서 파라미터 UI에서 원하는 매개변수를 선택하고 다음을 선택하여 매개변수 중 하나를 URI에 삽입할 수 있습니다. 끼워 넣다.

이렇게 하면 매개변수가 URI 끝에 추가됩니다. URI 내에서 원하는 섹션으로 이동해야 합니다.

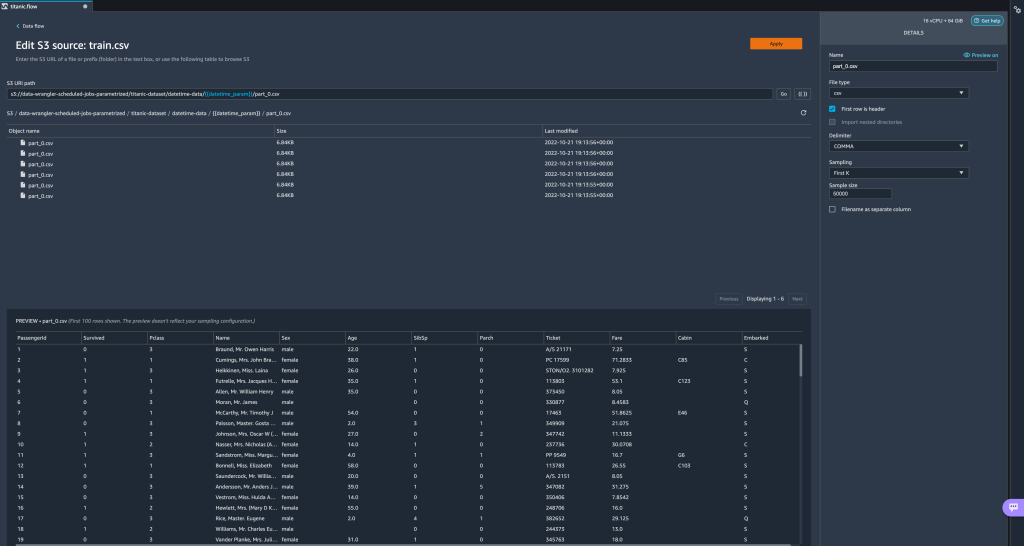

- 매개변수의 기본값을 변경하고 변경 사항을 적용합니다(모달에서). Go을 클릭하고 새로 고침 아이콘을 선택하여 새로 정의된 매개 변수 값을 기반으로 선택한 데이터 세트를 사용하여 미리 보기 목록을 업데이트합니다.

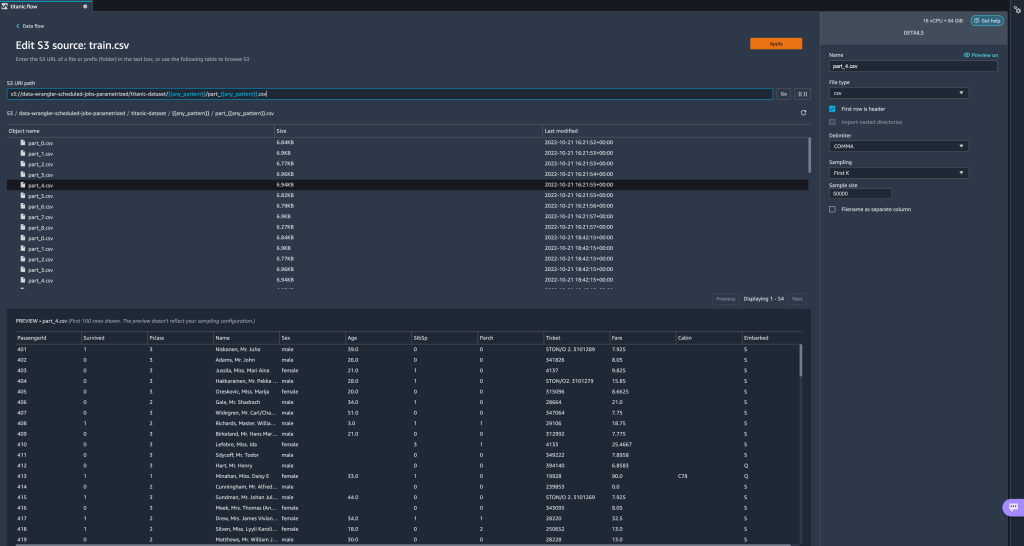

이제 다른 매개변수 유형을 살펴보겠습니다. 이제 데이터 세트가 여러 부분으로 분할되어 있고 각 파일에 부품 번호가 있다고 가정합니다.

이제 다른 매개변수 유형을 살펴보겠습니다. 이제 데이터 세트가 여러 부분으로 분할되어 있고 각 파일에 부품 번호가 있다고 가정합니다. - 파일 번호를 동적으로 변경하려면 다음 스크린샷과 같이 번호 매개변수를 정의할 수 있습니다.

선택한 파일은 매개변수에 지정된 번호와 일치하는 파일입니다.

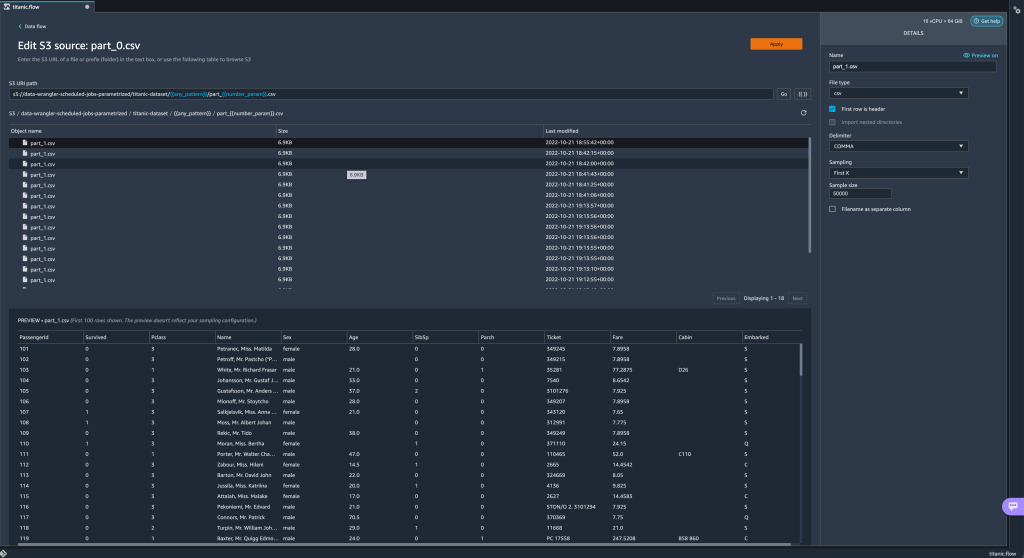

선택한 파일은 매개변수에 지정된 번호와 일치하는 파일입니다. 이제 Pattern 매개변수를 사용하는 방법을 보여드리겠습니다. 모든 것을 가져오고 싶다고 가정합니다.

이제 Pattern 매개변수를 사용하는 방법을 보여드리겠습니다. 모든 것을 가져오고 싶다고 가정합니다. part_1.csv아래의 모든 폴더에 있는 파일titanic-dataset/폴더. 패턴 매개변수는 유효한 정규식을 사용할 수 있습니다. 예제로 표시된 몇 가지 정규식 패턴이 있습니다. - 라는 패턴 매개변수를 만듭니다.

any_pattern아래의 폴더 또는 파일과 일치titanic-dataset/기본값이 있는 폴더.*.와일드카드는 단일 *(별표)가 아니라 점도 포함합니다. - 강조

titanic-dataset/경로의 일부를 만들고 맞춤 매개변수를 만듭니다. 이번에는 다음을 선택합니다. 무늬 유형. 이 패턴은 호출된 모든 파일을 선택합니다.

이 패턴은 호출된 모든 파일을 선택합니다. part-1.csv아래 폴더 중 하나에서titanic-dataset/. 매개변수는 경로에서 두 번 이상 사용할 수 있습니다. 다음 예에서는 새로 생성된 매개변수를 사용합니다.

매개변수는 경로에서 두 번 이상 사용할 수 있습니다. 다음 예에서는 새로 생성된 매개변수를 사용합니다. any_pattern아래의 폴더 중 하나에 있는 부품 파일과 일치하도록 URI에서 두 번titanic-dataset/. 마지막으로 Datetime 매개변수를 만들어 보겠습니다. 날짜/시간 매개변수는 아마존 키네 시스 데이터 파이어 호스 (참조 Kinesis Data Firehose의 동적 파티셔닝). 이 데모에서는 datetime-data 폴더 아래의 데이터를 사용합니다.

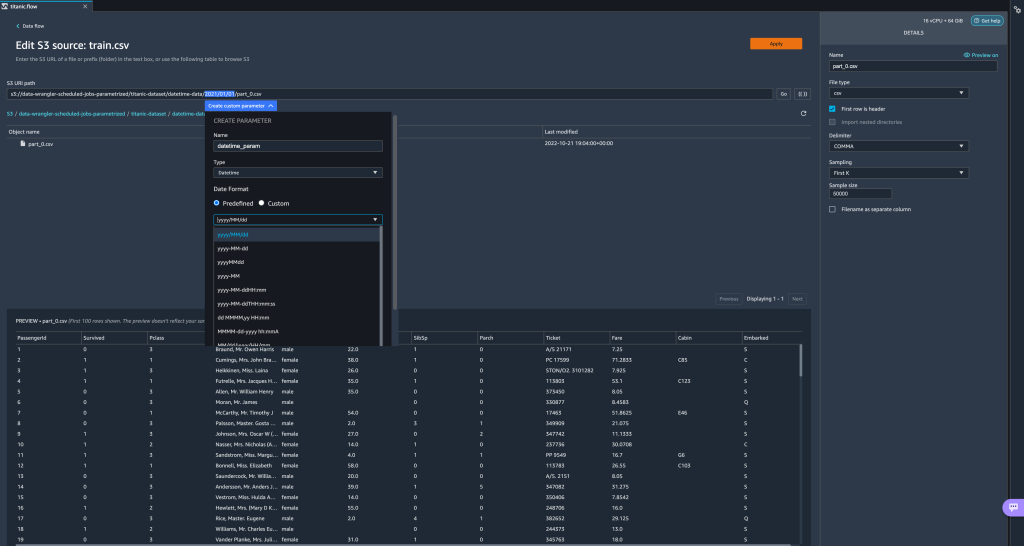

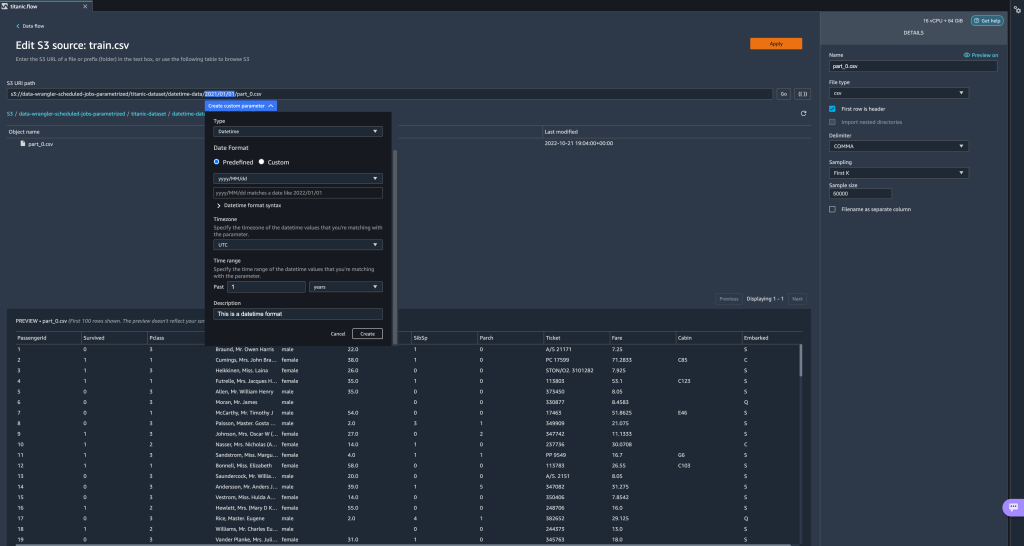

마지막으로 Datetime 매개변수를 만들어 보겠습니다. 날짜/시간 매개변수는 아마존 키네 시스 데이터 파이어 호스 (참조 Kinesis Data Firehose의 동적 파티셔닝). 이 데모에서는 datetime-data 폴더 아래의 데이터를 사용합니다. - 경로에서 날짜/시간 부분을 선택하고 맞춤 매개변수를 만듭니다. 선택 날짜 시간 매개변수 유형.

Datetime 데이터 유형을 선택할 때 더 자세한 정보를 입력해야 합니다. - 먼저 날짜 형식을 제공해야 합니다. 미리 정의된 날짜/시간 형식을 선택하거나 사용자 지정 형식을 만들 수 있습니다.

미리 정의된 날짜/시간 형식의 경우 범례는 선택한 형식과 일치하는 날짜의 예를 제공합니다. 이 데모에서는 형식을 선택합니다. yyyy/MM/dd.

- 다음으로 날짜/시간 값의 시간대를 지정합니다.

예를 들어 현재 날짜는 한 시간대에서는 1년 2022월 2일이지만 다른 시간대에서는 2022년 XNUMX월 XNUMX일일 수 있습니다. - 마지막으로 데이터 흐름에 포함할 파일 범위를 선택할 수 있는 시간 범위를 선택할 수 있습니다.

시간 범위를 시간, 일, 주, 월 또는 년 단위로 지정할 수 있습니다. 이 예에서는 작년의 모든 파일을 가져오려고 합니다. - 매개변수에 대한 설명을 제공하고 다음을 선택합니다. 만들기.

시간대가 다른 여러 데이터 세트를 사용하는 경우 시간이 자동으로 변환되지 않습니다. 하나의 시간대로 변환하려면 각 파일 또는 소스를 전처리해야 합니다. 선택한 파일은 작년 데이터에 해당하는 폴더 아래의 모든 파일입니다.

선택한 파일은 작년 데이터에 해당하는 폴더 아래의 모든 파일입니다.

- 이제 데이터 변환 작업을 생성하면 정의된 모든 매개변수 목록을 볼 수 있으며 변환 작업이 지정된 파일을 선택하도록 해당 기본값을 재정의할 수 있습니다.

처리 작업 예약

이제 처리 작업을 예약하여 데이터 변환 작업 실행을 자동화하고 변환된 데이터를 Amazon S3 또는 Amazon SageMaker 기능 스토어. 필요에 맞는 시간과 주기로 작업을 예약할 수 있습니다.

예약된 처리 작업 사용 아마존 이벤트 브리지 규칙 작업 실행을 예약합니다. 따라서 전제 조건으로 다음을 확인해야 합니다. AWS 자격 증명 및 액세스 관리 (IAM) Data Wrangler가 사용하는 역할, 즉 아마존 세이지 메이커 실행 역할 Studio 인스턴스의 EventBridge 규칙을 생성할 수 있는 권한이 있습니다.

IAM 구성

Data Wrangler 흐름이 실행 중인 Studio 인스턴스에 해당하는 IAM SageMaker 실행 역할에 대해 다음 업데이트를 진행합니다.

- 첨부 AmazonEventBridgeFullAccess 관리 정책.

- 처리 작업을 생성할 수 있는 권한을 부여하는 정책을 연결합니다.

- 다음 신뢰 정책을 추가하여 역할을 수임할 EventBridge 권한을 부여합니다.

또는 다른 역할을 사용하여 처리 작업을 실행하는 경우 2단계와 3단계에 설명된 정책을 해당 역할에 적용합니다. IAM 구성에 대한 자세한 내용은 다음을 참조하십시오. 새 데이터를 자동으로 처리하는 일정 만들기.

일정 만들기

일정을 만들려면 데이터 랭글러 흐름 편집기에서 흐름을 열어야 합니다.

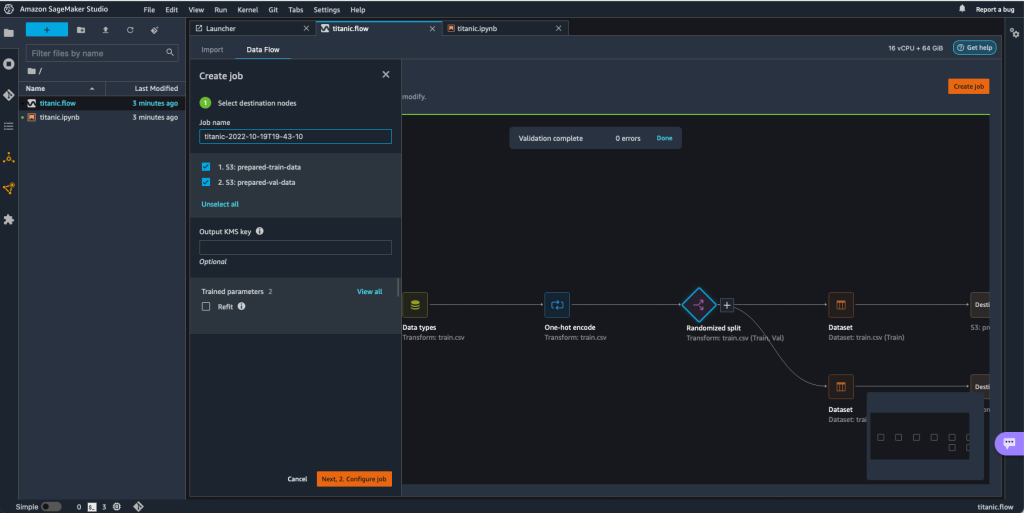

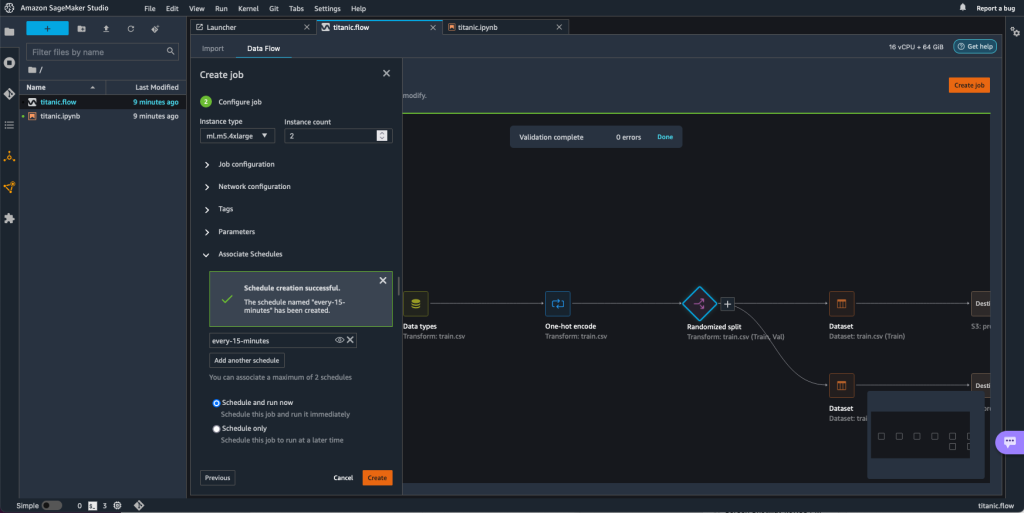

- 에 데이터 흐름 탭에서 직업 만들기.

- 필수 필드를 구성하고 선택했습니다. 다음, 2. 작업 구성.

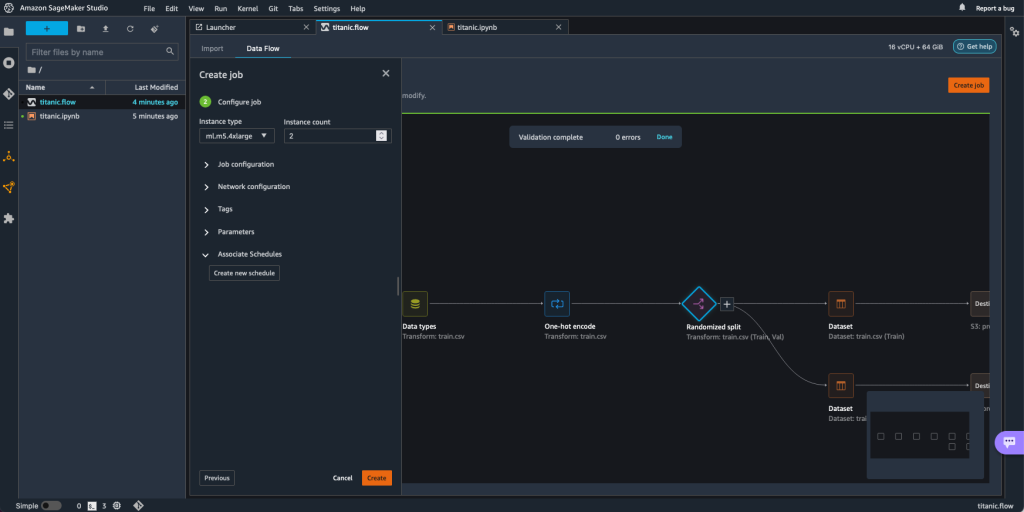

- 펼치기 일정 연결.

- 왼쪽 메뉴에서 새 일정 만들기.

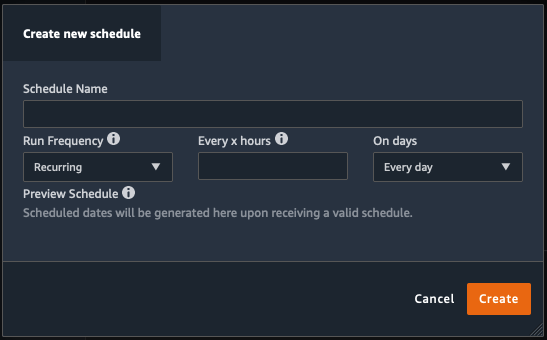

XNUMXD덴탈의 새 일정 만들기 처리 작업 일정의 세부 정보를 정의하는 대화 상자가 열립니다.

대화 상자는 일정을 정의하는 데 도움이 되는 뛰어난 유연성을 제공합니다. 예를 들어 특정 요일에 특정 시간 또는 X시간마다 처리 작업을 실행할 수 있습니다.

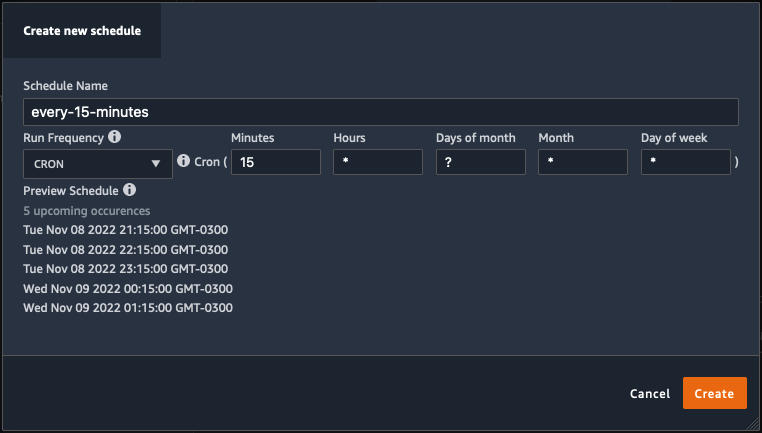

주기성은 분 단위로 세분화될 수 있습니다.

- 일정 이름과 주기를 정의한 다음 만들기 일정을 저장합니다.

- 향후 실행을 처리하는 예약과 함께 처리 작업을 즉시 시작하거나 일정에 따라서만 작업이 실행되도록 둘 수 있는 옵션이 있습니다.

- 동일한 처리 작업에 대해 추가 일정을 정의할 수도 있습니다.

- 처리 작업 일정을 완료하려면 다음을 선택합니다. 만들기.

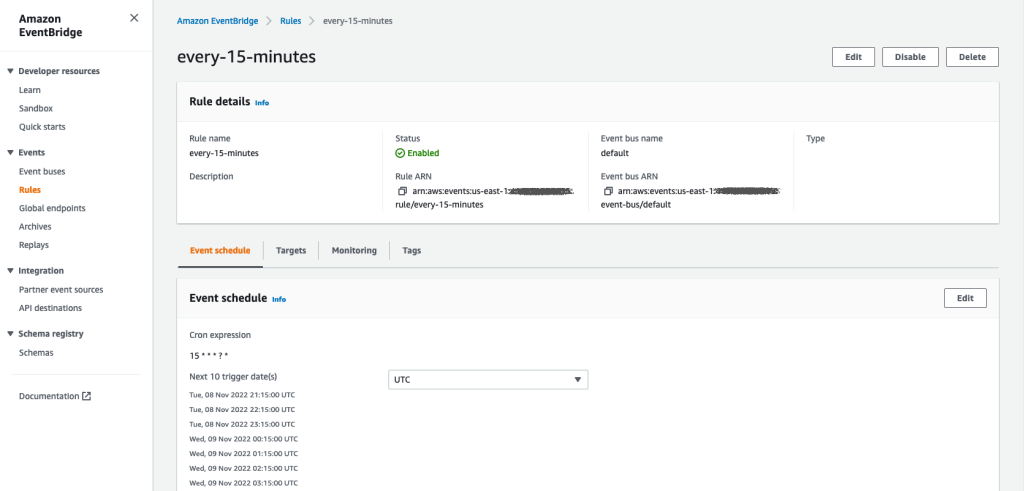

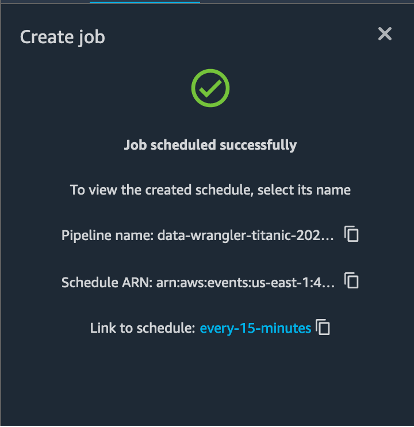

"작업 예약 성공" 메시지가 표시됩니다. 또한 일정에 따라서만 작업을 실행하도록 선택한 경우 방금 생성한 EventBridge 규칙에 대한 링크가 표시됩니다.

일정 링크를 선택하면 브라우저에서 새 탭이 열리고 EventBridge 규칙이 표시됩니다. 이 페이지에서 규칙을 추가로 수정하고 호출 기록을 추적할 수 있습니다. 예약된 처리 작업의 실행을 중지하려면 일정 이름이 포함된 이벤트 규칙을 삭제하십시오.

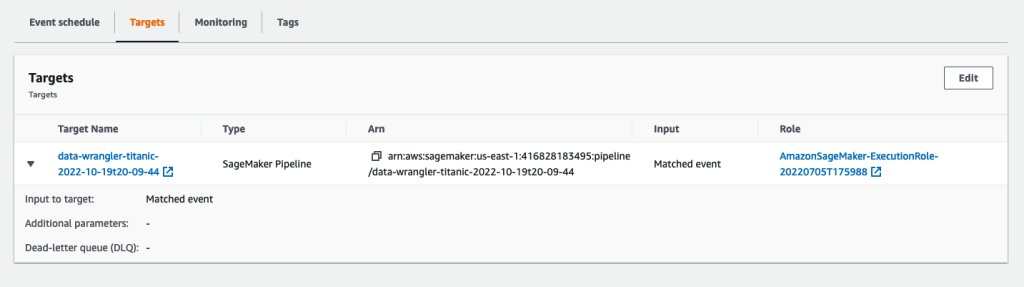

EventBridge 규칙은 정의된 일정에 따라 트리거되는 SageMaker 파이프라인을 대상으로 표시하고 파이프라인의 일부로 호출된 처리 작업을 보여줍니다.

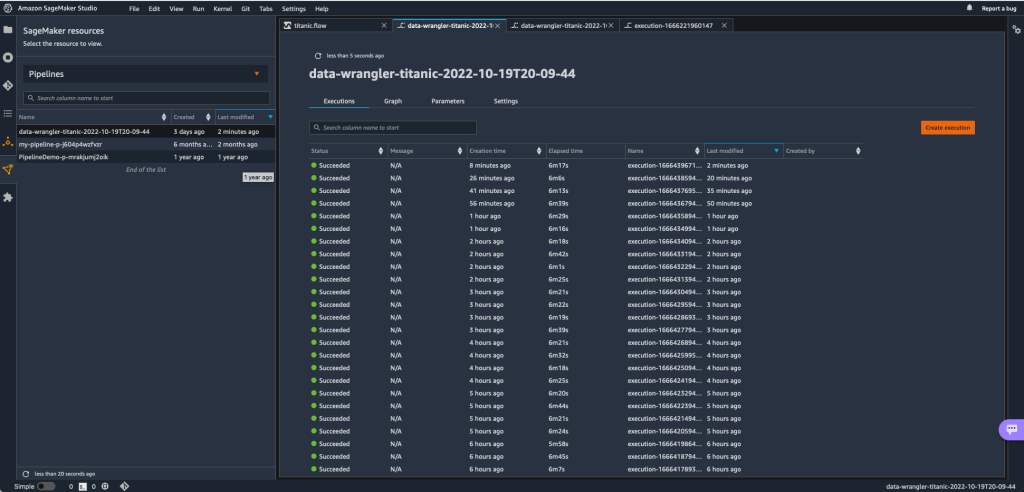

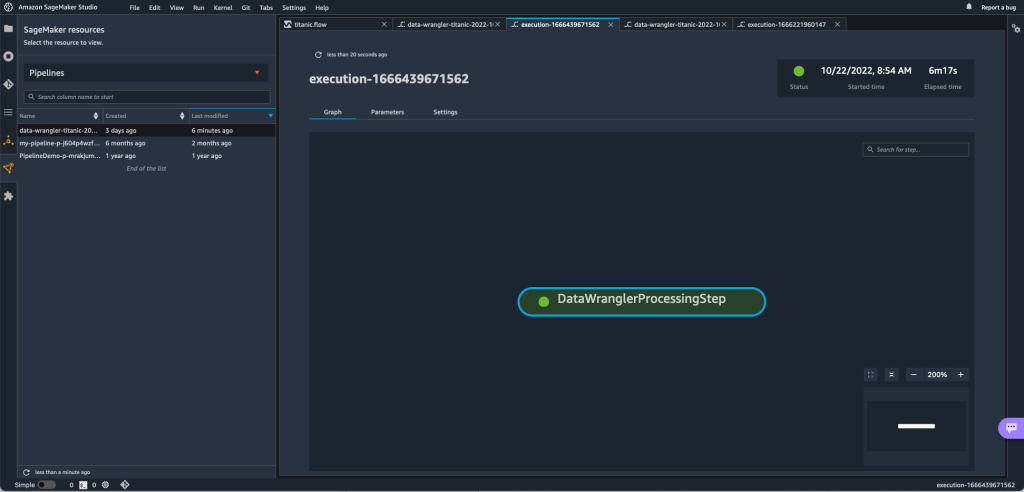

SageMaker 파이프라인의 실행을 추적하려면 Studio로 돌아가서 SageMaker 리소스 아이콘, 선택 파이프 라인, 추적하려는 파이프라인 이름을 선택합니다. 이제 모든 현재 및 과거 실행과 해당 파이프라인의 상태가 포함된 테이블을 볼 수 있습니다.

특정 항목을 두 번 클릭하면 자세한 내용을 볼 수 있습니다.

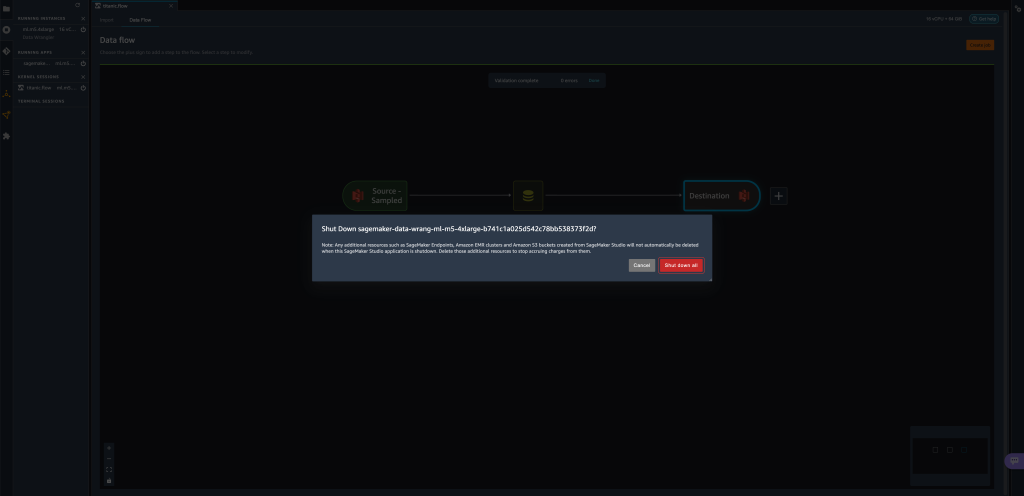

정리

Data Wrangler를 사용하지 않을 때는 추가 요금이 발생하지 않도록 실행 중인 인스턴스를 종료하는 것이 좋습니다.

작업 손실을 방지하려면 Data Wrangler를 종료하기 전에 데이터 흐름을 저장하십시오.

- Studio에서 데이터 흐름을 저장하려면 입양 부모로서의 귀하의 적합성을 결정하기 위해 미국 이민국에다음을 선택 데이터 랭글러 흐름 저장. Data Wrangler는 60초마다 데이터 흐름을 자동으로 저장합니다.

- Data Wrangler 인스턴스를 종료하려면 Studio에서 다음을 선택합니다. 인스턴스 및 커널 실행.

- $XNUMX Million 미만 실행 중인 앱, 옆에 있는 종료 아이콘을 선택합니다.

sagemaker-data-wrangler-1.0응용 프로그램.

- 왼쪽 메뉴에서 모두 종료 확인.

Data Wrangler는 ml.m5.4xlarge 인스턴스에서 실행됩니다. 이 인스턴스는 다음에서 사라집니다. 실행 중인 인스턴스 데이터 랭글러 앱을 종료할 때.

Data Wrangler 앱을 종료한 후에는 다음에 Data Wrangler 흐름 파일을 열 때 다시 시작해야 합니다. 몇 분 정도 걸릴 수 있습니다.

결론

이 게시물에서는 매개 변수를 사용하여 데이터 랭글러 흐름을 사용하여 데이터 세트를 가져오고 데이터 변환 작업을 생성하는 방법을 시연했습니다. 매개변수화된 데이터 세트를 사용하면 사용하는 데이터 세트에 더 많은 유연성을 제공하고 흐름을 재사용할 수 있습니다. 또한 Data Wrangler의 사용자 인터페이스 내에서 필요에 맞는 시간과 주기에 따라 데이터 변환 및 Amazon S3 또는 Feature Store로의 내보내기를 자동화하도록 예약된 작업을 설정하는 방법도 시연했습니다.

Data Wrangler에서 데이터 흐름을 사용하는 방법에 대한 자세한 내용은 다음을 참조하십시오. 데이터 랭글러 흐름 생성 및 사용 와 Amazon SageMaker 요금. Data Wrangler를 시작하려면 다음을 참조하세요. Amazon SageMaker Data Wrangler로 ML 데이터 준비.

저자 소개

데이비드 라레도 Amazon Web Services의 프로토타이핑 및 클라우드 엔지니어링 팀의 프로토타이핑 설계자로 AWS 고객을 위한 여러 기계 학습 프로토타입을 개발하는 데 도움을 주었습니다. 그는 지난 6년 동안 기계 학습 분야에서 일하면서 ML 모델을 훈련 및 미세 조정하고 엔드 투 엔드 파이프라인을 구현하여 해당 모델을 생산했습니다. 그의 관심 분야는 NLP, ML 애플리케이션 및 종단 간 ML입니다.

데이비드 라레도 Amazon Web Services의 프로토타이핑 및 클라우드 엔지니어링 팀의 프로토타이핑 설계자로 AWS 고객을 위한 여러 기계 학습 프로토타입을 개발하는 데 도움을 주었습니다. 그는 지난 6년 동안 기계 학습 분야에서 일하면서 ML 모델을 훈련 및 미세 조정하고 엔드 투 엔드 파이프라인을 구현하여 해당 모델을 생산했습니다. 그의 관심 분야는 NLP, ML 애플리케이션 및 종단 간 ML입니다.

지바닐도 알베스 Amazon Web Services의 프로토타이핑 및 클라우드 엔지니어링 팀의 프로토타이핑 설계자로 이미 인공 지능에 대한 여러 프로토타입을 구현한 경험이 있는 AWS에서 가능한 기술을 보여줌으로써 고객이 혁신하고 가속화할 수 있도록 지원합니다. 소프트웨어 엔지니어링 분야에서 오랜 경력을 쌓았으며 이전에는 Amazon.com.br에서 소프트웨어 개발 엔지니어로 근무했습니다.

지바닐도 알베스 Amazon Web Services의 프로토타이핑 및 클라우드 엔지니어링 팀의 프로토타이핑 설계자로 이미 인공 지능에 대한 여러 프로토타입을 구현한 경험이 있는 AWS에서 가능한 기술을 보여줌으로써 고객이 혁신하고 가속화할 수 있도록 지원합니다. 소프트웨어 엔지니어링 분야에서 오랜 경력을 쌓았으며 이전에는 Amazon.com.br에서 소프트웨어 개발 엔지니어로 근무했습니다.

아드리안 푸엔테스 Amazon Web Services의 프로토타이핑 및 클라우드 엔지니어링 팀의 프로그램 관리자로 기계 학습, IoT 및 블록체인 분야의 고객을 위해 혁신하고 있습니다. 그는 15년 이상의 프로젝트 관리 및 구현 경험과 AWS에서 1년의 재임 기간을 가지고 있습니다.

아드리안 푸엔테스 Amazon Web Services의 프로토타이핑 및 클라우드 엔지니어링 팀의 프로그램 관리자로 기계 학습, IoT 및 블록체인 분야의 고객을 위해 혁신하고 있습니다. 그는 15년 이상의 프로젝트 관리 및 구현 경험과 AWS에서 1년의 재임 기간을 가지고 있습니다.