우리는 영어 음성 인식에서 인간 수준의 견고성과 정확성에 접근하는 Whisper라는 신경망을 훈련하고 오픈소싱하고 있습니다.

코드보기

모델 카드 보기

속삭이는 예:

Whisper는 웹에서 수집된 680,000시간의 다국어 및 다중 작업 감독 데이터에 대해 훈련된 자동 음성 인식(ASR) 시스템입니다. 우리는 이처럼 크고 다양한 데이터 세트를 사용하면 악센트, 배경 소음 및 기술 언어에 대한 견고성이 향상된다는 것을 보여줍니다. 또한 여러 언어로 전사할 수 있을 뿐만 아니라 해당 언어에서 영어로 번역할 수 있습니다. 우리는 유용한 애플리케이션을 구축하고 강력한 음성 처리에 대한 추가 연구를 위한 기반으로 사용되는 모델 및 추론 코드를 공개합니다.

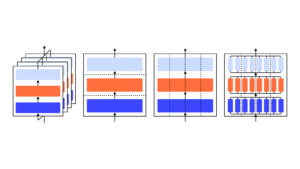

Whisper 아키텍처는 인코더-디코더 변환기로 구현되는 간단한 종단 간 접근 방식입니다. 입력 오디오는 30초 청크로 분할되어 log-Mel 스펙트로그램으로 변환된 다음 인코더로 전달됩니다. 디코더는 단일 모델이 언어 식별, 구문 수준 타임스탬프, 다국어 음성 전사 및 영어 음성 번역과 같은 작업을 수행하도록 지시하는 특수 토큰과 혼합된 해당 텍스트 캡션을 예측하도록 훈련됩니다.

다른 기존 접근 방식은 더 작고 더 밀접하게 쌍을 이루는 오디오 텍스트 교육 데이터 세트를 자주 사용합니다., 또는 광범위하지만 감독되지 않은 오디오 사전 교육을 사용합니다.. Whisper는 크고 다양한 데이터 세트에 대해 교육을 받았고 특정 데이터 세트에 대해 미세 조정되지 않았기 때문에 음성 인식에서 유명한 경쟁 벤치마크인 LibriSpeech 성능을 전문으로 하는 모델을 능가하지 않습니다. 그러나 다양한 데이터 세트에서 Whisper의 제로샷 성능을 측정할 때 훨씬 더 강력하고 이러한 모델보다 오류가 50% 더 적습니다.

Whisper 오디오 데이터 세트의 약 2분의 XNUMX은 영어가 아니며 원래 언어로 전사하거나 영어로 번역하는 작업이 번갈아 주어집니다. 우리는 이 접근 방식이 음성 대 텍스트 번역 학습에 특히 효과적이며 CoVoSTXNUMX에서 영어로 번역 제로샷으로 감독되는 SOTA를 능가한다는 것을 발견했습니다.

Whisper의 높은 정확도와 사용 편의성을 통해 개발자는 훨씬 더 광범위한 애플리케이션에 음성 인터페이스를 추가할 수 있기를 바랍니다. 체크 아웃 종이, 모델 카드및 암호 자세한 내용을 알아보고 Whisper를 사용해 보세요.