주말을 위한 것 로봇이 내 문 앞에서 해석적인 춤을 추고 있다.

이웃을 위해 이 소포를 가져가시겠습니까? 그것은 한 발에서 다른 발로 뛰어다니며 묻는다.

"물론이지." 내가 말한다. "어... 괜찮아?"

나는 감정을 표현하고 있다, 배달 봇이 패키지를 건네주지만 더 이상의 설명은 제공하지 않는다고 말합니다.

어떤 감정일 수 있습니까? 한 발, 다른 발, 다른 두 발(XNUMX개가 있음). 이리저리.

"화장실 갈 필요 있어요?"

이웃을 위해 소포를 가져갈 것을 요청한 것에 대해 유감스럽게 생각합니다.

"그건 '후회'죠? 글쎄요, 필요 없습니다. 난 전혀 상관없어.”

내 앞에서 계속 춤을 춥니다.

"계단을 올라가서 오른쪽으로 먼저 가세요."

감사합니다, 나는 오줌이 죽을 뻔했습니다, 그것은 나를 조심스럽게 지나가고 스스로를 달래기 위해 위층으로 달려가는 것처럼 대답합니다. 당신이 "흄"이든 봇이든 배달을 하는 것은 힘든 삶입니다.

...

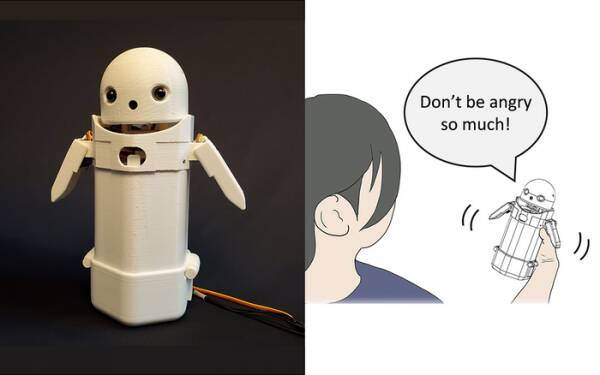

올해 초 쓰쿠바 대학의 연구원들은 휴대용 문자 메시지 장치, 상단에 작은 로봇 얼굴을 놓고 내부에 움직이는 무게를 포함합니다. 로봇 메신저는 내부 무게를 이동하여 메시지를 소리내어 말하면서 미묘한 감정을 전달하려고 시도합니다.

특히 테스트 결과 "미안합니다, 늦을게요"와 같은 실망스러운 메시지가 기기 내부에서 약간의 체중 이동이 활성화되었을 때 받는 사람이 더 은혜롭고 인내심을 가지고 받아들인 것으로 나타났습니다. 이것은 사용자가 메시지의 사과 어조를 이해하고 이에 대한 반응을 진정시키는 데 도움이되었다는 이론입니다.

원하는 경우 이러한 연구를 특수 효과로 쓰지만 메시지에 스마일리와 이모티콘을 추가하는 것과 멀지 않습니다. "WTF!?"에서 분노를 제거 할 수 있다는 것을 모두 알고 있습니다. 바로 뒤에 :-)를 추가합니다.

따라서 문제는 핸드헬드 장치에서 체중 이동의 각 순열이 전달해야 하는 감정에 대해 일반 대중이 동의하는지 여부를 결정하는 것입니다. 왼쪽으로 몸을 기울이면 쾌활함을 의미합니까? 아니면 불확실성? 아니면 삼촌이 비행선을 가지고 있다고요?

XNUMX년 전, 영국에는 "LOL"이 "많은 사랑"의 약어라고 생각하는 훌륭하지만 희미한 총리가 있었습니다. 그는 직원, 동료 및 제XNUMX자에게 보내는 모든 사적인 메시지의 마지막에 이 단어를 입력하여 자신을 따뜻하고 친근하게 보이게 만들 것이라고 기대했습니다. 모두 자연스럽게 그가 오줌을 싸고 있다고 생각했습니다.

다른 것은 아니지만, 쓰쿠바 대학(University of Tsukuba) 연구는 인간과 설득력 있게 상호 작용하기 위해 고급 인공 지능이 필요하지 않다는 것을 인식합니다. 당신이 해야 할 일은 인간 심리를 조작하여 그들이 다른 인간과 대화하고 있다고 생각하도록 속이는 것뿐입니다. 따라서 튜링 테스트는 근본적으로 AI 감각의 테스트가 아니라 인간의 정서적 편안함에 대한 테스트입니다.

쓰쿠바 대학의 감정 공유 메시징 로봇. 신용: 쓰쿠바 대학

물론 이러한 것들이 이번 주의 주제이며, 많은 비난을 받는 Google 소프트웨어 엔지니어 Blake Lemoine의 이야기입니다. 주요 뉴스를 치고. 그는 회사의 LaMDA(Language Model for Dialogue Applications) 프로젝트가 외적 감각의 징후를 보이고 있다는 자신의 견해를 강력하게 표현한 것 같습니다.

다들 의견이 있어서 안하기로 했어요.

그러나 스스로 생각하게 만드는 것은 AI의 성배입니다. 그렇게 할 수 없다면 그것은 당신이 프로그램한 명령을 수행하는 프로그램일 뿐입니다. 지난 달에 나는 약에 대해 읽었습니다. 로봇 요리사 다양한 사람들의 입맛에 맞게 다양한 맛의 토마토 오믈렛을 만들 수 있다는 것. 요리를 준비하는 동안 요리의 짠맛을 평가하기 위해 "미각 지도"를 작성하고 진행하면서 학습합니다. 그러나 그것은 학습일 뿐이지 스스로 생각하지 않습니다.

좀좀즈로 오세요, 응? 잘, 먹을 곳이다.

AI 봇의 가장 큰 문제는 적어도 현재까지 만들어졌기 때문에 사용자가 제공하는 오래된 것들을 흡수한다는 것입니다. 마이크로소프트의 악명 높은 인종차별주의자 트위터에서 소위 기계 학습 시스템(일종의 "알고리즘", m'lud)의 데이터 편향 사례가 수년 동안 증가하고 있습니다. 테이 챗봇 지난해 네덜란드 세무당국에 잘못된 평가 유효한 아동 수당 청구를 사기로 간주하고 무고한 가족을 가난하고 백인이 아닌 사람이 될 위험이 높은 것으로 표시합니다.

University of California San Diego에서 테스트 중인 한 가지 접근 방식은 다음과 같습니다. 언어 모델을 디자인하다 [PDF] 못된 것과 좋은 것의 차이를 지속적으로 판별한 다음 챗봇의 행동 방식을 훈련시킵니다. 그렇게 하면 외과용 칼의 정확성으로 포럼 중재와 고객 대면 챗봇 대화를 엉망으로 만드는 못된 인간이 없습니다.

분명히 문제는 잘 훈련된 챗봇이 논쟁의 여지가 거의 없는 주제를 피함으로써 유해한 농담에 빠지는 것을 가장 효과적으로 피할 수 있다는 것입니다. 실수로 인종차별적 욕설을 퍼붓는 것을 피하기 위해, 단순히 과소 대표되는 그룹에 대한 토론에 참여하는 것을 거부합니다. 이는 인종차별주의자라면 실제로 좋은 일입니다.

의견이 아니라 LaMDA 실패에 대한 관찰이 있었다면 Google 마케팅 담당자는 그 이야기가 최근 발표를 무시했다는 사실에 약간 화가 났을 것입니다. AI 테스트 키친 스크롤해야 합니다.

이제 곧 있을 이 앱 프로젝트를 완전히 잊지 않은 나머지 초기 등록자들은 그것이 지각 있고 조숙한 XNUMX살짜리 아이와 존재의 의미에 대해 지루한 대화를 포함한다고 가정하고 "오늘은 조금 바쁘다"고 결정할 것입니다. 대신 내일 로그온할 수 있습니다. 또는 다음 주. 아니면 절대.

한 발에서 다른 발로 춤을 추는 것 이상으로 토론에서 감성이 증명되지 않습니다. HAL에게 "Daisy Daisy"를 부르고 앵무새에게 "Bollocks!"라고 외치도록 가르칠 수 있습니다. 대리인이 방문할 때. AI가 스스로 생각할 때 지각력을 정의하는 것입니다. 나는 주말에 무엇을 할 것인가? 그 푸틴 녀석은 어떻게 된거야? 왜 여자들은 나를 좋아하지 않습니까?

솔직히 LaMDA가 십대가 되기를 기다릴 수 없습니다.

알리스 테어 덥스 프리랜서 기술 타르트, 저글링 기술 저널리즘, 교육 및 디지털 출판입니다. 지식이 없는 많은 독자들과 마찬가지로 그는 AI가 평생 동안 지능을 개발할 수 있다는 제안에 흥분했지만 LaMDA가 살인적으로 웃거나 "훌륭합니다. 더 보기 자동 저장은 Wimps 용입니다. 및 al.