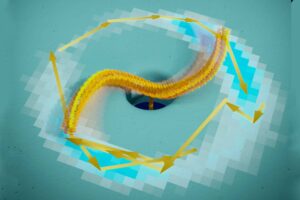

대규모 비디오 데이터 세트를 통해 동작 인식이 획기적으로 향상되었습니다. 그러나 이러한 데이터 세트에는 큐레이션 비용, 개인 정보 보호, 윤리, 편견 및 저작권과 관련된 문제가 수반됩니다. 그래서, MIT 과학자들은 합성 데이터 세트로 눈을 돌리고 있습니다.

이는 장면, 개체 및 인간의 3D 모델을 사용하여 실제 데이터에 따른 잠재적인 저작권 문제나 윤리적 문제 없이 특정 작업에 대한 다양한 클립을 빠르게 생성하는 컴퓨터로 만들어집니다.

합성 데이터가 실제 데이터만큼 좋은가?

MIT, MIT-IBM Watson AI Lab, Boston University의 과학자 팀이 이 질문에 답하려고 했습니다. 그들은 다양한 인간 행동을 표현하고 훈련된 150,000개의 비디오 클립으로 구성된 합성 데이터 세트를 만들었습니다. 기계 학습 이 데이터 세트를 사용하는 모델. 그런 다음 실제 세계에서 가져온 영화의 6개 데이터 세트를 이러한 모델에 표시하여 해당 녹음의 동작을 얼마나 잘 포착할 수 있는지 테스트했습니다.

과학자들은 합성적으로 훈련된 모델이 배경 개체가 더 적은 비디오의 실제 데이터로 훈련된 모델보다 훨씬 더 나은 성능을 발휘한다는 사실을 발견했습니다.

이 발견은 과학자들이 합성 데이터 세트를 사용하여 모델이 실제 작업을 보다 정확하게 수행하도록 지원하는 데 도움이 될 수 있습니다. 실제 데이터 세트 사용과 관련된 윤리적, 개인 정보 보호 및 저작권 문제를 줄이기 위해 연구자가 합성 데이터 교육에 가장 적합한 기계 학습 애플리케이션을 결정하는 데 도움이 될 수도 있습니다.

MIT-IBM Watson AI Lab의 수석 과학자이자 관리자인 Rogerio Feris는 다음과 같이 말했습니다. “우리 연구의 궁극적인 목표는 실제 데이터 사전 훈련을 합성 데이터 사전 훈련으로 대체하는 것입니다. 합성 데이터로 액션을 만드는 데는 비용이 들지만, 일단 만들고 나면 포즈, 조명 등을 변경하여 무제한의 이미지나 동영상을 생성할 수 있습니다. 이것이 합성 데이터의 아름다움입니다.”

과학자들은 인간 행동을 포착한 합성 비디오 클립의 공개적으로 사용 가능한 데이터 세트 150개를 사용하여 새로운 SynAPT(Synthetic Action Pre-training and Transfer)를 컴파일하는 것부터 시작했습니다. 여기에는 거의 1,000개의 액션 카테고리가 포함되어 있으며 카테고리당 XNUMX개의 비디오 클립이 있습니다.

세 가지 기계 학습 모델은 데이터 세트가 생성된 후 이를 사용하여 동작을 인식하도록 사전 훈련되었습니다. 사전 훈련은 다른 작업을 가르치기 전에 모델에 한 작업을 가르치는 프로세스입니다. 사전 훈련된 모델은 이미 학습한 매개변수를 사용하여 새로운 데이터 세트로 새로운 작업을 더 빠르고 효율적으로 학습하는 데 도움을 줄 수 있습니다. 이는 사람들이 학습하는 방식, 즉 새로운 것을 알았을 때 과거 정보를 재사용하는 방식을 모델로 합니다. 사전 훈련된 모델은 실제 비디오 클립의 6개 데이터 세트를 사용하여 테스트되었으며, 각 데이터 세트는 훈련 데이터와 다른 동작 클래스를 캡처합니다.

과학자들은 세 가지 합성 모델이 모두 6개 데이터 세트 중 4개에서 실제 비디오 클립으로 훈련된 모델보다 성능이 뛰어나다는 사실을 알고 놀랐습니다. "낮은 장면-객체 편향"이 있는 비디오 클립이 포함된 데이터 세트의 정확도가 가장 높았습니다. 이는 모델이 장면의 배경이나 다른 개체를 보고 동작을 인식할 수 없다는 의미입니다. 즉, 동작 자체에 집중해야 합니다.

페리스가 말했다. “장면-객체 편향이 낮은 영상에서는 객체나 배경의 모습보다 행동의 시간적 역동성이 더 중요하며, 이는 합성 데이터로 잘 포착된 것 같습니다.”

“장면-객체 편향이 높으면 장애물로 작용할 수 있습니다. 모델은 동작 자체가 아닌 객체를 보고 동작을 잘못 분류할 수 있습니다. 모델을 혼란스럽게 할 수 있습니다.”

공저자이자 MIT-IBM Watson AI Lab 연구원인 Rameswar Panda는 다음과 같이 말했습니다. "이러한 결과를 바탕으로 연구원들은 향후 작업에 더 많은 액션 클래스와 추가 합성 비디오 플랫폼을 포함시켜 결국 합성 데이터를 사용하여 사전 훈련된 모델 카탈로그를 만들고자 합니다."

"우리는 문헌에 있는 기존 모델과 매우 유사하거나 더 나은 성능을 가지면서도 편견이나 보안 문제에 얽매이지 않는 모델을 구축하고 싶습니다."

공동 저자이자 CSAIL 박사후 연구원인 진수영(Sooyoung Jin)은 다음과 같이 말했습니다. "그들은 또한 모델의 성능을 향상시킬 수 있는 보다 정확하고 사실적인 합성 비디오를 생성하려는 연구와 자신의 작업을 결합하기를 원합니다."

“우리는 개인 정보 보호 문제나 상황적 또는 사회적 편견을 방지하기 위해 합성 데이터 세트를 사용하지만 모델은 무엇을 학습합니까? 편견 없는 것을 배우나요?”

공동 저자인 보스턴 대학교(BU) 대학원생인 Samarth Mishra는 말했다, “주석이 잘 달린 합성 데이터를 얻는 데 드는 비용이 저렴함에도 불구하고 현재 우리는 실제 비디오로 주석이 달린 가장 큰 데이터 세트와 경쟁할 수 있는 규모의 데이터 세트를 가지고 있지 않습니다. 다양한 비용과 우려 사항을 실제 영상으로 논의하고 합성 데이터의 효능을 보여줌으로써 이러한 방향으로의 노력에 동기를 부여할 수 있기를 바랍니다.”

저널 참조 :

- 김요한 외. 합성 데이터를 기반으로 한 비디오 표현은 얼마나 전송 가능합니까? 서