Gebruikersgegevens: Vital Food van LLM's

Ja! RT @bryce hou van deze quote: “Als je er niet voor betaalt, ben je niet de klant; jij bent het product dat wordt verkocht.” http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) 2 september 2010

Blijf op de hoogte van cryptonieuws, ontvang dagelijkse updates in je inbox.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- : heeft

- :is

- :niet

- 7

- 8

- a

- vermogen

- absoluut

- Volgens

- accuraat

- het aanpassen

- aanpakken

- Voegt

- vergevorderd

- geleden

- eens

- AI

- AI-diensten

- AI-systemen

- wil

- Alexa

- Lijnt uit

- Alles

- toestaat

- ook

- altijd

- Amazone

- an

- en

- antropisch

- anticiperen

- elke

- toepasselijk

- ZIJN

- AS

- ervan uitgaan

- At

- Beschikbaar

- het vermijden van

- bewust

- gebaseerde

- BE

- omdat

- wezen

- geloofde

- heilzaam

- Betere

- tussen

- by

- CAN

- vorderingen

- klanten

- commercieel

- verplichting

- begaat

- Bedrijven

- afstand

- concurrerend

- concept

- Zorgen

- permanent

- content

- verband

- permanent

- onder controle te houden

- gemakkelijk

- conversaties

- auteursrecht

- kon

- cruciaal

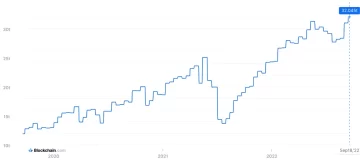

- crypto

- crypto Nieuws

- Actueel

- klant

- Klanten

- dagelijks

- Donker

- gegevens

- data Privacy

- debat

- decennia

- decoderen

- deep

- diepgaand leren

- Standaard

- Verdedigen

- het leveren van

- afhankelijk

- WIJST

- geschillen

- Verscheidenheid

- do

- document

- doet

- dollar

- Dont

- gedurende

- verdiencapaciteit

- rand

- effectiviteit

- beide

- engagement

- verbeteren

- waarborgt

- essentieel

- ethisch

- ethiek

- voorbeeld

- uitwisseling

- ervaring

- uitgebreid

- omvang

- extern

- naar

- Voor

- Voormalig

- Opgericht

- Gratis

- oppompen van

- met het verkrijgen van

- voortbrengen

- gegenereerde

- genereert

- generatief

- generatieve AI

- krijgen

- het krijgen van

- reuzen

- Geven

- Go

- toe te kennen

- grijpen

- Groeit

- hard

- eerlijk

- eren en respecteren

- Echter

- http

- HTTPS

- menselijk

- idealen

- if

- verbeteren

- in

- individueel

- informatie

- intellectueel

- intellectueel eigendom

- intenties

- interacties

- intern

- IP

- IT

- HAAR

- zelf

- sleutel

- taal

- Groot

- laatste

- Wet

- leiden

- LEARN

- leren

- Juridisch

- Hefboomwerking

- als

- Lama

- LLM

- liefde

- maken

- maken

- Mei..

- Media

- meta

- miljoenen

- model

- modellen

- meer

- meest

- netwerken

- neurale

- neurale netwerken

- New

- nieuws

- het verkrijgen van

- of

- on

- OpenAI

- or

- ogenschijnlijk

- anders-

- onze

- uit

- uitgangen

- over

- het te bezitten.

- bezit

- betaald

- partijen

- feest

- patronen

- Betaal

- het betalen van

- persoonlijk

- Personalisatie

- Gepersonaliseerde

- Foto's

- Plato

- Plato gegevensintelligentie

- PlatoData

- beleidsmaatregelen

- potentieel

- energie

- krachtige

- praktijken

- voorspellen

- Voorspellingen

- voorkeuren

- heersend

- privacy

- privaat

- geproduceerd

- Product

- prompts

- eigendom

- zorgen voor

- biedt

- publiek

- vertrouwen van het publiek

- in het openbaar

- citeren

- Racing

- RE

- echte wereld

- ontvangt

- verfijnen

- Beschouwen

- relatief

- los

- relevante

- gemeld

- verzoeken

- onderzoekers

- verantwoordelijk

- Revealed

- rechten

- rivalen

- rt

- Ryan

- s

- ervaren

- zegt

- scène

- service

- Diensten

- reeks

- Delen

- moet

- Scepticisme

- So

- Social

- social media

- uitverkocht

- SPELLEN

- woordvoerder

- startup

- Statement

- blijven

- Stap voor

- Systems

- Tandem

- tech

- tech reuzen

- technieken

- termen

- tekst

- dat

- De

- hun

- Ze

- Deze

- ze

- dit

- Tim

- naar

- vandaag

- top

- Trainen

- getraind

- Trainingen

- Transparantie

- Trends

- Trust

- voor

- begrijpen

- begrip

- komende

- bijgewerkt

- updates

- opgewaardeerd

- geüpload

- .

- gebruikt

- Gebruiker

- gebruikers

- gebruik

- waardevol

- divers

- versie

- Video's

- vitaal

- Stem

- volume

- was

- we

- waren

- wanneer

- of

- welke

- Waarom

- wil

- Met

- Woord

- zou

- You

- Your

- zephyrnet