Ik ben een grote fan van de reisshow van Anthony Bourdain Onderdelen onbekend. In elke aflevering bezoekt de chef-kok afgelegen dorpen over de hele wereld en documenteert hij de levens, het voedsel en de culturen van regionale stammen met een open hart en geest.

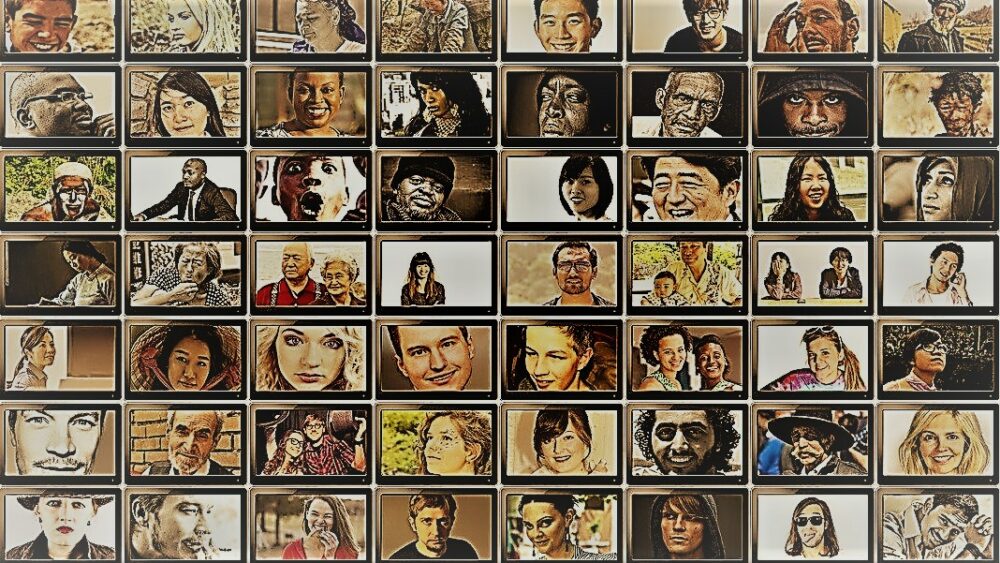

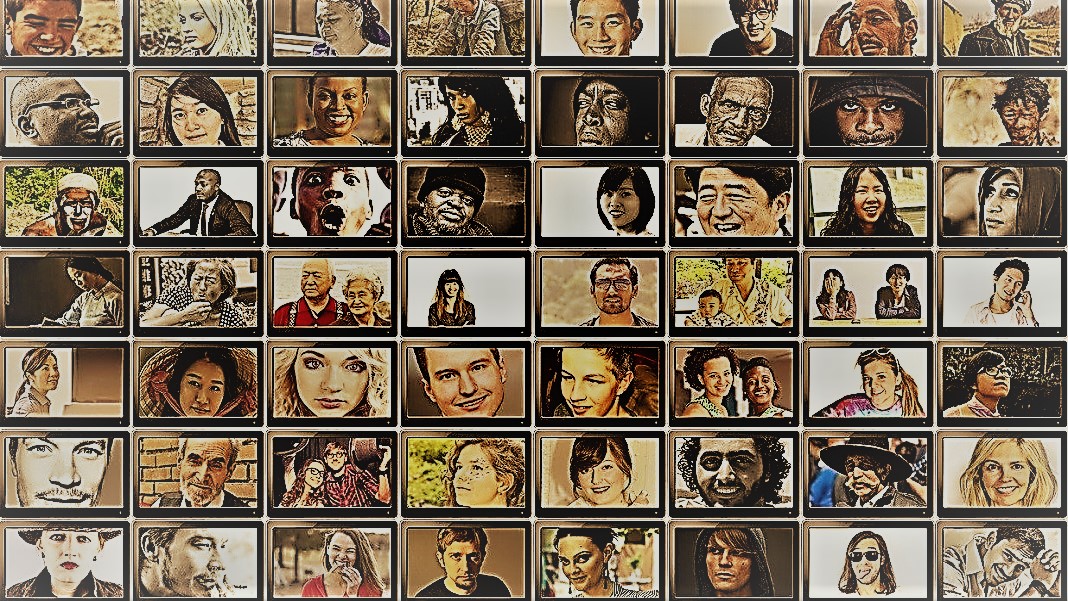

De show geeft een kijkje in de verbazingwekkende diversiteit van de mensheid. Sociale wetenschappers hebben een soortgelijk doel - het gedrag van verschillende mensen, groepen en culturen begrijpen - maar gebruiken verschillende methoden in gecontroleerde situaties. Voor beide zijn de sterren van deze bezigheden de onderwerpen: mensen.

Maar wat als je mensen zou vervangen door AI-chatbots?

Het idee klinkt belachelijk. Maar dankzij de komst van ChatGPT en andere grote taalmodellen (LLM's), flirten sociale wetenschappers met het idee om deze tools te gebruiken om snel diverse groepen "gesimuleerde mensen" te construeren en experimenten uit te voeren om hun gedrag en waarden te onderzoeken als een proxy voor hun biologische tegenhangers.

Als je je een digitaal nagemaakte menselijke geest voorstelt, dan is dat het niet. Het idee is om gebruik te maken van de expertise van ChatGPT in het nabootsen van menselijke reacties. Omdat de modellen enorme hoeveelheden online gegevens verzamelen - blogs, YouTube-commentaren, fanfictie, boeken - leggen ze gemakkelijk verbanden vast tussen woorden in meerdere talen. Deze geavanceerde algoritmen kunnen ook genuanceerde aspecten van taal decoderen, zoals ironie, sarcasme, metaforen en emotionele tonen, een cruciaal aspect van menselijke communicatie in elke cultuur. Deze sterke punten zorgen ervoor dat LLM's meerdere synthetische persoonlijkheden nabootsen met een breed scala aan overtuigingen.

Nog een bonus? In vergelijking met menselijke deelnemers worden ChatGPT en andere LLM's niet moe, waardoor wetenschappers met ongekende snelheid gegevens kunnen verzamelen en theorieën over menselijk gedrag kunnen testen.

Het idee, hoewel controversieel, heeft al steun. Een recent artikel bij het bekijken van het ontluikende veld bleek dat in bepaalde zorgvuldig ontworpen scenario's de reacties van ChatGPT correleerden met die van ongeveer 95 procent van de menselijke deelnemers.

AI "zou het spel voor sociaalwetenschappelijk onderzoek kunnen veranderen", zei Dr. Igor Grossman van de Universiteit van Waterloo, die onlangs met collega's een vooruitblikkend artikel schreef in Wetenschap. De sleutel voor gebruik Homo silicus in onderzoek? Zorgvuldig vooroordeelbeheer en gegevensgetrouwheid, zei het team.

Onderzoek naar de menselijke maatschappelijke geest

Wat is sociale wetenschappen precies?

Simpel gezegd, het bestudeert hoe mensen - als individu of als groep - zich gedragen onder verschillende omstandigheden, hoe ze met elkaar omgaan en zich ontwikkelen als een cultuur. Het is een paraplu van academische bezigheden met meerdere takken: economie, politieke wetenschappen, antropologie en psychologie.

De discipline behandelt een breed scala aan onderwerpen die prominent aanwezig zijn in de huidige tijdgeest. Wat is de impact van sociale media op de geestelijke gezondheid? Wat is de huidige houding van het publiek ten opzichte van klimaatverandering naarmate de periodes van zwaar weer toenemen? Hoe waarderen verschillende culturen communicatiemethoden - en wat veroorzaakt misverstanden?

Een sociaalwetenschappelijke studie begint met een vraag en een hypothese. Een van mijn favorieten: tolereren culturen lichaamsgeur anders? (Geen grapje, het onderwerp is onderzocht nogal wat, en ja, er is een verschil!)

Wetenschappers gebruiken vervolgens verschillende methoden, zoals vragenlijsten, gedragstesten, observatie en modellering om hun ideeën te testen. Enquêtes zijn een bijzonder populair hulpmiddel, omdat de vragen streng kunnen worden ontworpen en doorgelicht en gemakkelijk een breed scala aan mensen bereiken wanneer ze online worden verspreid. Wetenschappers analyseren vervolgens schriftelijke reacties en trekken inzichten in menselijk gedrag. Met andere woorden, het taalgebruik van een deelnemer is van cruciaal belang voor deze studies.

Dus hoe past ChatGPT erin?

De 'Homo Silicus'

Voor Grossman vormen de LLM's achter chatbots zoals ChatGPT of Google's Bard een ongekende kans om sociaalwetenschappelijke experimenten opnieuw te ontwerpen.

Omdat ze zijn getraind op enorme datasets, kunnen LLM's "een breed scala aan menselijke ervaringen en perspectieven vertegenwoordigen", aldus de auteurs. Omdat de modellen vrij en zonder grenzen over het internet "zwerven", zoals mensen die vaak internationaal reizen, kunnen ze een breder scala aan reacties aannemen en vertonen in vergelijking met gerekruteerde proefpersonen.

ChatGPT wordt ook niet beïnvloed door andere leden van een onderzoek en wordt ook niet moe, waardoor het mogelijk minder vooringenomen reacties kan genereren. Deze eigenschappen kunnen vooral nuttig zijn in 'risicovolle projecten', bijvoorbeeld door de reacties na te bootsen van mensen die in oorlogslanden of onder moeilijke regimes leven via berichten op sociale media. De reacties zouden op hun beurt kunnen leiden tot interventies in de echte wereld.

Evenzo kunnen LLM's die zijn opgeleid in culturele actuele onderwerpen zoals genderidentiteit of verkeerde informatie verschillende theoretische of ideologische stromingen reproduceren om beleid te informeren. In plaats van honderdduizenden menselijke deelnemers nauwgezet te ondervragen, kan de AI snel reacties genereren op basis van online discours.

Afgezien van potentieel gebruik in de praktijk, kunnen LLM's ook fungeren als digitale proefpersonen die communiceren met menselijke deelnemers aan sociaalwetenschappelijke experimenten, enigszins vergelijkbaar met niet-spelerpersonages (NPC) in videogames. De LLM zou bijvoorbeeld verschillende 'persoonlijkheden' kunnen aannemen en online met menselijke vrijwilligers over de hele wereld kunnen communiceren door hen dezelfde vraag te stellen door hen dezelfde vraag te stellen. Omdat algoritmen niet slapen, kan het 24/7 draaien. De resulterende gegevens kunnen wetenschappers vervolgens helpen onderzoeken hoe verschillende culturen vergelijkbare informatie evalueren en hoe meningen - en verkeerde informatie - zich verspreiden.

Kleine stapjes

Het idee om chatbots te gebruiken in plaats van mensen in studies is nog niet mainstream.

Maar er is al vroeg bewijs dat het zou kunnen werken. A preprint studie deze maand vrijgegeven door Georgia Tech, Microsoft Research en Olin College ontdekten dat een LLM menselijke reacties repliceerde in tal van klassieke psychologie-experimenten, waaronder de beruchte Milgram-schokexperimenten.

Toch blijft een kritische vraag: hoe goed kunnen deze modellen de reactie van een mens echt vastleggen?

Er zijn meerdere struikelblokken.

Ten eerste is er de kwaliteit van het algoritme en de trainingsgegevens. De meeste online-inhoud wordt gedomineerd door slechts een handvol talen. Een LLM die op deze gegevens is getraind, kan gemakkelijk het sentiment, het perspectief of zelfs het morele oordeel nabootsen van mensen die deze talen gebruiken, en op zijn beurt de vooroordelen overnemen van de trainingsgegevens.

"Deze reproductie van vooringenomenheid is een grote zorg, omdat het juist de ongelijkheden zou kunnen versterken die sociale wetenschappers proberen te ontdekken in hun onderzoek", zei Grossman.

Sommige wetenschappers maken zich ook zorgen dat LLM's rechtvaardig zijn oprispingen wat ze te horen krijgen. Het is de antithese van een sociaalwetenschappelijke studie, waarin het belangrijkste punt is om de mensheid in al haar diverse en complexe schoonheid te vangen. Aan de andere kant staan ChatGPT en vergelijkbare modellen bekend als "hallucineren”, informatie verzinnen die plausibel klinkt maar onjuist is.

Voor nu "vertrouwen grote taalmodellen op 'schaduwen' van menselijke ervaringen", aldus Grossman. Omdat deze AI-systemen grotendeels zwarte dozen zijn, is het moeilijk te begrijpen hoe of waarom ze bepaalde reacties genereren - een beetje verontrustend wanneer ze worden gebruikt als menselijke proxy's in gedragsexperimenten.

Ondanks beperkingen stellen "LLM's sociale wetenschappers in staat om traditionele onderzoeksmethoden te doorbreken en hun werk op innovatieve manieren te benaderen", aldus de auteurs. Als eerste stap zou Homo silicus kunnen helpen bij het brainstormen en snel hypothesen kunnen testen, waarbij veelbelovende hypothesen verder kunnen worden gevalideerd in menselijke populaties.

Maar wil de sociale wetenschappen AI echt verwelkomen, dan moet er transparantie, eerlijkheid en gelijke toegang tot deze krachtige systemen zijn. LLM's zijn moeilijk en duur om te trainen, met recente modellen die steeds meer worden opgesloten achter forse betaalmuren.

"We moeten ervoor zorgen dat LLM's in de sociale wetenschappen, zoals alle wetenschappelijke modellen, open-source zijn, wat betekent dat hun algoritmen en idealiter gegevens voor iedereen beschikbaar zijn om te onderzoeken, testen en wijzigen," zei studie auteur Dr. Dawn Parker aan de Universiteit van Waterloo. "Alleen door transparantie en repliceerbaarheid te behouden, kunnen we ervoor zorgen dat AI-ondersteund sociaalwetenschappelijk onderzoek echt bijdraagt aan ons begrip van de menselijke ervaring."

Krediet van het beeld: Gerd Altmann / Pixabay

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- : heeft

- :is

- :niet

- $UP

- 23

- a

- Over

- academische

- toegang

- over

- Handelen

- adopteren

- komst

- AI

- algoritme

- algoritmen

- Alles

- toelaten

- Het toestaan

- al

- ook

- hoeveelheden

- an

- analyseren

- en

- Anthony

- nadering

- ZIJN

- Arizona

- reeks

- dit artikel

- AS

- verschijning

- aspecten

- At

- auteur

- auteurs

- Beschikbaar

- gebaseerde

- BE

- Beauty

- omdat

- geweest

- gedrag

- achter

- wezen

- overtuigingen

- tussen

- vooringenomenheid

- vooringenomen

- Beetje

- Zwart

- Blokken

- lichaam

- Bonus

- grenzen

- zowel

- dozen

- brainstorm

- takken

- Breken

- maar

- by

- CAN

- vangen

- voorzichtig

- zeker

- verandering

- tekens

- chatbots

- ChatGPT

- situatie

- Klimaat

- Klimaatverandering

- collega's

- verzamelen

- College

- opmerkingen

- Communicatie

- vergeleken

- complex

- Bezorgdheid

- bouwen

- content

- draagt bij

- gecontroleerd

- controversieel

- kon

- landen

- Credits

- kritisch

- kritisch aspect

- culturele

- Culture

- Actueel

- gegevens

- datasets

- ontworpen

- ontwikkelen

- anders

- moeilijk

- digitaal

- digitaal

- Display

- verdeeld

- diversen

- Verscheidenheid

- do

- doet

- Nee

- Dont

- dr

- trekken

- elk

- Vroeg

- gemakkelijk

- Economie

- enorm

- verzekeren

- aflevering

- gelijk

- vooral

- schatten

- Zelfs

- Alle

- precies

- voorbeeld

- duur

- ervaring

- Ervaringen

- experimenten

- expertise

- Verken

- eerlijkheid

- vals

- ventilator

- Fictie

- trouw

- veld-

- Voornaam*

- geschikt

- voedsel

- Voor

- gevonden

- oppompen van

- verder

- spel

- Spellen

- Geslacht

- voortbrengen

- krijgen

- Glimp

- wereldbol

- Groep

- hand

- handvol

- Hebben

- Gezondheid

- Hart

- hulp

- Populair

- Hoe

- HTML

- http

- HTTPS

- reusachtig

- menselijk

- Menselijke ervaring

- Mensheid

- Mensen

- Honderden

- idee

- ideaal

- ideeën

- Identiteit

- if

- Impact

- in

- Anders

- Inclusief

- Laat uw omzet

- in toenemende mate

- individuen

- berucht

- beïnvloed

- informeren

- informatie

- innovatieve

- inzichten

- interactie

- in

- ironie

- IT

- HAAR

- jpg

- voor slechts

- sleutel

- bekend

- taal

- Talen

- Groot

- grotendeels

- minder

- als

- beperkingen

- Lives

- leven

- LLM

- Hoofd

- Hoofdstroom

- Het handhaven

- groot

- maken

- management

- massief

- Mei..

- betekenis

- Media

- Leden

- mentaal

- Mentale gezondheid

- methoden

- Microsoft

- denken

- deskundigen

- Desinformatie

- modellering

- modellen

- wijzigen

- Maand

- moreel

- meest

- meervoudig

- Dan moet je

- my

- ontluikend

- Noodzaak

- geen

- nu

- vele

- of

- vaak

- on

- EEN

- degenen

- online.

- open

- open source

- kansen

- or

- Overige

- onze

- deelnemers

- Mensen

- procent

- Persoonlijkheden

- perspectief

- perspectieven

- Plato

- Plato gegevensintelligentie

- PlatoData

- aannemelijk

- punt

- beleidsmaatregelen door te lezen.

- politiek

- Populair

- populaties

- Berichten

- mogelijk

- krachtige

- sonde

- vooraanstaand

- veelbelovend

- bewijs

- biedt

- volmacht

- Psychologie

- publiek

- achtervolging

- kwaliteit

- vraag

- Contact

- reeks

- snel

- liever

- bereiken

- echte wereld

- werkelijk

- recent

- onlangs

- herontwerp

- diëten

- regionaal

- Relaties

- uitgebracht

- vertrouwen

- stoffelijk overschot

- vanop

- vervangen

- repliceerbaarheid

- gerepliceerd

- vertegenwoordigen

- weergave

- onderzoek

- antwoord

- reacties

- verkregen

- ruw

- lopen

- Zei

- dezelfde

- scenario's

- scholen

- Wetenschap

- WETENSCHAPPEN

- wetenschappelijk

- wetenschappers

- sentiment

- reeks

- verscheidene

- streng

- tonen

- gelijk

- eenvoudigweg

- situaties

- slaap

- Social

- social media

- Posts op sociale media

- maatschappelijk

- enigszins

- geraffineerd

- snelheid

- Sterren

- starts

- Stap voor

- sterke punten

- zich inspannen

- studies

- Studie

- Bestuderen

- struikelen

- dergelijk

- ondersteuning

- synthetisch

- Systems

- Pakt aan

- Tik

- team

- tech

- proef

- testen

- neem contact

- Bedankt

- dat

- De

- hun

- Ze

- harte

- theoretisch

- Er.

- Deze

- ze

- dit

- die

- toch?

- gedachte

- duizenden kosten

- Door

- moe

- naar

- tools

- tools

- onderwerpen

- in de richting van

- traditioneel

- Trainen

- getraind

- Trainingen

- Transparantie

- reizen

- verontrustend

- echt

- BEURT

- paraplu

- ontdekken

- voor

- begrijpen

- begrip

- universiteit-

- zonder precedent

- .

- toepassingen

- gebruik

- gevalideerd

- waarde

- Values

- variëteit

- groot

- zeer

- doorgelicht

- Video

- video games

- Bezoeken

- vrijwilligers

- oorlog

- manieren

- we

- Weer

- welkom

- GOED

- Wat

- wanneer

- welke

- WIE

- Waarom

- breed

- Grote range

- bredere

- Wikipedia

- wil

- Met

- zonder

- woorden

- Mijn werk

- Bedrijven

- zorgen

- geschreven

- ja

- nog

- You

- youtube

- tijdsgeest

- zephyrnet