Data transformeert elk vakgebied en elk bedrijf. Echter, met gegevens die sneller groeien dan de meeste bedrijven kunnen bijhouden, is het verzamelen van gegevens en het halen van waarde uit die gegevens een uitdaging. EEN moderne datastrategie kan u helpen betere bedrijfsresultaten te behalen met data. AWS biedt de meest complete set services voor de end-to-end datareis om u te helpen ontgrendel waarde uit uw gegevens en zet het om in inzicht.

Datawetenschappers kunnen tot 80% van hun tijd besteden aan het voorbereiden van gegevens voor machine learning (ML)-projecten. Dit voorbereidingsproces is grotendeels ongedifferentieerd en vervelend werk en kan meerdere programmeer-API's en aangepaste bibliotheken omvatten. Amazon SageMaker-gegevens Wrangler helpt datawetenschappers en data-engineers bij het vereenvoudigen en versnellen van gegevensvoorbereiding in tabelvorm en tijdreeksen en feature-engineering via een visuele interface. U kunt gegevens importeren uit meerdere gegevensbronnen, zoals Amazon eenvoudige opslagservice (Amazone S3), Amazone Athene, Amazon roodverschuiving, of zelfs oplossingen van derden zoals Sneeuwvlok or GegevensBricks, en verwerk uw gegevens met meer dan 300 ingebouwde gegevenstransformaties en een bibliotheek met codefragmenten, zodat u functies snel kunt normaliseren, transformeren en combineren zonder code te schrijven. U kunt uw aangepaste transformaties ook in PySpark, SQL of Panda's brengen.

Dit bericht laat zien hoe u uw taken voor gegevensvoorbereiding kunt plannen om automatisch te worden uitgevoerd. We verkennen ook de nieuwe Data Wrangler-mogelijkheid van geparametriseerde datasets, waarmee u de bestanden kunt specificeren die moeten worden opgenomen in een gegevensstroom door middel van geparametriseerde URI's.

Overzicht oplossingen

Data Wrangler ondersteunt nu het importeren van gegevens met behulp van een geparametriseerde URI. Dit zorgt voor meer flexibiliteit omdat u nu alle datasets kunt importeren die overeenkomen met de opgegeven parameters, die van het type String, Number, Datetime en Pattern kunnen zijn, in de URI. Bovendien kunt u nu uw Data Wrangler-transformatietaken volgens een schema activeren.

In dit bericht maken we een voorbeeldstroom met de Titanic-dataset om te laten zien hoe je kunt gaan experimenteren met deze twee nieuwe functies van Data Wrangler. Om de dataset te downloaden, zie Titanic – Machine learning van rampen.

Voorwaarden

Om alle functies te krijgen die in dit bericht worden beschreven, moet je de nieuwste kernelversie van Data Wrangler gebruiken. Voor meer informatie, zie Gegevens Wrangler bijwerken. Bovendien moet je rennen Amazon SageMaker Studio JupyterLab 3. Om de huidige versie te bekijken en bij te werken, raadpleeg Versiebeheer van JupyterLab.

Bestandsstructuur

Voor deze demonstratie volgen we een eenvoudige bestandsstructuur die u moet repliceren om de stappen in dit bericht te reproduceren.

- in de studio, maak een nieuw notitieblok aan.

- Voer het volgende codefragment uit om de mapstructuur te maken die we gebruiken (zorg ervoor dat u zich in de gewenste map in uw bestandsboom bevindt):

- Kopieer de

train.csventest.csvbestanden van de originele Titanic-dataset naar de mappentitanic_dataset/trainentitanic_dataset/test, Respectievelijk. - Voer het volgende codefragment uit om de mappen te vullen met de benodigde bestanden:

We splitsten de train.csv bestand van de Titanic-dataset in negen verschillende bestanden, genaamd part_x, waarbij x het nummer van het onderdeel is. Deel 0 heeft de eerste 100 records, deel 1 de volgende 100, enzovoort tot deel 8. Elke knooppuntmap van de bestandsboom bevat een kopie van de negen delen van de trainingsgegevens, behalve de train en test mappen, die bevatten train.csv en test.csv.

Geparametriseerde datasets

Data Wrangler-gebruikers kunnen nu parameters specificeren voor de datasets die zijn geïmporteerd uit Amazon S3. Gegevenssetparameters worden opgegeven bij de URI van de bronnen en de waarde ervan kan dynamisch worden gewijzigd, waardoor er meer flexibiliteit is voor het selecteren van de bestanden die we willen importeren. Parameters kunnen van vier gegevenstypen zijn:

- Telefoon Nummer – Kan de waarde van elk geheel getal aannemen

- Draad - Kan de waarde van elke tekenreeks aannemen

- Patronen – Kan de waarde aannemen van elke reguliere expressie

- Datum Tijd – Kan de waarde aannemen van elk van de ondersteunde datum-/tijdnotaties

In deze sectie geven we een overzicht van deze nieuwe functie. Dit is alleen beschikbaar nadat u uw dataset in uw huidige stroom hebt geïmporteerd en alleen voor datasets die zijn geïmporteerd uit Amazon S3.

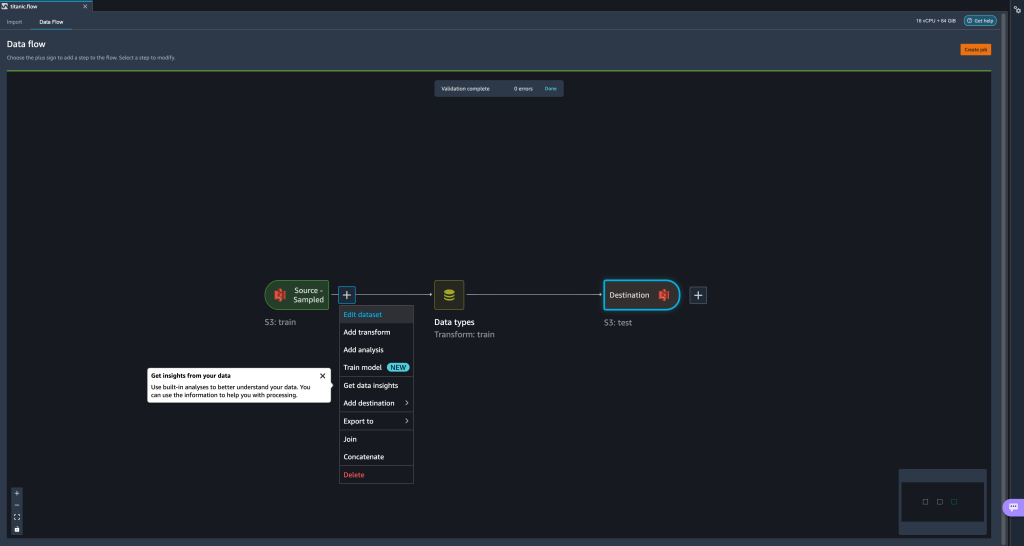

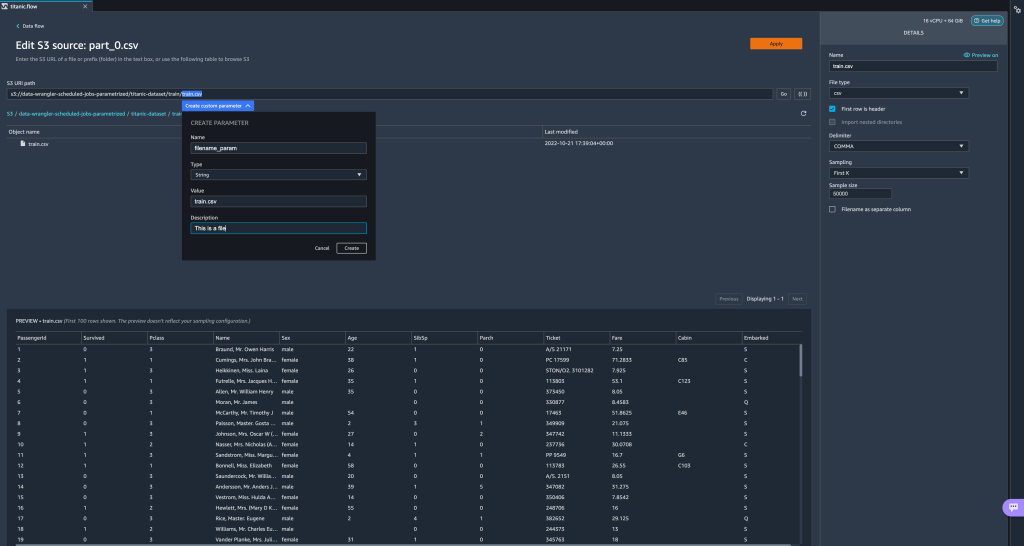

- Kies vanuit uw gegevensstroom het plusteken (+) naast de importstap en kies Gegevensset bewerken.

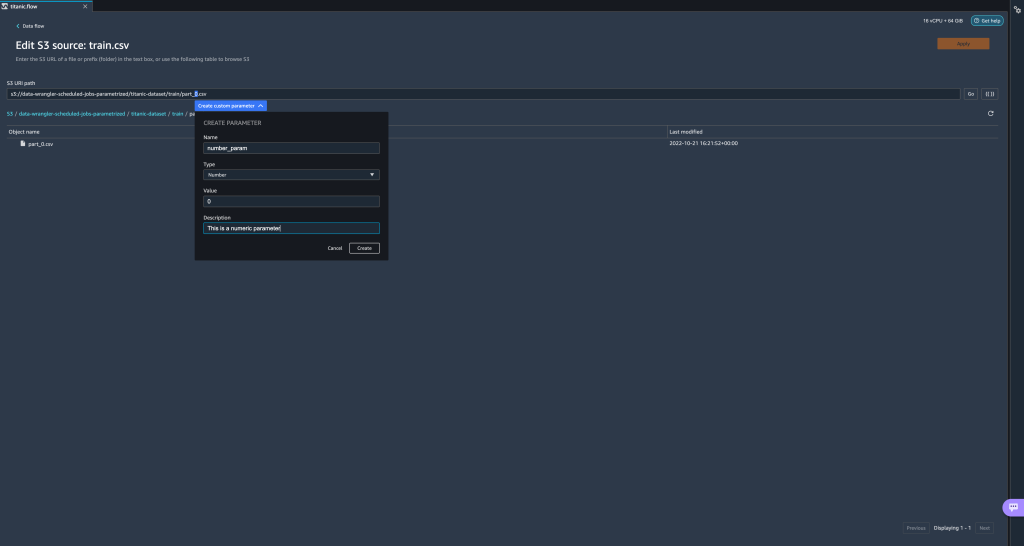

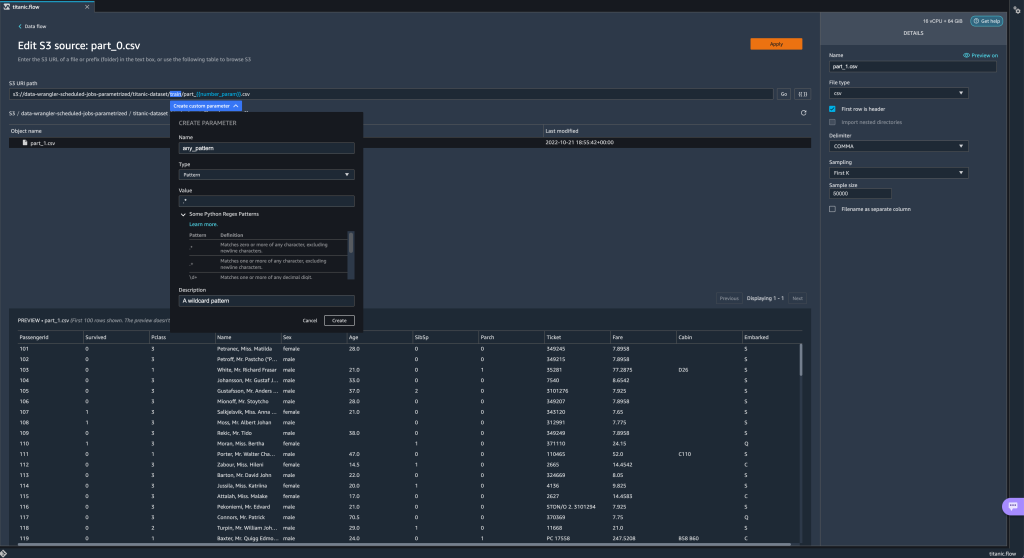

- De geprefereerde (en gemakkelijkste) methode om nieuwe parameters te maken, is door een gedeelte van uw URI te markeren en te kiezen Aangepaste parameter maken in het vervolgkeuzemenu. U moet vier dingen specificeren voor elke parameter die u wilt maken:

- Naam

- Type

- Standaardwaarde

- Omschrijving

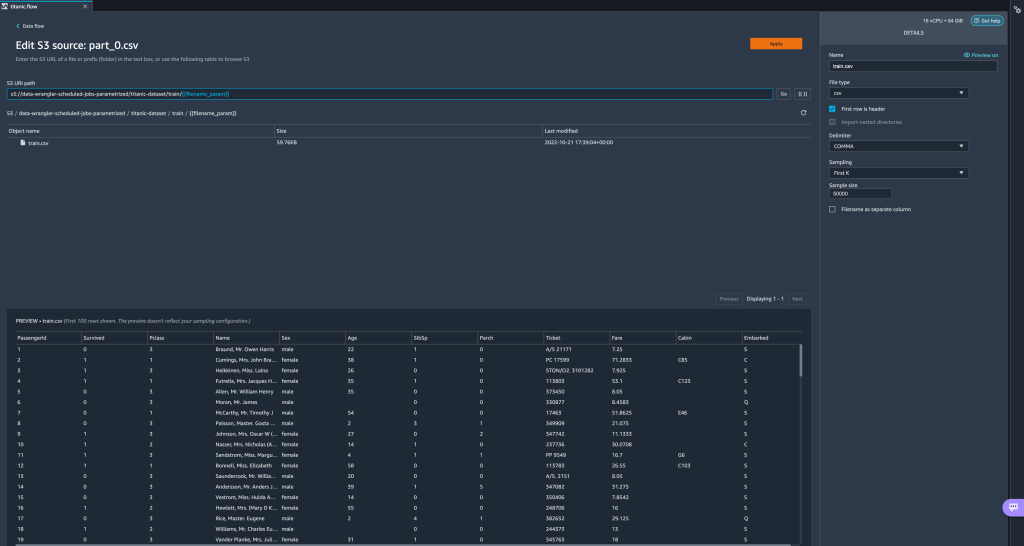

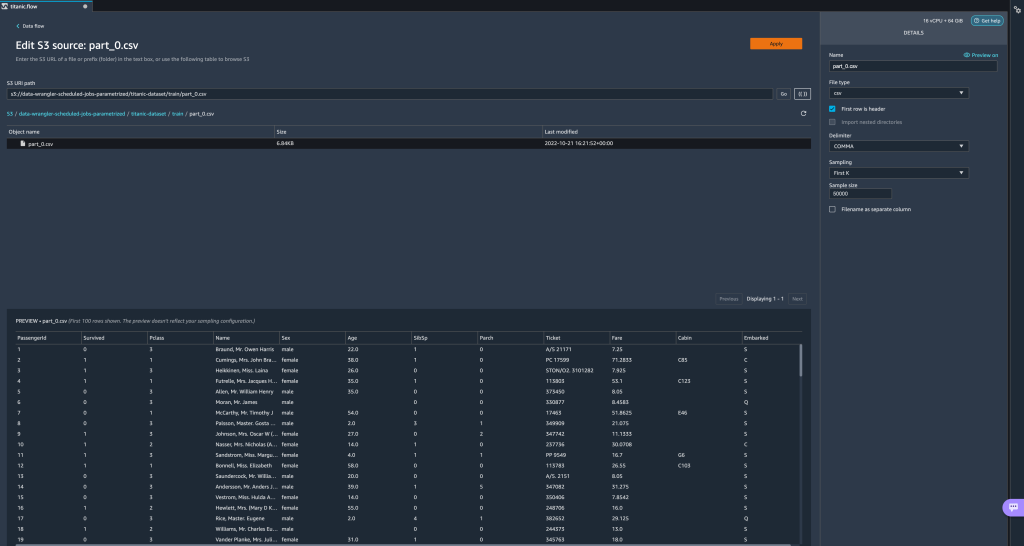

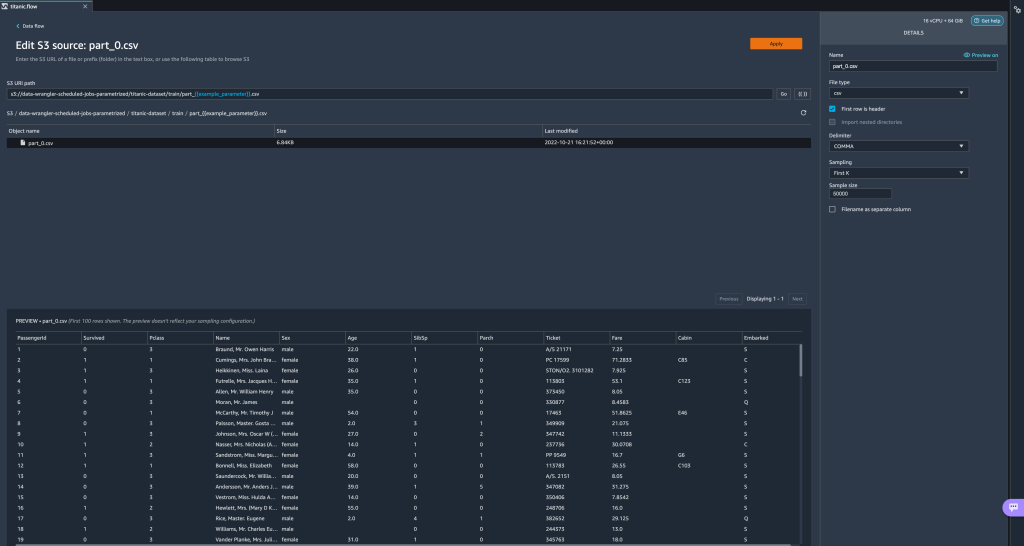

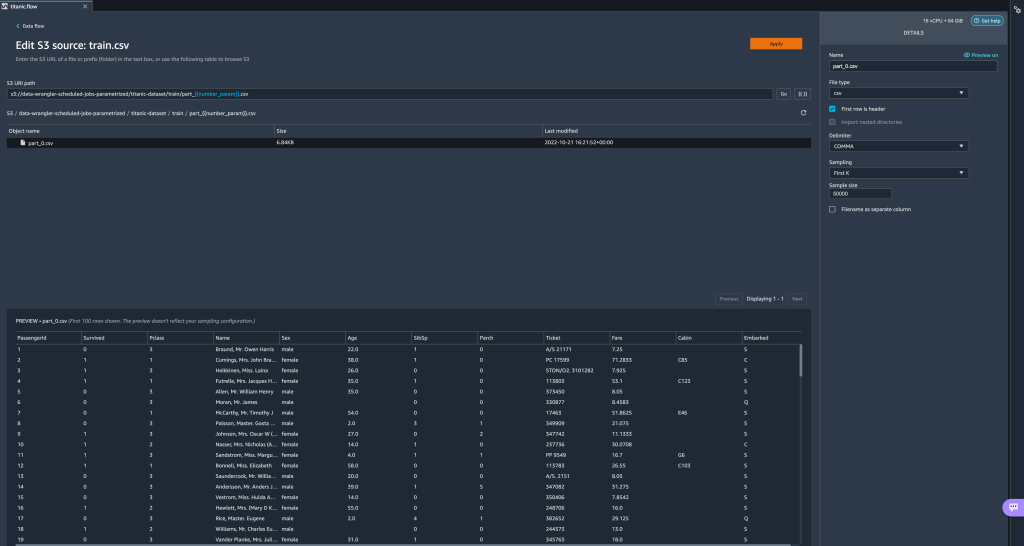

Hier hebben we een String-typeparameter gemaakt met de naamfilename_parammet een standaardwaarde vantrain.csv. Nu kunt u de parameternaam tussen dubbele haakjes zien, ter vervanging van het gedeelte van de URI dat we eerder hebben gemarkeerd. Omdat de gedefinieerde waarde voor deze parameter wastrain.csv, we zien nu het bestandtrain.csvvermeld op de importtabel.

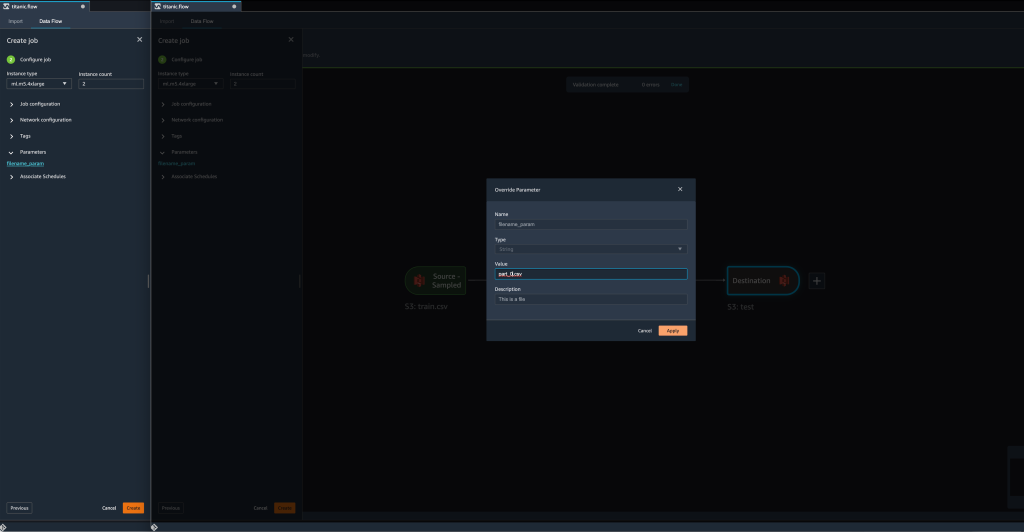

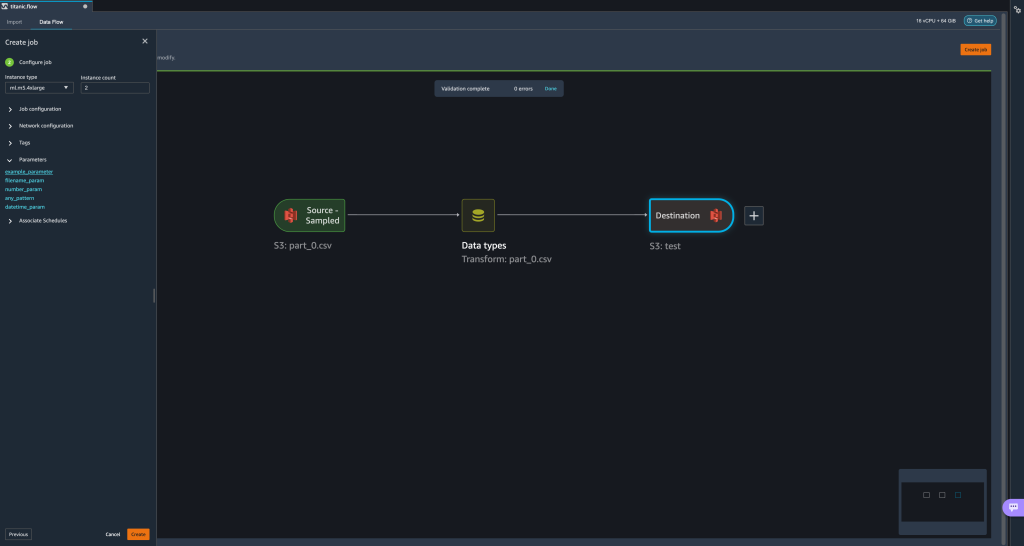

- Wanneer we een transformatiebaan proberen te creëren, op de Taak configureren stap zien we nu a parameters sectie, waar we een lijst kunnen zien van al onze gedefinieerde parameters.

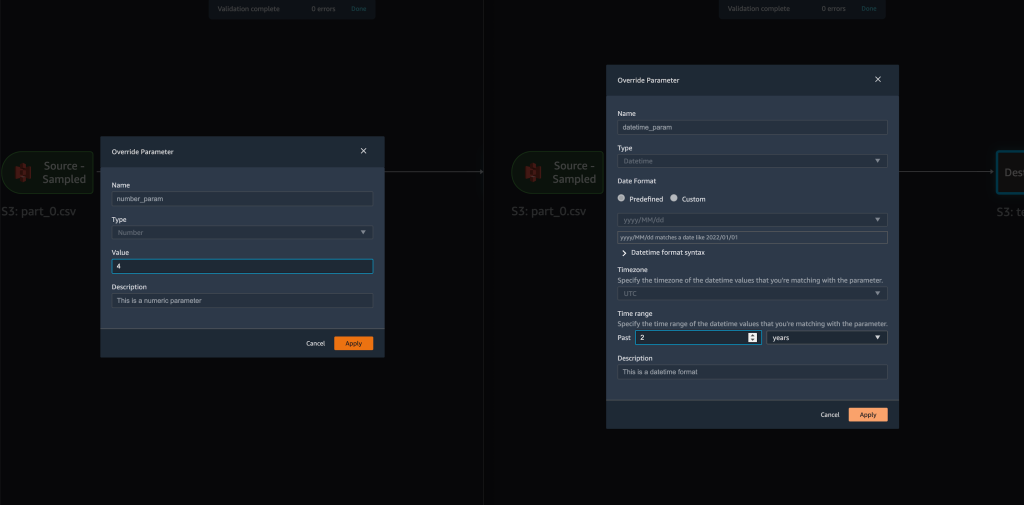

- Door de parameter te kiezen, hebben we de mogelijkheid om de waarde van de parameter te wijzigen, in dit geval de invoergegevensset die moet worden getransformeerd volgens de gedefinieerde stroom.

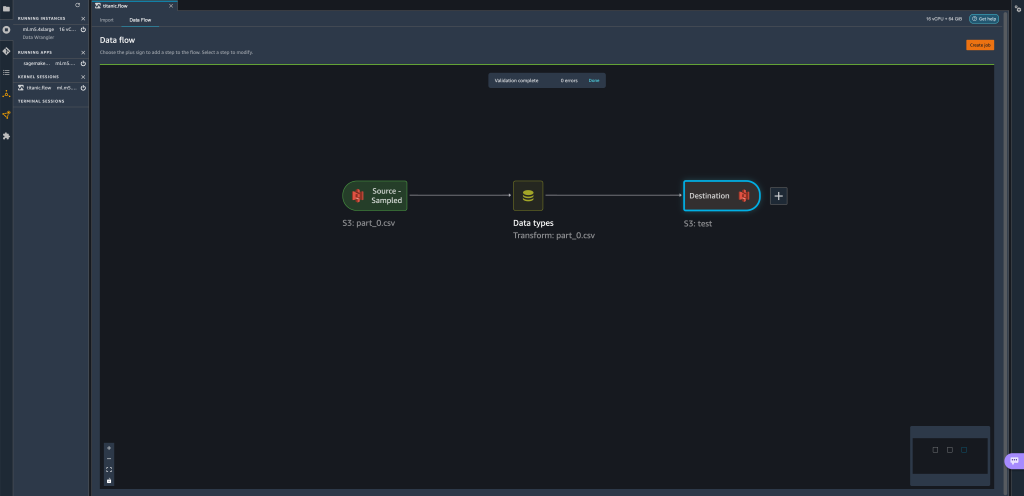

Ervan uitgaande dat we de waarde van wijzigenfilename_paramoppompen vantrain.csvnaarpart_0.csv, neemt de transformatieklus nupart_0.csv(op voorwaarde dat een bestand met de naampart_0.csvbestaat in dezelfde map) als de nieuwe invoergegevens.

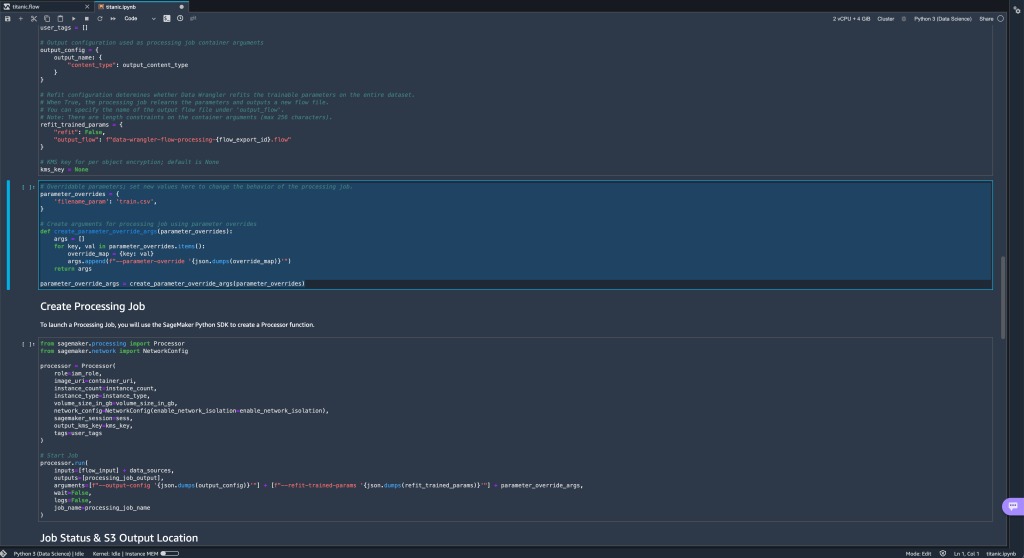

- Bovendien, als u uw stroom probeert te exporteren naar een Amazon S3-bestemming (via een Jupyter-notebook), ziet u nu een nieuwe cel met de parameters die u hebt gedefinieerd.

Merk op dat de parameter hun standaardwaarde aanneemt, maar u kunt deze wijzigen door de waarde in hetparameter_overrideswoordenboek (terwijl de sleutels van het woordenboek ongewijzigd blijven).

Bovendien kunt u nieuwe parameters maken vanuit het parameters UI. - Open het door het parameterpictogram te kiezen ({{}}) gelegen naast de Go keuze; beide bevinden zich naast de waarde van het URI-pad.

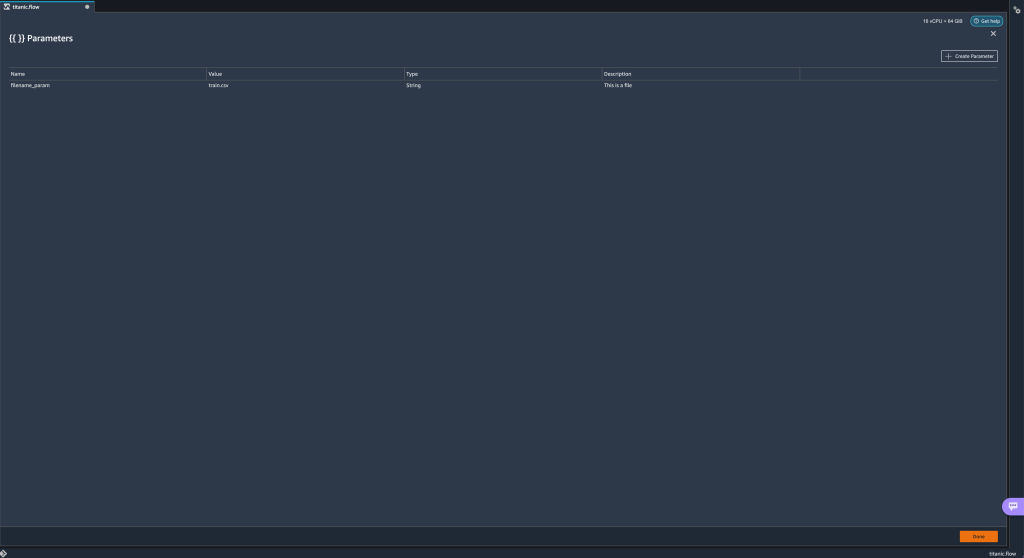

Er wordt een tabel geopend met alle parameters die momenteel bestaan in uw stroombestand (

Er wordt een tabel geopend met alle parameters die momenteel bestaan in uw stroombestand (filename_paramop dit punt). - U kunt nieuwe parameters voor uw stroom maken door te kiezen Parameter maken.

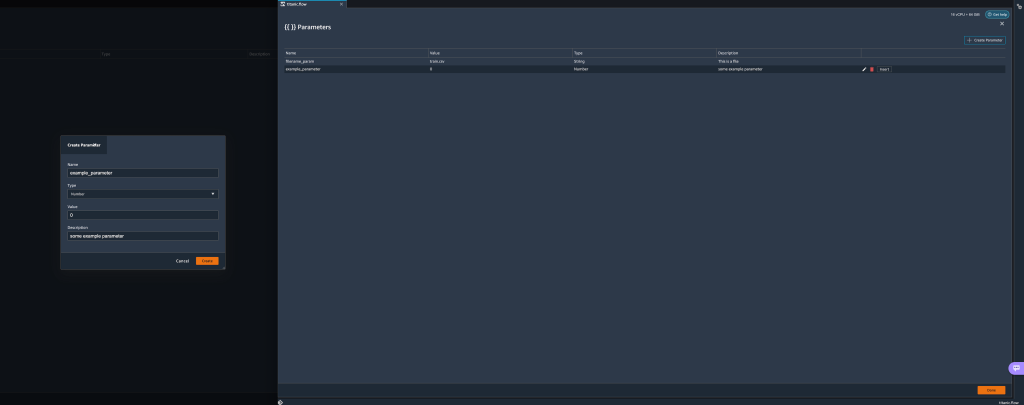

Er wordt een pop-upvenster geopend waarin u een nieuwe aangepaste parameter kunt maken. - Hier hebben we een nieuwe gemaakt

example_parameterals Getaltype met een standaardwaarde van 0. Deze nieuw aangemaakte parameter wordt nu vermeld in de parameters tafel. Door met de muis over de parameter te gaan, worden de opties weergegeven Edit, Verwijder en Invoegen.

- Van binnen de parameters UI, u kunt een van uw parameters in de URI invoegen door de gewenste parameter te selecteren en te kiezen Invoegen.

Dit voegt de parameter toe aan het einde van uw URI. U moet het naar het gewenste gedeelte binnen uw URI verplaatsen.

- Wijzig de standaardwaarde van de parameter, pas de wijziging toe (van de modal), kies Goen kies het pictogram Vernieuwen om de voorbeeldlijst bij te werken met de geselecteerde gegevensset op basis van de nieuw gedefinieerde parameterwaarde.

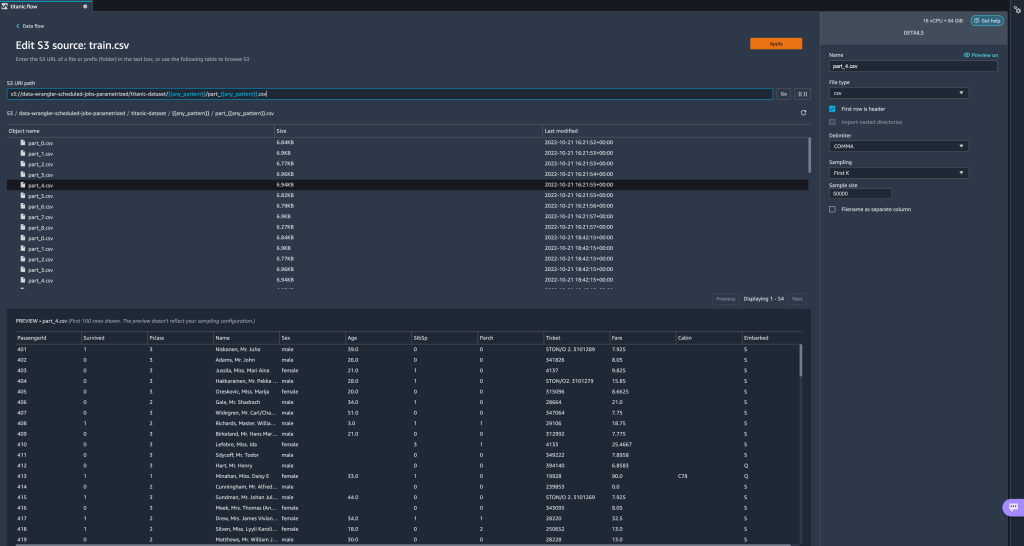

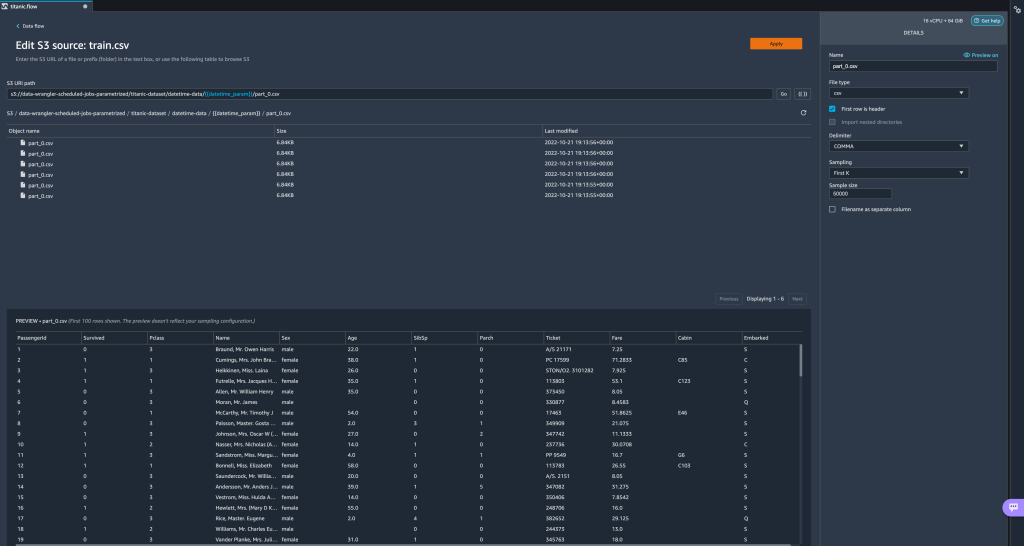

Laten we nu andere parametertypen onderzoeken. Stel dat we nu een dataset hebben die is opgesplitst in meerdere delen, waarbij elk bestand een onderdeelnummer heeft.

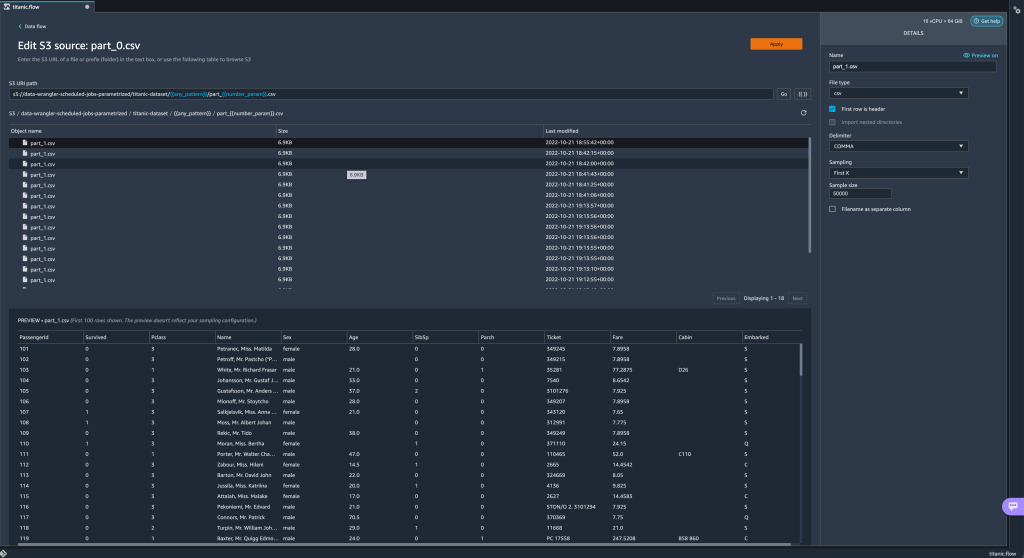

Laten we nu andere parametertypen onderzoeken. Stel dat we nu een dataset hebben die is opgesplitst in meerdere delen, waarbij elk bestand een onderdeelnummer heeft. - Als we het bestandsnummer dynamisch willen wijzigen, kunnen we een Number-parameter definiëren zoals weergegeven in de volgende schermafbeelding.

Merk op dat het geselecteerde bestand het bestand is dat overeenkomt met het nummer dat is opgegeven in de parameter.

Merk op dat het geselecteerde bestand het bestand is dat overeenkomt met het nummer dat is opgegeven in de parameter. Laten we nu demonstreren hoe u een Pattern-parameter kunt gebruiken. Stel dat we alle

Laten we nu demonstreren hoe u een Pattern-parameter kunt gebruiken. Stel dat we alle part_1.csvbestanden in alle mappen onder detitanic-dataset/map. Patroonparameters kunnen elke geldige reguliere expressie aannemen; er worden enkele regex-patronen weergegeven als voorbeelden. - Maak een Pattern-parameter genaamd

any_patternovereenkomen met elke map of bestand onder detitanic-dataset/map met standaardwaarde.*.Merk op dat het jokerteken geen enkele * (asterisk) is maar ook een punt heeft. - Markeer de

titanic-dataset/deel van het pad en maak een aangepaste parameter. Deze keer kiezen we voor de Patronen type. Dit patroon selecteert alle aangeroepen bestanden

Dit patroon selecteert alle aangeroepen bestanden part-1.csvuit een van de onderstaande mappentitanic-dataset/. Een parameter kan meerdere keren in een pad worden gebruikt. In het volgende voorbeeld gebruiken we onze nieuw gemaakte parameter

Een parameter kan meerdere keren in een pad worden gebruikt. In het volgende voorbeeld gebruiken we onze nieuw gemaakte parameter any_patterntwee keer in onze URI om overeen te komen met een van de deelbestanden in een van de onderstaande mappentitanic-dataset/. Laten we tot slot een Datetime-parameter maken. Datetime-parameters zijn handig als we te maken hebben met paden die zijn gepartitioneerd op datum en tijd, zoals die gegenereerd door Amazon Kinesis-gegevens Firehose (Zie Dynamische partitionering in Kinesis Data Firehose). Voor deze demonstratie gebruiken we de gegevens onder de map datetime-data.

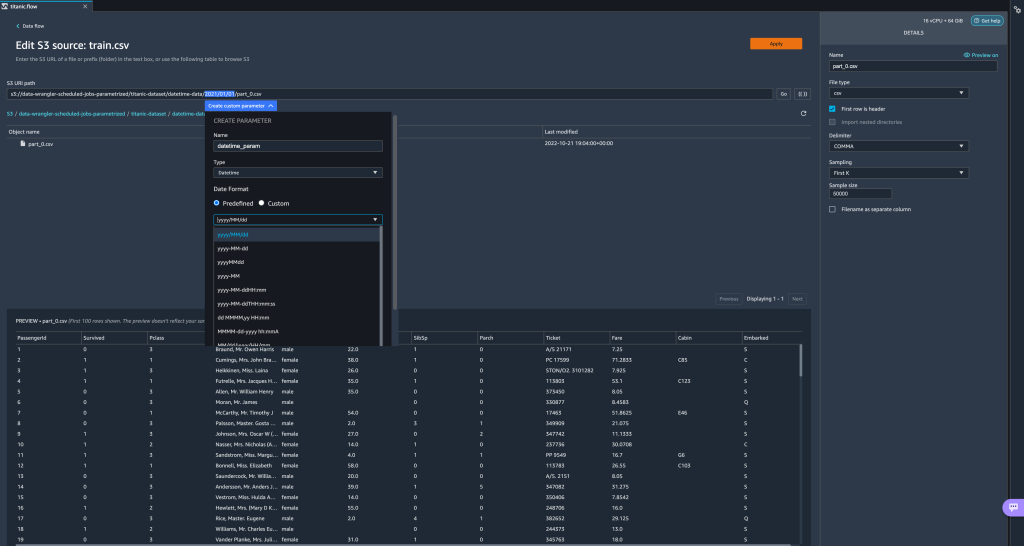

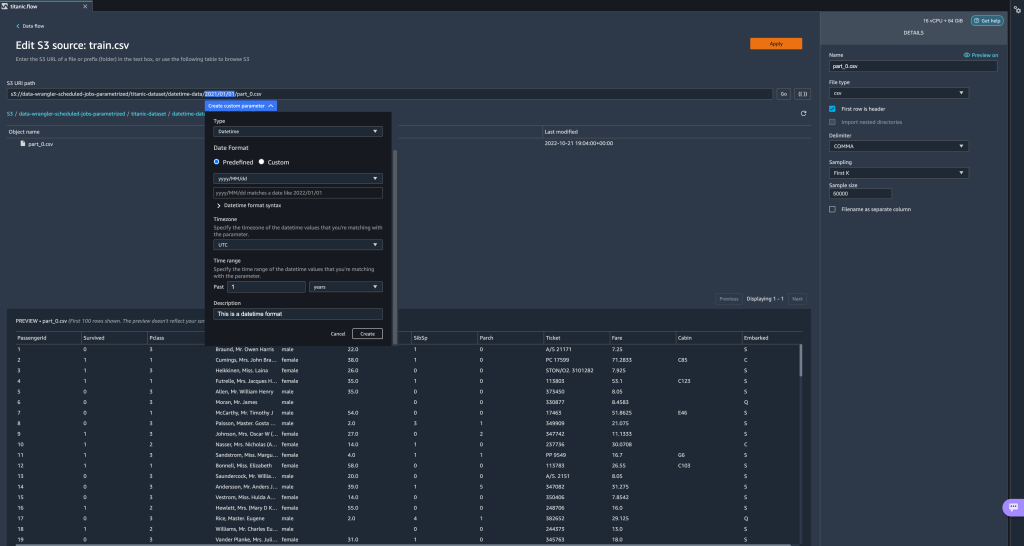

Laten we tot slot een Datetime-parameter maken. Datetime-parameters zijn handig als we te maken hebben met paden die zijn gepartitioneerd op datum en tijd, zoals die gegenereerd door Amazon Kinesis-gegevens Firehose (Zie Dynamische partitionering in Kinesis Data Firehose). Voor deze demonstratie gebruiken we de gegevens onder de map datetime-data. - Selecteer het gedeelte van uw pad dat een datum/tijd is en maak een aangepaste parameter. Kies de Datum Tijd parametertype.

Wanneer u het gegevenstype Datetime kiest, moet u meer details invullen. - Allereerst moet u een datumnotatie opgeven. U kunt elk van de vooraf gedefinieerde datum-/tijdnotaties kiezen of een aangepaste notatie maken.

Voor de vooraf gedefinieerde datum-/tijdnotaties geeft de legenda een voorbeeld van een datum die overeenkomt met de geselecteerde notatie. Voor deze demonstratie kiezen we het formaat jjjj/MM/dd.

- Geef vervolgens een tijdzone op voor de datum-/tijdwaarden.

De huidige datum kan bijvoorbeeld 1 januari 2022 zijn in de ene tijdzone, maar kan 2 januari 2022 zijn in een andere tijdzone. - Ten slotte kunt u het tijdsbereik selecteren, waarmee u het bereik van bestanden kunt selecteren dat u in uw gegevensstroom wilt opnemen.

U kunt uw tijdbereik specificeren in uren, dagen, weken, maanden of jaren. Voor dit voorbeeld willen we alle bestanden van het afgelopen jaar ophalen. - Geef een beschrijving van de parameter en kies creëren.

Als u meerdere datasets met verschillende tijdzones gebruikt, wordt de tijd niet automatisch geconverteerd; u moet elk bestand of elke bron voorbewerken om het naar één tijdzone te converteren. De geselecteerde bestanden zijn alle bestanden onder de mappen die overeenkomen met de gegevens van vorig jaar.

De geselecteerde bestanden zijn alle bestanden onder de mappen die overeenkomen met de gegevens van vorig jaar.

- Als we nu een gegevenstransformatietaak maken, kunnen we een lijst zien van al onze gedefinieerde parameters en kunnen we hun standaardwaarden overschrijven, zodat onze transformatietaken de opgegeven bestanden kiezen.

Plan verwerkingsopdrachten

U kunt nu verwerkingstaken plannen om het uitvoeren van de gegevenstransformatietaken en het exporteren van uw getransformeerde gegevens naar Amazon S3 of Amazon SXNUMX te automatiseren Amazon SageMaker Feature Store. U kunt de taken plannen met de tijd en frequentie die bij u past.

Geplande verwerkingstaken gebruiken Amazon EventBridge reglement om de uitvoering van de taak te plannen. Daarom moet u er als eerste vereiste voor zorgen dat de AWS Identiteits- en toegangsbeheer (IAM) rol die wordt gebruikt door Data Wrangler, namelijk de Amazon Sage Maker uitvoerende rol van de Studio-instantie, heeft machtigingen om EventBridge-regels te maken.

IAM configureren

Ga verder met de volgende updates voor de IAM SageMaker-uitvoeringsrol die overeenkomt met de Studio-instantie waarop de Data Wrangler-stroom wordt uitgevoerd:

- Bevestig de AmazonEventBridgeFullAccess beheerd beleid.

- Voeg een beleid toe om toestemming te verlenen voor het maken van een verwerkingstaak:

- Geef EventBridge toestemming om de rol op zich te nemen door het volgende vertrouwensbeleid toe te voegen:

Als u een andere rol gebruikt om de verwerkingstaak uit te voeren, past u het beleid dat in stap 2 en 3 wordt beschreven toe op die rol. Raadpleeg voor meer informatie over de IAM-configuratie Maak een schema om nieuwe gegevens automatisch te verwerken.

Maak een schema

Als u een schema wilt maken, opent u uw stroom in de Data Wrangler-stroomeditor.

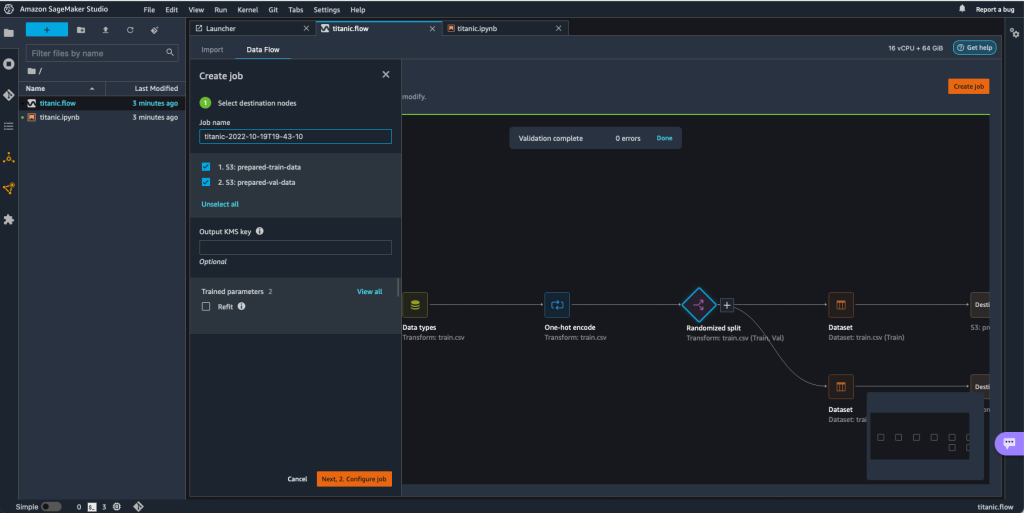

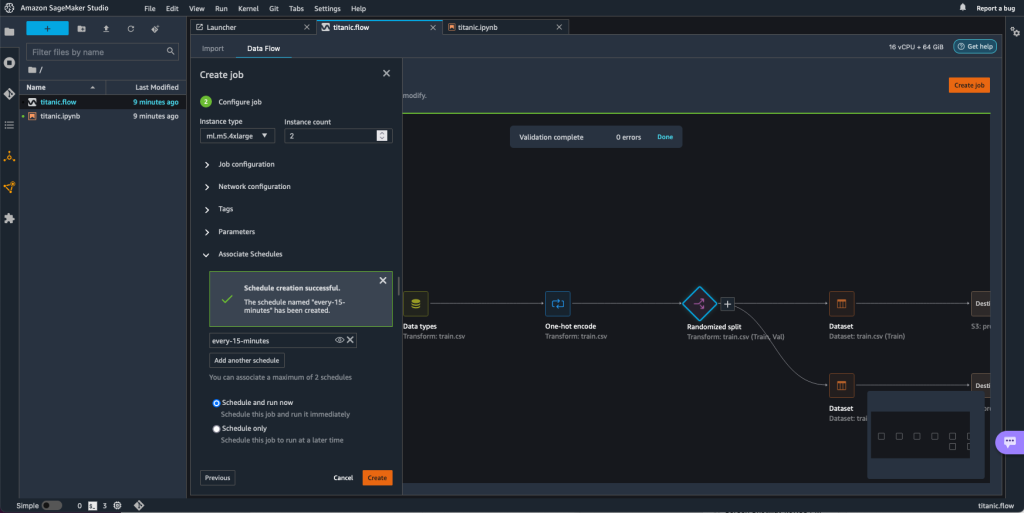

- Op de Informatiestroom tabblad, kies Baan creëren.

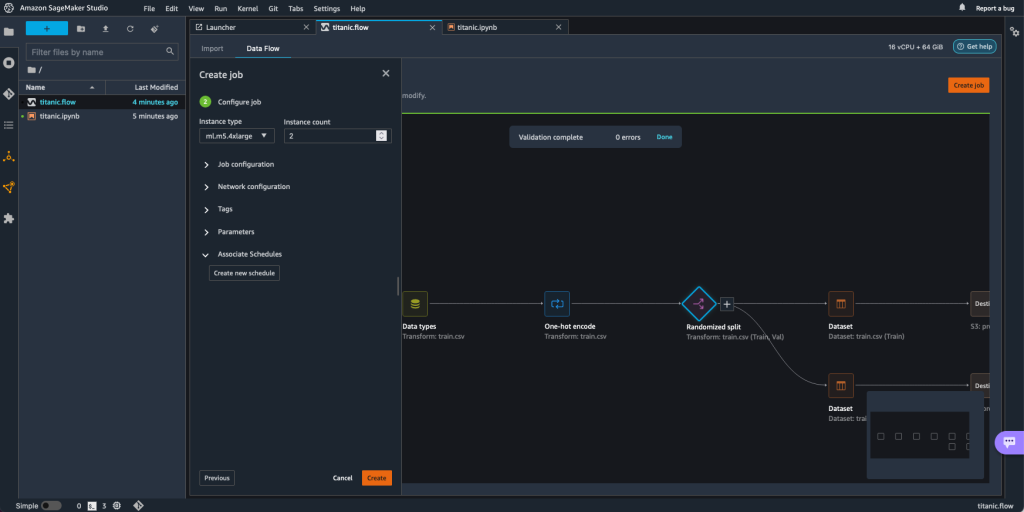

- Configureer de vereiste velden en kies Vervolgens 2. Configureer de taak.

- Uitvouwen Geassocieerde schema's.

- Kies Nieuw schema maken.

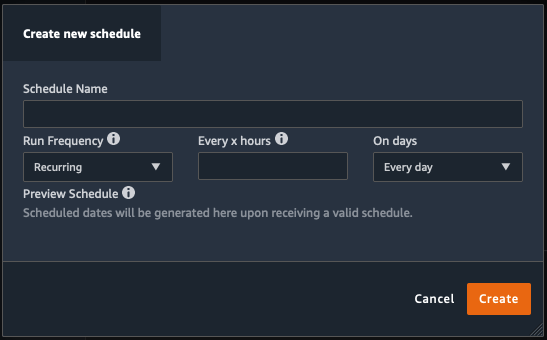

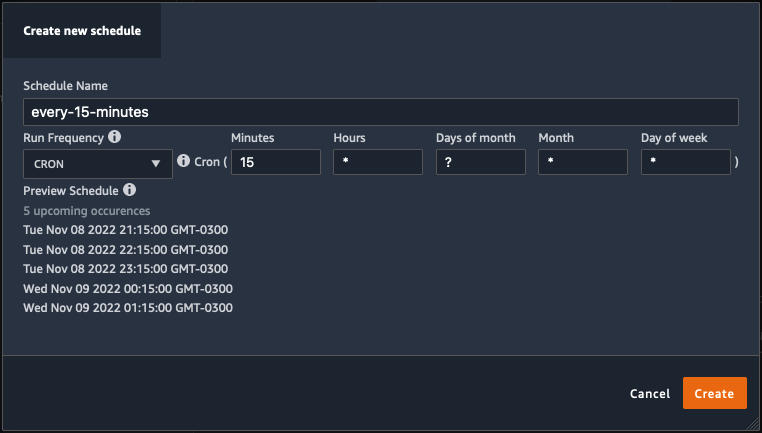

De Nieuw schema maken dialoogvenster wordt geopend, waarin u de details van het verwerkingstaakschema definieert.

Het dialoogvenster biedt grote flexibiliteit om u te helpen bij het definiëren van het schema. U kunt de verwerkingstaak bijvoorbeeld op een bepaald tijdstip laten draaien of elke X uur, op bepaalde dagen van de week.

De periodiciteit kan gedetailleerd zijn tot op het niveau van minuten.

- Definieer de naam en periodiciteit van het schema en maak vervolgens uw keuze creëren om het schema op te slaan.

- U hebt de mogelijkheid om de verwerkingstaak meteen te starten samen met de planning, die zorgt voor toekomstige uitvoeringen, of om de taak alleen volgens het schema te laten uitvoeren.

- U kunt ook een aanvullend schema definiëren voor dezelfde verwerkingstaak.

- Om het schema voor de verwerkingstaak te voltooien, kiest u creëren.

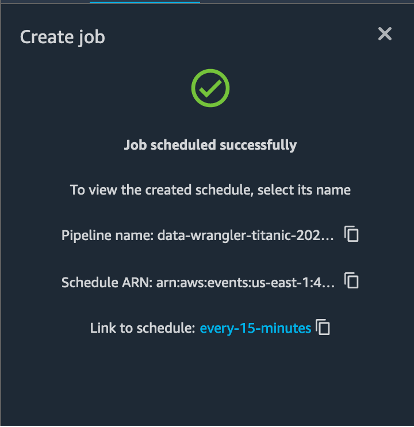

U ziet een bericht "Taak gepland succesvol". Als u ervoor kiest om de taak alleen volgens het schema te laten uitvoeren, ziet u bovendien een koppeling naar de EventBridge-regel die u zojuist hebt gemaakt.

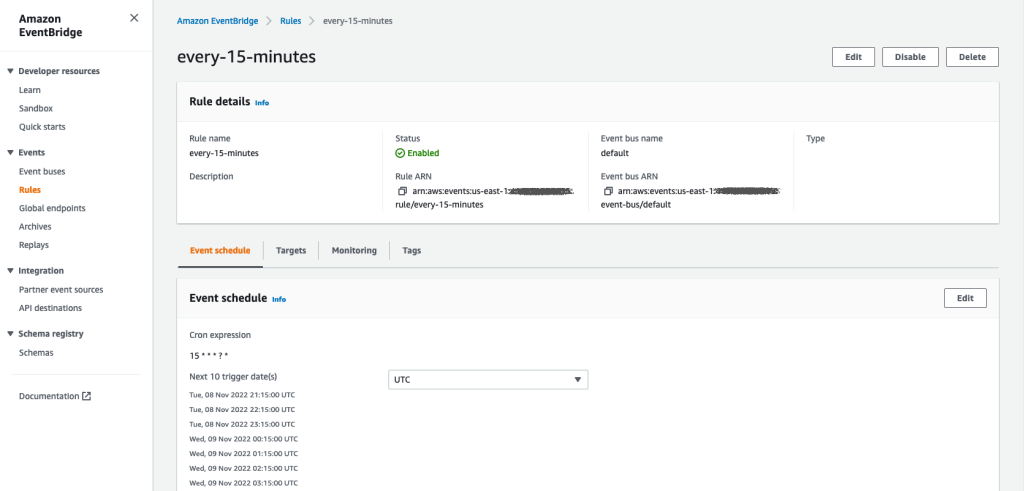

Als u de planningslink kiest, wordt er een nieuw tabblad in de browser geopend met de EventBridge-regel. Op deze pagina kunt u verdere wijzigingen aanbrengen in de regel en de aanroepgeschiedenis volgen. Om te voorkomen dat uw geplande verwerkingstaak wordt uitgevoerd, verwijdert u de gebeurtenisregel die de planningsnaam bevat.

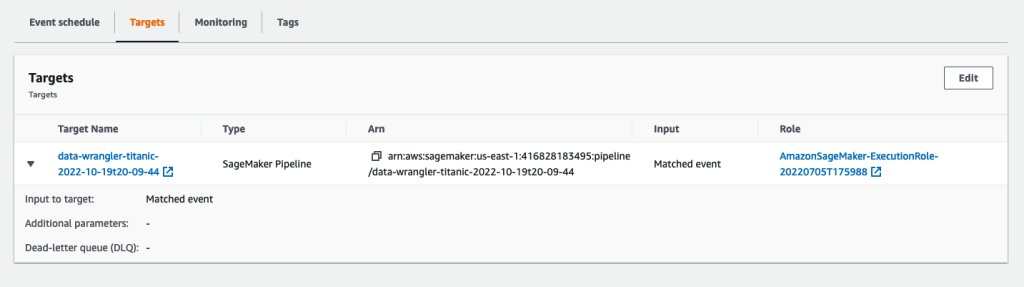

De EventBridge-regel toont een SageMaker-pijplijn als doel, die wordt geactiveerd volgens het gedefinieerde schema, en de verwerkingstaak wordt aangeroepen als onderdeel van de pijplijn.

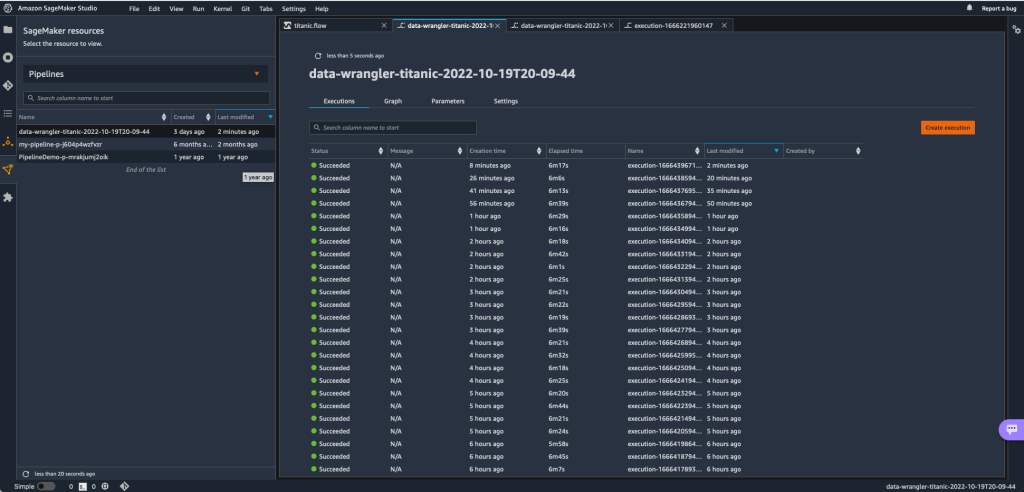

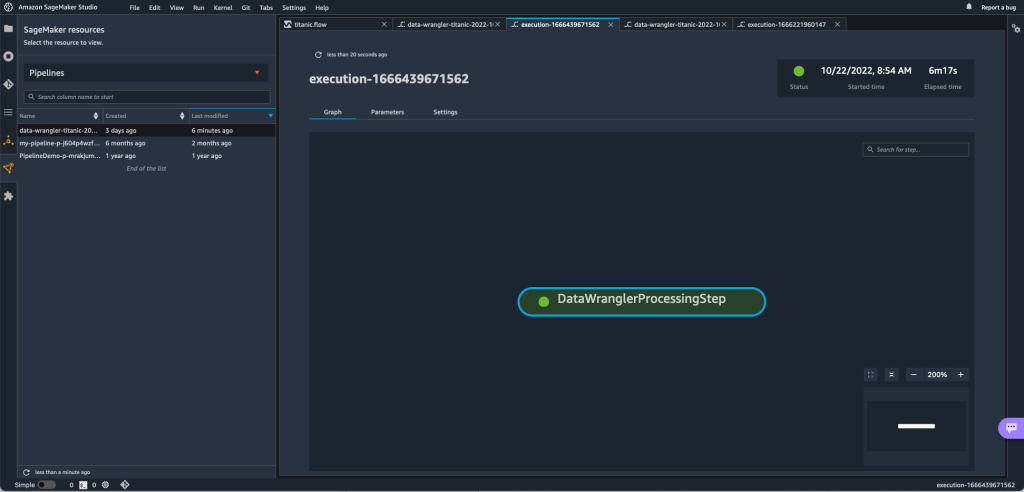

Om de uitvoeringen van de SageMaker-pijplijn bij te houden, kunt u teruggaan naar Studio en de SageMaker-bronnen pictogram, kies Pijpleidingenen kies de pijplijnnaam die u wilt volgen. U kunt nu een tabel zien met alle huidige en eerdere uitvoeringen en de status van die pijplijn.

U kunt meer details zien door te dubbelklikken op een specifiek item.

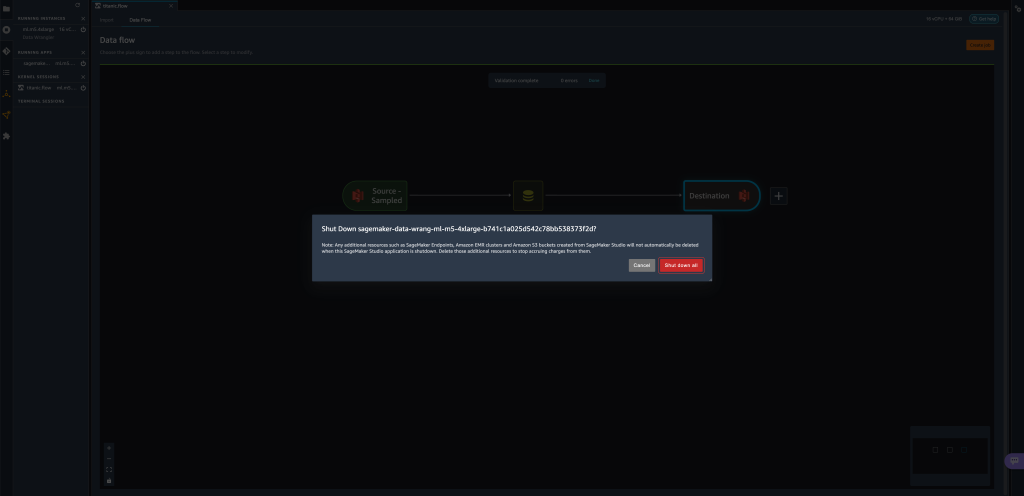

Opruimen

Wanneer u Data Wrangler niet gebruikt, is het raadzaam om de instantie waarop het draait af te sluiten om extra kosten te voorkomen.

Sla uw gegevensstroom op voordat u Data Wrangler afsluit om te voorkomen dat u werk verliest.

- Om uw gegevensstroom in Studio op te slaan, kiest u Dien in, kies dan Gegevens Wrangler-stroom opslaan. Data Wrangler slaat uw gegevensstroom automatisch elke 60 seconden op.

- Om de Data Wrangler-instantie af te sluiten, kiest u in Studio: Instanties en kernels uitvoeren.

- Onder ACTIEVE APPS, kies het afsluitpictogram naast de

sagemaker-data-wrangler-1.0app.

- Kies Alles afsluiten bevestigen.

Data Wrangler draait op een ml.m5.4xlarge instantie. Deze instantie verdwijnt uit LOPENDE INSTANTIES wanneer u de Data Wrangler-app afsluit.

Nadat u de Data Wrangler-app hebt afgesloten, moet deze opnieuw worden opgestart de volgende keer dat u een Data Wrangler-stroombestand opent. Dit kan enkele minuten duren.

Conclusie

In dit bericht hebben we gedemonstreerd hoe u parameters kunt gebruiken om uw datasets te importeren met behulp van Data Wrangler-stromen en om er datatransformatietaken op te maken. Geparameteriseerde datasets bieden meer flexibiliteit voor de datasets die u gebruikt en stellen u in staat uw stromen opnieuw te gebruiken. We hebben ook gedemonstreerd hoe u geplande taken kunt instellen om uw gegevenstransformaties en exports naar Amazon S3 of Feature Store te automatiseren, op het tijdstip en de frequentie die bij u past, rechtstreeks vanuit de gebruikersinterface van Data Wrangler.

Raadpleeg voor meer informatie over het gebruik van gegevensstromen met Data Wrangler: Een Data Wrangler-stroom maken en gebruiken en Amazon SageMaker-prijzen. Om aan de slag te gaan met Data Wrangler, zie Bereid ML-gegevens voor met Amazon SageMaker Data Wrangler.

Over de auteurs

David Laredo is een Prototyping Architect voor het Prototyping and Cloud Engineering-team bij Amazon Web Services, waar hij heeft geholpen bij het ontwikkelen van meerdere machine learning-prototypes voor AWS-klanten. Hij heeft de afgelopen 6 jaar gewerkt aan machine learning, waarbij hij ML-modellen heeft getraind en verfijnd en end-to-end-pijplijnen heeft geïmplementeerd om die modellen in productie te nemen. Zijn interessegebieden zijn NLP, ML-applicaties en end-to-end ML.

David Laredo is een Prototyping Architect voor het Prototyping and Cloud Engineering-team bij Amazon Web Services, waar hij heeft geholpen bij het ontwikkelen van meerdere machine learning-prototypes voor AWS-klanten. Hij heeft de afgelopen 6 jaar gewerkt aan machine learning, waarbij hij ML-modellen heeft getraind en verfijnd en end-to-end-pijplijnen heeft geïmplementeerd om die modellen in productie te nemen. Zijn interessegebieden zijn NLP, ML-applicaties en end-to-end ML.

Givanildo Alves is een Prototyping Architect bij het Prototyping and Cloud Engineering-team bij Amazon Web Services, die klanten helpt te innoveren en versnellen door de kunst van het mogelijke op AWS te laten zien, nadat hij al verschillende prototypes rond kunstmatige intelligentie heeft geïmplementeerd. Hij heeft een lange carrière in software engineering en werkte eerder als Software Development Engineer bij Amazon.com.br.

Givanildo Alves is een Prototyping Architect bij het Prototyping and Cloud Engineering-team bij Amazon Web Services, die klanten helpt te innoveren en versnellen door de kunst van het mogelijke op AWS te laten zien, nadat hij al verschillende prototypes rond kunstmatige intelligentie heeft geïmplementeerd. Hij heeft een lange carrière in software engineering en werkte eerder als Software Development Engineer bij Amazon.com.br.

Adriaan Fuentes is een programmamanager bij het Prototyping- en Cloud Engineering-team bij Amazon Web Services, waar hij voor klanten innoveert op het gebied van machine learning, IoT en blockchain. Hij heeft meer dan 15 jaar ervaring met het managen en implementeren van projecten en 1 jaar aanstelling bij AWS.

Adriaan Fuentes is een programmamanager bij het Prototyping- en Cloud Engineering-team bij Amazon Web Services, waar hij voor klanten innoveert op het gebied van machine learning, IoT en blockchain. Hij heeft meer dan 15 jaar ervaring met het managen en implementeren van projecten en 1 jaar aanstelling bij AWS.

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- Amazon machinaal leren

- Amazon SageMaker-gegevens Wrangler

- Mededelingen

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- AWS-machine learning

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- gegevensverwerking

- diepgaand leren

- google ai

- Intermediair (200)

- machine learning

- Geparametriseerde datasets

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- Geplande banen

- syntaxis

- Technische instructies

- zephyrnet