Amazon Sage Maker is een volledig beheerde service die elke ontwikkelaar en datawetenschapper de mogelijkheid biedt om snel machine learning (ML)-modellen op grote schaal te bouwen, trainen en implementeren. ML wordt gerealiseerd in gevolgtrekking. SageMaker biedt vier Inference-opties:

Deze vier opties kunnen grofweg worden ingedeeld in online- en batch-inferentie-opties. In Online Inference wordt verwacht dat verzoeken worden verwerkt zodra ze binnenkomen, en de verbruikende toepassing verwacht een reactie nadat elk verzoek is verwerkt. Dit kan synchroon gebeuren (realtime inferentie, serverloos) of asynchroon (asynchrone inferentie). In een synchroon patroon wordt de verbruikende toepassing geblokkeerd en kan deze niet doorgaan totdat deze een reactie ontvangt. Deze workloads zijn meestal realtime-applicaties, zoals online detectie van creditcardfraude, waarbij reacties worden verwacht in de orde van milliseconden tot seconden en de payloads van verzoeken klein zijn (enkele MB). In het asynchrone patroon wordt de applicatie-ervaring niet geblokkeerd (bijvoorbeeld het indienen van een verzekeringsclaim via een mobiele app) en vereist deze meestal grotere payloads en/of langere verwerkingstijden. In Offline inferentie wordt een aggregatie (batch) van inferentieverzoeken samen verwerkt, en antwoorden worden pas gegeven nadat de hele batch is verwerkt. Meestal zijn deze workloads niet latentiegevoelig, omvatten ze grote hoeveelheden (meerdere GB's) aan gegevens en worden ze gepland met een regelmatige cadans (laat bijvoorbeeld objectdetectie uitvoeren op bewakingscamerabeelden aan het eind van de dag of verwerk loonlijstgegevens aan het einde van de dag). eind van de maand).

Op de kale botten, SageMaker Realtime gevolgtrekking bestaat uit een model(len), het raamwerk/de container waarmee u werkt en de infrastructuur/instanties die uw geïmplementeerde eindpunt ondersteunen. In dit bericht zullen we onderzoeken hoe u een Single Model Endpoint kunt maken en aanroepen.

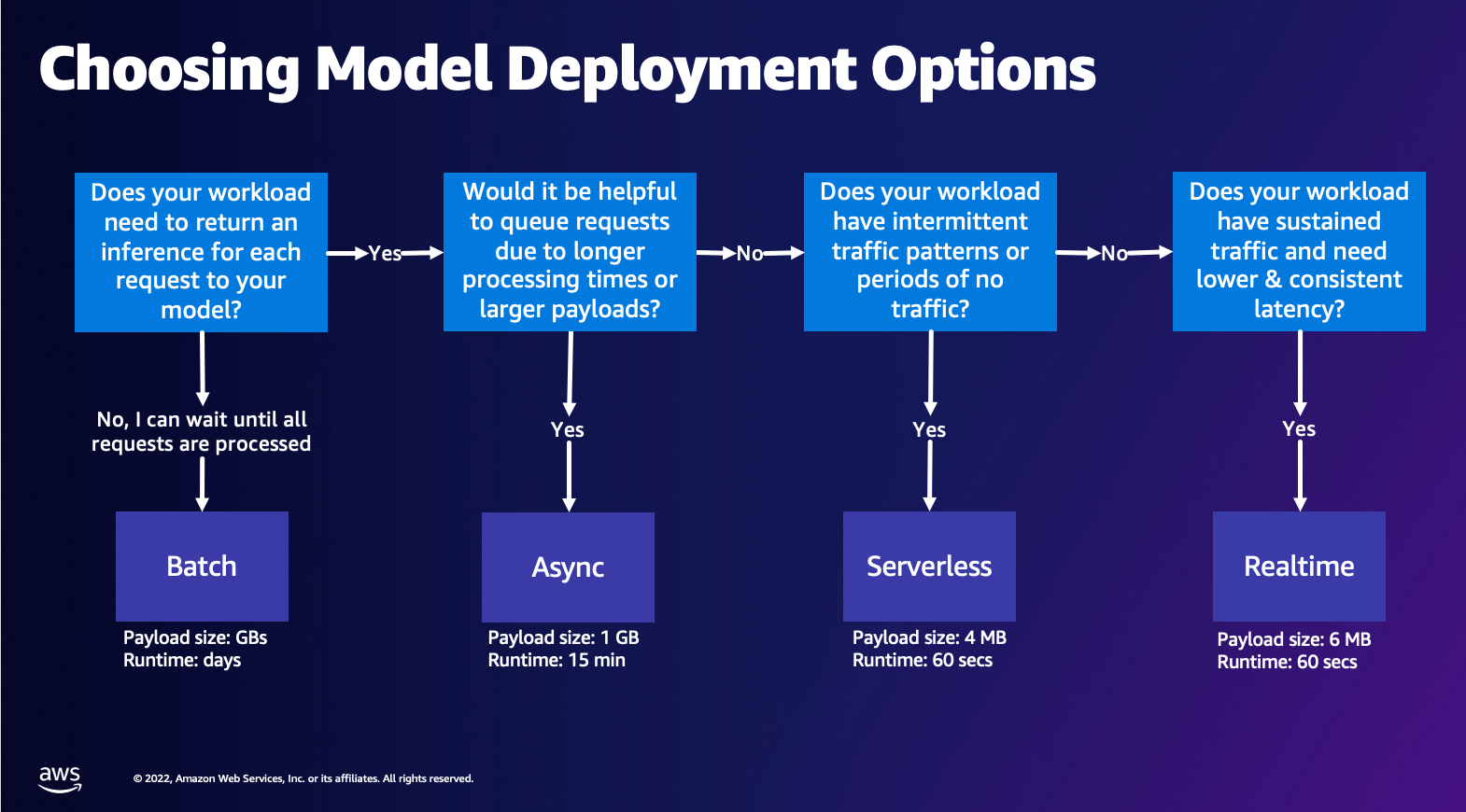

Optie voor modelimplementatie kiezen

Het kiezen van het juiste type gevolgtrekking kan moeilijk zijn en de volgende eenvoudige gids kan u helpen. Het is geen strikt stroomschema, dus als je merkt dat een andere optie beter voor je werkt, gebruik die dan gerust. Real-Time Inference is met name een geweldige optie voor het hosten van uw modellen wanneer u een lage en consistente latentie (in de orde van milliseconden of seconden) en doorvoergevoelige workloads heeft. U kunt het instantietype bepalen en achter uw eindpunt tellen terwijl u ook configureert Automatisch schalen beleid om het verkeer af te handelen. Er zijn twee andere SageMaker Inference-opties die u ook kunt gebruiken om een eindpunt te maken. Asynchrone inferentie is wanneer u een grote payload heeft en een bijna realtime latentiebandbreedte. Dit is een goede optie, vooral voor NLP- en Computer Vision-modellen met langere voorverwerkingstijden. Serverloze inferentie is een geweldige optie wanneer u intermitterend verkeer hebt en de schaling van de infrastructuur niet wilt beheren. Het recept voor het maken van een eindpunt blijft hetzelfde, ongeacht het type gevolgtrekking dat u kiest. In dit bericht zullen we ons concentreren op het maken van een realtime instantiegebaseerd eindpunt, maar u kunt het eenvoudig aanpassen aan een van de andere inferentieopties op basis van uw gebruiksscenario. Ten slotte vindt Batch-inferentie offline plaats, dus u kunt een set gegevens opgeven waaruit u gevolgtrekkingen wilt maken en wij zullen deze uitvoeren. Dit is eveneens instantiegebaseerd, zodat u de optimale instantie voor uw werkbelasting kunt selecteren. Omdat er geen endpoint actief is, betaalt u alleen voor de duur van de opdracht. Het is goed voor het verwerken van gigabytes aan gegevens en de taakduur kan dagen zijn. Er zijn ingebouwde functies om het werken met gestructureerde gegevens gemakkelijker te maken en optimalisaties om gestructureerde gegevens automatisch te distribueren. Enkele voorbeelden van use-cases zijn propensity-modellering, voorspellend onderhoud en churn-voorspelling. Deze kunnen allemaal in bulk offline plaatsvinden omdat er niet op een specifieke gebeurtenis hoeft te worden gereageerd.

Een model hosten op SageMaker Endpoints

In de kern bestaat SageMaker Real-Time Endpoints uit een model en de infrastructuur waarmee u ervoor kiest om het Endpoint te ondersteunen. SageMaker gebruikt containers om modellen te hosten, wat betekent dat je een container nodig hebt die de omgeving correct instelt voor het framework dat je gebruikt voor elk model dat je levert. Als u bijvoorbeeld met een Sklearn-model werkt, moet u uw modelscripts/gegevens doorgeven in een container die Sklearn correct instelt. Gelukkig biedt SageMaker beheerde afbeeldingen voor populaire frameworks, zoals TensorFlow, PyTorch, Sklearn en HuggingFace. U kunt deze afbeeldingen ophalen en gebruiken met behulp van de high-level SageMaker Python-SDK en injecteer uw modelscripts en gegevens in deze containers. In het geval dat SageMaker geen ondersteunde container heeft, kunt u ook: Bouw je eigen container en push uw eigen aangepaste afbeelding, waarbij u de afhankelijkheden installeert die nodig zijn voor uw model.

SageMaker ondersteunt zowel getrainde als vooraf getrainde modellen. In de vorige paragraaf, als we het hebben over modelscripts/gegevens, verwijzen we naar deze kwestie. U kunt ofwel een script aan uw container koppelen, of als u een vooraf getraind modelartefact hebt (bijvoorbeeld `model.joblib` voor SKLearn), dan kunt u dit samen met uw afbeelding aan SageMaker verstrekken. Om SageMaker Inference te begrijpen, zijn er drie hoofdentiteiten die u maakt tijdens het maken van eindpunten:

- SageMaker-modelentiteit - Hier kunt u uw getrainde modelgegevens/modelscript en uw afbeelding waarmee u werkt doorgeven, of deze nu eigendom is van AWS of door u is gebouwd.

- Aanmaken van eindpuntconfiguratie - Hier definieert u uw infrastructuur, wat betekent dat u het exemplaartype, het aantal, enz. selecteert.

- Eindpunt maken: dit is het REST-eindpunt dat als host fungeert voor uw model dat u aanroept om een reactie te krijgen. Laten we eens kijken hoe u een beheerd SageMaker-image en uw eigen op maat gemaakte image kunt gebruiken om een eindpunt te implementeren.

Realtime eindpuntvereisten

- Voordat u een eindpunt maakt, moet u weten welk type model u wilt hosten. Als het een Framework-model is, zoals TensorFlow, PyTorch of MXNet, kunt u een van de vooraf gebouwde Framework-afbeeldingen.

Als het een aangepast model is, of als u volledige flexibiliteit wilt bij het maken van de container die SageMaker zal uitvoeren voor inferentie, dan kunt u uw eigen container bouwen.

SageMaker-eindpunten zijn samengesteld uit een SageMaker-model en Eindpuntconfiguratie.

Als u Boto3 gebruikt, maakt u beide objecten. Anders, als u de SageMaker Python SDK gebruikt, wordt de eindpuntconfiguratie namens u gemaakt wanneer u de .deploy(..) functie.

SageMaker-entiteiten:

- SageMaker-model:

- Bevat de details van het gevolgtrekkingsbeeld, de locatie van de modelartefacten in Amazon Simple Storage-service (Amazon S3), netwerkconfiguratie, en AWS identiteits- en toegangsbeheer (IAM) rol die door het eindpunt moet worden gebruikt.

- SageMaker vereist dat uw modelartefacten worden gecomprimeerd in a

.tar.gzhet dossier. SageMaker extraheert dit automatisch.tar.gzbestand in de/opt/ml/model/map in uw container. Als u een van de framework-containers gebruikt, zoals TensorFlow, PyTorch of MXNet, verwacht de container dat uw TAR-structuur als volgt is:- TensorFlow

- PyTorch

- MXNet

- Sleren

- TensorFlow

- Bij gebruik van een Framework-image kunnen we een aangepast entrypoint-script leveren, waar we onze eigen voor- en nabewerking kunnen implementeren. In ons geval is het inferentiescript verpakt in de model.tar.gz onder de /code directory.

- SageMaker vereist dat uw modelartefacten worden gecomprimeerd in a

- Bevat de details van het gevolgtrekkingsbeeld, de locatie van de modelartefacten in Amazon Simple Storage-service (Amazon S3), netwerkconfiguratie, en AWS identiteits- en toegangsbeheer (IAM) rol die door het eindpunt moet worden gebruikt.

-

- Eindpuntconfiguratie

- Bevat de infrastructuurinformatie die nodig is om het SageMaker-model op het eindpunt te implementeren.

- Het SageMaker-model dat we hebben gemaakt, wordt hier bijvoorbeeld gespecificeerd, evenals het exemplaartype en het aantal initiële exemplaren.

Frameworks en BYOC

-

- SageMaker-afbeeldingen ophalen

- Dit gedeelte is niet altijd nodig en wordt geabstraheerd door de SageMaker Python SDK via schatters. Als u echter een door SageMaker beheerde afbeelding wilt kunnen ophalen om erop uit te breiden, kunt u de afbeeldingen krijgen die beschikbaar zijn via de SDK. Het volgende is een voorbeeld van het ophalen van een TF 2.2-afbeelding voor gevolgtrekking.

- Frameworks

- In het geval dat u een Framework-model wilt implementeren, zoals TensorFlow, PyTorch of MXNet, hebt u alleen de modelartefacten nodig.

- Zie de documentatie voor het direct implementeren van modellen vanuit modelartefacten voor: TensorFlow, PyTorchof MXNet.

- SageMaker-afbeeldingen ophalen

-

- Kiezen tussen 1P en BYOC

- De SageMaker SDK abstraheert ook het afhandelen van de afbeelding, zoals je zag in de vorige Frameworks-sectie. Het heeft kant-en-klare schatters voor Sklearn, TensorFlow en PyTorch die automatisch de afbeelding voor je selecteren op basis van de versie die je hebt geselecteerd. Dan kun je een training/inferentiescript doorgeven Scriptmodus in deze schatters.

- Niet alle pakketten en afbeeldingen worden ondersteund door SageMaker, en in dit geval moet u: neem je eigen container mee (BYOC). Dit betekent dat u een Dockerfile moet bouwen die de juiste omgeving voor uw modelserving zal opzetten. Een voorbeeld hiervan is de Spacy NLP-module en er zijn geen beheerde SageMaker-containers voor dit framework. Daarom moet u een Docker-bestand opgeven waarmee Spacy wordt geïnstalleerd. Binnen de container monteer je ook je modelinferentiescripts. Laten we snel de componenten bespreken die u levert in een Bring Your Own Container-formaat, aangezien deze voor de meeste voorbeelden consistent blijven.

- "nginx.conf" is het configuratiebestand voor de nginx-front-end. U hoeft dit bestand niet te bewerken, tenzij u deze delen wilt afstemmen.

- "voorspeller.py" is het programma dat de Flask-webserver en modelcode voor uw toepassing daadwerkelijk implementeert. U kunt nog meer Python-bestanden of -functies in uw container hebben die u in dit bestand kunt aanroepen.

- "dienen" is het programma dat wordt gestart wanneer de container wordt gestart voor hosting. Het start gewoon de gunicorn-server, die meerdere exemplaren van de Flask-app uitvoert die is gedefinieerd in predictor.py. Net als nginx.conf hoeft u dit bestand niet te bewerken, tenzij u nog verdere afstemming wilt uitvoeren.

- "trein" is het programma dat wordt aangeroepen wanneer de container wordt uitgevoerd voor training. U past dit programma aan om uw trainingsalgoritme te implementeren. Als je een vooraf getraind model of framework zoals Spacy meeneemt, heb je dit bestand niet nodig.

- "wsgi.py" is een kleine wrapper die wordt gebruikt om de Flask-app aan te roepen. U zou dit bestand moeten kunnen nemen zoals het is, tenzij u de naam van uw predictor.py-bestand hebt gewijzigd. Zorg er in dat geval voor dat deze hier goed in kaart wordt gebracht.

- Kiezen tussen 1P en BYOC

-

- Aangepast inferentiescript

- SageMaker Framework-containers bieden u de flexibiliteit om de pre-/postverwerking van de aanvraag en het laden van het model af te handelen met behulp van een aangepast toegangspuntscript/inference.py.

- Zie de documentatie voor het maken van een aangepast inference.py-script voor: TensorFlow, PyTorch en MXNet.

- Aangepaste container

- Aangepast inferentiescript

Verschillende manieren waarop u kunt communiceren met SageMaker Endpoints

Er zijn veel opties om SageMaker programmatisch te gebruiken, zodat u uw geïmplementeerde modellen kunt aanroepen om gevolgtrekkingen te krijgen. De AWS-opdrachtregelinterface (AWS CLI), REST API's, AWS CloudFormatie, AWS Cloud Development Kit (AWS CDK)), en AWS SDK's zijn algemene tools die worden aangeboden door AWS en breed worden ondersteund door andere AWS-services. Voor SageMaker hebben we ook een SageMaker Python SDK. Laten we nu de verschillende opties vergelijken om SageMaker Endpoints te maken, aan te roepen en te beheren.

Naast SageMaker-CLI, zijn er twee manieren om programmatisch te communiceren met Endpoints in SageMaker via de SDK's. Laten we eens kijken naar enkele verschillen tussen SageMaker Python-SDK en Boto3 Python-SDK:

- SageMaker "Python" SDK op hoog niveau - Deze SDK is een open-sourcebibliotheek die abstractie op een hoger niveau biedt, specifiek bedoeld voor het programmatisch aanroepen van SageMaker-API's met behulp van Python. Het goede van deze SDK is dat het heel eenvoudig is om sagemaker-API's aan te roepen, er wordt al veel zwaar werk gedaan, zoals het synchroon / asynchrone modus aanroepen van de API's (helpt polling te voorkomen), eenvoudiger verzoek / antwoordschema, veel minder code en veel eenvoudigere code. SageMaker Python SDK biedt verschillende abstracties op hoog niveau voor het werken met SageMaker. Het pakket is bedoeld om verschillende ML-processen op SageMaker te vereenvoudigen.

- Low-level AWS SDK (Boto3 SDK) – Deze SDK werkt op het lagere niveau doordat de gebruiker kan kiezen uit de ondersteunde programmeertalen en alle AWS-services programmatisch kan aanroepen. Dit is niet alleen specifiek voor SageMaker, maar kan in het algemeen voor alle AWS-services worden gebruikt. De low-level AWS SDK's zijn beschikbaar in verschillende programmeertalen, zoals .NET, Python, Java, Node.js, enz. Een van de populaire SDK's die wordt gebruikt is boto3 python SDK, die populair is in de gemeenschap van datawetenschappers voor ML. Het goede van deze SDK is dat hij erg licht is en standaard beschikbaar is geïnstalleerd op AWS Lambda Looptijd. Bovendien kunt u deze SDK gebruiken om te communiceren met elke AWS-service buiten SageMaker.

Beide SDK's kunnen voor dezelfde taken worden gebruikt, maar in sommige gevallen is het intuïtiever om de ene meer te gebruiken dan de andere. SageMaker Python SDK wordt aanbevolen voor eenvoudig testen, terwijl AWS SDK/Boto3 wordt aanbevolen voor productietoepassingen voor betere controle over de prestaties. SageMaker as a service biedt bijvoorbeeld vooraf gebouwde en onderhouden afbeeldingen voor populaire frameworks, zoals Sklearn, PyTorch en TensorFlow. Het kan met name handig zijn om SageMaker SDK te gebruiken om deep learning-afbeeldingen op te halen, modellen te trainen met behulp van schatters, en implementeer het model eenvoudig met een eenvoudige API-aanroep. Een voorbeeld om dit in actie te laten zien, is te vinden hier.

Aan de andere kant heb je soms voorgetrainde modellen of verschillende frameworks die je misschien gebruikt. Dit vereist meer maatwerk en de SageMaker SDK biedt dat niet altijd. We hebben drie belangrijke stappen en bijbehorende boto3 API-aanroepen die we moeten uitvoeren om een eindpunt te implementeren: Model creatie, Eindpuntconfiguratie maken en Eindpunt maken. De eerste twee entiteiten zijn geabstraheerd met de SageMaker SDK met onze ondersteunde frameworks, maar we zien die details met de Boto3 SDK. Een uitgebreid voorbeeld om de stappen te laten zien die betrokken zijn bij het gebruik van een Boto3 SDK om een eindpunt te maken en te beheren, vindt u hier.

Overwegingen van SageMaker-hosting

SageMaker Real-Time Inference heeft twee belangrijke optimalisaties die u kunt overwegen: 1/ Prestatie-optimalisatie en 2/ Kostenoptimalisatie. Laten we eerst kijken naar prestatie-optimalisatie, zoals wanneer we te maken hebben met latentiegevoelige workloads, is elke milliseconde cruciaal. Er zijn verschillende knoppen die u kunt afstemmen om uw latentie en doorvoer te optimaliseren. Op instantieniveau kunt u Inferentie-aanbeveler, onze ingebouwde tool voor het testen van belasting, om u te helpen het juiste instantietype te selecteren en te tellen voor uw werkbelasting. Door de juiste combinatie van rekenkracht te gebruiken, profiteert u van zowel prestaties als kosten. U kunt ook afstemmen op container- en raamwerkniveau.

Vragen die u uzelf kunt stellen zijn onder meer:

- Welk kader gebruik je?

- Zijn er omgevingsvariabelen die u in uw container kunt afstemmen?

Een voorbeeld hiervan is maximaliseren TensorFlow-prestaties met SageMaker-containers. Een ander voorbeeld van optimalisaties op containerniveau is: gRPC gebruiken in plaats van REST achter uw eindpunt. Ten slotte kunt u ook op scriptniveau optimaliseren. Neemt uw inferentiecode extra tijd in beslag bij bepaalde blokken? Door elke regel van uw script te timen, kunt u eventuele knelpunten in uw code vastleggen.

Er zijn drie manieren om naar te kijken: het gebruik verbeteren van uw realtime eindpunt:

- Eindpunten met meerdere modellen (MME)

- U kunt duizenden modellen hosten achter één enkel eindpunt. Dit is perfect voor gebruikssituaties waarbij u geen speciaal eindpunt nodig hebt voor elk van uw modellen. MME werkt het beste wanneer de modellen dezelfde grootte en latentie hebben en tot hetzelfde ML-framework behoren. Deze kunnen meestal worden gebruikt wanneer u niet altijd hetzelfde model hoeft te bellen. U kunt het respectieve model dynamisch op het SageMaker Endpoint laden om aan uw verzoek te voldoen. Een voorbeeld dat MME in actie laat zien, is te vinden hier. Als je meer wilt weten over de verschillende waarschuwingen en best practices voor het hosten van modellen op MME, raadpleeg dan de post hier.

- Eindpunten met meerdere containers (MCE)

- In plaats van meerdere eindpunten te gebruiken om meerdere containers te hosten, kunt u kijken naar het hosten van maximaal 15 containers op één enkel eindpunt. Elk van deze containers kan direct worden aangeroepen. Daarom kunt u verschillende modellen van verschillende frameworks allemaal op één eindpunt hosten. Deze optie is het beste wanneer containers vergelijkbare gebruiks- en prestatiekenmerken vertonen. Een voorbeeld dat MCE laat zien, is te vinden hier. Als je meer wilt weten over de verschillende waarschuwingen en best practices voor het hosten van modellen op MCE, raadpleeg dan de post hier.

- Seriële inferentiepijpleiding (SIP)

- Als u een pijplijn van stappen in uw inferentielogica hebt, kunt u Serial Inference Pipeline (SIP) gebruiken. Met SIP kunt u 2-15 containers aan elkaar koppelen achter een enkel eindpunt. SIP werkt goed wanneer u voor- en nabewerkingsstappen heeft. Als u meer wilt weten over de ontwerppatronen voor seriële inferentiepijplijnen, raadpleeg dan de post hier.

De tweede belangrijkste optimalisatie om in gedachten te houden is: kosten. Real-Time Inference is een van de drie opties bij het maken van SageMaker Endpoints. SageMaker Endpoints zijn altijd actief, tenzij ze worden verwijderd. Daarom moet u kijken naar het verbeteren van het gebruik van het eindpunt, wat op zijn beurt een kostenvoordeel oplevert.

SageMaker biedt ook Spaarplannen. Spaarplannen kunnen uw kosten tot 64% verlagen. Dit is een verbintenis van 1 of 3 jaar voor een consistente hoeveelheid gebruik ($/uur). Zie dit link voor meer informatie. En zie dit link voor het optimaliseren van de kosten voor Inference op Amazon SageMaker.

Conclusie

In dit bericht hebben we u enkele van de best practices laten zien om te kiezen tussen verschillende modelhostingopties op SageMaker. We bespraken de SageMaker Endpoint-vereisten, en ook contrasteerde Framework- en BYOC-vereisten en functionaliteit. Verder hebben we het gehad over de verschillende manieren waarop u Real-Time Endpoints kunt gebruiken om uw ML-modellen in productie te hosten. op een kosteneffectieve manier en met hoge prestaties.

Zie de bijbehorende GitHub-repository en probeer de voorbeelden uit.

Over de auteurs

Raghu Ramesha is een ML Solutions Architect bij het Amazon SageMaker Service-team. Hij richt zich op het helpen van klanten bij het bouwen, implementeren en migreren van ML-productieworkloads naar SageMaker op schaal. Hij is gespecialiseerd in machine learning, AI en computer vision-domeinen, en heeft een master in computerwetenschappen van de UT Dallas. In zijn vrije tijd houdt hij van reizen en fotograferen.

Raghu Ramesha is een ML Solutions Architect bij het Amazon SageMaker Service-team. Hij richt zich op het helpen van klanten bij het bouwen, implementeren en migreren van ML-productieworkloads naar SageMaker op schaal. Hij is gespecialiseerd in machine learning, AI en computer vision-domeinen, en heeft een master in computerwetenschappen van de UT Dallas. In zijn vrije tijd houdt hij van reizen en fotograferen.

Ram Vegiraju is een ML Architect bij het SageMaker Service-team. Hij richt zich op het helpen van klanten bij het bouwen en optimaliseren van hun AI/ML-oplossingen op Amazon SageMaker. In zijn vrije tijd houdt hij van reizen en schrijven.

Ram Vegiraju is een ML Architect bij het SageMaker Service-team. Hij richt zich op het helpen van klanten bij het bouwen en optimaliseren van hun AI/ML-oplossingen op Amazon SageMaker. In zijn vrije tijd houdt hij van reizen en schrijven.

Marc Karp is een ML Architect bij het SageMaker Service-team. Hij richt zich op het helpen van klanten bij het ontwerpen, implementeren en beheren van ML-workloads op schaal. In zijn vrije tijd houdt hij van reizen en het ontdekken van nieuwe plaatsen.

Marc Karp is een ML Architect bij het SageMaker Service-team. Hij richt zich op het helpen van klanten bij het ontwerpen, implementeren en beheren van ML-workloads op schaal. In zijn vrije tijd houdt hij van reizen en het ontdekken van nieuwe plaatsen.

Dhawal Patel is Principal Machine Learning Architect bij AWS. Hij heeft met organisaties, variërend van grote ondernemingen tot middelgrote startups, gewerkt aan problemen met betrekking tot gedistribueerde computing en kunstmatige intelligentie. Hij richt zich op deep learning, inclusief NLP en computer vision domeinen. Hij helpt klanten om hoogwaardige modelinferentie te bereiken op Amazon SageMaker.

Dhawal Patel is Principal Machine Learning Architect bij AWS. Hij heeft met organisaties, variërend van grote ondernemingen tot middelgrote startups, gewerkt aan problemen met betrekking tot gedistribueerde computing en kunstmatige intelligentie. Hij richt zich op deep learning, inclusief NLP en computer vision domeinen. Hij helpt klanten om hoogwaardige modelinferentie te bereiken op Amazon SageMaker.

Saurabh Trikande is Senior Product Manager voor Amazon SageMaker Inference. Hij heeft een passie voor het werken met klanten en wordt gemotiveerd door het doel om machine learning te democratiseren. Hij richt zich op kernuitdagingen met betrekking tot het inzetten van complexe ML-applicaties, multi-tenant ML-modellen, kostenoptimalisaties en het toegankelijker maken van de inzet van deep learning-modellen. In zijn vrije tijd houdt Saurabh van wandelen, leren over innovatieve technologieën, TechCrunch volgen en tijd doorbrengen met zijn gezin.

Saurabh Trikande is Senior Product Manager voor Amazon SageMaker Inference. Hij heeft een passie voor het werken met klanten en wordt gemotiveerd door het doel om machine learning te democratiseren. Hij richt zich op kernuitdagingen met betrekking tot het inzetten van complexe ML-applicaties, multi-tenant ML-modellen, kostenoptimalisaties en het toegankelijker maken van de inzet van deep learning-modellen. In zijn vrije tijd houdt Saurabh van wandelen, leren over innovatieve technologieën, TechCrunch volgen en tijd doorbrengen met zijn gezin.

- Gevorderd (300)

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- Amazon Sage Maker

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- AWS-machine learning

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- google ai

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- syntaxis

- zephyrnet