In de dynamische wereld van streaming Amazon MusicElke zoekopdracht naar een nummer, podcast of afspeellijst bevat een verhaal, een stemming of een stortvloed aan emoties die wachten om onthuld te worden. Deze zoekopdrachten dienen als toegangspoort tot nieuwe ontdekkingen, dierbare ervaringen en blijvende herinneringen. De zoekbalk gaat niet alleen over het vinden van een nummer; het gaat over de miljoenen actieve gebruikers die hun persoonlijke reis beginnen naar de rijke en diverse wereld die Amazon Music te bieden heeft.

Het bieden van een superieure klantervaring om direct de muziek te vinden waarnaar gebruikers zoeken, vereist een platform dat zowel slim als responsief is. Amazon Music gebruikt de kracht van AI om dit te bereiken. Het optimaliseren van de klantervaring en tegelijkertijd het beheren van de kosten van training en het afleiden van AI-modellen die de mogelijkheden van de zoekbalk aandrijven, zoals realtime spellingscontrole en vectorzoeken, is echter moeilijk tijdens drukke verkeerstijden.

Amazon Sage Maker biedt een end-to-end set services waarmee Amazon Music met minimale inspanning de AWS Cloud kan bouwen, trainen en implementeren. Door het ongedifferentieerde zware werk uit handen te nemen, kunt u met SageMaker zich concentreren op het werken aan uw machine learning-modellen (ML) en hoeft u zich geen zorgen te maken over zaken als de infrastructuur. Als onderdeel van het gedeelde verantwoordelijkheidsmodel zorgt SageMaker ervoor dat de diensten die zij leveren betrouwbaar, performant en schaalbaar zijn, terwijl u ervoor zorgt dat de toepassing van de ML-modellen optimaal gebruik maakt van de mogelijkheden die SageMaker biedt.

In dit bericht doorlopen we de reis die Amazon Music heeft afgelegd om de prestaties en kosten te optimaliseren met behulp van SageMaker en NVIDIA Triton Inference Server en TensorRT. We duiken er diep in om te laten zien hoe die ogenschijnlijk eenvoudige, maar toch ingewikkelde zoekbalk werkt, en zorgen voor een ononderbroken reis door het universum van Amazon Music met weinig tot nul frustrerende typfoutvertragingen en relevante realtime zoekresultaten.

Amazon SageMaker en NVIDIA: Biedt snelle en nauwkeurige vectorzoek- en spellingcontrolemogelijkheden

Amazon Music biedt een enorme bibliotheek met meer dan 100 miljoen nummers en miljoenen podcastafleveringen. Het vinden van het juiste nummer of de juiste podcast kan echter een uitdaging zijn, vooral als u de exacte titel, artiest of albumnaam niet weet, of als de zoekopdracht erg breed is, zoals 'nieuwspodcasts'.

Amazon Music heeft een tweeledige aanpak gevolgd om het zoek- en ophaalproces te verbeteren. De eerste stap is het introduceren van vectorzoeken (ook bekend als op embedding gebaseerd ophalen), een ML-techniek waarmee gebruikers de meest relevante inhoud kunnen vinden waarnaar ze op zoek zijn door gebruik te maken van de semantiek van de inhoud. De tweede stap omvat het introduceren van een op Transformer gebaseerd spellingcorrectiemodel in de zoekstapel. Dit kan vooral handig zijn bij het zoeken naar muziek, omdat gebruikers mogelijk niet altijd de exacte spelling van de titel van een nummer of de naam van een artiest kennen. Spellingcorrectie kan gebruikers helpen de muziek te vinden waarnaar ze op zoek zijn, zelfs als ze een spelfout maken in hun zoekopdracht.

Het introduceren van Transformer-modellen in een zoek- en ophaalpijplijn (in het insluiten van zoekopdrachten die nodig zijn voor vectorzoekopdrachten en het generatieve Seq2Seq Transformer-model in Spell Correction) kan leiden tot een aanzienlijke toename van de algehele latentie, wat een negatieve invloed heeft op de klantervaring. Daarom werd het voor ons een topprioriteit om de realtime inferentielatentie voor vectorzoek- en spellingcorrectiemodellen te optimaliseren.

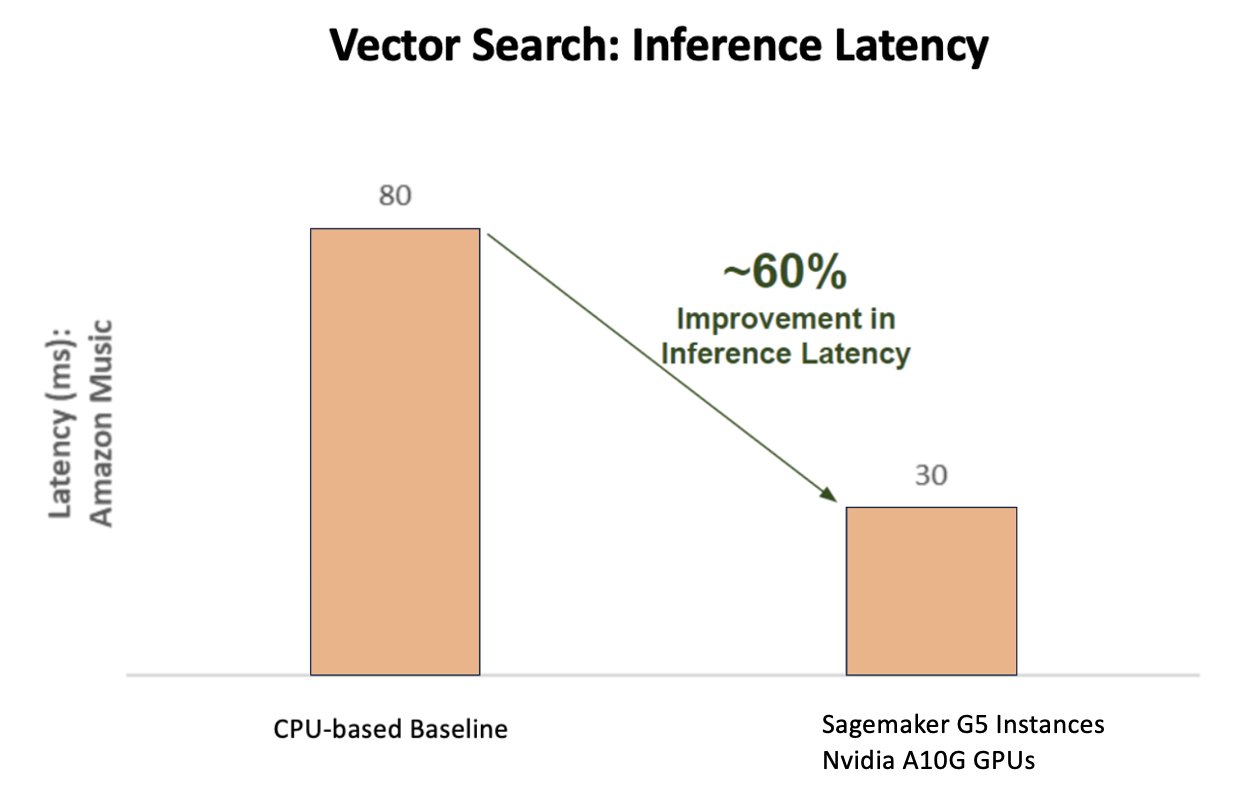

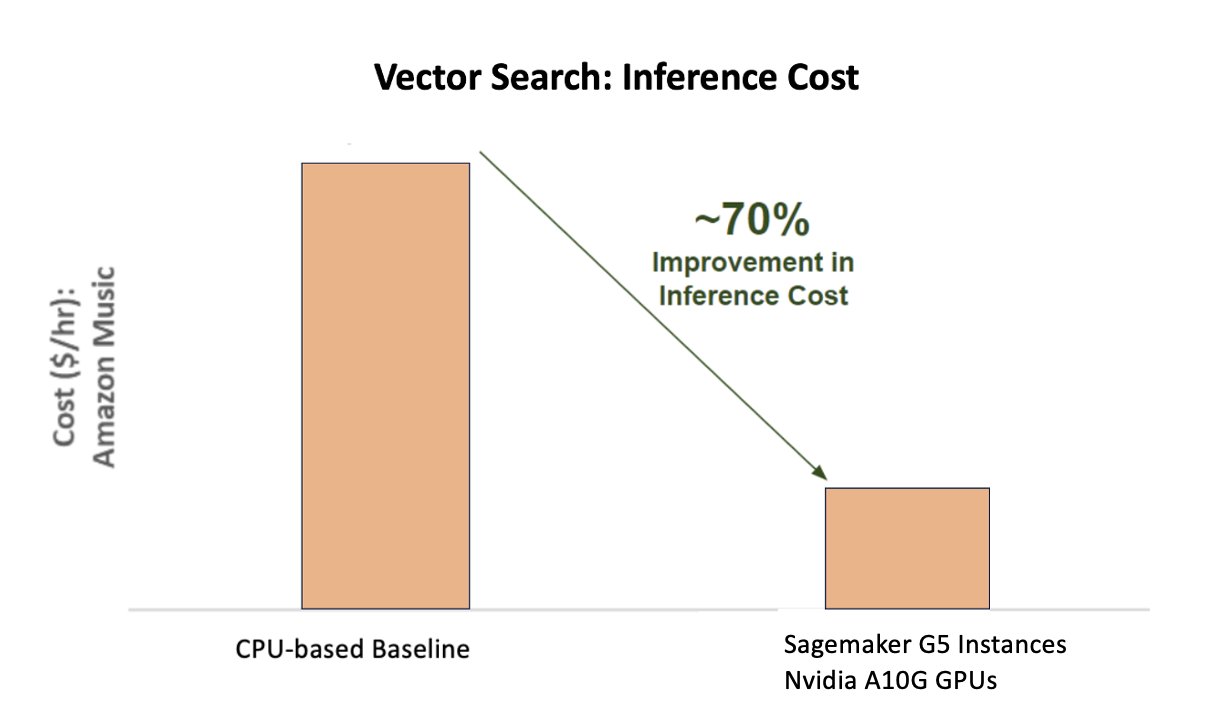

Amazon Music en NVIDIA zijn samengekomen om de best mogelijke klantervaring naar de zoekbalk te brengen, waarbij ze SageMaker gebruiken om zowel snelle als nauwkeurige spellingscontrolemogelijkheden en realtime semantische zoeksuggesties te implementeren met behulp van op vectorzoekopdrachten gebaseerde technieken. De oplossing omvat het gebruik van SageMaker-hosting mogelijk gemaakt door G5-instances die gebruikmaken van NVIDIA A10G Tensor Core GPU's, door SageMaker ondersteunde NVIDIA Triton Inference Server Container en de NVIDIA TensorRT modelformaat. Door de inferentielatentie van het spellingcontrolemodel terug te brengen tot 25 milliseconden bij piekverkeer, en de latentie bij het insluiten van zoekopdrachten met gemiddeld 63% en de kosten met 73% te verminderen in vergelijking met CPU-gebaseerde inferentie, heeft Amazon Music de prestaties van de zoekbalk verbeterd.

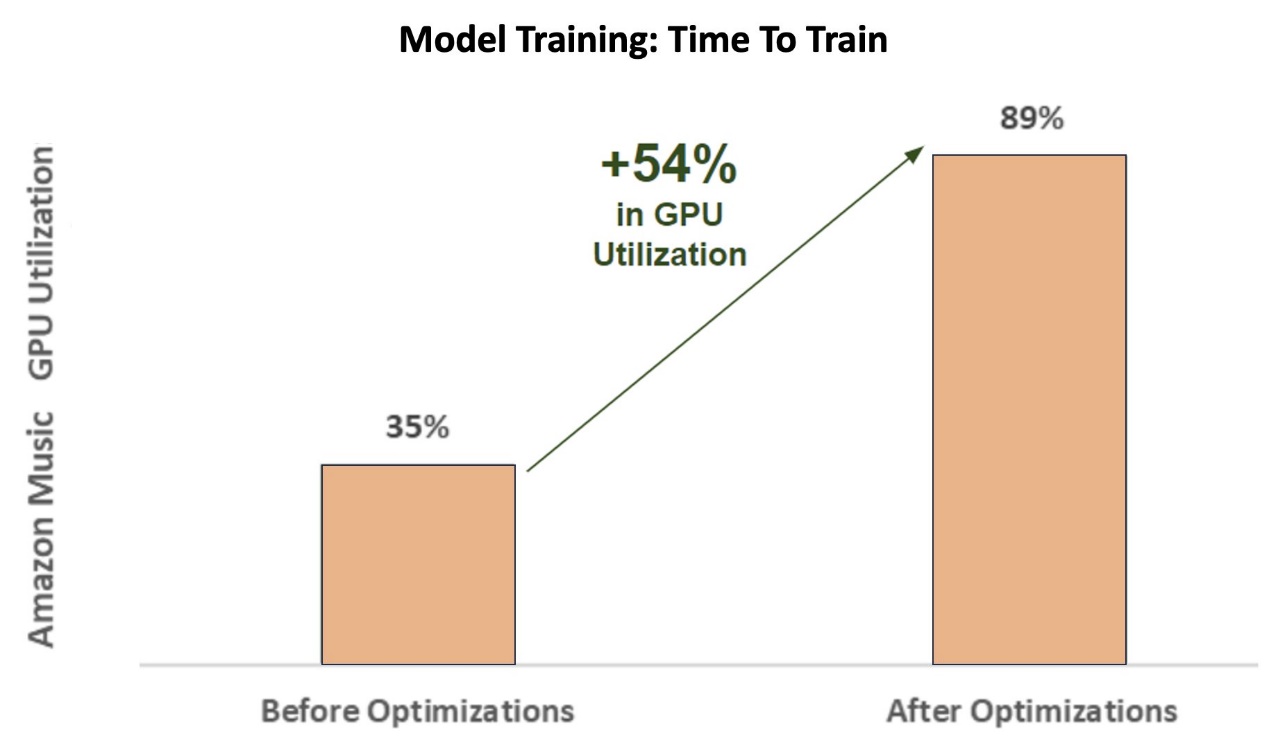

Bovendien bereikte Amazon Music bij het trainen van het AI-model om nauwkeurige resultaten te leveren een maar liefst twaalfvoudige versnelling in de trainingstijd voor hun BART sequence-to-sequence spell corrector transformer-model, waardoor ze zowel tijd als geld bespaarden door hun GPU-gebruik te optimaliseren.

Amazon Music werkte samen met NVIDIA om prioriteit te geven aan de zoekervaring van klanten en een zoekbalk te maken met goed geoptimaliseerde spellingcontrole en vectorzoekfunctionaliteiten. In de volgende secties delen we meer over hoe deze optimalisaties werden georkestreerd.

Training optimaliseren met NVIDIA Tensor Core GPU's

Toegang krijgen tot een NVIDIA Tensor Core GPU voor training van grote taalmodellen is niet voldoende om het ware potentieel ervan te benutten. Er zijn belangrijke optimalisatiestappen die tijdens de training moeten plaatsvinden om het gebruik van de GPU volledig te maximaliseren. Een onderbenutte GPU zal echter ongetwijfeld leiden tot inefficiënt gebruik van hulpbronnen, langere trainingsduur en hogere operationele kosten.

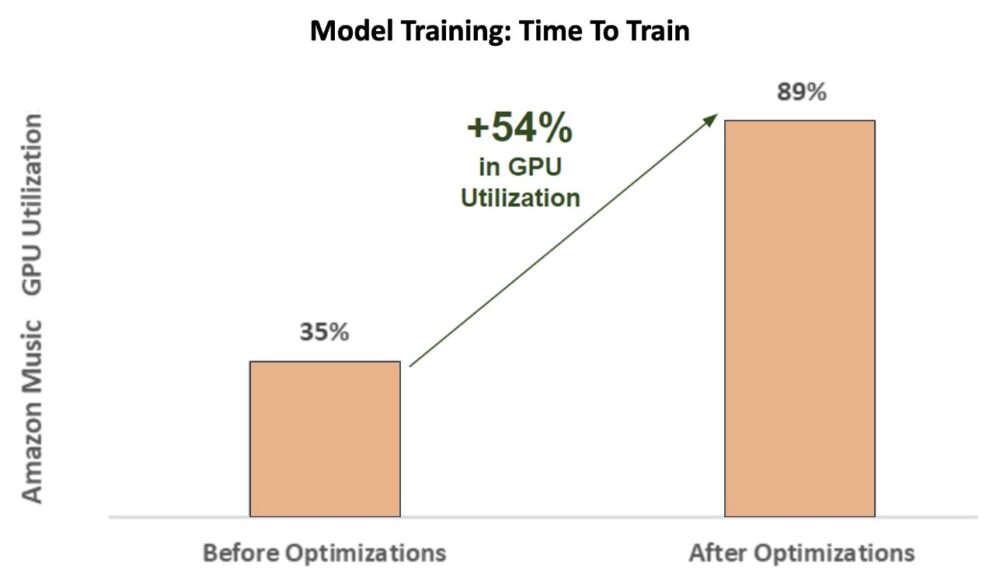

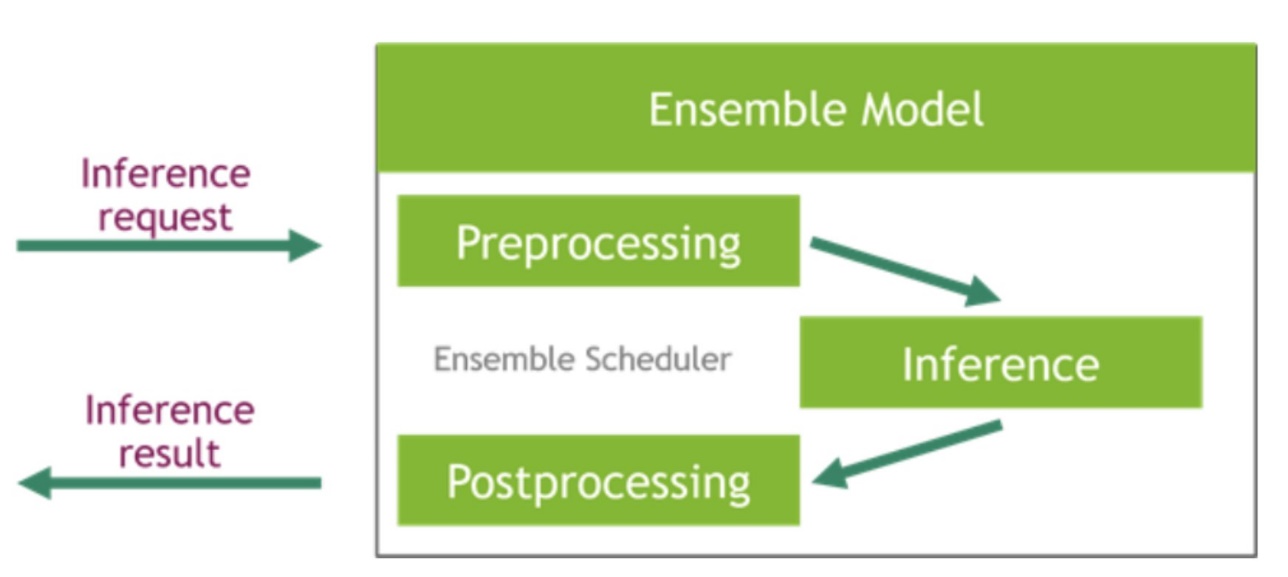

Tijdens de eerste fasen van de training wordt de spellingcorrector BART (bart-basis) transformatormodel op een SageMaker ml.p3.24xlarge-instantie (8 NVIDIA V100 Tensor Core GPU's), bedroeg het GPU-gebruik van Amazon Music ongeveer 35%. Om de voordelen van NVIDIA GPU-versnelde training te maximaliseren, ondersteunden AWS en NVIDIA-oplossingsarchitecten Amazon Music bij het identificeren van gebieden voor optimalisatie, met name rond de batchgrootte en precisieparameters. Deze twee cruciale parameters beïnvloeden de efficiëntie, snelheid en nauwkeurigheid van het trainen van deep learning-modellen.

De resulterende optimalisaties leverden een nieuw en verbeterd V100 GPU-gebruik op, stabiel op ongeveer 89%, waardoor de trainingstijd van Amazon Music drastisch werd teruggebracht van 3 dagen naar 5 à 6 uur. Door de batchgrootte te veranderen van 32 naar 256 en gebruik te maken van optimalisatietechnieken zoals hardlopen automatische gemengde precisietraining in plaats van alleen FP32-precisie te gebruiken, kon Amazon Music zowel tijd als geld besparen.

Het volgende diagram illustreert de toename van 54% procentpunt in het GPU-gebruik na optimalisaties.

De volgende afbeelding illustreert de versnelling van de trainingstijd.

Door deze toename in batchgrootte kon de NVIDIA GPU aanzienlijk meer gegevens gelijktijdig verwerken over meerdere Tensor Cores, wat resulteerde in een snellere trainingstijd. Het is echter belangrijk om een delicaat evenwicht met het geheugen te bewaren, omdat grotere batchgroottes meer geheugen vereisen. Zowel het vergroten van de batchgrootte als het toepassen van gemengde precisie kunnen van cruciaal belang zijn bij het ontsluiten van de kracht van NVIDIA Tensor Core GPU's.

Nadat het model was getraind op convergentie, was het tijd om te optimaliseren voor de implementatie van gevolgtrekkingen in de zoekbalk van Amazon Music.

Spellingcorrectie: gevolgtrekking uit het BART-model

Met de hulp van SageMaker G5-instanties en NVIDIA Triton Inference Server (een open source software voor inferentiebediening), evenals NVIDIA TensorRT, een SDK voor krachtige deep learning-inferentie die een inferentie-optimalisatie en runtime omvat, beperkt Amazon Music hun spellingcontrole BART (bart-basis) modelserver-inferentielatentie tot slechts 25 milliseconden bij piekverkeer. Dit omvat overheadkosten zoals taakverdeling, voorverwerking, modelinferentie en naverwerkingstijden.

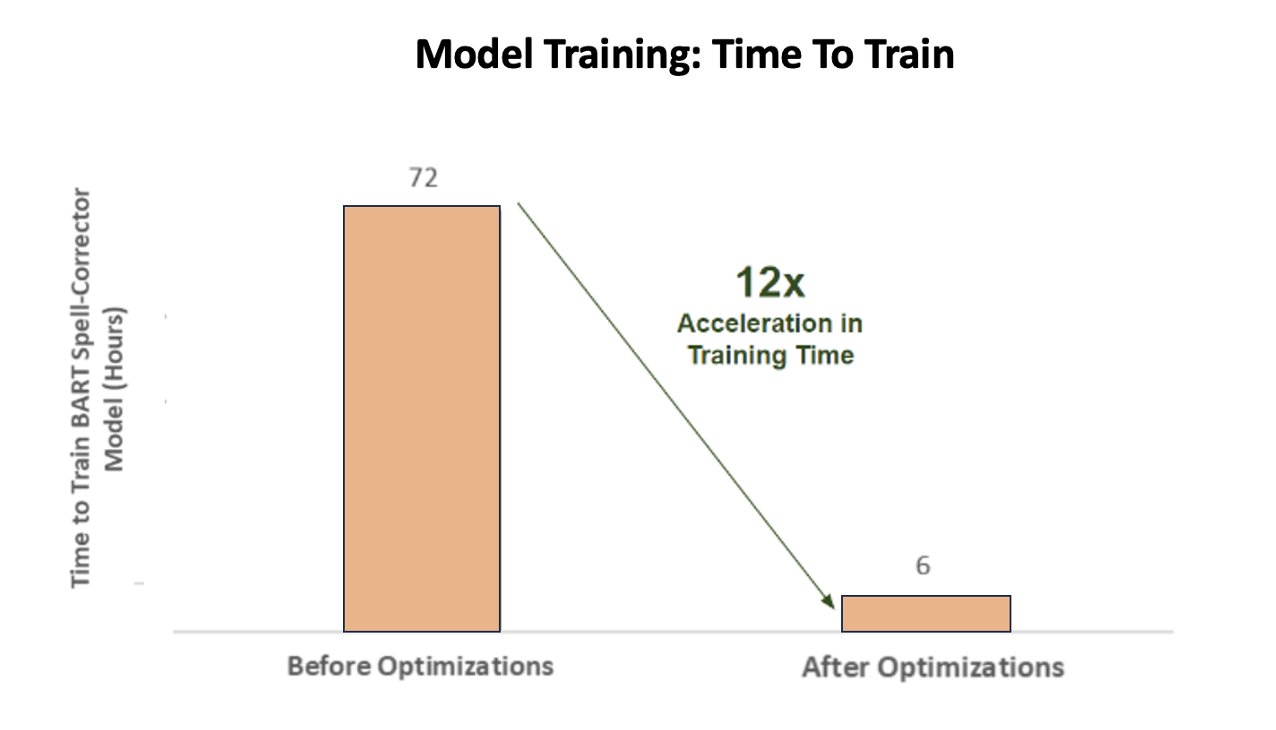

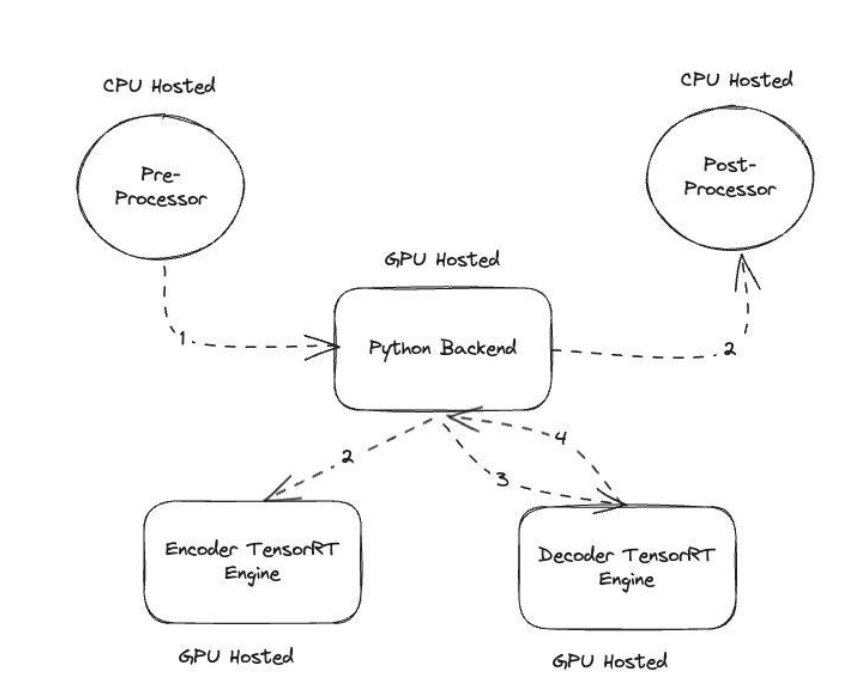

NVIDIA Triton Inference Server biedt twee verschillende soorten backends: één voor het hosten van modellen op GPU, en een Python-backend waar u uw eigen aangepaste code kunt meenemen voor gebruik in voor- en naverwerkingsstappen. De volgende afbeelding illustreert de model ensembleschema.

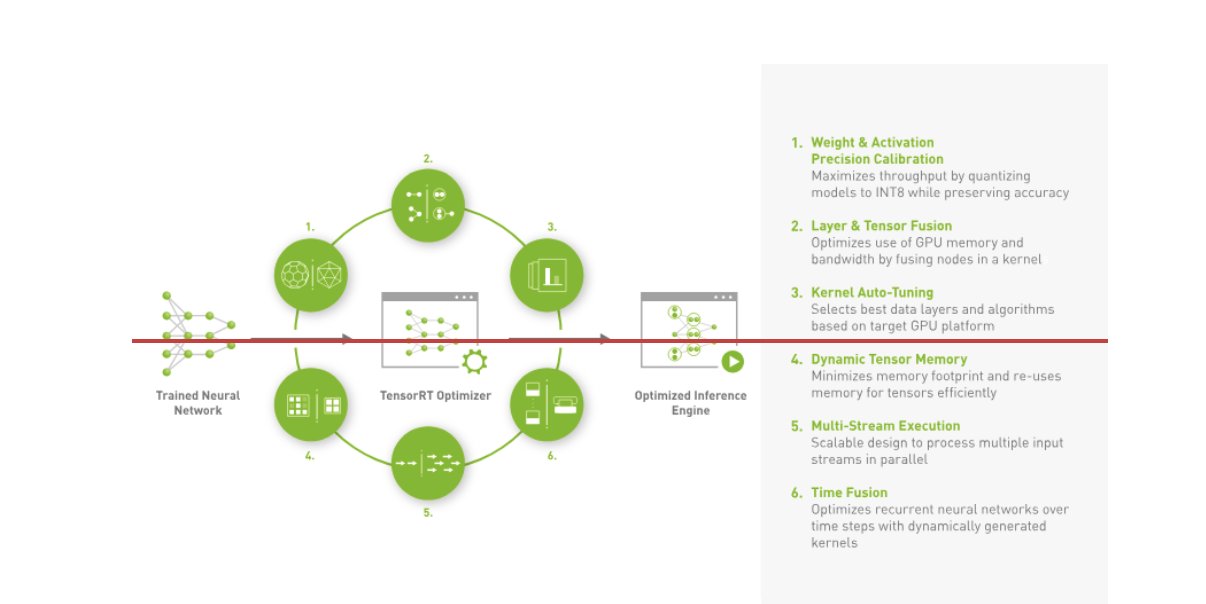

Amazon Music heeft zijn BART gebouwd inferentie pijplijn door zowel preprocessing (teksttokenisatie) als postprocessing (tokens naar tekst) stappen uit te voeren op CPU's, terwijl de modeluitvoeringsstap draait op NVIDIA A10G Tensor Core GPU's. Een Python-backend bevindt zich in het midden van de voor- en nabewerkingsstappen en is verantwoordelijk voor de communicatie met de TensorRT-geconverteerde BART-modellen en de encoder-/decodernetwerken. TensorRT verbetert de inferentieprestaties met nauwkeurige kalibratie, laag- en tensorfusie, automatische kernelafstemming, dynamisch tensorgeheugen, uitvoering van meerdere stromen en tijdfusie.

De volgende afbeelding illustreert het ontwerp op hoog niveau van de sleutelmodules waaruit de inferentiepijplijn van het BART-model voor spellingcorrector bestaat.

Zoeken naar vectoren: het insluiten van query's voor het genereren van zinnen BERT-model-inferentie

Het volgende diagram illustreert de verbetering van 60% in latentie (bij p90 800–900 TPS) bij gebruik van het NVIDIA AI Inference Platform vergeleken met een CPU-gebaseerde basislijn.

Het volgende diagram toont een kostenverbetering van 70% bij gebruik van het NVIDIA AI Inference Platform vergeleken met een CPU-gebaseerde basislijn.

De volgende afbeelding illustreert een SDK voor krachtige deep learning-inferentie. Het bevat een deep learning inference optimizer en runtime die lage latentie en hoge doorvoer levert voor inferentietoepassingen.

Om deze resultaten te bereiken, experimenteerde Amazon Music met verschillende Triton-implementatieparameters Triton-modelanalysator, een tool die helpt bij het vinden van de beste NVIDIA Triton-modelconfiguratie om efficiënte inferentie te implementeren. Om de modelinferentie te optimaliseren, biedt Triton functies zoals dynamische batching en gelijktijdige uitvoering van modellen, en heeft het raamwerkondersteuning voor andere flexibiliteitsmogelijkheden. De dynamische batching verzamelt gevolgtrekkingsverzoeken en groepeert ze naadloos in cohorten om de doorvoer te maximaliseren, terwijl realtime reacties voor Amazon Music-gebruikers worden gegarandeerd. De mogelijkheid om gelijktijdige modellen uit te voeren verbetert de inferentieprestaties verder door meerdere exemplaren van het model op dezelfde GPU te hosten. Tenslotte door gebruik te maken van Triton-modelanalysator, kon Amazon Music de dynamische batching- en modelconcurrency-inferentiehostingparameters zorgvuldig verfijnen om optimale instellingen te vinden die de inferentieprestaties maximaliseren met behulp van gesimuleerd verkeer.

Conclusie

Door configuraties met Triton Inference Server en TensorRT op SageMaker te optimaliseren, kon Amazon Music uitstekende resultaten behalen voor zowel training als inferentiepijplijnen. Het SageMaker-platform is het end-to-end open platform voor productie-AI, dat een snelle time-to-value en de veelzijdigheid biedt om alle belangrijke AI-gebruiksscenario's op zowel hardware als software te ondersteunen. Door het gebruik van de V100 GPU te optimaliseren voor training en het overschakelen van CPU's naar G5-instances met behulp van NVIDIA A10G Tensor Core GPU's, en door gebruik te maken van geoptimaliseerde NVIDIA-software zoals Triton Inference Server en TensorRT, kunnen bedrijven als Amazon Music tijd en geld besparen en tegelijkertijd de prestaties op beide gebieden verbeteren. training en gevolgtrekking, wat zich direct vertaalt in een betere klantervaring en lagere bedrijfskosten.

SageMaker verzorgt het ongedifferentieerde zware werk voor ML-training en hosting, waardoor Amazon Music betrouwbare, schaalbare ML-bewerkingen kan leveren op zowel hardware als software.

We moedigen u aan om te controleren of uw werklasten zijn geoptimaliseerd met SageMaker door altijd uw hardware- en softwarekeuzes te evalueren om te zien of er manieren zijn waarop u betere prestaties kunt bereiken tegen lagere kosten.

Raadpleeg het volgende voor meer informatie over NVIDIA AI in AWS:

Over de auteurs

Siddharth Sharma is een Machine Learning Tech Lead bij het Science & Modeling-team van Amazon Music. Hij is gespecialiseerd in zoek-, retrieval-, ranking- en NLP-gerelateerde modelleringsproblemen. Siddharth heeft een rijke achtergrond in het werken aan grootschalige machine learning-problemen die latentiegevoelig zijn, bijvoorbeeld advertentietargeting, multimodaal ophalen, begrip van zoekopdrachten enz. Voordat hij bij Amazon Music werkte, werkte Siddharth bij bedrijven als Meta, Walmart Labs, Rakuten over op e-commerce gerichte ML-problemen. Siddharth bracht het eerste deel van zijn carrière door met ad-tech startups in de Bay Area.

Siddharth Sharma is een Machine Learning Tech Lead bij het Science & Modeling-team van Amazon Music. Hij is gespecialiseerd in zoek-, retrieval-, ranking- en NLP-gerelateerde modelleringsproblemen. Siddharth heeft een rijke achtergrond in het werken aan grootschalige machine learning-problemen die latentiegevoelig zijn, bijvoorbeeld advertentietargeting, multimodaal ophalen, begrip van zoekopdrachten enz. Voordat hij bij Amazon Music werkte, werkte Siddharth bij bedrijven als Meta, Walmart Labs, Rakuten over op e-commerce gerichte ML-problemen. Siddharth bracht het eerste deel van zijn carrière door met ad-tech startups in de Bay Area.

Tarun Sharma is een Software Development Manager die leiding geeft aan Amazon Music Search Relevance. Zijn team van wetenschappers en ML-ingenieurs is verantwoordelijk voor het leveren van contextueel relevante en gepersonaliseerde zoekresultaten aan Amazon Music-klanten.

Tarun Sharma is een Software Development Manager die leiding geeft aan Amazon Music Search Relevance. Zijn team van wetenschappers en ML-ingenieurs is verantwoordelijk voor het leveren van contextueel relevante en gepersonaliseerde zoekresultaten aan Amazon Music-klanten.

James Park is een oplossingsarchitect bij Amazon Web Services. Hij werkt samen met Amazon.com aan het ontwerpen, bouwen en implementeren van technologische oplossingen op AWS, en heeft een bijzondere interesse in AI en machine learning. In zijn vrije tijd gaat hij graag op zoek naar nieuwe culturen, nieuwe ervaringen en op de hoogte blijven van de nieuwste technologische trends. Je kunt hem vinden op LinkedIn.

James Park is een oplossingsarchitect bij Amazon Web Services. Hij werkt samen met Amazon.com aan het ontwerpen, bouwen en implementeren van technologische oplossingen op AWS, en heeft een bijzondere interesse in AI en machine learning. In zijn vrije tijd gaat hij graag op zoek naar nieuwe culturen, nieuwe ervaringen en op de hoogte blijven van de nieuwste technologische trends. Je kunt hem vinden op LinkedIn.

Kshitiz Gupta is Solutions Architect bij NVIDIA. Hij vindt het leuk om cloudklanten te informeren over de GPU AI-technologieën die NVIDIA te bieden heeft en hen te helpen bij het versnellen van hun machine learning en deep learning-applicaties. Naast zijn werk houdt hij van hardlopen, wandelen en het spotten van dieren in het wild.

Kshitiz Gupta is Solutions Architect bij NVIDIA. Hij vindt het leuk om cloudklanten te informeren over de GPU AI-technologieën die NVIDIA te bieden heeft en hen te helpen bij het versnellen van hun machine learning en deep learning-applicaties. Naast zijn werk houdt hij van hardlopen, wandelen en het spotten van dieren in het wild.

Jiahong Liu is Solution Architect in het Cloud Service Provider-team van NVIDIA. Hij helpt klanten bij het adopteren van machine learning en AI-oplossingen die gebruikmaken van NVIDIA Accelerated Computing om hun trainings- en inferentie-uitdagingen aan te pakken. In zijn vrije tijd houdt hij van origami, doe-het-zelfprojecten en basketbal.

Jiahong Liu is Solution Architect in het Cloud Service Provider-team van NVIDIA. Hij helpt klanten bij het adopteren van machine learning en AI-oplossingen die gebruikmaken van NVIDIA Accelerated Computing om hun trainings- en inferentie-uitdagingen aan te pakken. In zijn vrije tijd houdt hij van origami, doe-het-zelfprojecten en basketbal.

Tugrul Konuk is een Senior Solution Architect bij NVIDIA, gespecialiseerd in grootschalige training, multimodaal deep learning en high-performance wetenschappelijk computergebruik. Voordat hij bij NVIDIA kwam, werkte hij in de energiesector, waar hij zich richtte op de ontwikkeling van algoritmen voor computationele beeldvorming. Als onderdeel van zijn doctoraat werkte hij aan op fysica gebaseerd deep learning voor numerieke simulaties op schaal. In zijn vrije tijd leest hij graag, speelt hij gitaar en piano.

Tugrul Konuk is een Senior Solution Architect bij NVIDIA, gespecialiseerd in grootschalige training, multimodaal deep learning en high-performance wetenschappelijk computergebruik. Voordat hij bij NVIDIA kwam, werkte hij in de energiesector, waar hij zich richtte op de ontwikkeling van algoritmen voor computationele beeldvorming. Als onderdeel van zijn doctoraat werkte hij aan op fysica gebaseerd deep learning voor numerieke simulaties op schaal. In zijn vrije tijd leest hij graag, speelt hij gitaar en piano.

Rohil Bhargava is een Product Marketing Manager bij NVIDIA, gericht op het implementeren van NVIDIA-applicatieframeworks en SDK's op specifieke CSP-platforms.

Rohil Bhargava is een Product Marketing Manager bij NVIDIA, gericht op het implementeren van NVIDIA-applicatieframeworks en SDK's op specifieke CSP-platforms.

Eliuth Triana Isaza is een Developer Relations Manager bij NVIDIA die Amazon's AI MLOps, DevOps, wetenschappers en technische experts van AWS in staat stelt de NVIDIA-computingstack onder de knie te krijgen voor het versnellen en optimaliseren van Genative AI Foundation-modellen, variërend van datacuratie, GPU-training, modelinferentie en productie-implementatie op AWS GPU-instanties . Daarnaast is Eliuth een gepassioneerd mountainbiker, skiër, tennis- en pokerspeler.

Eliuth Triana Isaza is een Developer Relations Manager bij NVIDIA die Amazon's AI MLOps, DevOps, wetenschappers en technische experts van AWS in staat stelt de NVIDIA-computingstack onder de knie te krijgen voor het versnellen en optimaliseren van Genative AI Foundation-modellen, variërend van datacuratie, GPU-training, modelinferentie en productie-implementatie op AWS GPU-instanties . Daarnaast is Eliuth een gepassioneerd mountainbiker, skiër, tennis- en pokerspeler.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- : heeft

- :is

- :niet

- :waar

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- in staat

- Over

- versneld

- versnellen

- versnelling

- toegang

- bereiken

- nauwkeurigheid

- accuraat

- Bereiken

- bereikt

- over

- actieve

- toevoeging

- adres

- De goedkeuring van

- advertenties

- die van invloed

- Na

- AI

- AI-modellen

- ai-gebruiksgevallen

- Album

- algoritmen

- Alles

- toelaten

- toegestaan

- Het toestaan

- toestaat

- ook

- altijd

- Amazone

- Amazon Web Services

- Amazon.com

- an

- en

- Aanvraag

- toepassingen

- nadering

- architecten

- ZIJN

- GEBIED

- gebieden

- rond

- kunstenaar

- AS

- bijstaan

- helpt

- At

- gemiddelde

- AWS

- backend

- Balance

- balancing

- bars

- gebaseerde

- Baseline

- Basketbal

- Baai

- BE

- werd

- omdat

- betekent

- BEST

- Betere

- het stimuleren

- boosts

- zowel

- brengen

- breed

- bouw

- bebouwd

- by

- CAN

- mogelijkheden

- bekwaamheid

- vangen

- verzorging

- Carrière

- voorzichtig

- gevallen

- uitdagingen

- uitdagend

- tabel

- controle

- gekoesterde

- keuzes

- klanten

- Cloud

- code

- COM

- hoe

- communiceren

- Bedrijven

- vergeleken

- computationeel

- computergebruik

- gelijktijdig

- Configuratie

- Containers

- content

- Convergentie

- Kern

- Kosten

- Kosten

- ambachtelijke

- kritisch

- cruciaal

- CSP

- curation

- gewoonte

- klant

- klantervaring

- Klanten

- gegevens

- Datum

- dagen

- verminderde

- deep

- diepgaand leren

- vertragingen

- leveren

- het leveren van

- levert

- Vraag

- implementeren

- het inzetten

- inzet

- Design

- Ontwikkelaar

- het ontwikkelen van

- Ontwikkeling

- anders

- moeilijk

- direct

- duiken

- diversen

- diy

- Dont

- drastisch

- gedurende

- dynamisch

- e

- e-commerce

- Vroeg

- opleiden

- doeltreffendheid

- doeltreffend

- inspanning

- verhoogd

- inbedding

- emoties

- gebruik

- empowering

- ingeschakeld

- aanmoedigen

- eind tot eind

- energie-niveau

- Ingenieurs

- Verbetert

- genoeg

- zorgen

- vooral

- etc

- evalueren

- Zelfs

- Alle

- uitvoering

- ervaring

- Ervaringen

- deskundigen

- SNELLE

- Voordelen

- Figuur

- Tot slot

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- het vinden van

- Voornaam*

- Flexibiliteit

- overstroming

- Focus

- gericht

- gericht

- volgend

- Voor

- formaat

- Foundation

- Achtergrond

- frameworks

- oppompen van

- frustrerend

- geheel

- functionaliteiten

- verder

- fusie

- poort

- generatie

- generatief

- generatieve AI

- GPU

- GPU's

- Handvaten

- gebeuren

- Hardware

- Hebben

- he

- zwaar

- zwaar tillen

- hulp

- nuttig

- helpt

- Hoge

- high-level

- hoge performantie

- hem

- zijn

- houdt

- Hosting

- HOURS

- Hoe

- Echter

- HTML

- HTTPS

- het identificeren van

- if

- illustreert

- Imaging

- uitvoeren

- belangrijk

- verbeteren

- verbeterd

- verbetering

- in

- omvat

- Laat uw omzet

- meer

- meer

- -industrie

- ondoeltreffend

- beïnvloeden

- Infrastructuur

- eerste

- instantie

- ogenblikkelijk

- verkrijgen in plaats daarvan

- belang

- in

- voorstellen

- de invoering

- IT

- HAAR

- jpg

- voor slechts

- sleutel

- Soort

- blijven

- bekend

- Labs

- taal

- Groot

- grootschalig

- groter

- duurzaam

- Wachttijd

- laatste

- lagen

- leiden

- leidend

- LEARN

- leren

- Hefboomwerking

- Bibliotheek

- facelift

- als

- grenzen

- laden

- op zoek

- Laag

- te verlagen

- machine

- machine learning

- onderhouden

- groot

- maken

- MERKEN

- manager

- beheren

- Marketing

- meester

- Maximaliseren

- Mei..

- Memories

- Geheugen

- meta

- Midden

- miljoen

- miljoenen

- milliseconden

- minimaal

- fout

- gemengd

- ML

- MLops

- model

- modellering

- modellen

- Modules

- geld

- meer

- meest

- Berg

- multi-

- meervoudig

- Muziek

- Dan moet je

- naam

- nodig

- negatief

- netwerken

- New

- nlp

- Nvidia

- of

- bieden

- Aanbod

- on

- EEN

- Slechts

- open

- open source

- werkzaam

- operationele

- Operations

- optimale

- optimalisatie

- Optimaliseer

- geoptimaliseerde

- optimaliseren

- or

- georkestreerd

- bestellen

- Overige

- uit

- buiten

- uitstekend

- over

- totaal

- het te bezitten.

- parameters

- deel

- bijzonder

- vooral

- partnered

- hartstochtelijk

- Hoogtepunt

- percentage

- prestatie

- persoonlijk

- Gepersonaliseerde

- phd

- pijpleiding

- platform

- platforms

- Plato

- Plato gegevensintelligentie

- PlatoData

- speler

- spelen

- Podcast

- podcasts

- punt

- poker

- mogelijk

- Post

- potentieel

- energie

- aangedreven

- precisie

- Voorafgaand

- prioriteren

- prioriteit

- problemen

- Product

- productie

- projecten

- zorgen voor

- leverancier

- biedt

- het verstrekken van

- Python

- Quick

- Ranking

- lezing

- real-time

- vermindering

- verwijzen

- verwant

- betrekkingen

- relevantie

- relevante

- betrouwbaar

- verzoeken

- vereist

- Resources

- reacties

- verantwoordelijkheid

- verantwoordelijk

- responsive

- verkregen

- Resultaten

- Rijk

- rechts

- lopend

- loopt

- runtime

- sagemaker

- dezelfde

- Bespaar

- besparing

- schaalbare

- Scale

- Wetenschap

- wetenschappelijk

- wetenschappers

- sdk

- SDK's

- naadloos

- Ontdek

- zoekopdrachten

- zoeken

- Tweede

- secties

- zien

- op zoek naar

- schijnbaar

- semantiek

- senior

- gevoelig

- zin

- dienen

- server

- service

- Service Provider

- Diensten

- serveer-

- reeks

- settings

- verscheidene

- Delen

- gedeeld

- Shows

- aanzienlijke

- aanzienlijk

- Eenvoudig

- zit

- Maat

- maten

- slim

- Software

- software development

- oplossing

- Oplossingen

- lied

- bron

- overspannen

- specialiseert

- gespecialiseerd

- specifiek

- snelheid

- SPELLEN

- spelling

- besteed

- stack

- Start

- Startups

- verblijven

- vast

- Stap voor

- Stappen

- Verhaal

- streaming

- dergelijk

- superieur

- ondersteuning

- ondersteunde

- zeker

- ingenomen

- het nemen

- targeting

- team

- tech

- Technisch

- techniek

- technieken

- Technologies

- Technologie

- tekst

- dat

- De

- hun

- Ze

- Er.

- daarom

- Deze

- ze

- spullen

- dit

- Door

- doorvoer

- niet de tijd of

- keer

- Titel

- naar

- samen

- tokenization

- tokens

- nam

- tools

- top

- tps

- verkeer

- Trainen

- getraind

- Trainingen

- transformator

- Trends

- Triton

- waar

- twee

- begrip

- ongetwijfeld

- Universum

- ontgrendelen

- onthuld

- us

- .

- gebruikt

- gebruikers

- toepassingen

- gebruik

- Gebruik makend

- waarde

- groot

- veelzijdigheid

- zeer

- Het wachten

- lopen

- Walmart

- was

- kijken

- manieren

- we

- web

- webservices

- GOED

- waren

- wanneer

- terwijl

- en

- wil

- Met

- Mijn werk

- werkte

- werkzaam

- Bedrijven

- wereld

- zorgen

- nog

- opgeleverd

- You

- Your

- zephyrnet