In een steeds meer op gegevens gerichte wereld moeten ondernemingen zich richten op het verzamelen van zowel waardevolle fysieke informatie als het genereren van de informatie die ze nodig hebben maar niet gemakkelijk kunnen vastleggen. Gegevenstoegang, regulering en naleving vormen een toenemende bron van wrijving voor innovatie op het gebied van analyse en kunstmatige intelligentie (AI).

Voor sterk gereguleerde sectoren zoals financiële dienstverlening, gezondheidszorg, biowetenschappen, auto-industrie, robotica en productie is het probleem nog groter. Het veroorzaakt belemmeringen voor systeemontwerp, het delen van gegevens (intern en extern), het genereren van inkomsten, analyse en machine learning (ML).

Synthetische gegevens zijn een hulpmiddel dat veel gegevensuitdagingen aanpakt, met name AI- en analysekwesties zoals privacybescherming, naleving van regelgeving, toegankelijkheid, gegevensschaarste en vooringenomenheid. Hieronder valt ook het delen van data en time to data (en dus time to market).

Synthetische gegevens worden algoritmisch gegenereerd. Het weerspiegelt statistische eigenschappen en patronen van de brongegevens. Maar belangrijker is dat het geen gevoelige, privé- of persoonlijke datapunten bevat.

U stelt vragen over de synthetische gegevens en krijgt dezelfde antwoorden als bij de echte gegevens.

In onze eerdere bericht, we hebben gedemonstreerd hoe vijandige netwerken zoals Generative Adversarial Networks (GANS) kunnen worden gebruikt om datasets in tabelvorm te genereren om de training van kredietfraudemodellen te verbeteren.

Voor zakelijke belanghebbenden die synthetische gegevens willen gebruiken voor hun ML- en analyseprojecten, is het absoluut noodzakelijk om er niet alleen voor te zorgen dat de gegenereerde synthetische gegevens passen bij het doel en de verwachte downstream-toepassingen, maar ook dat ze de kwaliteit van de gegenereerde gegevens.

Met toenemende wettelijke en ethische verplichtingen voor het behoud van privacy, is een van de sterke punten van synthetische gegevens de mogelijkheid om gevoelige en originele informatie tijdens de synthese te verwijderen. Daarom hebben we naast kwaliteit ook maatstaven nodig om het risico van het lekken van privé-informatie te evalueren, indien aanwezig, en om te beoordelen of het proces van genereren niet bestaat uit het "onthouden" of kopiëren van de originele gegevens.

Om dit allemaal te bereiken, kunnen we de kwaliteit van synthetische gegevens in dimensies in kaart brengen, die de gebruikers, belanghebbenden en ons helpen de gegenereerde gegevens beter te begrijpen.

De drie dimensies van synthetische datakwaliteitsevaluatie

De gegenereerde synthetische gegevens worden gemeten aan de hand van drie belangrijke dimensies:

- Trouw

- utility

- Privacy

Dit zijn enkele van de vragen over gegenereerde synthetische gegevens die moeten worden beantwoord door een rapport over de kwaliteit van synthetische gegevens:

- Hoe vergelijkbaar zijn deze synthetische gegevens in vergelijking met de oorspronkelijke trainingsset?

- Hoe nuttig zijn deze synthetische gegevens voor onze downstream-applicaties?

- Is er informatie gelekt van de oorspronkelijke trainingsgegevens naar de synthetische gegevens?

- Zijn er gegevens die in de echte wereld als gevoelig worden beschouwd (uit andere datasets die niet worden gebruikt voor het trainen van het model) per ongeluk door ons model gesynthetiseerd?

De statistieken die elk van deze dimensies voor de eindgebruikers vertalen, zijn enigszins flexibel. De te genereren gegevens kunnen immers variëren in termen van distributies, grootte en gedrag. Ze moeten ook gemakkelijk te begrijpen en te interpreteren zijn.

Uiteindelijk moeten de statistieken volledig datagestuurd zijn en geen voorkennis of domeinspecifieke informatie vereisen. Als de gebruiker echter specifieke regels en beperkingen wil toepassen die van toepassing zijn op een specifiek bedrijfsdomein, moet hij deze tijdens het syntheseproces kunnen definiëren om ervoor te zorgen dat aan de domeinspecifieke getrouwheid wordt voldaan.

We bekijken elk van deze statistieken in meer detail in de volgende secties.

Statistieken om trouw te begrijpen

In elk data science-project moeten we begrijpen of een bepaalde steekproefpopulatie relevant is voor het probleem dat we oplossen. Evenzo moeten we voor het proces van het beoordelen van de relevantie van de gegenereerde synthetische gegevens deze evalueren in termen van trouw in vergelijking met het origineel.

Visuele representaties van deze statistieken maken ze gemakkelijker te begrijpen. We konden illustreren of de kardinaliteit en ratio van categorieën werden gerespecteerd, de correlaties tussen de verschillende variabelen werden behouden, enzovoort.

Het visualiseren van de data helpt niet alleen om de kwaliteit van de synthetische data te evalueren, maar past ook als een van de eerste stappen in de data science-levenscyclus voor een beter begrip van de data.

Laten we dieper ingaan op enkele betrouwbaarheidsstatistieken.

Verkennende statistische vergelijkingen

Binnen de verkennende statistische vergelijkingen worden de kenmerken van de originele en synthetische datasets onderzocht met behulp van belangrijke statistische maatstaven, zoals het gemiddelde, de mediaan, de standaarddeviatie, verschillende waarden, ontbrekende waarden, minima, maxima, kwartielbereiken voor continue kenmerken en het aantal van records per categorie, ontbrekende waarden per categorie en meest voorkomende tekens voor categorische attributen.

Deze vergelijking moet worden gemaakt tussen de originele hold-out dataset en de synthetische data. Deze evaluatie zou onthullen of de vergeleken datasets statistisch vergelijkbaar zijn. Als dat niet het geval is, hebben we inzicht in welke kenmerken en maatregelen anders zijn. Overweeg om de synthetische gegevens opnieuw te trainen en te regenereren met andere parameters als er een significant verschil wordt opgemerkt.

Deze test fungeert als een eerste screening om ervoor te zorgen dat de synthetische gegevens redelijk getrouw zijn aan de originele dataset en daarom nuttiger kunnen zijn om strengere tests te ondergaan.

Histogram gelijkenisscore

De gelijkenisscore van het histogram meet de marginale distributies van elk kenmerk van de synthetische en originele datasets.

De gelijkenisscore wordt begrensd tussen nul en één, waarbij een score van één aangeeft dat de synthetische gegevensverdelingen de verdelingen van de oorspronkelijke gegevens perfect overlappen.

Een score dicht bij één zou de gebruikers het vertrouwen geven dat de holdout-dataset en de synthetische dataset statistisch vergelijkbaar zijn.

Wederzijdse informatiescore

De wederzijdse informatiescore meet de wederzijdse afhankelijkheid van twee kenmerken, numeriek of categorisch, en geeft aan hoeveel informatie uit het ene kenmerk kan worden verkregen door het andere te observeren.

Wederzijdse informatie kan niet-lineaire relaties meten, wat een beter begrip geeft van de kwaliteit van synthetische gegevens omdat het ons inzicht geeft in de mate waarin de relaties van de variabele behouden blijven.

Een score van één geeft aan dat de onderlinge afhankelijkheid tussen kenmerken perfect is vastgelegd in de synthetische data.

Correlatie score

De correlatiescore meet hoe goed de correlaties in de originele dataset zijn vastgelegd in de synthetische data.

Correlaties tussen twee of meer kolommen zijn uiterst belangrijk voor ML-toepassingen, die helpen bij het blootleggen van relaties tussen kenmerken en de doelvariabele en helpen bij het maken van een goed getraind model.

De correlatiescore wordt begrensd tussen nul en één, waarbij een score van één aangeeft dat de correlaties perfect op elkaar zijn afgestemd.

In tegenstelling tot gestructureerde gegevens in tabelvorm, die we vaak tegenkomen bij gegevensproblemen, vertonen sommige typen gestructureerde gegevens een bepaald gedrag waarbij waarnemingen uit het verleden waarschijnlijk de volgende waarneming beïnvloeden. Deze staan bekend als tijdreeks- of sequentiële gegevens, bijvoorbeeld een dataset met uurlijkse metingen van kamertemperatuur.

Dit gedrag betekent dat er een vereiste is om bepaalde statistieken te definiëren die specifiek de kwaliteit van deze tijdreeksgegevenssets kunnen meten.

Autocorrelatie en gedeeltelijke autocorrelatiescore

Hoewel vergelijkbaar met correlatie, toont autocorrelatie de relatie van een tijdreeks op zijn huidige waarde in relatie tot zijn eerdere waarden. Het verwijderen van de effecten van de vorige vertragingen levert gedeeltelijke autocorrelatie op. Daarom meet de autocorrelatiescore hoe goed de synthetische gegevens de significante autocorrelaties of gedeeltelijke correlaties uit de oorspronkelijke dataset hebben vastgelegd.

Statistieken om nut te begrijpen

Nu hebben we ons statistisch misschien gerealiseerd dat de synthetische gegevens vergelijkbaar zijn met de originele dataset. Bovendien moeten we ook beoordelen hoe goed de gesynthetiseerde dataset presteert op veelvoorkomende datawetenschapsproblemen wanneer deze wordt getraind op verschillende ML-algoritmen.

Met behulp van het volgende: utility metrics, streven we ernaar het vertrouwen op te bouwen dat we daadwerkelijk prestaties kunnen leveren op downstream-applicaties met betrekking tot hoe de oorspronkelijke gegevens hebben gepresteerd.

Voorspellingsscore

Het meten van de prestaties van synthetische gegevens in vergelijking met de originele echte gegevens kan worden gedaan door middel van ML-modellen. De downstream-modelscore legt de kwaliteit van de synthetische gegevens vast door de prestaties te vergelijken van ML-modellen die zijn getraind op zowel de synthetische als de originele datasets en die zijn gevalideerd op achtergehouden testgegevens van de originele dataset. Dit levert een Train Synthetic Test Real (TSTR)-score en Trein Real Test Real (TRTR) respectievelijk scoren.

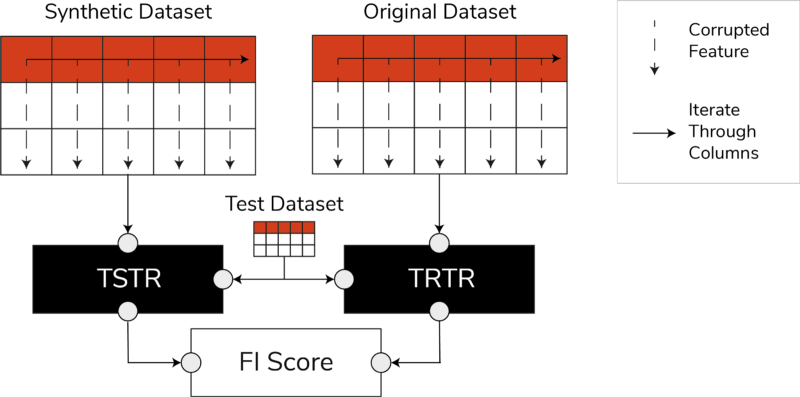

TSTR, TRTR-scores en de Feature Importance Score (afbeelding door auteur)

De score bevat een breed scala van de meest vertrouwde ML-algoritmen voor regressie- of classificatietaken. Het gebruik van verschillende classifiers en regressors zorgt ervoor dat de score beter generaliseerbaar is voor de meeste algoritmen, zodat de synthetische gegevens in de toekomst als nuttig kunnen worden beschouwd.

Uiteindelijk, als de TSTR-score en TRTR-score vergelijkbaar zijn, geeft dit aan dat de synthetische gegevens de kwaliteit hebben om te worden gebruikt om effectieve ML-modellen te trainen voor real-world toepassingen.

Kenmerk belangrijkheidsscore

Sterk gerelateerd aan de voorspellingsscore, breidt de functie-belangrijkheidsscore (FI) deze uit door interpreteerbaarheid toe te voegen aan de TSTR- en TRTR-scores.

De F1-score vergelijkt de veranderingen en stabiliteit van de verkregen prioriteitsvolgorde van het kenmerk met de voorspellingsscore. Een synthetische set gegevens wordt als zeer nuttig beschouwd als deze dezelfde orde van belangrijkheid oplevert als de oorspronkelijke echte gegevens.

QScore

Om ervoor te zorgen dat een model dat is getraind op onze nieuw gegenereerde gegevens dezelfde antwoorden op dezelfde vragen zal produceren als een model dat is getraind op basis van de originele gegevens, gebruiken we de Qscore. Dit meet de downstream-prestaties van de synthetische gegevens door veel willekeurige, op aggregatie gebaseerde query's uit te voeren op zowel de synthetische als de originele (en holdout) datasets.

Het idee hier is dat beide zoekopdrachten vergelijkbare resultaten moeten opleveren.

Een hoge QScore zorgt ervoor dat downstream-applicaties die gebruik maken van query- en aggregatiebewerkingen bijna dezelfde waarde kunnen bieden als die van de oorspronkelijke dataset.

Statistieken om privacy te begrijpen

met privacy regelgeving die al van kracht is, is het een ethische verplichting en een wettelijke vereiste om ervoor te zorgen dat gevoelige informatie wordt beschermd.

Voordat deze synthetische gegevens vrij kunnen worden gedeeld en gebruikt voor downstream-toepassingen, moeten we rekening houden met de privacystatistieken die de belanghebbende kunnen helpen begrijpen waar de gegenereerde synthetische gegevens staan in vergelijking met de oorspronkelijke gegevens in termen van de omvang van gelekte informatie. Bovendien moeten we cruciale beslissingen nemen over hoe de synthetische gegevens kunnen worden gedeeld en gebruikt.

Exacte wedstrijdscore

Een directe en intuïtieve evaluatie van privacy is het zoeken naar kopieën van de echte gegevens tussen de synthetische records. De exacte matchscore telt het aantal echte records dat kan worden gevonden in de synthetische set.

De score moet nul zijn, waarmee wordt aangegeven dat er geen echte informatie aanwezig is in de synthetische gegevens. Deze statistiek fungeert als een screeningmechanisme voordat we verdere privacystatistieken evalueren.

Privacyscore van buren

Bovendien meet de privacyscore van de buren de verhouding van synthetische records die mogelijk te veel op de echte lijkt. Dit betekent dat, hoewel het geen directe kopieën zijn, ze potentiële punten van privacylekkage zijn en een bron van nuttige informatie voor inferentieaanvallen.

De score wordt berekend door een hoog-dimensionale zoektocht naar de naaste buren uit te voeren op de synthetische gegevens die overlappen met de oorspronkelijke gegevens.

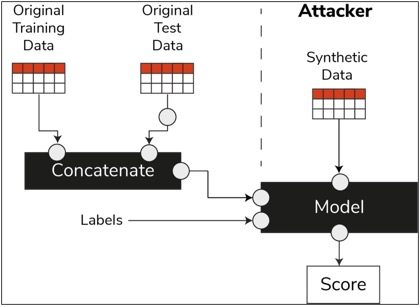

Lidmaatschapsinferentiescore

Als een model eenmaal is getraind in de data science-levenscyclus, heeft het geen toegang meer nodig tot de trainingsvoorbeelden en kan het voorspellingen doen op ongeziene gegevens. Evenzo kunnen in ons geval, als het synthesizermodel eenmaal is getraind, monsters van synthetische gegevens worden gegenereerd zonder dat de originele gegevens nodig zijn.

Door een type aanval genaamd "lidmaatschap inferentie aanval", kunnen aanvallers proberen de gegevens te onthullen die zijn gebruikt om de synthetische gegevens te maken, zonder toegang te hebben tot de originele gegevens. Dit resulteert in een compromis van privacy.

De lidmaatschapsinferentiescore meet de waarschijnlijkheid dat een lidmaatschapsinferentieaanval succesvol is.

Een lage score suggereert dat het haalbaar is om te concluderen dat een bepaald record deel uitmaakte van de trainingsgegevensset die leidde tot het maken van de synthetische gegevens. Met andere woorden, de aanvallen kunnen details van een individueel record afleiden, waardoor de privacy in gevaar wordt gebracht.

Een hoge lidmaatschapsinferentiescore geeft aan dat het onwaarschijnlijk is dat een aanvaller kan bepalen of een bepaald record deel uitmaakte van de oorspronkelijke gegevensset die werd gebruikt om de synthetische gegevens te maken. Dit betekent ook dat de informatie van geen enkel individu in gevaar is gebracht door de synthetische gegevens.

Het holdout-concept

Een belangrijke best practice die we moeten volgen, is ervoor te zorgen dat de synthetische gegevens algemeen genoeg zijn en niet te veel passen bij de oorspronkelijke gegevens waarop ze zijn getraind. In een typische datawetenschapsstroom, terwijl we ML-modellen bouwen, zoals een Random Forest-classificatie, leggen we testgegevens opzij, trainen we de modellen met behulp van de trainingsgegevens en evalueren we de statistieken op ongeziene testgegevens.

Op dezelfde manier houden we voor synthetische gegevens een steekproef van de originele gegevens opzij – over het algemeen aangeduid als een hold-out dataset of ongeziene achtergehouden testgegevens – en evalueren we de gegenereerde synthetische data tegen de hold-out dataset.

De holdout-gegevensset is naar verwachting een weergave van de oorspronkelijke gegevens, maar is niet zichtbaar toen de synthetische gegevens werden gegenereerd. Daarom is het essentieel om vergelijkbare scores te hebben voor alle statistieken bij het vergelijken van het origineel met de holdout en de synthetische datasets.

Wanneer vergelijkbare scores worden verkregen, kunnen we vaststellen dat de synthetische datapunten niet het resultaat zijn van het onthouden van de originele datapunten, met behoud van dezelfde getrouwheid en bruikbaarheid.

Laatste gedachten

De wereld begint het strategische belang van synthetische data te begrijpen. Als datawetenschappers en datageneratoren is het onze plicht om vertrouwen op te bouwen in de synthetische data die we genereren en ervoor te zorgen dat deze een doel hebben.

Synthetische data evolueren naar een must-have in de data science development toolkit. MIT Technology Review heeft bekend synthetische data als een van de baanbrekende technologieën van 2022. We kunnen ons niet voorstellen dat we AI-modellen met een uitstekende waarde bouwen zonder synthetische data, claims Gartner.

Think McKinsey, minimaliseert synthetische data de kosten en barrières die u anders zou hebben bij het ontwikkelen van algoritmen of het verkrijgen van toegang tot data.

Het genereren van synthetische data gaat over het kennen van de downstream-applicaties en het begrijpen van de afwegingen tussen de verschillende dimensies voor de kwaliteit van synthetische data.

Samengevat

Als gebruiker van de synthetische data is het essentieel om de context van de use case te definiëren waarvoor elk synthetisch monster in de toekomst zal worden gebruikt. Net als bij echte gegevens, is de kwaliteit van de synthetische gegevens afhankelijk van de beoogde use-case, evenals de parameters die voor synthese zijn gekozen.

Het behouden van uitschieters in de synthetische gegevens zoals in de oorspronkelijke gegevens is bijvoorbeeld handig voor gebruik bij fraudedetectie. Het is echter niet nuttig in een gebruikssituatie in de gezondheidszorg met privacykwesties, aangezien uitschieters over het algemeen het lekken van informatie kunnen zijn.

Bovendien bestaat er een afweging tussen trouw, nut en privacy. Gegevens kunnen niet voor alle drie tegelijkertijd worden geoptimaliseerd. Deze statistieken stellen de belanghebbenden in staat om prioriteit te geven aan wat essentieel is voor elke use case en om de verwachtingen van de gegenereerde synthetische gegevens te beheren.

Als we de waarden van elke statistiek zien en als ze aan de verwachtingen voldoen, kunnen belanghebbenden uiteindelijk vertrouwen hebben in de oplossingen die ze bouwen met behulp van de synthetische gegevens.

De use cases voor gestructureerde synthetische data bestrijken een breed scala aan toepassingen, van testdata voor softwareontwikkeling tot het creëren van synthetische controle-armen in klinische onderzoeken.

Neem contact op om deze kansen te verkennen of bouw een PoC om de waarde aan te tonen.

Faris Haddad is de Data & Insights Lead in het AABG Strategic Pursuits-team. Hij helpt ondernemingen om datagedreven te worden.

Faris Haddad is de Data & Insights Lead in het AABG Strategic Pursuits-team. Hij helpt ondernemingen om datagedreven te worden.

- Gevorderd (300)

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- Amazon machinaal leren

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- AWS-machine learning

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- google ai

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- syntaxis

- Technische instructies

- zephyrnet