In november 2022 hebben wij aangekondigd waarmee AWS-klanten afbeeldingen uit tekst kunnen genereren Stabiele diffusie modellen met behulp van Amazon SageMaker JumpStart. Vandaag introduceren we met veel plezier een nieuwe functie waarmee gebruikers afbeeldingen kunnen inkleuren met Stable Diffusion-modellen. Inpainting verwijst naar het proces waarbij een deel van een afbeelding wordt vervangen door een andere afbeelding op basis van een tekstuele prompt. Door de oorspronkelijke afbeelding, een maskerafbeelding die het te vervangen deel schetst en een tekstuele prompt te leveren, kan het stabiele diffusiemodel een nieuwe afbeelding produceren die het gemaskeerde gebied vervangt door het object, onderwerp of de omgeving die in de tekstuele prompt wordt beschreven.

U kunt inpainting gebruiken om verslechterde afbeeldingen te herstellen of nieuwe afbeeldingen te maken met nieuwe onderwerpen of stijlen in bepaalde secties. Binnen het domein van architectonisch ontwerp kan Stable Diffusion inpainting worden toegepast om onvolledige of beschadigde delen van bouwtekeningen te repareren, waardoor bouwploegen nauwkeurige informatie krijgen. In het geval van klinische MRI-beeldvorming moet het hoofd van de patiënt worden vastgehouden, wat kan leiden tot ondermaatse resultaten vanwege het bijsnijdingsartefact dat gegevensverlies of verminderde diagnostische nauwkeurigheid veroorzaakt. Image inpainting kan effectief helpen om deze suboptimale resultaten te verminderen.

In dit bericht presenteren we een uitgebreide gids over het implementeren en uitvoeren van inferentie met behulp van het Stable Diffusion inpainting-model op twee manieren: via de gebruikersinterface (UI) van JumpStart in Amazon SageMaker Studio, en programmatisch door JumpStart-API's beschikbaar in de SageMaker Python-SDK.

Overzicht oplossingen

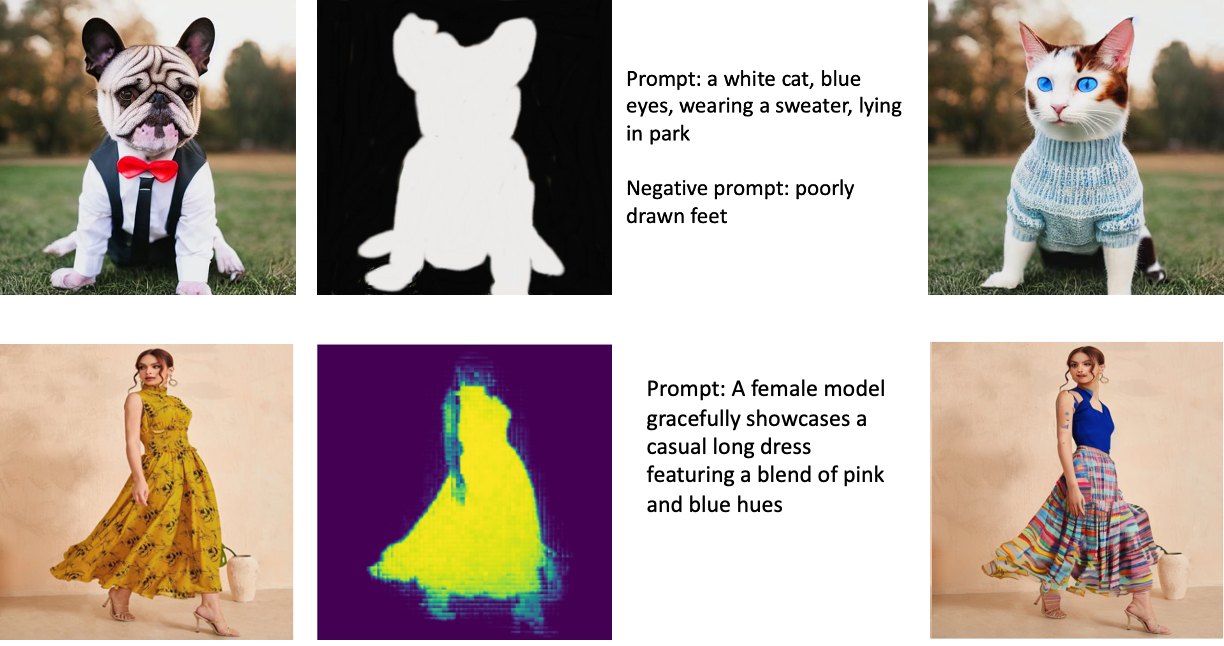

De volgende afbeeldingen zijn voorbeelden van inpainting. De originele afbeeldingen bevinden zich aan de linkerkant, de maskerafbeelding bevindt zich in het midden en de ingeschilderde afbeelding die door het model is gegenereerd, bevindt zich aan de rechterkant. Voor het eerste voorbeeld kreeg het model de originele afbeelding, een maskerafbeelding en de tekstuele prompt 'een witte kat, blauwe ogen, gekleed in een trui, liggend in het park', evenals de negatieve prompt 'slecht getekende voeten. ” Voor het tweede voorbeeld was de tekstuele prompt: "Een vrouwelijk model toont gracieus een casual lange jurk met een mix van roze en blauwe tinten,"

Het uitvoeren van grote modellen zoals Stable Diffusion vereist aangepaste inferentiescripts. U moet end-to-end-tests uitvoeren om ervoor te zorgen dat het script, het model en de gewenste instantie efficiënt samenwerken. JumpStart vereenvoudigt dit proces door kant-en-klare scripts aan te bieden die robuust zijn getest. Je hebt toegang tot deze scripts met één klik via de gebruikersinterface van Studio of met heel weinig regels code via de JumpStart-API's.

In de volgende secties wordt u begeleid bij het implementeren van het model en het uitvoeren van inferentie met behulp van de Studio-gebruikersinterface of de JumpStart-API's.

Merk op dat door dit model te gebruiken, u akkoord gaat met de CreativeML Open RAIL++-M-licentie.

Toegang tot JumpStart via de Studio UI

In deze sectie illustreren we de implementatie van JumpStart-modellen met behulp van de gebruikersinterface van Studio. De bijgevoegde video demonstreert het vinden van het vooraf getrainde Stable Diffusion inpainting-model op JumpStart en het implementeren ervan. De modelpagina biedt essentiële details over het model en het gebruik ervan. Om gevolgtrekkingen uit te voeren, gebruiken we het instantietype ml.p3.2xlarge, dat de vereiste GPU-versnelling levert voor gevolgtrekkingen met lage latentie tegen een betaalbare prijs. Nadat de SageMaker-hostinginstantie is geconfigureerd, kiest u Implementeren. Het eindpunt is operationeel en klaar om deductieverzoeken binnen ongeveer 10 minuten af te handelen.

JumpStart biedt een voorbeeldnotitieboekje dat kan helpen de tijd te versnellen die nodig is om gevolgtrekkingen uit te voeren op het nieuw gemaakte eindpunt. Kies voor toegang tot het notitieboek in Studio Notitieblok openen in de Eindpunt van Studio gebruiken gedeelte van de modeleindpuntpagina.

Gebruik JumpStart programmatisch met de SageMaker SDK

Door gebruik te maken van de JumpStart-gebruikersinterface kunt u met slechts een paar klikken een vooraf getraind model interactief implementeren. Als alternatief kunt u JumpStart-modellen programmatisch gebruiken door API's te gebruiken die zijn geïntegreerd in de SageMaker Python SDK.

In deze sectie kiezen we een geschikt vooraf getraind model in JumpStart, implementeren we dit model op een SageMaker-eindpunt en voeren we gevolgtrekkingen uit op het geïmplementeerde eindpunt, allemaal met behulp van de SageMaker Python SDK. De volgende voorbeelden bevatten codefragmenten. Om toegang te krijgen tot de volledige code met alle stappen in deze demonstratie, raadpleegt u de Inleiding tot JumpStart Beeldbewerking – Stabiele diffusie Inpainting voorbeeld notitieboekje.

Het vooraf getrainde model implementeren

SageMaker gebruikt Docker-containers voor verschillende build- en runtime-taken. JumpStart maakt gebruik van de SageMaker Deep Learning-containers (DLC's) die framework-specifiek zijn. We halen eerst eventuele aanvullende pakketten op, evenals scripts om training en inferentie voor de geselecteerde taak af te handelen. Vervolgens worden de vooraf getrainde modelartefacten afzonderlijk opgehaald model_uris, wat het platform flexibiliteit biedt. Hierdoor kunnen meerdere vooraf getrainde modellen worden gebruikt met één inferentiescript. De volgende code illustreert dit proces:

Vervolgens verstrekken we die middelen aan a SageMaker-model instantie en implementeer een eindpunt:

Nadat het model is geïmplementeerd, kunnen we er realtime voorspellingen uit halen!

Invoer

De invoer is de basisafbeelding, een maskerafbeelding en de prompt die het onderwerp, object of de omgeving beschrijft die moet worden vervangen in het gemaskeerde gedeelte. Het creëren van de perfecte maskerafbeelding voor in-painting-effecten omvat verschillende best practices. Begin met een specifieke prompt en aarzel niet om te experimenteren met verschillende instellingen voor stabiele diffusie om de gewenste resultaten te bereiken. Gebruik een maskerafbeelding die sterk lijkt op de afbeelding die u wilt schilderen. Deze benadering helpt het inpainting-algoritme bij het voltooien van de ontbrekende delen van de afbeelding, wat resulteert in een natuurlijker uiterlijk. Afbeeldingen van hoge kwaliteit leveren over het algemeen betere resultaten op, dus zorg ervoor dat uw basis- en maskerafbeeldingen van goede kwaliteit zijn en op elkaar lijken. Kies daarnaast voor een grote en vloeiende maskerafbeelding om details te behouden en artefacten te minimaliseren.

Het eindpunt accepteert de basisafbeelding en het masker als onbewerkte RGB-waarden of een in base64 gecodeerde afbeelding. De inferentiehandler decodeert de afbeelding op basis van content_type:

- Voor

content_type = “application/json”, moet de invoerpayload een JSON-woordenboek zijn met de onbewerkte RGB-waarden, tekstuele prompt en andere optionele parameters - Voor

content_type = “application/json;jpeg”, moet de invoerpayload een JSON-woordenboek zijn met de base64-gecodeerde afbeelding, een tekstuele prompt en andere optionele parameters

uitgang

Het eindpunt kan twee soorten uitvoer genereren: een Base64-gecodeerde RGB-afbeelding of een JSON-woordenboek van de gegenereerde afbeeldingen. U kunt aangeven welk uitvoerformaat u wilt door de accept kop naar "application/json" or "application/json;jpeg" voor respectievelijk een JPEG-afbeelding of base64.

- Voor

accept = “application/json”, retourneert het eindpunt een JSON-woordenboek met RGB-waarden voor de afbeelding - Voor

accept = “application/json;jpeg”, retourneert het eindpunt een JSON-woordenboek met de JPEG-afbeelding als bytes gecodeerd met base64.b64-codering

Houd er rekening mee dat het verzenden of ontvangen van de payload met de onbewerkte RGB-waarden mogelijk de standaardlimieten voor de invoerpayload en de responsgrootte bereikt. Daarom raden we aan om de base64-gecodeerde afbeelding per instelling te gebruiken content_type = “application/json;jpeg” en accepteer = "application/json;jpeg".

De volgende code is een voorbeeld van een gevolgtrekkingsverzoek:

Ondersteunde parameters

Stabiele diffusie in-schilderijmodellen ondersteunen veel parameters voor het genereren van afbeeldingen:

- beeld – De originele afbeelding.

- maskeren – Een beeld waarbij het zwarte gedeelte ongewijzigd blijft tijdens het genereren van het beeld en het witte gedeelte wordt vervangen.

- prompt - Een prompt om het genereren van afbeeldingen te begeleiden. Dit kan een tekenreeks of een lijst met tekenreeksen zijn.

- num_inference_steps (optioneel) – Het aantal stappen voor het verwijderen van ruis tijdens het genereren van afbeeldingen. Meer stappen leiden tot een afbeelding van hogere kwaliteit. Indien gespecificeerd, moet het een positief geheel getal zijn. Merk op dat meer inferentiestappen zullen leiden tot een langere responstijd.

- guidance_scale (optioneel) – Een hogere begeleidingsschaal resulteert in een beeld dat nauwer verwant is aan de prompt, ten koste van de beeldkwaliteit. Indien gespecificeerd, moet het een float zijn.

guidance_scale<=1wordt genegeerd. - negatieve_prompt (optioneel) - Dit leidt het genereren van afbeeldingen tegen deze prompt. Indien opgegeven, moet het een tekenreeks of een lijst met tekenreeksen zijn en worden gebruikt met

guidance_scale. Indienguidance_scaleis uitgeschakeld, is dit ook uitgeschakeld. Bovendien, als de prompt een lijst met tekenreeksen is, dan is denegative_promptmoet ook een lijst met tekenreeksen zijn. - zaad (optioneel) – Hiermee wordt de gerandomiseerde toestand voor reproduceerbaarheid hersteld. Indien gespecificeerd, moet het een geheel getal zijn. Telkens wanneer u dezelfde prompt met dezelfde seed gebruikt, is de resulterende afbeelding altijd hetzelfde.

- batch_size (optioneel) - Het aantal afbeeldingen dat moet worden gegenereerd in een enkele voorwaartse beweging. Als u een kleinere instantie gebruikt of veel afbeeldingen genereert, reduceer dan

batch_sizeeen klein getal zijn (1–2). Het aantal afbeeldingen = aantal prompts*num_images_per_prompt.

Beperkingen en vooroordelen

Hoewel Stable Diffusion indrukwekkende prestaties levert bij het schilderen, heeft het te kampen met verschillende beperkingen en vooroordelen. Deze omvatten, maar zijn niet beperkt tot:

- Het model genereert mogelijk geen nauwkeurige gezichten of ledematen omdat de trainingsgegevens niet voldoende afbeeldingen met deze functies bevatten.

- Het model is getraind op de LAION-5B-gegevensset, die inhoud voor volwassenen bevat en mogelijk niet geschikt is voor productgebruik zonder verdere overwegingen.

- Het model werkt mogelijk niet goed met niet-Engelse talen omdat het model is getraind op Engelstalige tekst.

- Het model kan geen goede tekst in afbeeldingen genereren.

- Stabiele diffusie in schilderen werkt meestal het beste met afbeeldingen met een lagere resolutie, zoals 256×256 of 512×512 pixels. Bij het werken met afbeeldingen met een hoge resolutie (768 × 768 of hoger), kan de methode moeite hebben om het gewenste niveau van kwaliteit en detail te behouden.

- Hoewel het gebruik van een seed de reproduceerbaarheid kan helpen beheersen, kan Stabiele diffusie bij het schilderen nog steeds gevarieerde resultaten opleveren met kleine wijzigingen in de invoer of parameters. Dit kan het een uitdaging maken om de uitvoer af te stemmen op specifieke vereisten.

- De methode kan moeite hebben met het genereren van ingewikkelde texturen en patronen, vooral wanneer ze grote gebieden binnen het beeld beslaan of essentieel zijn voor het behoud van de algehele samenhang en kwaliteit van het ingeschilderde gebied.

Voor meer informatie over beperkingen en vooringenomenheid, zie de Stabiele diffusie Inpainting modelkaart.

Inpainting-oplossing met masker gegenereerd via een prompt

CLIPSeq is een geavanceerde deep learning-techniek die gebruikmaakt van de kracht van vooraf getrainde CLIP-modellen (Contrastive Language-Image Pretraining) om maskers te genereren op basis van invoerbeelden. Deze aanpak biedt een efficiënte manier om maskers te maken voor taken zoals beeldsegmentatie, inpainting en manipulatie. CLIPSeq gebruikt CLIP om een tekstbeschrijving van de invoerafbeelding te genereren. De tekstbeschrijving wordt vervolgens gebruikt om een masker te genereren dat de pixels in de afbeelding identificeert die relevant zijn voor de tekstbeschrijving. Het masker kan vervolgens worden gebruikt om de relevante delen van de afbeelding te isoleren voor verdere verwerking.

CLIPSeq heeft verschillende voordelen ten opzichte van andere methoden voor het genereren van maskers op basis van invoerafbeeldingen. Ten eerste is het een efficiëntere methode, omdat de afbeelding niet hoeft te worden verwerkt door een afzonderlijk algoritme voor beeldsegmentatie. Ten tweede is het nauwkeuriger, omdat het maskers kan genereren die beter aansluiten bij de tekstbeschrijving van de afbeelding. Ten derde is het veelzijdiger, omdat je het kunt gebruiken om maskers te genereren op basis van een grote verscheidenheid aan afbeeldingen.

CLIPSeq heeft echter ook enkele nadelen. Ten eerste kan de techniek beperkingen hebben wat betreft het onderwerp, omdat deze berust op vooraf getrainde CLIP-modellen die mogelijk geen specifieke domeinen of expertisegebieden omvatten. Ten tweede kan het een gevoelige methode zijn, omdat het vatbaar is voor fouten in de tekstbeschrijving van de afbeelding.

Raadpleeg voor meer informatie Virtuele mode-styling met generatieve AI met behulp van Amazon SageMaker.

Opruimen

Nadat u klaar bent met het uitvoeren van de notebook, moet u ervoor zorgen dat u alle bronnen verwijdert die tijdens het proces zijn gemaakt om ervoor te zorgen dat de facturering wordt gestopt. De code om het eindpunt op te schonen is beschikbaar in het bijbehorende notitieboekje.

Conclusie

In dit bericht hebben we laten zien hoe u een vooraf getraind stabiel diffusie-inpainting-model kunt implementeren met behulp van JumpStart. We hebben in dit bericht codefragmenten getoond - de volledige code met alle stappen in deze demo is beschikbaar in de Inleiding tot JumpStart – Verbeter de beeldkwaliteit op aanwijzing voorbeeld notitieboekje. Probeer de oplossing zelf uit en stuur ons uw opmerkingen.

Raadpleeg de volgende bronnen voor meer informatie over het model en hoe het werkt:

Bekijk de volgende berichten voor meer informatie over JumpStart:

Over de auteurs

Dr Vivek Madan is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign en was een postdoctoraal onderzoeker bij Georgia Tech. Hij is een actief onderzoeker op het gebied van machine learning en algoritmeontwerp en heeft artikelen gepubliceerd op EMNLP-, ICLR-, COLT-, FOCS- en SODA-conferenties.

Dr Vivek Madan is een Applied Scientist bij het Amazon SageMaker JumpStart-team. Hij promoveerde aan de Universiteit van Illinois in Urbana-Champaign en was een postdoctoraal onderzoeker bij Georgia Tech. Hij is een actief onderzoeker op het gebied van machine learning en algoritmeontwerp en heeft artikelen gepubliceerd op EMNLP-, ICLR-, COLT-, FOCS- en SODA-conferenties.

Alfred Schen is een Senior AI/ML-specialist bij AWS. Hij heeft in Silicon Valley gewerkt en bekleedde technische en leidinggevende functies in diverse sectoren, waaronder de gezondheidszorg, financiën en hightech. Hij is een toegewijde toegepaste AI/ML-onderzoeker, die zich concentreert op CV, NLP en multimodaliteit. Zijn werk is tentoongesteld in publicaties zoals EMNLP, ICLR en Public Health.

Alfred Schen is een Senior AI/ML-specialist bij AWS. Hij heeft in Silicon Valley gewerkt en bekleedde technische en leidinggevende functies in diverse sectoren, waaronder de gezondheidszorg, financiën en hightech. Hij is een toegewijde toegepaste AI/ML-onderzoeker, die zich concentreert op CV, NLP en multimodaliteit. Zijn werk is tentoongesteld in publicaties zoals EMNLP, ICLR en Public Health.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/inpaint-images-with-stable-diffusion-using-amazon-sagemaker-jumpstart/

- :is

- $UP

- 10

- 100

- 2022

- 7

- a

- Over

- versnellen

- ACCEPTEREN

- Accepteert

- toegang

- nauwkeurigheid

- accuraat

- Bereiken

- actieve

- Extra

- Daarnaast

- Adult

- vergevorderd

- voordelen

- betaalbaar

- Na

- tegen

- AI

- AI / ML

- AIDS

- algoritme

- uitgelijnd

- Alles

- toestaat

- altijd

- Amazone

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- en

- Nog een

- api

- APIs

- toegepast

- nadering

- passend

- ongeveer

- bouwkundig

- ZIJN

- GEBIED

- gebieden

- AS

- At

- webmaster.

- Beschikbaar

- AWS

- baseren

- gebaseerde

- BE

- omdat

- BEST

- 'best practices'

- Betere

- vooringenomenheid

- factuuradres

- Blend

- Blauw

- bouw

- Gebouw

- by

- CAN

- geval

- business casual outfit

- KAT

- veroorzakend

- Centreren

- zeker

- uitdagend

- controle

- Kies

- klasse

- Klik

- Klinisch

- van nabij

- code

- opmerkingen

- compleet

- het invullen van

- uitgebreid

- conferenties

- overwegingen

- bouw

- bevatten

- Containers

- containers

- content

- onder controle te houden

- en je merk te creëren

- aangemaakt

- Wij creëren

- gewoonte

- Klanten

- gegevens

- Data Loss

- toegewijd aan

- deep

- diepgaand leren

- Standaard

- levert

- demonstreert

- implementeren

- ingezet

- het inzetten

- inzet

- beschreven

- beschrijving

- Design

- gewenste

- detail

- gegevens

- Verspreiding

- invalide

- diversen

- havenarbeider

- Nee

- domeinen

- Dont

- gedurende

- elk

- effectief

- duurt

- doeltreffend

- efficiënt

- beide

- maakt

- eind tot eind

- Endpoint

- Engels

- verzekeren

- toegang

- Milieu

- fouten

- vooral

- essentieel

- voorbeeld

- voorbeelden

- opgewonden

- experiment

- expertise

- Ogen

- gezichten

- Mode

- Kenmerk

- Voordelen

- Met

- Voeten

- vrouw

- opgehaald

- weinig

- Dien in

- financiën

- Voornaam*

- geschikt

- Flexibiliteit

- Vlotter

- volgend

- Voor

- formaat

- Naar voren

- oppompen van

- vol

- verder

- algemeen

- voortbrengen

- gegenereerde

- het genereren van

- generatie

- generatief

- generatieve AI

- goed

- GPU

- leiding

- gids

- Guides

- handvat

- Hebben

- hoofd

- Gezondheid

- gezondheidszorg

- hulp

- hoogwaardige

- hoge-resolutie

- hoger

- Hit

- bezit

- Hosting

- Hoe

- How To

- HTML

- HTTPS

- identificeert

- Illinois

- beeld

- afbeeldingen

- Imaging

- indrukwekkend

- in

- omvatten

- inclusief

- Inclusief

- informatie

- invoer

- instantie

- geïntegreerde

- Interface

- voorstellen

- IT

- HAAR

- jpg

- json

- taal

- Talen

- Groot

- leiden

- LEARN

- leren

- Niveau

- als

- beperkingen

- Beperkt

- grenzen

- lijnen

- Lijst

- lang

- langer

- uit

- machine

- machine learning

- onderhouden

- Het handhaven

- maken

- leidinggevende

- Manipulatie

- veel

- maskeren

- Maskers

- Materie

- Mei..

- methode

- methoden

- macht

- minuten

- vermist

- Verzachten

- ML

- model

- modellen

- meer

- efficiënter

- Bovendien

- MRI

- meervoudig

- Naturel

- Noodzaak

- negatief

- New

- nlp

- notitieboekje

- roman

- November

- aantal

- object

- verkrijgen

- of

- Aanbod

- on

- EEN

- open

- operationele

- bestellen

- origineel

- Overige

- outlines

- uitgang

- totaal

- het te bezitten.

- Paketten

- pagina

- papieren

- parameters

- Park

- onderdelen

- passeren

- patronen

- Uitvoeren

- prestatie

- platform

- Plato

- Plato gegevensintelligentie

- PlatoData

- punt

- posities

- positief

- Post

- Berichten

- energie

- praktijken

- nauwkeurig

- Voorspellingen

- predictor

- bereid

- presenteren

- prijs

- Verwerkt

- verwerking

- produceren

- Product

- zorgen voor

- mits

- biedt

- het verstrekken van

- publiek

- volksgezondheid

- publicaties

- gepubliceerde

- Python

- kwaliteit

- Gerandomiseerd

- Rauw

- real-time

- rijk

- ontvangende

- adviseren

- verminderen

- Gereduceerd

- verwijst

- regio

- verwant

- relevante

- stoffelijk overschot

- reparatie

- vervangen

- te vragen

- verzoeken

- vereisen

- nodig

- Voorwaarden

- vereist

- onderzoeker

- lijkt op

- Resources

- antwoord

- het herstellen van

- verkregen

- Resultaten

- terugkeer

- Retourneren

- RGB

- lopen

- lopend

- sagemaker

- dezelfde

- Scale

- Wetenschapper

- scripts

- sdk

- Tweede

- sectie

- secties

- Sectoren

- zaad

- segmentatie

- gekozen

- verzending

- senior

- gevoelig

- apart

- het instellen van

- settings

- verscheidene

- Silicium

- Silicon Valley

- single

- Maat

- Klein

- kleinere

- So

- oplossing

- sommige

- span

- specialist

- specifiek

- gespecificeerd

- stabiel

- begin

- Land

- Stappen

- Still

- gestopt

- Draad

- studio

- onderwerpen

- dergelijk

- lijdt

- voldoende

- ondersteuning

- geneigd

- neemt

- Taak

- taken

- team

- tech

- Technisch

- termen

- testen

- dat

- De

- daarom

- Deze

- Derde

- Door

- niet de tijd of

- naar

- vandaag

- samen

- getraind

- Trainingen

- types

- typisch

- ui

- universiteit-

- us

- Gebruik

- .

- Gebruiker

- User Interface

- gebruikers

- gebruik maken van

- maakt gebruik van

- Vallei

- Values

- variëteit

- divers

- veelzijdig

- via

- Video

- Manier..

- GOED

- welke

- wit

- breed

- wil

- Met

- binnen

- zonder

- Mijn werk

- samenwerken

- werkzaam

- Bedrijven

- Opbrengst

- You

- Your

- zephyrnet