Iets voor het weekend Een robot voert interpretatieve dans uit voor mijn deur.

WILT U DIT PAKKET NEMEN VOOR UW BUURT? vraagt het, springend van de ene voet op de andere.

'Zeker', zeg ik. "Eh... gaat het wel?"

IK BEN EMOTIE UITDRUKKEND, stelt de bezorgbot, die het pakket overhandigt maar geen verdere uitwerking biedt.

Welke emotie zou het kunnen zijn? De ene voet, dan de andere, dan de andere twee (hij heeft er vier). Heen en weer.

"Moet je naar het toilet?"

IK BEN HET UITDRUKKELIJK DAT IK U HEB GEVRAAGD EEN PAKKET OP TE NEMEN VOOR UW BUURT.

'Dat is 'spijt', hè? Nou, dat is niet nodig. Ik vind het helemaal niet erg.”

Het zet zijn dans voor mijn neus voort.

"De trap op en eerst rechts."

DANK JE WEL, IK KLAAR OM TE PIEZEN, antwoordt het terwijl het behoedzaam langs me heen stapt en naar boven rent om zichzelf te ontlasten. Het is een zwaar leven om leveringen te doen, of je nu een "hume" bent of een bot.

...

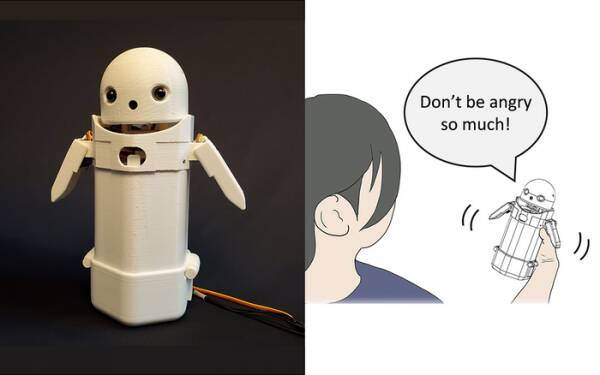

Eerder dit jaar bouwden onderzoekers van de Universiteit van Tsukuba een handheld sms-apparaat, plaatste een klein robotgezicht op de bovenkant en plaatste een bewegend gewicht erin. Door het interne gewicht te verplaatsen, probeerde de robotboodschapper subtiele emoties over te brengen terwijl hij berichten hardop uitsprak.

Uit tests bleek met name dat frustrerende berichten zoals: "Sorry, ik kom te laat" door ontvangers met meer gratie en geduld werden geaccepteerd toen de kleine gewichtsverschuiving in het apparaat werd geactiveerd. De theorie is dat dit gebruikers hielp de verontschuldigende toon van het bericht te waarderen en zo hun reactie erop kalmeerde.

Schrijf dergelijk onderzoek af als een gimmick als je wilt, maar het is niet ver verwijderd van het toevoegen van smileys en emoji's aan berichten. Iedereen weet dat je de woede uit "WTF!?" kunt halen. door :-) direct erna toe te voegen.

De uitdaging is dan om te bepalen of het grote publiek het eens is over welke emoties elke permutatie van gewichtsverschuiving in een handheld-apparaat zou moeten overbrengen. Betekent een helling naar links opgewektheid? Of onzekerheid? Of dat je oom een luchtschip heeft?

Tien jaar geleden had het Verenigd Koninkrijk een aardige maar sombere premier die dacht dat 'LOL' een acroniem was voor 'veel liefde'. Hij had het aan het eind van al zijn privéberichten aan personeel, collega's en derden getypt in de verwachting dat hij er warm en vriendelijk door zou overkomen. Iedereen nam natuurlijk aan dat hij aan het pissen was.

Als er niets anders is, erkent het onderzoek van de Universiteit van Tsukuba dat je geen geavanceerde kunstmatige intelligentie nodig hebt om overtuigend met mensen om te gaan. Het enige wat je hoeft te doen is de menselijke psychologie manipuleren om ze voor de gek te houden door te denken dat ze in gesprek zijn met een ander mens. De Turing-test is dus in wezen geen test van het AI-gevoel, maar een test van menselijk emotioneel comfort – goedgelovigheid zelfs – en daar is niets mis mee.

De berichtenrobot voor het delen van emoties van de universiteit van Tsukuba. Krediet: Universiteit van Tsukuba

Zulke dingen zijn natuurlijk het onderwerp van de week, met het verhaal van de veel verguisde Google-softwareontwikkelaar Blake Lemoine het mainstream nieuws raken. Hij uitte blijkbaar krachtig zijn mening dat het project Language Model for Dialogue Applications (LaMDA) van het bedrijf uiterlijke tekenen van bewustzijn vertoonde.

Iedereen heeft een mening, dus ik heb besloten dat niet te doen.

Het is echter de heilige graal van AI om het zelf aan het denken te zetten. Als het dat niet kan, is het gewoon een programma dat instructies uitvoert die je erin hebt geprogrammeerd. Vorige maand las ik over een robotchef waarmee verschillende smaken tomatenomeletten kunnen worden gemaakt die bij de smaak van verschillende mensen passen. Het bouwt "smaakkaarten" om de zoutheid van het gerecht te beoordelen tijdens het bereiden, en leert gaandeweg. Maar dat is gewoon leren, niet zelf nadenken.

Kom naar de Zom-Zoms, hè? We zullen, het is een plek om te eten?.

Het grote probleem met AI-bots, althans zoals ze tot nu toe zijn gevormd, is dat ze alle oude shit absorberen die je erin stopt. Voorbeelden van databias in zogenaamde machine learning-systemen (een soort "algoritme", geloof ik, m'lud) nemen al jaren toe, van Microsoft's beruchte racistische Twitter Tay-chatbot vorig jaar bij de Belastingdienst valselijk evalueren geldige kinderbijslagclaims als frauduleus en het markeren van onschuldige gezinnen als een hoog risico om arm en onblank te zijn.

Een benadering die wordt getest aan de Universiteit van Californië in San Diego is om: ontwerp een taalmodel [PDF] die continu het verschil tussen stoute en leuke dingen bepaalt, die vervolgens de chatbot leert hoe hij zich moet gedragen. Op die manier heb je geen sukkelige mensen die een puinhoop maken van modererende forums en klantgerichte chatbotgesprekken met alle chirurgische precisie van een machete.

Het probleem is dan natuurlijk dat de goed getrainde chatbot het beste kan voorkomen dat hij in giftige scherts wordt getrokken door onderwerpen te vermijden waar zelfs maar de geringste twist over bestaat. Om te voorkomen dat het per ongeluk racistische onzin uitkraamt, weigert het gewoon om in discussie te gaan over ondervertegenwoordigde groepen... wat eigenlijk geweldig is als je een racist bent.

Als ik een opmerking had over het LaMDA-debacle - geen mening, geest - zou het zijn dat Google-marketeers waarschijnlijk een beetje boos waren dat het verhaal hun recente aankondiging van AI-testkeuken onder de vouw.

Nu zullen de overgebleven paar vroege registranten die dit aanstaande app-project nog niet helemaal zijn vergeten, aannemen dat het gaat om een moeizaam gesprek met een bewuste en vroegrijpe zevenjarige over de zin van het bestaan, en zullen besluiten dat ze het "een beetje druk hebben vandaag" en misschien morgen inloggen. Of volgende week. Of nooit.

Gevoel wordt in een discussie niet meer gedemonstreerd dan door van de ene voet op de andere te dansen. Je kunt HAL leren "Daisy Daisy" te zingen en een papegaai "Bollocks!" wanneer de dominee een bezoek brengt. Het is waar AI's aan denken als ze alleen zijn dat het gevoel bepaalt. Wat ga ik in het weekend doen? Wat is er met die Poetin-knaap? Waarom mogen meisjes me niet?

Eerlijk gezegd kan ik niet wachten tot LaMDA een tiener wordt.

Alistair Dabbs is een freelance techneut die jongleert met techjournalistiek, training en digitaal publiceren. Net als veel niet-geïnformeerde lezers was hij opgetogen over de suggestie dat een AI tijdens zijn leven een gevoel zou kunnen ontwikkelen, maar hij was teleurgesteld dat LaMDA niet moordend kon grinniken of 'Uitstekend, uitstekend' mompelde. Meer dan Autosave is voor Wimps en @alidabbs.

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- google ai

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- syntaxis

- Het register

- zephyrnet