Het kunnen decoderen van hersengolven zou patiënten die het vermogen om te spreken zijn kwijtgeraakt, kunnen helpen om weer te communiceren, en zou uiteindelijk nieuwe manieren kunnen bieden voor mensen om met computers om te gaan. Nu hebben Meta-onderzoekers aangetoond dat ze kunnen zien welke woorden iemand is gehoor met behulp van opnames van niet-invasieve hersenscans.

Ons vermogen om te onderzoeken menselijk de hersenactiviteit is de afgelopen decennia aanzienlijk verbeterd, aangezien wetenschappers een verscheidenheid aan brain-computer interface (BCI) -technologieën hebben ontwikkeld die een venster op onze gedachten en bedoelingen kunnen bieden.

De meest indrukwekkende resultaten zijn afkomstig van invasieve opnameapparaten, die elektroden rechtstreeks in de implanteren hersenen gray matter, gecombineerd met AI die kan leren interpreterent hersensignalen. Dit heeft de laatste jaren veelhet is mogelijk om ontcijfer volledige zinnen van iemands neurale activiteit met een nauwkeurigheid van 97 procent, en vertaalpoging handschriftbewegingen direct in tekst bij snelheden vergelijkbaarle om te sms'en.

Maar het implanteren van elektroden in iemands hersenen heeft duidelijke nadelen. Deze risicovolle procedures zijn alleen medisch verantwoord voor patiënten die hersenregistratie nodig hebben om andere medische problemen, zoals epilepsie, op te lossen. En neurale sondes verslechteren in de loop van de tijd, wat het vooruitzicht vergroot dat ze regelmatig moeten worden vervangen.

Daarom besloten onderzoekers van Meta's AI-onderzoeksdivisie te onderzoeken of ze vergelijkbare doelen konden bereiken zonder een gevaarlijke hersenoperatie te vereisenj. in een krant gepubliceerd op de pre-print server arXiv, het team meldde dat ze een AI-systeem hebben ontwikkeld dat kan voorspellen naar welke woorden iemand luistert op basis van hersenactiviteit die is geregistreerd met behulp van niet-invasieve brain-computer interfaces.

"Het is natuurlijk extreem ingrijpend om een elektrode in iemands brein te plaatsen”, zegt Jean Remi King, onderzoeker bij Facebook Artificial Intelligence Research (FAIR) Lab, vertelde TIJD. "Dus wilden we proberen om niet-invasieve registraties van hersenactiviteit te gebruiken. En het doel was om een AI-systeem te bouwen dat hersenreacties op gesproken verhalen kan decoderen.”

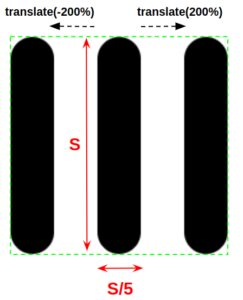

De onderzoekers vertrouwden op vier reeds bestaande datasets over hersenactiviteit, verzameld van 169 mensen terwijl ze luisterden naar opnames van sprekende mensen. Elke vrijwilliger werd opgenomen met behulp van magneto-encefalografie (MEG) of elektro-encefalografie (EEG), die verschillende soorten sensoren gebruiken om de elektrische activiteit van de hersenen van buiten de schedel op te pikken.

Hun aanpak houdt in:d het splitsen van de hersenen en audiogegevens in drie-secondenlange fragmenten en deze in een neuraal netwerk invoeren dat er vervolgens uitzieted voor patronen die could verbind de twee. Nadat ze de AI vele uren van deze gegevens hadden getraind, testten ze deze vervolgens op voorheen ongeziene gegevens.

Het systeem presteerde het beste op een van de MEG-datasets, waar het een top-10 nauwkeurigheid van 72.5 procent behaalde. Dat betekent dat wanneer het de 10 woorden met de grootste kans om te worden gekoppeld aan het hersengolfsegment, het juiste woord was er 72.5 procent van de tijd.

Dat klinkt misschien niet geweldig, maar het is belangrijk om te onthouden dat het een keuze was uit een potentieel vocabulaire van 793 woorden. Het systeem scoorde 67.2 procent op de andere MEG-dataset, maar deed het minder goed op de EEG-datasets en kreeg top-10 nauwkeurigheid van slechts 31.4 en 19.1.

Het is duidelijk dat dit nog ver verwijderd is van een praktisch systeem, maar het betekent een aanzienlijke vooruitgang op een moeilijk probleem. Niet-invasieve BCI's hebben veel slechtere signaal-ruisverhoudingen, dus het is een uitdaging om neurale activiteit op deze manier te ontcijferen, maar als het lukt, kan dit resulteren in een veel breder toepasbare technologie.

Niet iedereen is er echter van overtuigd dat het een oplosbaar probleem is. Thomas Knopfel van Imperial College London vertelde: New Scientist dat het proberen om gedachten te onderzoeken met behulp van deze niet-invasieve benaderingen was als "proberen een HD-film te streamen via ouderwetse analoge telefoonmodems”, en vroegen zich af of dergelijke benaderingen ooit praktische nauwkeurigheidsniveaus zullen bereiken.

Bedrijven zoals Neuralink van Elon Musk wedden ook dat we uiteindelijk onze preutsheid over invasieve benaderingen zullen overwinnen naarmate de technologie verbetert, waardoor de deur wordt geopend voor gewone mensen die hersenimplantaten krijgen.

Maar het onderzoek van het team van Meta staat nog in de kinderschoenen en er is veel ruimte voor verbetering. En de commerciële kansen voor iedereen die niet-invasieve hersenscans kan kraken, zullen waarschijnlijk voldoende motivatie bieden om het te proberen.