Het uitkiezen van afzonderlijke objecten in een visuele scène lijkt ons intuïtief, maar machines worstelen met deze taak. Nu heeft een nieuw AI-model van Meta een breed idee ontwikkeld van wat een object is, waardoor het objecten kan scheiden, zelfs als het ze nog nooit eerder heeft gezien.

Het lijkt misschien een vrij prozaïsche computervisie-taak, maar een afbeelding kunnen ontleden en uitzoeken waar het ene object eindigt en het andere begint, is een vrij fundamentele vaardigheid, zonder welke een groot aantal meer gecompliceerde taken onoplosbaar zou zijn.

"Objectsegmentatie" is niets nieuws; AI-onderzoekers hebben er jaren aan gewerkt. Maar doorgaans is het bouwen van deze modellen een tijdrovend proces geweest dat veel menselijke annotaties van afbeeldingen en aanzienlijke computerbronnen vereist. En doorgaans waren de resulterende modellen zeer gespecialiseerd voor bepaalde gebruikssituaties.

Nu hebben onderzoekers van Meta echter het Segment Anything Model (SAM) onthuld, dat elk object in elke scène kan wegsnijden, ongeacht of het eerder zoiets heeft gezien. Het model kan dit ook doen als reactie op verschillende prompts, van tekstbeschrijving tot muisklikken of zelfs eye-tracking-gegevens.

"SAM heeft een algemeen idee van wat objecten zijn, en het kan maskers genereren voor elk object in elke afbeelding of elke video", schreven de onderzoekers in een blog post. "We geloven dat de mogelijkheden breed zijn en we zijn enthousiast over de vele potentiële use-cases die we ons nog niet eens hebben voorgesteld."

De sleutel tot de ontwikkeling van het model was een enorme nieuwe dataset van 1.1 miljard segmentatiemaskers, die verwijst naar delen van een afbeelding die zijn geïsoleerd en geannoteerd om aan te geven dat ze een bepaald object bevatten. Het is gemaakt door een combinatie van handmatige menselijke annotatie van afbeeldingen en geautomatiseerde processen, en is verreweg de grootste verzameling van dit type die tot nu toe is verzameld.

Door te trainen op zo'n enorme dataset, zeggen de onderzoekers van Meta dat het een algemeen concept heeft ontwikkeld van wat een object is, waardoor het dingen kan segmenteren die het nog niet eens eerder heeft gezien. Dit vermogen om te generaliseren leidde ertoe dat de onderzoekers SAM een "basismodel" noemden controversiële term gebruikt om andere enorme vooraf getrainde modellen te beschrijven, zoals De GPT van OpenAI serie, waarvan de mogelijkheden zogenaamd zo algemeen zijn dat ze kunnen worden gebruikt als basis voor een groot aantal toepassingen.

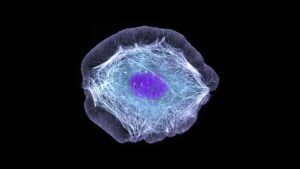

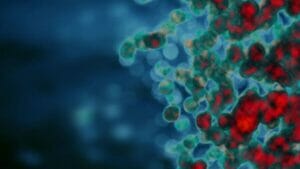

Beeldsegmentatie is absoluut een belangrijk ingrediënt in een breed scala aan computervisietaken. Als je de verschillende componenten van een scène niet kunt scheiden, is het moeilijk om er iets ingewikkelder mee te doen. In hun blog zeggen de onderzoekers dat het van onschatbare waarde kan zijn bij het bewerken van video's en afbeeldingen, of kan helpen bij de analyse van wetenschappelijke beelden.

Misschien relevanter voor de metaverse ambities van het bedrijf, bieden ze een demo van hoe het kan worden gebruikt in combinatie met een virtual reality-headset om specifieke objecten te selecteren op basis van de blik van de gebruiker. Ze zeggen ook dat het mogelijk kan worden gecombineerd met een groot taalmodel om een multimodaal systeem te creëren dat zowel de visuele als de tekstuele inhoud van een webpagina kan begrijpen.

De mogelijkheid om met een breed scala aan prompts om te gaan, maakt het systeem bijzonder flexibel. In een webpagina Bij het demonstreren van het nieuwe model laat het bedrijf zien dat het na het analyseren van een afbeelding kan worden gevraagd om specifieke objecten te scheiden door er simpelweg op te klikken met een muiscursor, in te typen wat u wilt segmenteren, of door de hele afbeelding op te splitsen in aparte objecten.

En het allerbelangrijkste is dat het bedrijf zowel het model als de dataset opensourcet voor onderzoeksdoeleinden, zodat anderen op hun werk kunnen voortbouwen. Dit is dezelfde benadering die het bedrijf volgde met zijn LLaMA-model voor grote talen, wat ertoe leidde dat het snel werd online gelekt en het aansporen van een golf van experimenteren door hobbyisten en hackers.

Of hetzelfde zal gebeuren met SAM valt nog te bezien, maar het is hoe dan ook een geschenk aan de AI-onderzoeksgemeenschap dat de voortgang van een groot aantal belangrijke computervisieproblemen zou kunnen versnellen.

Krediet van het beeld: Meta-AI

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://singularityhub.com/2023/04/10/metas-new-ai-can-identify-and-remove-objects-in-images/

- :is

- $UP

- 1

- a

- vermogen

- in staat

- versnellen

- Na

- AI

- ai onderzoek

- Het toestaan

- toestaat

- ambities

- analyse

- het analyseren van

- en

- Nog een

- toepassingen

- nadering

- ZIJN

- AS

- gemonteerd

- At

- geautomatiseerde

- gebaseerde

- BE

- vaardigheden

- wezen

- geloofd wie en wat je bent

- Miljard

- Blog

- Breaking

- breed

- bouw

- Gebouw

- by

- CAN

- mogelijkheden

- gevallen

- Collectie

- combinatie van

- gemeenschap

- afstand

- Bedrijf

- ingewikkeld

- componenten

- computer

- Computer visie

- computergebruik

- concept

- aanzienlijk

- bevatten

- content

- kon

- en je merk te creëren

- aangemaakt

- Credits

- Snijden

- gegevens

- Datum

- transactie

- definitief

- beschrijven

- beschrijving

- ontwikkelde

- Ontwikkeling

- anders

- beide

- eindigt

- Geheel

- Zelfs

- opgewonden

- tamelijk

- flexibel

- Voor

- Stichtingen

- oppompen van

- fundamenteel

- Algemeen

- voortbrengen

- gift

- Hackers

- gebeuren

- Hard

- Hebben

- Hoofdtelefoon

- hulp

- zeer

- gastheer

- Hoe

- HTTPS

- menselijk

- idee

- beeld

- afbeeldingen

- belangrijk

- in

- intuïtief

- onschatbaar

- geïsoleerd

- IT

- HAAR

- sleutel

- taal

- Groot

- grootste

- geleerd

- LED

- als

- Lama

- Machines

- MERKEN

- handboek

- veel

- Maskers

- massief

- meta

- metaverse

- macht

- model

- modellen

- meer

- meest

- New

- notie

- object

- objecten

- of

- on

- EEN

- Overige

- Overig

- pagina

- gepaarde

- bijzonder

- vooral

- kiezen

- Plato

- Plato gegevensintelligentie

- PlatoData

- mogelijkheden

- potentieel

- mogelijk

- mooi

- problemen

- processen

- Voortgang

- Bewijzen

- zorgen voor

- doeleinden

- reeks

- snel

- Realiteit

- verwijst

- achteloos

- regio

- stoffelijk overschot

- onderzoek

- onderzoekers

- Resources

- antwoord

- verkregen

- Sam

- dezelfde

- scène

- wetenschappelijk

- lijkt

- segment

- segmentatie

- apart

- -Series

- Shows

- eenvoudigweg

- bekwaamheid

- So

- gespecialiseerde

- specifiek

- dergelijk

- system

- Taak

- taken

- dat

- De

- hun

- Ze

- Deze

- spullen

- Door

- tijdrovend

- naar

- Trainingen

- typisch

- begrijpen

- onthuld

- us

- .

- variëteit

- Video

- Virtueel

- Virtuele realiteit

- visie

- Manier..

- web

- Wat

- of

- welke

- breed

- Grote range

- wil

- Met

- zonder

- Mijn werk

- uitwerken

- werkte

- zou

- jaar

- You

- zephyrnet