Amazon Sage Maker maakt het eenvoudig om machine learning (ML)-modellen in te zetten voor realtime gevolgtrekking en biedt een brede selectie van ML-instanties die CPU's en accelerators omvatten, zoals AWS Inferentie. Als volledig beheerde service kunt u uw modelimplementaties schalen, de gevolgtrekkingskosten minimaliseren en uw modellen effectiever in productie beheren met minder operationele lasten. Een real-time inferentie-eindpunt van SageMaker bestaat uit een HTTPs-eindpunt en ML-instanties die worden geïmplementeerd in meerdere beschikbaarheidszones voor hoge beschikbaarheid. SalieMaker automatisch schalen van applicaties kan het aantal ML-instanties dat voor een model is ingericht, dynamisch aanpassen als reactie op wijzigingen in de werklast. Het eindpunt distribueert binnenkomende aanvragen uniform naar ML-instanties met behulp van een round-robin-algoritme.

Wanneer ML-modellen die op instances zijn geïmplementeerd API-aanroepen ontvangen van een groot aantal clients, kan een willekeurige verdeling van verzoeken heel goed werken als er niet veel variatie is in uw verzoeken en antwoorden. Maar in systemen met generatieve AI-workloads kunnen verzoeken en antwoorden extreem variabel zijn. In deze gevallen is het vaak wenselijk om de belasting te verdelen door rekening te houden met de capaciteit en het gebruik van de instantie in plaats van willekeurige taakverdeling.

In dit bericht bespreken we de routeringsstrategie voor de minst openstaande verzoeken (LOR) van SageMaker en hoe deze de latentie voor bepaalde typen real-time inferentie-workloads kan minimaliseren door rekening te houden met de capaciteit en het gebruik van ML-instanties. We praten over de voordelen ervan ten opzichte van het standaard routeringsmechanisme en hoe u LOR kunt inschakelen voor uw modelimplementaties. Ten slotte presenteren we een vergelijkende analyse van latentieverbeteringen met LOR ten opzichte van de standaard routeringsstrategie van willekeurige routering.

SageMaker LOR-strategie

Standaard hebben SageMaker-eindpunten een willekeurige routeringsstrategie. SageMaker ondersteunt nu een LOR-strategie, waarmee SageMaker verzoeken optimaal kan routeren naar de instantie die het meest geschikt is om aan dat verzoek te voldoen. SageMaker maakt dit mogelijk door de belasting van de instanties achter uw eindpunt te monitoren, en de modellen of inferentiecomponenten die op elke instantie worden geïmplementeerd.

Het volgende interactieve diagram toont het standaard routeringsbeleid waarbij aanvragen die naar de modeleindpunten komen, op willekeurige wijze worden doorgestuurd naar de ML-instanties.

Het volgende interactieve diagram toont de routeringsstrategie waarbij SageMaker het verzoek zal routeren naar het exemplaar met het minste aantal openstaande verzoeken.

Over het algemeen werkt LOR-routering goed voor fundamentele modellen of generatieve AI-modellen wanneer uw model binnen honderden milliseconden tot minuten reageert. Als uw modelreactie een lagere latentie heeft (tot honderden milliseconden), profiteert u mogelijk meer van willekeurige routering. Hoe dan ook, we raden u aan het beste routeringsalgoritme voor uw workloads te testen en te identificeren.

Hoe u SageMaker-routeringsstrategieën instelt

Met SageMaker kunt u nu de RoutingStrategy parameter tijdens het maken van de EndpointConfiguration voor eindpunten. Het verschil RoutingStrategy waarden die worden ondersteund door SageMaker zijn:

LEAST_OUTSTANDING_REQUESTSRANDOM

Hier volgt een voorbeeld van de implementatie van een model op een inferentie-eindpunt waarvoor LOR is ingeschakeld:

- Maak de eindpuntconfiguratie door setting

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Maak het eindpunt met behulp van de eindpuntconfiguratie (geen wijziging):

Prestatie resultaten

We hebben prestatiebenchmarks uitgevoerd om de end-to-end inferentielatentie en doorvoer van de codegen2-7B model gehost op ml.g5.24xl-instanties met standaardroutering en slimme routeringseindpunten. Het CodeGen2-model behoort tot de familie van autoregressieve taalmodellen en genereert uitvoerbare code wanneer er Engelse aanwijzingen worden gegeven.

In onze analyse hebben we voor elke testuitvoering het aantal ml.g5.24xl-instanties achter elk eindpunt verhoogd naarmate het aantal gelijktijdige gebruikers toenam, zoals weergegeven in de volgende tabel.

| test | Aantal gelijktijdige gebruikers | Aantal instanties |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

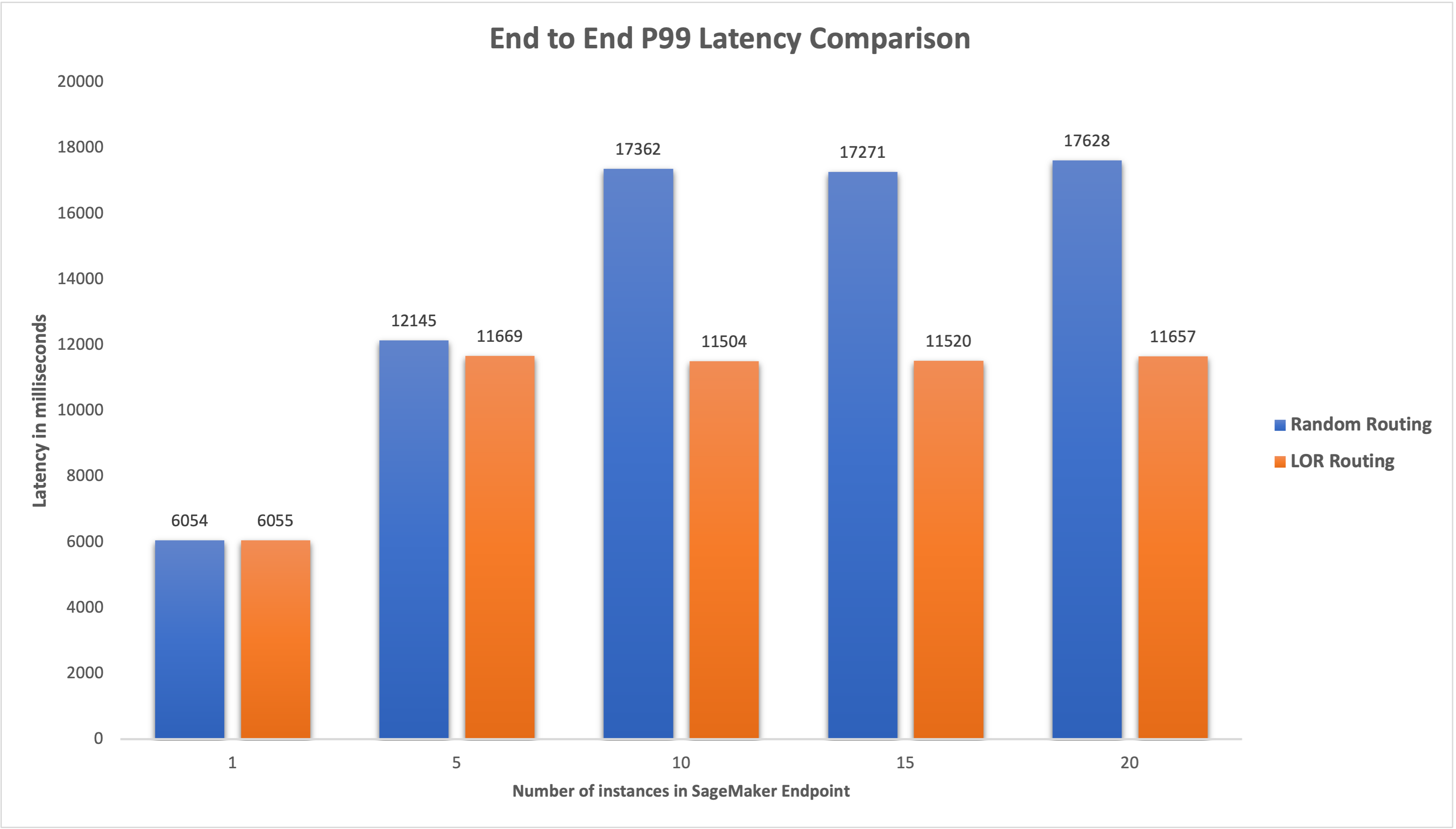

We hebben de end-to-end P99-latentie voor beide eindpunten gemeten en een verbetering van 4-33% in de latentie waargenomen toen het aantal instanties werd verhoogd van 5 naar 20, zoals weergegeven in de volgende grafiek.

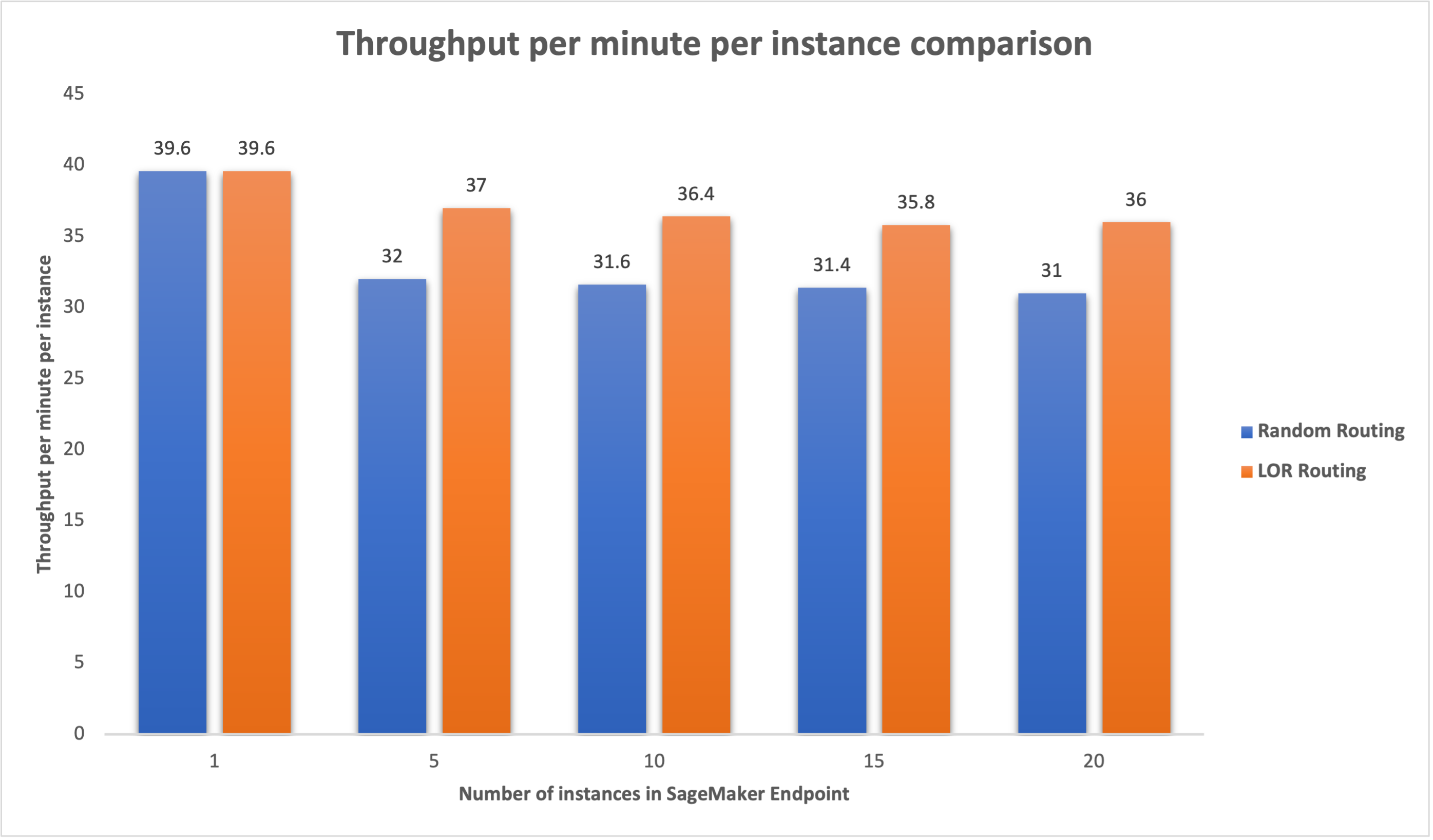

Op dezelfde manier hebben we een verbetering van 15-16% waargenomen in de doorvoer per minuut per exemplaar wanneer het aantal exemplaren werd verhoogd van 5 naar 20.

Dit illustreert dat slimme routering de verkeersverdeling tussen de eindpunten kan verbeteren, wat leidt tot verbeteringen in de end-to-end latentie en de algehele doorvoer.

Conclusie

In dit bericht hebben we de SageMaker-routeringsstrategieën uitgelegd en de nieuwe optie om LOR-routering in te schakelen. We hebben uitgelegd hoe u LOR kunt inschakelen en hoe dit uw modelimplementaties ten goede kan komen. Onze prestatietests lieten verbeteringen in de latentie en doorvoer zien tijdens realtime inferentie. Voor meer informatie over de routeringsfuncties van SageMaker raadpleegt u documentatie. We moedigen u aan om uw inferentiewerkbelastingen te evalueren en te bepalen of u optimaal bent geconfigureerd met de routeringsstrategie.

Over de auteurs

James Park is oplossingsarchitect bij Amazon Web Services. Hij werkt samen met Amazon.com om technologische oplossingen op AWS te ontwerpen, bouwen en implementeren, en heeft een bijzondere interesse in AI en machine learning. In zijn vrije tijd gaat hij graag op zoek naar nieuwe culturen, nieuwe ervaringen en blijft hij op de hoogte van de nieuwste technologische trends. Je kunt hem vinden op LinkedIn.

James Park is oplossingsarchitect bij Amazon Web Services. Hij werkt samen met Amazon.com om technologische oplossingen op AWS te ontwerpen, bouwen en implementeren, en heeft een bijzondere interesse in AI en machine learning. In zijn vrije tijd gaat hij graag op zoek naar nieuwe culturen, nieuwe ervaringen en blijft hij op de hoogte van de nieuwste technologische trends. Je kunt hem vinden op LinkedIn.

Venugopale Pai is een oplossingsarchitect bij AWS. Hij woont in Bengaluru, India, en helpt digital-native klanten hun applicaties op AWS te schalen en te optimaliseren.

Venugopale Pai is een oplossingsarchitect bij AWS. Hij woont in Bengaluru, India, en helpt digital-native klanten hun applicaties op AWS te schalen en te optimaliseren.

David Negenda is een Senior Software Development Engineer bij het Amazon SageMaker-team en werkt momenteel aan het verbeteren van productie-machine learning-workflows en het lanceren van nieuwe inferentiefuncties. In zijn vrije tijd probeert hij zijn kinderen bij te houden.

David Negenda is een Senior Software Development Engineer bij het Amazon SageMaker-team en werkt momenteel aan het verbeteren van productie-machine learning-workflows en het lanceren van nieuwe inferentiefuncties. In zijn vrije tijd probeert hij zijn kinderen bij te houden.

Diepte Ragha is een Software Development Engineer in het Amazon SageMaker-team. Haar huidige werk is gericht op het bouwen van functies om machine learning-modellen efficiënt te hosten. In haar vrije tijd houdt ze van reizen, wandelen en planten kweken.

Diepte Ragha is een Software Development Engineer in het Amazon SageMaker-team. Haar huidige werk is gericht op het bouwen van functies om machine learning-modellen efficiënt te hosten. In haar vrije tijd houdt ze van reizen, wandelen en planten kweken.

Alan Tan is Senior Product Manager bij SageMaker en leidt inspanningen op het gebied van grote modelinferentie. Hij heeft een passie voor het toepassen van machine learning op het gebied van analytics. Buiten zijn werk geniet hij van het buitenleven.

Alan Tan is Senior Product Manager bij SageMaker en leidt inspanningen op het gebied van grote modelinferentie. Hij heeft een passie voor het toepassen van machine learning op het gebied van analytics. Buiten zijn werk geniet hij van het buitenleven.

Dhawal Patel is een Principal Machine Learning Architect bij AWS. Hij heeft gewerkt met organisaties variërend van grote ondernemingen tot middelgrote startups aan problemen met betrekking tot gedistribueerde computing en kunstmatige intelligentie. Hij richt zich op Deep learning inclusief NLP en Computer Vision domeinen. Hij helpt klanten bij het bereiken van high-performance modelinferentie op SageMaker.

Dhawal Patel is een Principal Machine Learning Architect bij AWS. Hij heeft gewerkt met organisaties variërend van grote ondernemingen tot middelgrote startups aan problemen met betrekking tot gedistribueerde computing en kunstmatige intelligentie. Hij richt zich op Deep learning inclusief NLP en Computer Vision domeinen. Hij helpt klanten bij het bereiken van high-performance modelinferentie op SageMaker.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- : heeft

- :is

- :niet

- :waar

- $UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- in staat

- Over

- versnellers

- Bereiken

- over

- AI

- AI-modellen

- Alan

- algoritme

- toestaat

- Amazone

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- onder

- an

- analyse

- analytics

- en

- api

- toepassingen

- Het toepassen van

- ZIJN

- GEBIED

- kunstmatig

- kunstmatige intelligentie

- AS

- At

- auto

- beschikbaarheid

- AWS

- Balance

- balancing

- BE

- achter

- behoort

- benchmarking

- voordeel

- betekent

- BEST

- zowel

- breed

- bouw

- Gebouw

- last

- maar

- by

- oproepen

- CAN

- Inhoud

- gevallen

- zeker

- verandering

- Wijzigingen

- klanten

- code

- COM

- komst

- componenten

- computer

- Computer visie

- computergebruik

- gelijktijdig

- Configuratie

- geconfigureerd

- overweging

- aangezien

- bestaat uit

- Kosten

- Wij creëren

- Actueel

- Op dit moment

- Klanten

- Datum

- deep

- diepgaand leren

- Standaard

- implementeren

- ingezet

- inzet

- implementaties

- Design

- Bepalen

- Ontwikkeling

- anders

- bespreken

- verdeeld

- distributed computing

- distributie

- domeinen

- gedurende

- dynamisch

- elk

- effectief

- efficiënt

- inspanningen

- in staat stellen

- ingeschakeld

- aanmoedigen

- eind tot eind

- Endpoint

- ingenieur

- Engels

- bedrijven

- schatten

- voorbeeld

- Ervaringen

- uitgelegd

- uiterst

- familie

- Voordelen

- Tot slot

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- richt

- volgend

- Voor

- fundamentele

- oppompen van

- geheel

- Algemeen

- genereert

- generatief

- generatieve AI

- gif

- gegeven

- diagram

- Groeiend

- Hebben

- he

- helpt

- haar

- Hoge

- hem

- zijn

- gastheer

- gehost

- Hoe

- How To

- HTML

- HTTPS

- Honderden

- identificeren

- if

- illustreert

- verbeteren

- verbetering

- verbeteringen

- het verbeteren van

- in

- Inclusief

- Inkomend

- meer

- Indië

- instantie

- Intelligentie

- interactieve

- belang

- in

- IT

- HAAR

- jpg

- Houden

- kinderen

- taal

- Groot

- Grote ondernemingen

- Wachttijd

- laatste

- lancering

- leidend

- LEARN

- leren

- minst

- Lives

- laden

- lot

- te verlagen

- machine

- machine learning

- MERKEN

- beheer

- beheerd

- manager

- manier

- Mei..

- maatregel

- mechanisme

- milliseconden

- minuut

- minuten

- ML

- model

- modellen

- Grensverkeer

- meer

- meervoudig

- New

- nlp

- geen

- nu

- aantal

- of

- Aanbod

- vaak

- on

- operationele

- Optimaliseer

- Keuze

- or

- organisaties

- onze

- uit

- buiten

- buiten

- uitstekend

- over

- totaal

- parameter

- bijzonder

- hartstochtelijk

- voor

- prestatie

- Plants

- Plato

- Plato gegevensintelligentie

- PlatoData

- beleidsmaatregelen

- mogelijk

- Post

- presenteren

- Principal

- problemen

- Product

- product manager

- productie

- prompts

- willekeurige

- variërend

- liever

- real-time

- ontvangen

- adviseren

- Gereduceerd

- verwijzen

- achteloos

- verwant

- te vragen

- verzoeken

- antwoord

- reacties

- weg

- routing

- lopen

- sagemaker

- Scale

- op zoek naar

- selectie

- senior

- dienen

- service

- Diensten

- reeks

- het instellen van

- ze

- vertoonde

- getoond

- Shows

- slim

- Software

- software development

- Oplossingen

- overspannen

- Startups

- verblijven

- eenvoudig

- strategieën

- Strategie

- dergelijk

- ondersteunde

- steunen

- Systems

- tafel

- het nemen

- Talk

- team

- Technologie

- proef

- testen

- neem contact

- dat

- De

- De omgeving

- hun

- Er.

- Deze

- dit

- doorvoer

- niet de tijd of

- naar

- verkeer

- Reizend

- Trends

- types

- gebruikers

- gebruik

- Values

- variabele

- zeer

- visie

- we

- web

- webservices

- GOED

- waren

- wanneer

- welke

- en

- wil

- Met

- Mijn werk

- werkte

- workflows

- werkzaam

- Bedrijven

- You

- Your

- zephyrnet

- zones