Amazon SageMaker-gegevens Wrangler helpt u gegevens te begrijpen, samen te voegen, te transformeren en voor te bereiden voor machine learning (ML) vanuit één enkele visuele interface. Het bevat meer dan 300 ingebouwde gegevenstransformaties, zodat u snel functies kunt normaliseren, transformeren en combineren zonder dat u code hoeft te schrijven.

Data science-beoefenaars genereren, observeren en verwerken gegevens om bedrijfsproblemen op te lossen waar ze functies uit datasets moeten transformeren en extraheren. Transformaties zoals ordinale codering of one-hot codering leren coderingen op uw dataset. Deze gecodeerde uitvoer wordt aangeduid als getrainde parameters. Aangezien datasets in de loop van de tijd veranderen, kan het nodig zijn om coderingen op eerder ongeziene gegevens aan te passen om de transformatiestroom relevant te houden voor uw gegevens.

We zijn verheugd om de refit-functie voor getrainde parameters aan te kondigen, waarmee u eerder getrainde parameters kunt gebruiken en deze naar wens kunt aanpassen. In dit bericht laten we zien hoe u deze functie kunt gebruiken.

Overzicht van de Data Wrangler-refitfunctie

We illustreren hoe deze functie werkt met het volgende voorbeeld, voordat we ingaan op de details van de refit getrainde parameterfunctie.

Stel dat uw klantgegevensset een categorische functie heeft voor: country weergegeven als strings zoals Australia en Singapore. ML-algoritmen vereisen numerieke invoer; daarom moeten deze categorische waarden worden gecodeerd naar numerieke waarden. Het coderen van categorische gegevens is het proces van het creëren van een numerieke representatie voor categorieën. Als uw categorieland bijvoorbeeld waarden heeft Australia en Singapore, kunt u deze informatie in twee vectoren coderen: [1, 0] om weer te geven Australia en [0, 1] om te vertegenwoordigen Singapore. De hier gebruikte transformatie is one-hot codering en de nieuwe gecodeerde uitvoer weerspiegelt de getrainde parameters.

Na het trainen van het model kunnen uw klanten na verloop van tijd toenemen en heeft u meer onderscheidende waarden in de landenlijst. De nieuwe dataset kan een andere categorie bevatten, India, die geen deel uitmaakte van de oorspronkelijke dataset, wat de nauwkeurigheid van het model kan beïnvloeden. Daarom is het noodzakelijk om uw model opnieuw te trainen met de nieuwe gegevens die in de loop van de tijd zijn verzameld.

Om dit probleem op te lossen, moet u de codering vernieuwen om de nieuwe categorie op te nemen en de vectorrepresentatie bijwerken volgens uw laatste gegevensset. In ons voorbeeld moet de codering de nieuwe categorie weergeven voor de countryDit is India. Dit proces van het vernieuwen van een codering noemen we gewoonlijk een refit-operatie. Nadat u de refit-bewerking hebt uitgevoerd, krijgt u de nieuwe codering: Australia: [1, 0, 0], Singapore: [0, 1, 0], en India: [0, 0, 1]. Het opnieuw aanpassen van de one-hot-codering en het opnieuw trainen van het model op de nieuwe dataset resulteert in voorspellingen van betere kwaliteit.

De refit-getrainde parameterfunctie van Data Wrangler is nuttig in de volgende gevallen:

- Er worden nieuwe gegevens toegevoegd aan de dataset – Omscholing van het ML-model is nodig wanneer de dataset wordt verrijkt met nieuwe data. Om optimale resultaten te bereiken, moeten we de getrainde parameters aanpassen aan de nieuwe dataset.

- Training op een volledige dataset na het uitvoeren van feature engineering op voorbeelddata – Voor een grote dataset wordt een steekproef van de dataset overwogen voor het leren van getrainde parameters, die mogelijk niet uw volledige dataset vertegenwoordigen. We moeten de getrainde parameters op de volledige dataset opnieuw leren.

Hieronder volgen enkele van de meest voorkomende Data Wrangler-transformaties die op de dataset worden uitgevoerd en die profiteren van de optie voor getrainde refit-parameter:

Voor meer informatie over transformaties in Data Wrangler, zie: Transformeer gegevens.

In dit bericht laten we zien hoe deze getrainde parameters op datasets kunnen worden verwerkt met behulp van Data Wrangler. U kunt Data Wrangler-stromen in productietaken gebruiken om uw gegevens opnieuw te verwerken wanneer deze groeien en veranderen.

Overzicht oplossingen

Voor dit bericht laten we zien hoe u de refit-getrainde parameterfunctie van Data Wrangler kunt gebruiken met de openbaar beschikbare dataset op Kaggle: Amerikaanse huisvestingsgegevens van Zillow, te koop aangeboden woningen in de Verenigde Staten. Het heeft de huizenverkoopprijzen over verschillende geo-distributies van huizen.

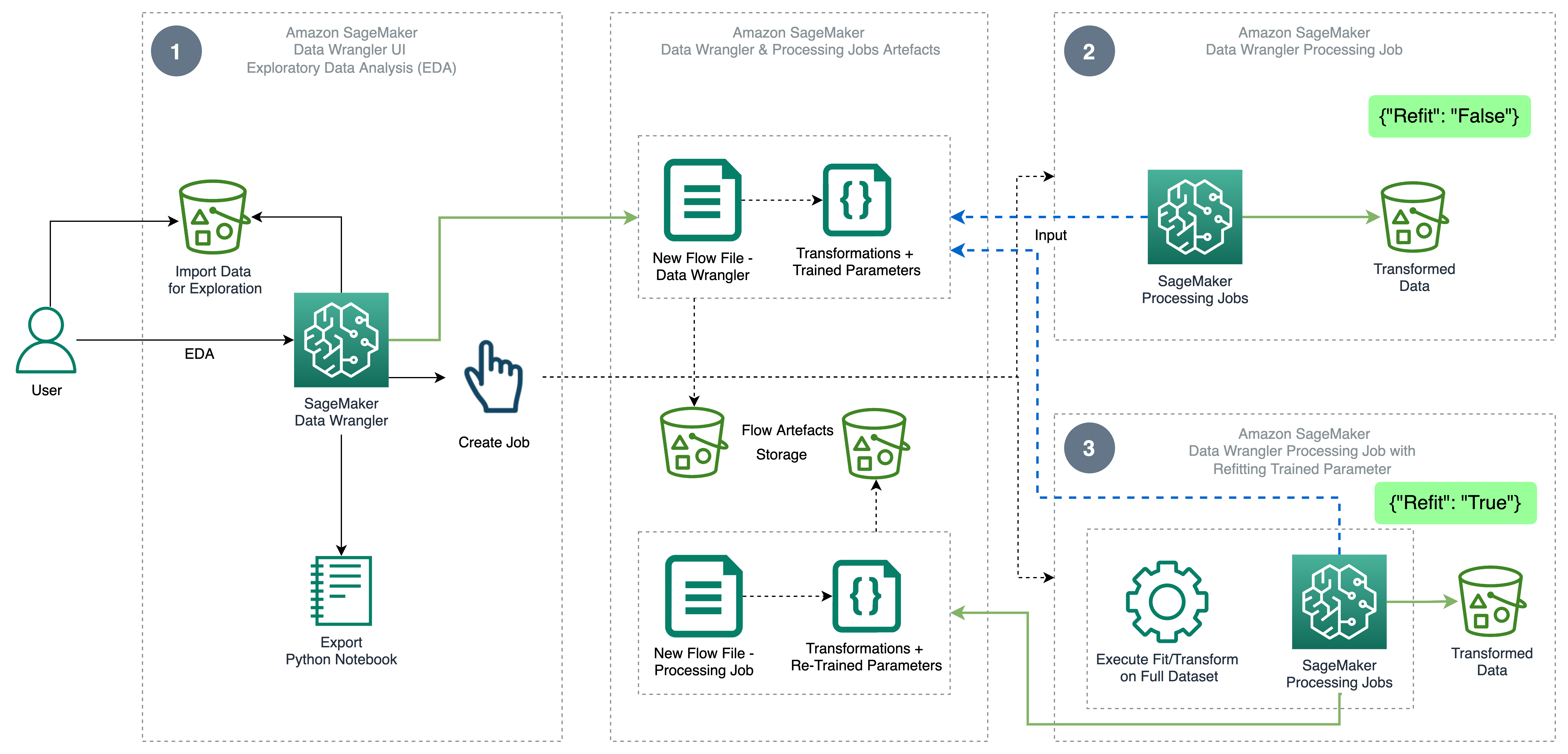

Het volgende diagram illustreert de architectuur op hoog niveau van Data Wrangler met behulp van de refit-getrainde parameterfunctie. We laten ook het effect op de datakwaliteit zien zonder de refit-getrainde parameter en contrasteren de resultaten aan het einde.

De workflow omvat de volgende stappen:

- Verkennende data-analyse uitvoeren – Maak een nieuwe stroom op Data Wrangler om de verkennende data-analyse (EDA) te starten. Importeer bedrijfsgegevens om uw gegevens te begrijpen, op te schonen, samen te voegen, te transformeren en voor te bereiden op training. Verwijzen naar Ontdek de mogelijkheden van Amazon SageMaker Data Wrangler met voorbeelddatasets voor meer informatie over het uitvoeren van EDA met Data Wrangler.

- Maak een gegevensverwerkingstaak aan – Deze stap exporteert alle transformaties die u op de gegevensset hebt gemaakt als een stroombestand dat is opgeslagen in het geconfigureerde Amazon eenvoudige opslagservice (Amazon S3) locatie. De gegevensverwerkingstaak met het door Data Wrangler gegenereerde stroombestand past de transformaties en getrainde parameters toe die zijn geleerd op uw dataset. Wanneer de gegevensverwerkingstaak is voltooid, worden de uitvoerbestanden geüpload naar de Amazon S3-locatie die is geconfigureerd in het bestemmingsknooppunt. Merk op dat de refit-optie standaard is uitgeschakeld. Als alternatief voor het direct uitvoeren van de verwerkingstaak, kunt u dat ook een verwerkingstaak plannen in een paar klikken met behulp van Data Wrangler – Create Job to run at specific times.

- Creëer een gegevensverwerkingstaak met de refit getrainde parameterfunctie – Selecteer de nieuwe refit-functie voor getrainde parameters tijdens het maken van de taak om het opnieuw leren van uw getrainde parameters op uw volledige of versterkte dataset af te dwingen. Volgens de Amazon S3-locatieconfiguratie voor het opslaan van het stroombestand, maakt of werkt de gegevensverwerkingstaak het nieuwe stroombestand bij. Als u dezelfde Amazon S3-locatie configureert als in stap 2, werkt de gegevensverwerkingstaak het in stap 2 gegenereerde stroombestand bij, dat kan worden gebruikt om uw stroom relevant te houden voor uw gegevens. Na voltooiing van de verwerkingstaak worden de uitvoerbestanden geüpload naar de geconfigureerde S3-bucket van het bestemmingsknooppunt. U kunt de bijgewerkte stroom op uw volledige dataset gebruiken voor een productieworkflow.

Voorwaarden

Voordat u aan de slag gaat, uploadt u de dataset naar een S3-bucket en importeert u deze vervolgens in Data Wrangler. Raadpleeg voor instructies: Gegevens importeren uit Amazon S3.

Laten we nu de stappen doorlopen die in het architectuurdiagram worden genoemd.

Voer EDA uit in Data Wrangler

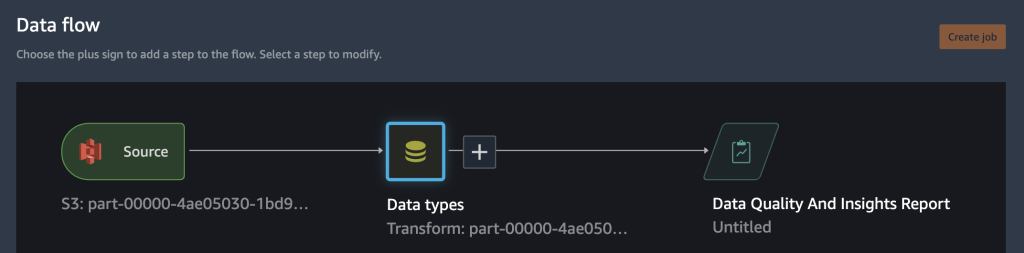

Stel de volgende analyse en transformatie in Data Wrangler in om de refit-getrainde parameterfunctie uit te proberen. Aan het einde van het instellen van EDA maakt Data Wrangler een stroombestand dat is vastgelegd met getrainde parameters uit de dataset.

- Maak een nieuwe stroom in Amazon SageMaker Data Wrangler voor verkennende gegevensanalyse.

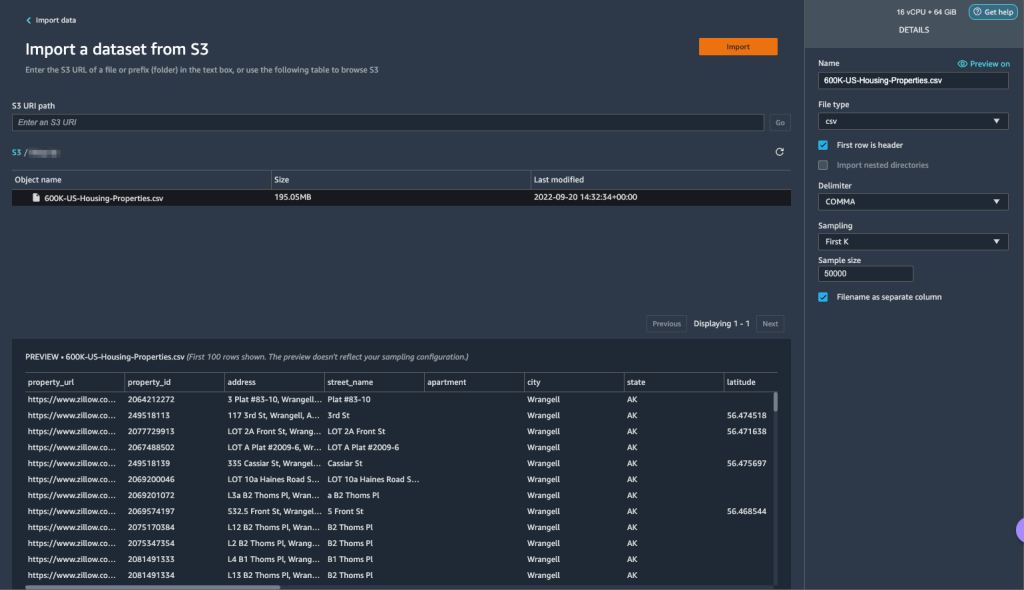

- Importeer de bedrijfsgegevens die je hebt geüpload naar Amazon S3.

- U kunt een voorbeeld van de gegevens en opties bekijken voor het kiezen van het bestandstype, scheidingsteken, steekproeven, enzovoort. Voor dit voorbeeld gebruiken we de Eerste K samplingoptie geleverd door Data Wrangler om de eerste 50,000 records uit de dataset te importeren.

- Kies import.

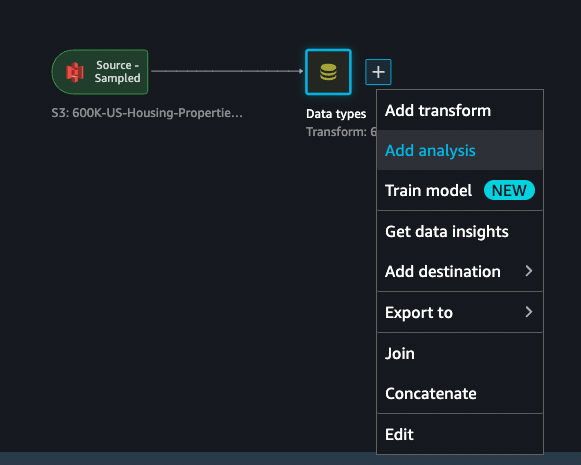

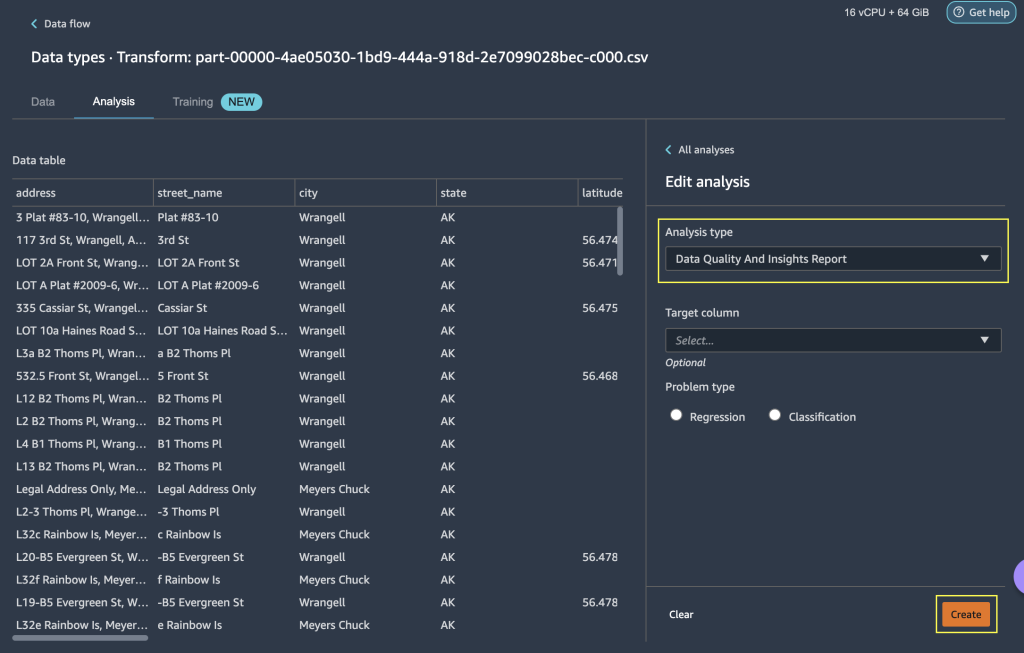

- Nadat u de door Data Wrangler toegepaste gegevenstypeovereenkomst hebt uitgecheckt, voegt u een nieuwe analyse toe.

- Voor Type analyse, kiezen Rapport Gegevenskwaliteit en inzichten.

- Kies creëren.

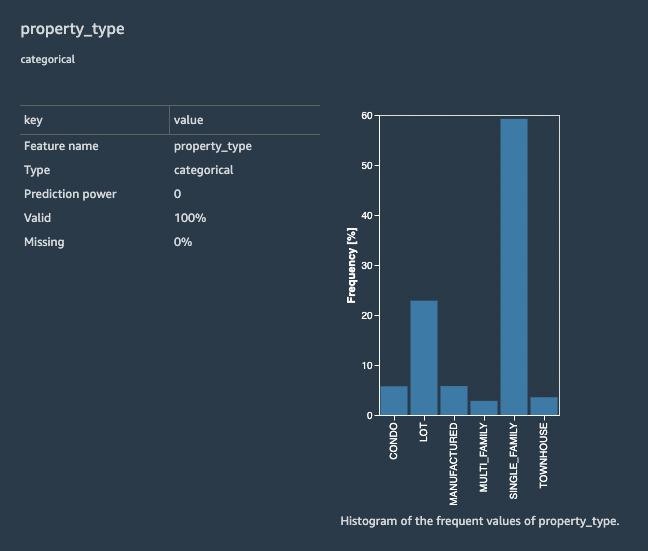

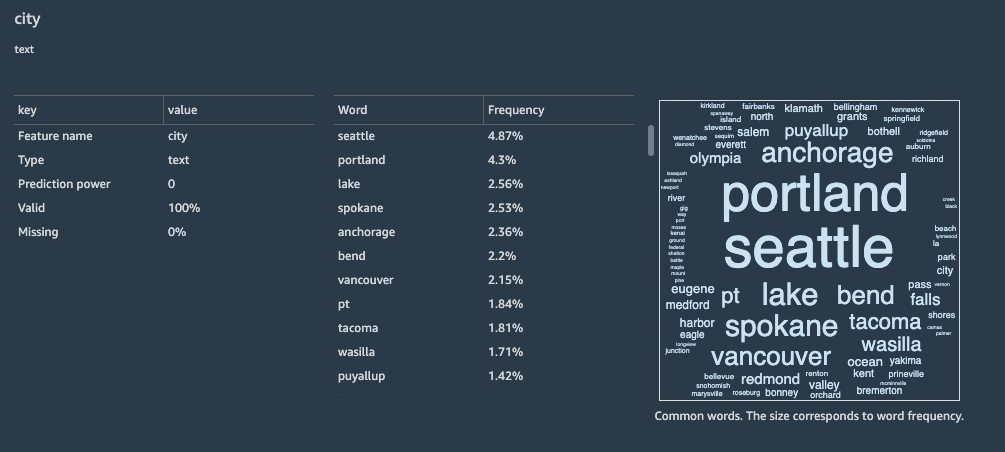

Met het Data Quality and Insights Report krijgt u een korte samenvatting van de dataset met algemene informatie zoals ontbrekende waarden, ongeldige waarden, featuretypes, uitschieters en meer. U kunt functies kiezen property_type en city voor het toepassen van transformaties op de dataset om de refit-getrainde parameterfunctie te begrijpen.

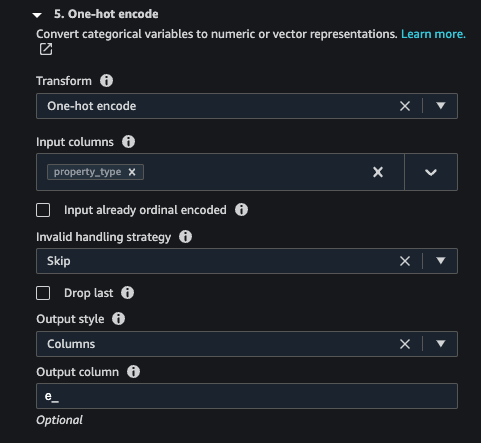

Laten we ons concentreren op de functie property_type uit de dataset. In het rapport Feature Details sectie, kunt u de property_type, wat een categorische functie is, en zes unieke waarden die zijn afgeleid van de 50,000 gesamplede dataset door Data Wrangler. De volledige dataset heeft mogelijk meer categorieën voor de functie property_type. Voor een functie met veel unieke waarden geeft u misschien de voorkeur aan ordinale codering. Als de functie een paar unieke waarden heeft, kan een one-hot coderingsbenadering worden gebruikt. Voor dit voorbeeld kiezen we voor one-hot encoding aan property_type.

Zo ook voor de city functie, een tekstgegevenstype met een groot aantal unieke waarden, laten we ordinale codering op deze functie toepassen.

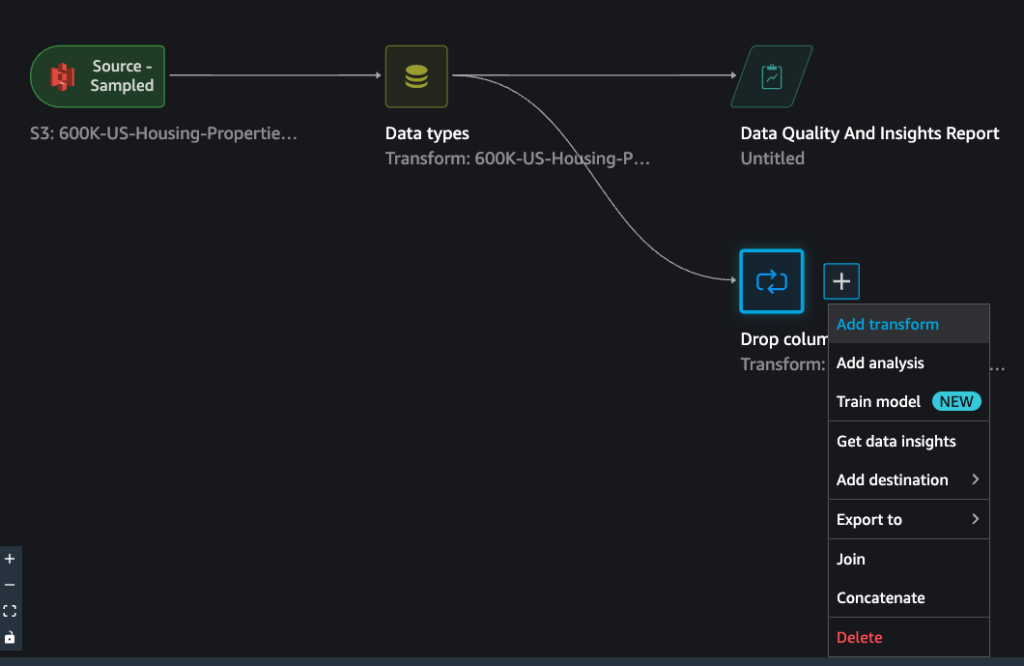

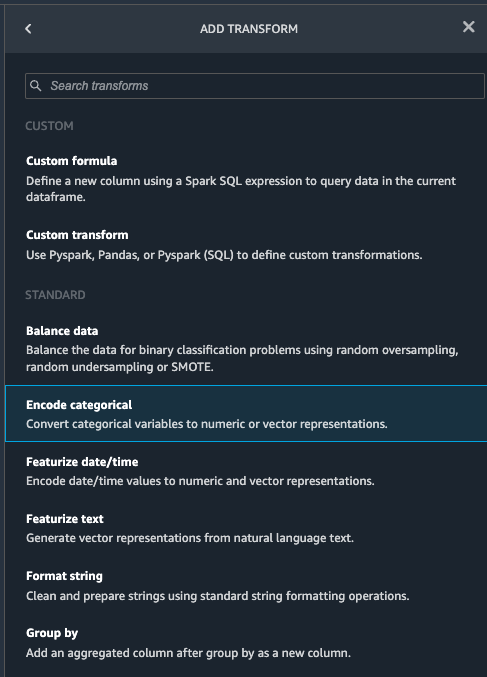

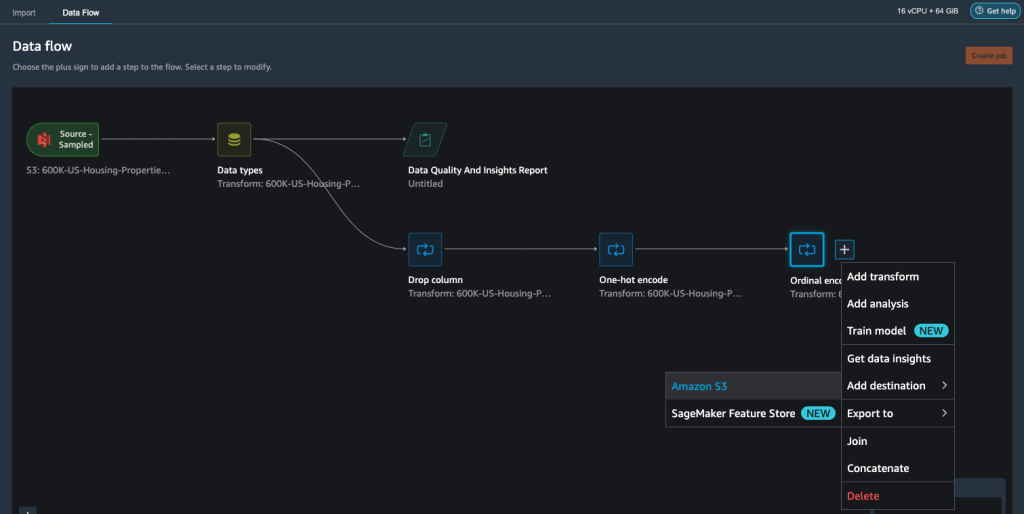

- Navigeer naar de Data Wrangler-stroom, kies het plusteken en kies Voeg transformatie toe.

- Kies de Codeer categorisch optie voor het transformeren van categorische kenmerken.

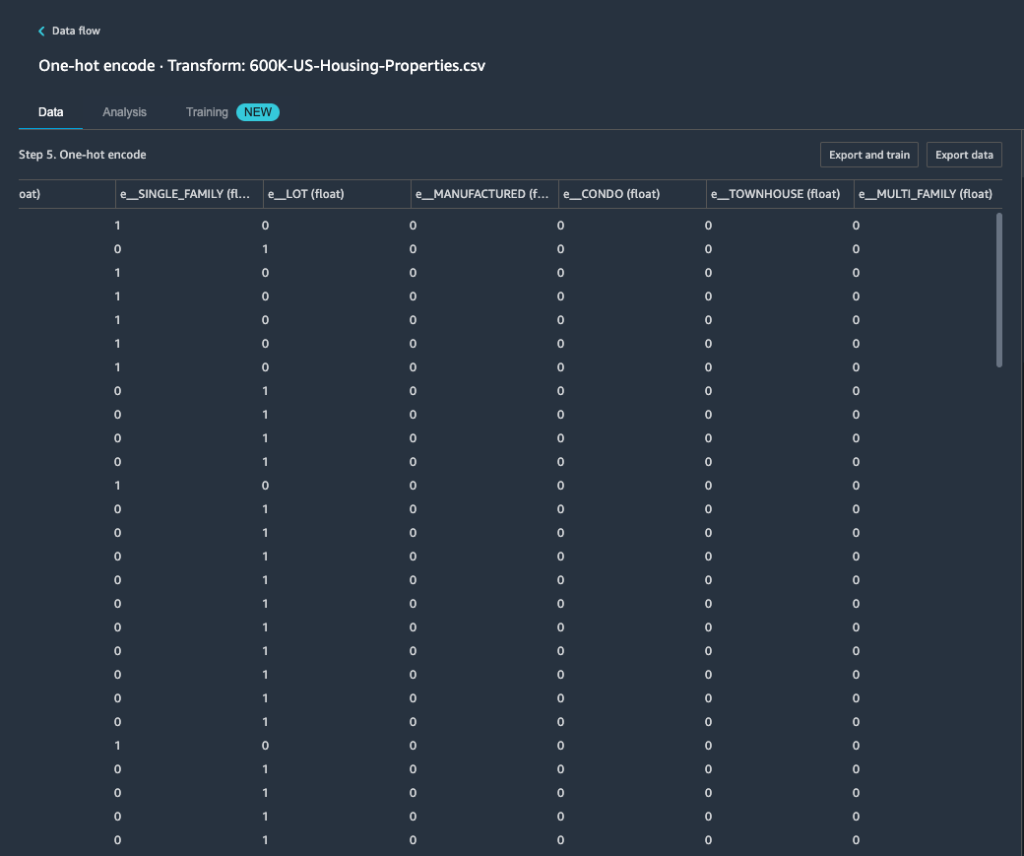

Uit het Data Quality and Insights Report, feature property_type toont zes unieke categorieën: CONDO, LOT, MANUFACTURED, SINGLE_FAMILY, MULTI_FAMILY en TOWNHOUSE.

- Voor Transformeren, kiezen One-hot coderen.

Na het toepassen van one-hot codering op functie property_type, kunt u een voorbeeld van alle zes categorieën bekijken als afzonderlijke functies die zijn toegevoegd als nieuwe kolommen. Houd er rekening mee dat er 50,000 records uit uw dataset zijn gesampled om dit voorbeeld te genereren. Tijdens het uitvoeren van een Data Wrangler-verwerkingstaak met deze stroom, worden deze transformaties toegepast op uw volledige gegevensset.

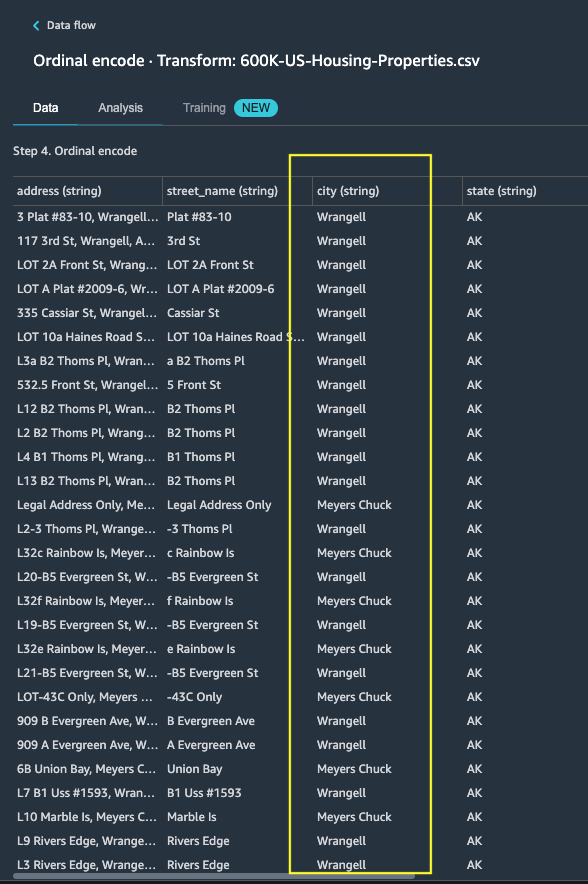

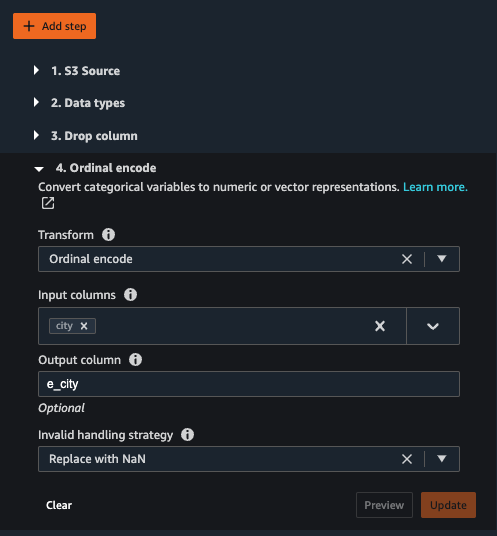

- Voeg een nieuwe transformatie toe en kies Codeer categorisch om een transformatie toe te passen op het object

city, die een groter aantal unieke categorische tekstwaarden heeft. - Om dit kenmerk in een numerieke weergave te coderen, kiest u Ordinale codering For Transformeren.

- Kies Preview op deze transformatie.

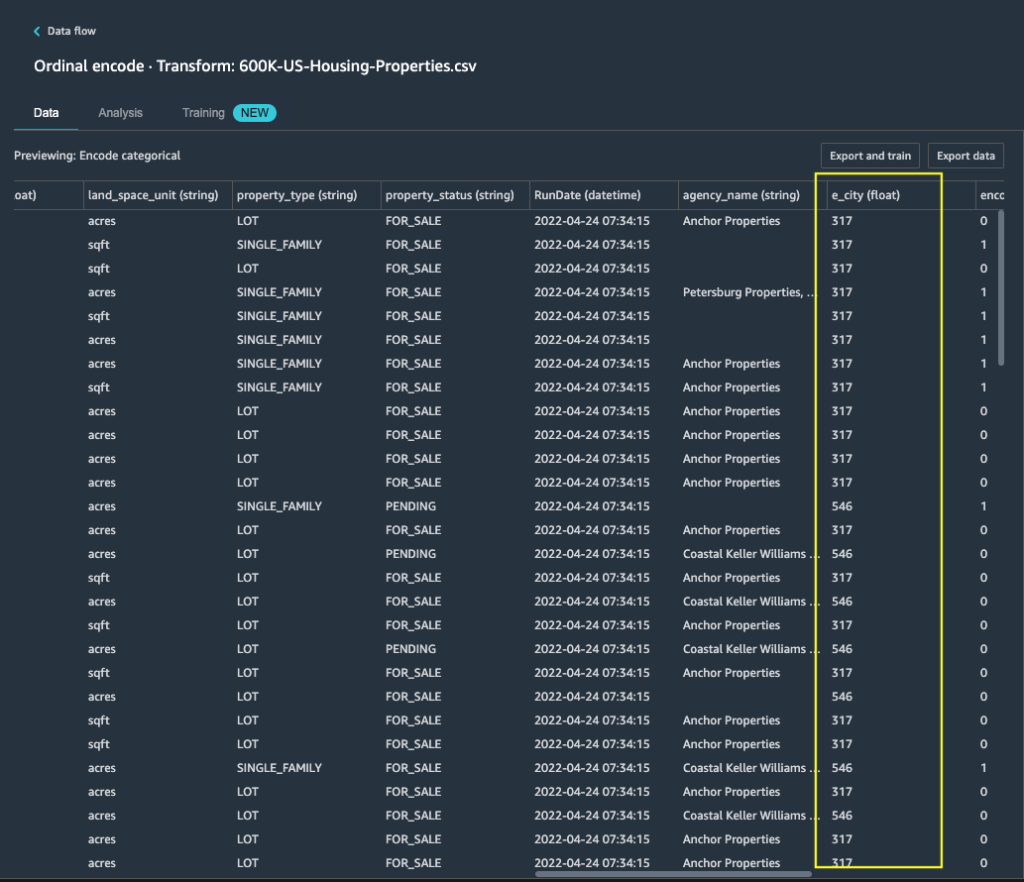

Je kunt zien dat de categorische functie city wordt toegewezen aan ordinale waarden in de uitvoerkolom e_city.

- Voeg deze stap toe door te kiezen voor bijwerken.

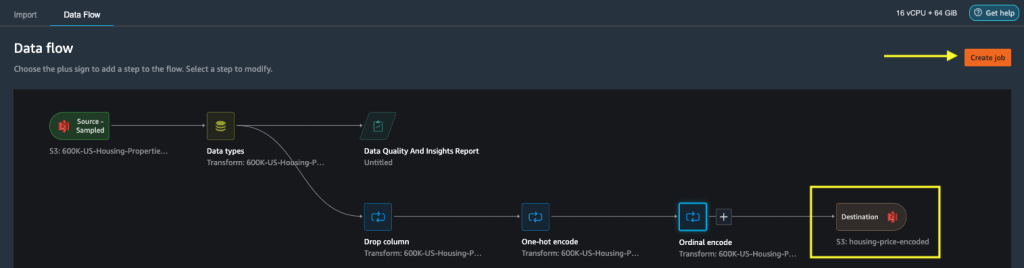

- U kunt de bestemming instellen op Amazon S3 om de toegepaste transformaties op de dataset op te slaan om de uitvoer als CSV-bestand te genereren.

Data Wrangler slaat de workflow op die u in de gebruikersinterface hebt gedefinieerd als een stroombestand en uploadt naar de Amazon S3-locatie van de geconfigureerde gegevensverwerkingstaak. Dit stroombestand wordt gebruikt wanneer u Data Wrangler-verwerkingstaken maakt om de transformaties toe te passen op grotere gegevenssets of om nieuwe versterkingsgegevens te transformeren om het model opnieuw te trainen.

Start een Data Wrangler-gegevensverwerkingstaak zonder refit ingeschakeld

Nu kunt u zien hoe de refit-optie getrainde parameters gebruikt voor nieuwe datasets. Voor deze demonstratie definiëren we twee Data Wrangler-verwerkingstaken die op dezelfde gegevens werken. De eerste verwerkingstaak zal refit niet inschakelen; voor de tweede bewerking gebruiken we refit. Aan het eind vergelijken we de effecten.

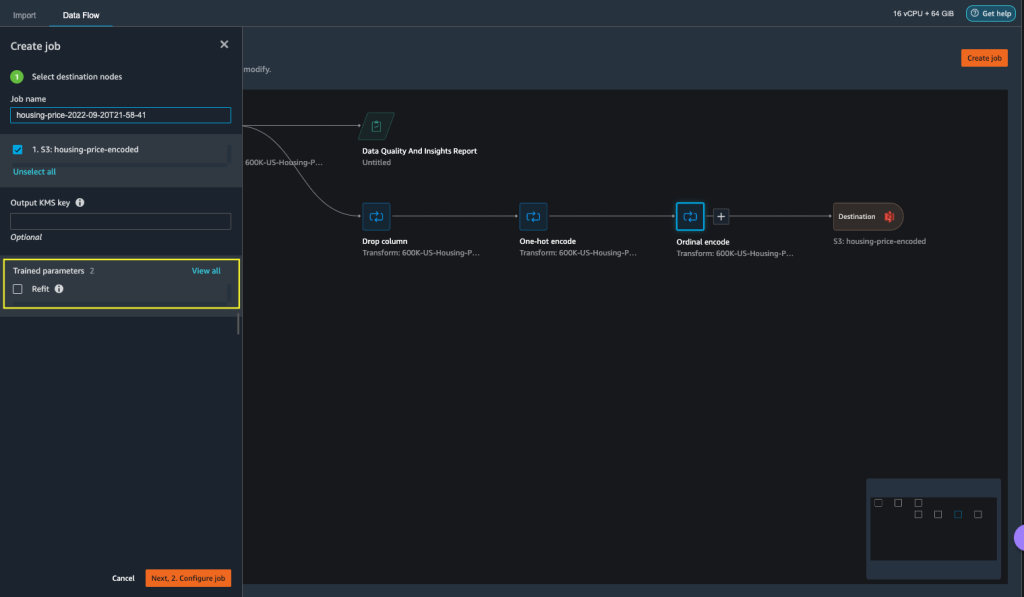

- Kies Baan creëren om een gegevensverwerkingstaak te starten met Data Wrangler.

- Voor Taaknaam, voer een naam in.

- Onder Getrainde parameters, niet selecteren herstel.

- Kies Taak configureren.

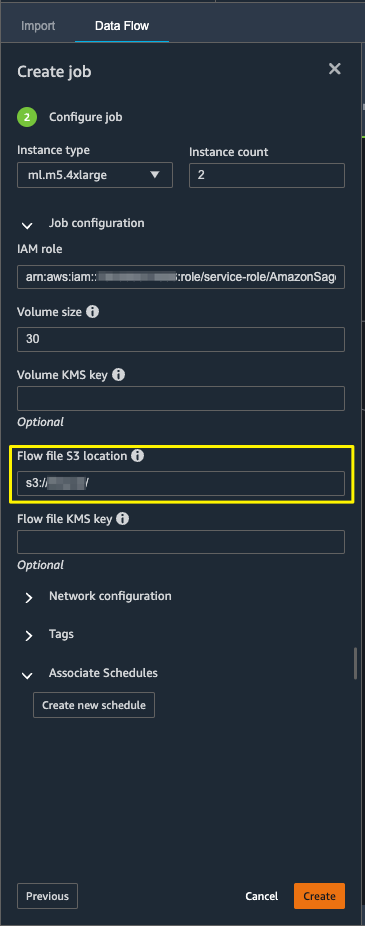

- Configureer de taakparameters zoals instantietypes, volumegrootte en Amazon S3-locatie voor het opslaan van het uitvoerstroombestand.

- Data Wrangler maakt een stroombestand op de locatie van stroombestand S3. De stroom gebruikt transformaties om parameters te trainen en later gebruiken we de refit-optie om deze parameters opnieuw te trainen.

- Kies creëren.

Wacht tot de gegevensverwerkingstaak is voltooid om de getransformeerde gegevens te zien in de S3-bucket die is geconfigureerd in het doelknooppunt.

Start een Data Wrangler-gegevensverwerkingstaak met refit ingeschakeld

Laten we een andere verwerkingstaak maken die is ingeschakeld met de refit getrainde parameterfunctie ingeschakeld. Deze optie dwingt de opnieuw geleerde getrainde parameters af op de volledige dataset. Wanneer deze gegevensverwerkingstaak is voltooid, wordt een stroombestand gemaakt of bijgewerkt naar de geconfigureerde Amazon S3-locatie.

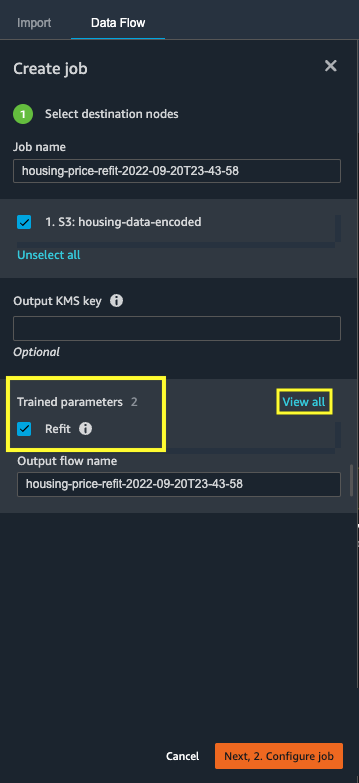

- Kies Baan creëren.

- Voor Taaknaam, voer een naam in.

- Voor Getrainde parametersselecteer herstel.

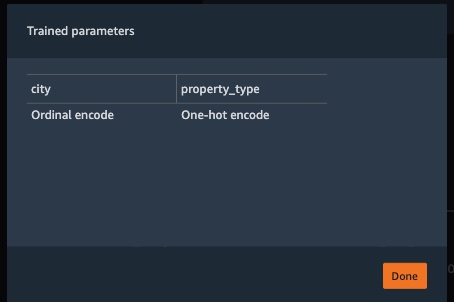

- Als u kiest Bekijk alles, kunt u alle getrainde parameters bekijken.

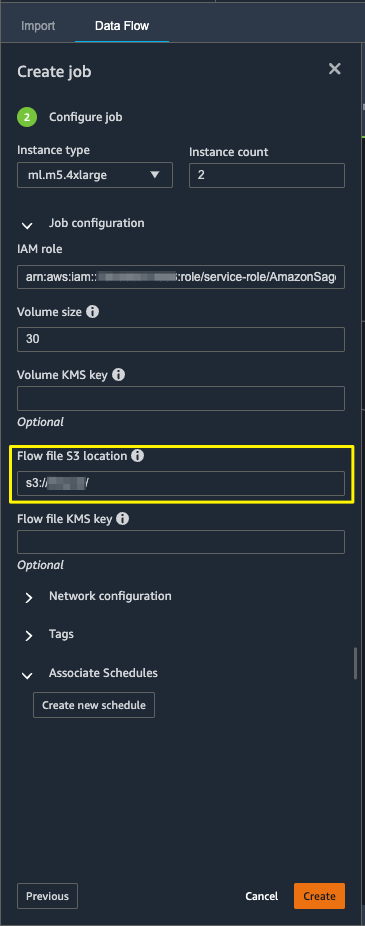

- Kies Taak configureren.

- Voer de locatie van het Amazon S3-stroombestand in.

- Kies creëren.

Wacht tot de gegevensverwerkingstaak is voltooid.

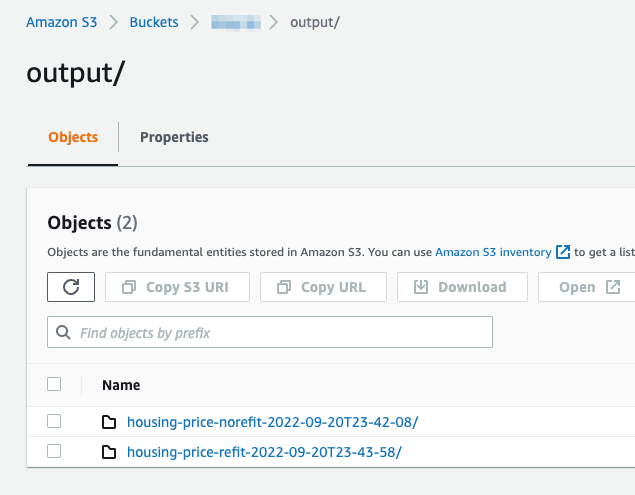

Raadpleeg de geconfigureerde S3-bucket in het bestemmingsknooppunt om de gegevens te bekijken die zijn gegenereerd door de gegevensverwerkingstaak die de gedefinieerde transformaties uitvoert.

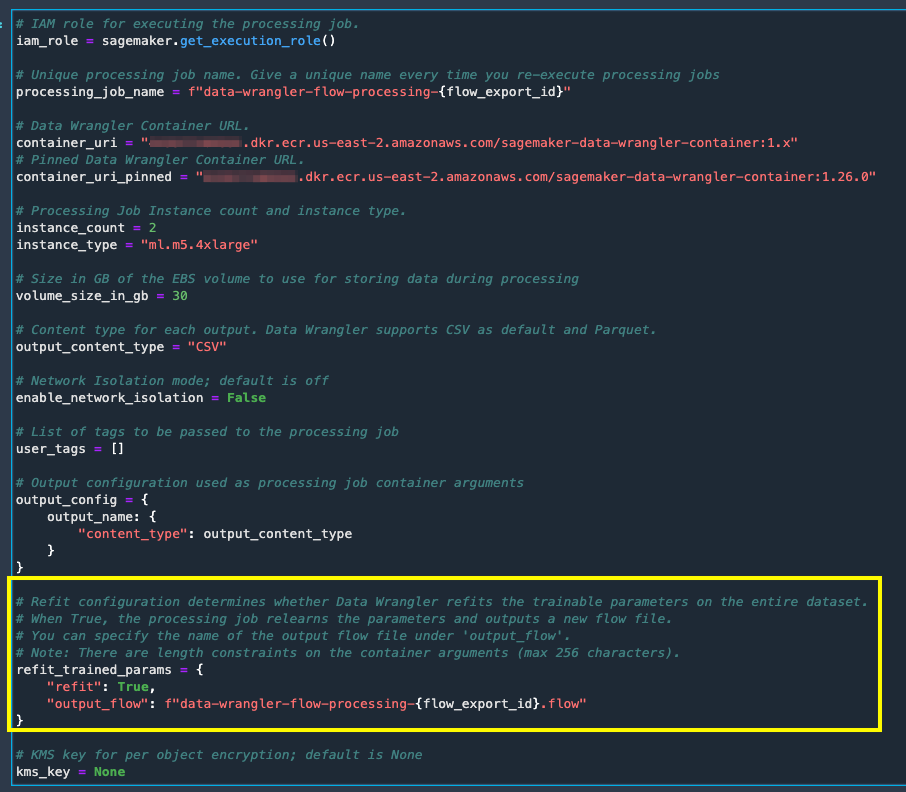

Exporteren naar Python-code voor het uitvoeren van Data Wrangler-verwerkingstaken

Als alternatief voor het starten van de verwerkingstaken met de optie Taak maken in Data Wrangler, kunt u de gegevensverwerkingstaken activeren door de Data Wrangler-stroom naar een Jupyter-notebook te exporteren. Data Wrangler genereert een Jupyter-notebook met invoer, uitvoer, verwerkingstaakconfiguraties en code voor taakstatuscontroles. U kunt de parameters wijzigen of bijwerken volgens uw vereisten voor gegevenstransformatie.

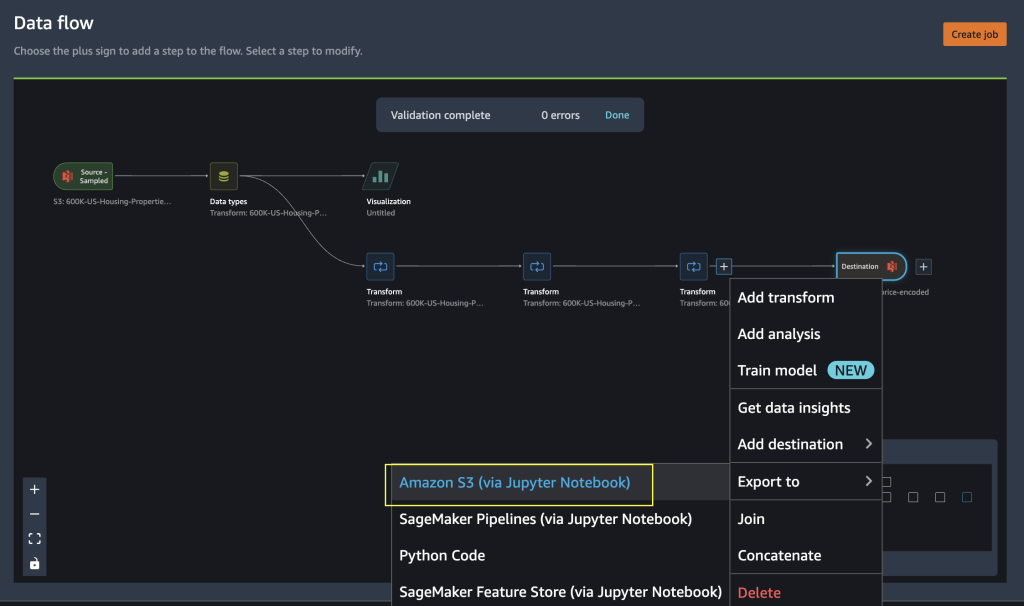

- Kies het plusteken naast de finale Transformeren knooppunt.

- Kies Exporteren tot en Amazon S3 (via Jupyter-notebook).

U ziet een Jupyter-notebook geopend met invoer, uitvoer, verwerkingstaakconfiguraties en code voor taakstatuscontroles.

- Om de refit getrainde parameters optie via code af te dwingen, stelt u de

refitparameterTrue.

Vergelijk de resultaten van gegevensverwerkingstaken

Vergelijk de resultaten van gegevensverwerkingstaken

Nadat de Data Wrangler-verwerkingstaken zijn voltooid, moet u twee nieuwe Data Wrangler-stromen maken met de uitvoer die wordt gegenereerd door de gegevensverwerkingstaken die zijn opgeslagen in de geconfigureerde Amazon S3-bestemming.

U kunt de geconfigureerde locatie in de bestemmingsmap van Amazon S3 raadplegen om de uitvoer van de gegevensverwerkingstaken te bekijken.

Om de resultaten van de verwerkingstaak te inspecteren, maakt u twee nieuwe Data Wrangler-stromen met behulp van het Data Quality and Insights Report om de transformatieresultaten te vergelijken.

- Maak een nieuwe stroom in Amazon SageMaker Data Wrangler.

- Importeer de gegevensverwerkingstaak zonder refit-enabled uitvoerbestand van Amazon S3.

- Voeg een nieuwe analyse toe.

- Voor Type analyse, kiezen Rapport Gegevenskwaliteit en inzichten.

- Kies creëren.

Herhaal de bovenstaande stappen en maak een nieuwe data wrangler-stroom om de uitvoer van de gegevensverwerkingstaak te analyseren terwijl refit is ingeschakeld.

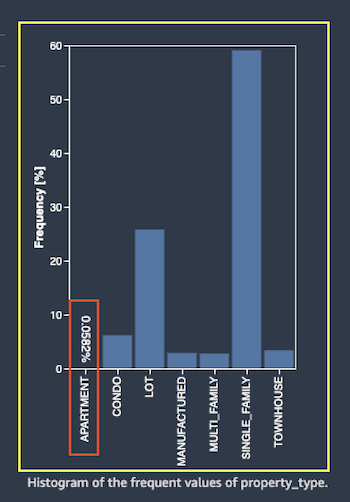

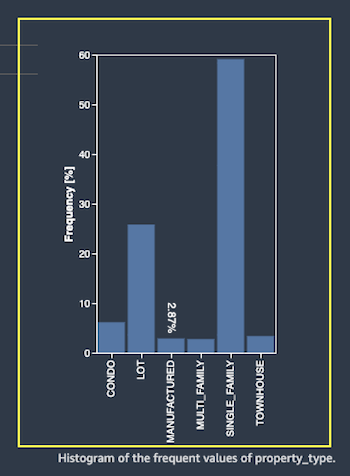

Laten we nu eens kijken naar de uitvoer van verwerkingstaken voor de functie property_type met behulp van de rapporten over gegevenskwaliteit en inzichten. Scrol naar de functiedetails in de lijst Gegevens- en inzichtenrapporten feature_type.

De refit getrainde parameterverwerkingstaak heeft de getrainde parameters op de gehele dataset opnieuw aangepast en de nieuwe waarde gecodeerd APARTMENT met zeven verschillende waarden op de volledige dataset.

De normale verwerkingstaak paste de getrainde parameters van de voorbeelddataset toe, die slechts zes verschillende waarden hebben voor de property_type voorzien zijn van. Voor gegevens met feature_type APARTMENT ongeldige behandelingsstrategie Overslaan wordt toegepast en de gegevensverwerkingstaak leert deze nieuwe categorie niet. De one-hot codering heeft deze nieuwe categorie overgeslagen die aanwezig is op de nieuwe gegevens, en de codering slaat de categorie over APARTMENT.

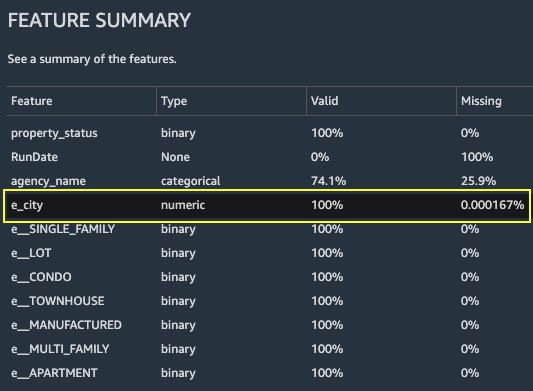

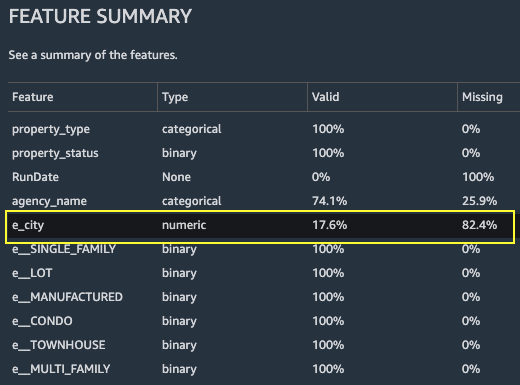

Laten we ons nu concentreren op een andere functie, city. De door refit getrainde parameterverwerkingstaak heeft alle beschikbare waarden opnieuw geleerd voor de city functie, gezien de nieuwe gegevens.

Zoals getoond in de Functieoverzicht sectie van het rapport, de nieuwe gecodeerde functiekolom e_city heeft 100% geldige parameters door gebruik te maken van de refit getrainde parameterfunctie.

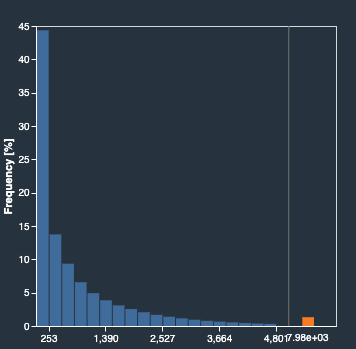

Daarentegen heeft de normale verwerkingstaak 82.4% ontbrekende waarden in de nieuwe gecodeerde functiekolom e_city. Dit fenomeen is omdat alleen de voorbeeldset van aangeleerde getrainde parameters wordt toegepast op de volledige dataset en er geen aanpassing wordt toegepast door de gegevensverwerkingstaak.

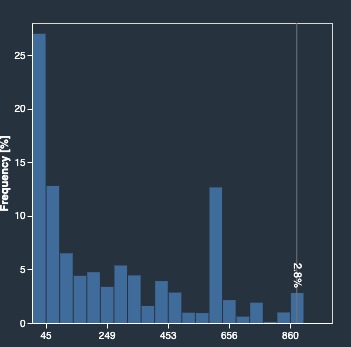

De volgende histogrammen geven de ordinale gecodeerde eigenschap weer e_city. Het eerste histogram is van het kenmerk dat is getransformeerd met de refit-optie.

Het volgende histogram is van het getransformeerde kenmerk zonder de refit-optie. De oranje kolom toont ontbrekende waarden (NaN) in het rapport Gegevenskwaliteit en inzichten. De nieuwe waarden die niet uit de voorbeelddataset worden geleerd, worden vervangen als Not a Number (NaN) zoals geconfigureerd in de Data Wrangler UI's ongeldige behandelingsstrategie.

De gegevensverwerkingstaak met de refit-getrainde parameter heeft de opnieuw geleerd property_type en city functies rekening houdend met de nieuwe waarden van de gehele dataset. Zonder de refit-getrainde parameter gebruikt de gegevensverwerkingstaak alleen de vooraf aangeleerde getrainde parameters van de bemonsterde dataset. Vervolgens worden ze toegepast op de nieuwe gegevens, maar de nieuwe waarden worden niet in aanmerking genomen voor codering. Dit heeft gevolgen voor de nauwkeurigheid van het model.

Opruimen

Als u Data Wrangler niet gebruikt, is het belangrijk om de instantie waarop het wordt uitgevoerd af te sluiten om extra kosten te voorkomen.

Sla uw gegevensstroom op voordat u Data Wrangler afsluit om te voorkomen dat u werk verliest.

- Om uw gegevensstroom op te slaan in Amazon SageMaker Studio, kiezen Dien in, kies dan Gegevens Wrangler-stroom opslaan. Data Wrangler slaat uw gegevensstroom automatisch elke 60 seconden op.

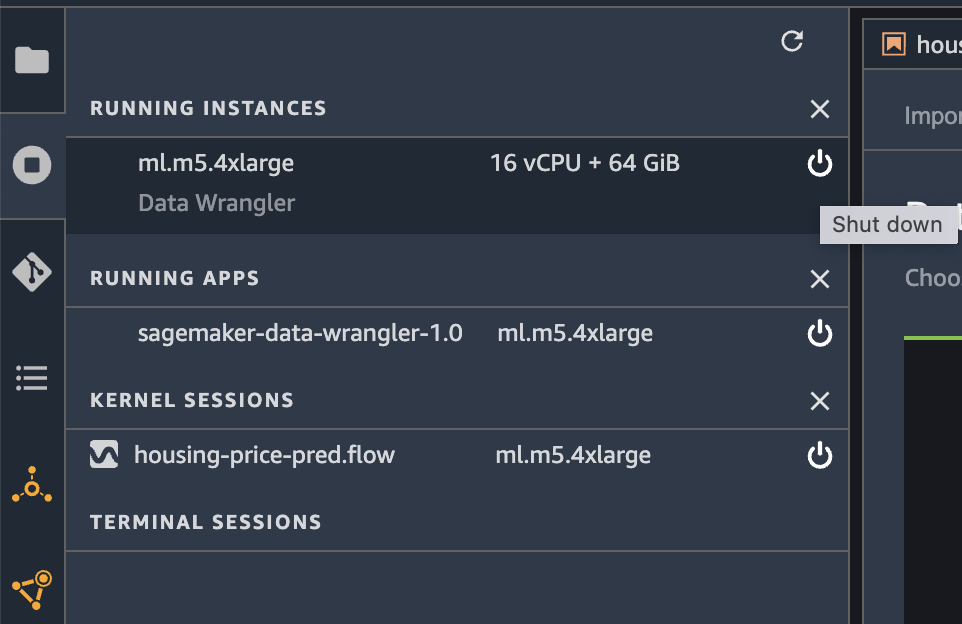

- Om de Data Wrangler-instantie af te sluiten, kiest u in Studio: Instanties en kernels uitvoeren.

- Onder ACTIEVE APPS, kies het afsluitpictogram naast de app sagemaker-data-wrangler-1.0.

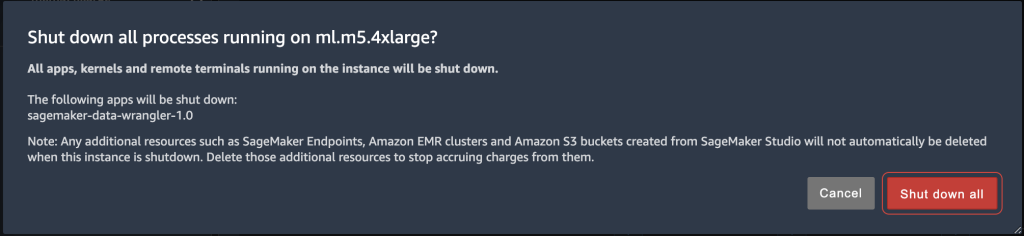

- Kies Alles afsluiten bevestigen.

Data Wrangler draait op een ml.m5.4xlarge instantie. Deze instantie verdwijnt uit LOPENDE INSTANTIES wanneer u de Data Wrangler-app afsluit.

Nadat u de Data Wrangler-app hebt afgesloten, moet deze opnieuw worden opgestart de volgende keer dat u een Data Wrangler-stroombestand opent. Dit kan enkele minuten duren.

Conclusie

In dit bericht hebben we een overzicht gegeven van de refit-getrainde parameterfunctie in Data Wrangler. Met deze nieuwe functie kunt u de getrainde parameters opslaan in de Data Wrangler-stroom, en de gegevensverwerkingstaken gebruiken de getrainde parameters om de geleerde transformaties toe te passen op grote datasets of versterkingsdatasets. U kunt deze optie toepassen op het vectoriseren van tekstkenmerken, numerieke gegevens en het afhandelen van uitschieters.

Het behouden van getrainde parameters tijdens de gegevensverwerking van de ML-levenscyclus vereenvoudigt en vermindert de gegevensverwerkingsstappen, ondersteunt robuuste functie-engineering en ondersteunt modeltraining en versterkingstraining op nieuwe gegevens.

We raden u aan om deze nieuwe functie uit te proberen voor uw gegevensverwerkingsvereisten.

Over de auteurs

Hariharan Suresh is Senior Solutions Architect bij AWS. Hij is gepassioneerd door databases, machine learning en het ontwerpen van innovatieve oplossingen. Voordat hij bij AWS kwam, was Hariharan productarchitect, core banking-implementatiespecialist en ontwikkelaar, en werkte hij meer dan 11 jaar met BFSI-organisaties. Buiten de technologie houdt hij van paragliden en fietsen.

Hariharan Suresh is Senior Solutions Architect bij AWS. Hij is gepassioneerd door databases, machine learning en het ontwerpen van innovatieve oplossingen. Voordat hij bij AWS kwam, was Hariharan productarchitect, core banking-implementatiespecialist en ontwikkelaar, en werkte hij meer dan 11 jaar met BFSI-organisaties. Buiten de technologie houdt hij van paragliden en fietsen.

Santosh Kulkarni is een Enterprise Solutions Architect bij Amazon Web Services die werkt met sportklanten in Australië. Hij is gepassioneerd door het bouwen van grootschalige gedistribueerde applicaties om zakelijke problemen op te lossen met behulp van zijn kennis van AI/ML, big data en softwareontwikkeling.

Santosh Kulkarni is een Enterprise Solutions Architect bij Amazon Web Services die werkt met sportklanten in Australië. Hij is gepassioneerd door het bouwen van grootschalige gedistribueerde applicaties om zakelijke problemen op te lossen met behulp van zijn kennis van AI/ML, big data en softwareontwikkeling.

Vishaal Kapoor is een Senior Applied Scientist bij AWS AI. Hij is gepassioneerd om klanten te helpen hun gegevens in Data Wrangler te begrijpen. In zijn vrije tijd mountainbiket, snowboardt hij en brengt hij tijd door met zijn gezin.

Vishaal Kapoor is een Senior Applied Scientist bij AWS AI. Hij is gepassioneerd om klanten te helpen hun gegevens in Data Wrangler te begrijpen. In zijn vrije tijd mountainbiket, snowboardt hij en brengt hij tijd door met zijn gezin.

Aniketh Manjunath is een Software Development Engineer bij Amazon SageMaker. Hij ondersteunt Amazon SageMaker Data Wrangler en heeft een passie voor gedistribueerde machine learning-systemen. Buiten zijn werk houdt hij van wandelen, films kijken en cricket spelen.

Aniketh Manjunath is een Software Development Engineer bij Amazon SageMaker. Hij ondersteunt Amazon SageMaker Data Wrangler en heeft een passie voor gedistribueerde machine learning-systemen. Buiten zijn werk houdt hij van wandelen, films kijken en cricket spelen.

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- Amazon Sage Maker

- Amazon SageMaker-gegevens Wrangler

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- AWS-machine learning

- blockchain

- blockchain conferentie ai

- vindingrijk

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- google ai

- Intermediair (200)

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- syntaxis

- zephyrnet