generatieve AI Modellen hebben het potentieel om de bedrijfsactiviteiten radicaal te veranderen, maar bedrijven moeten zorgvuldig overwegen hoe ze hun macht kunnen benutten en tegelijkertijd uitdagingen kunnen overwinnen, zoals het beschermen van gegevens en het waarborgen van de kwaliteit van door AI gegenereerde inhoud.

Het Retrieval-Augmented Generation (RAG)-framework breidt aanwijzingen uit met externe gegevens uit meerdere bronnen, zoals documentopslagplaatsen, databases of API's, om basismodellen effectief te maken voor domeinspecifieke taken. Dit bericht presenteert de mogelijkheden van het RAG-model en benadrukt het transformatieve potentieel van MongoDB Atlas met zijn Vector Search-functie.

MongoDB-atlas is een geïntegreerde suite van datadiensten die de ontwikkeling van datagestuurde applicaties versnellen en vereenvoudigen. De vectorgegevensopslag kan naadloos worden geïntegreerd met operationele gegevensopslag, waardoor er geen aparte database meer nodig is. Deze integratie maakt krachtige semantische zoekmogelijkheden mogelijk Vector zoeken, een snelle manier om semantische zoek- en AI-aangedreven applicaties te bouwen.

Amazon Sage Maker stelt bedrijven in staat machine learning (ML)-modellen te bouwen, trainen en implementeren. Amazon SageMaker JumpStart biedt vooraf getrainde modellen en gegevens om u te helpen aan de slag te gaan met ML. U kunt vooraf getrainde modellen en gegevens openen, aanpassen en implementeren via de startpagina van SageMaker JumpStart in Amazon SageMaker Studio met slechts een paar klikken.

Amazon-Lex is een conversatie-interface waarmee bedrijven chatbots en stembots kunnen maken die natuurlijke, levensechte interacties aangaan. Door Amazon Lex te integreren met generatieve AI kunnen bedrijven een holistisch ecosysteem creëren waarin gebruikersinvoer naadloos overgaat in samenhangende en contextueel relevante antwoorden.

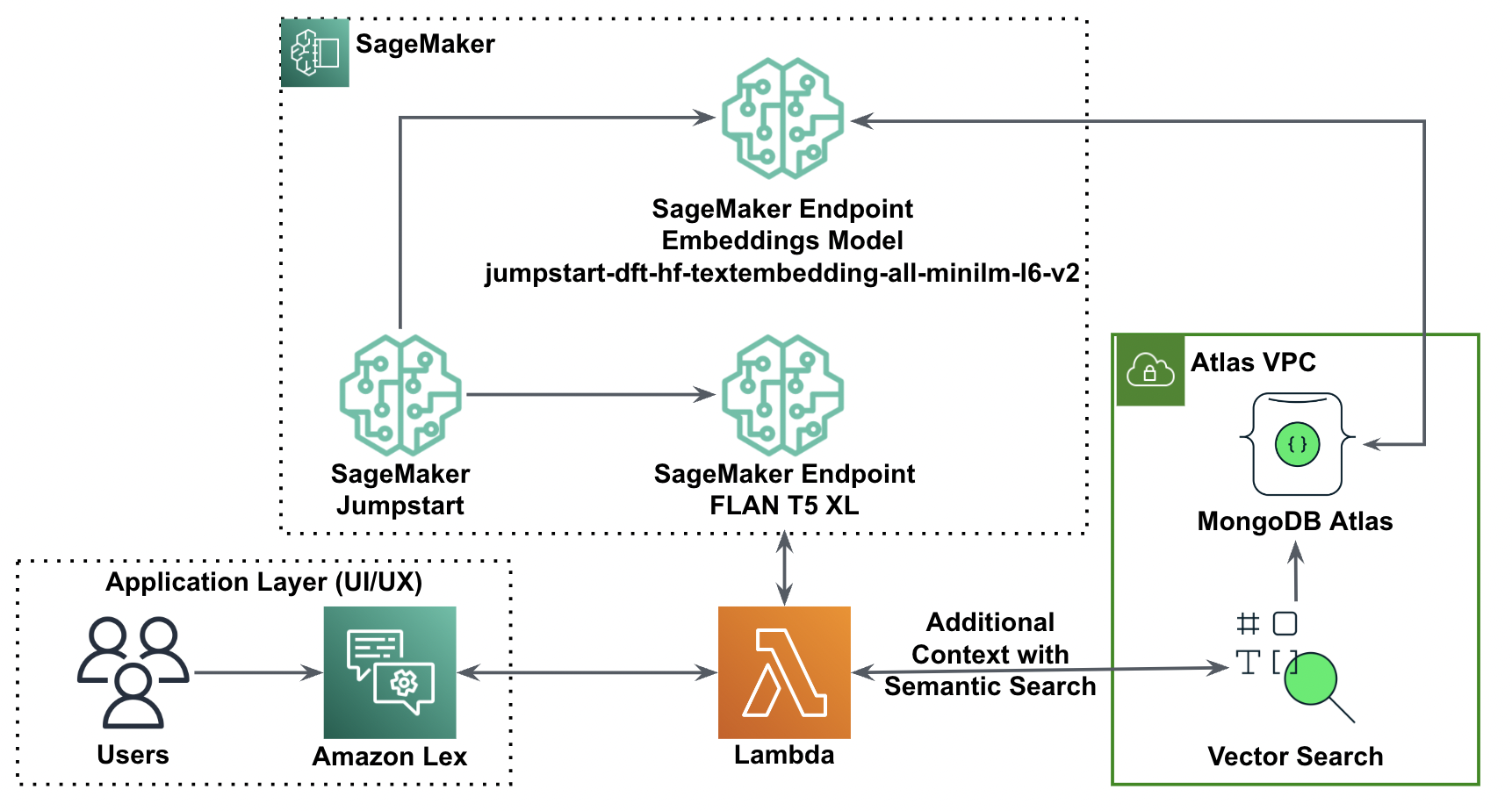

Overzicht oplossingen

Het volgende diagram illustreert de oplossingsarchitectuur.

In de volgende secties doorlopen we de stappen om deze oplossing en de componenten ervan te implementeren.

Stel een MongoDB-cluster in

Volg de instructies in om een gratis laag MongoDB Atlas-cluster te maken Maak een cluster. Stel de database in toegang en netwerk toegang.

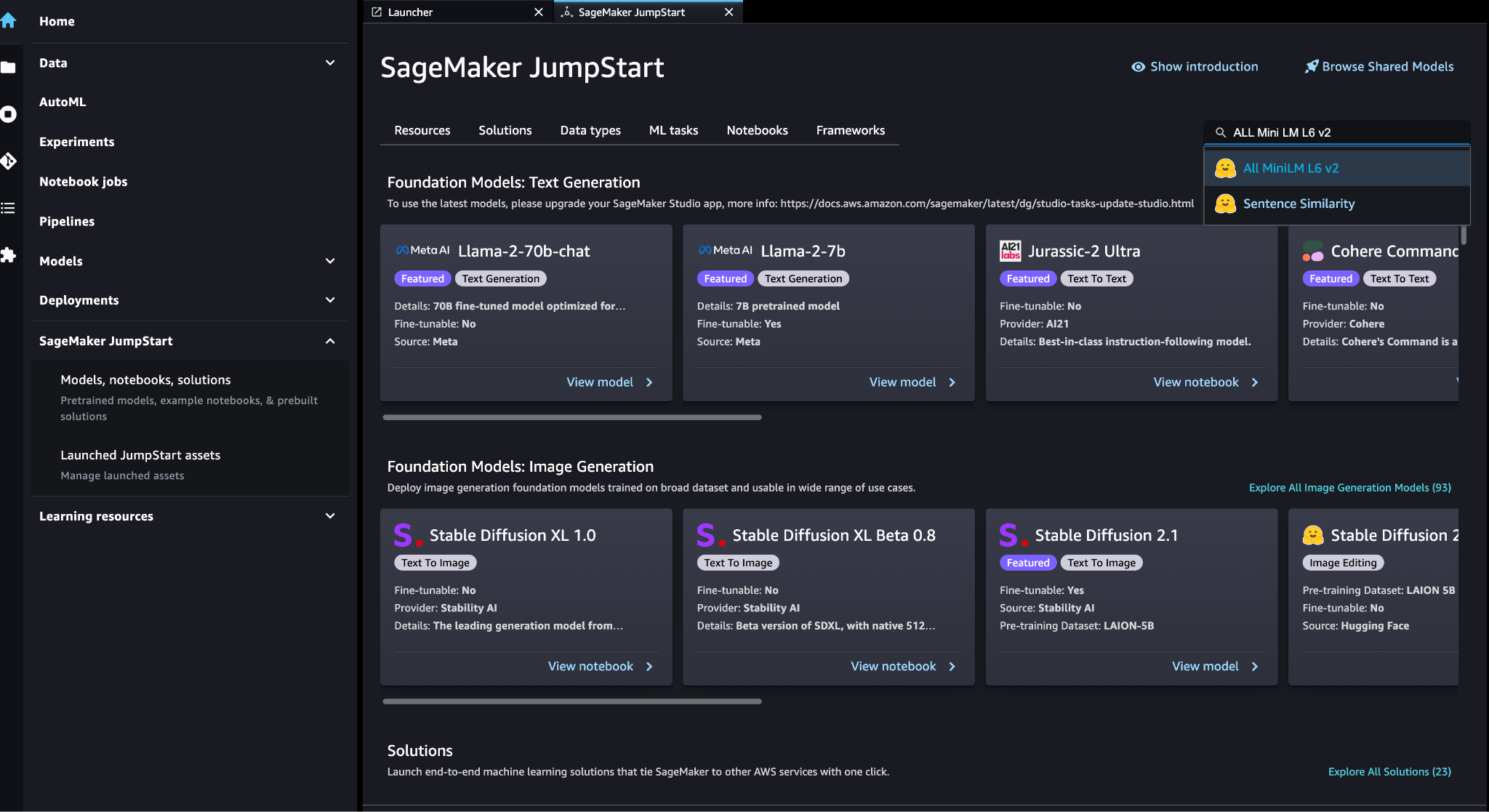

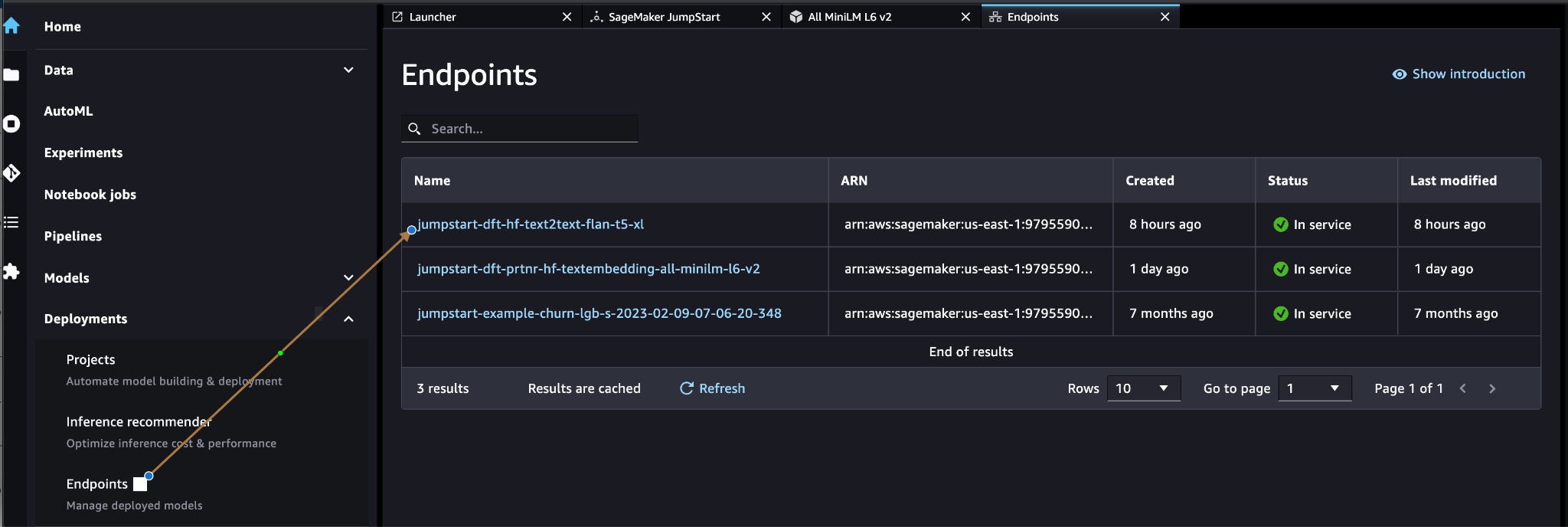

Implementeer het SageMaker-insluitingsmodel

U kunt het inbeddingsmodel (ALL MiniLM L6 v2) kiezen op de SageMaker JumpStart-modellen, notebooks, oplossingen pagina.

Kies Implementeren om het model in te zetten.

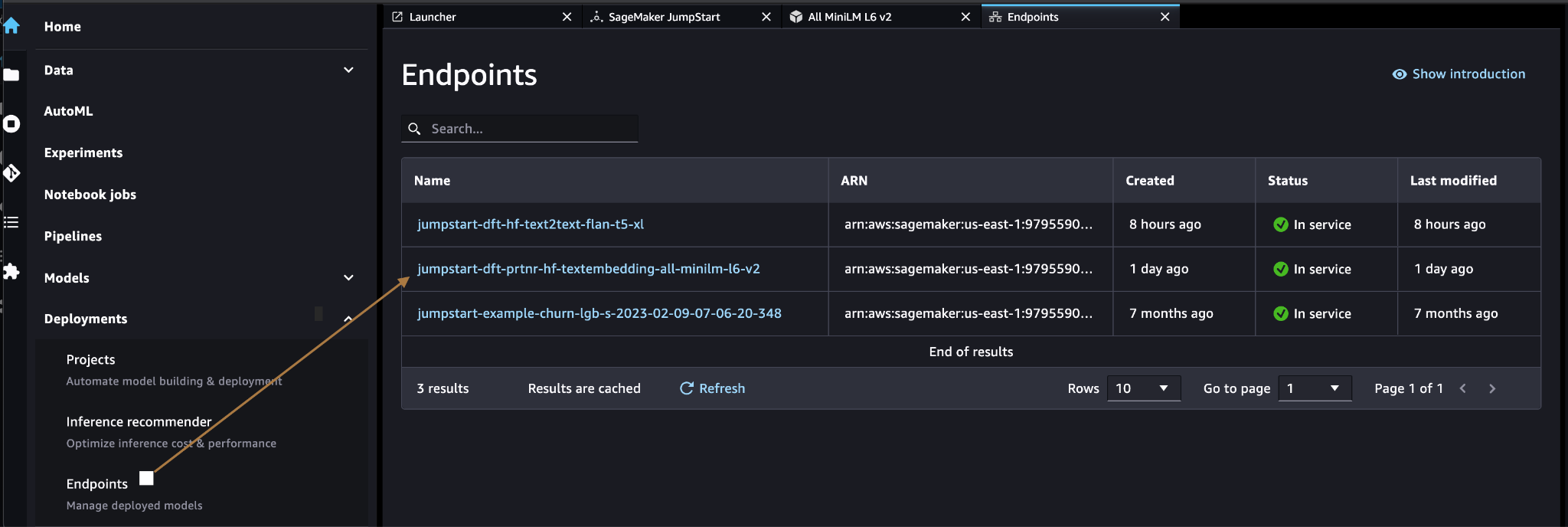

Controleer of het model succesvol is geïmplementeerd en of het eindpunt is gemaakt.

Vector inbedding

Vector inbedding is een proces waarbij een tekst of afbeelding wordt omgezet in een vectorrepresentatie. Met de volgende code kunnen we vectorinsluitingen genereren met SageMaker JumpStart en de verzameling bijwerken met de gemaakte vector voor elk document:

payload = {"text_inputs": [document[field_name_to_be_vectorized]]}

query_response = query_endpoint_with_json_payload(json.dumps(payload).encode('utf-8'))

embeddings = parse_response_multiple_texts(query_response) # update the document

update = {'$set': {vector_field_name : embeddings[0]}}

collection.update_one(query, update)De bovenstaande code laat zien hoe u één object in een verzameling kunt bijwerken. Om alle objecten bij te werken volgt u de instructies.

MongoDB vectorgegevensopslag

MongoDB Atlas Vector-zoekopdracht is een nieuwe functie waarmee u vectorgegevens in MongoDB kunt opslaan en doorzoeken. Vectorgegevens zijn een soort gegevens die een punt in een hoogdimensionale ruimte vertegenwoordigen. Dit soort gegevens wordt vaak gebruikt in ML- en kunstmatige intelligentie-toepassingen. MongoDB Atlas Vector Search maakt gebruik van een techniek genaamd k-dichtstbijzijnde buren (k-NN) om naar vergelijkbare vectoren te zoeken. k-NN werkt door de k te vinden die het meest op een bepaalde vector lijken. De meest vergelijkbare vectoren zijn degenen die het dichtst bij de gegeven vector liggen in termen van de Euclidische afstand.

Het opslaan van vectorgegevens naast operationele gegevens kan de prestaties verbeteren door de noodzaak om gegevens tussen verschillende opslagsystemen te verplaatsen te verminderen. Dit is vooral gunstig voor toepassingen die realtime toegang tot vectorgegevens vereisen.

Maak een Vector Search-index

De volgende stap is het maken van een MongoDB Vectorzoekindex op het vectorveld dat u in de vorige stap hebt gemaakt. MongoDB maakt gebruik van de knnVector type om vectorinbedding te indexeren. Het vectorveld moet worden weergegeven als een reeks getallen (alleen BSON int32, int64 of dubbele gegevenstypen).

Verwijzen naar Bekijk knnVector-typebeperkingen voor meer informatie over de beperkingen van de knnVector type.

De volgende code is een voorbeeld van een indexdefinitie:

{ "mappings": { "dynamic": true, "fields": { "egVector": { "dimensions": 384, "similarity": "euclidean", "type": "knnVector" } } }

}

Houd er rekening mee dat de dimensie moet overeenkomen met de dimensie van uw inbeddingsmodel.

Query uitvoeren in het vectorgegevensarchief

U kunt het vectorgegevensarchief opvragen met behulp van de Vector Zoekaggregatiepijplijn. Het maakt gebruik van de Vector Search-index en voert een semantisch zoeken op de vectorgegevensopslag.

De volgende code is een voorbeeld van een zoekdefinitie:

{ $search: { "index": "<index name>", // optional, defaults to "default" "knnBeta": { "vector": [<array-of-numbers>], "path": "<field-to-search>", "filter": {<filter-specification>}, "k": <number>, "score": {<options>} } }

}

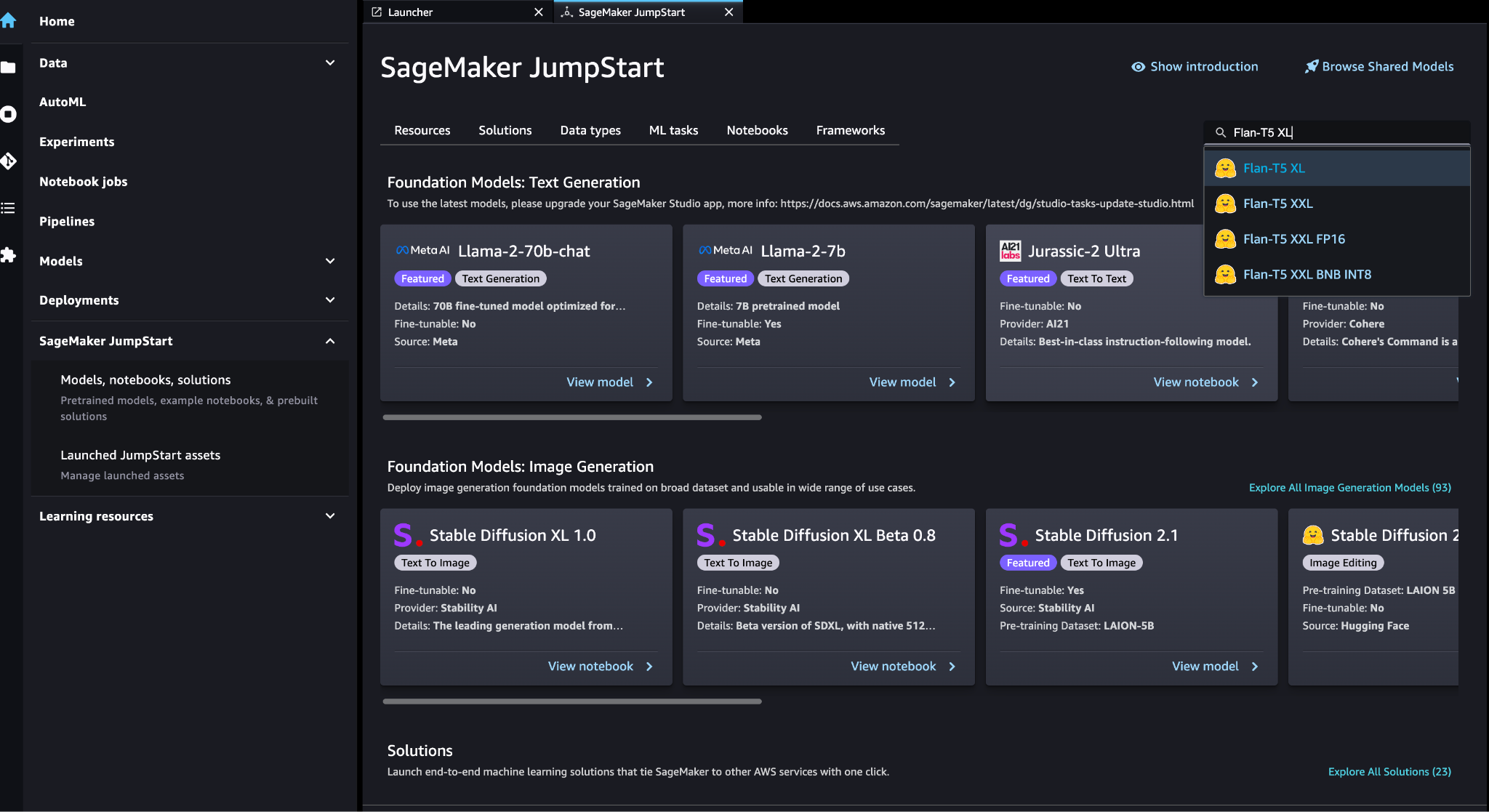

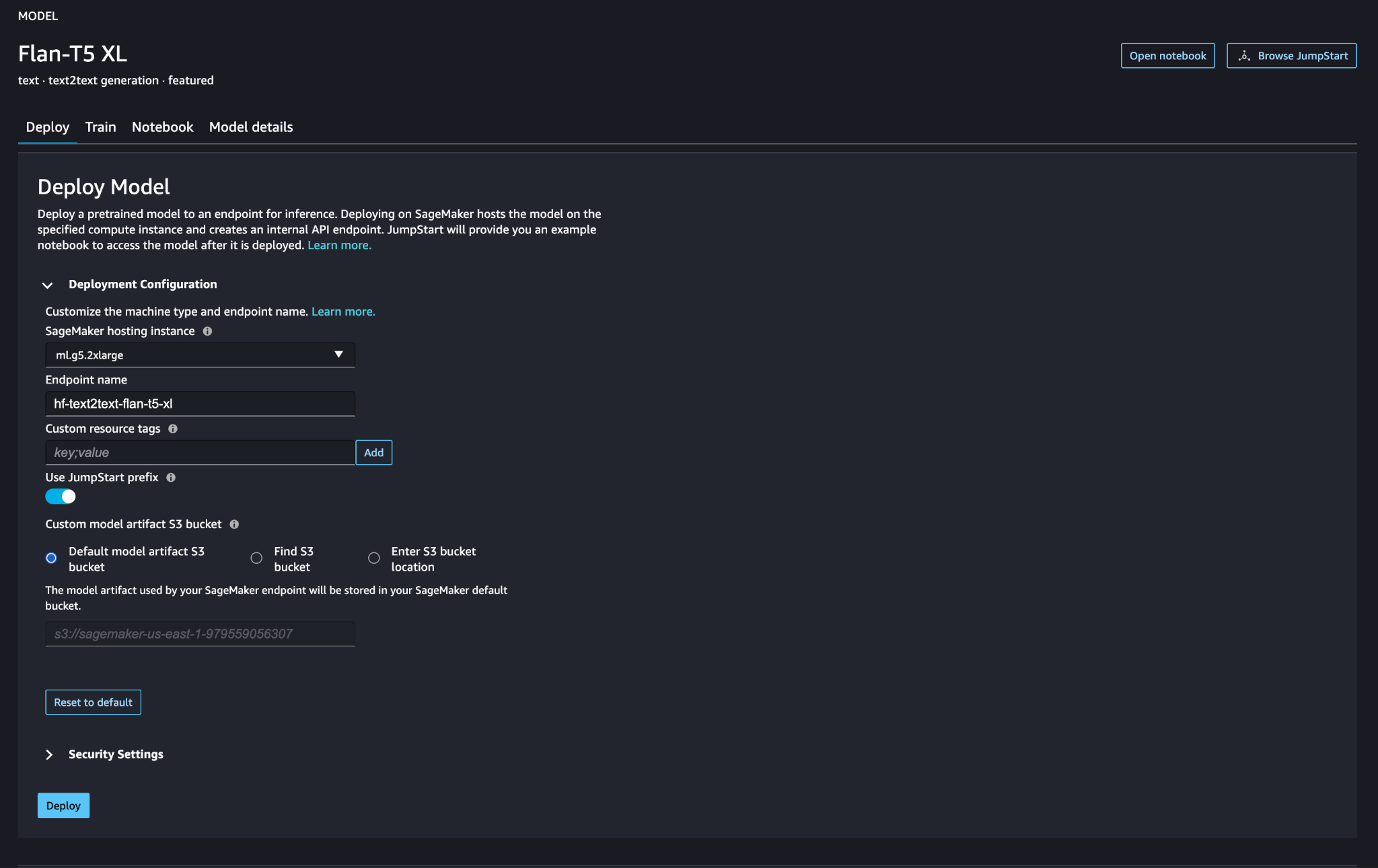

Implementeer het grote taalmodel van SageMaker

SageMaker JumpStart-basismodellen zijn vooraf getrainde grote taalmodellen (LLM's) die worden gebruikt om een verscheidenheid aan taken op het gebied van natuurlijke taalverwerking (NLP) op te lossen, zoals het samenvatten van teksten, het beantwoorden van vragen en het infereren van natuurlijke taal. Ze zijn verkrijgbaar in verschillende maten en configuraties. In deze oplossing gebruiken we de Gezicht knuffelen FLAN-T5-XL-model.

Zoek naar het FLAN-T5-XL-model in SageMaker JumpStart.

Kies Implementeren om het FLAN-T5-XL-model in te stellen.

Controleer of het model succesvol is geïmplementeerd en het eindpunt actief is.

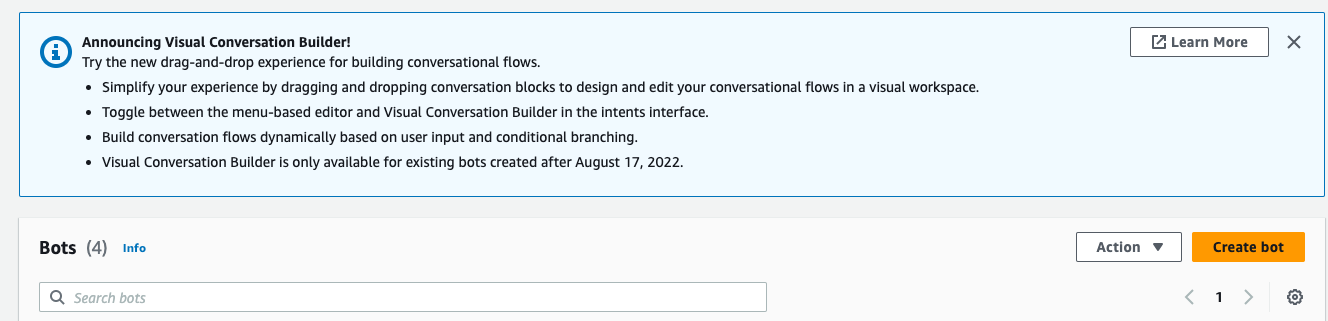

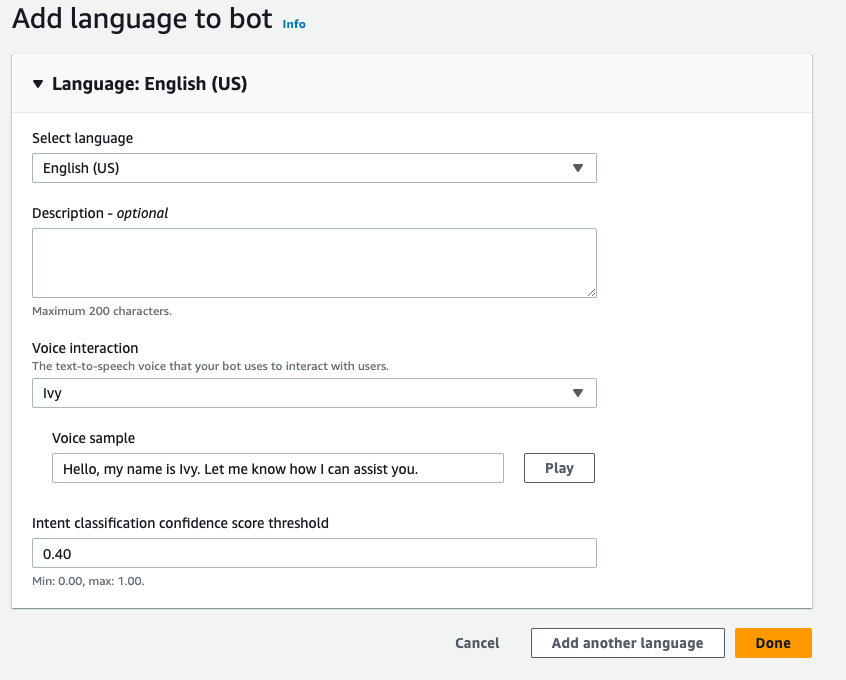

Een Amazon Lex-bot maken

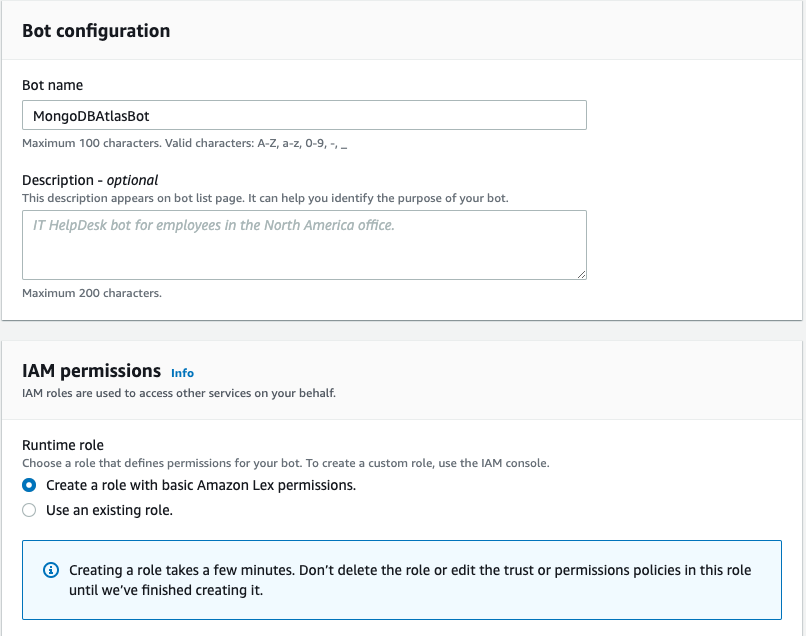

Voer de volgende stappen uit om een Amazon Lex-bot te maken:

- Kies op de Amazon Lex-console Bot maken.

- Voor Bot naam, voer een naam in.

- Voor Runtime-rolselecteer Een rol maken met basisrechten voor Amazon Lex.

- Geef uw taalinstellingen op en kies vervolgens Klaar

.

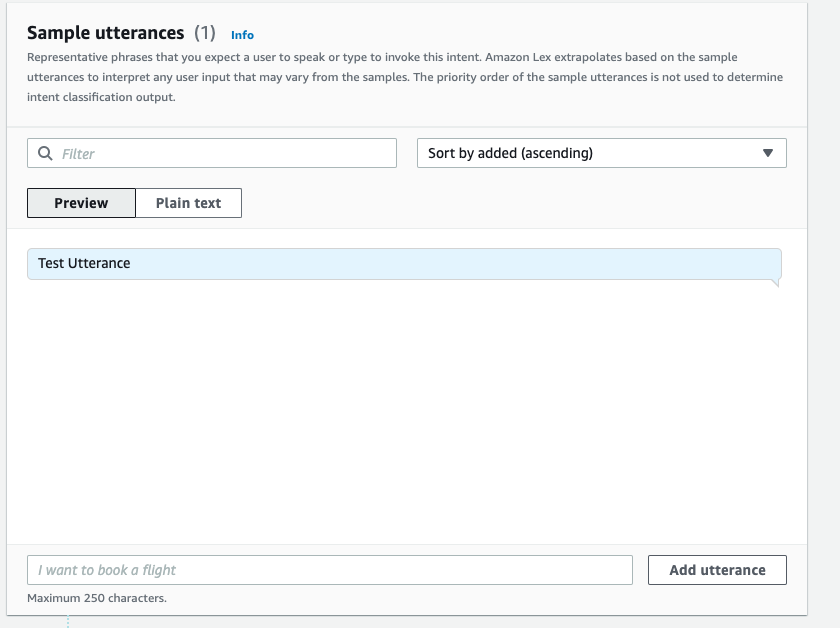

- Voeg een voorbeelduiting toe in de

NewIntentUI en kies Bewaar intentie.

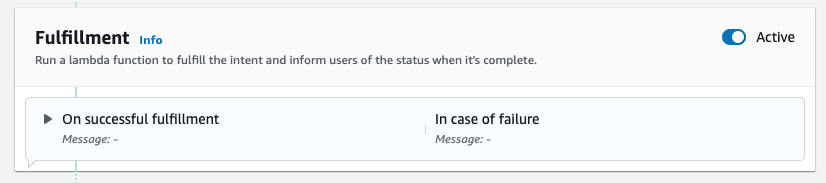

- Navigeer naar de

FallbackIntentdie standaard voor u is gemaakt en schakel Actief in de Vervulling pagina.

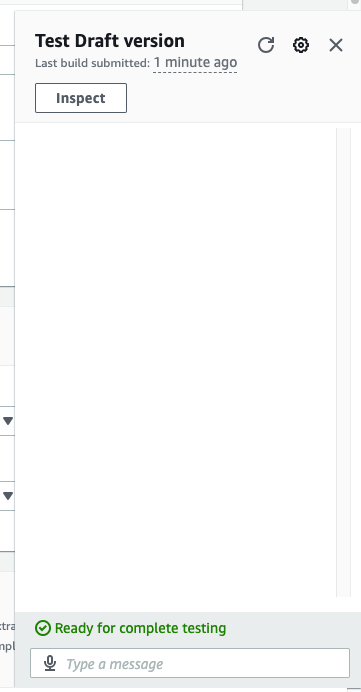

- Kies Bouw en nadat de build succesvol is, kiest u test.

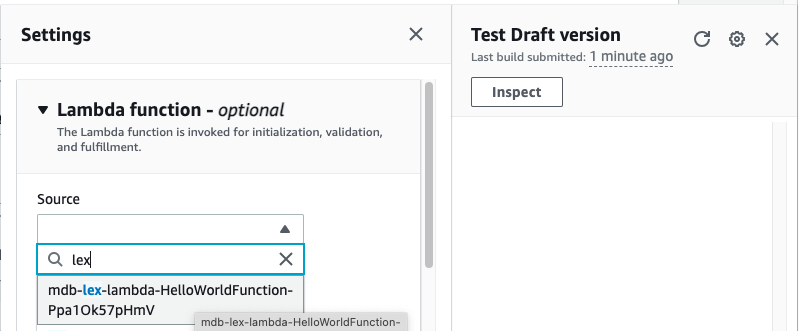

- Kies vóór het testen het tandwielpictogram.

- Geef het AWS Lambda functie die zal communiceren met MongoDB Atlas en de LLM om antwoorden te geven. Volg om de lambda-functie te maken deze stappen.

- U kunt nu communiceren met de LLM.

Opruimen

Voer de volgende stappen uit om uw bronnen op te schonen:

- Verwijder de Amazon Lex-bot.

- Verwijder de Lambda-functie.

- Verwijder het LLM SageMaker-eindpunt.

- Verwijder het SageMaker-eindpunt van het inbeddingsmodel.

- Verwijder het MongoDB Atlas-cluster.

Conclusie

In de post hebben we laten zien hoe je een eenvoudige bot kunt maken die de semantische zoekfunctie van MongoDB Atlas gebruikt en kan worden geïntegreerd met een model van SageMaker JumpStart. Met deze bot kunt u snel een prototype maken van gebruikersinteractie met verschillende LLM's in SageMaker Jumpstart, terwijl u ze koppelt aan de context afkomstig uit MongoDB Atlas.

Zoals altijd verwelkomt AWS feedback. Laat uw feedback en vragen achter in het opmerkingengedeelte.

Over de auteurs

Igor Aleksejev is een Senior Partner Solution Architect bij AWS in het domein Data en Analytics. In zijn rol werkt Igor samen met strategische partners die hen helpen bij het bouwen van complexe, voor AWS geoptimaliseerde architecturen. Voordat hij bij AWS kwam, implementeerde hij als Data/Solution Architect veel projecten in het Big Data-domein, waaronder verschillende datameren in het Hadoop-ecosysteem. Als Data Engineer was hij betrokken bij het toepassen van AI/ML op fraudedetectie en kantoorautomatisering.

Baboe Srinivasan is een Senior Partner Solutions Architect bij MongoDB. In zijn huidige rol werkt hij samen met AWS om de technische integraties en referentiearchitecturen voor de AWS- en MongoDB-oplossingen te bouwen. Hij heeft meer dan twee decennia ervaring in database- en cloudtechnologieën. Hij is gepassioneerd door het bieden van technische oplossingen aan klanten die werken met meerdere Global System Integrators (GSI's) in meerdere regio's.

Baboe Srinivasan is een Senior Partner Solutions Architect bij MongoDB. In zijn huidige rol werkt hij samen met AWS om de technische integraties en referentiearchitecturen voor de AWS- en MongoDB-oplossingen te bouwen. Hij heeft meer dan twee decennia ervaring in database- en cloudtechnologieën. Hij is gepassioneerd door het bieden van technische oplossingen aan klanten die werken met meerdere Global System Integrators (GSI's) in meerdere regio's.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/retrieval-augmented-generation-with-langchain-amazon-sagemaker-jumpstart-and-mongodb-atlas-semantic-search/

- : heeft

- :is

- :waar

- $UP

- 100

- 200

- 321

- 361

- 7

- 9

- a

- Over

- boven

- versnellen

- toegang

- over

- actieve

- Na

- aggregatie

- AI

- AI-powered

- AI / ML

- Alles

- toestaat

- altijd

- Amazone

- Amazon-Lex

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- analytics

- en

- APIs

- toepassingen

- Het toepassen van

- architectuur

- ZIJN

- reeks

- kunstmatig

- kunstmatige intelligentie

- AS

- At

- augments

- Automatisering

- Beschikbaar

- AWS

- AWS Lambda

- basis-

- BE

- heilzaam

- tussen

- Groot

- Big data

- Bot

- bots

- bouw

- ondernemingen

- maar

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- CAN

- mogelijkheden

- voorzichtig

- uitdagingen

- chatbots

- Kies

- schoon

- Cloud

- TROS

- code

- SAMENHANGEND

- Collectie

- opmerkingen

- compleet

- complex

- componenten

- Overwegen

- troosten

- content

- verband

- spraakzaam

- het omzetten van

- en je merk te creëren

- aangemaakt

- Actueel

- Klanten

- aan te passen

- gegevens

- gegevensopslag

- Gegevensgestuurde

- Database

- databanken

- decennia

- Standaard

- defaults

- definitie

- implementeren

- ingezet

- Opsporing

- Ontwikkeling

- anders

- Afmeting

- Afmeting

- afstand

- document

- domein

- verdubbelen

- dynamisch

- ecosysteem

- effectief

- elimineren

- inbedding

- maakt

- Endpoint

- toegewijd

- ingenieur

- zorgen

- Enter

- Enterprise

- bedrijven

- vooral

- Alle

- ervaring

- extern

- SNELLE

- Kenmerk

- feedback

- weinig

- veld-

- Velden

- filter

- het vinden van

- volgen

- volgend

- Voor

- Foundation

- Achtergrond

- bedrog

- fraude detectie

- Gratis

- oppompen van

- functie

- Kookgerei

- voortbrengen

- generatie

- generatief

- generatieve AI

- geografieën

- krijgen

- gegeven

- Globaal

- harnas

- Hebben

- he

- hulp

- het helpen van

- helpt

- highlights

- zijn

- holistische

- Hoe

- How To

- HTML

- http

- HTTPS

- ICON

- illustreert

- beeld

- uitvoeren

- geïmplementeerd

- verbeteren

- in

- Inclusief

- index

- informatie

- invoer

- instructies

- geïntegreerde

- integreert

- Integreren

- integratie

- integraties

- Intelligentie

- interactie

- wisselwerking

- interacties

- Interface

- in

- betrokken zijn

- IT

- HAAR

- aansluiting

- json

- voor slechts

- meren

- landing

- taal

- Groot

- leren

- Verlof

- levensecht

- beperkingen

- LLM

- machine

- machine learning

- maken

- veel

- Match

- ML

- model

- modellen

- MongoDB

- meer

- meest

- beweging

- meervoudig

- Dan moet je

- naam

- Naturel

- Natural Language Processing

- Noodzaak

- netwerk

- New

- volgende

- nlp

- nu

- nummers

- object

- objecten

- of

- Kantoor

- vaak

- on

- degenen

- Slechts

- operationele

- Operations

- or

- afkomstig

- het overwinnen van

- overzicht

- pagina

- pairing

- partner

- partners

- hartstochtelijk

- pad

- prestatie

- presteert

- Plato

- Plato gegevensintelligentie

- PlatoData

- dan

- punt

- Post

- potentieel

- energie

- krachtige

- cadeautjes

- vorig

- Voorafgaand

- verwerking

- projecten

- prototype

- zorgen voor

- biedt

- het verstrekken van

- kwaliteit

- vraag

- Contact

- snel

- real-time

- vermindering

- referentie

- relevante

- vertegenwoordiging

- vertegenwoordigd

- vertegenwoordigt

- vereisen

- Resources

- reacties

- revolutioneren

- Rol

- vrijwaring

- sagemaker

- partituur

- naadloos

- Ontdek

- sectie

- secties

- senior

- apart

- Diensten

- reeks

- settings

- verscheidene

- moet

- vertoonde

- Shows

- gelijk

- Eenvoudig

- vereenvoudigen

- single

- maten

- oplossing

- Oplossingen

- OPLOSSEN

- bronnen

- Tussenruimte

- gestart

- Stap voor

- Stappen

- mediaopslag

- shop

- strategisch

- strategische partners

- geslaagd

- Met goed gevolg

- dergelijk

- suite

- system

- Systems

- taken

- Technisch

- techniek

- Technologies

- termen

- proef

- Testen

- tekst

- neem contact

- dat

- De

- hun

- Ze

- harte

- ze

- dit

- Door

- rij

- naar

- Trainen

- transformatieve

- overgangen

- waar

- twee

- type dan:

- types

- ui

- bijwerken

- .

- gebruikt

- Gebruiker

- toepassingen

- gebruik

- variëteit

- controleren

- Stem

- lopen

- was

- Manier..

- we

- web

- webservices

- Welkom

- en

- wil

- Met

- werkzaam

- Bedrijven

- You

- Your

- zephyrnet