Toen Google aankondigde dat zijn kwantumcomputer een probleem had opgelost dat verder ging dan de... vermogen van de krachtigste supercomputer, het was een mijlpaal voor de industrie. Maar Chinese onderzoekers hebben nu aangetoond dat ze dat wel kunnen los De .. Op dezelfde probleem op een normale supercomputer in slechts enkele seconden.

De ultieme belofte van kwantum computergebruik is zijn vermogen om bepaalde computerprestaties veel sneller uit te voeren dan klassieke machines, of zelfs problemen op te lossen die met traditionele benaderingen in wezen onmogelijk te kraken zouden zijn.

Het veld staat echter nog in de kinderschoenen en de apparaten van vandaag zijn veel te klein om aan echte uitdagingen te kunnen werken. Maar in een poging om te bewijzen dat het veld vooruitgang boekt, zijn ontwikkelaars van kwantumprocessors gretig op zoek gegaan naar problemen die misschien niet veel praktisch nut hebben, maar die de potentiële versnellingen kunnen aantonen waartoe hun technologie in staat is.

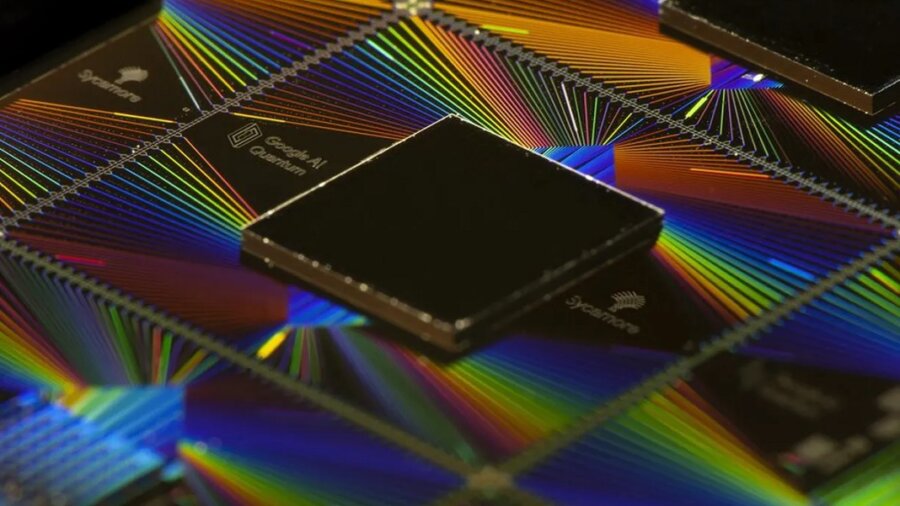

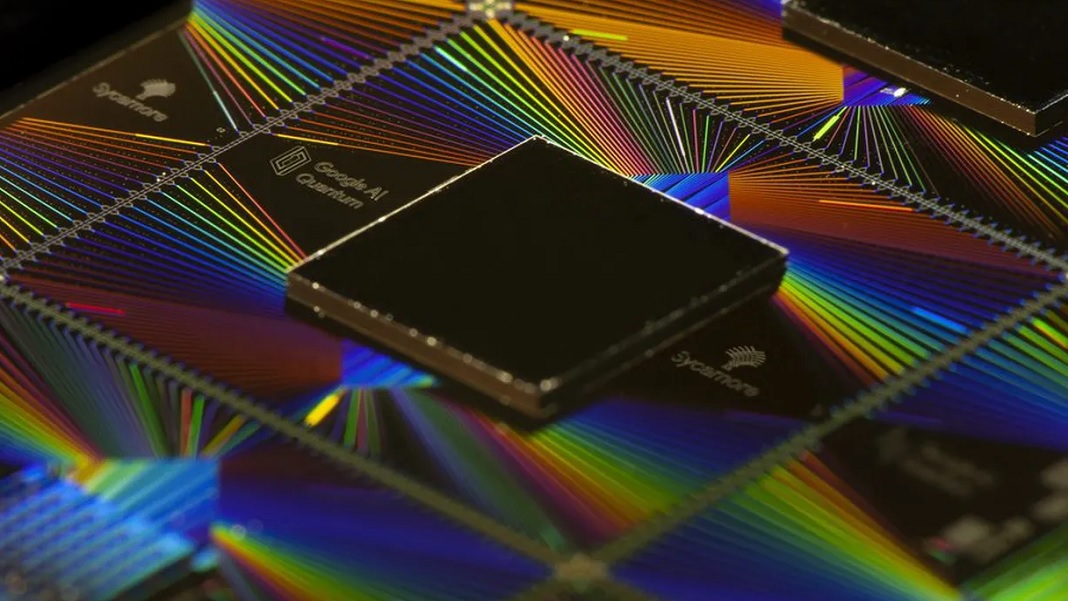

Google heeft op dit gebied in 2019 een grote doorbraak gemaakt toen het beweerde dat zijn Sycamore-processor een probleem had opgelost dat een supercomputer 10,000 jaar zou kosten in slechts 200 seconden. Het probleem werd in hun voordeel opgetuigd, omdat het in wezen ging om het simuleren van de output van hun processor, maar door te laten zien dat een klassieke computer het moeilijk zou hebben, konden ze aanspraak maken op 'kwantum suprematie', tegenwoordig beter bekend als 'kwantumvoordeel'.

Maar nu onderzoekers in Chineen hebben hetzelfde probleem gekraakt in slechts 15 uur met seen slim algoritmisch ontwerp en een redelijk grote computer. Volgens hun berekeningen zou het slechts enkele tientallen seconden duren als ze toegang hadden tot supercomputers op ware grootte.

De uitdaging die Google had gesteld, was om de processor te simuleren die min of meer als een generator van willekeurige getallen werkte. Het enige verschil was dat ze het algoritme miljoenen keren herhaalden, en vanwege de aard van het algoritme zou er een bepaald patroon moeten ontstaan in de willekeurige getallen die worden uitgespuugd.

Dit simuleren op een klassieke computer zou snel moeilijk moeten worden naarmate de processor groter wordt, omdat de hoeveelheid gecodeerde informatie exponentieel toeneemt met elke extra qubit. Met behulp van conventionele benaderingen om dit probleem op te lossen, voorspelde Google dat het 10,000 jaar zou duren om zijn 53-qubit-processor te simuleren.

Het team van het Instituut voor Theoretische Fysica van de Chinese Academie van Wetenschappen heeft arond dit af door de onderliggende wiskunde die werd gebruikt om het probleem op te lossen, opnieuw te bewerken. Ze stelden de processor voor als een 3D-netwerk van wiskundige objecten, tensoren genaamd, die de logische poorten tussen de 53 qubits vertegenwoordigen. Dit netwerk werd herhaald over 20 lagen, ontworpen om de 20 cycli weer te geven die het kwantumalgoritme doorloopt voordat de uitvoer van de processor wordt gelezen.

Het voordeel van het gebruik van tensoren is dat GPU's, de chips die de deep learning-revolutie hebben aangedreven, ze zeer snel parallel kunnen verwerken. De onderzoekers profiteerden ook van het feit dat de berekeningen van Google op Sycamore niet erg nauwkeurig waren, met een betrouwbaarheid van slechts 0.2 procent. Hierdoor konden ze een deel van de nauwkeurigheid van hun simulatie opofferen om de snelheid te verhogen, wat ze deden door enkele verbindingen tussen qubits te verwijderen.

Het resultaat was dat ze erin slaagden om de output van de Sycamore-processor in slechts 0.37 uur te simuleren met een getrouwheid van 15 procent op 512 GPU's - aanzienlijk minder verwerkingskracht dan de meeste toonaangevende supercomputers. Een paper waarin de resultaten worden geschetst, ligt momenteel in de pers op: Physical Review Letters, maar een niet-peer-reviewed pre-print werd afgelopen november uitgebracht.

Hoewel het resultaat de kwantumsuprematiebubbel van Google enigszins doet barsten, in een e-mail aan: Wetenschap, wees het bedrijf erop dat het in zijn paper van 2019 had voorspeld dat klassieke algoritmen zouden verbeteren. Maar ze voegen eraan toe dat ze niet denken dat ze de exponentiële prestatieverbeteringen van kwantumcomputers lang zullen kunnen bijhouden.

Het is niet het enige quantum suprematie-experiment dat ongedaan moet worden gemaakt. In 2020 een Chinees team beweerde dat een probleem dat hun kwantumcomputer in 200 seconden kon oplossennds zou een supercomputer 2.5 miljard jaar kosten, maar in januari toonden onderzoekers aan dat het eigenlijk maar 73 dagen zou duren.

Hoewel dit de vooruitgang in het veld niet tenietdoet, zegt een groeiend koor van onderzoekers dat het tegen elkaar opnemen van kwantum- en klassieke machines op dit soort abstracte computerproblemen niet echt een duidelijk idee geeft van waar de technologie is at.

De echte test, zeggen ze, zal zijn wanneer kwantumcomputers in staat zijn om echte problemen sneller en efficiënter op te lossen dan klassieke. En dat lijkt nog ver weg te zijn.

Afbeelding: Google

- AI

- ai kunst

- ai kunst generator

- je hebt een robot

- kunstmatige intelligentie

- certificering van kunstmatige intelligentie

- kunstmatige intelligentie in het bankwezen

- kunstmatige intelligentie robot

- kunstmatige intelligentie robots

- kunstmatige intelligentiesoftware

- blockchain

- blockchain conferentie ai

- vindingrijk

- computergebruik

- conversatie kunstmatige intelligentie

- crypto conferentie ai

- van dall

- diepgaand leren

- Kopen Google Reviews

- google ai

- machine learning

- Plato

- plato ai

- Plato gegevensintelligentie

- Plato-spel

- PlatoData

- platogamen

- schaal ai

- Hub voor singulariteit

- syntaxis

- onderwerpen

- zephyrnet