Dit bericht neemt je mee door de meest voorkomende uitdagingen waarmee klanten worden geconfronteerd bij het zoeken naar interne documenten, en geeft je concrete richtlijnen over hoe AWS-services kunnen worden gebruikt om een generatieve AI-gespreksbot te creëren die interne informatie nuttiger maakt.

Ongestructureerde data zijn goed voor 80% van alle data gevonden binnen organisaties, bestaande uit opslagplaatsen van handleidingen, pdf's, veelgestelde vragen, e-mails en andere documenten die dagelijks groeien. Bedrijven zijn tegenwoordig afhankelijk van voortdurend groeiende opslagplaatsen van interne informatie, en er ontstaan problemen wanneer de hoeveelheid ongestructureerde gegevens onbeheersbaar wordt. Vaak lezen en controleren gebruikers veel verschillende interne bronnen om de antwoorden te vinden die ze nodig hebben.

Interne vraag- en antwoordforums kunnen gebruikers helpen zeer specifieke antwoorden te krijgen, maar vereisen ook langere wachttijden. Bij bedrijfsspecifieke interne FAQ’s resulteren lange wachttijden in een lagere productiviteit van de medewerkers. Vraag- en antwoordforums zijn moeilijk te schalen omdat ze afhankelijk zijn van handmatig geschreven antwoorden. Met generatieve AI vindt er momenteel een paradigmaverschuiving plaats in de manier waarop gebruikers informatie zoeken en vinden. De volgende logische stap is het gebruik van generatieve AI om grote documenten samen te vatten in kleinere hapklare informatie, zodat deze gemakkelijker door de gebruiker kan worden gebruikt. In plaats van veel tijd te besteden aan het lezen van tekst of het wachten op antwoorden, kunnen gebruikers in realtime samenvattingen genereren op basis van meerdere bestaande opslagplaatsen met interne informatie.

Overzicht oplossingen

De oplossing stelt klanten in staat om samengestelde antwoorden op vragen over interne documenten op te halen door een transformermodel te gebruiken om antwoorden te genereren op vragen over gegevens waarop het niet is getraind, een techniek die bekend staat als zero-shot prompting. Door deze oplossing te gebruiken, kunnen klanten de volgende voordelen behalen:

- Vind nauwkeurige antwoorden op vragen op basis van bestaande bronnen van interne documenten

- Verminder de tijd die gebruikers besteden aan het zoeken naar antwoorden door Large Language Models (LLM's) te gebruiken om vrijwel onmiddellijke antwoorden te geven op complexe vragen met behulp van documenten met de meest actuele informatie

- Zoek eerder beantwoorde vragen via een gecentraliseerd dashboard

- Verminder stress die wordt veroorzaakt door tijd te besteden aan het handmatig lezen van informatie om naar antwoorden te zoeken

Ophalen van Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) vermindert enkele tekortkomingen van op LLM gebaseerde zoekopdrachten door de antwoorden uit uw kennisbank te vinden en de LLM te gebruiken om de documenten samen te vatten in beknopte antwoorden. Lees dit alstublieft post om te leren hoe u de RAG-aanpak kunt implementeren Amazon Kendra. De volgende risico's en beperkingen houden verband met op LLM gebaseerde zoekopdrachten die een RAG-benadering met Amazon Kendra adresseert:

- Hallucinaties en traceerbaarheid – LLMS worden getraind op grote datasets en genereren reacties op waarschijnlijkheden. Dit kan leiden tot onnauwkeurige antwoorden, die bekend staan als hallucinaties.

- Meerdere datasilo's – Om binnen uw respons naar gegevens uit meerdere bronnen te kunnen verwijzen, moet u een connector-ecosysteem opzetten om de gegevens te aggregeren. Toegang tot meerdere repository's is handmatig en tijdrovend.

- Beveiliging – Beveiliging en privacy zijn cruciale overwegingen bij het inzetten van conversatiebots die worden aangedreven door RAG en LLM’s. Ondanks gebruik Amazon begrijpt het Om persoonlijke gegevens uit te filteren die via zoekopdrachten van gebruikers kunnen worden verstrekt, blijft er een mogelijkheid bestaan dat onbedoeld persoonlijke of gevoelige informatie boven water komt, afhankelijk van de opgenomen gegevens. Dit betekent dat het controleren van de toegang tot de chatbot cruciaal is om onbedoelde toegang tot gevoelige informatie te voorkomen.

- Gegevensrelevantie – LLMS worden getraind op gegevens tot een bepaalde datum, wat betekent dat informatie vaak niet actueel is. De kosten die gepaard gaan met het trainen van modellen op basis van recente gegevens zijn hoog. Om nauwkeurige en actuele antwoorden te garanderen, dragen organisaties de verantwoordelijkheid om de inhoud van de geïndexeerde documenten regelmatig bij te werken en te verrijken.

- Kosten – De kosten die gepaard gaan met de implementatie van deze oplossing moeten voor bedrijven een overweging zijn. Bedrijven moeten hun budget- en prestatie-eisen zorgvuldig beoordelen bij de implementatie van deze oplossing. Voor het uitvoeren van LLM's kunnen aanzienlijke computerbronnen nodig zijn, waardoor de operationele kosten kunnen stijgen. Deze kosten kunnen een beperking worden voor toepassingen die op grote schaal moeten opereren. Echter, een van de voordelen van de AWS Cloud is de flexibiliteit om alleen te betalen voor wat u gebruikt. AWS biedt een eenvoudig, consistent, pay-as-you-go-prijsmodel, zodat u alleen betaalt voor de bronnen die u verbruikt.

Gebruik van Amazon SageMaker JumpStart

Organisaties kunnen profiteren van het gebruik van op transformatoren gebaseerde taalmodellen Amazon Sage Maker JumpStart, dat een verzameling vooraf gebouwde machine learning-modellen biedt. Amazon SageMaker JumpStart biedt een breed scala aan fundamentele modellen voor het genereren van tekst en het beantwoorden van vragen (Q&A), die eenvoudig kunnen worden geïmplementeerd en gebruikt. Deze oplossing integreert een FLAN T5-XL Amazon SageMaker JumpStart-model, maar er zijn verschillende aspecten waarmee u rekening moet houden wanneer het kiezen van een funderingsmodel.

Beveiliging integreren in onze workflow

Volgens de beste praktijken van de Veiligheidspijler van de Goed ontworpen raamwerk, Amazon Cognito wordt gebruikt voor authenticatie. Amazon Cognito User Pools kunnen worden geïntegreerd met externe identiteitsproviders die verschillende raamwerken ondersteunen die worden gebruikt voor toegangscontrole, waaronder Open Authorization (OAuth), OpenID Connect (OIDC) of Security Assertion Markup Language (SAML). Door gebruikers en hun acties te identificeren, kan de oplossing de traceerbaarheid behouden. De oplossing maakt ook gebruik van de Amazon Comprehend detectie van persoonlijk identificeerbare informatie (PII). functie om PII automatisch te identificeren en te redigeren. Geredigeerde PII omvat adressen, burgerservicenummers, e-mailadressen en andere gevoelige informatie. Dit ontwerp zorgt ervoor dat alle PII die door de gebruiker via de invoerquery wordt verstrekt, wordt geredigeerd. De PII wordt niet opgeslagen, gebruikt door Amazon Kendra of doorgegeven aan de LLM.

Oplossingsoverzicht

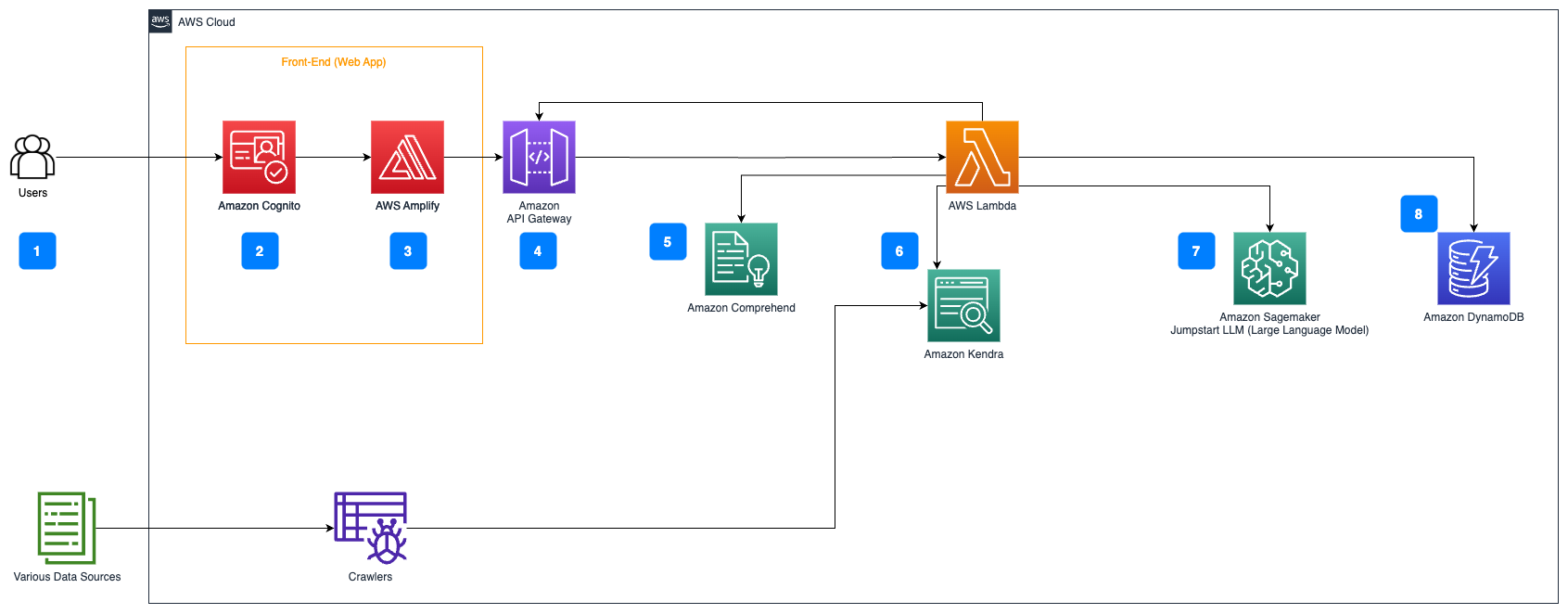

De volgende stappen beschrijven de workflow van de stroom Vragen beantwoorden over documenten:

- Gebruikers sturen een vraag via een webinterface.

- Amazon Cognito wordt gebruikt voor authenticatie, waardoor veilige toegang tot de webapplicatie wordt gegarandeerd.

- De front-end van de webapplicatie wordt gehost op AWS versterken.

- Amazon API-gateway host een REST API met verschillende eindpunten om gebruikersverzoeken af te handelen die zijn geverifieerd met Amazon Cognito.

- PII redactie met Amazon begrijpt het:

- Verwerking van gebruikersquery's: Wanneer een gebruiker een query of invoer indient, wordt deze eerst via Amazon Comprehend doorgegeven. De service analyseert de tekst en identificeert eventuele PII-entiteiten die aanwezig zijn in de zoekopdracht.

- PII-extractie: Amazon Comprehend extraheert de gedetecteerde PII-entiteiten uit de gebruikersquery.

- Relevante informatie ophalen met Amazon Kendra:

- Amazon Kendra wordt gebruikt om een index van documenten te beheren die de informatie bevat die wordt gebruikt om antwoorden op de vragen van de gebruiker te genereren.

- De LangChain QA-ophalen module wordt gebruikt om een gespreksketen op te bouwen die relevante informatie bevat over de vragen van de gebruiker.

- Integratie met Amazon SageMaker JumpStart:

- De AWS Lambda-functie maakt gebruik van de LangChain-bibliotheek en maakt verbinding met het Amazon SageMaker JumpStart-eindpunt met een contextrijke query. Het Amazon SageMaker JumpStart-eindpunt fungeert als de interface van de LLM die wordt gebruikt voor gevolgtrekking.

- Reacties opslaan en terugsturen naar de gebruiker:

- Het antwoord van de LLM wordt opgeslagen in Amazon DynamoDB samen met de zoekopdracht van de gebruiker, de tijdstempel, een unieke identificatie en andere willekeurige identificatiegegevens voor het item, zoals de vraagcategorie. Door de vraag en het antwoord als afzonderlijke items op te slaan, kan de AWS Lambda-functie eenvoudig de gespreksgeschiedenis van een gebruiker opnieuw creëren op basis van het tijdstip waarop vragen werden gesteld.

- Ten slotte wordt het antwoord teruggestuurd naar de gebruiker via een HTTPs-verzoek via het Amazon API Gateway REST API-integratieantwoord.

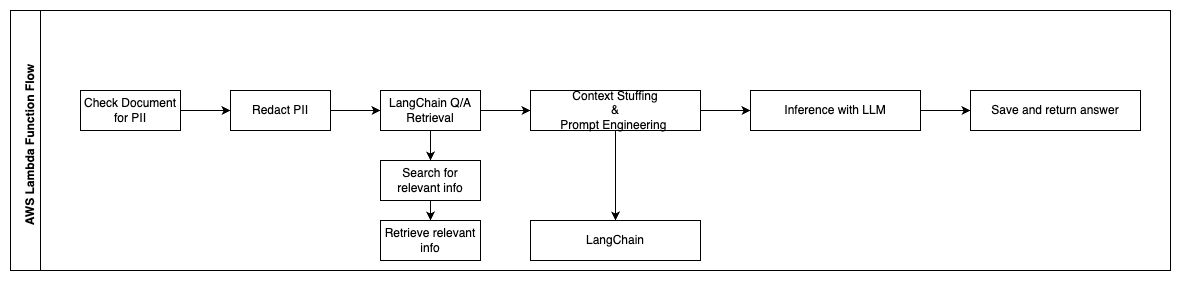

De volgende stappen beschrijven de AWS Lambda-functies en hun stroom door het proces:

- Controleer en redigeer eventuele PII/gevoelige informatie

- LangChain QA-ophaalketen

- Zoek en haal relevante informatie op

- Contextvulling en snelle engineering

- Inferentie met LLM

- Antwoord retourneren en opslaan

Use cases

Er zijn veel zakelijke gebruiksscenario's waarin klanten deze workflow kunnen gebruiken. In het volgende gedeelte wordt uitgelegd hoe de workflow in verschillende sectoren en branches kan worden gebruikt.

Employee Assistance

Goed ontworpen bedrijfstrainingen kunnen de medewerkerstevredenheid verbeteren en de tijd die nodig is voor het onboarden van nieuwe medewerkers verkorten. Naarmate organisaties groeien en de complexiteit toeneemt, vinden werknemers het moeilijk om de vele bronnen van interne documenten te begrijpen. Interne documenten in deze context omvatten bedrijfsrichtlijnen, beleid en standaard operationele procedures. Voor dit scenario heeft een medewerker een vraag over hoe verder te gaan en een ticket voor interne uitgiftetickets te bewerken. De medewerker heeft toegang tot de generatieve kunstmatige intelligentie (AI) conversatiebot en kan deze gebruiken om de volgende stappen voor een specifiek ticket te vragen en uit te voeren.

Specifiek gebruiksscenario: Automatiseer probleemoplossing voor medewerkers op basis van bedrijfsrichtlijnen.

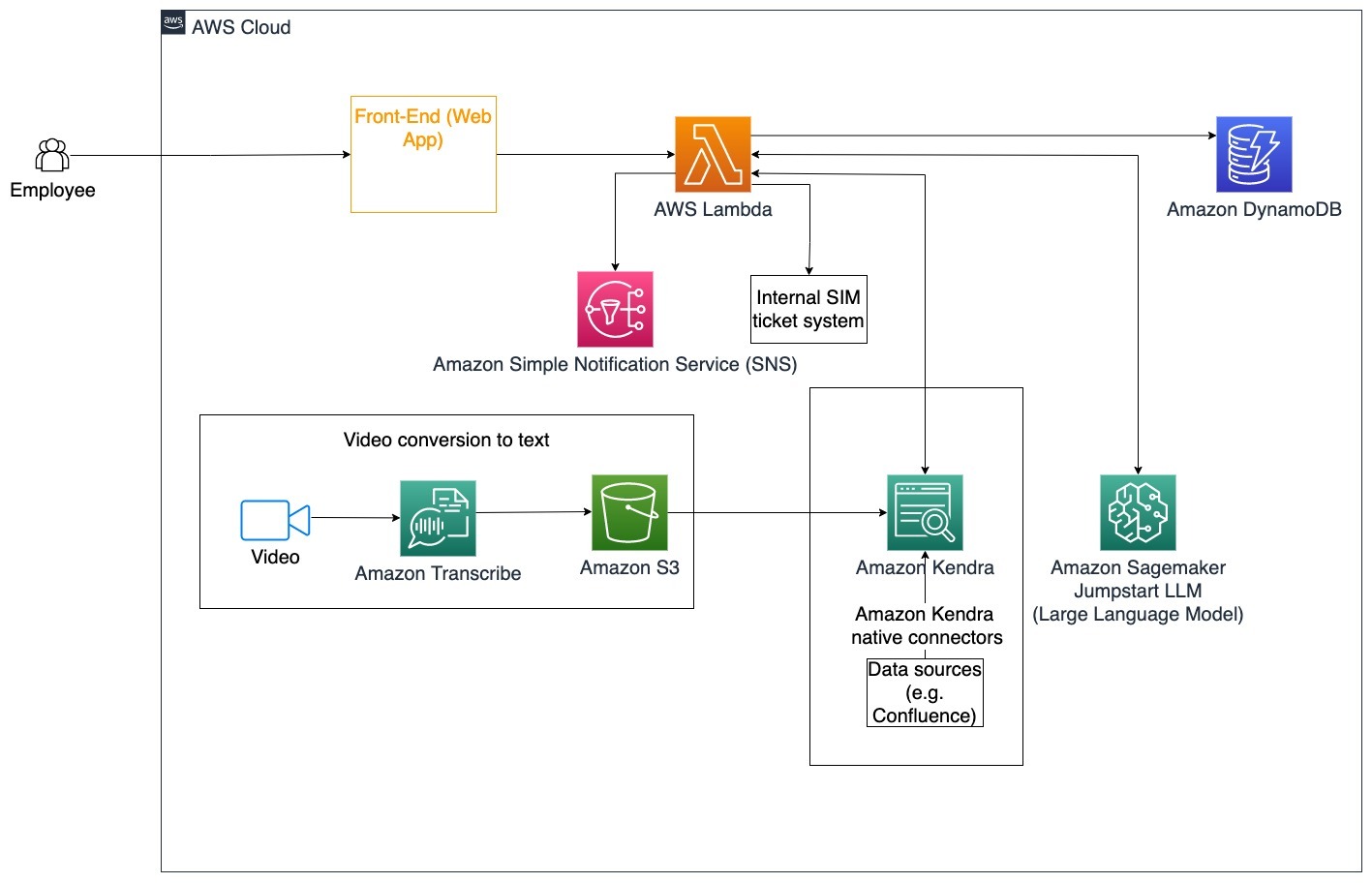

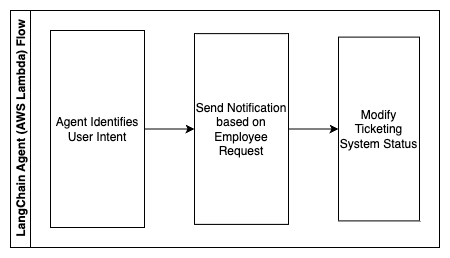

De volgende stappen beschrijven de AWS Lambda-functies en hun stroom door het proces:

- LangChain-agent om de intentie te identificeren

- Verstuur een notificatie op basis van een werknemersverzoek

- Ticketstatus wijzigen

In dit architectuurdiagram kunnen bedrijfstrainingsvideo's worden opgenomen via Amazon Transcribe om een logboek van deze videoscripts te verzamelen. Bovendien kan bedrijfstrainingsinhoud die is opgeslagen in verschillende bronnen (dwz Confluence, Microsoft SharePoint, Google Drive, Jira, enz.) worden gebruikt om indexen te maken via Amazon Kendra-connectoren. Lees dit artikel voor meer informatie over het verzamelen van native connectoren je kunt in Amazon Kendra als bronpunt gebruiken. De Amazon Kendra-crawler kan vervolgens zowel de videoscripts voor bedrijfstrainingen als de documentatie die in deze andere bronnen is opgeslagen, gebruiken om de gespreksbot te helpen bij het beantwoorden van vragen die specifiek zijn voor de richtlijnen voor bedrijfstrainingen van bedrijven. De LangChain-agent verifieert de machtigingen, wijzigt de ticketstatus en brengt de juiste personen op de hoogte met behulp van de Amazon Simple Notification Service (Amazon SNS).

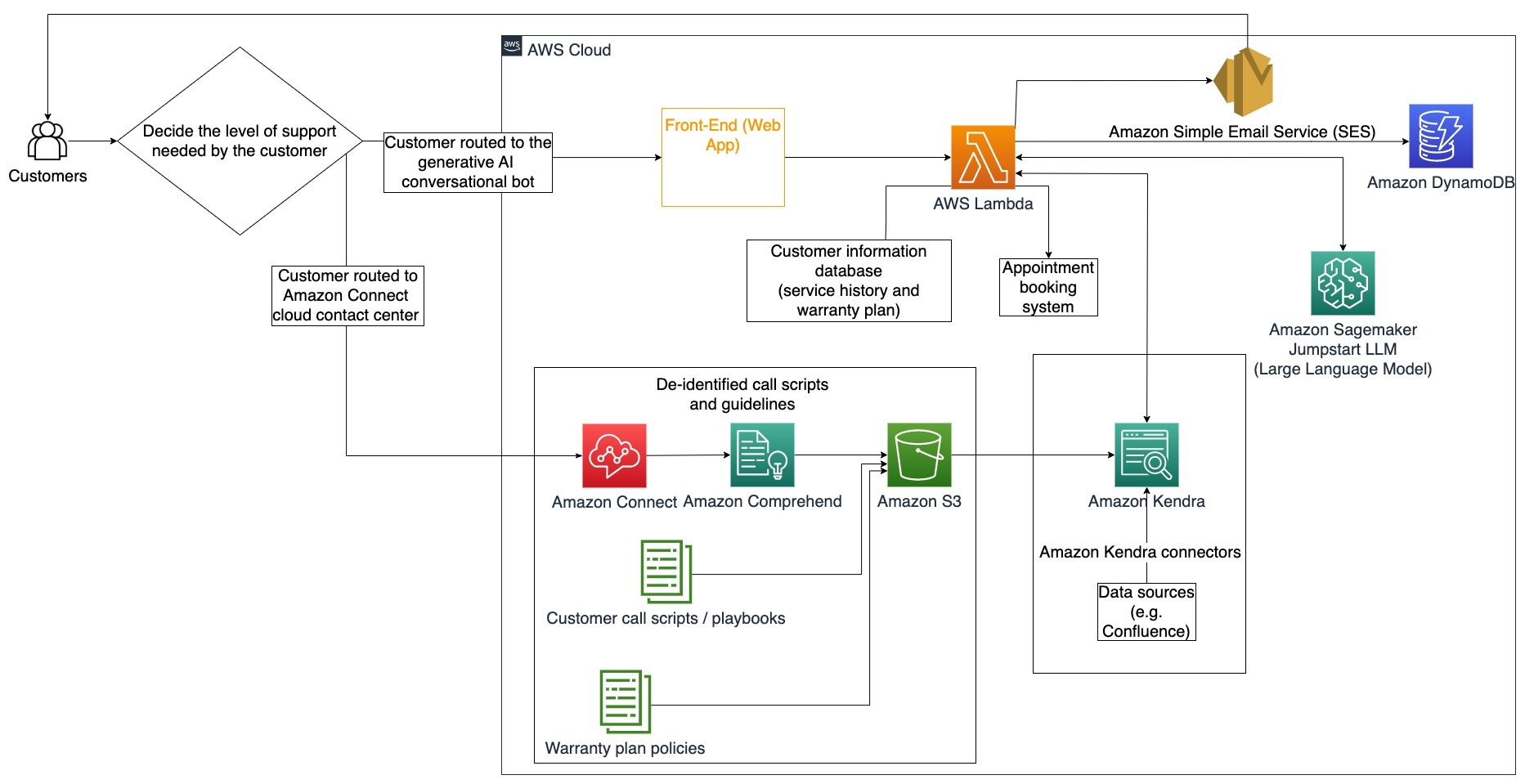

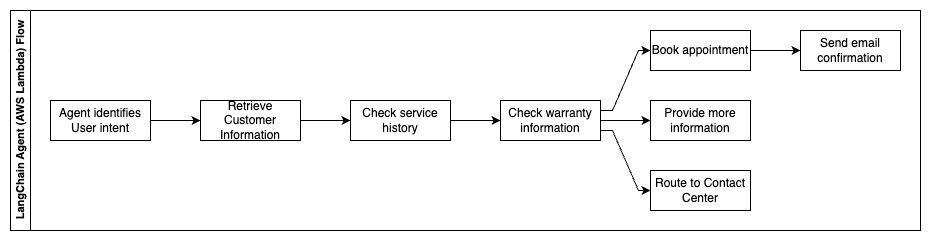

Klantenondersteuningsteams

Het snel oplossen van klantvragen verbetert de klantervaring en stimuleert merkloyaliteit. Een loyale klantenbasis helpt de verkoop te stimuleren, wat bijdraagt aan het bedrijfsresultaat en de klantbetrokkenheid vergroot. Klantenondersteuningsteams besteden veel energie aan het raadplegen van veel interne documenten en klantrelatiebeheersoftware om vragen van klanten over producten en diensten te beantwoorden. Interne documenten in deze context kunnen algemene scripts voor klantondersteuningsoproepen, draaiboeken, escalatierichtlijnen en bedrijfsinformatie omvatten. De generatieve AI-conversatiebot helpt bij kostenoptimalisatie omdat deze namens het klantenondersteuningsteam vragen afhandelt.

Specifiek gebruiksscenario: Het afhandelen van een olieverversingsverzoek op basis van de servicegeschiedenis en het aangeschafte klantenserviceplan.

In dit architectuurdiagram wordt de klant doorgestuurd naar de generatieve AI-gespreksbot of de Amazon Connect contact Centrum. Deze beslissing kan gebaseerd zijn op het benodigde ondersteuningsniveau of de beschikbaarheid van klantenservicemedewerkers. De LangChain-agent identificeert de intentie van de klant en verifieert de identiteit. De LangChain-agent controleert ook de servicegeschiedenis en het aangeschafte ondersteuningsplan.

De volgende stappen beschrijven de AWS Lambda-functies en hun stroom door het proces:

- LangChain-agent identificeert de intentie

- Klantinformatie ophalen

- Controleer de klantenservicegeschiedenis en garantie-informatie

- Maak een afspraak, geef meer informatie of routeer naar het contactcentrum

- Stuur een e-mailbevestiging

Amazon Connect wordt gebruikt om de spraak- en chatlogboeken te verzamelen, en Amazon Comprehend wordt gebruikt om persoonlijk identificeerbare informatie (PII) uit deze logbestanden te verwijderen. De Amazon Kendra-crawler kan vervolgens de geredigeerde stem- en chatlogboeken, klantoproepscripts en beleid voor klantenserviceondersteuning gebruiken om de index te maken. Zodra er een beslissing is genomen, beslist de generatieve AI-gespreksbot of een afspraak wordt geboekt, meer informatie wordt verstrekt of de klant naar het contactcentrum wordt doorgestuurd voor verdere hulp. Voor kostenoptimalisatie kan de LangChain-agent ook antwoorden genereren met minder tokens en een goedkoper groot taalmodel voor klantvragen met een lagere prioriteit.

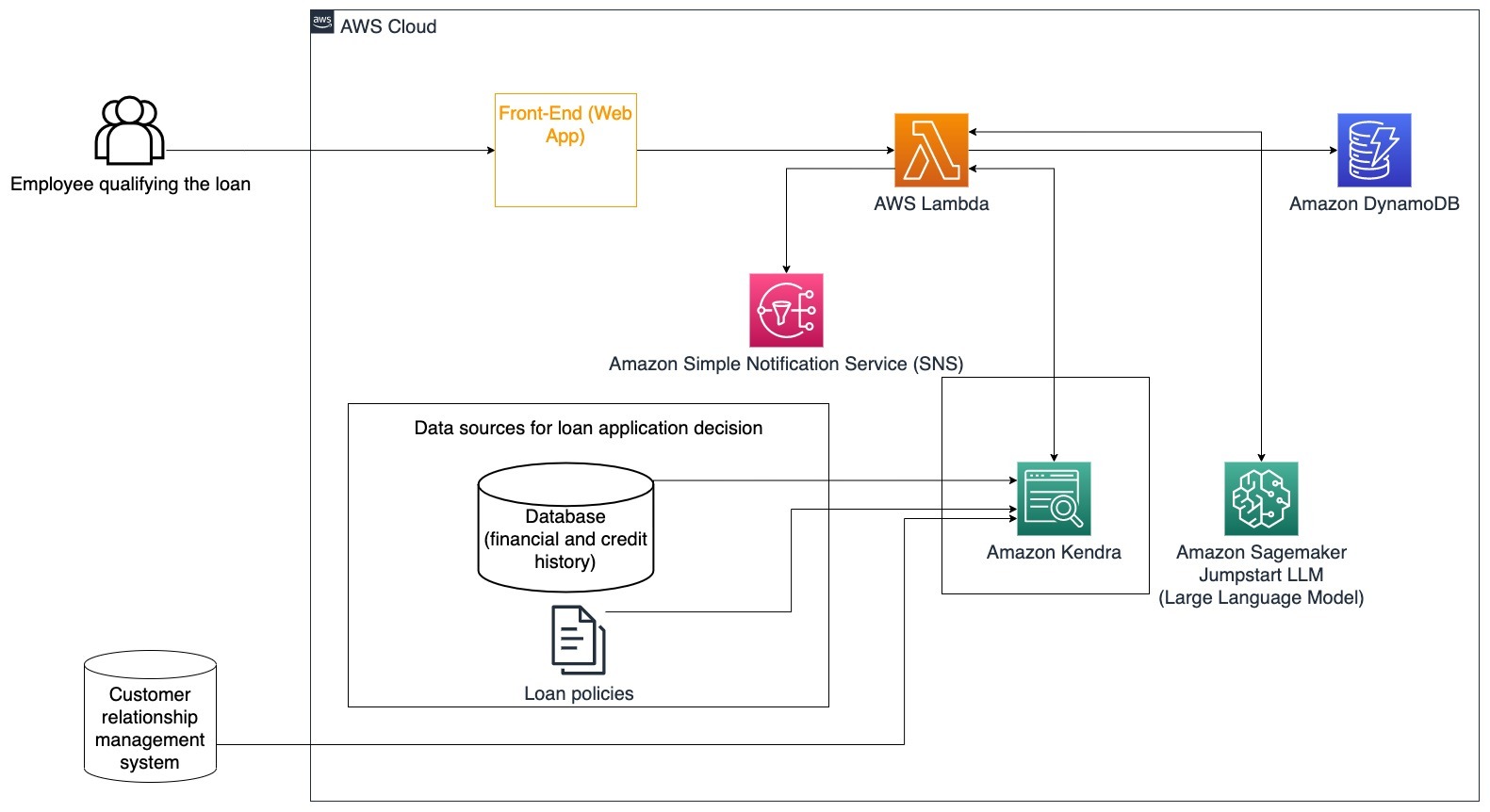

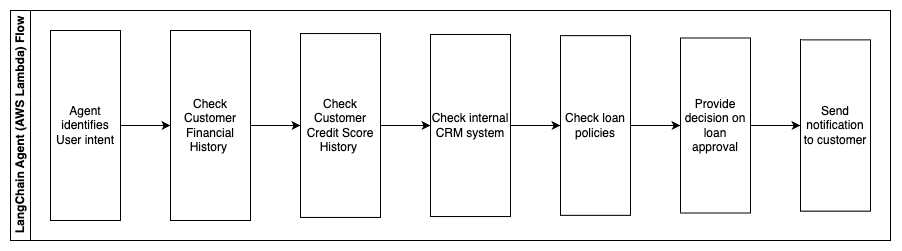

Financial Services

Financiële dienstverleners vertrouwen op het tijdige gebruik van informatie om concurrerend te blijven en aan de financiële regelgeving te voldoen. Met behulp van een generatieve AI-gespreksbot kunnen financiële analisten en adviseurs op een gemoedelijke manier met tekstuele informatie communiceren en de tijd en moeite verminderen die nodig is om beter geïnformeerde beslissingen te nemen. Buiten investeringen en marktonderzoek kan een generatieve AI-gespreksbot ook de menselijke capaciteiten vergroten door taken uit te voeren die traditioneel meer menselijke inspanning en tijd vergen. Een financiële instelling die gespecialiseerd is in persoonlijke leningen kan bijvoorbeeld de snelheid waarmee leningen worden verwerkt verhogen en tegelijkertijd een betere transparantie voor klanten bieden.

Specifiek gebruiksscenario: Gebruik de financiële geschiedenis van klanten en eerdere leningaanvragen om een leningbeslissing te nemen en uit te leggen.

De volgende stappen beschrijven de AWS Lambda-functies en hun stroom door het proces:

- LangChain-agent om de intentie te identificeren

- Controleer de financiële en kredietscoregeschiedenis van klanten

- Controleer het interne klantrelatiebeheersysteem

- Controleer het standaardleningbeleid en stel een beslissing voor voor de werknemer die in aanmerking komt voor de lening

- Melding naar klant sturen

Deze architectuur omvat financiële gegevens van klanten die zijn opgeslagen in een database en gegevens die zijn opgeslagen in een CRM-tool (Customer Relationship Management). Deze gegevenspunten worden gebruikt om een beslissing te nemen op basis van het interne leningbeleid van het bedrijf. De klant kan verduidelijkende vragen stellen om te begrijpen voor welke leningen hij in aanmerking komt en wat de voorwaarden zijn van de leningen die hij kan accepteren. Als de generatieve AI-conversatiebot een leningaanvraag niet kan goedkeuren, kan de gebruiker nog steeds vragen stellen over het verbeteren van kredietscores of alternatieve financieringsopties.

Overheid

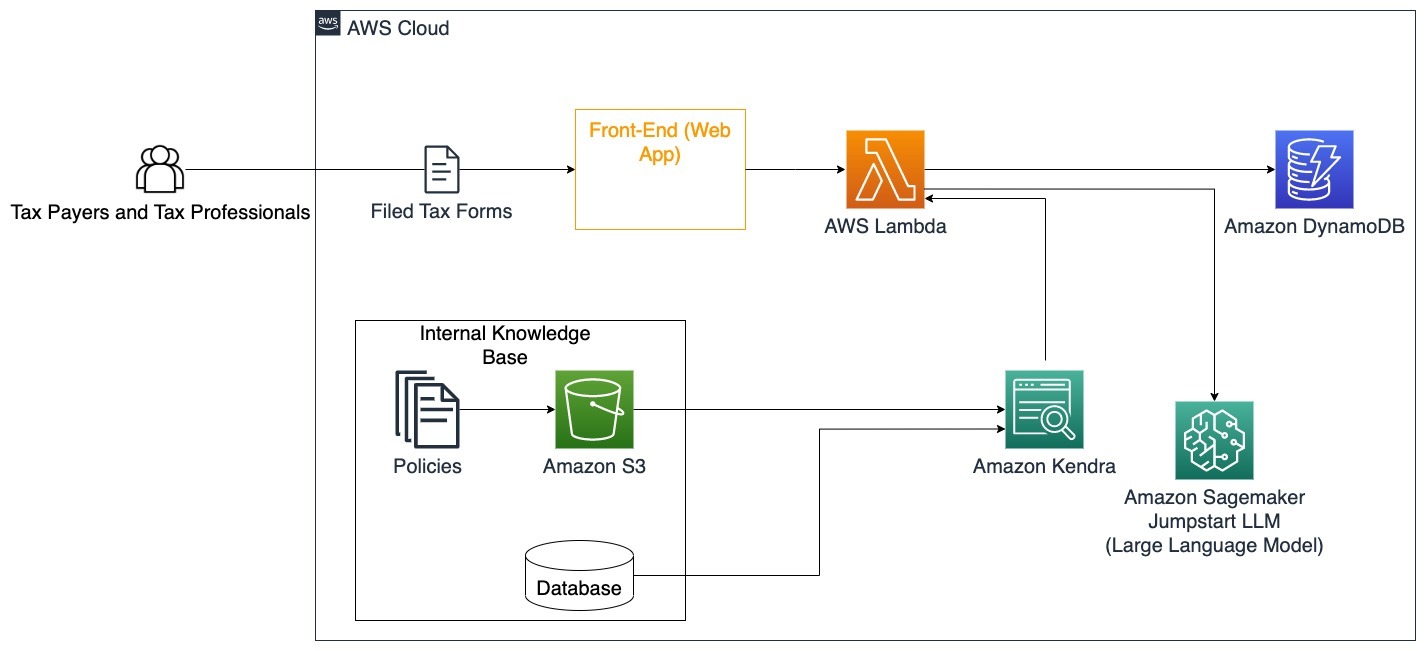

Generatieve AI-conversatiebots kunnen overheidsinstellingen enorm ten goede komen door de communicatie, efficiëntie en besluitvormingsprocessen te versnellen. Generatieve AI-conversatiebots kunnen ook directe toegang bieden tot interne kennisbanken om overheidsmedewerkers te helpen snel informatie, beleid en procedures op te halen (dwz geschiktheidscriteria, aanvraagprocessen en burgerdiensten en -ondersteuning). Eén oplossing is een interactief systeem waarmee belastingbetalers en belastingprofessionals gemakkelijk belastinggerelateerde details en voordelen kunnen vinden. Het kan worden gebruikt om gebruikersvragen te begrijpen, belastingdocumenten samen te vatten en duidelijke antwoorden te geven via interactieve gesprekken.

Gebruikers kunnen vragen stellen zoals:

- Hoe werkt de successierechten en wat zijn de fiscale drempels?

- Kunt u het begrip inkomstenbelasting uitleggen?

- Wat zijn de fiscale gevolgen bij de verkoop van een tweede woning?

Bovendien kunnen gebruikers het gemak hebben om belastingformulieren in te dienen bij een systeem, dat kan helpen de juistheid van de verstrekte informatie te verifiëren.

Deze architectuur illustreert hoe gebruikers ingevulde belastingformulieren naar de oplossing kunnen uploaden en deze kunnen gebruiken voor interactieve verificatie en begeleiding bij het nauwkeurig invullen van de benodigde informatie.

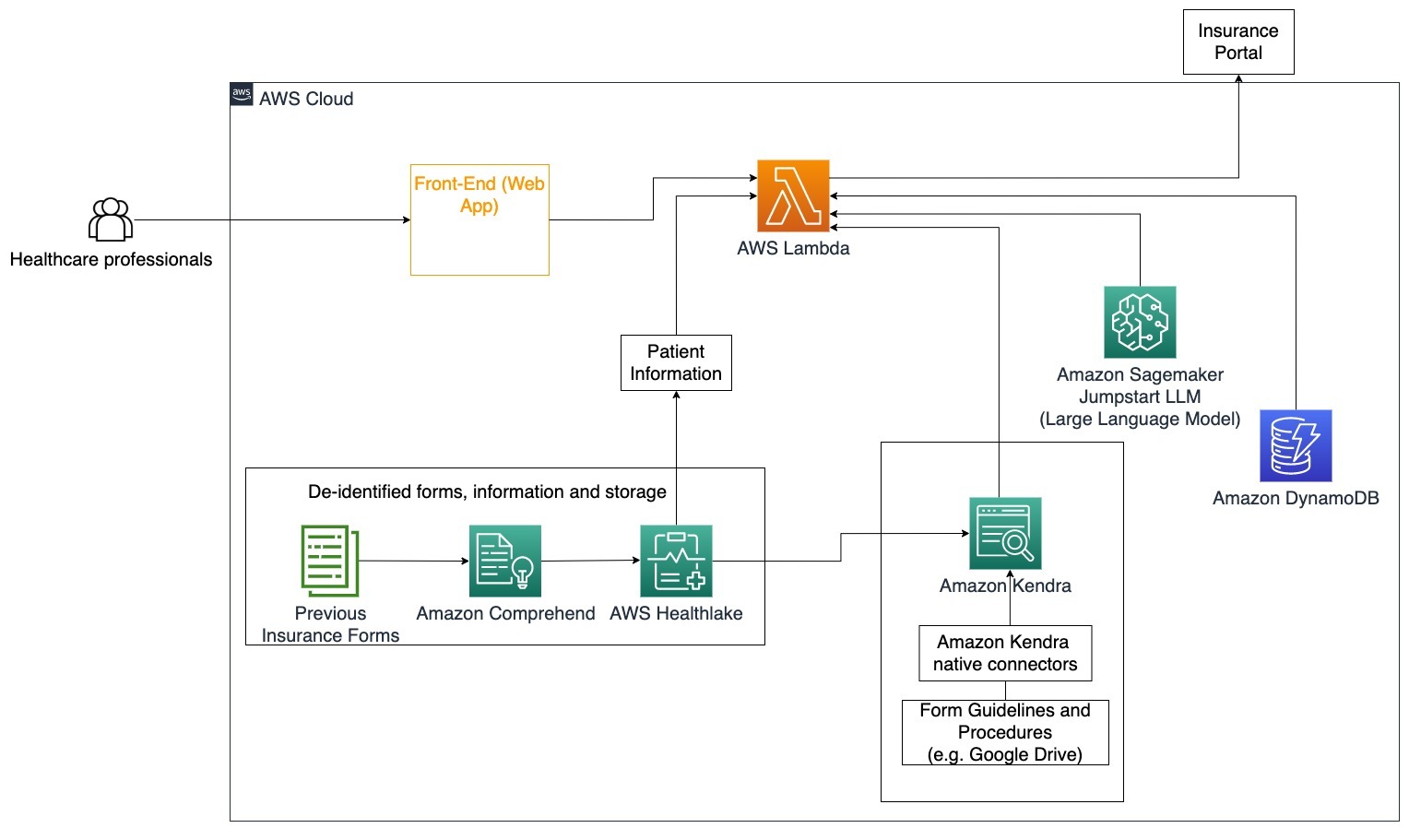

Gezondheidszorg

Bedrijven in de gezondheidszorg hebben de mogelijkheid om het gebruik van grote hoeveelheden interne patiëntinformatie te automatiseren, terwijl ze ook algemene vragen kunnen beantwoorden over gebruiksscenario's zoals behandelingsopties, verzekeringsclaims, klinische onderzoeken en farmaceutisch onderzoek. Het gebruik van een generatieve AI-conversatiebot maakt het snel en nauwkeurig genereren van antwoorden over gezondheidsinformatie uit de aangeboden kennisbank mogelijk. Sommige beroepsbeoefenaren in de gezondheidszorg besteden bijvoorbeeld veel tijd aan het invullen van formulieren om verzekeringsclaims in te dienen.

In vergelijkbare omstandigheden moeten beheerders van klinische onderzoeken en onderzoekers informatie vinden over behandelingsopties. Een generatieve AI-conversatiebot kan de vooraf gebouwde connectoren in Amazon Kendra gebruiken om de meest relevante informatie op te halen uit de miljoenen documenten die zijn gepubliceerd via lopend onderzoek uitgevoerd door farmaceutische bedrijven en universiteiten.

Specifiek gebruiksscenario: Verminder de fouten en de tijd die nodig is om verzekeringsformulieren in te vullen en te verzenden.

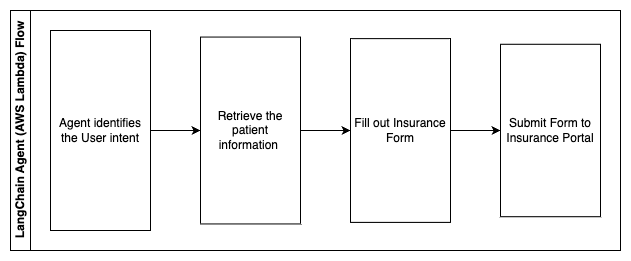

In dit architectuurdiagram kan een zorgprofessional de generatieve AI-gespreksbot gebruiken om erachter te komen welke formulieren voor de verzekering moeten worden ingevuld. De LangChain-agent kan vervolgens de juiste formulieren ophalen, de benodigde informatie voor een patiënt toevoegen en antwoorden geven op beschrijvende delen van de formulieren op basis van verzekeringspolissen en eerdere formulieren. De zorgprofessional kan de antwoorden van de LLM bewerken voordat hij het formulier goedkeurt en op het verzekeringsportaal laat bezorgen.

De volgende stappen beschrijven de AWS Lambda-functies en hun stroom door het proces:

- LangChain-agent om de intentie te identificeren

- Haal de benodigde patiëntinformatie op

- Vul het verzekeringsformulier in op basis van de patiëntgegevens en de formulierrichtlijn

- Dien het formulier na goedkeuring van de gebruiker in bij het verzekeringsportaal

AWS HealthLake wordt gebruikt om de gezondheidsgegevens, inclusief eerdere verzekeringsformulieren en patiëntinformatie, veilig op te slaan, en Amazon Comprehend wordt gebruikt om persoonlijk identificeerbare informatie (PII) van de eerdere verzekeringsformulieren te verwijderen. De Amazon Kendra-crawler kan vervolgens de set verzekeringsformulieren en richtlijnen gebruiken om de index te maken. Zodra de formulier(en) zijn ingevuld door de generatieve AI, kunnen de door de medische professional beoordeelde formulier(en) naar het verzekeringsportaal worden verzonden.

Kostenraming

De kosten voor het inzetten van de basisoplossing als proof-of-concept worden weergegeven in de volgende tabel. Omdat de basisoplossing wordt beschouwd als een proof-of-concept, werd Amazon Kendra Developer Edition gebruikt als een goedkope optie, omdat de werklast niet in productie zou zijn. Onze veronderstelling voor Amazon Kendra Developer Edition was 730 actieve uren voor de maand.

Voor Amazon SageMaker gingen we ervan uit dat de klant de ml.g4dn.2xlarge-instantie zou gebruiken voor realtime inferentie, met één inferentie-eindpunt per instantie. U kunt meer informatie vinden over de prijzen van Amazon SageMaker en de beschikbare typen inferentie-instanties hier.

| Service | Verbruikte hulpbronnen | Kostenraming per maand in USD |

| AWS versterken | 150 bouwminuten 1 GB aan gegevens geserveerd 500,000 verzoeken |

15.71 |

| Amazon API-gateway | 1 miljoen REST API-oproepen | 3.5 |

| AWS Lambda | 1 miljoen verzoeken Duur van 5 seconden per verzoek 2 GB geheugen toegewezen |

160.23 |

| Amazon DynamoDB | 1 miljoen keer gelezen 1 miljoen schrijft 100 GB opslag |

26.38 |

| Amazone Saliemaker | Realtime gevolgtrekking met ml.g4dn.2xlarge | 676.8 |

| Amazon Kendra | Developer Edition met 730 uur/maand 10,000 documenten gescand 5,000 zoekopdrachten/dag |

821.25 |

| . | . | Totale kosten: 1703.87 |

* Amazon Cognito heeft een gratis niveau van 50,000 maandelijks actieve gebruikers die Cognito-gebruikerspools gebruiken of 50 maandelijks actieve gebruikers die SAML 2.0-identiteitsproviders gebruiken

Clean Up

Om kosten te besparen, verwijdert u alle resources die u als onderdeel van de zelfstudie hebt geïmplementeerd. U kunt alle SageMaker-eindpunten verwijderen die u mogelijk via de SageMaker-console hebt gemaakt. Houd er rekening mee dat het verwijderen van een Amazon Kendra-index niet de originele documenten uit uw opslag verwijdert.

Conclusie

In dit bericht hebben we u laten zien hoe u de toegang tot interne informatie kunt vereenvoudigen door in realtime samen te vatten vanuit meerdere opslagplaatsen. Na de recente ontwikkelingen van commercieel verkrijgbare LLM’s zijn de mogelijkheden van generatieve AI duidelijker geworden. In dit bericht hebben we manieren laten zien om AWS-services te gebruiken om een serverloze chatbot te creëren die generatieve AI gebruikt om vragen te beantwoorden. Deze aanpak omvat een authenticatielaag en de PII-detectie van Amazon Comprehend om alle gevoelige informatie uit de zoekopdracht van de gebruiker eruit te filteren. Of het nu individuen in de gezondheidszorg zijn die de nuances begrijpen bij het indienen van verzekeringsclaims of HR die specifieke bedrijfsbrede regelgeving begrijpt, er zijn meerdere sectoren en branches die van deze aanpak kunnen profiteren. Een Amazon SageMaker JumpStart-basismodel is de motor achter de chatbot, terwijl een context-opvullen-aanpak met behulp van de RAG-techniek wordt gebruikt om ervoor te zorgen dat de antwoorden nauwkeuriger naar interne documenten verwijzen.

Voor meer informatie over het werken met generatieve AI op AWS raadpleegt u Aankondiging van nieuwe tools voor bouwen met generatieve AI op AWS. Voor meer diepgaande richtlijnen over het gebruik van de RAG-techniek met AWS-services, raadpleegt u Bouw snel zeer nauwkeurige generatieve AI-applicaties op bedrijfsgegevens met behulp van Amazon Kendra, LangChain en grote taalmodellen. Omdat de aanpak in deze blog LLM-agnostisch is, kan elke LLM worden gebruikt voor gevolgtrekking. In ons volgende bericht zullen we manieren schetsen om deze oplossing te implementeren met behulp van Amazon Bedrock en de Amazon Titan LLM.

Over de auteurs

Abhishek Maligehalli Shivalingaiah is een Senior AI Services Solution Architect bij AWS. Hij heeft een passie voor het bouwen van applicaties met behulp van Generatieve AI, Amazon Kendra en NLP. Hij heeft ongeveer 10 jaar ervaring in het bouwen van data- en AI-oplossingen om waarde te creëren voor klanten en ondernemingen. Hij heeft zelfs voor de lol een (persoonlijke) chatbot gebouwd om vragen over zijn carrière en professionele reis te beantwoorden. Buiten zijn werk maakt hij graag portretten van familie en vrienden, en maakt hij graag kunstwerken.

Abhishek Maligehalli Shivalingaiah is een Senior AI Services Solution Architect bij AWS. Hij heeft een passie voor het bouwen van applicaties met behulp van Generatieve AI, Amazon Kendra en NLP. Hij heeft ongeveer 10 jaar ervaring in het bouwen van data- en AI-oplossingen om waarde te creëren voor klanten en ondernemingen. Hij heeft zelfs voor de lol een (persoonlijke) chatbot gebouwd om vragen over zijn carrière en professionele reis te beantwoorden. Buiten zijn werk maakt hij graag portretten van familie en vrienden, en maakt hij graag kunstwerken.

Medha Aiyah is een Associate Solutions Architect bij AWS, gevestigd in Austin, Texas. Ze studeerde onlangs in december 2022 af aan de Universiteit van Texas in Dallas met haar Masters of Science in Computer Science met een specialisatie in intelligente systemen met de nadruk op AI/ML. Ze wil graag meer leren over AI/ML en het gebruik van AWS-services om oplossingen te ontdekken waar klanten van kunnen profiteren.

Medha Aiyah is een Associate Solutions Architect bij AWS, gevestigd in Austin, Texas. Ze studeerde onlangs in december 2022 af aan de Universiteit van Texas in Dallas met haar Masters of Science in Computer Science met een specialisatie in intelligente systemen met de nadruk op AI/ML. Ze wil graag meer leren over AI/ML en het gebruik van AWS-services om oplossingen te ontdekken waar klanten van kunnen profiteren.

Hugo Tse is een Associate Solutions Architect bij AWS, gevestigd in Seattle, Washington. Hij heeft een masterdiploma in informatietechnologie van de Arizona State University en een bachelordiploma in economie van de Universiteit van Chicago. Hij is lid van de Information Systems Audit and Control Association (ISACA) en het International Information System Security Certification Consortium (ISC)2. Hij vindt het leuk om klanten te helpen profiteren van technologie.

Hugo Tse is een Associate Solutions Architect bij AWS, gevestigd in Seattle, Washington. Hij heeft een masterdiploma in informatietechnologie van de Arizona State University en een bachelordiploma in economie van de Universiteit van Chicago. Hij is lid van de Information Systems Audit and Control Association (ISACA) en het International Information System Security Certification Consortium (ISC)2. Hij vindt het leuk om klanten te helpen profiteren van technologie.

Ayman Ishimwe is een Associate Solutions Architect bij AWS, gevestigd in Seattle, Washington. Hij heeft een masterdiploma in Software Engineering en IT behaald aan de Oakland University. Hij heeft eerdere ervaring in softwareontwikkeling, met name in het bouwen van microservices voor gedistribueerde webapplicaties. Hij heeft een passie voor het helpen van klanten bij het bouwen van robuuste en schaalbare oplossingen op AWS-cloudservices volgens best practices.

Ayman Ishimwe is een Associate Solutions Architect bij AWS, gevestigd in Seattle, Washington. Hij heeft een masterdiploma in Software Engineering en IT behaald aan de Oakland University. Hij heeft eerdere ervaring in softwareontwikkeling, met name in het bouwen van microservices voor gedistribueerde webapplicaties. Hij heeft een passie voor het helpen van klanten bij het bouwen van robuuste en schaalbare oplossingen op AWS-cloudservices volgens best practices.

Shervin Suresh is een Associate Solutions Architect bij AWS, gevestigd in Austin, Texas. Hij is afgestudeerd met een Masters in Software Engineering met een concentratie in Cloud Computing en Virtualisatie en een Bachelors in Computer Engineering aan de San Jose State University. Hij heeft een passie voor het inzetten van technologie om de levens van mensen van alle achtergronden te helpen verbeteren.

Shervin Suresh is een Associate Solutions Architect bij AWS, gevestigd in Austin, Texas. Hij is afgestudeerd met een Masters in Software Engineering met een concentratie in Cloud Computing en Virtualisatie en een Bachelors in Computer Engineering aan de San Jose State University. Hij heeft een passie voor het inzetten van technologie om de levens van mensen van alle achtergronden te helpen verbeteren.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- ChartPrime. Verhoog uw handelsspel met ChartPrime. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- : heeft

- :is

- :niet

- :waar

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- in staat

- Over

- ACCEPTEREN

- toegang

- toegang

- accounts

- accuraat

- nauwkeurig

- acties

- actieve

- toevoegen

- Daarnaast

- adressen

- aanpakken

- beheerders

- De goedkeuring van

- adviseurs

- Na

- Agent

- agenten

- aggregaat

- AI

- AI-diensten

- AI / ML

- Alles

- toestaat

- langs

- ook

- alternatief

- Amazone

- Amazon API-gateway

- Amazon Cognito

- Amazon begrijpt het

- Amazon Kendra

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- bedragen

- hoeveelheden

- an

- analisten

- analyseert

- en

- beantwoorden

- antwoorden

- elke

- api

- schijnbaar

- Aanvraag

- toepassingen

- afspraak

- nadering

- goedkeuren

- architectuur

- ZIJN

- ontstaan

- Arizona

- rond

- dit artikel

- kunstmatig

- kunstmatige intelligentie

- Kunstmatige intelligentie (AI)

- kunstwerken

- AS

- vragen

- aspecten

- schatten

- helpen

- Hulp

- Associëren

- geassocieerd

- Vereniging

- aanname

- At

- controleren

- aangevuld

- austin

- geverifieerd

- authenticatie

- machtiging

- automatiseren

- webmaster.

- beschikbaarheid

- Beschikbaar

- AWS

- AWS Lambda

- terug

- achtergronden

- baseren

- gebaseerde

- BE

- Beer

- omdat

- worden

- wordt

- geweest

- vaardigheden

- namens

- achter

- voordeel

- betekent

- BEST

- 'best practices'

- Betere

- Blog

- boek

- Bot

- zowel

- bots

- Onder

- merk

- begroting

- bouw

- Gebouw

- bebouwd

- bedrijfsdeskundigen

- ondernemingen

- maar

- by

- Bellen

- CAN

- mogelijkheden

- Carrière

- voorzichtig

- geval

- gevallen

- Categorie

- veroorzaakt

- Centreren

- gecentraliseerde

- zeker

- Certificering

- keten

- uitdagingen

- verandering

- opgeladen

- Chatbot

- controleren

- Controles

- chicago

- vorderingen

- duidelijk

- Klinisch

- klinische proeven

- Cloud

- cloud computing

- cloud-diensten

- verzamelen

- Collectie

- commercieel

- Gemeen

- Communicatie

- Bedrijven

- afstand

- Bedrijf

- concurrerend

- Voltooid

- het invullen van

- complex

- ingewikkeldheid

- voldoen

- begrijpen

- computer

- Computertechniek

- Computer Science

- computergebruik

- concentratie

- concept

- beknopt

- uitgevoerd

- samenvloeiing

- Verbinden

- verbindt

- overweging

- overwegingen

- beschouwd

- consequent

- bestaande uit

- troosten

- consortium

- consumeren

- consumptie

- contact

- contactcentrum

- bevat

- content

- verband

- doorlopend

- draagt bij

- onder controle te houden

- het regelen van

- gemak

- Gesprek

- spraakzaam

- conversaties

- Bedrijfs-

- te corrigeren

- Kosten

- Kosten

- crawler

- en je merk te creëren

- Waarde creëren

- aangemaakt

- Wij creëren

- Credits

- criteria

- kritisch

- CRM

- cruciaal

- curated

- Actueel

- Op dit moment

- klant

- Klantbinding

- klantervaring

- Klantenservice

- Klantenservice

- Klanten

- dagelijks

- Dallas

- gegevens

- data punten

- gegevenssets

- Database

- Datum

- December

- beslissen

- beslissing

- Besluitvorming

- beslissingen

- Mate

- geleverd

- Afhankelijk

- ingezet

- het inzetten

- beschrijven

- Design

- Niettegenstaande

- gegevens

- gedetecteerd

- Opsporing

- Ontwikkelaar

- Ontwikkeling

- ontwikkelingen

- anders

- moeilijk

- Onthul Nu

- verdeeld

- documentatie

- documenten

- doet

- Nee

- rit

- duur

- e

- gemakkelijker

- gemakkelijk

- Economie

- ecosysteem

- editie

- doeltreffendheid

- inspanning

- beide

- verkiesbaarheid

- e-mails

- Werknemer

- medewerkers

- maakt

- moedigt

- Endpoint

- energie-niveau

- engagement

- Motor

- Engineering

- verrijkende

- verzekeren

- waarborgt

- zorgen

- Enterprise

- bedrijven

- entiteiten

- fouten

- escalatie

- schatting

- etc

- Zelfs

- voorbeeld

- uitvoeren

- bestaand

- duur

- ervaring

- Verklaren

- Verklaart

- extractie

- extracten

- Gezicht

- familie

- Kenmerk

- Fed

- minder

- Figuur

- Dien in

- vullen

- gevuld

- vulling

- filter

- financieel

- financiële data

- financiële geschiedenis

- financiele instelling

- financiering

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- het vinden van

- Voornaam*

- Flexibiliteit

- stroom

- gericht

- volgend

- Voor

- formulier

- formulieren

- forums

- gevonden

- Foundation

- frameworks

- Gratis

- vrienden

- oppompen van

- leuke

- functie

- functies

- verder

- Krijgen

- poort

- voortbrengen

- generatie

- generatief

- generatieve AI

- krijgen

- gegeven

- geeft

- Vrijgevigheid

- Kopen Google Reviews

- Overheid

- sterk

- Groeien

- Groeiend

- Groeit

- leiding

- richtlijnen

- handvat

- Handvaten

- Behandeling

- Hebben

- met

- he

- Gezondheid

- gezondheidsinformatie

- gezondheidszorg

- hulp

- het helpen van

- helpt

- haar

- Hoge

- zeer

- zijn

- geschiedenis

- houdt

- gehost

- hosts

- HOURS

- Hoe

- How To

- Echter

- hr

- HTML

- HTTPS

- menselijk

- i

- identificatie

- identifiers

- identificeert

- identificeren

- het identificeren van

- Identiteit

- if

- illustreert

- uitvoeren

- uitvoering

- implicaties

- verbeteren

- verbetert

- het verbeteren van

- in

- diepgaande

- onnauwkeurig

- omvatten

- omvat

- Inclusief

- Inkomen

- inkomstenbelasting

- Laat uw omzet

- Verhoogt

- index

- geïndexeerd

- indexen

- individuen

- industrieën

- informeren

- informatie

- Informatie Systemen

- informatietechnologie

- op de hoogte

- erfenis

- invoer

- instantie

- moment

- verkrijgen in plaats daarvan

- Instelling

- instellingen

- verzekering

- geïntegreerde

- integreert

- integratie

- Intelligentie

- Intelligent

- aandachtig

- interactie

- interactieve

- geïnteresseerd

- Interface

- intern

- Internationale

- in

- investering

- kwestie

- IT

- artikelen

- jpg

- Houden

- kennis

- bekend

- taal

- Groot

- lagen

- leiden

- LEARN

- leren

- minder

- Niveau

- leveraging

- Bibliotheek

- beperking

- beperkingen

- Lijn

- Lives

- LLM

- lening

- Leningen

- inloggen

- logisch

- lang

- lange tijd

- langer

- Kijk

- lot

- houdt

- Low-cost

- te verlagen

- loyaal

- Loyaliteit

- machine

- machine learning

- gemaakt

- onderhouden

- maken

- MERKEN

- maken

- beheer

- management

- manier

- handboek

- handmatig

- veel

- Markt

- marktonderzoek

- master's

- Mei..

- middel

- medisch

- lid

- Geheugen

- microservices

- Microsoft

- miljoen

- miljoenen

- denken

- ML

- model

- modellen

- Module

- Maand

- maandelijks

- meer

- meest

- meervoudig

- inheemse

- noodzakelijk

- Noodzaak

- nodig

- behoeften

- New

- volgende

- nlp

- notificatie

- nummers

- Oakland

- OAuth

- of

- Aanbod

- vaak

- Olie

- on

- Onboarding

- eens

- EEN

- lopend

- Slechts

- open

- besturen

- werkzaam

- operationele

- kansen

- optimalisatie

- Keuze

- Opties

- or

- bestellen

- organisaties

- origineel

- Overige

- onze

- uit

- schets

- buiten

- over

- paradigma

- deel

- onderdelen

- voorbij

- hartstochtelijk

- patiënt

- Betaal

- Mensen

- voor

- prestatie

- permissies

- persoonlijk

- persoonlijke gegevens

- Persoonlijk

- Farmaceutisch

- Pijler

- plan

- Plato

- Plato gegevensintelligentie

- PlatoData

- dan

- punt

- punten

- beleidsmaatregelen door te lezen.

- Zwembaden

- Portaal

- portretten

- mogelijkheden

- mogelijkheid

- Post

- aangedreven

- praktijken

- presenteren

- voorkomen

- vorig

- die eerder

- prijsstelling

- prijs model

- Voorafgaand

- prioriteit

- privacy

- problemen

- procedures

- gaan

- Verwerkt

- processen

- verwerking

- productie

- produktiviteit

- Producten

- professioneel

- professionals

- eigendom

- zorgen voor

- mits

- providers

- het verstrekken van

- gepubliceerde

- gekocht

- Q & A

- kwalificeren

- kwalificatie

- queries

- vraag

- Contact

- Quick

- snel

- reeks

- tarief

- Lees

- lezing

- real-time

- recent

- onlangs

- verminderen

- vermindert

- verwijzen

- referencing

- met betrekking tot

- regelmatig

- reglement

- verwantschap

- relevantie

- relevante

- vertrouwen

- stoffelijk overschot

- niet vergeten

- verwijderen

- te vragen

- verzoeken

- vereisen

- nodig

- Voorwaarden

- onderzoek

- onderzoekers

- Resolutie

- oplossen

- Resources

- antwoord

- reacties

- verantwoordelijkheid

- REST

- resultaat

- terugkerende

- beoordeeld

- rechts

- risico's

- robuust

- weg

- lopend

- s

- sagemaker

- verkoop

- heilige

- San Jose

- tevredenheid

- Bespaar

- schaalbare

- Scale

- scenario

- Wetenschap

- partituur

- scripts

- Ontdek

- zoeken

- Seattle

- Tweede

- seconden

- sectie

- beveiligen

- vast

- veiligheid

- binnen XNUMX minuten

- sturen

- senior

- gevoelig

- verzonden

- Serverless

- bedient

- service

- Diensten

- reeks

- Sets

- settings

- verscheidene

- ze

- verschuiving

- tekortkomingen

- moet

- tentoongesteld

- vertoonde

- getoond

- silo's

- gelijk

- Eenvoudig

- vereenvoudigen

- sinds

- single

- sized

- kleinere

- So

- Social

- Software

- software development

- software engineering

- oplossing

- Oplossingen

- sommige

- bron

- bronnen

- gespecialiseerd

- specifiek

- specifiek

- besteden

- Uitgaven

- standaard

- Land

- Status

- blijven

- Stap voor

- Stappen

- Still

- mediaopslag

- shop

- opgeslagen

- bewaartemperatuur

- spanning

- vulling

- wezenlijk

- dergelijk

- stel

- samenvatten

- ondersteuning

- system

- Systems

- tafel

- neemt

- taken

- belasting

- team

- teams

- Technologie

- termen

- Texas

- tekst

- tekstueel

- dat

- De

- de informatie

- hun

- zich

- harte

- Er.

- Deze

- ze

- van derden

- dit

- Door

- ticket

- ticketing

- rij

- niet de tijd of

- tijdrovend

- actuele

- keer

- tijdstempel

- Titan

- naar

- vandaag

- tokens

- tools

- tools

- Traceerbaarheid

- traditioneel

- getraind

- Trainingen

- transformator

- Transparantie

- behandeling

- proces

- proeven

- zelfstudie

- types

- niet in staat

- begrijpen

- begrip

- unieke

- Universiteiten

- universiteit-

- University of Chicago

- up-to-date

- bijgewerkt

- bijwerken

- .

- use case

- gebruikt

- Gebruiker

- gebruikers

- toepassingen

- gebruik

- gebruik maken van

- gebruikt

- Gebruik makend

- waarde

- divers

- Verificatie

- controleren

- verticals

- via

- Video

- Video's

- Stem

- wachten

- Het wachten

- was

- Washington

- manieren

- we

- web

- web applicatie

- Webapplicaties

- webservices

- GOED

- waren

- Wat

- wanneer

- of

- welke

- en

- WIE

- breed

- Grote range

- Met

- binnen

- Mijn werk

- workflow

- werkzaam

- zou

- geschreven

- jaar

- You

- Your

- zephyrnet