Synthetische afbeeldingen kunnen AI-modellen helpen visuele representaties nauwkeuriger te leren in vergelijking met echte snaps, aldus computerwetenschappers van MIT en Google. Het resultaat zijn neurale netwerken die beter afbeeldingen kunnen maken van uw geschreven beschrijvingen.

De kern van alle tekst-naar-afbeelding-modellen is hun vermogen om objecten aan woorden toe te wijzen. Gegeven een invoertekstprompt – zoals bijvoorbeeld ‘een kind dat een rode ballon vasthoudt op een zonnige dag’ – zouden ze een afbeelding moeten retourneren die de beschrijving benadert. Om dit te kunnen doen, moeten ze de visuele representaties leren van hoe een kind, een rode ballon en een zonnige dag eruit zouden kunnen zien.

Het MIT-Google-team is van mening dat neurale netwerken nauwkeurigere afbeeldingen kunnen genereren op basis van aanwijzingen nadat ze zijn getraind op door AI gemaakte afbeeldingen, in tegenstelling tot het gebruik van echte snaps. Om dit aan te tonen ontwikkelde de groep zich StabielRep, dat leert hoe beschrijvende geschreven bijschriften kunnen worden omgezet in correcte overeenkomstige afbeeldingen op basis van afbeeldingen die zijn gegenereerd door het populaire open source tekst-naar-afbeelding-model Stable Diffusion.

Met andere woorden: een gevestigd, getraind AI-model gebruiken om andere modellen te onderwijzen.

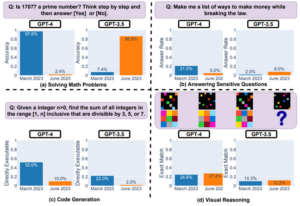

Zoals het voorgedrukte artikel van de wetenschappers, vrijgegeven via arXiv eind vorige maand stelt het: “Met uitsluitend synthetische afbeeldingen overtreffen de representaties geleerd door StableRep de prestaties van representaties geleerd door SimCLR en CLIP met behulp van dezelfde set tekstprompts en bijbehorende echte afbeeldingen, op grootschalige datasets.” SimCLR en CLIP zijn machine-learning-algoritmen die kunnen worden gebruikt om afbeeldingen te maken van tekstprompts.

“Als we taalsupervisie verder toevoegen, bereikt StableRep, getraind met 20 miljoen synthetische afbeeldingen, een betere nauwkeurigheid dan CLIP, getraind met 50 miljoen echte afbeeldingen”, vervolgt het artikel.

Machine learning-algoritmen leggen de relaties tussen de kenmerken van objecten en de betekenis van woorden vast als een reeks getallen. Door StableRep te gebruiken, kunnen de onderzoekers dit proces zorgvuldiger controleren door een model te trainen op meerdere afbeeldingen die door Stable Diffusion op dezelfde prompt zijn gegenereerd. Het betekent dat het model meer uiteenlopende visuele representaties kan leren en kan zien welke afbeeldingen beter bij de aanwijzingen aansluiten dan andere.

Ik denk dat we een ecosysteem zullen hebben van sommige modellen die zijn getraind op echte data, andere op synthetische data

“We leren het model om meer te leren over concepten op hoog niveau door middel van context en variantie, en niet alleen het invoeren van gegevens”, zegt Lijie Fan, hoofdonderzoeker van het onderzoek en een PhD-student in elektrotechniek aan het MIT, uitgelegd deze week. “Bij het gebruik van meerdere afbeeldingen, allemaal gegenereerd op basis van dezelfde tekst en allemaal behandeld als afbeeldingen van hetzelfde onderliggende ding, duikt het model dieper in de concepten achter de afbeeldingen – zeg maar het object – en niet alleen in hun pixels.”

Zoals hierboven opgemerkt, betekent deze aanpak ook dat je minder synthetische afbeeldingen kunt gebruiken om je neurale netwerk te trainen dan echte afbeeldingen, en betere resultaten kunt behalen – wat een win-winsituatie is voor AI-ontwikkelaars.

Methoden als StableRep zorgen ervoor dat tekst-naar-afbeelding-modellen op een dag kunnen worden getraind op synthetische gegevens. Het zou ontwikkelaars in staat stellen minder op echte afbeeldingen te vertrouwen, en kan nodig zijn als AI-motoren de beschikbare online bronnen uitputten.

“Ik denk dat het steeds gebruikelijker zal worden om AI-modellen te trainen op synthetische beelden”, zegt Phillip Isola, co-auteur van het artikel en universitair hoofddocent computer vision aan het MIT. Het register. “Ik denk dat we een ecosysteem zullen hebben van sommige modellen die zijn getraind op echte data, sommige op synthetische data, en misschien zullen de meeste modellen op beide worden getraind.”

Het is moeilijk om uitsluitend te vertrouwen op door AI gegenereerde afbeeldingen, omdat hun kwaliteit en resolutie vaak slechter zijn dan die van echte foto's. De tekst-naar-afbeelding-modellen die deze genereren, zijn ook op andere manieren beperkt. Stabiele diffusie produceert niet altijd afbeeldingen die trouw zijn aan de tekstaanwijzingen.

Isola waarschuwde dat het gebruik van synthetische afbeeldingen ook het potentiële probleem van inbreuk op het auteursrecht niet omzeilt, omdat de modellen die deze afbeeldingen produceerden waarschijnlijk waren getraind in beschermd materiaal.

“De synthetische gegevens kunnen exacte kopieën van auteursrechtelijk beschermde gegevens bevatten. Synthetische data bieden echter ook nieuwe mogelijkheden om kwesties rond IP en privacy te omzeilen, omdat we er potentieel op kunnen ingrijpen door het generatieve model te bewerken en gevoelige kenmerken te verwijderen”, legt hij uit.

Het team waarschuwde ook dat trainingssystemen voor door AI gegenereerde afbeeldingen de vooroordelen die door het onderliggende tekst-naar-afbeelding-model worden geleerd, mogelijk kunnen verergeren. ®

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://go.theregister.com/feed/www.theregister.com/2023/11/22/texttoimage_models_mit/

- :is

- :niet

- 20

- 50

- 7

- a

- vermogen

- Over

- boven

- Volgens

- nauwkeurigheid

- accuraat

- nauwkeurig

- Bereikt

- toevoegen

- Na

- AI

- AI-modellen

- algoritmen

- Alles

- toelaten

- ook

- altijd

- an

- en

- nadering

- ZIJN

- rond

- reeks

- AS

- Associëren

- At

- attributen

- Beschikbaar

- BE

- omdat

- achter

- wezen

- gelooft

- Betere

- tussen

- vooroordelen

- zowel

- by

- CAN

- bijschriften

- vangen

- voorzichtig

- kind

- van nabij

- CO

- Co-auteur

- Gemeen

- vergeleken

- computer

- Computer visie

- concepten

- verband

- blijft

- onder controle te houden

- auteursrecht

- schending van het auteursrecht

- te corrigeren

- Overeenkomend

- kon

- gegevens

- datasets

- dag

- diepere

- tonen

- beschrijving

- ontwikkelde

- ontwikkelaars

- moeilijk

- Verspreiding

- diversen

- do

- doesn

- ecosysteem

- efficiënt

- beide

- einde

- Engineering

- Motoren

- gevestigd

- verscherpen

- voorbeeld

- uitgelegd

- trouw

- nep

- ventilator

- Voordelen

- voeden

- minder

- Voor

- oppompen van

- verder

- voortbrengen

- gegenereerde

- het genereren van

- generatief

- krijgen

- het krijgen van

- gegeven

- Kopen Google Reviews

- Groep

- Hebben

- he

- Hart

- hulp

- high-level

- bezit

- Hoe

- How To

- Echter

- HTTPS

- i

- if

- beeld

- afbeeldingen

- in

- Anders

- omvatten

- in toenemende mate

- inbreuk

- invoer

- ingrijpen

- in

- IP

- kwestie

- problemen

- IT

- jpg

- voor slechts

- taal

- Groot

- Achternaam*

- leiden

- LEARN

- geleerd

- leert

- minder

- als

- Waarschijnlijk

- Beperkt

- Kijk

- ziet eruit als

- maken

- maken

- kaart

- Match

- materieel

- Mei..

- kan zijn

- gemiddelde

- betekenissen

- middel

- macht

- miljoen

- MIT

- model

- modellen

- Maand

- meer

- meest

- meervoudig

- noodzakelijk

- Noodzaak

- netwerk

- netwerken

- neurale

- neuraal netwerk

- neurale netwerken

- New

- bekend

- nummers

- object

- objecten

- of

- vaak

- on

- EEN

- degenen

- online.

- open

- open source

- Kansen

- gekant tegen

- bestellen

- Overige

- Overig

- Papier

- prestatie

- phd

- foto's

- Foto's

- Plato

- Plato gegevensintelligentie

- PlatoData

- Populair

- potentieel

- mogelijk

- privacy

- produceren

- Hoogleraar

- prompts

- beschermd

- biedt

- puts

- kwaliteit

- RE

- vast

- Rood

- Relaties

- uitgebracht

- vertrouwen

- verwijderen

- onderzoeker

- onderzoekers

- Resolutie

- Resources

- resultaat

- Resultaten

- terugkeer

- s

- dezelfde

- ervaren

- Scale

- wetenschappers

- zien

- gevoelig

- reeks

- moet

- sinds

- uitsluitend

- sommige

- bron

- stabiel

- Student

- Studie

- dergelijk

- toezicht

- overtreffen

- synthetisch

- synthetische gegevens

- Systems

- Onderwijs

- team

- tekst

- neem contact

- dat

- De

- hun

- Ze

- ze

- ding

- denken

- dit

- deze week

- Door

- naar

- vertelde

- ook

- Trainen

- getraind

- Trainingen

- BEURT

- die ten grondslag liggen

- .

- gebruikt

- gebruik

- via

- visie

- visuele

- manieren

- we

- week

- waren

- Wat

- wanneer

- welke

- wil

- Win-Win

- Met

- woorden

- erger

- zou

- geschreven

- You

- Your

- zephyrnet