Ooit een babygazelle zien leren lopen? Een reekalf, in feite een zoogdier met lange benen, krabbelt overeind, valt, staat en valt weer. Uiteindelijk staat het lang genoeg om met zijn tandenstokerachtige poten in een reeks bijna vallen te zwaaien ... ahem, stappen. Verbazingwekkend genoeg springt het reekalf een paar minuten na dit vertederende scherm rond als een oude professional.

Welnu, nu hebben we een robotversie van deze klassieke Serengeti-scène.

Het reekalf in dit geval is een robothond van de University of California, Berkeley. En het is ook een verrassend snelle leerling (in vergelijking met de rest van de robot-soort). De robot is ook bijzonder omdat hij, in tegenstelling tot andere flitsendere robots die je misschien online hebt gezien, kunstmatige intelligentie gebruikt om zichzelf te leren lopen.

Beginnend op zijn rug, met zwaaiende benen, leert de robot zichzelf omdraaien, opstaan en lopen in een uur. Nog eens tien minuten lastigvallen met een rol karton is genoeg om het te leren hoe te weerstaan en te herstellen van rondgeduwd worden door zijn begeleiders.

Het is niet de eerste keer een robot heeft kunstmatige intelligentie gebruikt om te leren lopen. Maar terwijl eerdere robots de vaardigheid met vallen en opstaan leerden over ontelbare iteraties in simulaties, leerde de Berkeley-bot volledig in de echte wereld.

[Ingesloten inhoud]

In een papier gepubliceerd op de arXiv preprint-server zeggen de onderzoekers - Danijar Hafner, Alejandro Escontrela en Philipp Wu - dat het niet eenvoudig is om algoritmen die in simulatie zijn geleerd over te brengen naar de echte wereld. Kleine details en verschillen tussen de echte wereld en simulatie kunnen jonge robots doen struikelen. Aan de andere kant is het trainen van algoritmen in de echte wereld onpraktisch: het zou te veel tijd en slijtage vergen.

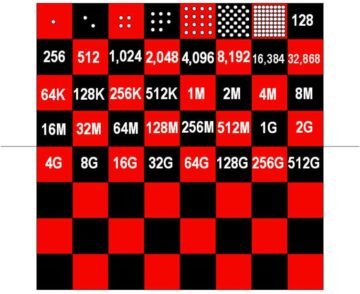

Vier jaar geleden toonde OpenAI bijvoorbeeld een AI-compatibele robothand die een kubus kon manipuleren. Het besturingsalgoritme, Dactyl, had zo'n 100 jaar ervaring nodig in een simulatie aangedreven door 6,144 CPU's en 8 Nvidia V100 GPU's om deze relatief eenvoudige taak te volbrengen. Sindsdien is er vooruitgang geboekt, maar het probleem blijft grotendeels bestaan. Pure versterkingsleeralgoritmen hebben te veel vallen en opstaan nodig om vaardigheden te leren die ze in de echte wereld kunnen trainen. Simpel gezegd, het leerproces zou onderzoekers breken en robots voordat ze enige betekenisvolle vooruitgang boeken.

Het Berkeley-team probeerde dit probleem op te lossen met een algoritme genaamd Dreamer. Het construeren van een zogenaamde "wereldmodelDreamer kan de waarschijnlijkheid projecteren dat een toekomstige actie zijn doel zal bereiken. Met ervaring verbetert de nauwkeurigheid van de projecties. Door vooraf minder succesvolle acties uit te filteren, laat het wereldmodel de robot efficiënter uitzoeken wat werkt.

"Door wereldmodellen te leren uit ervaringen uit het verleden, kunnen robots zich de toekomstige resultaten van mogelijke acties voorstellen, waardoor de hoeveelheid vallen en opstaan in de echte omgeving die nodig is om succesvol gedrag te leren, wordt verminderd", schrijven de onderzoekers. "Door toekomstige resultaten te voorspellen, maken wereldmodellen planning en gedragsleren mogelijk met slechts kleine hoeveelheden interactie in de echte wereld."

Met andere woorden, een wereldmodel kan het equivalent van jaren trainingstijd in een simulatie reduceren tot niet meer dan een ongemakkelijk uur in de echte wereld.

De aanpak kan ook een bredere relevantie hebben dan robothonden. Het team paste Dreamer ook toe op een pick-and-place robotarm en een robot op wielen. In beide gevallen ontdekten ze dat Dreamer hun robots in staat stelde om op efficiënte wijze relevante vaardigheden te leren, zonder dat daarvoor tijd nodig was. Meer ambitieuze toekomstige toepassingen kunnen zijn: zelfrijdende auto's.

Natuurlijk zijn er nog uitdagingen om aan te pakken. Hoewel versterkingsleren een deel van de ingewikkelde handcodering achter de meest geavanceerde robots van vandaag automatiseert, zijn er nog steeds ingenieurs nodig om de doelen van een robot te definiëren en wat succes inhoudt - een oefening die zowel tijdrovend als onbegrensd is voor real-world omgevingen. Hoewel de robot de experimenten van het team hier heeft overleefd, kan een langere training op meer geavanceerde vaardigheden te veel blijken voor toekomstige bots om zonder schade te overleven. De onderzoekers zeggen dat het vruchtbaar kan zijn om simulatortraining te combineren met snel real-world leren.

Toch brengen de resultaten AI in robotica nog een stap verder. Dreamer versterkt het argument dat "reinforcement learning een hoeksteen zal zijn in de toekomst van robotbesturing", Jonathan Hurst, een professor in robotica aan de Oregon State University vertelde MIT Technology Review.

Krediet van het beeld: Danijar Hafner / YouTube