- Oktober 10, 2021

- Vasilis Vryniotis

- . Ingen kommentarer

De siste par ukene har vært veldig travle i "PyTorch Land" da vi i full gang forbereder utgivelsen av PyTorch v1.10 og TorchVision v0.11. I denne andre delen av seriene, Jeg skal dekke noen av de kommende funksjonene som for øyeblikket er inkludert i utgivelsesgrenen til TorchVision.

Ansvarsfraskrivelse: Selv om den kommende utgivelsen er fullpakket med en rekke forbedringer og forbedringer av feil/test/dokumentasjon, fremhever jeg nye "brukervendte" funksjoner på domener jeg personlig er interessert i. Etter å ha skrevet blogginnlegget la jeg også merke til en skjevhet mot funksjoner jeg har vurdert, skrevet eller fulgt nøye med på utviklingen deres. Å dekke (eller ikke dekke) en funksjon sier ingenting om dens betydning. Uttrykte meninger er utelukkende mine egne.

Nye modeller

Den nye utgivelsen er fullpakket med nye modeller:

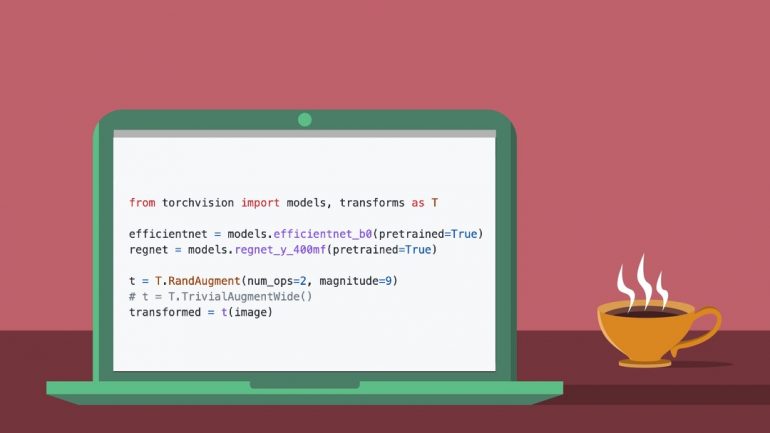

- Kai Zhang har lagt til en implementering av RegNet arkitektur sammen med ferdigtrente vekter for 14 varianter som tett gjengir originalpapiret.

- Jeg har nylig lagt til en implementering av EfficientNet-arkitektur sammen med ferdigtrente vekter for variantene B0-B7 levert av Luke Melas-Kyriazi og Ross Wightman.

Nye datautvidelser

Noen få nye dataforsterkningsteknikker er lagt til i den nyeste versjonen:

- Samuel Gabriel har bidratt TrivialAugment, en ny enkel, men svært effektiv strategi som ser ut til å gi overlegne resultater til AutoAugment.

- Jeg har lagt til RandAugment metode for automatiske forstørrelser.

- Jeg har gitt en implementering av Mixup og CutMix transformeres i referanser. Disse vil bli flyttet i transformasjoner ved neste utgivelse når API-en deres er ferdigstilt.

Nye operatører og lag

En rekke nye operatører og lag er inkludert:

Referanser / Treningsoppskrifter

Selv om forbedringen av referanseskriptene våre er en kontinuerlig innsats, er her noen nye funksjoner inkludert i den kommende versjonen:

- Prabhat Roy har lagt til støtte for Eksponentiell Flytende Gjennomsnitt i vår klassifiseringsoppskrift.

- Jeg har oppdatert referansene våre til støtte Etikettutjevning, som nylig ble introdusert av Joel Schlosser og Thomas J. Fan på PyTorch-kjerne.

- Jeg har inkludert muligheten til å opptre Oppvarming av læringshastighet, ved å bruke de nyeste LR-planleggerne utviklet av Ilqar Ramazanli.

andre forbedringer

Her er noen andre bemerkelsesverdige forbedringer lagt til i utgivelsen:

- Alexander Soare og Francisco Massa har utviklet en FX-basert verktøy som gjør det mulig å trekke ut vilkårlige mellomfunksjoner fra modellarkitekturer.

- Nikita Shulga har lagt til støtte for CUDA 11.3 til TorchVision.

- Zhongkai Zhu har fikset avhengighetsproblemer av JPEG lib (dette problemet har forårsaket store hodepine for mange av våre brukere).

Pågår og neste opp

Det er mange spennende nye funksjoner under utvikling som ikke gjorde det i denne utgivelsen. Her er noen:

- Moto Hira, Parmeet Singh Bhatia og jeg har utarbeidet en RFC, som foreslår en ny mekanisme for Modellversjon og for håndtering av metadata knyttet til ferdigtrente vekter. Dette vil gjøre oss i stand til å støtte flere forhåndstrente vekter for hver modell og legge til tilhørende informasjon som etiketter, forbehandlingstransformasjoner osv. til modellene.

- Jeg jobber for tiden med å bruke primitivene lagt til av "Batterier inkludert” prosjekt for å forbedre nøyaktigheten til vår ferdig trente modeller. Målet er å oppnå klassens beste resultater for de mest populære ferdigtrente modellene levert av TorchVision.

- Philip Meier og Francisco Massa jobber med en spennende prototype for TorchVisions nye datasett og Transforms API.

- Prabhat Roy jobber med å utvide PyTorch Core

AveragedModelklasse for å støtte gjennomsnittsberegning av bufferne i tillegg til parametere. Mangelen på denne funksjonen rapporteres ofte som feil og vilje aktivere en rekke nedstrøms biblioteker og rammeverk for å fjerne deres egendefinerte EMA-implementeringer. - Aditya Oke skrev et verktøy som tillater plotte resultatene av Keypoint-modeller på de originale bildene (funksjonen kom ikke til utgivelsen da vi ble oversvømmet og ikke kunne se den i tide 🙁 )

- Jeg bygger en prototype FX-verktøy som tar sikte på å oppdage gjenværende tilkoblinger i vilkårlige modellarkitekturer og modifisere nettverket for å legge til regulariseringsblokker (som f.eks.

StochasticDepth).

Til slutt er det noen nye funksjoner i backloggen vår (PR-er kommer snart):

Jeg håper du fant oppsummeringen ovenfor interessant. Eventuelle ideer til hvordan man kan tilpasse formatet på bloggserien er hjertelig velkommen. Slå meg opp Linkedin or Twitter.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://blog.datumbox.com/a-sneak-peek-on-torchvision-v0-11-memoirs-of-a-torchvision-developer-2/

- 10

- 11

- 7

- a

- Om oss

- ovenfor

- nøyaktighet

- Oppnå

- tilpasse

- la til

- tillegg

- Etter

- mål

- tillater

- og

- api

- assosiert

- feste

- forfatter

- Bias

- Blocks

- Blogg

- Branch

- Bug

- Bygning

- forårsaket

- klasse

- klassifisering

- tett

- kommer

- Kommer snart

- vanligvis

- Tilkoblinger

- kontinuerlig

- bidratt

- Kjerne

- Par

- dekke

- dekker

- I dag

- skikk

- dato

- Datoboks

- utviklet

- Utvikler

- Utvikling

- domener

- utarbeidet

- hver enkelt

- Effektiv

- innsats

- EMA

- muliggjøre

- etc

- spennende

- uttrykte

- strekker

- vifte

- Trekk

- Egenskaper

- Noen få

- avsluttet

- fikset

- fulgt

- format

- funnet

- rammer

- Francisco

- fra

- Håndtering

- hodepine

- her.

- utheving

- svært

- hit

- håp

- Hvordan

- Hvordan

- HTTPS

- JEG VIL

- Ideer

- bilder

- gjennomføring

- betydning

- forbedre

- forbedring

- forbedringer

- in

- inkludert

- informasjon

- interessert

- interessant

- introdusert

- utstedelse

- IT

- etiketter

- maling

- Siste

- siste

- lag

- større

- gjøre

- mange

- max bredde

- mekanisme

- metode

- modell

- modeller

- mest

- Mest populær

- flytting

- flere

- nettverk

- Ny

- Nye funksjoner

- neste

- bemerkelsesverdig

- Antall

- mange

- oktober

- operatører

- Meninger

- Alternativ

- rekkefølge

- original

- Annen

- egen

- pakket

- Papir

- parametere

- Utfør

- personlig

- plato

- Platon Data Intelligence

- PlatonData

- Populær

- Post

- innlegg

- forbereder

- prosjekt

- foreslår

- prototype

- gi

- forutsatt

- pytorch

- Sats

- nylig

- .

- referanser

- slipp

- fjerne

- rapportert

- Resultater

- anmeldelse

- anmeldt

- skript

- synes

- Serien

- Enkelt

- snike

- noen

- Strategi

- slik

- SAMMENDRAG

- Super

- overlegen

- støtte

- Target

- teknikker

- De

- deres

- tid

- til

- Torchvision

- mot

- Kurs

- kommende

- oppdatert

- us

- Brukere

- versjon

- uker

- velkommen

- hvilken

- vil

- arbeid

- skriving

- Du

- zephyrnet