Sam var seks måneder gammel da han først festet et lett kamera på pannen.

For det neste halvannet året, kameraet fanget utklipp av livet hans. Han krøp rundt familiens kjæledyr, så foreldrene lage mat og gråt på verandaen sammen med bestemor. Hele tiden tok kameraet opp alt han hørte.

Det som høres ut som en søt hjemmevideo for småbarn er faktisk et vågalt konsept: Kan AI lære språk som et barn? Resultatene kan også avdekke hvordan barn raskt tilegner seg språk og begreper i tidlig alder.

En ny studie in Vitenskap beskriver hvordan forskere brukte Sams opptak til å trene en AI til å forstå språk. Med bare en liten del av ett barns livserfaring over et år, var AI i stand til å forstå grunnleggende konsepter – for eksempel en ball, en sommerfugl eller en bøtte.

AI, kalt Child's View for Contrastive Learning (CVCL), etterligner omtrent hvordan vi lærer som småbarn ved å matche syn og lyd. Det er en helt annen tilnærming enn den som brukes av store språkmodeller som de bak ChatGPT eller Bard. Disse modellenes uhyggelige evne til å lage essays, poesi eller til og med podcast-manus har begeistret verden. Men de trenger å fordøye billioner av ord fra et bredt utvalg av nyhetsartikler, manus og bøker for å utvikle disse ferdighetene.

Barn, derimot, lærer med langt mindre input og generaliserer raskt læringen sin etter hvert som de vokser. Forskere har lenge lurt på om AI kan fange disse evnene med hverdagsopplevelser alene.

"Vi viser, for første gang, at et nevralt nettverk som er trent på denne utviklingsrealistiske input fra et enkelt barn kan lære å koble ord til sine visuelle motparter," studieforfatter Dr. Wai Keen Vong ved NYUs Center for Data Science sa i en pressemelding om forskningen.

Barnas lek

Barn suger lett til seg ord og deres betydninger fra hverdagsopplevelsen.

Bare seks måneder gamle begynner de å koble ord til det de ser - for eksempel er en rund sprettende ting en "ball". Ved to års alder kan de omtrent 300 ord og deres konsepter.

Forskere har lenge diskutert hvordan dette skjer. En teori sier at barn lærer å matche det de ser med det de hører. En annen antyder at språklæring krever en bredere opplevelse av verden, for eksempel sosial interaksjon og evnen til å resonnere.

Det er vanskelig å pirre disse ideene fra hverandre med tradisjonelle kognitive tester hos småbarn. Men vi kan få et svar ved å trene en AI gjennom øynene og ørene til et barn.

M3GAN?

Den nye studien benyttet en rik videoressurs kalt SAYCam, som inkluderer data samlet inn fra tre barn mellom 6 og 32 måneder med GoPro-lignende kameraer festet til pannen.

To ganger hver uke tok kameraene opp rundt en time med opptak og lyd mens de ammet, kravlet og spilte. All hørbar dialog ble transkribert til "ytringer" - ord eller setninger som ble sagt før taleren eller samtalen endres. Resultatet er et vell av multimediedata fra babyer og småbarns perspektiv.

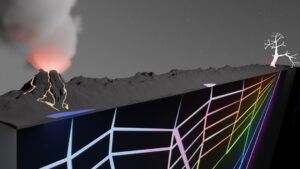

For det nye systemet designet teamet to nevrale nettverk med en "dommer" for å koordinere dem. En oversatte førstepersonsbilder til en scenes hvem og hva – er det en mor som lager mat? Den andre tydet ord og betydninger fra lydopptakene.

De to systemene ble deretter korrelert i tid slik at AI lærte å assosiere korrekte bilder med ord. For eksempel lærte AI å matche et bilde av en baby med ordene "Se, det er en baby" eller et bilde av en yogaball til "Wow, det er en stor ball." Med trening lærte den seg gradvis å skille konseptet med en yogaball fra en baby.

"Dette gir modellen en pekepinn på hvilke ord som skal assosieres med hvilke objekter," sa Vong.

Teamet trente deretter AI på videoer fra omtrent halvannet år av Sams liv. Til sammen utgjorde det over 600,000 37,500 videobilder, sammen med XNUMX XNUMX transkriberte ytringer. Selv om tallene høres store ut, er de omtrent bare én prosent av Sams daglige våkne liv og peanøtter sammenlignet med mengden data som brukes til å trene store språkmodeller.

Baby AI på vei opp

For å teste systemet tilpasset teamet en vanlig kognitiv test som brukes til å måle barns språklige evner. De viste AI fire nye bilder – en katt, en barneseng, en ball og en plen – og spurte hvilken som var ballen.

Totalt sett valgte AI det riktige bildet rundt 62 prosent av tiden. Ytelsen matchet nesten en state-of-the-art algoritme trent på 400 millioner bilde- og tekstpar fra nettet – størrelsesordener flere data enn det som ble brukt til å trene opp AI i studien. De fant ut at det var avgjørende å koble videobilder med lyd. Da teamet blandet videorammer og deres tilhørende ytringer, brøt modellen fullstendig sammen.

AI kan også "tenke" utenfor boksen og generalisere til nye situasjoner.

I en annen test ble den trent på Sams perspektiv på en bildebok, da foreldrene hans sa: "Det er en and og en sommerfugl." Senere holdt han opp en lekesommerfugl da han ble spurt: «Kan du gjøre sommerfuglen?» Når den ble utfordret med flerfargede sommerfuglbilder - de AI aldri hadde sett før - oppdaget den tre av fire eksempler på "sommerfugl" med over 80 prosent nøyaktighet.

Ikke alle ordbegreper skåret like. For eksempel var "skje" en kamp. Men det er verdt å påpeke at, som en tøff reCAPTCHA, treningsbildene var vanskelige å tyde selv for et menneske.

Voksesmerter

De AI bygger på nylige fremskritt innen multimodal maskinlæring, som kombinerer tekst, bilder, lyd eller video for å trene en maskinhjerne.

Med innspill fra kun ett enkelt barns opplevelse, klarte algoritmen å fange hvordan ord forholder seg til hverandre og koble ord til bilder og konsepter. Det antyder at for småbarn hjelper det å bygge ordforrådet deres å høre ord og å matche dem med det de ser.

Det er ikke dermed sagt at andre hjerneprosesser, som sosiale signaler og resonnement, ikke spiller inn. Å legge til disse komponentene til algoritmen kan potensielt forbedre den, skrev forfatterne.

Teamet planlegger å fortsette eksperimentet. Foreløpig lærer "baby" AI bare fra stillbilderammer og har et vokabular som hovedsakelig består av substantiv. Å integrere videosegmenter i opplæringen kan hjelpe AI med å lære verb fordi video inkluderer bevegelse.

Å legge til intonasjon i taledata kan også hjelpe. Barn lærer tidlig at en mors "hmm" kan ha vidt forskjellige betydninger avhengig av tonen.

Men totalt sett er det å kombinere AI og livserfaringer en kraftig ny metode for å studere både maskin- og menneskehjerner. Det kan hjelpe oss med å utvikle nye AI-modeller som lærer som barn, og potensielt omforme vår forståelse av hvordan hjernen vår lærer språk og konsepter.

Bildekreditt: Wai Keen Vong

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://singularityhub.com/2024/02/01/an-ai-just-learned-language-through-the-eyes-and-ears-of-a-toddler/

- : har

- :er

- :ikke

- $OPP

- 000

- 300

- 32

- 400

- 500

- 600

- 80

- a

- evner

- evne

- I stand

- Om oss

- ovenfor

- nøyaktighet

- erverve

- faktisk

- legge

- fremskritt

- alder

- AI

- AI-modeller

- algoritme

- Alle

- alene

- også

- Selv

- beløp

- an

- og

- En annen

- besvare

- hverandre

- tilnærming

- rundt

- artikler

- AS

- Førsteamanuensis

- assosiert

- At

- lyd

- forfatter

- forfattere

- Baby

- ball

- grunnleggende

- BE

- fordi

- før du

- begynne

- mellom

- Stor

- bok

- bøker

- både

- Eske

- Brain

- bredere

- Broke

- bygge

- bygger

- men

- by

- som heter

- rom

- kameraer

- CAN

- fangst

- fanget

- CAT

- sentrum

- utfordret

- Endringer

- ChatGPT

- barn

- Barn

- kognitiv

- skurtreskerne

- kombinere

- Kom

- Felles

- sammenlignet

- helt

- komponenter

- Omfattet

- konsept

- konsepter

- Koble

- fortsette

- kontrast

- Samtale

- koordinere

- korrigere

- kunne

- kolleger

- lage

- kreditt

- avgjørende

- daglig

- dato

- datavitenskap

- dechiffrere

- avhengig

- beskriver

- designet

- oppdaget

- utvikle

- Dialog

- forskjellig

- Fordøye

- do

- ikke

- ned

- dr

- hver enkelt

- Tidlig

- lett

- Selv

- Hver

- hverdagen

- alt

- eksempel

- eksempler

- erfaring

- Erfaringer

- eksperiment

- øyne

- langt

- Først

- første gang

- Til

- panne

- funnet

- fire

- fra

- foran

- få

- gradvis

- gripe

- Grow

- HAD

- Halvparten

- skjer

- Hard

- Ha

- he

- hørt

- hørsel

- Held

- hjelpe

- hjelper

- hans

- Hjemprodukt

- time

- Hvordan

- http

- HTTPS

- menneskelig

- Ideer

- if

- bilde

- bilder

- forbedre

- in

- inkluderer

- inngang

- f.eks

- Integrering

- interaksjon

- inn

- IT

- bare

- bare én

- Keen

- kids

- Vet

- Språk

- stor

- seinere

- LÆRE

- lært

- læring

- lærer

- mindre

- Life

- lettvekt

- i likhet med

- LINK

- linking

- Lang

- maskin

- Match

- matchet

- matchende

- Kan..

- betydninger

- måle

- metode

- millioner

- modell

- modeller

- ledd

- måneder

- mer

- for det meste

- bevegelse

- multimedia

- nesten

- Trenger

- nettverk

- nettverk

- nevrale

- nevrale nettverket

- nevrale nettverk

- aldri

- Ny

- nyheter

- neste

- NIH

- substantiver

- nå

- tall

- gjenstander

- of

- Gammel

- on

- ONE

- seg

- bare

- videre til

- or

- Annen

- vår

- ut

- utenfor

- enn

- samlet

- sammen

- par

- foreldre

- prosent

- ytelse

- perspektiv

- Kjæledyr

- plukket

- bilde

- planer

- plato

- Platon Data Intelligence

- PlatonData

- Spille

- spilt

- podcast

- Poesi

- del

- potensielt

- kraftig

- trykk

- Prosesser

- gir

- raskt

- realistisk

- grunnen til

- nylig

- registrert

- Krever

- forskning

- forskere

- omskape

- ressurs

- resultere

- Resultater

- avsløre

- Rich

- omtrent

- runde

- Sa

- samme

- sier

- sier

- Vitenskap

- forskere

- skript

- se

- sett

- segmenter

- separat

- bør

- Vis

- viste

- Syn

- enkelt

- situasjoner

- SIX

- Seks måneder

- ferdigheter

- So

- selskap

- Lyd

- lyder

- Høyttaler

- tale

- talt

- state-of-the-art

- Still

- Struggle

- Studer

- slik

- foreslår

- system

- Systemer

- tatt

- Tappet

- lag

- test

- tester

- tekst

- enn

- Det

- De

- verden

- deres

- Dem

- deretter

- teori

- Disse

- de

- ting

- denne

- tre

- begeistret

- Gjennom

- tid

- til

- sammen

- TONE

- tøff

- tradisjonelle

- Tog

- trent

- Kurs

- billioner

- to

- forstå

- forståelse

- us

- brukt

- ved hjelp av

- variasjon

- vesentlig

- veldig

- video

- videoer

- Se

- visuell

- visuelle

- var

- overvåket

- we

- Rikdom

- uke

- var

- Hva

- whats

- når

- hvilken

- mens

- bred

- med

- ord

- ord

- verden

- verdt

- skrev

- år

- år

- yoga

- Du

- zephyrnet