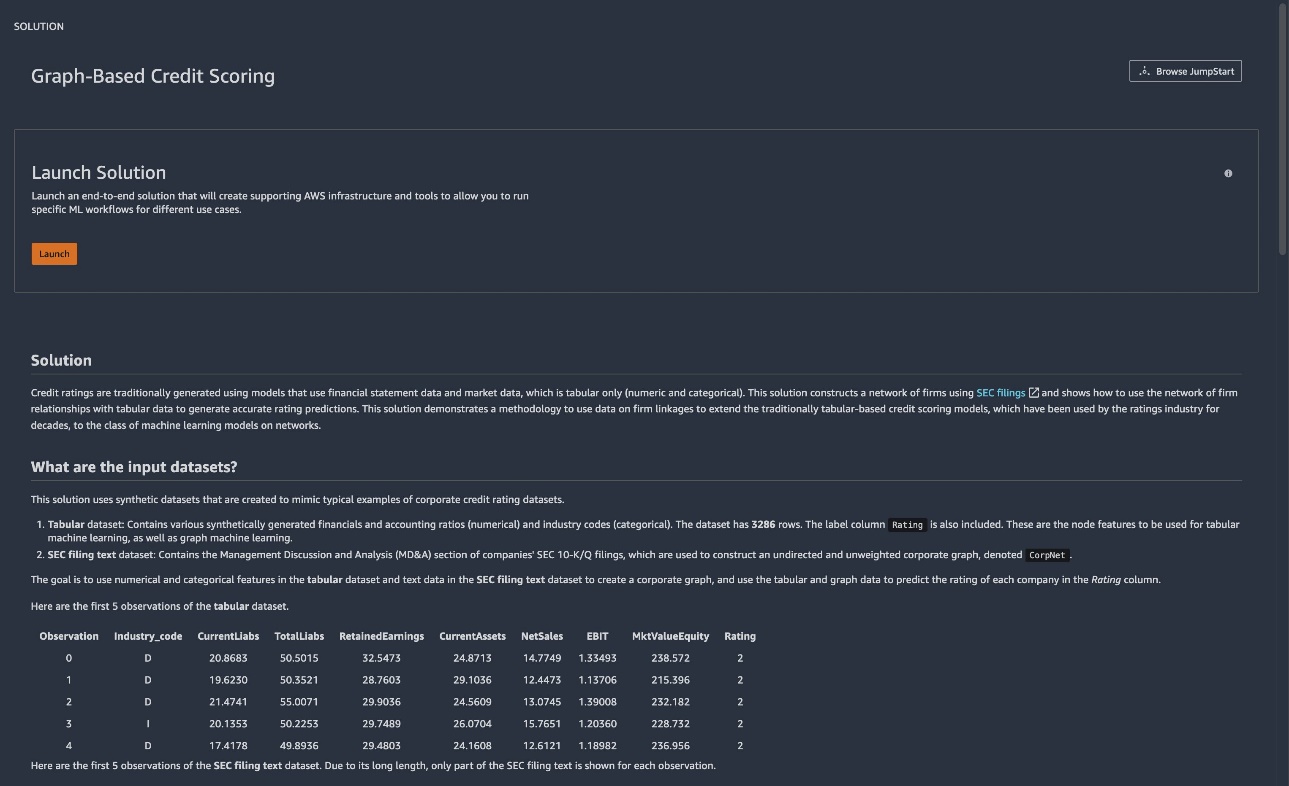

I dag slipper vi en ny løsning for maskinlæring av finansielle grafer (ML) i Amazon SageMaker JumpStart. JumpStart hjelper deg raskt å komme i gang med ML og gir et sett med løsninger for de vanligste brukstilfellene som kan trenes og distribueres med bare noen få klikk.

Den nye JumpStart-løsningen (Graph-Based Credit Scoring) demonstrerer hvordan man konstruerer et bedriftsnettverk fra SEC-arkivering (langformede tekstdata), kombinerer dette med økonomiske forhold (tabelldata) og bruker grafiske nevrale nettverk (GNN) for å bygge kreditt vurderingsprediksjonsmodeller. I dette innlegget forklarer vi hvordan du kan bruke denne fullstendig tilpassbare løsningen for kredittscoring, slik at du kan akselerere din graf-ML-reise. Graph ML er i ferd med å bli et fruktbart område for finansiell ML fordi det muliggjør bruk av nettverksdata i forbindelse med tradisjonelle tabelldatasett. For mer informasjon, se Amazon på WSDM: Fremtiden til grafiske nevrale nettverk.

Løsningsoversikt

Du kan forbedre kredittscoring ved å utnytte data om forretningsforbindelser, som du kan lage en graf for, betegnet som CorpNet (forkortelse for bedriftsnettverk) i denne løsningen. Du kan deretter bruke graf-ML-klassifisering ved å bruke GNN-er på denne grafen og et tabellfunksjonssett for nodene, for å se om du kan bygge en bedre ML-modell ved å utnytte informasjonen i nettverksrelasjoner ytterligere. Derfor tilbyr denne løsningen en mal for forretningsmodeller som utnytter nettverksdata, for eksempel bruk av grafer for forsyningskjedeforhold, sosiale nettverksgrafer og mer.

Løsningen utvikler flere nye artefakter ved å konstruere et bedriftsnettverk og generere syntetiske økonomiske data, og kombinerer begge former for data for å lage modeller ved hjelp av graf ML.

Løsningen viser hvordan du kan konstruere et nettverk av tilknyttede selskaper ved å bruke MD&A-delen fra SEC 10-K/Q-filene. Selskaper med lignende fremtidsrettede utsagn vil sannsynligvis bli knyttet til kreditthendelser. Disse forbindelsene er representert i en graf. For grafnodefunksjoner bruker løsningen variablene i Altman Z-score-modellen og bransjekategorien til hvert firma. Disse er gitt i et syntetisk datasett som er gjort tilgjengelig for demonstrasjonsformål. Grafdataene og tabelldataene brukes for å passe til en klassifiseringsklassifisering ved bruk av GNN-er. For illustrative formål sammenligner vi ytelsen til modeller med og uten grafinformasjonen.

Bruk den grafbaserte kredittscoringsløsningen

For å begynne å bruke JumpStart, se Komme i gang med Amazon SageMaker. JumpStart-kortet for den grafbaserte kredittscoringsløsningen er tilgjengelig via Amazon SageMaker Studio.

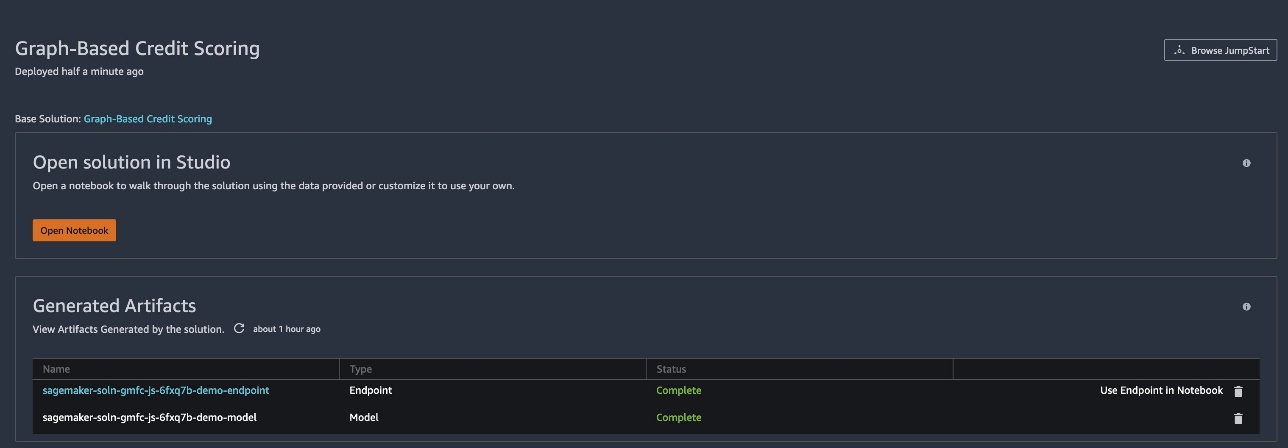

Løsningen genererer en modell for slutning og et endepunkt som kan brukes med en bærbar PC.

- Vent til de er klare og statusen vises som

Complete. - Velg Åpne Notebook for å åpne den første notatboken, som er for opplæring og endepunktsdistribusjon.

Du kan gå gjennom denne notatboken for å lære hvordan du bruker denne løsningen og deretter endre den for andre applikasjoner på dine egne data. Løsningen kommer med syntetiske data og bruker et undersett av det for å eksemplifisere trinnene som trengs for å trene modellen, distribuere den til et endepunkt og deretter påkalle endepunktet for slutning. Den bærbare datamaskinen inneholder også kode for å distribuere et eget endepunkt.

- For å åpne den andre notatboken (brukt til slutning), velg Bruk endepunkt i Notebook ved siden av endepunktartefakten.

I denne notatboken kan du se hvordan du forbereder dataene for å påkalle eksempelendepunktet for å utføre inferens på en gruppe eksempler.

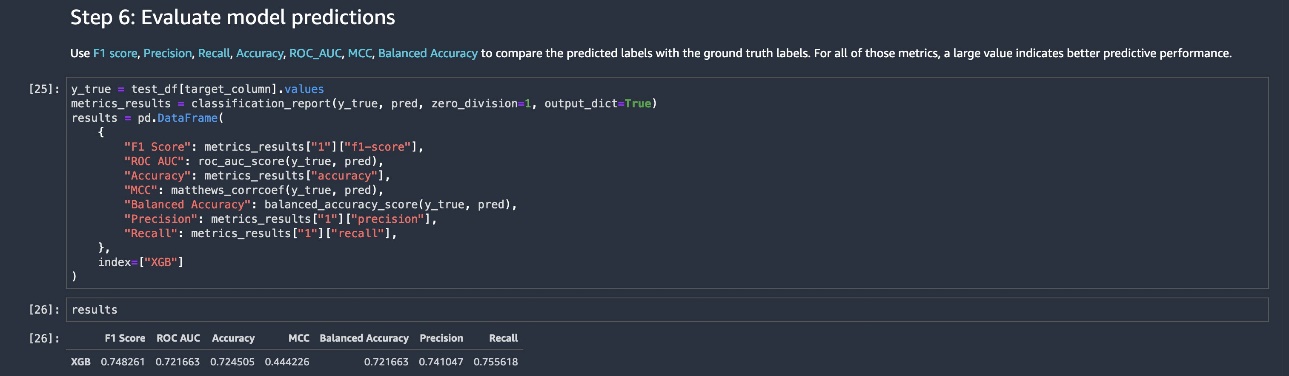

Endepunktet returnerer predikerte vurderinger, som brukes til å vurdere modellytelse, som vist i følgende skjermbilde av den siste kodeblokken i inferensnotatboken.

Du kan bruke denne løsningen som en mal for en grafforbedret kredittvurderingsmodell. Du er ikke begrenset til funksjonssettet i dette eksemplet – du kan endre både grafdata og tabelldata for ditt eget bruk. Omfanget av kodeendringer som kreves er minimalt. Vi anbefaler å gå gjennom maleksemplet vårt for å forstå strukturen til løsningen, og deretter endre det etter behov.

Denne løsningen er kun for demonstrasjonsformål. Det er ikke finansiell rådgivning og bør ikke stoles på som finansiell eller investeringsrådgivning. De tilknyttede bærbare PC-ene, inkludert den opplærte modellen, bruker syntetiske data og er ikke beregnet for produksjonsbruk. Selv om tekst fra SEC-registreringer brukes, er de økonomiske dataene syntetisk og tilfeldig generert og har ingen relasjon til noe selskaps sanne økonomi. Derfor har de syntetisk genererte vurderingene heller ikke noen relasjon til et ekte selskaps sanne vurdering.

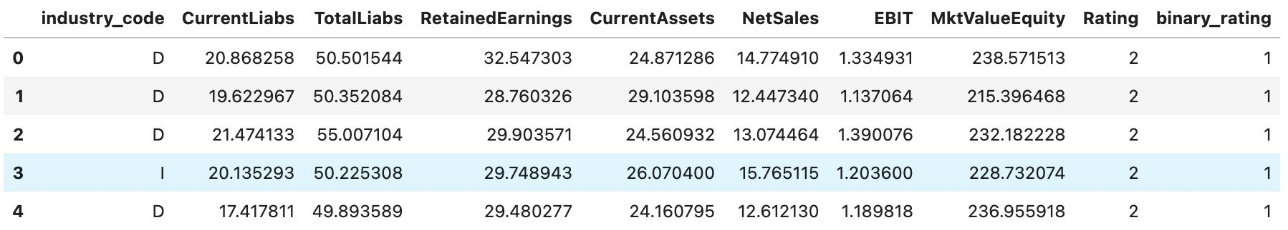

Data brukt i løsningen

Datasettet har syntetiske tabelldata som ulike regnskapsforhold (numeriske) og bransjekoder (kategoriske). Datasettet har 𝑁=3286 rader. Vurderingsetiketter er også lagt til. Dette er nodefunksjonene som skal brukes med graf ML.

Datasettet inneholder også en bedriftsgraf, som er urettet og uvektet. Denne løsningen lar deg justere strukturen til grafen ved å variere måten lenker er inkludert på. Hvert selskap i det tabellformede datasettet er representert med en node i bedriftsgrafen. Funksjonen construct_network_data() hjelper til med å konstruere grafen, som omfatter lister over kildenoder og destinasjonsnoder.

Rangeringsetiketter brukes for klassifisering ved bruk av GNN-er, som kan være multi-kategorier for alle vurderinger eller binære, delt mellom investeringsgrad (AAA, AA, A, BBB) og ikke-investeringsgrad (BB, B, CCC, CC, C, D). D står her for misligholdt.

Den komplette koden for å lese inn dataene og kjøre løsningen er gitt i løsningsnotisboken. Følgende skjermbilde viser strukturen til de syntetiske tabelldataene.

Grafinformasjonen sendes inn til Deep Graph Library og kombinert med tabelldataene for å gjennomføre grafen ML. Hvis du tar med din egen graf, oppgir du den som et sett med kildenoder og destinasjonsnoder.

Modelltrening

Til sammenligning trener vi først en modell kun på tabelldata ved hjelp av AutoGluon, som etterligner den tradisjonelle tilnærmingen til kredittvurdering av selskaper. Vi legger deretter inn grafdata og bruker GNN-er for trening. Fullstendige detaljer er gitt i notatboken, og en kort oversikt tilbys i dette innlegget. Notatboken gir også en rask oversikt over graf ML med utvalgte referanser.

Opplæring av GNN utføres som følger. Vi bruker en tilpasning av GraphSAGE modell implementert i Deep Graph Library.

- Les inn grafdata fra Amazon enkel lagringstjeneste (Amazon S3) og lag kilde- og destinasjonsnodelistene for CorpNet.

- Les inn grafnodens funksjonssett (tren og test). Normaliser dataene etter behov.

- Angi justerbare hyperparametre. Kall den spesialiserte grafen ML-beholderen som kjører PyTorch for å passe til GNN uten hyperparameteroptimalisering (HPO).

- Gjenta graf ML med HPO.

For å gjøre implementeringen enkel og stabil, kjører vi modellopplæring i en beholder ved å bruke følgende kode (oppsettkoden før denne opplæringskoden er i løsningsnotisboken):

Den nåværende treningsprosessen utføres i en transduktiv setting, der funksjonene til testdatasettet (ikke inkludert målkolonnen) brukes til å konstruere grafen, og derfor er testnodene inkludert i treningsprosessen. På slutten av treningen genereres og lagres spådommene på testdatasettet output_location i S3-bøtta.

Selv om opplæringen er transduktiv, brukes ikke etikettene til testdatasettet til trening, og øvelsen vår tar sikte på å forutsi disse etikettene ved å bruke nodeinnbygginger for testdatasettets noder. En viktig funksjon ved GraphSAGE er at induktiv læring på nye observasjoner som ikke er en del av grafen også er mulig, men ikke utnyttet i denne løsningen.

Optimalisering av hyperparameter

Denne løsningen utvides ytterligere ved å gjennomføre HPO på GNN. Dette gjøres i SageMaker. Se følgende kode:

Vi satte deretter opp treningsmålet, for å maksimere F1-poengsummen i dette tilfellet:

Etabler det valgte miljøet og opplæringsressursene på SageMaker:

Til slutt, kjør treningsjobben med hyperparameteroptimalisering:

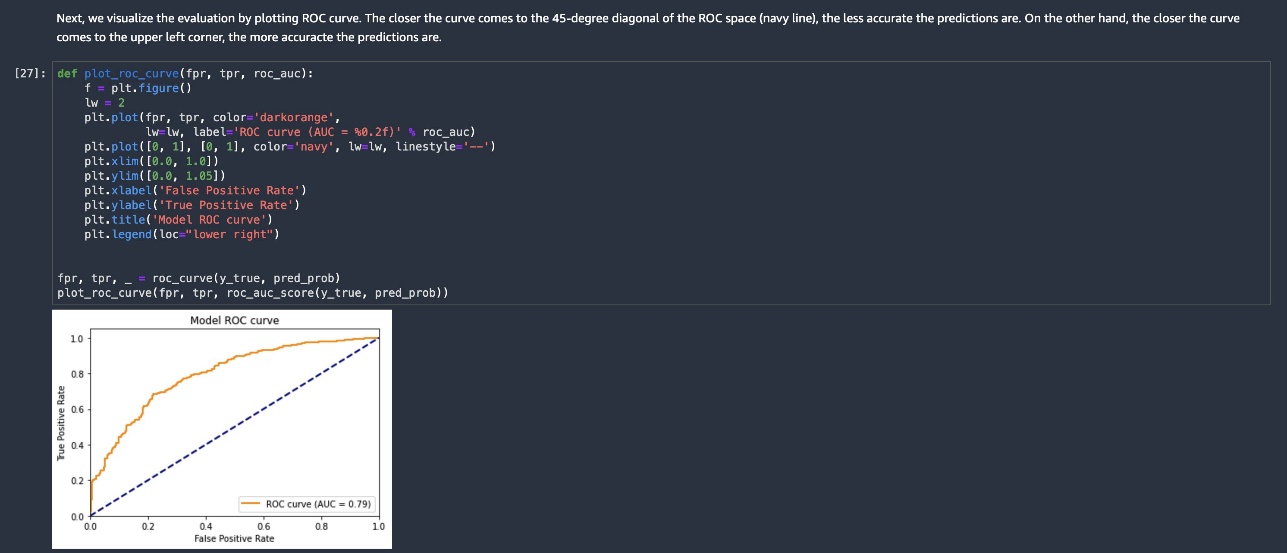

Resultater

Inkludering av nettverksdata og hyperparameteroptimalisering gir forbedrede resultater. Ytelsesberegningene i tabellen nedenfor viser fordelen med å legge til CorpNet til standard tabelldatasett som brukes for kredittscoring.

Resultatene for AutoGluon bruker ikke grafen, bare tabelldataene. Når vi legger inn grafdata og bruker HPO, får vi en vesentlig gevinst i ytelse.

| F1-poengsum | ROC AUC | Nøyaktighet | MCC | Balansert nøyaktighet | Precision | Husker | |

| AutoGluon | 0.72 | 0.74323 | 0.68037 | 0.35233 | 0.67323 | 0.68528 | 0.75843 |

| GCN uten HPO | 0.64 | 0.84498 | 0.69406 | 0.45619 | 0.71154 | 0.88177 | 0.50281 |

| GCN med HPO | 0.81 | 0.87116 | 0.78082 | 0.563 | 0.77081 | 0.75119 | 0.89045 |

(Merk: MCC er Matthews korrelasjonskoeffisient; https://en.wikipedia.org/wiki/Phi_coefficient.)

Rydd opp

Når du er ferdig med å bruke denne notatboken, sletter du modellartefakter og andre ressurser for å unngå å pådra deg ytterligere kostnader. Du må manuelt slette ressurser du kan ha opprettet mens du kjørte den bærbare datamaskinen, for eksempel S3-bøtter for modellartefakter, opplæringsdatasett, behandlingsartefakter og Amazon CloudWatch logggrupper.

Oppsummering

I dette innlegget introduserte vi en grafbasert kredittscoringsløsning i JumpStart for å hjelpe deg med å akselerere din graf-ML-reise. Den bærbare datamaskinen gir en pipeline som du kan endre og utnytte grafer med eksisterende tabellmodeller for å oppnå bedre ytelse.

For å komme i gang kan du finne den grafbaserte kredittscoringsløsningen i JumpStart in SageMaker Studio.

Om forfatterne

Dr. Sanjiv Das er en Amazon-stipendiat og Terry-professor i finans og datavitenskap ved Santa Clara University. Han har postgraduate grader i finans (M.Phil og Ph.D. fra New York University) og informatikk (MS fra UC Berkeley), og en MBA fra Indian Institute of Management, Ahmedabad. Før han ble akademiker jobbet han i derivatbransjen i Asia-Stillehavsregionen som visepresident i Citibank. Han jobber med multimodal maskinlæring innen økonomiske applikasjoner.

Dr. Sanjiv Das er en Amazon-stipendiat og Terry-professor i finans og datavitenskap ved Santa Clara University. Han har postgraduate grader i finans (M.Phil og Ph.D. fra New York University) og informatikk (MS fra UC Berkeley), og en MBA fra Indian Institute of Management, Ahmedabad. Før han ble akademiker jobbet han i derivatbransjen i Asia-Stillehavsregionen som visepresident i Citibank. Han jobber med multimodal maskinlæring innen økonomiske applikasjoner.

Dr. Xin Huang er en anvendt vitenskapsmann for Amazon SageMaker JumpStart og Amazon SageMaker innebygde algoritmer. Han fokuserer på å utvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er innen områdene naturlig språkbehandling, dyp læring på tabelldata og robust analyse av ikke-parametrisk rom-tid klynging.

Dr. Xin Huang er en anvendt vitenskapsmann for Amazon SageMaker JumpStart og Amazon SageMaker innebygde algoritmer. Han fokuserer på å utvikle skalerbare maskinlæringsalgoritmer. Hans forskningsinteresser er innen områdene naturlig språkbehandling, dyp læring på tabelldata og robust analyse av ikke-parametrisk rom-tid klynging.

Soji Adeshina er en Applied Scientist ved AWS, hvor han utvikler grafiske nevrale nettverksbaserte modeller for maskinlæring på grafoppgaver med applikasjoner for svindel og misbruk, kunnskapsgrafer, anbefalingssystemer og biovitenskap. På fritiden liker han å lese og lage mat.

Soji Adeshina er en Applied Scientist ved AWS, hvor han utvikler grafiske nevrale nettverksbaserte modeller for maskinlæring på grafoppgaver med applikasjoner for svindel og misbruk, kunnskapsgrafer, anbefalingssystemer og biovitenskap. På fritiden liker han å lese og lage mat.

Patrick Yang er programvareutviklingsingeniør hos Amazon SageMaker. Han fokuserer på å bygge maskinlæringsverktøy og produkter for kunder.

Patrick Yang er programvareutviklingsingeniør hos Amazon SageMaker. Han fokuserer på å bygge maskinlæringsverktøy og produkter for kunder.

- Myntsmart. Europas beste Bitcoin og Crypto Exchange.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. FRI TILGANG.

- CryptoHawk. Altcoin Radar. Gratis prøveperiode.

- Kilde: https://aws.amazon.com/blogs/machine-learning/build-a-corporate-credit-ratings-classifier-using-graph-machine-learning-in-amazon-sagemaker-jumpstart/

- "

- 100

- 70

- 9

- akselerere

- Regnskap og administrasjon

- råd

- algoritmer

- Alle

- Selv

- Amazon

- analyse

- søknader

- tilnærming

- arkitektur

- AREA

- rundt

- tilgjengelig

- AWS

- bli

- være

- nytte

- Berkeley

- Blokker

- grensen

- bygge

- Bygning

- innebygd

- virksomhet

- ring

- saker

- Kategori

- kjede

- endring

- avgifter

- Velg

- klassifisering

- kode

- Kolonne

- kombinert

- Felles

- Selskaper

- Selskapet

- Selskapets

- datamaskin

- informatikk

- tilkoblet

- Tilkoblinger

- Container

- inneholder

- Bedriftens

- skape

- opprettet

- kreditt

- Gjeldende

- Kunder

- tilpasses

- dato

- datavitenskap

- demonstrere

- utplassere

- utplassert

- distribusjon

- Derivater

- detaljer

- utvikle

- Utvikling

- dynamisk

- Endpoint

- ingeniør

- Miljø

- hendelser

- eksempel

- Øvelse

- eksisterende

- Exploit

- Trekk

- Egenskaper

- finansiere

- finansiell

- Økonomiske data

- økonomi

- Firm

- Først

- passer

- fokuserer

- etter

- skjemaer

- fremtidsrettet

- svindel

- fullt

- funksjon

- videre

- framtid

- genererer

- Gruppens

- høyde

- hjelpe

- hjelper

- her.

- holder

- Hvordan

- Hvordan

- HTTPS

- gjennomføring

- implementert

- viktig

- forbedre

- forbedret

- inkludert

- Inkludert

- inkludering

- industri

- informasjon

- interesser

- investering

- IT

- Jobb

- Jobb

- kunnskap

- etiketter

- Språk

- LÆRE

- læring

- Bibliotek

- Life Sciences

- Sannsynlig

- lenker

- lister

- maskin

- maskinlæring

- laget

- ledelse

- manuelt

- materiale

- Metrics

- ML

- modell

- modeller

- Overvåke

- mer

- mest

- Naturlig

- nettverk

- Nettverksdata

- nettverksbasert

- nettverk

- New York

- noder

- bærbare

- tilbudt

- Tilbud

- åpen

- optimalisering

- Annen

- egen

- ytelse

- basseng

- mulig

- prediksjon

- Spådommer

- Forbered

- president

- forrige

- prosess

- prosessering

- Produksjon

- Produkter

- gir

- formål

- formål

- Rask

- raskt

- vurdering

- rangeringer

- Lesning

- anbefaler

- forholdet

- Relasjoner

- påkrevd

- forskning

- Ressurser

- Resultater

- avkastning

- Kjør

- rennende

- Nisse

- skalerbar

- Vitenskap

- VITENSKAPER

- Forsker

- Søk

- SEK

- valgt

- sett

- innstilling

- oppsett

- Kort

- lignende

- Enkelt

- So

- selskap

- sosiale nettverk

- Software

- programvareutvikling

- solid

- løsning

- Solutions

- spesialisert

- Standard

- står

- Begynn

- startet

- uttalelser

- status

- lagring

- vellykket

- levere

- forsyningskjeden

- Systemer

- Target

- oppgaver

- test

- Kilden

- derfor

- Gjennom

- tid

- verktøy

- tradisjonelle

- Kurs

- forstå

- universitet

- bruke

- validering

- ulike

- Vice President

- mens

- Wikipedia

- innenfor

- uten

- Arbeid

- arbeidet

- arbeid

- virker