Bildeklassifisering er en datasynsbasert maskinlæringsteknikk (ML) som lar deg klassifisere bilder. Noen kjente eksempler på bildeklassifisering inkluderer klassifisering av håndskrevne sifre, medisinsk bildeklassifisering og ansiktsgjenkjenning. Bildeklassifisering er en nyttig teknikk med flere forretningsapplikasjoner, men å bygge en god bildeklassifiseringsmodell er ikke trivielt.

Flere hensyn kan spille en rolle når man skal vurdere en ML-modell. Utover modellnøyaktighet, er andre potensielle beregninger av betydning modelltreningstid og slutningstid. Gitt den iterative karakteren til utvikling av ML-modeller, gjør raskere treningstider det mulig for dataforskere å raskt teste ulike hypoteser. Raskere inferencing kan være avgjørende i sanntidsapplikasjoner.

Amazon SageMaker JumpStart gir ett-klikks finjustering og distribusjon av et bredt utvalg av forhåndstrente modeller på tvers av populære ML-oppgaver, samt et utvalg ende-til-ende-løsninger som løser vanlige forretningsproblemer. Disse funksjonene fjerner de tunge løftene fra hvert trinn i ML-prosessen, noe som gjør det enklere å utvikle høykvalitetsmodeller og reduserer tiden til utrulling. JumpStart APIer lar deg programmere distribuere og finjustere et stort utvalg av JumpStart-støttede forhåndstrente modeller på dine egne datasett.

Du kan trinnvis trene og justere ML-modellene som tilbys i JumpStart før distribusjon. I skrivende stund er 87 dyplæringsbaserte bildeklassifiseringsmodeller tilgjengelige i JumpStart.

Men hvilken modell vil gi deg de beste resultatene? I dette innlegget presenterer vi en metodikk for enkelt å kjøre flere modeller og sammenligne resultatene deres på tre dimensjoner av interesse: modellnøyaktighet, treningstid og slutningstid.

Løsningsoversikt

JumpStart lar deg trene, stille inn og distribuere modeller enten fra JumpStart-konsollen ved å bruke brukergrensesnittet eller med API-en. I dette innlegget bruker vi API-ruten, og presenterer en notatbok med ulike hjelpeskript. Du kan kjøre denne notatboken og få resultater for enkel sammenligning av disse modellene mot hverandre, og deretter velge en modell som passer best for bedriftens behov når det gjelder modellnøyaktighet, treningstid og slutningstid.

De offentlig datasett brukt i dette innlegget består av nesten 55,000 0 bilder av syke og friske planteblader samlet under kontrollerte forhold, med klasseetiketter fra 38–44,000. Dette datasettet er delt inn i tog- og valideringsdatasett, med omtrent 11,000 XNUMX under opplæring og XNUMX XNUMX bilder under validering. Følgende er noen eksempler på bilder.

For denne øvelsen valgte vi modeller fra to rammeverk – PyTorch og TensorFlow – som tilbys av JumpStart. Følgende 15 modellalgoritmer dekker et bredt spekter av populære nevrale nettverksarkitekturer fra disse rammeverkene:

pytorch-ic-alexnet-FTpytorch-ic-densenet121-FTpytorch-ic-densenet201-FTpytorch-ic-googlenet-FTpytorch-ic-mobilenet-v2-FTpytorch-ic-resnet152-FTpytorch-ic-resnet34-FTtensorflow-ic-bit-s-r101x1-ilsvrc2012-classification-1-FTtensorflow-ic-imagenet-inception-resnet-v2-classification 4-FTtensorflow-ic-imagenet-inception-v3-classification-4-FTtensorflow-ic-imagenet-mobilenet-v2-050-224-classification-4-FTtensorflow-ic-imagenet-mobilenet-v2-075-224-classification-4-FTtensorflow-ic-imagenet-mobilenet-v2-140-224-classification-4-FTtensorflow-ic-imagenet-resnet-v2-152-classification-4-FTtensorflow-ic-tf2-preview-mobilenet-v2-classification-4-FT

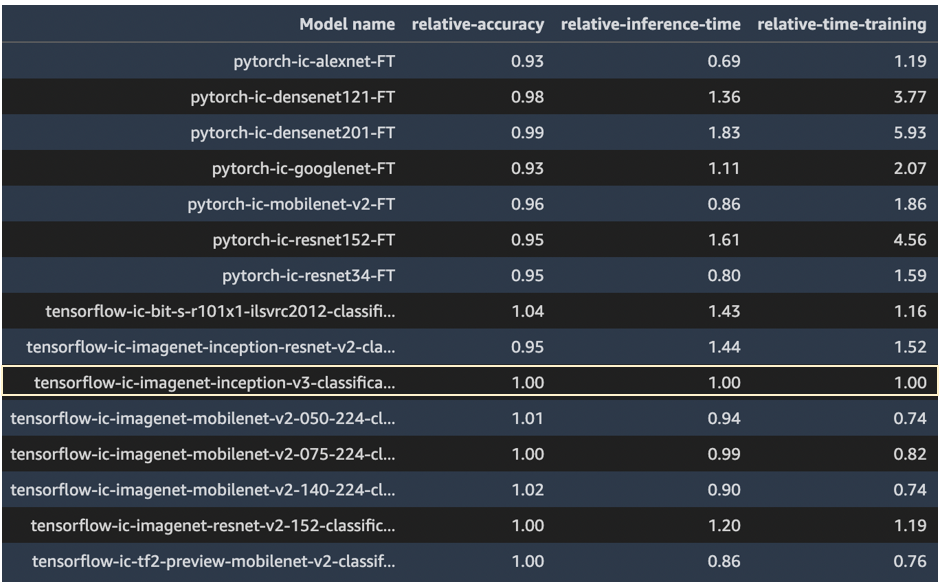

Vi bruker modellen tensorflow-ic-imagenet-inception-v3-classification-4-FT som en base som resultater fra andre modeller sammenlignes mot. Denne basismodellen ble valgt vilkårlig.

Koden som brukes til å kjøre denne sammenligningen er tilgjengelig på AWS prøver GitHub repo.

Resultater

I denne delen presenterer vi resultatene fra disse 15 løpene. For alle disse kjøringene var hyperparametrene som ble brukt epoker = 5, læringshastighet = 0.001, batchstørrelse = 16.

Modellnøyaktighet, treningstid og slutningstid fra modell tensorflow-ic-imagenet-inception-v3-classification-4-FT ble tatt som basis, og resultater fra alle andre modeller er presentert i forhold til denne basismodellen. Vår intensjon her er ikke å vise hvilken modell som er best, men heller å vise hvordan du gjennom JumpStart API kan sammenligne resultater fra ulike modeller og deretter velge en modell som passer best til ditt bruksområde.

Følgende skjermbilde fremhever basismodellen som alle andre modeller ble sammenlignet med.

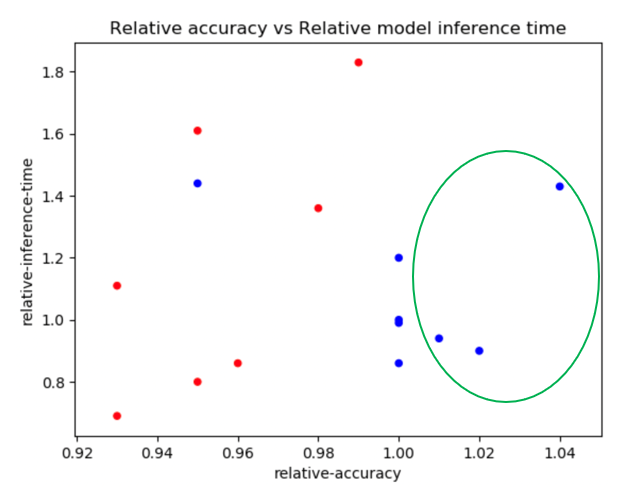

Følgende plot viser en detaljert oversikt over relativ nøyaktighet vs. relativ treningstid. PyTorch-modeller er fargekodet i rødt og TensorFlow-modeller i blått.

Modellene fremhevet med en grønn ellipse i det foregående plottet ser ut til å ha en god kombinasjon av relativ nøyaktighet og lav relativ treningstid. Tabellen nedenfor gir flere detaljer om disse tre modellene.

| Modellnavn | Relativ nøyaktighet | Relativ treningstid |

| tensorflow-ic-imagenet-mobilenet-v2-050-224-classification-4-FT | 1.01 | 0.74 |

| tensorflow-ic-imagenet-mobilenet-v2-140-224-classification-4-FT | 1.02 | 0.74 |

| tensorflow-ic-bit-s-r101x1-ilsvrc2012-classification-1-FT | 1.04 | 1.16 |

Følgende plot sammenligner relativ nøyaktighet vs. relativ slutningstid. PyTorch-modeller er fargekodet i rødt og TensorFlow-modeller i blått.

Tabellen nedenfor gir detaljer om de tre modellene i den grønne ellipsen.

| Modellnavn | Relativ nøyaktighet | Relativ slutningstid |

| tensorflow-ic-imagenet-mobilenet-v2-050-224-classification-4-FT | 1.01 | 0.94 |

| tensorflow-ic-imagenet-mobilenet-v2-140-224-classification-4-FT | 1.02 | 0.90 |

| tensorflow-ic-bit-s-r101x1-ilsvrc2012-classification-1-FT | 1.04 | 1.43 |

De to plottene viser tydelig at enkelte modellalgoritmer presterte bedre enn andre på de tre dimensjonene som ble valgt. Fleksibiliteten som tilbys gjennom denne øvelsen kan hjelpe deg med å velge riktig algoritme, og ved å bruke den medfølgende notatboken kan du enkelt kjøre denne typen eksperiment på alle de 87 tilgjengelige modellene.

konklusjonen

I dette innlegget viste vi hvordan du bruker JumpStart til å bygge høyytende bildeklassifiseringsmodeller på flere dimensjoner av interesse, for eksempel modellnøyaktighet, treningstid og slutningsforsinkelse. Vi ga også koden for å kjøre denne øvelsen på ditt eget datasett; du kan velge hvilken som helst modell av interesse fra de 87 modellene som for øyeblikket er tilgjengelige for bildeklassifisering i JumpStart-modellhuben. Vi oppfordrer deg til å prøve det i dag.

For mer informasjon om JumpStart, se SageMaker JumpStart.

Om forfatterne

Dr. Raju Penmatcha er en AI/ML Specialist Solutions Architect i AI-plattformer ved AWS. Han fikk sin doktorgrad fra Stanford University. Han jobber tett med lav/ingen kode-serien av tjenester i SageMaker, som hjelper kundene enkelt å bygge og distribuere maskinlæringsmodeller og -løsninger. Når han ikke hjelper kunder, liker han å reise til nye steder.

Dr. Raju Penmatcha er en AI/ML Specialist Solutions Architect i AI-plattformer ved AWS. Han fikk sin doktorgrad fra Stanford University. Han jobber tett med lav/ingen kode-serien av tjenester i SageMaker, som hjelper kundene enkelt å bygge og distribuere maskinlæringsmodeller og -løsninger. Når han ikke hjelper kunder, liker han å reise til nye steder.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker innebygde algoritmer og hjelper til med å utvikle maskinlæringsalgoritmer. Han fikk sin doktorgrad fra University of Illinois Urbana-Champaign. Han er en aktiv forsker innen maskinlæring og statistisk inferens, og har publisert mange artikler på NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP-konferanser.

Dr. Ashish Khetan er en Senior Applied Scientist med Amazon SageMaker innebygde algoritmer og hjelper til med å utvikle maskinlæringsalgoritmer. Han fikk sin doktorgrad fra University of Illinois Urbana-Champaign. Han er en aktiv forsker innen maskinlæring og statistisk inferens, og har publisert mange artikler på NeurIPS, ICML, ICLR, JMLR, ACL og EMNLP-konferanser.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- Amazon SageMaker JumpStart

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- Middels (200)

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet