Maskinlæring (ML) hjelper organisasjoner med å øke inntektene, drive virksomhetsvekst og redusere kostnadene ved å optimalisere kjernevirksomhetsfunksjoner på tvers av flere vertikaler, for eksempel etterspørselsprognoser, kredittscoring, prissetting, forutsi kundefragang, identifisere nest beste tilbud, forutsi sene forsendelser og forbedre produksjonskvaliteten. Tradisjonelle ML-utviklingssykluser tar måneder og krever knappe datavitenskap og ML-ingeniørferdigheter. Analytikeres ideer for ML-modeller sitter ofte i lange etterslep mens de venter på datavitenskapsteamets båndbredde, mens dataforskere fokuserer på mer komplekse ML-prosjekter som krever deres fulle kompetanse.

For å bidra til å bryte denne fastlåsningen, har vi introduserte Amazon SageMaker Canvas, en kodefri ML-løsning som kan hjelpe bedrifter med å akselerere levering av ML-løsninger ned til timer eller dager. SageMaker Canvas gjør det mulig for analytikere å enkelt bruke tilgjengelige data i datainnsjøer, datavarehus og driftsdatalagre; bygge ML-modeller; og bruke dem til å lage spådommer interaktivt og for batch-scoring på bulkdatasett – alt uten å skrive en eneste kodelinje.

I dette innlegget viser vi hvordan SageMaker Canvas muliggjør samarbeid mellom dataforskere og forretningsanalytikere, oppnår raskere time to market og akselererer utviklingen av ML-løsninger. Analytikere får sitt eget ML-arbeidsområde uten kode i SageMaker Canvas, uten å måtte bli en ML-ekspert. Analytikere kan deretter dele modellene sine fra Canvas med noen få klikk, som dataforskere vil kunne jobbe med i Amazon SageMaker Studio, et ende-til-ende ML integrert utviklingsmiljø (IDE). Ved å jobbe sammen kan forretningsanalytikere ta med seg domenekunnskapen og resultatene av eksperimentet, mens dataforskere effektivt kan lage rørledninger og effektivisere prosessen.

La oss gå dypt inn i hvordan arbeidsflyten vil se ut.

Forretningsanalytikere bygger en modell, og deler den deretter

For å forstå hvordan SageMaker Canvas forenkler samarbeid mellom forretningsanalytikere og dataforskere (eller ML-ingeniører), nærmer vi oss først prosessen som forretningsanalytiker. Før du setter i gang, se Kunngjøring av Amazon SageMaker Canvas – en visuell maskinlæringsevne uten kode for forretningsanalytikere for instruksjoner om å bygge og teste modellen med SageMaker Canvas.

For dette innlegget bruker vi en modifisert versjon av Datasett for oppdagelse av kredittkortsvindel fra Kaggle, et velkjent datasett for et binært klassifiseringsproblem. Datasettet er opprinnelig svært ubalansert – det har svært få oppføringer klassifisert som en negativ klasse (unormale transaksjoner). Uavhengig av målfunksjonsdistribusjonen, kan vi fortsatt bruke dette datasettet, fordi SageMaker Canvas håndterer denne ubalansen når den trener og tuner en modell automatisk. Dette datasettet består av rundt 9 millioner celler. Du kan også laste ned en redusert versjon av dette datasettet. Datasettstørrelsen er mye mindre, på rundt 500,000 0 celler, fordi den har blitt tilfeldig undersamplet og deretter oversamplet med SMOTE-teknikken for å sikre at så lite informasjon som mulig går tapt under denne prosessen. Å kjøre et helt eksperiment med dette reduserte datasettet koster deg $XNUMX under SageMaker Canvas Free Tier.

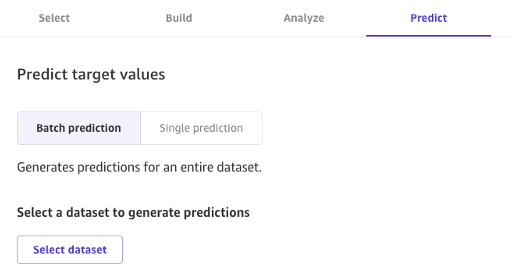

Etter at modellen er bygget, kan analytikere bruke den til å lage spådommer direkte i Canvas for enten individuelle forespørsler, eller for et helt input-datasett i bulk.

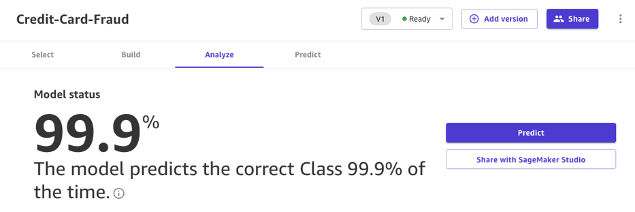

Modeller bygget med Canvas Standard Build kan også enkelt deles med et klikk på en knapp med dataforskere og ML-ingeniører som bruker SageMaker Studio. Dette lar en dataforsker validere ytelsen til modellen du har bygget og gi tilbakemelding. ML-ingeniører kan plukke opp modellen din og integrere den med eksisterende arbeidsflyter og produkter tilgjengelig for din bedrift og dine kunder. Merk at i skrivende stund er det ikke mulig å dele en modell bygget med Canvas Quick Build, eller en tidsserieprognosemodell.

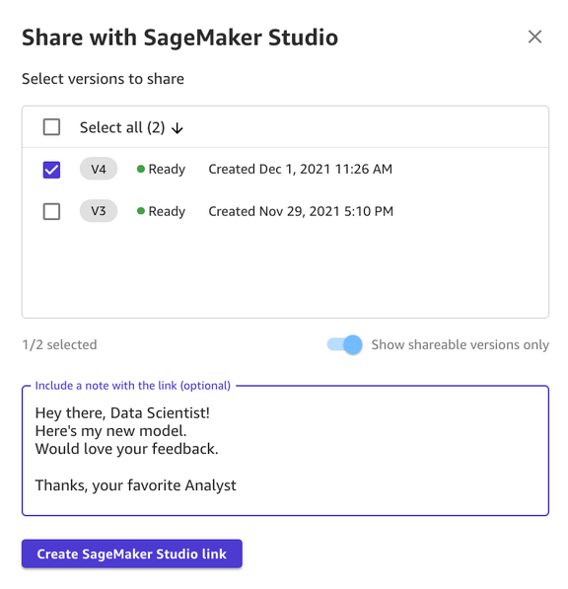

Å dele en modell via Canvas UI er enkelt:

- Velg en modell på siden som viser modellene du har laget.

- Velg Del.

- Velg én eller flere versjoner av modellen du vil dele.

- Du kan eventuelt inkludere et notat som gir mer kontekst om modellen eller hjelpen du leter etter.

- Velg Lag SageMaker Studio Link.

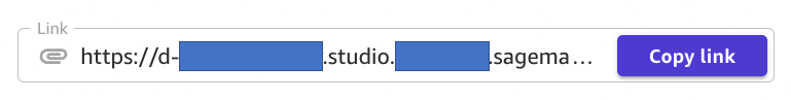

- Kopier den genererte lenken.

Og det er det! Du kan nå dele lenken med kollegene dine via Slack, e-post eller en hvilken som helst annen metode du foretrekker. Dataforskeren må være i samme SageMaker Studio-domene for å få tilgang til modellen din, så sørg for at dette er tilfelle med organisasjonsadministratoren din.

Dataforskere får tilgang til modellinformasjonen fra SageMaker Studio

La oss nå spille rollen som en dataforsker eller ML-ingeniør, og se ting fra deres synspunkt ved å bruke SageMaker Studio.

Linken som er delt av analytikeren tar oss inn i SageMaker Studio, den første skybaserte IDE-en for ende-til-ende ML-arbeidsflyten.

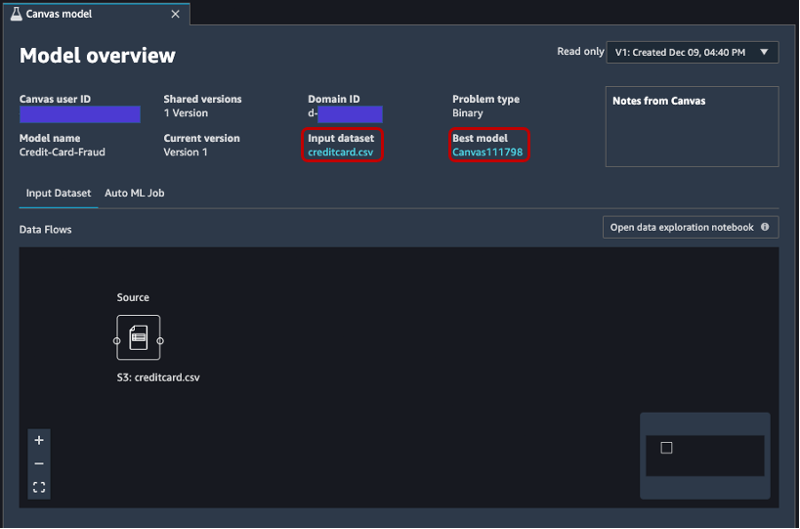

Fanen åpnes automatisk, og viser en oversikt over modellen laget av analytikeren i SageMaker Canvas. Du kan raskt se modellens navn, ML-problemtypen, modellversjonen og hvilken bruker som har laget modellen (under feltet Canvas bruker-ID). Du har også tilgang til detaljer om input-datasettet og den beste modellen som SageMaker var i stand til å produsere. Det skal vi dykke ned i senere i innlegget.

På Inndatasett fanen, kan du også se dataflyten fra kilden til inndatasettet. I dette tilfellet brukes bare én datakilde og ingen sammenføyningsoperasjoner er brukt, så en enkelt kilde vises. Du kan analysere statistikk og detaljer om datasettet ved å velge Åpne notatbok for datautforskning. Denne notatboken lar deg utforske dataene som var tilgjengelige før trening av modellen, og inneholder en analyse av målvariabelen, et utvalg av inputdata, statistikk og beskrivelser av kolonner og rader, samt annen nyttig informasjon for dataforskeren å vite mer om datasettet. For å lære mer om denne rapporten, se Datautforskningsrapport.

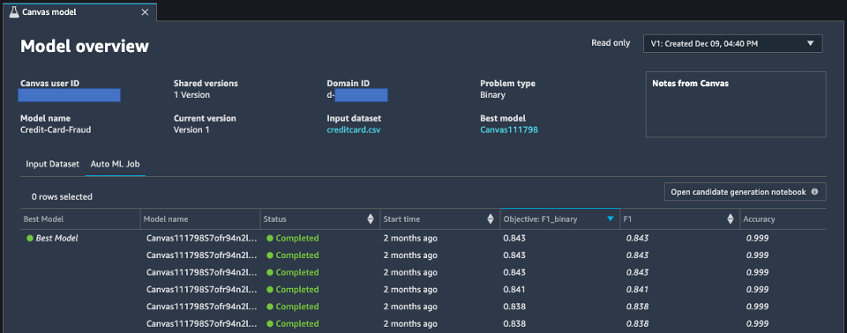

Etter å ha analysert inndatasettet, la oss gå videre til den andre fanen i modelloversikten, AutoML jobb. Denne kategorien inneholder en beskrivelse av AutoML-jobben når du valgte Standard Build-alternativet i SageMaker Canvas.

AutoML-teknologien under SageMaker Canvas eliminerer de tunge løftene ved å bygge ML-modeller. Den bygger, trener og justerer automatisk den beste ML-modellen basert på dataene dine ved å bruke en automatisert tilnærming, samtidig som den lar deg opprettholde full kontroll og synlighet. Denne synligheten på de genererte kandidatmodellene så vel som hyperparametrene som brukes under AutoML-prosessen, finnes i notatbok for kandidatgenerering, som er tilgjengelig på denne fanen.

De AutoML jobb fanen inneholder også en liste over hver modell som er bygget som en del av AutoML-prosessen, sortert etter F1-målberegningen. For å fremheve den beste modellen av opplæringsjobbene som er lansert, brukes en merkelapp med en grønn sirkel i Beste modell kolonne. Du kan også enkelt visualisere andre beregninger som brukes under trenings- og evalueringsfasen, for eksempel nøyaktighetsscore og Area Under the Curve (AUC). For å lære mer om modellene du kan trene under en AutoML-jobb og beregningene som brukes for å evaluere ytelsen til den trente modellen, se Modellstøtte, beregninger og validering.

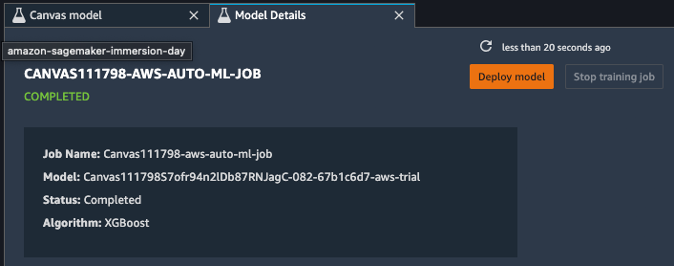

For å lære mer om modellen kan du nå høyreklikke på den beste modellen og velge Åpne i modelldetaljer. Alternativt kan du velge Beste modellen lenke øverst på Modelloversikt delen du først besøkte.

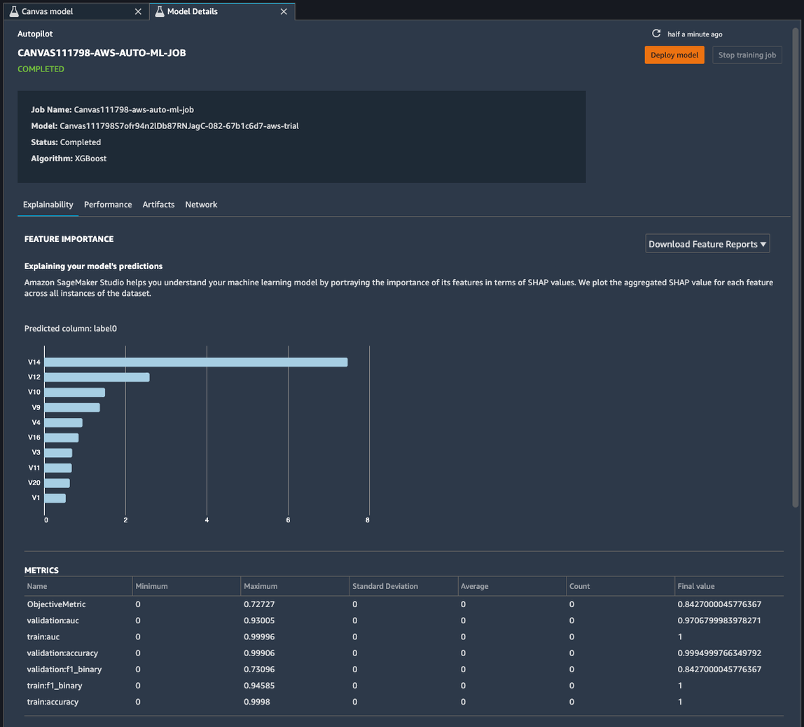

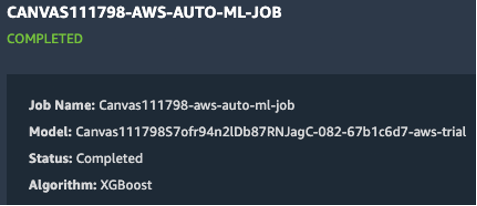

Modelldetaljer-siden inneholder en mengde nyttig informasjon om modellen som presterte best med disse inndataene. La oss først fokusere på sammendraget øverst på siden. Skjermbildet ovenfor viser at av hundrevis av modelltreningsløp, presterte en XGBoost-modell best på inndatadatasettet. Når dette skrives, kan SageMaker Canvas trene tre typer ML-algoritmer: lineær innlærer, XGBoost og en flerlagsperceptron (MLP), hver med et bredt utvalg av forbehandlingsrørledninger og hyperparametere. For å lære mer om hver algoritme, se side med støttede algoritmer.

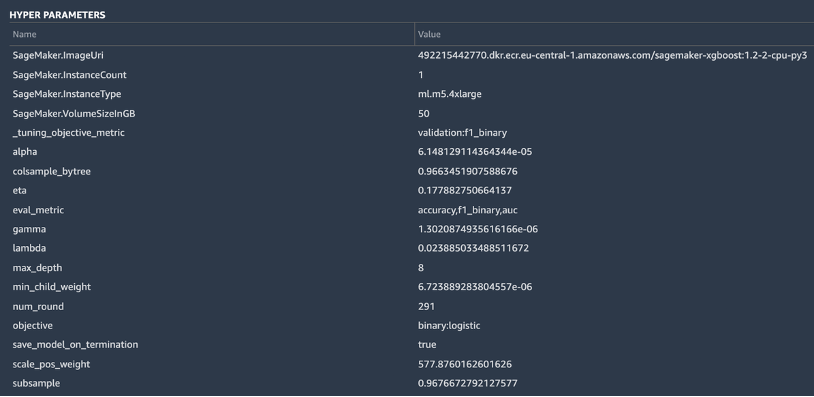

SageMaker inkluderer også en forklarende funksjonalitet takket være en skalerbar og effektiv implementering av KernelSHAP, basert på konseptet om en Shapley-verdi fra feltet kooperativ spillteori som tildeler hver funksjon en viktighetsverdi for en bestemt prediksjon. Dette gir åpenhet om hvordan modellen kom frem til sine spådommer, og det er veldig nyttig å definere funksjonens betydning. En fullstendig forklaringsrapport inkludert funksjonsviktighet kan lastes ned i PDF-, notatbok- eller rådataformat. I den rapporten vises et bredere sett med beregninger i tillegg til en fullstendig liste over hyperparametere som ble brukt under AutoML-jobben. For å lære mer om hvordan SageMaker tilbyr integrerte forklaringsverktøy for AutoML-løsninger og standard ML-algoritmer, se Bruk integrerte forklaringsverktøy og forbedre modellkvaliteten ved å bruke Amazon SageMaker Autopilot.

Til slutt viser de andre fanene i denne visningen informasjon om ytelsesdetaljer (forvirringsmatrise, presisjonsgjenkallingskurve, ROC-kurve), artefakter brukt for innganger og generert under AutoML-jobben, og nettverksdetaljer.

På dette tidspunktet har dataforskeren to valg: distribuere modellen direkte, eller opprette en treningspipeline som kan planlegges eller utløses manuelt eller automatisk. De følgende delene gir litt innsikt i begge alternativene.

Distribuer modellen direkte

Hvis dataforskeren er fornøyd med resultatene oppnådd av AutoML-jobben, kan de distribuere modellen direkte fra Modelldetaljer side. Det er like enkelt som å velge Implementer modell ved siden av modellnavnet.

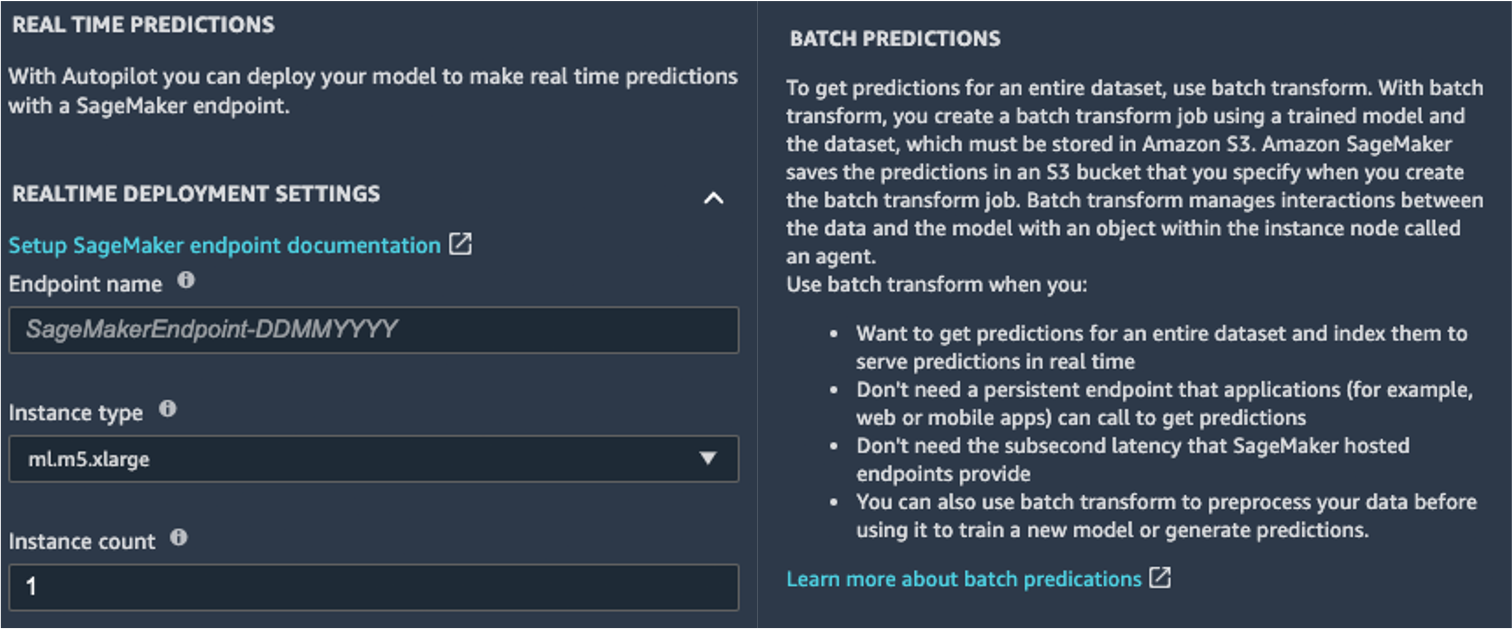

SageMaker viser deg to alternativer for distribusjon: et endepunkt i sanntid, drevet av Amazon SageMaker-endepunkter, og batch-inferens, drevet av Batchtransformasjon fra Amazon SageMaker.

SageMaker tilbyr også andre slutningsmåter. For å lære mer, se Distribuer modeller for inferens.

For å aktivere sanntidsprediksjonsmodus, gir du ganske enkelt endepunktet et navn, en forekomsttype og en forekomsttelling. Fordi denne modellen ikke krever store dataressurser, kan du bruke en CPU-basert forekomst med et startantall på 1. Du kan lære mer om de forskjellige typene tilgjengelige forekomster og deres spesifikasjoner på Amazon SageMaker-prisside (i On-Demand-priser velger du Sanntidsslutning fanen). Hvis du ikke vet hvilken instans du bør velge for distribusjonen din, kan du også be SageMaker om å finne den beste for deg i henhold til KPI-ene dine ved å bruke SageMaker Inference Recommender. Du kan også angi flere valgfrie parametere, angående hvorvidt du vil fange opp forespørsels- og svardata til eller fra endepunktet. Dette kan være nyttig hvis du planlegger det overvåking av modellen din. Du kan også velge hvilket innhold du vil gi som en del av svaret ditt – enten det bare er prediksjonen eller prediksjonssannsynligheten, sannsynligheten for alle klasser og måletikettene.

For å kjøre en batch-scoringsjobb og få spådommer for et helt sett med innganger på en gang, kan du starte batch-transformeringsjobben fra AWS-administrasjonskonsoll eller via SageMaker Python SDK. For å lære mer om batchtransformasjon, se Bruk Batch Transform og eksempelnotatbøkene.

Definer en treningspipeline

ML-modeller kan svært sjelden, om noen gang, betraktes som statiske og uforanderlige, fordi de driver fra grunnlinjen de har blitt trent på. Data fra den virkelige verden utvikler seg over tid, og flere mønstre og innsikt dukker opp fra dem, som kanskje fanges opp av den originale modellen som er trent på historiske data. For å løse dette problemet kan du sette opp en treningspipeline som automatisk omskoler modellene dine med de siste tilgjengelige dataene.

Ved å definere denne pipelinen er et av alternativene til dataforskeren å igjen bruke AutoML for treningspipelinen. Du kan starte en AutoML-jobb programmatisk ved å starte create_auto_ml_job() API fra AWS Boto3 SDK. Du kan ringe denne operasjonen fra en AWS Lambda funksjon innenfor en AWS trinnfunksjoner arbeidsflyt, eller fra en LambdaStep in Amazon SageMaker-rørledninger.

Alternativt kan dataforskeren bruke kunnskapen, artefaktene og hyperparametrene hentet fra AutoML-jobben for å definere en komplett treningspipeline. Du trenger følgende ressurser:

- Algoritmen som fungerte best for brukstilfellet – Du har allerede fått denne informasjonen fra sammendraget av den Canvas-genererte modellen. For denne brukssaken er det den innebygde XGBoost-algoritmen. For instruksjoner om hvordan du bruker SageMaker Python SDK for å trene XGBoost-algoritmen med SageMaker, se Bruk XGBoost med SageMaker Python SDK.

- Hyperparametrene utledet av AutoML-jobben – Disse er tilgjengelige i Forklarbarhet seksjon. Du kan bruke dem som input når du definerer treningsjobben med SageMaker Python SDK.

- Funksjonsteknikkkoden oppgitt i Artefakter-delen – Du kan bruke denne koden både for å forhåndsbehandle dataene før trening (for eksempel via Amazon SageMaker Processing), eller før inferens (for eksempel som en del av en SageMaker-inferenspipeline).

Du kan kombinere disse ressursene som en del av en SageMaker-pipeline. Vi utelater implementeringsdetaljene i dette innlegget – følg med for mer innhold som kommer om dette emnet.

konklusjonen

SageMaker Canvas lar deg bruke ML til å generere spådommer uten å måtte skrive noen kode. En forretningsanalytiker kan autonomt begynne å bruke den med lokale datasett, så vel som data som allerede er lagret på Amazon enkel lagringstjeneste (Amazon S3), Amazon RedShift, eller Snowflake. Med bare noen få klikk kan de forberede og slå sammen datasettene sine, analysere estimert nøyaktighet, verifisere hvilke kolonner som har effekt, trene opp modellen med best ytelse og generere nye individuelle eller batch-prediksjoner, alt uten behov for å trekke inn en ekspert dataforsker. Deretter kan de, etter behov, dele modellen med et team av dataforskere eller MLOps-ingeniører, som importerer modellene til SageMaker Studio, og jobber sammen med analytikeren for å levere en produksjonsløsning.

Forretningsanalytikere kan uavhengig få innsikt fra dataene sine uten å ha en grad i ML, og uten å måtte skrive en eneste linje med kode. Dataforskere kan nå ha ekstra tid til å jobbe med mer utfordrende prosjekter som bedre kan bruke deres omfattende kunnskap om AI og ML.

Vi tror dette nye samarbeidet åpner døren for å bygge mange kraftigere ML-løsninger for din virksomhet. Du har nå analytikere som produserer verdifull forretningsinnsikt, samtidig som du lar dataforskere og ML-ingeniører hjelpe til med å finjustere, justere og utvide etter behov.

Tilleggsressurser

- For å lære mer om hvordan SageMaker kan hjelpe forretningsanalytikere ytterligere, se Amazon SageMaker for forretningsanalytikere.

- For å finne ut mer om hvordan SageMaker lar dataforskere utvikle, trene og distribuere ML-modellene deres, sjekk ut Amazon SageMaker for dataforskere.

- For mer informasjon om hvordan SageMaker kan hjelpe MLOps-ingeniører med å strømlinjeforme ML-livssyklusen ved å bruke MLOps, se Amazon SageMaker for MLOps-ingeniører.

Om forfatterne

Davide Gallitelli er en spesialistløsningsarkitekt for AI/ML i EMEA-regionen. Han er basert i Brussel og jobber tett med kunder i hele Benelux. Han har vært utvikler siden han var veldig ung, og begynte å kode i en alder av 7. Han begynte å lære AI/ML på universitetet, og har forelsket seg i det siden den gang.

Davide Gallitelli er en spesialistløsningsarkitekt for AI/ML i EMEA-regionen. Han er basert i Brussel og jobber tett med kunder i hele Benelux. Han har vært utvikler siden han var veldig ung, og begynte å kode i en alder av 7. Han begynte å lære AI/ML på universitetet, og har forelsket seg i det siden den gang.

Mark Roy er en hovedarkitektlæringsarkitekt for AWS, som hjelper kunder med å designe og bygge AI / ML-løsninger. Marks arbeid dekker et bredt spekter av ML-brukstilfeller, med hovedinteresse i datasyn, dyp læring og skalering av ML over hele virksomheten. Han har hjulpet selskaper i mange bransjer, inkludert forsikring, finansielle tjenester, media og underholdning, helsetjenester, verktøy og produksjon. Mark har seks AWS-sertifiseringer, inkludert ML-spesialitetssertifisering. Før han begynte i AWS, var Mark arkitekt, utvikler og teknologileder i over 25 år, inkludert 19 år innen finansielle tjenester.

Mark Roy er en hovedarkitektlæringsarkitekt for AWS, som hjelper kunder med å designe og bygge AI / ML-løsninger. Marks arbeid dekker et bredt spekter av ML-brukstilfeller, med hovedinteresse i datasyn, dyp læring og skalering av ML over hele virksomheten. Han har hjulpet selskaper i mange bransjer, inkludert forsikring, finansielle tjenester, media og underholdning, helsetjenester, verktøy og produksjon. Mark har seks AWS-sertifiseringer, inkludert ML-spesialitetssertifisering. Før han begynte i AWS, var Mark arkitekt, utvikler og teknologileder i over 25 år, inkludert 19 år innen finansielle tjenester.

- Myntsmart. Europas beste Bitcoin og Crypto Exchange.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. FRI TILGANG.

- CryptoHawk. Altcoin Radar. Gratis prøveperiode.

- Kilde: https://aws.amazon.com/blogs/machine-learning/build-share-deploy-how-business-analysts-and-data-scientists-achieve-faster-time-to-market-using-no- code-ml-and-amazon-sagemaker-canvas/

- "

- 000

- 100

- 7

- 9

- Om oss

- akselerere

- akselerer

- adgang

- Ifølge

- tvers

- Ytterligere

- admin

- AI

- algoritme

- algoritmer

- Alle

- tillate

- allerede

- Amazon

- analyse

- analytiker

- api

- tilnærming

- AREA

- rundt

- Automatisert

- tilgjengelig

- AWS

- Baseline

- bli

- BEST

- grensen

- Brussel

- bygge

- Bygning

- bygger

- innebygd

- virksomhet

- ring

- saker

- sertifisering

- valg

- Circle

- klassifisering

- kode

- samarbeid

- Kolonne

- kommer

- Selskaper

- Selskapet

- komplekse

- Beregn

- konsept

- forvirring

- inneholder

- innhold

- kontroll

- samarbeidende

- Kjerne

- Kostnader

- kreditt

- skjøger

- Kunder

- dato

- datavitenskap

- dataforsker

- levering

- Etterspørsel

- utplassere

- distribusjon

- utforming

- Gjenkjenning

- utvikle

- Utvikler

- Utvikling

- forskjellig

- distribusjon

- ikke

- domene

- ned

- lett

- effektiv

- emalje

- Endpoint

- ingeniør

- Ingeniørarbeid

- Ingeniører

- Enterprise

- Entertainment

- Miljø

- anslått

- eksempel

- eksperiment

- leting

- utvide

- raskere

- Trekk

- tilbakemelding

- finansiell

- finansielle tjenester

- Først

- flyten

- Fokus

- etter

- format

- svindel

- Gratis

- fullt

- funksjon

- funksjonalitet

- spill

- generere

- få

- Giving

- Grønn

- Vekst

- å ha

- helsetjenester

- hjelpe

- hjelper

- Uthev

- svært

- historisk

- holder

- Hvordan

- Hvordan

- HTTPS

- Hundrevis

- betydning

- forbedre

- inkludere

- Inkludert

- Øke

- individuelt

- bransjer

- informasjon

- innsikt

- forsikring

- integrere

- integrert

- interesse

- IT

- Jobb

- Jobb

- bli medlem

- kunnskap

- etiketter

- siste

- lansere

- LÆRE

- læring

- linje

- LINK

- Liste

- lite

- lokal

- Lang

- ser

- elsker

- maskin

- maskinlæring

- ledelse

- manuelt

- produksjon

- merke

- marked

- Matrix

- Media

- Metrics

- millioner

- ML

- modell

- modeller

- måneder

- flytte

- nettverk

- bærbare

- Tilbud

- åpner

- Drift

- Alternativ

- alternativer

- rekkefølge

- organisasjon

- organisasjoner

- Annen

- ytelse

- forestillinger

- fase

- planlegging

- Spille

- Synspunkt

- mulig

- kraftig

- prediksjon

- Spådommer

- prising

- primære

- Principal

- Problem

- prosess

- produsere

- Produksjon

- Produkter

- prosjekter

- gi

- gir

- trekke

- kvalitet

- raskt

- område

- Raw

- sanntids

- redusere

- rapporterer

- krever

- Ressurser

- svar

- Resultater

- inntekter

- Kjør

- rennende

- skalerbar

- skalering

- Vitenskap

- Forsker

- forskere

- SDK

- valgt

- Serien

- Tjenester

- sett

- Del

- delt

- Enkelt

- SIX

- Størrelse

- ferdigheter

- slakk

- So

- Solutions

- LØSE

- Begynn

- startet

- statistikk

- lagring

- butikker

- studio

- støtte

- Target

- lag

- Teknologi

- Testing

- Kilden

- hele

- tid

- sammen

- verktøy

- topp

- tradisjonelle

- Kurs

- Togene

- Transaksjoner

- Transform

- Åpenhet

- ui

- forstå

- universitet

- us

- bruke

- verdi

- Se

- synlighet

- syn

- Hva

- om

- HVEM

- innenfor

- uten

- Arbeid

- arbeidet

- arbeid

- virker

- skriving

- år