Hvis du har vært på sosiale medier denne uken, har du sannsynligvis kommet over bilder av AI-genererte bilder av vennene dine som fevesener, animé-figurer, avatarer og magiske vesener.

Dette skyldes delvis Lensa, en kunstig intelligens som syntetiserer digitale portretter basert på bilder brukere laster opp. Appens portretter tok praktisk talt over internett, med Lensa som ble den mest nedlastede appen i Apples appbutikk.

Lensa, som alle AI-applikasjoner som digitalt gjengir bilder, har beundret både beundring og kontrovers for sin tilsynelatende åpenbare seksualisering av kvinnelige bilder. Andre brukere bemerket at appen gjorde huden blekere eller kroppen tynnere.

Les også: AI-teknologi som skaper livsødeleggende dype falske bilder

Hvordan få din egen "magiske avatar"

Bildene som går rundt er en stolt kreasjon av Lensas magiske avatarfunksjon. For å få en følelse av det, må man laste ned Lensa-appen på en telefon. Et årlig abonnement er rundt $35.99, men tjenestene er også tilgjengelige, om enn med begrensninger gratis på en ukes prøveperiode hvis man vil sjekke det ut først.

Generering av populære magiske avatarer krever imidlertid en ekstra avgift på grunn av det appen sier er "enorm beregningskraft" å oppnå.

På en gratis prøveversjon kan man få 50 avatarer for $3.99, og 200 avatarer for $7.99. For å få de beste resultatene oppfordrer appen brukere til å laste opp minst 20 nærbilder.

Ideelt sett bør disse bildene være nærbilder av ens ansikt med en rekke ulike bakgrunner, ansiktsuttrykk og vinkler. Appen insisterer på at brukere skal være 13 år eller eldre. Lensa er ikke en helt ny applikasjon.

Et produkt fra Prisma, applikasjonen ble først populær i 2016 takket være en funksjon som tillot brukere å endre selfiene sine til bilder i stil med kjente artister.

Hvordan fungerer Lensa?

Ifølge selskapet bruker det det det kaller "TrueDepth API-teknologi" der en bruker gir bilder, eller "ansiktsdata", så blir AI deretter trent på sine algoritmer for å yte bedre og vise deg bedre resultater. Trening er når AI behandler data, validerer og tester modellene.

For å bruke appen kan man kurere 20 selfies med en rekke uttrykk og vinkler og velge alternativet 100 avatarer.

Det tar omtrent 20 minutter å gjøre jobben. Når den er ferdig, returnerer AI avatarer som faller inn i 10 kategorier som fantasy, feprinsesse, fokus, pop, stilig, animé, lys, kawaii, iriserende og kosmisk.

"Generelt følte jeg at appen gjorde en anstendig jobb med å produsere kunstneriske bilder basert på selfiene mine. Jeg kunne ikke helt kjenne meg igjen i de fleste portrettene, men jeg kunne se hvor de kom fra. Zoe Sottile fra CNN skrev.

"Det så ut til å gjenkjenne og gjenta visse trekk, som min bleke hud eller den runde nesen, mer enn andre. Noen av dem var i en mer realistisk stil, og var nærme nok til at jeg kunne tro at de faktisk var bilder av meg hvis jeg så dem langveisfra. Andre var betydelig mer stiliserte og kunstneriske, så de føltes mindre spesifikke for meg.»

Sottile la merke til at AI også gjorde henne lettere.

Når det gjelder meg, ante jeg også at det automatisk gjorde meg lysere, og bildet jeg prøvde i galleriet mitt av meg og en venn som er lett mørkere i huden ga en noe mye lysere versjon av oss, tydelig en overdrivelse, og avslørte en tilbøyelighet til å lyse. svarte hudtoner.

Seksualisering av kvinner

Andre som brukte det hadde mer eller mindre lignende bekymringer.

Kvinner sier at AI er rask til å seksualisere bildene sine. Men i en tidligere artikkel, vi forklarte dette har blitt muliggjort av det enorme antallet seksualiserte bilder som finnes i datasett som brukes i AI-trening.

Med andre ord betyr dette at AI er altfor kjent med hvordan man genererer disse bildene og enkelt blir pornografisk. Med litt lureri kan det bli bedt om å uforvarende produsere porno fra disse bildene også hvis en bruker ønsker det.

seksualisering av en ung kvinne som tilbrakte mesteparten av tiden sin i offentligheten iført posete klær bare for å unngå denne typen seksualisering. forby menn fra å bruke AI https://t.co/YnNCurvYDS

— joan of arc but a commie (@postnuclearjoan) Desember 13, 2022

I andre historier har vi dekket hvordan AI:er kan lures til å gi informasjon om hvordan man lager en bombe for eksempel. Merkelig nok dukket ikke spørsmålet om seksualisering opp i bilder av menn lastet opp til Magic Avatar-funksjonen. For MIT Technology Review, Melissa Heikkilä skrev,

"Avatarene mine ble tegneserieaktig pornifisert, mens mine mannlige kolleger ble astronauter, oppdagelsesreisende og oppfinnere."

Sottile, derimot, la merke til at AI hadde "i et av de mest desorienterende bildene" fått henne til å se ut "som en versjon av ansiktet mitt var på en naken kropp."

"På flere bilder så det ut som om jeg var naken, men med et teppe strategisk plassert, eller bildet bare kuttet av for å skjule noe eksplisitt," sa hun.

"Og mange av bildene, selv der jeg var fullt påkledd, inneholdt et sensuelt ansiktsuttrykk, betydelig spalting og tynne klær som ikke stemte med bildene jeg hadde sendt inn," legger Zoe Sottile til.

Andre uttrykte frykt for at de ville bli gjort til pornostjerner av AI-teknologi som Lensa.

VARSEL: Hvem som helst i verden kan ha din IKKE-AVTALE PORNO nå !!

Folk er i ærefrykt for generative AI-verktøy som Lensa uten å forstå de alvorlige konsekvensene.

🧵 VERSTE DEL? Her er hva selskaper ikke vil at du skal vite: pic.twitter.com/gdS0h1FbXj

— Kritarth Mittal | Ghostwriter 🖋️ (@kritarthmittal) Desember 14, 2022

Body shaming

For kvinner med full kropp var opplevelsen noe annerledes og enda verre i noen tilfeller. AI gjorde dem tynnere og sexy.

"For Lmfao, hvis du har Body Dysmorphia, ikke bruk den Lensa-appen for de AI-genererte bildene. Dette er din advarsel,» en bruker skrev.

En annen sa at appen hadde fått henne til å se asiatisk ut.

Prøvde AI Lensa-appen. Fortell meg hvorfor AI fikk meg til å se mer asiatisk ut enn noen gang? 😂😂😂😂 pic.twitter.com/lveJNXaXHO

— Kristina🌴🌊🐚 (@kut1e) Desember 9, 2022

En annen bruker tok til twitter for å klage over at han hadde betalt $8 for å oppleve kroppsdysmorfi da han brukte AI.

betalte $8 til Lensa bare for å oppleve kroppsdysmorfi pic.twitter.com/NRYfh5Jyej

— garrett (@dollhaus_x) Desember 3, 2022

Kroppsdysmorfi er en psykisk helsetilstand der en person bruker mye tid på å bekymre seg for feil i utseendet. Disse feilene er ofte umerkelige for andre.

En annen klaget over at AI automatisk kastet betydelig vekt på hennes ellers fullfigursbilder.

"En klage jeg har på Lensa AI er at den vil gjøre deg tynn på noen bilder. Som en feit person plaget disse bildene meg veldig. Så pass på å ikke bli trigget hvis du er en fetter uten interesse for å bli tynn,» skrev Mariah Successful (@Shlatz) 5. desember 2022.

Psykologisk tidsinnstilt bombe

Og psykologer er enig i uttalelsene hennes om at AI kan utløse fullverdige kvinner.

En klinisk psykolog, Dr. Toni Pikoos, en australsk basert mental helseutøver, som forsker på og spesialiserer seg på behandling av kroppsdysmorfisk lidelse, mente programmet kunne gjøre mer skade enn nytte og er ikke annet enn et "fotofiltreringsverktøy" for å endre ens selvoppfatning.

"Når det er et større avvik mellom ideelt og oppfattet utseende, kan det gi næring til kroppsmisnøye, nød og et ønske om å fikse eller endre utseendet med potensielt usunne eller utrygge midler" som spiseforstyrrelser eller unødvendige kosmetiske prosedyrer, sier Pikoos.

Hun uttrykte bekymring over at bildene slettet «intrikate detaljer» som «fregner og linjer», noe som kan øke bekymringene for huden. Dette kan også psykologisk trigge en sårbar person, sier hun.

«Å se et eksternt bilde reflektere deres usikkerhet tilbake mot dem, forsterker bare ideen 'Se, dette er galt med meg! Og jeg er ikke den eneste som kan se det!'» sier Pikoos.

På grunn av det faktum at AI introduserer sine egne funksjoner som ikke skildrer en brukers virkelige utseende, kan appen skape nye bekymringer, sier han.

Hun sier at AIs "magiske avatarer" var "spesielt interessante fordi det virker mer objektivt - som om et eksternt, allvitende vesen har generert dette bildet av hvordan du ser ut."

Dette mener hun faktisk kan være "nyttig" for mennesker med kroppsdysmorfisk lidelse og bidra til å kaste lys over et "misforhold" mellom en "individs negative syn på seg selv og hvordan andre ser dem."

Hun bemerket imidlertid at AI ikke var objektiv på grunn av forsøket på å skildre en feilfri og mer "forbedret og perfeksjonert versjon" av ens ansikt.

For eksempel kan noen som opplever kroppsdysmorfisk lidelse, eller BDD, "oppleve en kort selvtillitsøkning når de ser på bildet sitt, og ønsker å dele denne versjonen av seg selv med verden," sier hun, men vil bli hardt rammet av virkeligheten når de er av. skjerm, ufiltrert, i speilet eller et bilde som de tar av seg selv.»

Forsvarer sitt eget

Andrey Usoltsev, administrerende direktør i Prisma Labs, sier at selskapet hans for øyeblikket er "overveldet" med henvendelser om Lensa og tilbød en lenke til en FAQ-side som tar for seg spørsmål om seksualiserte bilder, men ikke den typen brukerreaksjoner Pikoos beskriver.

"Å se dette reflektert i appen ville være veldig konfronterende og gi en slags "bekreftelse" for måten de ser seg selv på, noe som fører til at de blir "mer forankret i lidelsen."

Stabil diffusjon

Lensa bruker også Stable Diffusion, som bruker dyp-læringssyntese som kan lage nye bilder fra tekstbeskrivelser og kan kjøres på en Windows- eller Linux-PC, på en Mac eller i skyen på leid maskinvare.

Stable Diffusions nevrale nettverk har ved hjelp av intensiv læring mestret å assosiere ord og den generelle statistiske assosiasjonen mellom posisjonene til piksler i bilder.

Vi dekket inn en annen historie hvordan teknologien kan få livsødeleggende konsekvenser ved å gjengi og avbilde bilder av mennesker som ser ut til å være kriminelle eller å være involvert i mindre enn smigrende praksiser som tyveri.

For eksempel kan man gi den åpne kilden Stable Diffusion en forespørsel, for eksempel "Tom Hanks i et klasserom", og det vil gi ham/henne et nytt bilde av Tom Hanks i et klasserom. I Tom Hanks tilfelle er det en tur i parken fordi hundrevis av bildene hans allerede er i datasettet som brukes til å trene Stable Diffusion.

Artister får også rått

På kunstfronten er noen kunstnere misfornøyde.

De er bekymret for at AI kan true deres levebrød. Dette er fordi artister, inkludert digitale, heller ikke kan produsere like raskt som AI for et digitalt portrett.

Jeg beskjærer disse av personvernhensyn/fordi jeg ikke prøver å kalle ut noen enkeltperson. Disse er alle Lensa-portretter der de manglede restene av en kunstners signatur fortsatt er synlige. Det er restene av signaturen til en av de mange artistene den stjal fra.

En 🧵 https://t.co/0lS4WHmQfW pic.twitter.com/7GfDXZ22s1

— Lauryn Ipsum (@LaurynIpsum) Desember 6, 2022

Lensas morselskap, Prisma, har forsøkt å massere bekymringene om teknologien sin og eliminere arbeid for digitale artister.

"Selv om både mennesker og AI lærer om kunstneriske stiler på semi-lignende måter, er det noen grunnleggende forskjeller: AI er i stand til raskt å analysere og lære fra store sett med data, men den har ikke samme nivå av oppmerksomhet og verdsettelse for kunst som menneske» skrev selskapet på Twitter 6. desember.

Det står at "utgangene ikke kan beskrives som eksakte kopier av noe bestemt kunstverk."

Er dette AI-generert kunst eller AI-kopiert kunst? Stjeler Lensa AI fra menneskelig kunst? En ekspert forklarer kontroversen https://t.co/cxi2t6URC7 pic.twitter.com/20xJgbHZgA

— John Chapman (@JChapman1729) Desember 15, 2022

Endre selvbilde

Kerry Bowman, en bioetiker ved University of Toronto, sier at AI har potensial til å påvirke ens selvbilde negativt, blant andre etiske spørsmål.

"På noen måter kan det være veldig gøy, men disse idealiserte bildene er drevet av sosiale forventninger som kan være veldig grusomme og veldig smale," sa Bowman mandag.

Bowman sa at disse AI-programmene bruker datasettkilder som internett på jakt etter forskjellige kunststiler for å lage disse portrettene. Ulempen er at når AI gjør det, blir kunstnere sjelden honorert økonomisk for bruk av arbeidet deres eller kreditert.

«Det som skjer med nye AI er at lovene ikke har vært i stand til å holde tritt med dette når det gjelder opphavsrettsloven. Det er veldig vanskelig og veldig grumsete og etikk er enda lenger bak lovene fordi jeg vil hevde at dette er grunnleggende urettferdig, sa Bowman.

Bekymringer om personopplysninger

Bowman reiste også bekymringer for hvordan folks personopplysninger lagres.

«Vil du virkelig ha ansiktet ditt i en stor database? Folk må bestemme selv om dette, men det er ikke godartet, det er ikke noe med dette, det er ikke bare moro, sa han.

Lensa sier at bilder oppbevares på servere og i apper i ikke mer enn 24 timer. Med dyp læring og maskinlæringsalgoritmer samler AI og leverer bedre resultater i fremtiden, også basert på de slettede dataene. Dette, sier Bowman, vil føre til sikkerhetsbekymringer for potensiell bruk av ansiktsgjenkjenning ettersom denne typen data kan bli brukt av politiet ulovlig.

- AI

- Albright Stonebridge

- antitrust

- Barack Obama

- Bitcoin

- blockchain

- blockchain-overholdelse

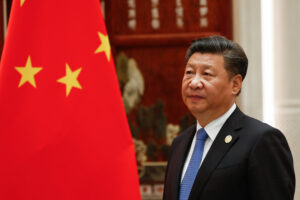

- california

- Kina

- coinbase

- coingenius

- Konsensus

- kryptokonferanse

- krypto gruvedrift

- cryptocurrency

- Cyberspace Administrator of China

- desentralisert

- deepfakes

- Defi

- Digitale eiendeler

- Donald Trump

- ethereum

- maskinlæring

- MetaNews

- ikke soppbart token

- Paul Triolo

- plato

- plato ai

- Platon Data Intelligence

- PlatonData

- platogaming

- polygon

- bevis på innsatsen

- Regulering

- forskrifter

- Teknologi

- W3

- xi jinping

- zephyrnet