DeepMind har gjort det igjen.

Etter å ha løst en grunnleggende utfordring i biologi—forutsi proteinstruktur-og løse ut matematikken i knuteteorien, er det tatt sikte på en grunnleggende databehandlingsprosess innebygd i tusenvis av hverdagsapplikasjoner. Fra å analysere bilder til modelleringsvær eller til og med undersøke den indre funksjonen til kunstige nevrale nettverk, kan AI teoretisk sett fremskynde beregninger på tvers av en rekke felt, øke effektiviteten samtidig som energibruk og kostnader reduseres.

Men mer imponerende er det hvordan de gjorde det. Den rekordstore algoritmen, kalt AlphaTensor, er en spinoff av alphazero, som berømt satte menneskelige spillere i sjakk og Go.

"Algorithmer har blitt brukt i hele verdens sivilisasjoner for å utføre grunnleggende operasjoner i tusenvis av år," skrev medforfattere Drs. Matej Balog og Alhussein Fawzi hos DeepMind. "Men det er svært utfordrende å oppdage algoritmer."

AlphaTensor baner sporet til en ny verden der AI designer programmer som utkonkurrerer alt menneskelig ingeniør, samtidig som den forbedrer sin egen maskins "hjerne".

"Dette arbeidet presser seg inn på ukjent territorium ved å bruke AI for et optimaliseringsproblem som folk har jobbet med i flere tiår ... løsningene det finner kan umiddelbart utvikles for å forbedre beregningsmessige kjøretider," sa Dr. Federico Levi, seniorredaktør ved Natur, Som publisert studien.

Skriv inn matrisemultiplikasjonen

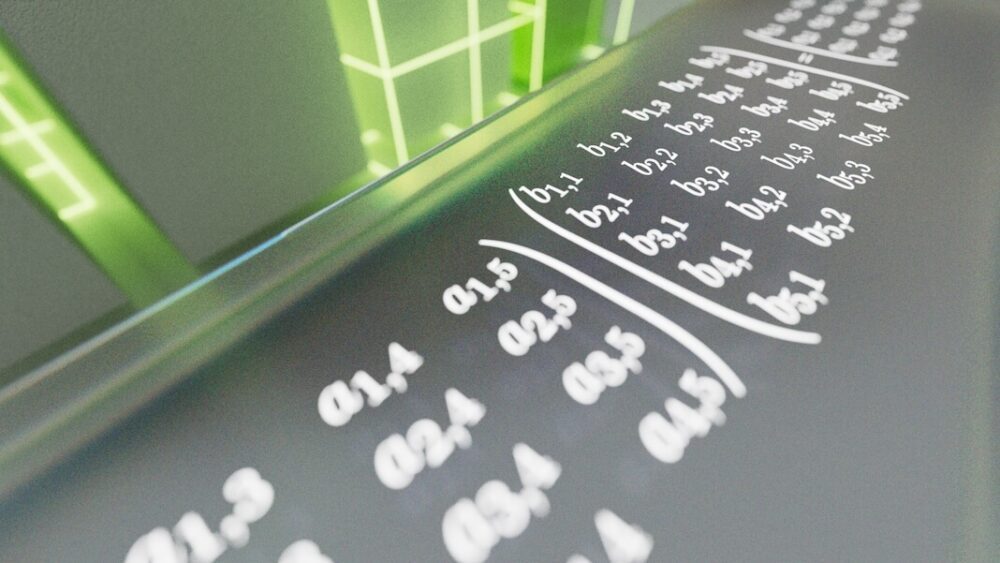

Problemet AlphaTensor står overfor er matrisemultiplikasjon. Hvis du plutselig ser for deg rader og kolonner med grønne tall som ruller nedover skjermen din, er du ikke alene. Grovt sett er en matrise litt sånn - et rutenett med tall som digitalt representerer data du velger. Det kan være piksler i et bilde, frekvensene til et lydklipp eller utseendet og handlingene til karakterer i videospill.

Matrisemultiplikasjon tar to rutenett med tall og multipliserer den ene med den andre. Det er en beregning som ofte undervises på videregående skole, men den er også kritisk for datasystemer. Her multipliseres tallrekker i en matrise med kolonner i en annen. Resultatene genererer et resultat – for eksempel en kommando for å zoome inn eller vippe visningen av en videospillscene. Selv om disse beregningene fungerer under panseret, er alle som bruker en telefon eller datamaskin avhengig av resultatene hver eneste dag.

Du kan se hvordan problemet kan bli ekstremt vanskelig, ekstremt raskt. Å multiplisere store matriser er utrolig energi- og tidskrevende. Hvert tallpar må multipliseres individuelt for å konstruere en ny matrise. Etter hvert som matrisene vokser, blir problemet raskt uholdbart – enda mer enn å forutsi de beste sjakk- eller Go-trekkene. Noen eksperter anslår at det er det flere måter å løse matrisemultiplikasjon enn antall atomer i universet.

Tilbake i 1969 viste Volker Strassen, en tysk matematiker, at det er måter å kutte hjørner på, ved å kutte en runde med to-og-to-matrisemultiplikasjon fra totalt åtte til sju. Det høres kanskje ikke imponerende ut, men Strassens metode viste at det er mulig å slå langvarige standarder for operasjoner – det vil si algoritmer – for matrisemultiplikasjon. Hans tilnærming, Strassen-algoritmen, har regjert som den mest effektive tilnærmingen i over 50 år.

Men hva om det finnes enda mer effektive metoder? "Ingen kjenner den beste algoritmen for å løse det," Dr. François Le Gall ved Nagoya University i Japan, som ikke var involvert i arbeidet, fortalte MIT Technology Review. "Det er et av de største åpne problemene innen informatikk."

AI Chasing Algoritmer

Hvis menneskelig intuisjon vakler, hvorfor ikke benytte seg av et mekanisk sinn?

I den nye studien gjorde DeepMind-teamet matrisemultiplikasjon til et spill. I likhet med forgjengeren AlphaZero, bruker AlphaTensor dyp forsterkningslæring, en maskinlæringsmetode inspirert av måten biologiske hjerner lærer på. Her samhandler en AI-agent (ofte et kunstig nevralt nettverk) med omgivelsene for å løse et flertrinnsproblem. Hvis det lykkes, får det en "belønning" – det vil si at AIs nettverksparametere oppdateres slik at det er mer sannsynlig at det lykkes igjen i fremtiden.

Det er som å lære å snu en pannekake. Mye vil først falle på gulvet, men til slutt vil nevrale nettverk lære seg arm- og håndbevegelsene for en perfekt flip.

Treningsplassen for AlphaTensor er et slags 3D-brettspill. Det er egentlig et enspiller-puslespill som omtrent ligner Sudoku. AI-en må multiplisere rutenett med tall i færrest mulig trinn, mens den velger fra et utall tillatte trekk – over en billion av dem.

Disse tillatte bevegelsene ble omhyggelig designet i AlphaTensor. På en pressebriefing forklarte medforfatter Dr. Hussain Fawzi: "Å formulere rommet for algoritmisk oppdagelse er veldig komplisert ... enda vanskeligere er det, hvordan kan vi navigere i dette rommet."

Med andre ord, når vi står overfor en forbløffende rekke alternativer, hvordan kan vi begrense dem for å forbedre sjansene våre for å finne nålen i høystakken? Og hvordan kan vi best legge strategier for å komme til nålen uten å grave gjennom hele høystakken?

Et triks teamet inkorporerte i AlphaTensor er en metode som kalles tresøk. I stedet for, metaforisk sett, tilfeldig å grave gjennom høystakken, sonderer AI her "veier" som kan føre til et bedre resultat. Den mellomliggende læringen hjelper deretter AI med å planlegge sitt neste trekk for å øke sjansene for suksess. Teamet viste også algoritmeeksempler av vellykkede spill, som å lære et barn åpningstrekkene til sjakk. Til slutt, når AI oppdaget verdifulle trekk, lot teamet det omorganisere disse operasjonene for mer skreddersydd læring på jakt etter et bedre resultat.

Nye baner

AlphaTensor spilte bra. I en serie tester utfordret teamet AI til å finne de mest effektive løsningene for matriser opp til fem ganger fem – det vil si med fem tall hver i en rad eller kolonne.

Algoritmen gjenoppdaget raskt Strassens originale hack, men overgikk deretter alle løsninger som tidligere ble utviklet av menneskesinnet. Ved å teste AI med forskjellige størrelser av matriser, fant AlphaTensor mer effektive løsninger for over 70. "Faktisk oppdager AlphaTensor vanligvis tusenvis av algoritmer for hver størrelse på matrisen," sa teamet. "Det er sjokkerende."

I ett tilfelle, multipliserte en fem ganger fem matrise med en fire ganger fem, kuttet AI den forrige rekorden med 80 individuelle multiplikasjoner til bare 76. Den skinnet også på større matriser, og reduserte antallet beregninger som trengs for to elleve-av-elleve matriser fra 919 til 896.

Proof-of-concept i hånden, teamet vendte seg til praktisk bruk. Databrikker er ofte designet for å optimere forskjellige beregninger - GPUer for grafikk, for eksempel, eller AI-brikker for maskinlæring– og å matche en algoritme med den best egnede maskinvaren øker effektiviteten.

Her brukte teamet AlphaTensor for å finne algoritmer for to populære brikker innen maskinlæring: NVIDIA V100 GPU og Google TPU. Til sammen økte de AI-utviklede algoritmene beregningshastigheten med opptil 20 prosent.

Det er vanskelig å si om AI også kan øke hastigheten på smarttelefoner, bærbare datamaskiner eller andre hverdagslige enheter. "Denne utviklingen ville imidlertid vært veldig spennende hvis den kan brukes i praksis," sa MITs Dr. Virginia Williams. "Et løft i ytelse vil forbedre mange applikasjoner."

Sinnet til en AI

Til tross for at AlphaTensor brøytet den siste menneskelige rekorden for matrisemultiplikasjon, kan DeepMind-teamet ennå ikke forklare hvorfor.

"Det har fått denne fantastiske intuisjonen ved å spille disse spillene," sa DeepMind-forsker og medforfatter Dr. Pushmeet Kohli på en pressekonferanse.

Utviklende algoritmer trenger heller ikke å være menneske mot maskiner.

Mens AlphaTensor er et springbrett mot raskere algoritmer, kan det finnes enda raskere. "Fordi den trenger å begrense søket til algoritmer av en bestemt form, kan den gå glipp av andre typer algoritmer som kan være mer effektive," skrev Balog og Fawzi.

Kanskje en enda mer spennende vei ville kombinere menneskelig og maskinell intuisjon. "Det ville vært fint å finne ut om denne nye metoden faktisk subsumerer alle de tidligere, eller om du kan kombinere dem og få noe enda bedre," sa Williams. Andre eksperter er enige. Med et vell av algoritmer til rådighet, kan forskere begynne å dissekere dem for å finne ledetråder til hva som fikk AlphaTensors løsninger til å tikke, og baner vei for det neste gjennombruddet.

Bildekreditt: DeepMind