Maskinlæring (ML) forstyrrer mange bransjer i et enestående tempo. Helse- og biovitenskapsindustrien (HCLS) har gjennomgått en rask utvikling de siste årene og omfatter ML på tvers av en rekke bruksområder for å levere kvalitetspleie og forbedre pasientresultatene.

I en typisk ML-livssyklus bruker dataingeniører og forskere mesteparten av tiden sin på dataforberedelse og funksjonstrinn før de i det hele tatt kommer i gang med prosessen med modellbygging og opplæring. Å ha et verktøy som kan senke adgangsbarrieren for dataforberedelse, og dermed forbedre produktiviteten, er en svært ønskelig forespørsel for disse personasene. Amazon SageMaker Data Wrangler er spesialbygget av AWS for å redusere læringskurven og gjøre det mulig for datautøvere å utføre dataforberedelse, rengjøring og funksjonsingeniøroppgaver med mindre innsats og tid. Den tilbyr et GUI-grensesnitt med mange innebygde funksjoner og integrasjoner med andre AWS-tjenester som f.eks Amazon enkel lagringstjeneste (Amazon S3) og Amazon SageMaker Feature Store, samt partnerdatakilder inkludert Snowflake og Databricks.

I dette innlegget viser vi hvordan du bruker Data Wrangler til å forberede helsetjenester for å trene en modell for å forutsi hjertesvikt, gitt en pasients demografi, tidligere medisinske tilstander og laboratorietestresultathistorie.

Løsningsoversikt

Løsningen består av følgende trinn:

- Skaff deg et helsedatasett som input til Data Wrangler.

- Bruk Data Wranglers innebygde transformasjonsfunksjoner for å transformere datasettet. Dette inkluderer slippkolonner, fremheve data/tid, slå sammen datasett, imputere manglende verdier, kode kategoriske variabler, skalere numeriske verdier, balansere datasettet og mer.

- Bruk Data Wranglers tilpassede transformasjonsfunksjon (Pandas eller PySpark-kode) for å supplere ytterligere transformasjoner som kreves utover de innebygde transformasjonene og demonstrere utvidelsesmuligheten til Data Wrangler. Dette inkluderer filterrader, gruppedata, form nye datarammer basert på betingelser og mer.

- Bruk Data Wranglers innebygde visualiseringsfunksjoner for å utføre visuell analyse. Dette inkluderer mållekkasje, funksjonskorrelasjon, hurtigmodell og mer.

- Bruk Data Wranglers innebygde eksportalternativer for å eksportere det transformerte datasettet til Amazon S3.

- Start en Jupyter-notisbok for å bruke det transformerte datasettet i Amazon S3 som input for å trene en modell.

Generer et datasett

Nå som vi har bestemt oss for ML-problemformuleringen, retter vi først blikket mot å innhente dataene vi trenger. Forskningsstudier som f.eks Forutsigelse av hjertesvikt kan gi data som allerede er i god form. Imidlertid møter vi ofte scenarier der dataene er ganske rotete og krever sammenføyning, rensing og flere andre transformasjoner som er veldig spesifikke for helsedomenet før de kan brukes til ML-trening. Vi ønsker å finne eller generere data som er rotete nok og lede deg gjennom trinnene for å forberede dem ved hjelp av Data Wrangler. Med det i tankene valgte vi Synthea som et verktøy for å generere syntetiske data som passer målet vårt. Synthea er en åpen kildekode syntetisk pasientgenerator som modellerer sykehistorien til syntetiske pasienter. For å generere datasettet ditt, fullfør følgende trinn:

- Følg instruksjonene i henhold til kjapp start dokumentasjon for å lage en Amazon SageMaker Studio domene og start Studio.

Dette er et forutsetningssteg. Det er valgfritt hvis Studio allerede er satt opp på kontoen din. - Etter at Studio er lansert, på Launcher kategorien, velg Systemterminal.

Dette starter en terminaløkt som gir deg et kommandolinjegrensesnitt å jobbe med. - For å installere Synthea og generere datasettet i CSV-format, kjør følgende kommandoer i den lanserte terminaløkten:

Vi leverer en parameter for å generere datasettene med en populasjonsstørrelse på 10,000 XNUMX. Merk at størrelsesparameteren angir antall levende medlemmer av befolkningen. I tillegg genererer Synthea også data for døde medlemmer av befolkningen som kan legge til noen ekstra datapunkter på toppen av den angitte prøvestørrelsen.

Vent til datagenereringen er fullført. Dette trinnet tar vanligvis rundt en time eller mindre. Synthea genererer flere datasett, inkludert patients, medications, allergies, conditions, og mer. For dette innlegget bruker vi tre av de resulterende datasettene:

- pasienter.csv – Dette datasettet er på omtrent 3.2 MB og inneholder omtrent 11,000 25 rader med pasientdata (XNUMX kolonner inkludert pasient-ID, fødselsdato, kjønn, adresse og mer)

- conditions.csv – Dette datasettet er på omtrent 47 MB og inneholder omtrent 370,000 XNUMX rader med medisinsk tilstandsdata (seks kolonner inkludert pasient-ID, tilstandens startdato, tilstandskode og mer)

- observasjoner.csv – Dette datasettet er på omtrent 830 MB og inneholder omtrent 5 millioner rader med observasjonsdata (åtte kolonner inkludert pasient-ID, observasjonsdato, observasjonskode, verdi og mer)

Det er et en-til-mange forhold mellom patients og conditions datasett. Det er også et en-til-mange forhold mellom patients og observations datasett. For en detaljert dataordbok, se CSV-fildataordbok.

- For å laste opp de genererte datasettene til en kildebøtte i Amazon S3, kjør følgende kommandoer i terminaløkten:

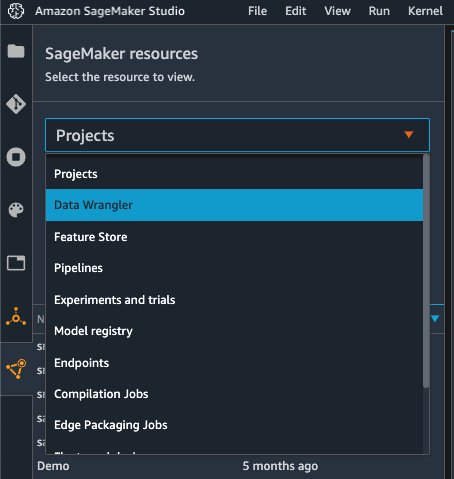

Start Data Wrangler

Velg SageMaker-ressurser på navigasjonssiden i Studio og på Prosjekter meny, velg Data Wrangler for å lage en Data Wrangler-dataflyt. For detaljerte trinn for hvordan du starter Data Wrangler fra Studio, se Kom i gang med Data Wrangler.

Import datoer

For å importere dataene dine, fullfør følgende trinn:

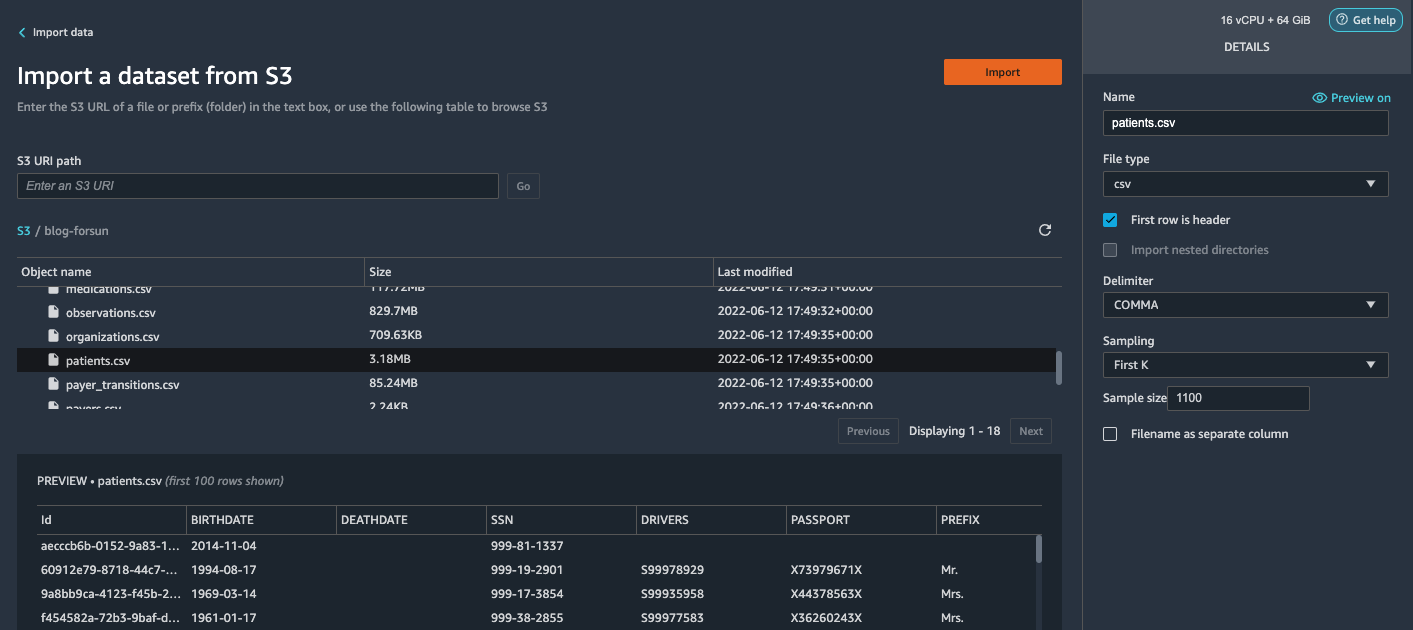

- Velg Amazon S3 og finn patient.csv-filen i S3-bøtten.

- på Detaljer ruten, velg Først K forum sampling.

- Enter

1100forum Prøvestørrelse.

I forhåndsvisningsruten henter Data Wrangler de første 100 radene fra datasettet og viser dem som en forhåndsvisning. - Velg Import.

Data Wrangler velger de første 1,100 pasientene fra de totale pasientene (11,000 XNUMX rader) generert av Synthea og importerer dataene. Sampling-tilnærmingen lar Data Wrangler bare behandle prøvedataene. Det gjør oss i stand til å utvikle dataflyten vår med et mindre datasett, noe som resulterer i raskere behandling og en kortere tilbakemeldingssløyfe. Etter at vi har opprettet dataflyten, kan vi sende den utviklede oppskriften til en SageMaker-behandling jobb med å horisontalt skalere ut behandlingen for hele eller større datasett på en distribuert måte.

- Gjenta denne prosessen for

conditionsogobservationsdatasett.- For det

conditionsdatasett, skriv inn37000forum Prøvestørrelse, som er 1/10 av de totalt 370,000 XNUMX radene som genereres av Synthea. - For det

observationsdatasett, skriv inn500000forum Prøvestørrelse, som er 1/10 av de totale observasjonene 5 millioner rader generert av Synthea.

- For det

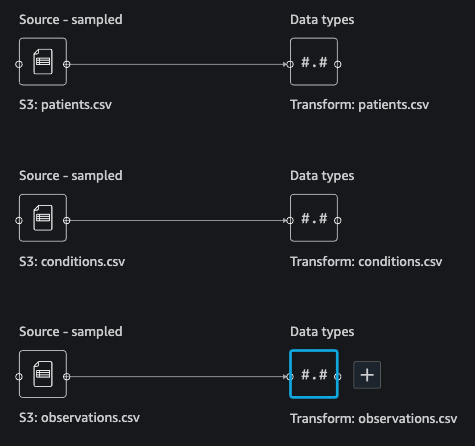

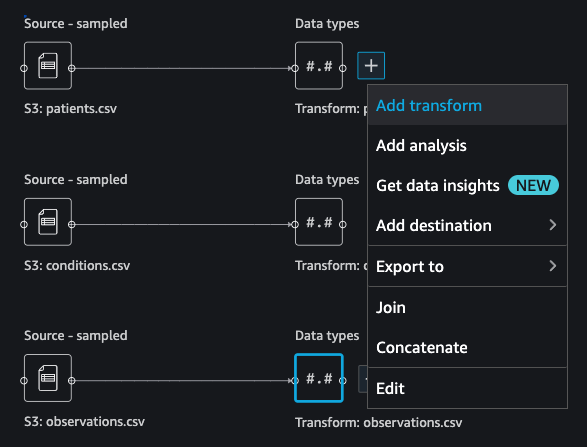

Du bør se tre datasett som vist i følgende skjermbilde.

Transformere dataene

Datatransformasjon er prosessen med å endre strukturen, verdien eller formatet til én eller flere kolonner i datasettet. Prosessen er vanligvis utviklet av en dataingeniør og kan være utfordrende for personer med et mindre dataingeniørkompetansesett å dechiffrere logikken som foreslås for transformasjonen. Datatransformasjon er en del av den bredere funksjonsutviklingsprosessen, og riktig sekvens av trinn er et annet viktig kriterium å huske på når du utarbeider slike oppskrifter.

Data Wrangler er designet for å være et lavkodeverktøy for å redusere adgangsbarrieren for effektiv dataforberedelse. Den kommer med over 300 forhåndskonfigurerte datatransformasjoner som du kan velge mellom uten å skrive en eneste linje med kode. I de følgende delene ser vi hvordan du transformerer de importerte datasettene i Data Wrangler.

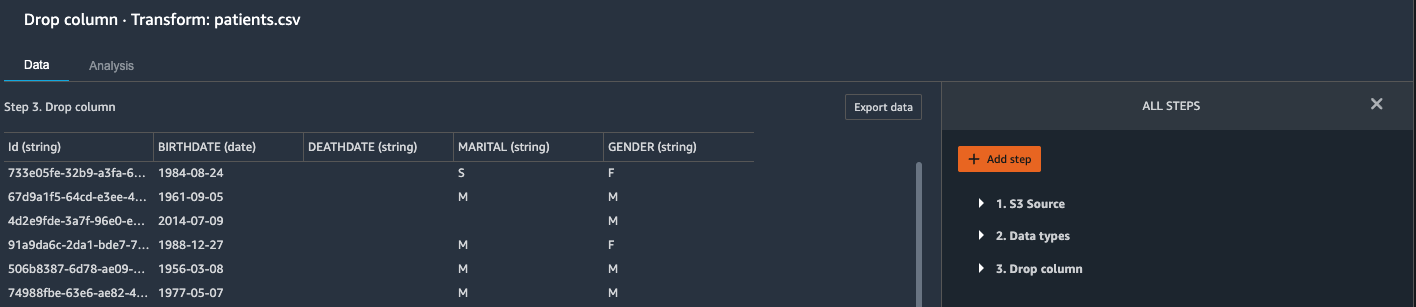

Slipp kolonner i pasienter.csv

Vi slipper først noen kolonner fra patients datasett. Å slippe redundante kolonner fjerner ikke-relevant informasjon fra datasettet og hjelper oss med å redusere mengden dataressurser som kreves for å behandle datasettet og trene en modell. I denne delen slipper vi kolonner som SSN eller passnummer basert på sunn fornuft om at disse kolonnene ikke har noen prediktiv verdi. Med andre ord hjelper de ikke vår modell med å forutsi hjertesvikt. Vår studie er heller ikke bekymret for andre spalter som fødested eller helseutgifters innflytelse på en pasients hjertesvikt, så vi dropper dem også. Redundante kolonner kan også identifiseres ved å kjøre de innebygde analysene som mållekkasje, funksjonskorrelasjon, multikollinearitet og mer, som er innebygd i Data Wrangler. For mer informasjon om de støttede analysetypene, se Analyser og visualiser. I tillegg kan du bruke Rapport om datakvalitet og innsikt å utføre automatiserte analyser på datasettene for å komme frem til en liste over overflødige kolonner å eliminere.

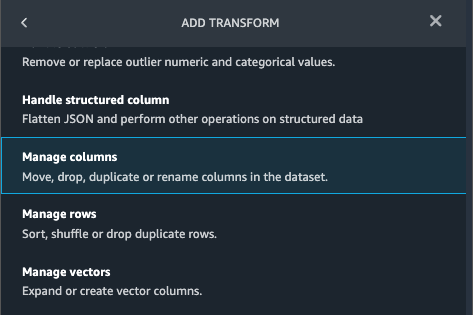

- Velg plusstegnet ved siden av Datatyper for patients.csv-datasettet og velg Legg til transform.

- Velg Legg til trinn Og velg Administrer kolonner.

- Til Transform¸ velg Slipp kolonne.

- Til Kolonner å slippe, velg følgende kolonner:

SSNDRIVERSPASSPORTPREFIXFIRSTLASTSUFFIXMAIDENRACEETHNICITYBIRTHPLACEADDRESSCITYSTATECOUNTYZIPLATLONHEALTHCARE_EXPENSESHEALTHCARE_COVERAGE

- Velg Forhåndsvisning for å se gjennom det transformerte datasettet, og velg deretter Legg til.

Du bør se trinnet Slipp kolonne i listen over transformasjoner.

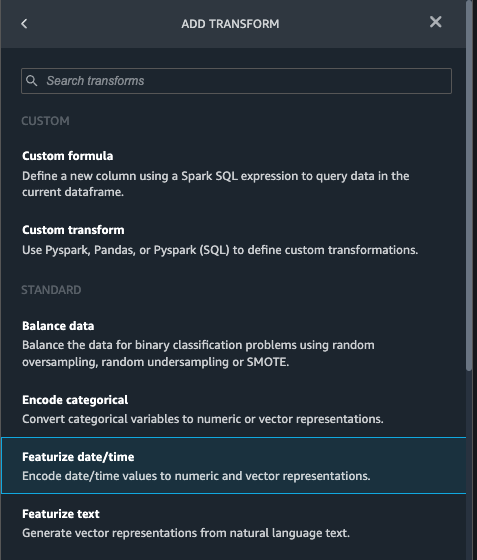

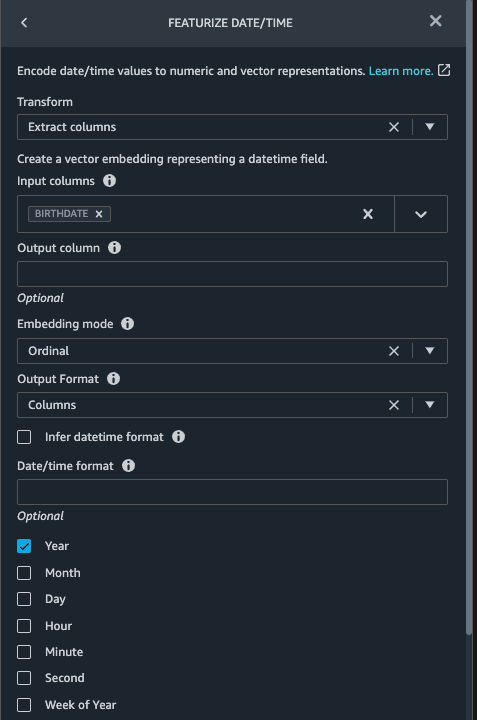

Vis dato/klokkeslett i pasienter.csv

Nå bruker vi funksjonen Featurize dato/klokkeslett for å generere den nye funksjonen Year fra BIRTHDATE kolonne i patients datasett. Vi bruker den nye funksjonen i et påfølgende trinn for å beregne en pasients alder på tidspunktet for observasjon finner sted.

- på Transforms ruten din Slipp kolonne side for

patientsdatasett, velg Legg til trinn. - Velg Vis dato/klokkeslett forvandle.

- Velg Trekk ut kolonner.

- Til Inndatakolonner, legg til kolonnen

BIRTHDATE. - Plukke ut År og fravelg Måned, dag, time, Minutt, Sekund.

- Velg Forhåndsvisning, velg deretter Legg til.

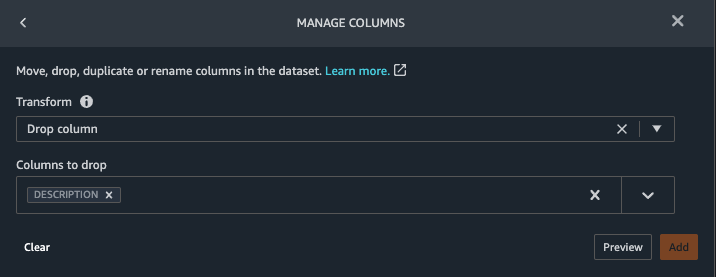

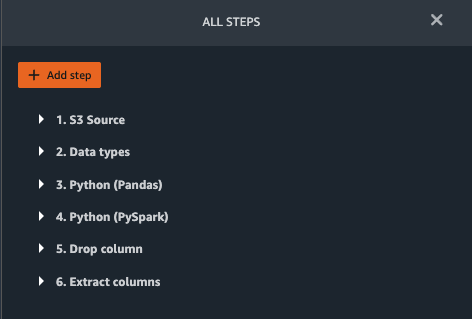

Legg til transformasjoner i observations.csv

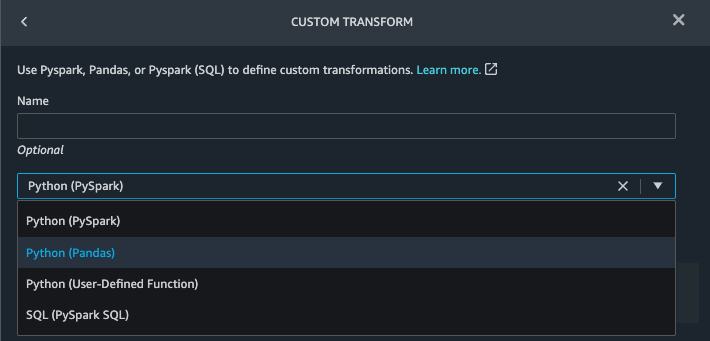

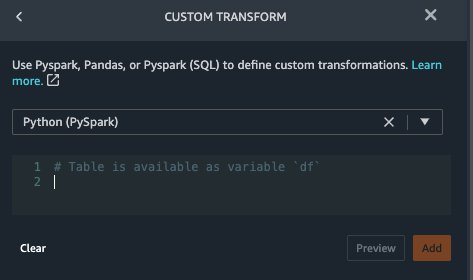

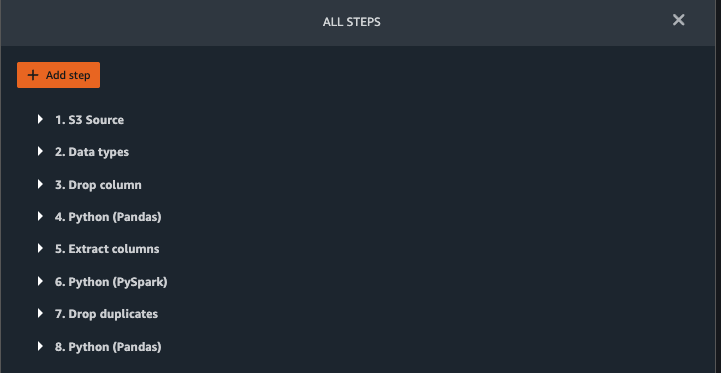

Data Wrangler støtter tilpassede transformasjoner ved hjelp av Python (brukerdefinerte funksjoner), PySpark, Pandas eller PySpark (SQL). Du kan velge transformasjonstype basert på din kjennskap til hvert alternativ og preferanse. For de tre sistnevnte alternativene avslører Data Wrangler variabelen df for at du skal få tilgang til datarammen og bruke transformasjoner på den. For en detaljert forklaring og eksempler, se Egendefinerte transformasjoner. I denne delen legger vi til tre tilpassede transformasjoner til observations datasett.

- Legg til en transformasjon til observations.csv og slipp

DESCRIPTIONkolonne.

- Velg Forhåndsvisning, velg deretter Legg til.

- på Transforms ruten, velg Legg til trinn Og velg Tilpasset transformasjon.

- Velg på rullegardinmenyen Python (Pandaer).

- Skriv inn følgende kode:

Dette er LONIC-koder som tilsvarer følgende observasjoner vi er interessert i å bruke som funksjoner for å forutsi hjertesvikt:

- Velg Forhåndsvisning, velg deretter Legg til.

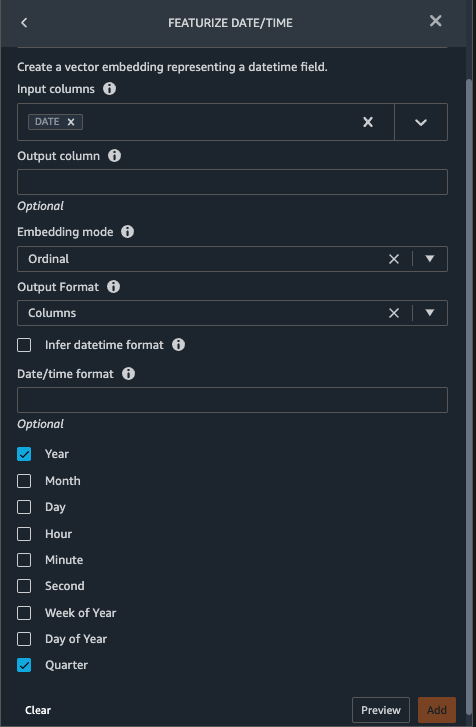

- Legg til en transformasjon for å trekke ut

YearogQuarterfraDATEkolonne.

- Velg Forhåndsvisning, velg deretter Legg til.

- Velg Legg til trinn Og velg Tilpasset transformasjon.

- Velg på rullegardinmenyen Python (PySpark).

De fem typene observasjoner er kanskje ikke alltid registrert på samme dato. For eksempel kan en pasient besøke fastlegen sin 21. januar og få målt og registrert sitt systoliske blodtrykk, diastoliske blodtrykk, hjertefrekvens og kroppsmasseindeks. Imidlertid kan en laboratorietest som inkluderer blodplater gjøres på et senere tidspunkt den 2. februar. Derfor er det ikke alltid mulig å koble til datarammer innen observasjonsdatoen. Her slår vi sammen datarammer på en grov granularitet på kvartalsbasis. - Skriv inn følgende kode:

- Velg Forhåndsvisning, velg deretter Legg til.

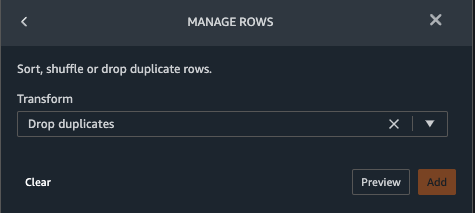

- Velg Legg til trinn, velg deretter Administrer rader.

- Til Transform, velg Slipp duplikater.

- Velg Forhåndsvisning, velg deretter Legg til.

- Velg Legg til trinn Og velg Tilpasset transformasjon.

- Velg på rullegardinmenyen Python (Pandaer).

- Skriv inn følgende kode for å ta et gjennomsnitt av datapunkter som deler samme tidsverdi:

- Velg Forhåndsvisning, velg deretter Legg til.

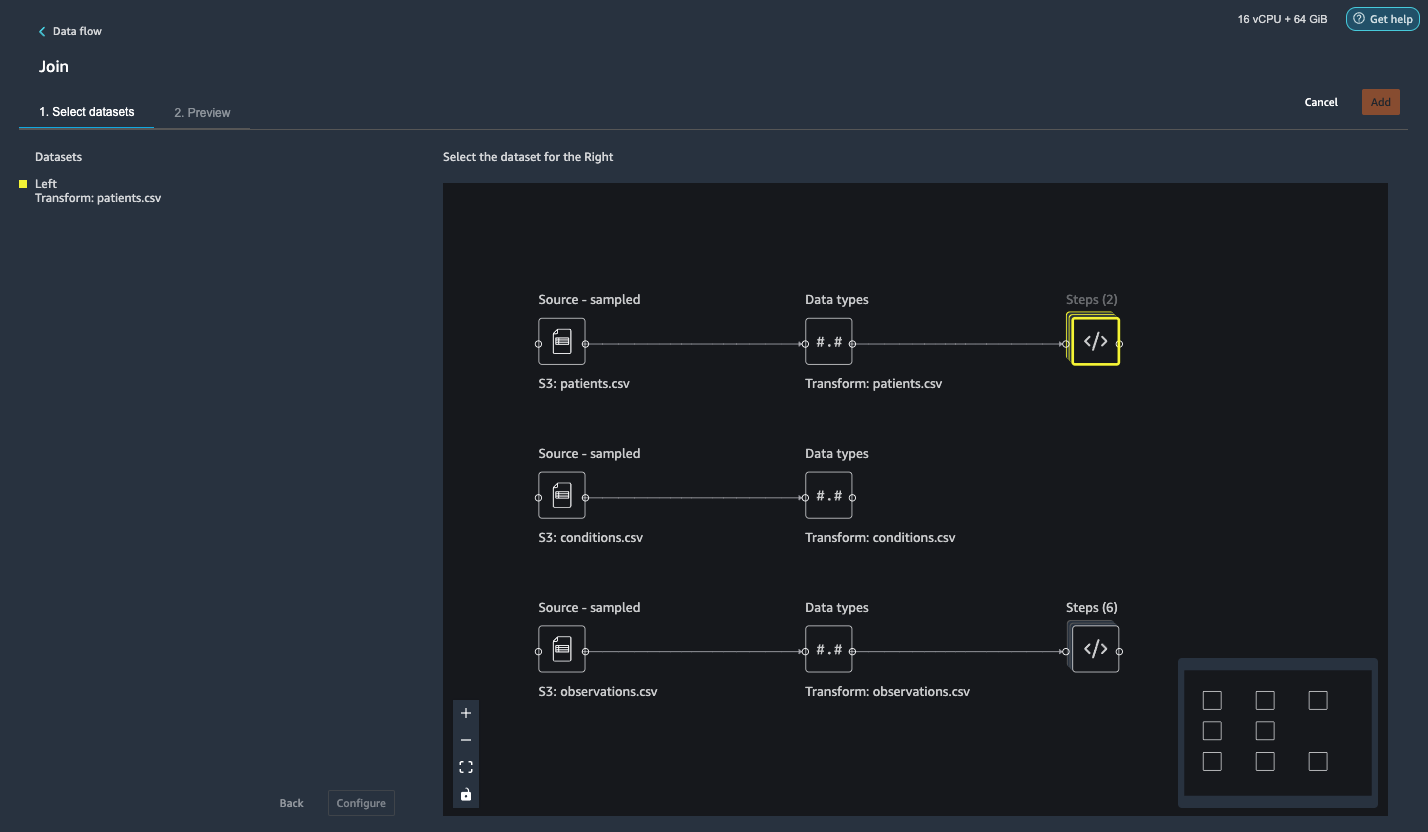

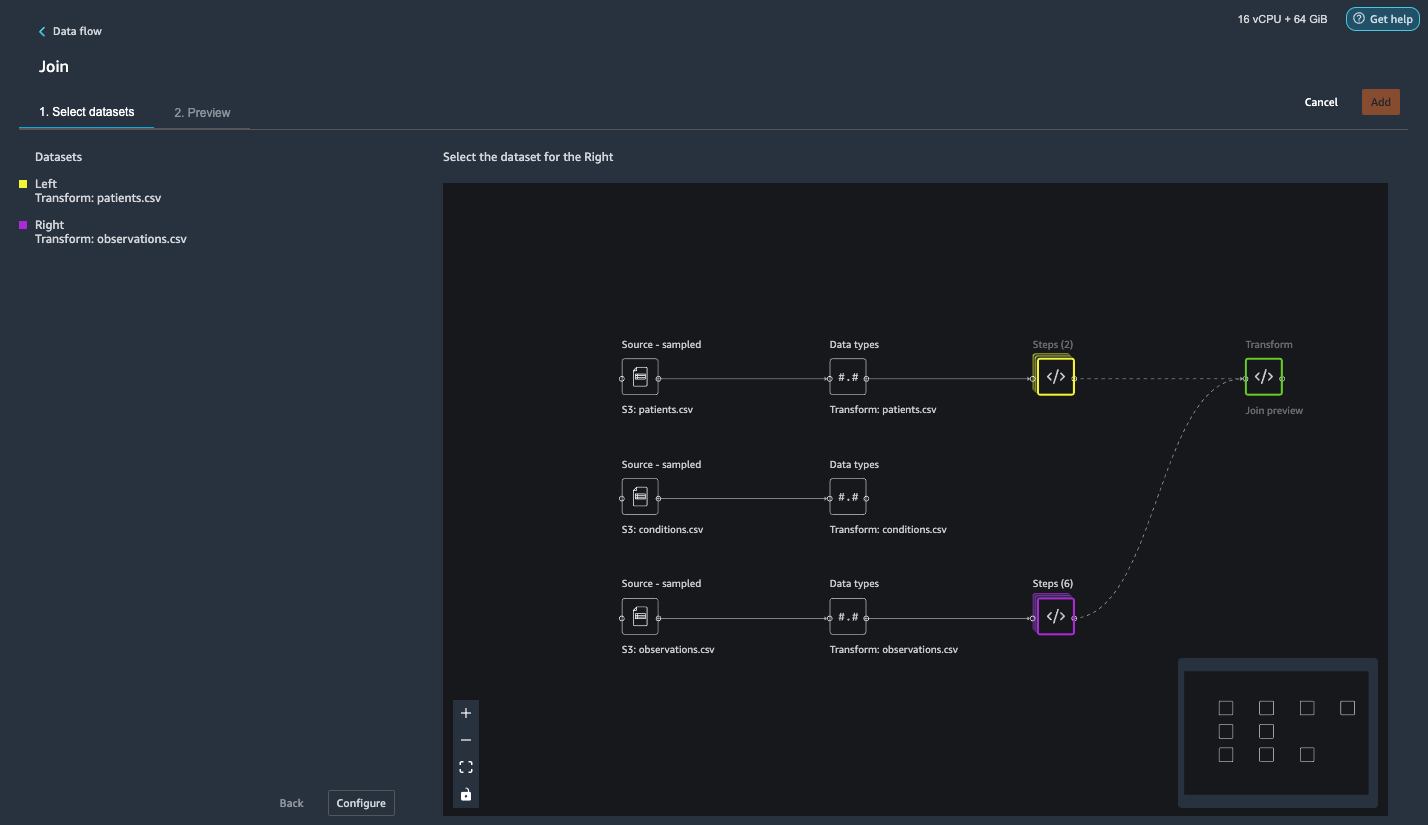

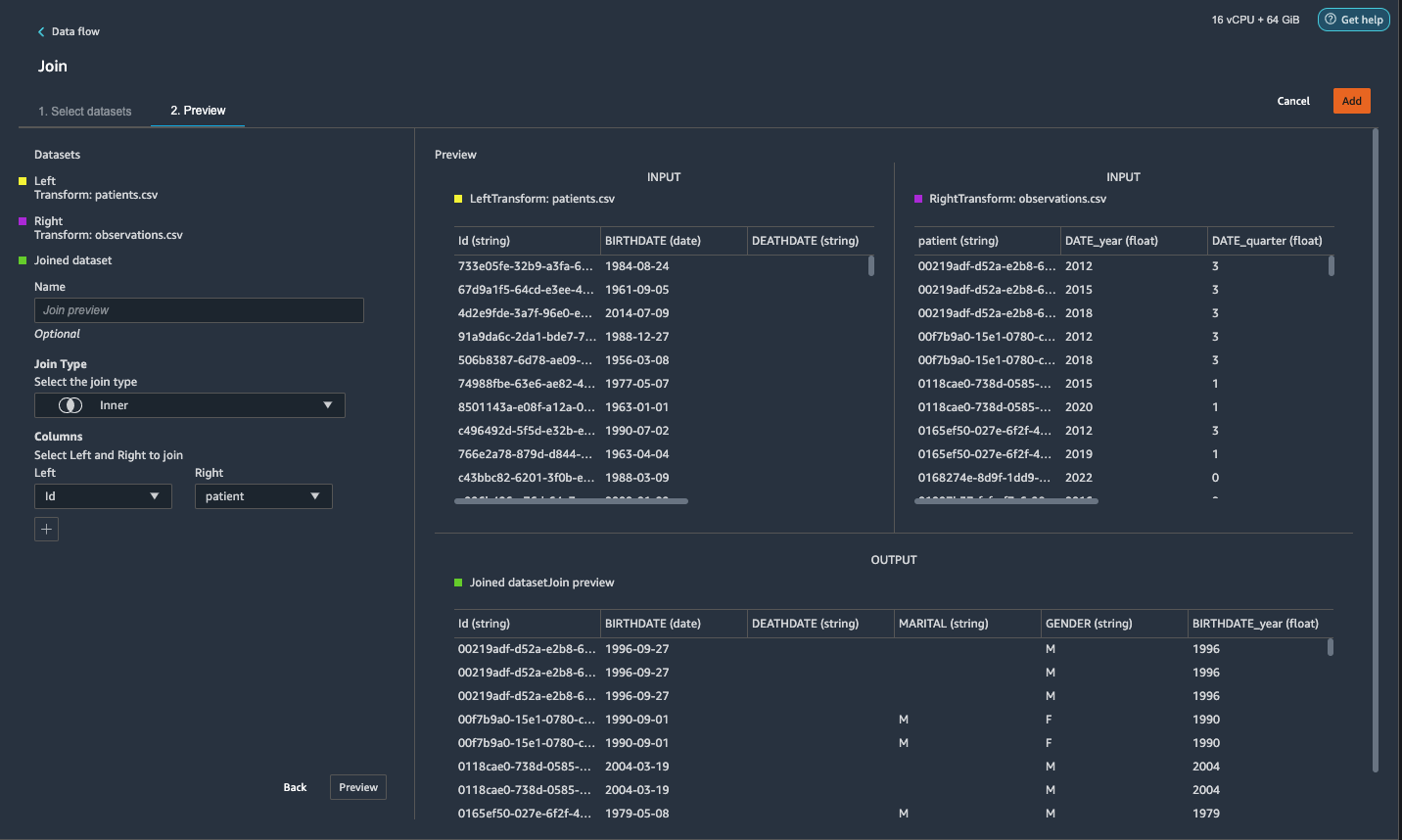

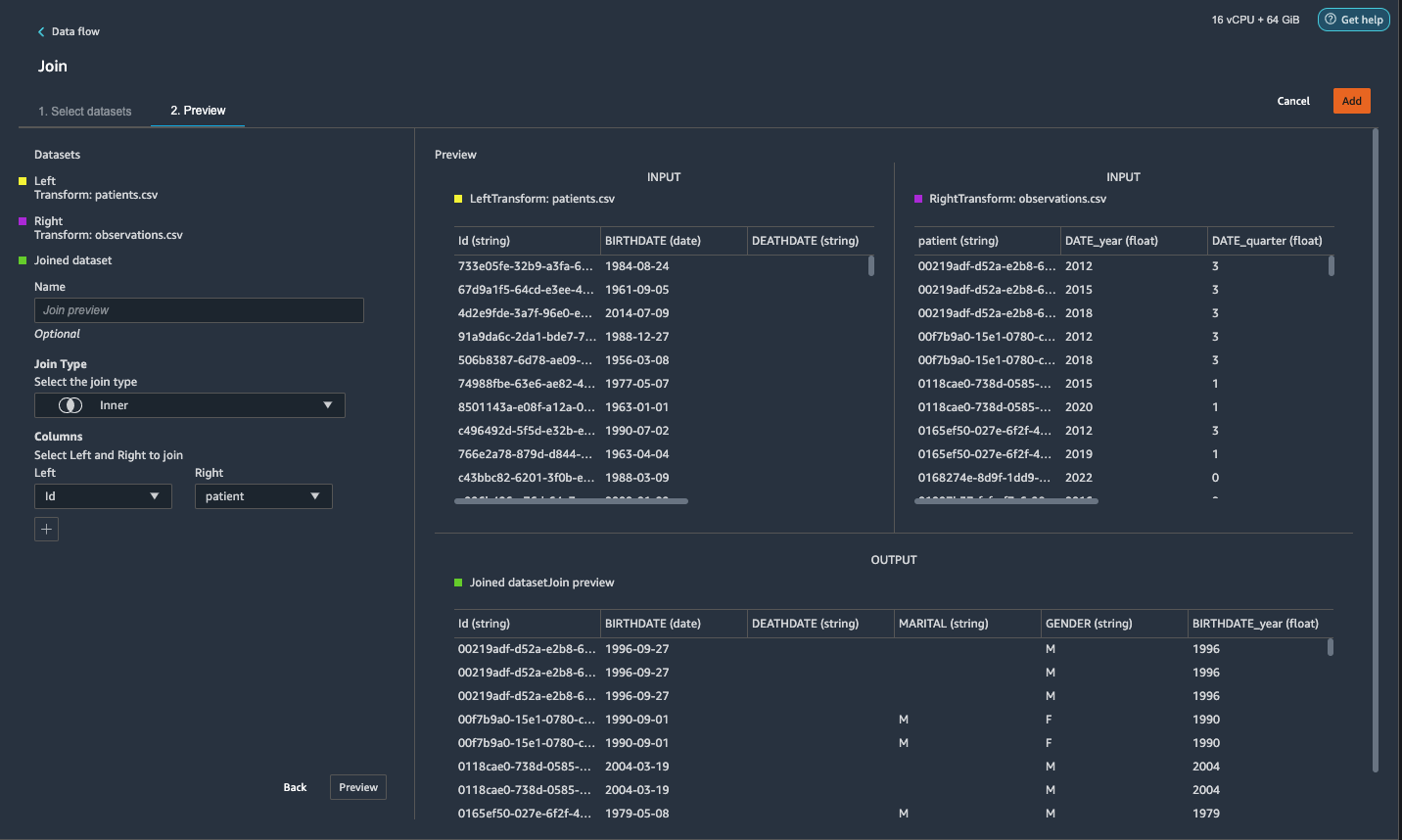

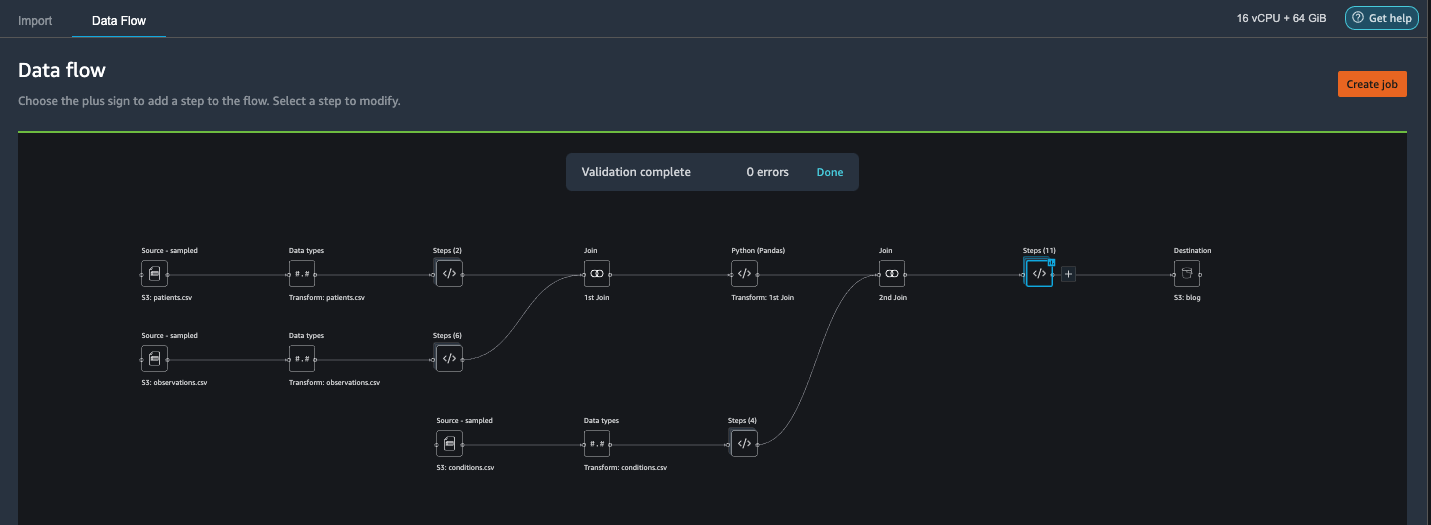

Bli med patients.csv og observations.csv

I dette trinnet viser vi frem hvordan du effektivt og enkelt utfører komplekse sammenføyninger på datasett uten å skrive noen kode via Data Wranglers kraftige brukergrensesnitt. For å lære mer om de støttede typene sammenføyninger, se Transformer data.

- Til høyre for Transform: pasienter.csv, velg plusstegnet ved siden av Steps Og velg Bli med.

Du kan se den transformerte patients.csv-filen oppført under datasett i venstre rute.

- Til høyre for Transform: observations.csv, Klikk på Steps for å starte sammenføyningsoperasjonen.

Den transformerte observations.csv-filen er nå oppført under datasett i venstre rute.

- Velg Konfigurer.

- Til Bli med Type, velg Indre.

- Til Venstre, velg Id.

- Til Ikke sant, velg pasient.

- Velg Forhåndsvisning, velg deretter Legg til.

Legg til en tilpasset transformasjon til de sammenføyde datasettene

I dette trinnet beregner vi en pasients alder på observasjonstidspunktet. Vi dropper også kolonner som ikke lenger er nødvendige.

- Velg plusstegnet ved siden av 1. Bli med Og velg Legg til transform.

- Legg til en tilpasset transformasjon i Pandas:

- Velg Forhåndsvisning, velg deretter Legg til.

Legg til egendefinerte transformasjoner i conditions.csv

- Velg plusstegnet ved siden av Transform: conditions.csv Og velg Legg til transform.

- Legg til en tilpasset transformasjon i Pandas:

OBS: Som vi demonstrerte tidligere, kan du slippe kolonner enten ved å bruke tilpasset kode eller ved å bruke de innebygde transformasjonene fra Data Wrangler. Tilpassede transformasjoner i Data Wrangler gir fleksibiliteten til å ta med din egen transformasjonslogikk i form av kodebiter i de støttede rammeverkene. Disse utdragene kan senere søkes og brukes om nødvendig.

Kodene i den foregående transformasjonen er SNOMED-CT-koder som tilsvarer følgende forhold. De heart failure or chronic congestive heart failure tilstand blir etiketten. Vi bruker de resterende forholdene som funksjoner for å forutsi hjertesvikt. Vi slipper også noen kolonner som ikke lenger er nødvendige.

- La oss deretter legge til en tilpasset transformasjon i PySpark:

Vi utfører en venstre ytre sammenføyning for å beholde alle oppføringer i hjertesviktdatarammen. En ny kolonne

has_xxxberegnes for hver annen tilstand enn hjertesvikt basert på tilstandens startdato. Vi er kun interessert i medisinske tilstander som ble registrert før hjertesvikten og bruker dem som funksjoner for å forutsi hjertesvikt. - Legg til en innebygd Administrer kolonner transformer for å slippe de overflødige kolonnene som ikke lenger er nødvendige:

hypertensiondiabetescoronarysmokeatrial

- Pakk

YearogQuarterfraheartfailurekolonne.

Dette samsvarer med granulariteten vi brukte tidligere i transformasjonen avobservationsdatasett. - Vi bør ha totalt 6 trinn for conditions.csv.

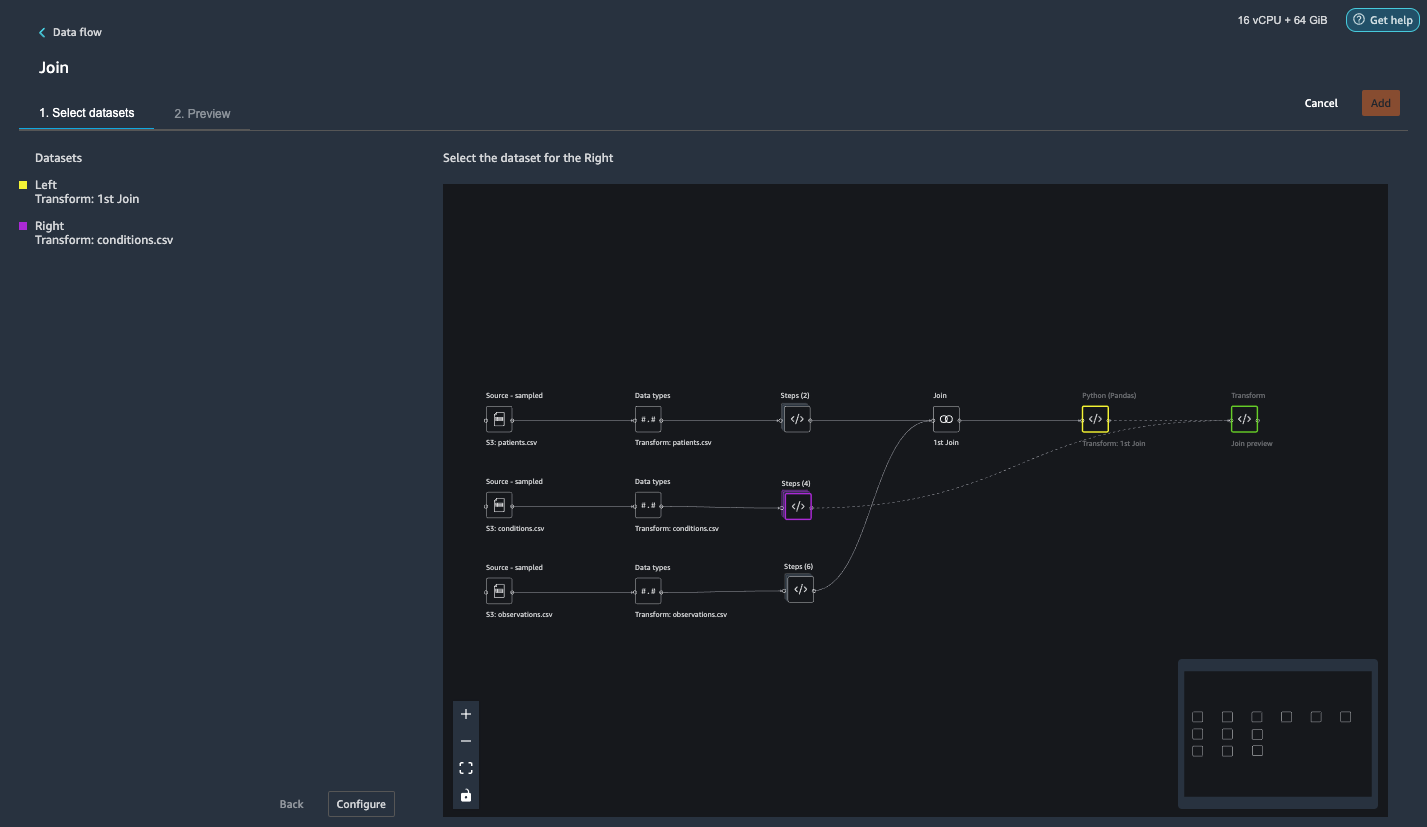

Koble til conditions.csv til det sammenføyde datasettet

Vi utfører nå en ny sammenføyning for å koble vilkårsdatasettet til det sammenføyde patients og observations datasett.

- Velg Transform: 1. Join.

- Velg plusstegnet og velg Bli med.

- Velg Steps ved siden av Transform: conditions.csv.

- Velg Konfigurer.

- Til Bli med Type, velg Venstre ytre.

- Til Venstre, velg Id.

- Til Ikke sant, velg pasient.

- Velg Forhåndsvisning, velg deretter Legg til.

Legg til transformasjoner til de sammenføyde datasettene

Nå som vi har alle tre datasettene sammen, la oss bruke noen ekstra transformasjoner.

- Legg til følgende tilpassede transformasjon i PySpark så

has_heartfailureblir etikettkolonnen vår: - Legg til følgende tilpassede transformasjon i PySpark:

- Slipp de overflødige kolonnene som ikke lenger er nødvendige:

IdDATE_yearDATE_quarterpatientheartfailureheartfailure_yearheartfailure_quarter

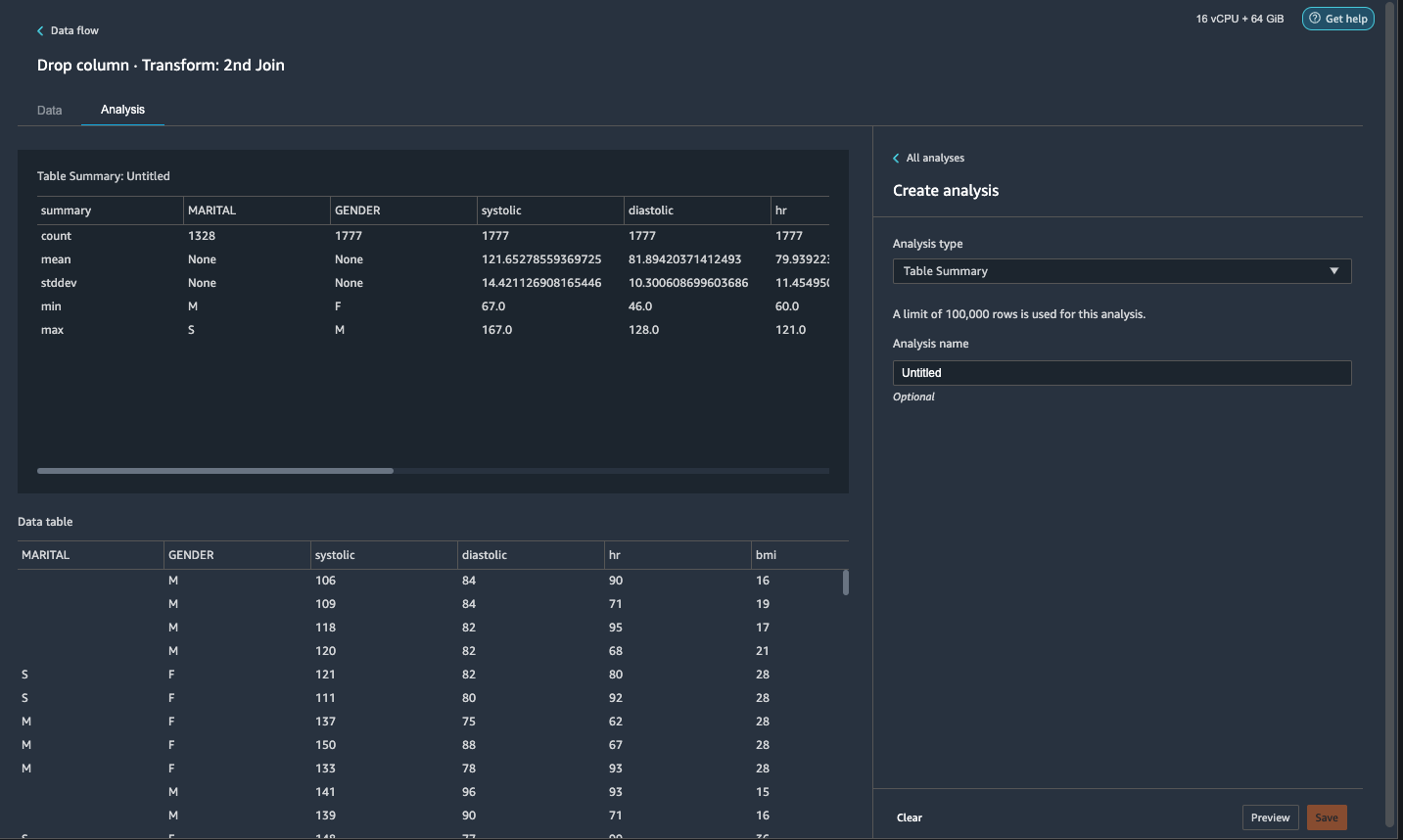

- På Analyse fanen, for Analysetype¸ velg Tabellsammendrag.

En rask skanning gjennom sammendraget viser atMARITALkolonnen mangler data.

- Velg Data fanen og legg til et trinn.

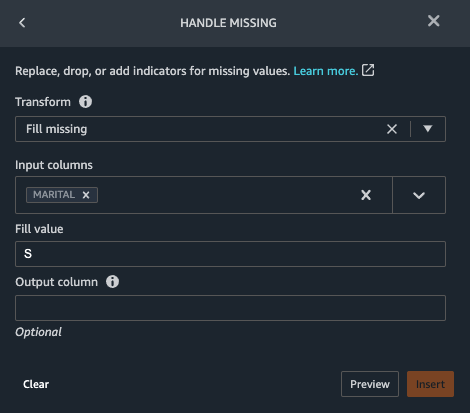

- Velg Håndtak mangler.

- Til Transform, velg Fyll mangler.

- Til Inndatakolonner, velg EKTESKAP.

- Til Fyll verdi, Tast inn

S.

Vår strategi her er å anta at pasienten er singel dersom sivilstatusen har manglende verdi. Du kan ha en annen strategi.

- Velg Forhåndsvisning, velg deretter Legg til.

- Fyll den manglende verdien som 0 for

has_hypertension,has_diabetes,has_coronary,has_smoke,has_atrial.

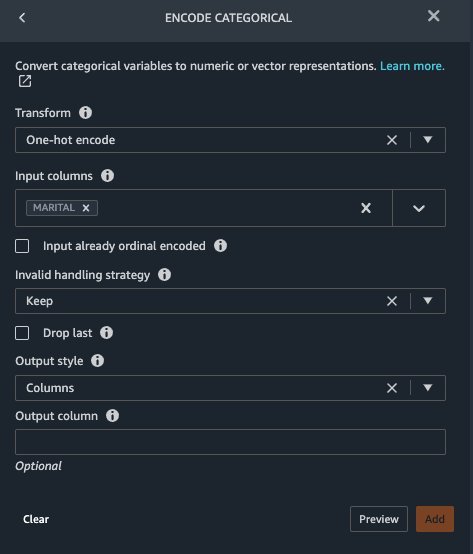

Marital og Gender er kategorivariabler. Data Wrangler har en innebygd funksjon for å kode kategorivariabler.

- Legg til et trinn og velg Kode kategori.

- Til Transform, velg En-varm koding.

- Til Inndatakolonner, velg EKTESKAP.

- Til Utgangsstil, velg Kolonne.

Denne utdatastilen produserer kodede verdier i separate kolonner.

- Velg Forhåndsvisning, velg deretter Legg til.

- Gjenta disse trinnene for Kjønn kolonne.

Den ene-hot-kodingen deler ekteskapsspalten inn i Marital_M (gift) og Marital_S (enkelt), og deler Kjønn-kolonnen inn i Gender_M (hann) og Gender_F (hunn). Fordi Marital_M og Marital_S er gjensidig utelukkende (som er Gender_M og Gender_F), kan vi slippe én kolonne for å unngå overflødige funksjoner.

- Drop

Marital_SogGender_F.

Numeriske funksjoner som systolisk, hjertefrekvens og alder har forskjellige enhetsstandarder. For en lineær regresjonsbasert modell må vi først normalisere disse numeriske funksjonene. Ellers kan noen funksjoner med høyere absolutte verdier ha en uberettiget fordel fremfor andre funksjoner med lavere absolutte verdier og resultere i dårlig modellytelse. Data Wrangler har den innebygde transformatoren Min-max scaler for å normalisere dataene. For en beslutningstrebasert klassifiseringsmodell er det ikke nødvendig med normalisering. Studien vår er et klassifiseringsproblem, så vi trenger ikke å bruke normalisering. Ubalanserte klasser er et vanlig problem i klassifisering. Ubalanse oppstår når opplæringsdatasettet inneholder alvorlig skjev klassefordeling. For eksempel, når datasettet vårt inneholder uforholdsmessig flere pasienter uten hjertesvikt enn pasienter med hjertesvikt, kan det føre til at modellen blir partisk mot å forutsi hjertesvikt og gir dårlige resultater. Data Wrangler har en innebygd funksjon for å takle problemet.

- Legg til en tilpasset transformasjon i Pandas for å konvertere datatype av kolonner fra "objekt"-type til numerisk type:

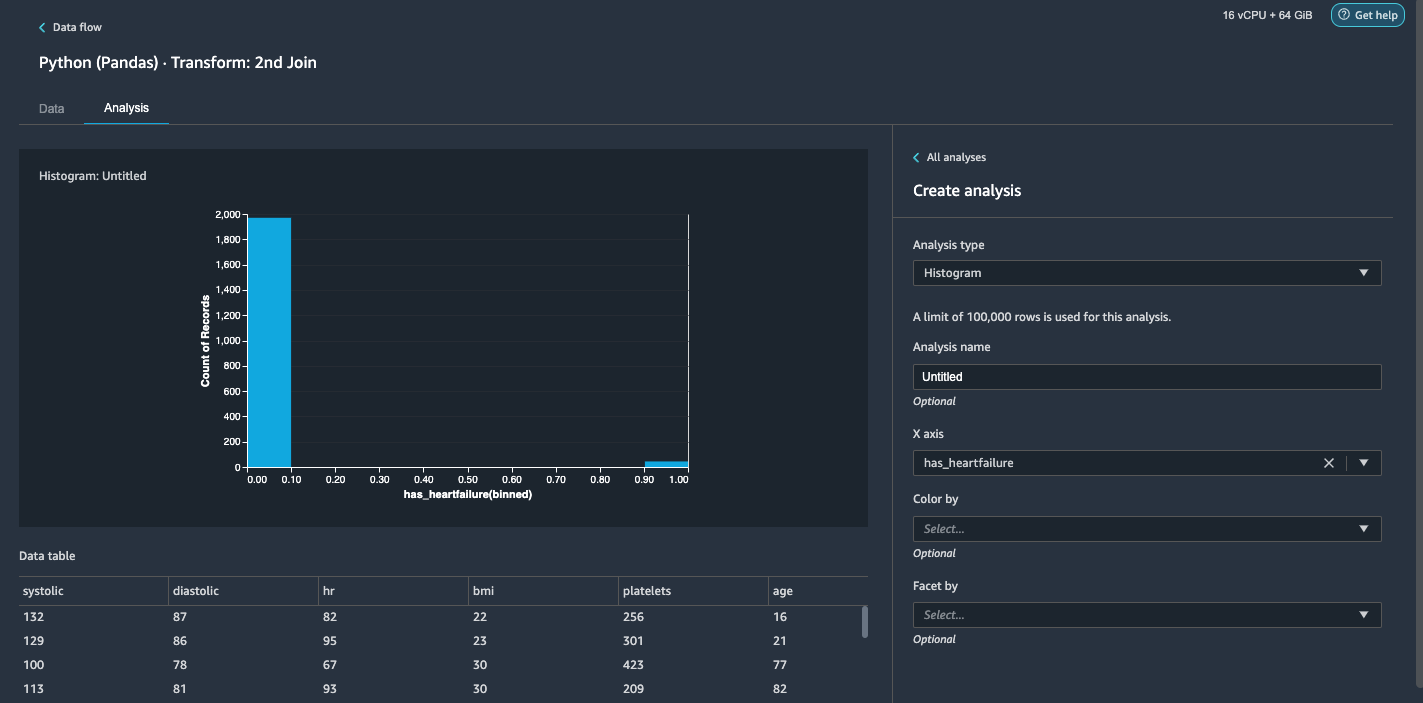

- Velg Analyse fanen.

- Til Analysetype¸ velg histogram.

- Til X-aksen, velg har_hjertesvikt.

- Velg Forhåndsvisning.

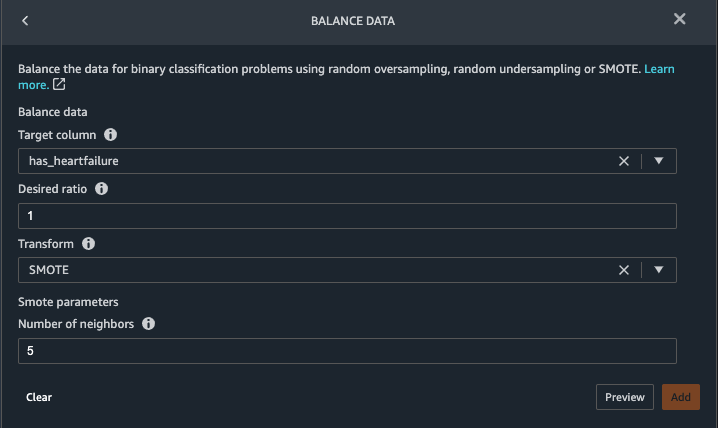

Det er åpenbart at vi har en ubalansert klasse (flere datapunkter merket som ingen hjertesvikt enn datapunkter merket som hjertesvikt). - Gå tilbake til Data kategorien. Velge Legg til trinn Og velg Balansedata.

- Til Målkolonne, velg har_hjertesvikt.

- Til Ønsket forhold, Tast inn

1. - Til Transform, velg SMOTE.

SMOTE står for Synthetic Minority Over-sampling Technique. Det er en teknikk for å lage nye minoritetsforekomster og legge til datasettet for å oppnå klassebalanse. For detaljert informasjon, se SMOTE: Synthetic Minority Over-sampling Technique. - Velg Forhåndsvisning, velg deretter Legg til.

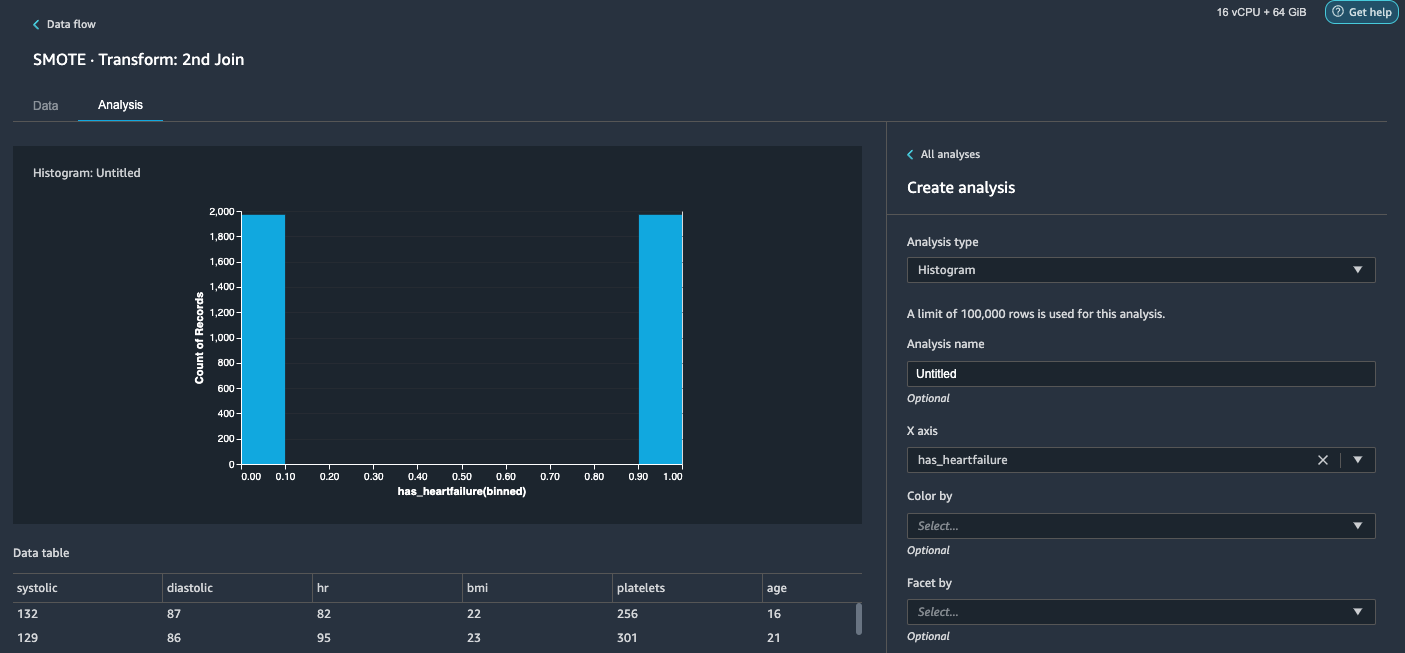

- Gjenta histogramanalysen i trinn 20-23. Resultatet er en balansert klasse.

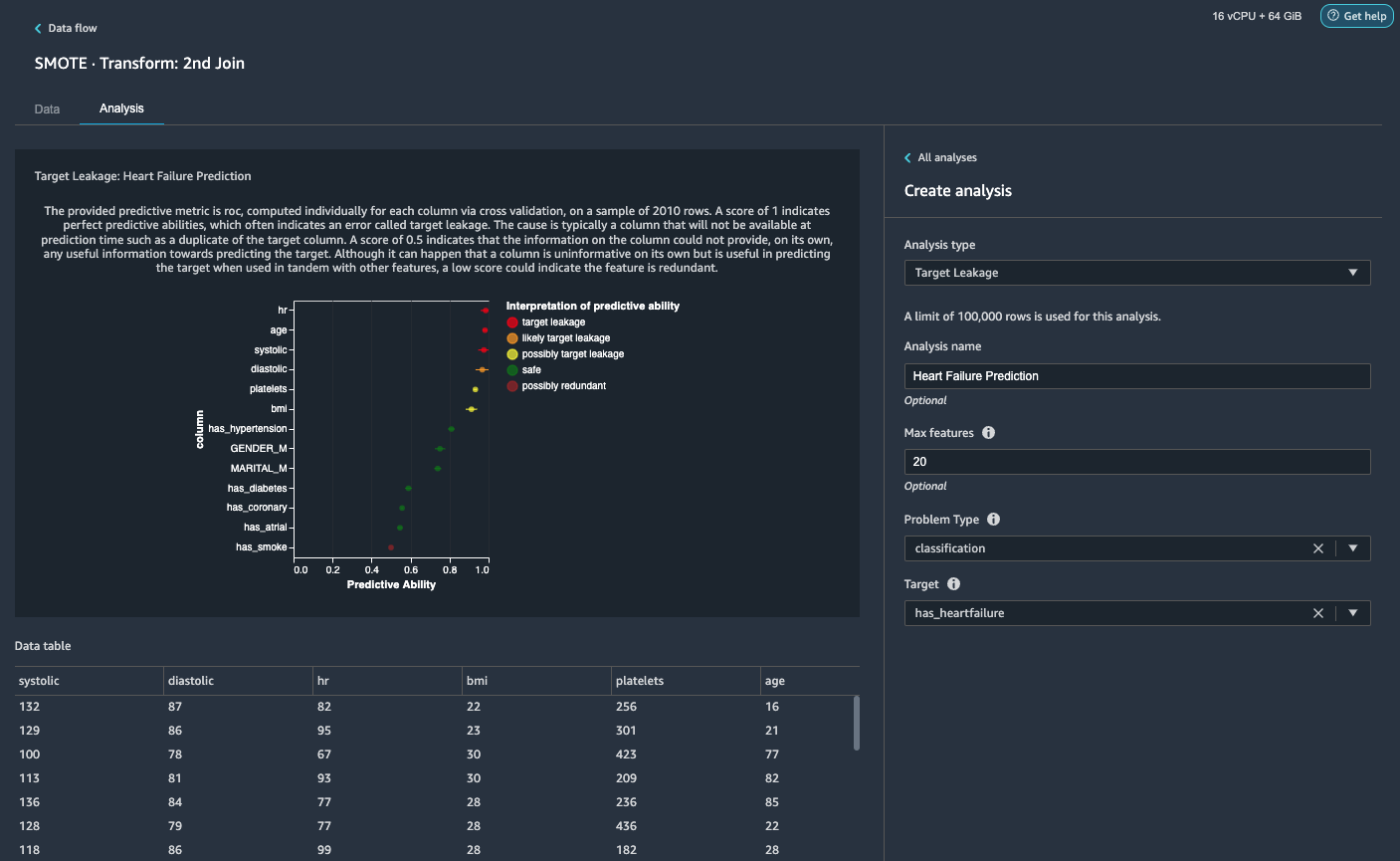

Visualiser mållekkasje og funksjonskorrelasjon

Deretter skal vi utføre noen få visuelle analyser ved hjelp av Data Wranglers rike verktøysett med avanserte ML-støttede analysetyper. Først ser vi på mållekkasje. Mållekkasje oppstår når data i treningsdatasettet er sterkt korrelert med måletiketten, men ikke er tilgjengelig i virkelige data på slutningstidspunktet.

- På Analyse-fanenFor Analysetype¸ velg Mållekkasje.

- Til Problemtype, velg klassifisering.

- Til Target, velg har_hjertesvikt.

- Velg Forhåndsvisning.

Basert på analysen,hrer en mållekkasje. Vi slipper det i et påfølgende trinn.ageer merket som en mållekkasje. Det er rimelig å si at en pasients alder vil være tilgjengelig under slutningstid, så vi beholder alder som en funksjon.Systolicogdiastolicer også merket som sannsynlig mållekkasje. Vi forventer å ha de to målingene i løpet av inferenstiden, så vi beholder dem som funksjoner. - Velg Legg til for å legge til analysen.

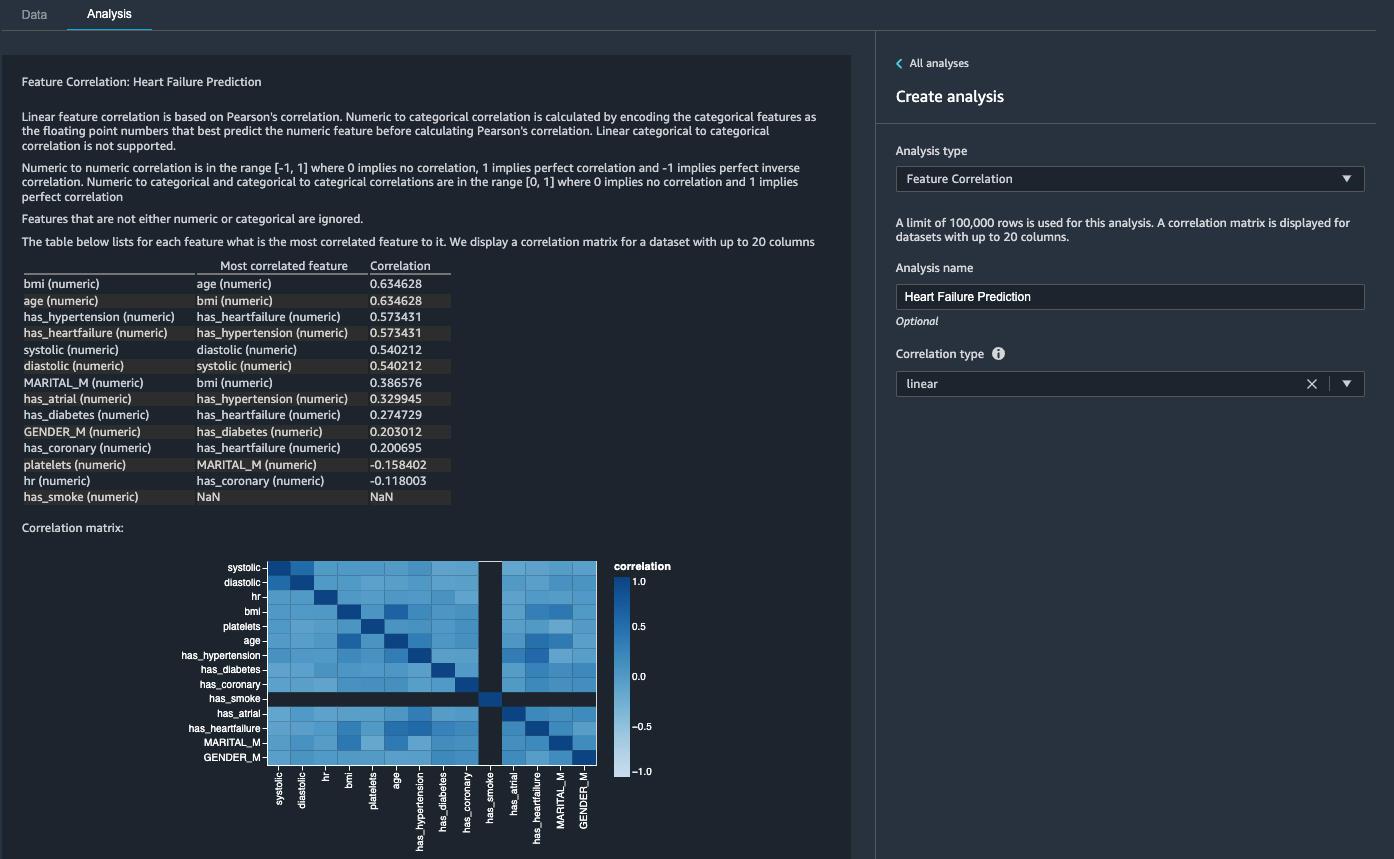

Deretter ser vi på funksjonskorrelasjon. Vi ønsker å velge funksjoner som er korrelert med målet, men som er ukorrelerte seg imellom.

- På Analyse-fanenFor Analysetype¸ velg Funksjonskorrelasjon.

- Til Korrelasjonstype¸ velg lineær.

- Velg Forhåndsvisning.

Koeffisientskårene indikerer sterke korrelasjoner mellom følgende par:

systolicogdiastolicbmiogagehas_hypertensionoghas_heartfailure(merkelapp)

For funksjoner som er sterkt korrelert, er matriser beregningsmessig vanskelig å invertere, noe som kan føre til numerisk ustabile estimater. For å redusere korrelasjonen kan vi ganske enkelt fjerne en fra paret. Vi slipper diastolic og bmi og hold systolic og age i et påfølgende trinn.

Slipp diastoliske og bmi kolonner

Legg til flere transformeringstrinn for å slippe hr, diastolic og bmi kolonner ved hjelp av den innebygde transformasjonen.

Generer rapporten om datakvalitet og -innsikt

AWS nylig annonsert den nye datakvalitets- og innsiktsrapportfunksjonen i Data Wrangler. Denne rapporten verifiserer automatisk datakvaliteten og oppdager avvik i dataene dine. Dataforskere og dataingeniører kan bruke dette verktøyet til å effektivt og raskt bruke domenekunnskap til å behandle datasett for opplæring i ML-modeller. Dette trinnet er valgfritt. For å generere denne rapporten på datasettene våre, fullfør følgende trinn:

- På Analyse fanen, for Analysetype, velg Rapport om datakvalitet og innsikt.

- Til Målkolonne, velg har_hjertesvikt.

- Til Problemtype, plukke ut Klassifisering.

- Velg Opprett.

På noen få minutter genererer den en rapport med et sammendrag, bilder og anbefalinger.

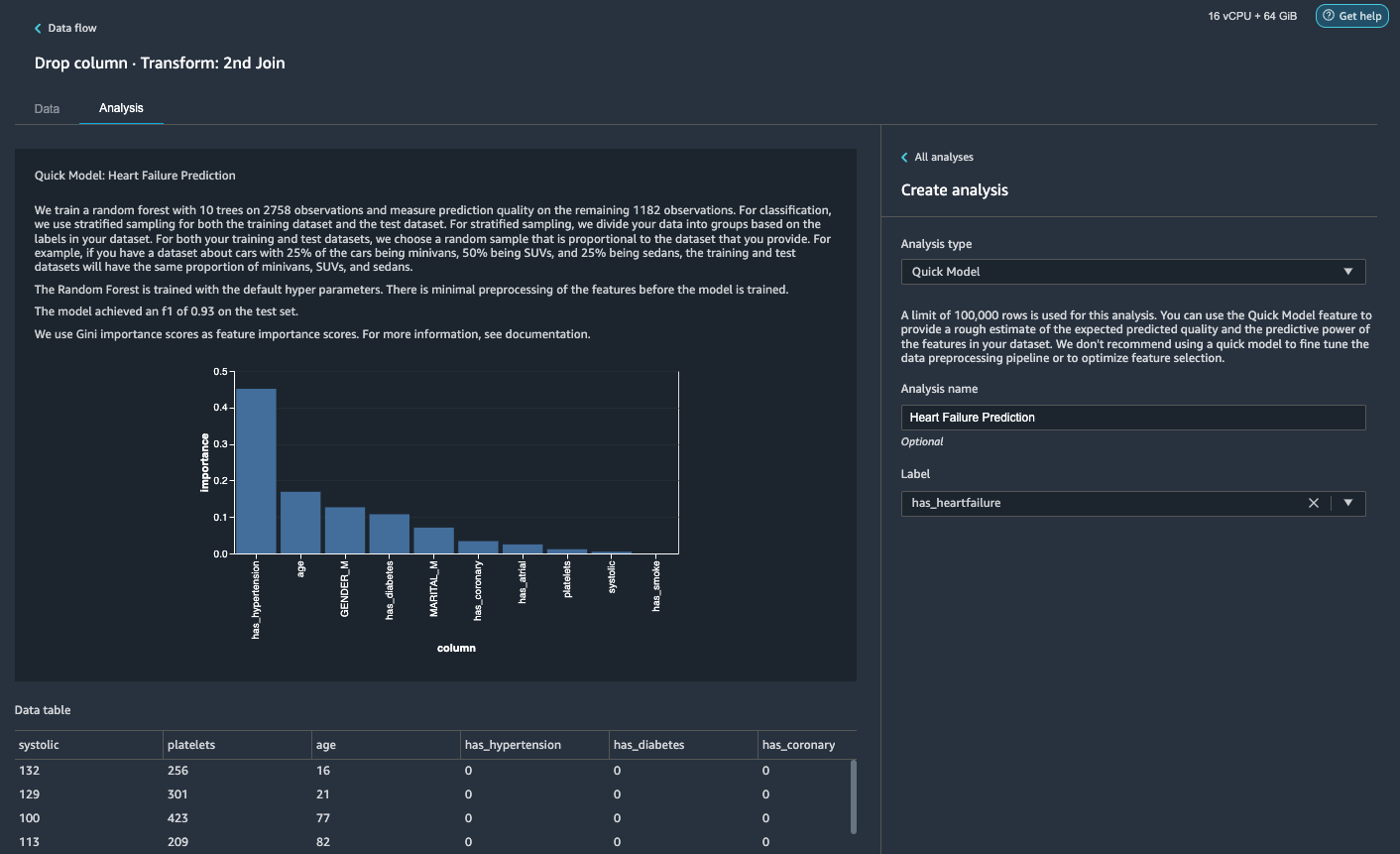

Generer en rask modellanalyse

Vi har fullført vår dataforberedelse, rengjøring og funksjonsutvikling. Data Wrangler har en innebygd funksjon som gir et grovt estimat av forventet predikert kvalitet og prediksjonskraften til funksjonene i datasettet vårt.

- På Analyse fanen, for Analysetype¸ velg Rask modell.

- Til Etiketten, velg har_hjertesvikt.

- Velg Forhåndsvisning.

I henhold til vår Quick Model-analyse kan vi se funksjonen has_hypertension har den høyeste funksjonens betydningsscore blant alle funksjoner.

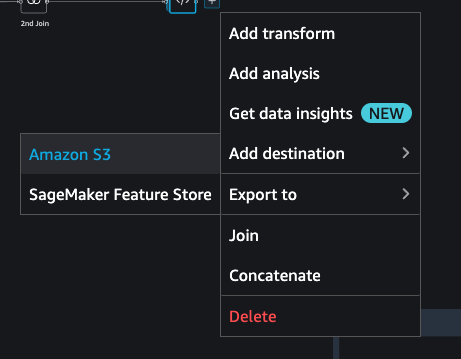

Eksporter dataene og tren modellen

La oss nå eksportere de transformerte ML-klare funksjonene til en S3-destinasjonsbøtte og skalere hele funksjonsteknikk-pipelinen vi har laget så langt ved å bruke prøvene inn i hele datasettet på en distribuert måte.

- Velg plusstegnet ved siden av den siste boksen i dataflyten og velg Legg til destinasjon.

- Velg Amazon S3.

- Skriv inn et Datasettnavn. For Amazon S3 plassering, velg en S3-bøtte, og velg deretter Legg til destinasjon.

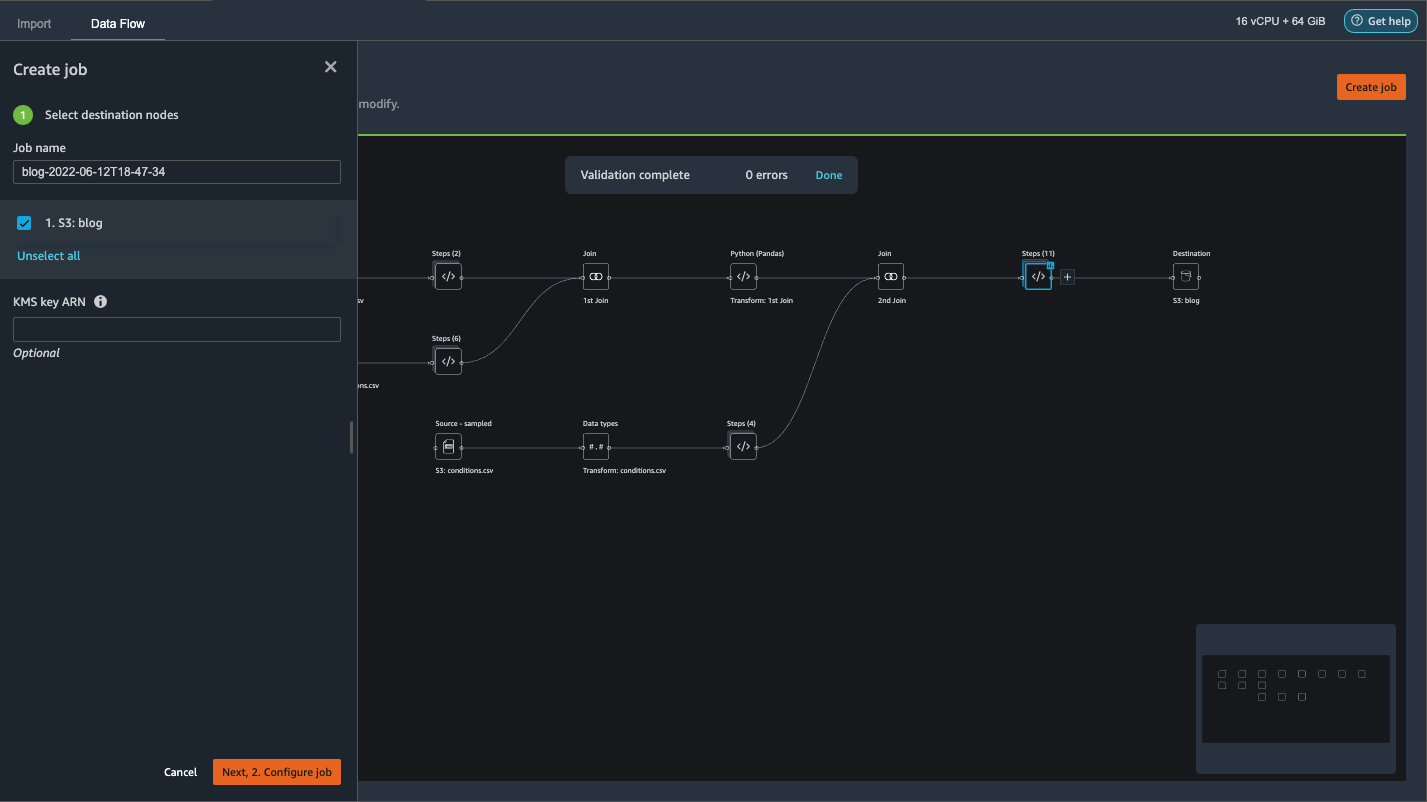

- Velg Lag jobb for å starte en distribuert PySpark-behandlingsjobb for å utføre transformasjonen og sende ut dataene til S3-destinasjonsbøtten.

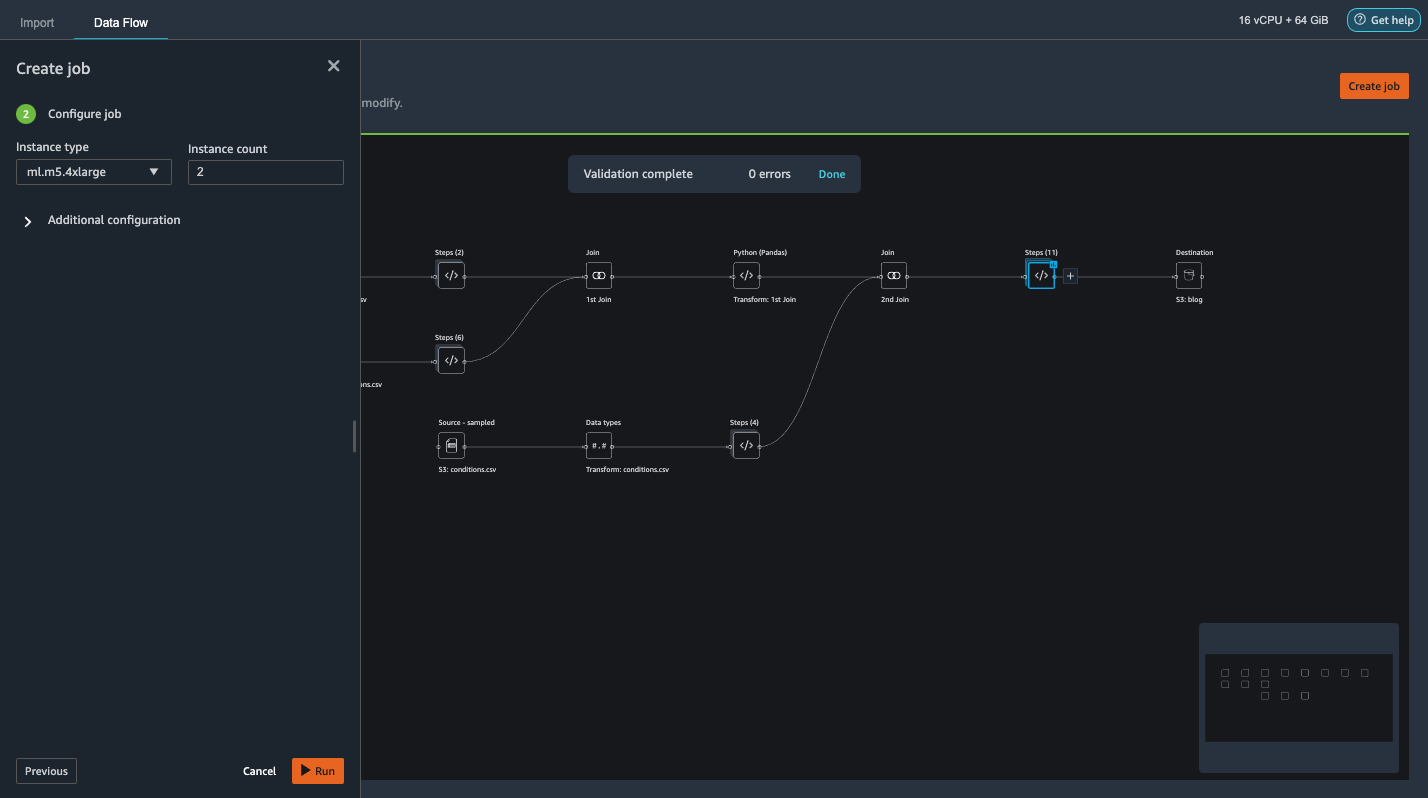

Avhengig av størrelsen på datasettene, lar dette alternativet oss enkelt konfigurere klyngen og horisontalt skalere uten kode. Vi trenger ikke å bekymre oss for å partisjonere datasettene eller administrere klyngen og Spark-internene. Alt dette blir automatisk tatt hånd om for oss av Data Wrangler. - Velg i venstre rute Neste, 2. Konfigurer jobb.

- Velg deretter Kjør.

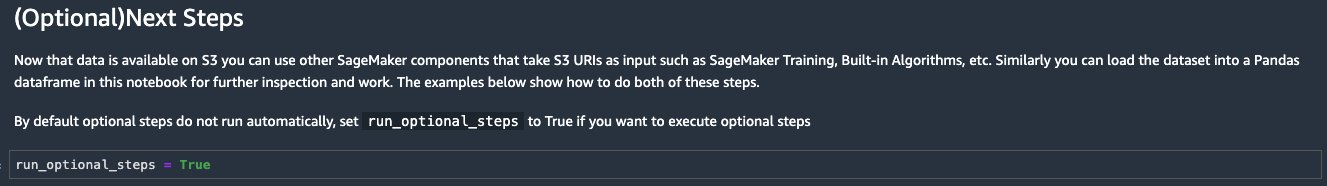

Alternativt kan vi også eksportere den transformerte utgangen til S3 via en Jupyter Notebook. Med denne tilnærmingen genererer Data Wrangler automatisk en Jupyter-notisbok med all koden som trengs for å starte en behandlingsjobb for å bruke dataflyttrinnene (opprettet ved hjelp av en prøve) på det større fullstendige datasettet og bruke det transformerte datasettet som funksjoner for å kick- fra en treningsjobb senere. Den bærbare koden kan enkelt kjøres med eller uten å gjøre endringer. La oss nå gå gjennom trinnene for hvordan du får dette gjort via Data Wranglers brukergrensesnitt.

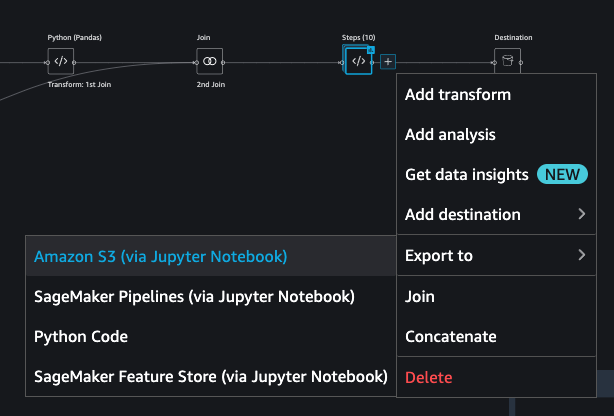

- Velg plusstegnet ved siden av det siste trinnet i dataflyten og velg Eksport til.

- Velg Amazon S3 (via Jupyter Notebook).

- Den åpner automatisk en ny fane med en Jupyter-notisbok.

- I Jupyter-notisboken, finn cellen i (Valgfritt) Neste trinn seksjon og endring

run_optional_stepsfraFalsetilTrue.

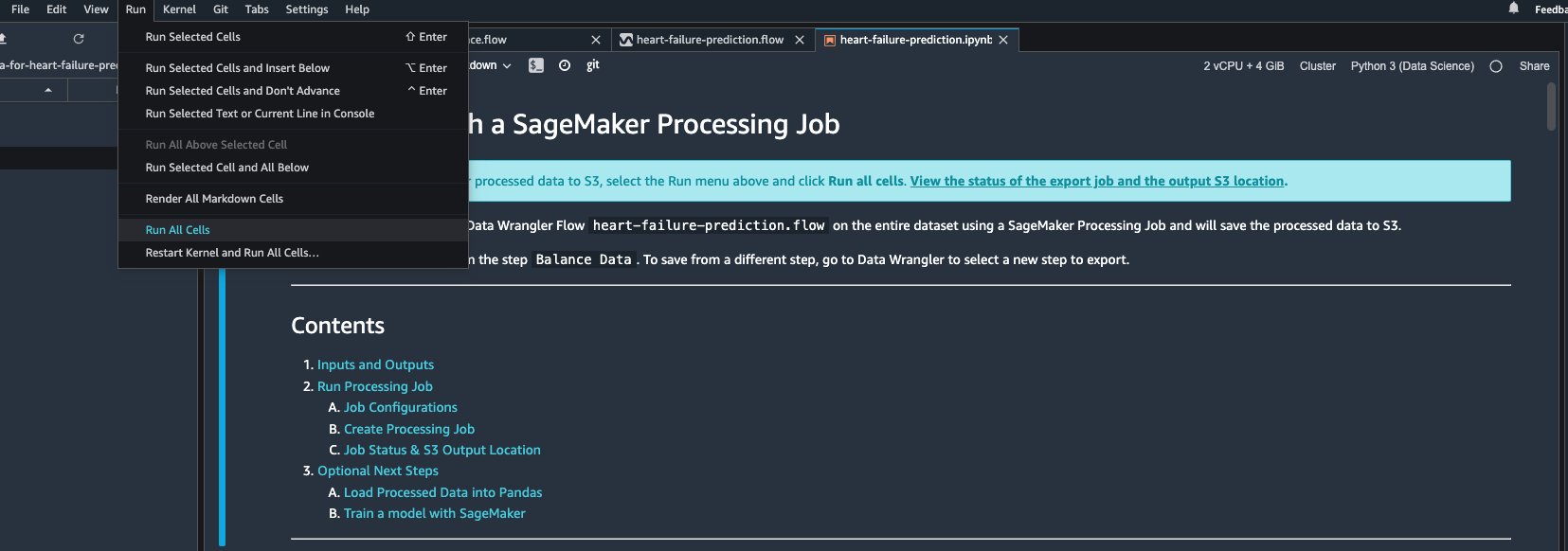

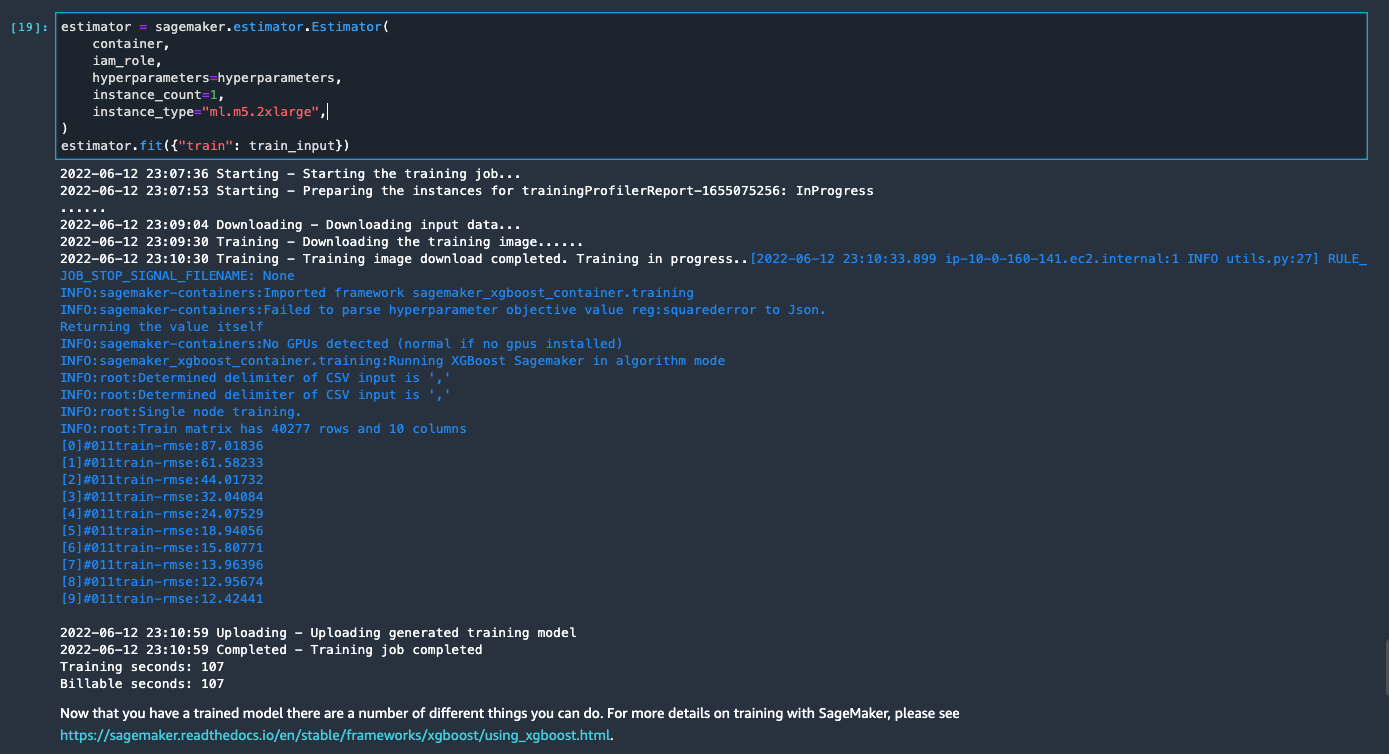

De aktiverte valgfrie trinnene i den bærbare datamaskinen utfører følgende: - Gå tilbake til toppen av notatboken og på Kjør meny, velg Kjør alle celler.

Hvis du bruker den genererte notatboken som den er, starter den en SageMaker-behandlingsjobb som skalerer ut behandlingen over to m5.4xlarge forekomster for å behandle hele datasettet på S3-bøtten. Du kan justere antall forekomster og forekomsttyper basert på datasettstørrelsen og tiden du trenger for å fullføre jobben.

Vent til treningsjobben fra den siste cellen er fullført. Den genererer en modell i SageMaker standard S3-bøtte.

Den trente modellen er klar for distribusjon for enten sanntidsslutning eller batchtransformasjon. Merk at vi brukte syntetiske data for å demonstrere funksjonaliteter i Data Wrangler og brukte behandlede data for treningsmodell. Gitt at dataene vi brukte er syntetiske, er ikke konklusjonsresultatet fra den trente modellen ment for medisinsk tilstandsdiagnose i den virkelige verden eller erstatning av skjønn fra leger.

Du kan også eksportere det transformerte datasettet direkte til Amazon S3 ved å velge Eksport øverst på forhåndsvisningssiden for transformering. Alternativet for direkte eksport eksporterer bare den transformerte prøven hvis sampling ble aktivert under importen. Dette alternativet er best egnet hvis du har å gjøre med mindre datasett. De transformerte dataene kan også tas inn direkte i en funksjonsbutikk. For mer informasjon, se Amazon SageMaker Feature Store. Dataflyten kan også eksporteres som en SageMaker-pipeline som kan orkestreres og planlegges i henhold til dine krav. For mer informasjon, se Amazon SageMaker-rørledninger.

konklusjonen

I dette innlegget viste vi hvordan du bruker Data Wrangler til å behandle helsedata og utføre skalerbar funksjonsutvikling på en verktøydrevet, lavkodemåte. Vi lærte hvordan vi bruker de innebygde transformasjonene og analysene på en passende måte der det er nødvendig, og kombinerer det med tilpassede transformasjoner for å legge til enda mer fleksibilitet til arbeidsflyten vår for dataforberedelse. Vi gikk også gjennom de forskjellige alternativene for å skalere ut dataflytoppskriften via distribuerte behandlingsjobber. Vi lærte også hvordan de transformerte dataene enkelt kan brukes til å trene en modell for å forutsi hjertesvikt.

Det er mange andre funksjoner i Data Wrangler vi ikke har dekket i dette innlegget. Utforsk hva som er mulig i Forbered ML-data med Amazon SageMaker Data Wrangler og lær hvordan du kan utnytte Data Wrangler for ditt neste datavitenskap eller maskinlæringsprosjekt.

Om forfatterne

Forrest Sun er senior løsningsarkitekt med AWS Public Sector-teamet i Toronto, Canada. Han har jobbet i helse- og finansbransjen de siste to tiårene. Utenom jobben liker han å campe med familien.

Forrest Sun er senior løsningsarkitekt med AWS Public Sector-teamet i Toronto, Canada. Han har jobbet i helse- og finansbransjen de siste to tiårene. Utenom jobben liker han å campe med familien.

Arunprasath Shankar er en kunstig intelligens og maskinlæring (AI / ML) spesialistløsningsarkitekt med AWS, som hjelper globale kunder å skalere sine AI-løsninger effektivt og effektivt i skyen. På fritiden liker Arun å se sci-fi-filmer og lytte til klassisk musikk.

Arunprasath Shankar er en kunstig intelligens og maskinlæring (AI / ML) spesialistløsningsarkitekt med AWS, som hjelper globale kunder å skalere sine AI-løsninger effektivt og effektivt i skyen. På fritiden liker Arun å se sci-fi-filmer og lytte til klassisk musikk.

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon SageMaker

- Amazon SageMaker Data Wrangler

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- zephyrnet