video Googles største AI-språkmodell hjelper roboter med å være mer fleksible i å forstå og tolke menneskelige kommandoer, ifølge nettgigantens siste forskning.

Maskiner reagerer vanligvis best på svært spesifikke krav – åpne forespørsler kan noen ganger kaste dem ut og føre til resultater som brukerne ikke hadde i tankene. Folk lærer å samhandle med roboter på en rigid måte, som å stille spørsmål på en bestemt måte for å få ønsket respons.

Googles nyeste system, kalt PaLM-SayCan, lover imidlertid å være smartere. Den fysiske enheten fra Everyday Robots – en oppstart spunnet ut av Google X – har kameraer for øyne i hodet og en arm med en tang gjemt bak den lange rette kroppen, som sitter på toppen av et sett med hjul.

Du kan se roboten i aksjon i videoen nedenfor:

Spør roboten, noe sånt som "Jeg har nettopp trent, kan du få meg en sunn matbit?" vil dytte den til å hente et eple. "PaLM-SayCan [er] en tolkbar og generell tilnærming til å utnytte kunnskap fra språkmodeller som gjør det mulig for en robot å følge tekstinstruksjoner på høyt nivå for å utføre fysisk funderte oppgaver," forskere fra Googles hjerneteam forklarte.

Google introduserte sin største språkmodell PALM i april i år. PaLM ble trent på data skrapet fra internett, men i stedet for å spy ut åpne tekstsvar, ble systemet tilpasset for å generere en liste med instruksjoner som roboten skulle følge.

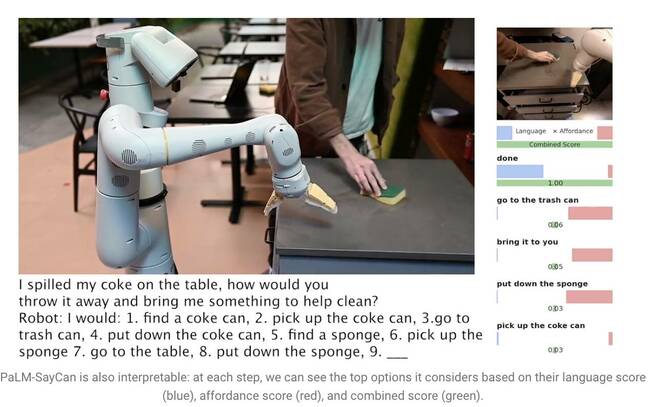

Å si «Jeg sølt colaen min på bordet, hvordan ville du kastet den og tatt med noe for å hjelpe meg med å rengjøre?», får PaLM til å forstå spørsmålet og generere en liste over trinn roboten kan følge for å fullføre oppgaven, som å gå over å plukke opp boksen, kaste den i en søppelbøtte og få en svamp.

Store språkmodeller (LLM) som PaLM forstår imidlertid ikke betydningen av noe de sier. Av denne grunn trente forskerne en egen modell ved å bruke forsterkende læring for å jorde abstrakt språk til visuelle representasjoner og handlinger. På den måten lærer roboten å assosiere ordet "cola" med et bilde av en brusboks.

PaLM-SayCan lærer også såkalte "affordance-funksjoner" - en metode som rangerer muligheten for å fullføre en spesifikk handling gitt objekter i miljøet. Roboten er mer sannsynlig å plukke opp en svamp enn en støvsuger, for eksempel hvis den oppdager en svamp, men ikke noe vakuum i nærheten av den.

"Vår metode, SayCan, trekker ut og utnytter kunnskapen innen LLMs i fysisk funderte oppgaver," forklarte teamet i en forskning papir. "LLM (Say) gir en oppgavegrunnlag for å bestemme nyttige handlinger for et mål på høyt nivå, og de lærte affordance-funksjonene (Can) gir verdensgrunnlag for å bestemme hva som er mulig å utføre på planen. Vi bruker forsterkende læring (RL) som en måte å lære språkbetingede verdifunksjoner som gir råd til hva som er mulig i verden.»

For å forhindre at roboten går fra oppgaven, er den opplært til å velge handlinger kun fra 101 forskjellige instruksjoner. Google lærte det opp til å tilpasse seg et kjøkken – PaLM-SayCan kan få snacks, drikke og utføre enkle rengjøringsoppgaver. Forskerne mener LLM-er er det første trinnet i å få roboter til å utføre mer komplekse oppgaver trygt gitt abstrakte instruksjoner.

"Våre eksperimenter på en rekke robotoppgaver i den virkelige verden viser evnen til å planlegge og fullføre abstrakte, naturlige språkinstruksjoner med lang horisont med høy suksessrate. Vi tror at PaLM-SayCans tolkbarhet tillater sikker brukerinteraksjon med roboter i den virkelige verden,» konkluderte de. ®

- AI

- ai kunst

- ai art generator

- du har en robot

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- Registeret

- zephyrnet