I den dynamiske verden av streaming på Amazon Musikk, hvert søk etter en sang, podcast eller spilleliste inneholder en historie, en stemning eller en flom av følelser som venter på å bli avduket. Disse søkene fungerer som en inngangsport til nye oppdagelser, kjære opplevelser og varige minner. Søkefeltet handler ikke bare om å finne en sang; det handler om de millioner av aktive brukere som starter sin personlige reise inn i den rike og mangfoldige verden som Amazon Music har å tilby.

Å levere en overlegen kundeopplevelse for å umiddelbart finne musikken brukerne søker etter krever en plattform som er både smart og responsiv. Amazon Music bruker kraften til AI for å oppnå dette. Det er imidlertid vanskelig å optimere kundeopplevelsen mens du administrerer kostnadene for opplæring og slutninger til AI-modeller som driver søkefeltets muligheter, som sanntids stavekontroll og vektorsøk.

Amazon SageMaker gir et ende-til-ende-sett med tjenester som lar Amazon Music bygge, trene og distribuere på AWS Cloud med minimal innsats. Ved å ta vare på de udifferensierte tunge løftene lar SageMaker deg fokusere på å jobbe med maskinlæringsmodellene dine (ML), og ikke bekymre deg for ting som infrastruktur. Som en del av delt ansvarsmodellen sørger SageMaker for at tjenestene de leverer er pålitelige, ytende og skalerbare, mens du sørger for at applikasjonen av ML-modellene utnytter mulighetene som SageMaker tilbyr best mulig.

I dette innlegget går vi gjennom reisen Amazon Music tok for å optimalisere ytelsen og kostnadene ved å bruke SageMaker og NVIDIA Triton Inference Server og TensorRT. Vi dykker dypt ned i å vise hvordan den tilsynelatende enkle, men likevel intrikate søkelinjen fungerer, og sikrer en uavbrutt reise inn i universet til Amazon Music med lite til null frustrerende skrivefeilforsinkelser og relevante søkeresultater i sanntid.

Amazon SageMaker og NVIDIA: Leverer raske og nøyaktige vektorsøk og stavekontrollfunksjoner

Amazon Music tilbyr et stort bibliotek med over 100 millioner sanger og millioner av podcast-episoder. Det kan imidlertid være utfordrende å finne den rette sangen eller podcasten, spesielt hvis du ikke kjenner den eksakte tittelen, artisten eller albumnavnet, eller søket som er søkt er veldig bredt, for eksempel «nyhetspodcaster».

Amazon Music har tatt en todelt tilnærming for å forbedre søke- og gjenfinningsprosessen. Det første trinnet er å introdusere vektorsøk (også kjent som innebyggingsbasert henting), en ML-teknikk som kan hjelpe brukere med å finne det mest relevante innholdet de leter etter ved å bruke semantikk av innholdet. Det andre trinnet innebærer å introdusere en transformatorbasert stavekorreksjonsmodell i søkestakken. Dette kan være spesielt nyttig når du søker etter musikk, fordi brukere kanskje ikke alltid vet den nøyaktige stavemåten til en sangtittel eller artistnavn. Stavekorrigering kan hjelpe brukere med å finne musikken de leter etter selv om de gjør en stavefeil i søket.

Å introdusere transformatormodeller i en søk- og gjenfinningspipeline (i generering av spørringsinnbygging som er nødvendig for vektorsøk og den generative Seq2Seq Transformer-modellen i stavekorreksjon) kan føre til betydelig økning i total latens, noe som påvirker kundeopplevelsen negativt. Derfor ble det en toppprioritet for oss å optimalisere sanntidsslutningsforsinkelsen for vektorsøk og stavekorrigeringsmodeller.

Amazon Music og NVIDIA har kommet sammen for å bringe den best mulige kundeopplevelsen til søkefeltet, ved å bruke SageMaker til å implementere både raske og nøyaktige stavekontrollfunksjoner og sanntids semantiske søkeforslag ved bruk av vektorsøkbaserte teknikker. Løsningen inkluderer bruk av SageMaker-hosting drevet av G5-instanser som bruker NVIDIA A10G Tensor Core GPUer, SageMaker-støttet NVIDIA Triton Inference Server Container, og NVIDIA TensorRT modellformat. Ved å redusere slutningsforsinkelsen til stavekontrollmodellen til 25 millisekunder ved topptrafikk, og redusere forsinkelsen for generering av søkespørringsinnbygging med 63 % i gjennomsnitt og kostnad med 73 % sammenlignet med CPU-basert slutning, har Amazon Music hevet søkefeltets ytelse.

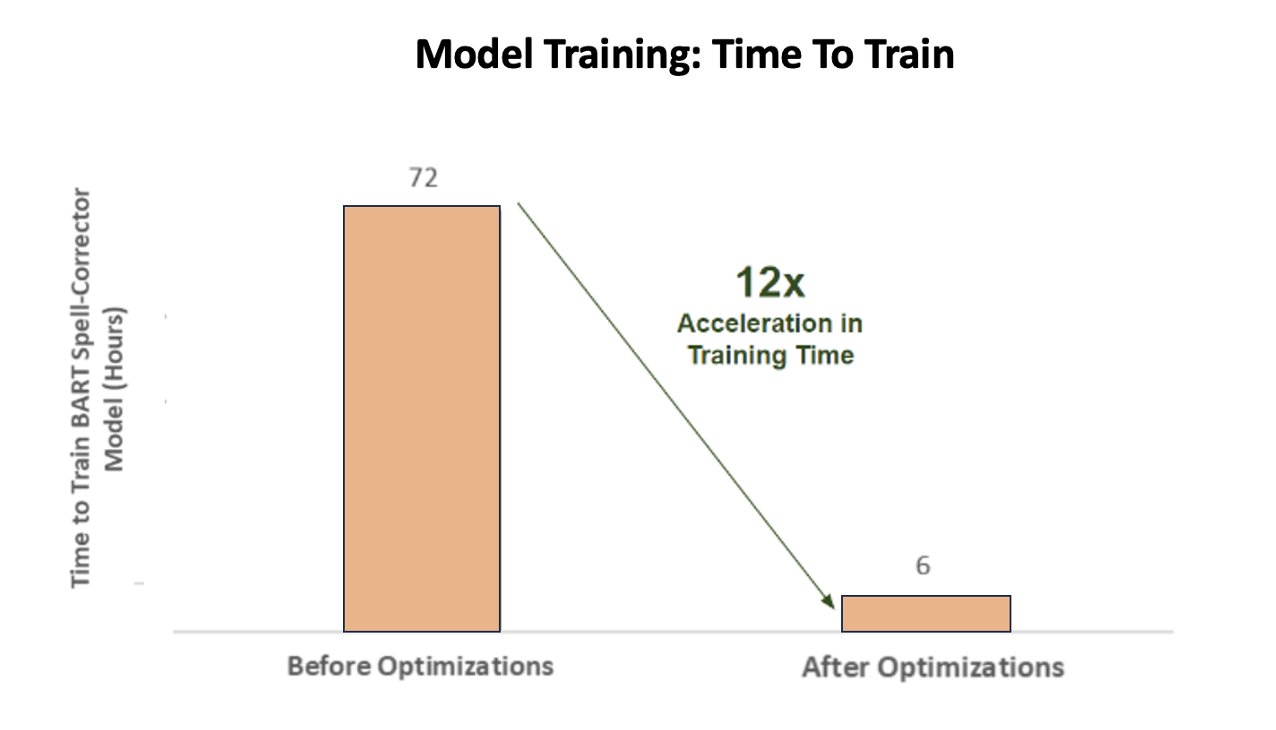

I tillegg, når du trente AI-modellen for å levere nøyaktige resultater, oppnådde Amazon Music en gigantisk 12 ganger akselerasjon i treningstid for deres BART-sekvens-til-sekvens stavekontroll-transformatormodell, og sparte dem både tid og penger ved å optimalisere GPU-bruken.

Amazon Music samarbeidet med NVIDIA for å prioritere kundesøkeopplevelsen og lage en søkelinje med godt optimalisert stavekontroll og vektorsøkefunksjoner. I de følgende delene deler vi mer om hvordan disse optimaliseringene ble orkestrert.

Optimalisering av trening med NVIDIA Tensor Core GPUer

Å få tilgang til en NVIDIA Tensor Core GPU for opplæring av store språkmodeller er ikke nok til å fange opp dets sanne potensiale. Det er viktige optimaliseringstrinn som må skje under trening for å maksimere GPU-ens utnyttelse fullt ut. Imidlertid vil en underutnyttet GPU utvilsomt føre til ineffektiv bruk av ressurser, forlenget opplæringsvarighet og økte driftskostnader.

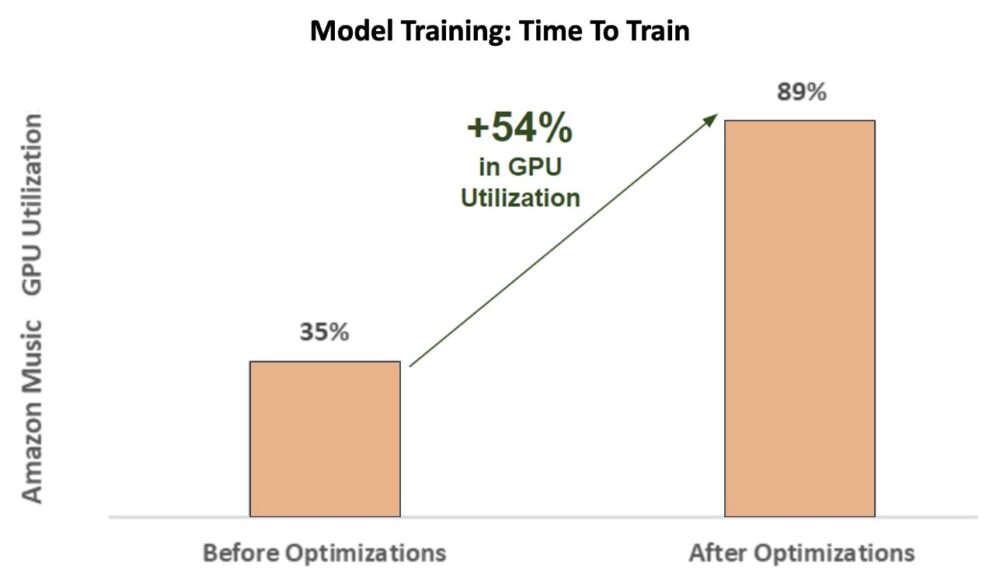

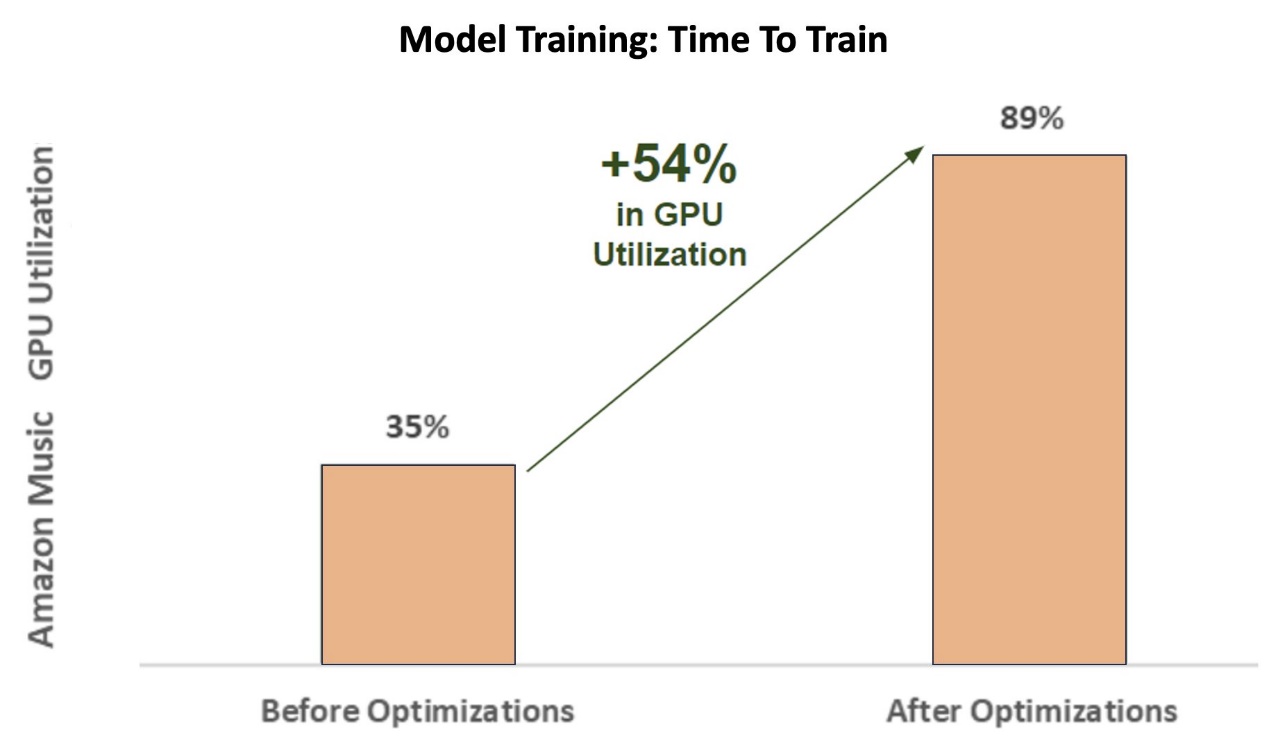

Under de innledende fasene av treningen av stavekorrigereren BART (bart-base) transformatormodell på en SageMaker ml.p3.24xlarge forekomst (8 NVIDIA V100 Tensor Core GPUer), var Amazon Musics GPU-utnyttelse rundt 35 %. For å maksimere fordelene med NVIDIA GPU-akselerert opplæring, støttet AWS- og NVIDIA-løsningsarkitekter Amazon Music med å identifisere områder for optimaliseringer, spesielt rundt batchstørrelse og presisjonsparametere. Disse to avgjørende parameterne påvirker effektiviteten, hastigheten og nøyaktigheten til treningsmodeller for dyp læring.

De resulterende optimaliseringene ga en ny og forbedret V100 GPU-utnyttelse, stabil på rundt 89 %, noe som drastisk reduserte Amazon Musics treningstid fra 3 dager til 5–6 timer. Ved å bytte batchstørrelse fra 32 til 256 og bruke optimaliseringsteknikker som løping automatisk blandet presisjonstrening i stedet for bare å bruke FP32-presisjon, kunne Amazon Music spare både tid og penger.

Følgende diagram illustrerer økningen på 54 % prosentpoeng i GPU-bruken etter optimaliseringer.

Følgende figur illustrerer akselerasjonen i treningstid.

Denne økningen i batchstørrelse gjorde at NVIDIA GPU kunne behandle betydelig mer data samtidig på tvers av flere Tensor Cores, noe som resulterte i akselerert treningstid. Det er imidlertid viktig å opprettholde en delikat balanse med minne, fordi større batchstørrelser krever mer minne. Både å øke batchstørrelsen og bruke blandet presisjon kan være avgjørende for å låse opp kraften til NVIDIA Tensor Core GPUer.

Etter at modellen ble trent til å konvergens, var det på tide å optimalisere for slutningsdistribusjon på Amazon Musics søkefelt.

Stavekorreksjon: BART-modellslutning

Med hjelp av SageMaker G5-forekomster og NVIDIA Triton Inference Server (en åpen kildekode-programvare for inferensservering), samt NVIDIA TensorRT, en SDK for høyytelses dyplæringsslutninger som inkluderer en inferensoptimalisering og kjøretid, begrenser Amazon Music stavekontrollen deres BART (bart-base) modellserverens slutningsforsinkelse til bare 25 millisekunder ved høytrafikk. Dette inkluderer overhead som lastbalansering, forbehandling, modellslutning og etterbehandlingstider.

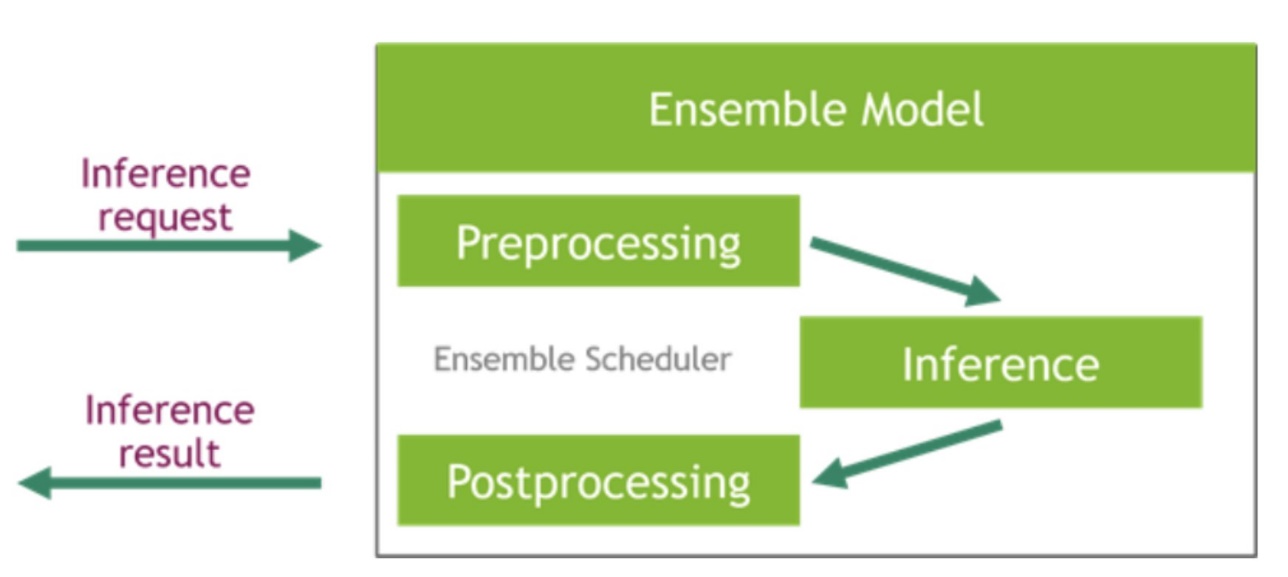

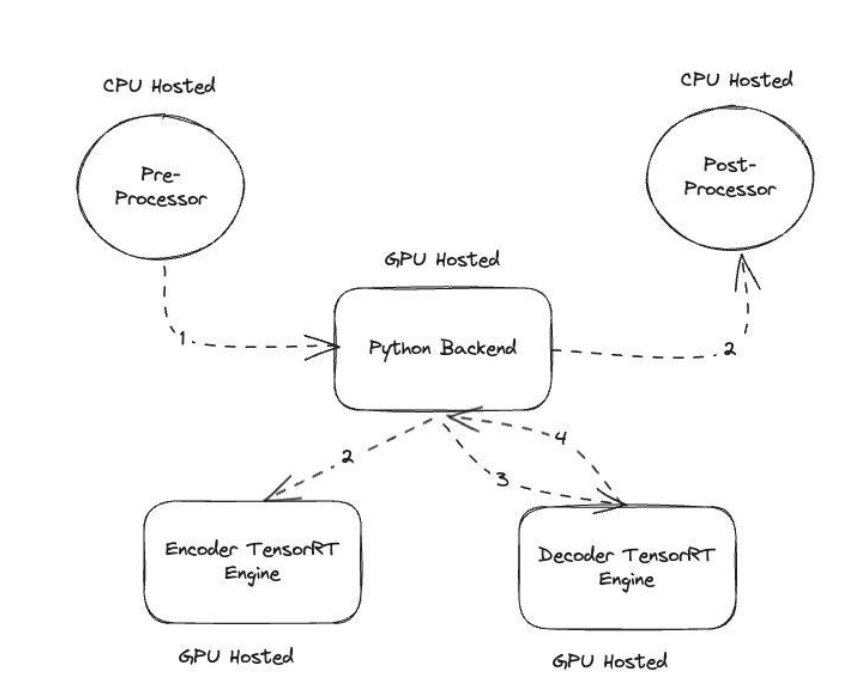

NVIDIA Triton Inference Server gir to forskjellige typer backends: en for hosting av modeller på GPU, og en Python-backend hvor du kan ta med din egen tilpassede kode som skal brukes i forbehandlings- og etterbehandlingstrinn. Følgende figur illustrerer modell ensemble ordning.

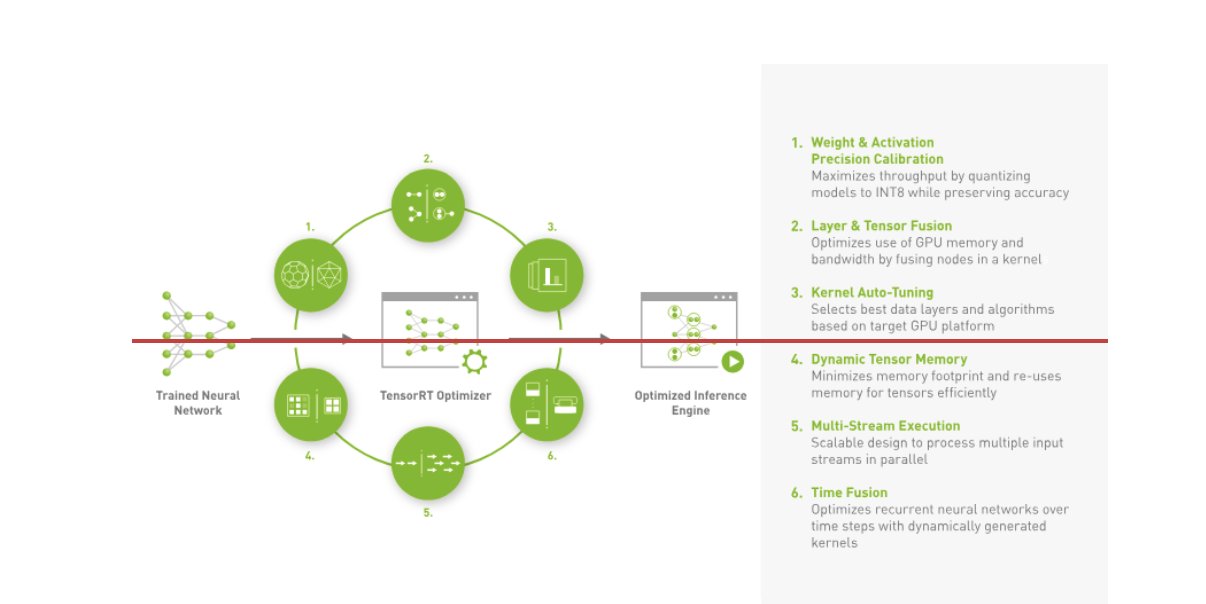

Amazon Music bygde sin BART slutningsrørledning ved å kjøre både forhåndsbehandling (teksttokenisering) og etterbehandling (tokens til tekst) trinn på CPUer, mens modellutførelsestrinnet kjører på NVIDIA A10G Tensor Core GPUer. En Python-backend sitter midt i forbehandlings- og etterbehandlingstrinnene, og er ansvarlig for å kommunisere med de TensorRT-konverterte BART-modellene samt koder/dekodernettverk. TensorRT øker slutningsytelsen med presisjonskalibrering, lag- og tensorfusjon, autotuning av kjernen, dynamisk tensorminne, flerstrømsutførelse og tidsfusjon.

Den følgende figuren illustrerer høynivådesignen til nøkkelmodulene som utgjør stavekorrigeringsrørledningen for BART-modellen.

Vektorsøk: Spørring som innebygger generasjonssetning BERT-modellslutning

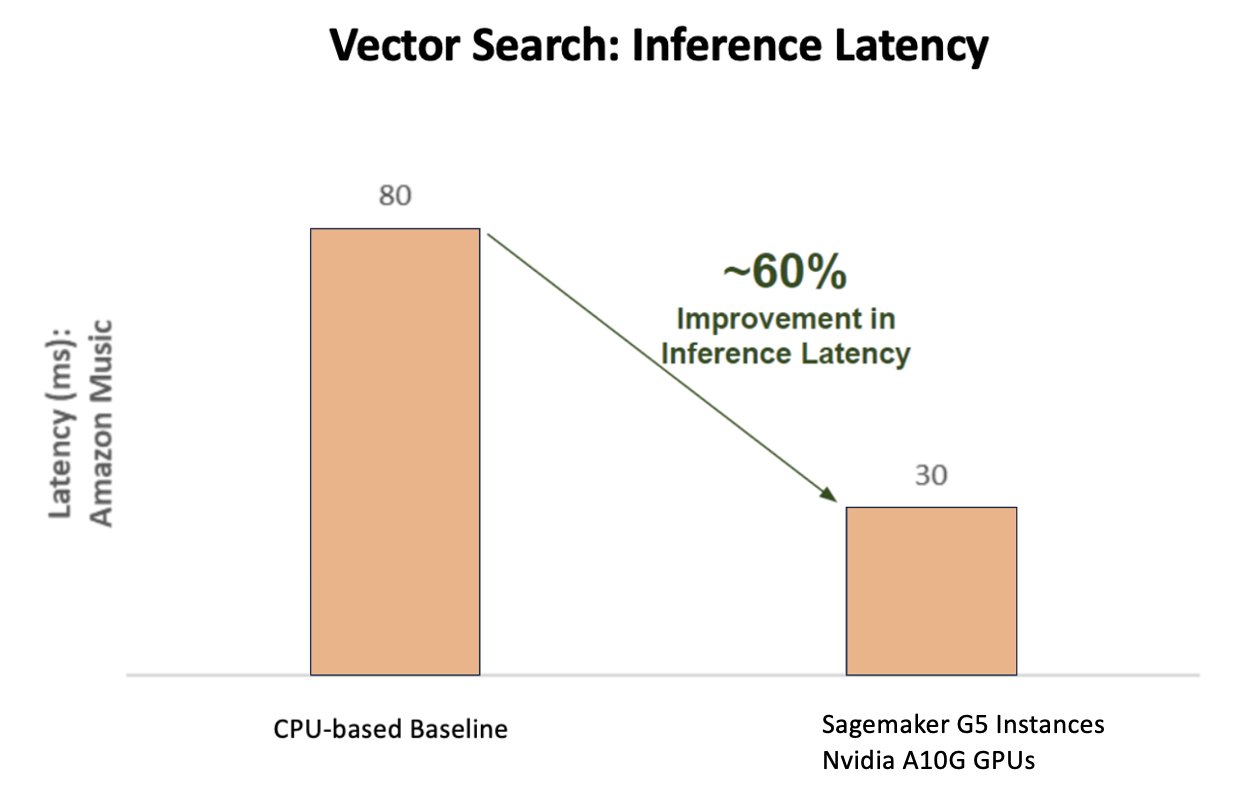

Følgende diagram illustrerer 60 % forbedring i ventetid (serverer p90 800–900 TPS) ved bruk av NVIDIA AI Inference Platform sammenlignet med en CPU-basert baseline.

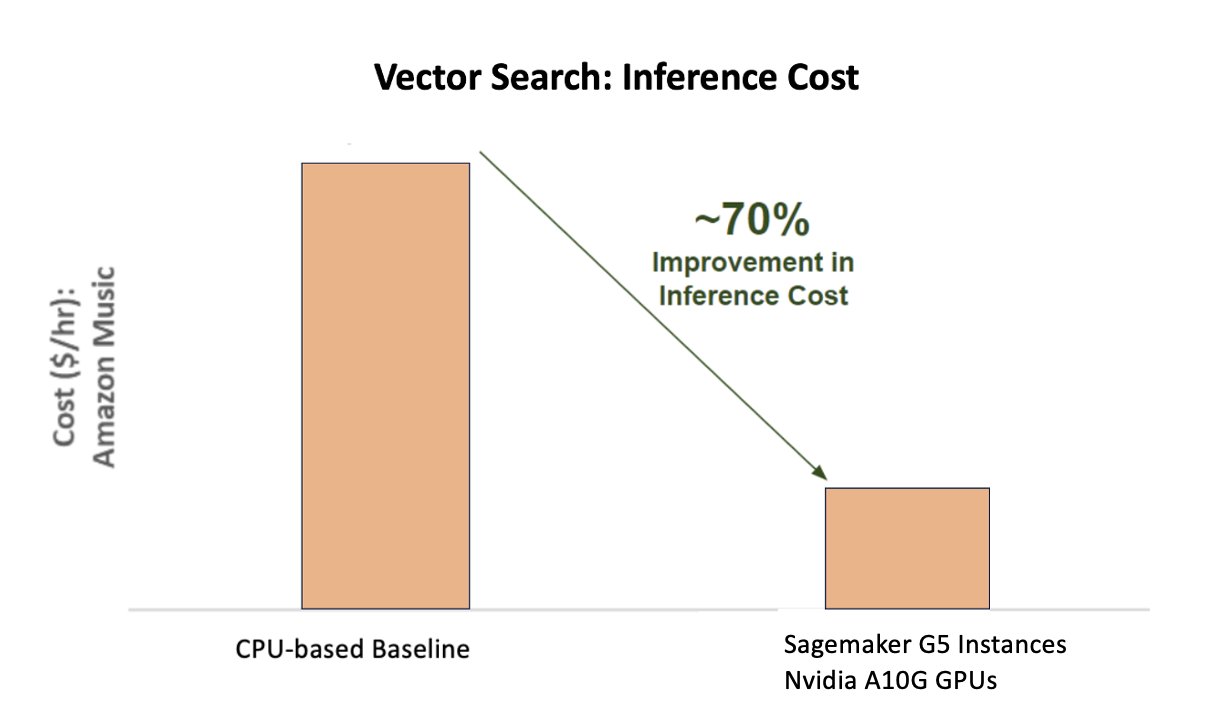

Følgende diagram viser en 70 % forbedring i kostnadene ved bruk av NVIDIA AI Inference Platform sammenlignet med en CPU-basert baseline.

Følgende figur illustrerer en SDK for dyp læringsslutning med høy ytelse. Den inkluderer en deep learning inferensoptimalisering og kjøretid som gir lav latenstid og høy gjennomstrømning for inferensapplikasjoner.

For å oppnå disse resultatene eksperimenterte Amazon Music med flere forskjellige Triton-distribusjonsparametere ved å bruke Triton modellanalysator, et verktøy som hjelper deg med å finne den beste NVIDIA Triton-modellkonfigurasjonen for å distribuere effektiv inferens. For å optimere modellslutninger tilbyr Triton funksjoner som dynamisk batching og samtidig modellutførelse, og har rammeverkstøtte for andre fleksibilitetsmuligheter. Den dynamiske batchingen samler slutningsforespørsler, og grupperer dem sømløst sammen i kohorter for å maksimere gjennomstrømmingen, samtidig som den sikrer sanntidssvar for Amazon Music-brukere. Muligheten for samtidig modellutførelse forbedrer slutningsytelsen ytterligere ved å være vert for flere kopier av modellen på samme GPU. Til slutt, ved å bruke Triton modellanalysator, var Amazon Music i stand til å finjustere den dynamiske batchingen og modellere vertsparametere for samtidighet for å finne optimale innstillinger som maksimerer slutningsytelsen ved bruk av simulert trafikk.

konklusjonen

Optimalisering av konfigurasjoner med Triton Inference Server og TensorRT på SageMaker tillot Amazon Music å oppnå enestående resultater for både trenings- og inferensrørledninger. SageMaker-plattformen er den ende-til-ende åpne plattformen for produksjons-AI, som gir rask tid til verdi og allsidighet for å støtte alle større AI-brukssaker på tvers av både maskinvare og programvare. Ved å optimalisere V100 GPU-utnyttelsen for trening og bytte fra CPUer til G5-instanser ved å bruke NVIDIA A10G Tensor Core GPUer, samt ved å bruke optimalisert NVIDIA-programvare som Triton Inference Server og TensorRT, kan selskaper som Amazon Music spare tid og penger samtidig som de øker ytelsen i både opplæring og slutninger, direkte oversatt til en bedre kundeopplevelse og lavere driftskostnader.

SageMaker håndterer de udifferensierte tunge løftene for ML-trening og hosting, slik at Amazon Music kan levere pålitelige, skalerbare ML-operasjoner på tvers av både maskinvare og programvare.

Vi oppfordrer deg til å sjekke at arbeidsbelastningene dine er optimalisert ved å bruke SageMaker ved alltid å evaluere maskinvare- og programvarevalgene dine for å se om det finnes måter du kan oppnå bedre ytelse med reduserte kostnader på.

For å lære mer om NVIDIA AI i AWS, se følgende:

Om forfatterne

Siddharth Sharma er en maskinlæringsleder hos Science & Modeling-teamet hos Amazon Music. Han spesialiserer seg på søk, henting, rangering og NLP-relaterte modelleringsproblemer. Siddharth har en rik bakgrunn som arbeider med maskinlæringsproblemer i stor skala som er latenssensitive, f.eks. annonsemålretting, multimodal henting, søkeforståelse osv. Før han jobbet hos Amazon Music, jobbet Siddharth i selskaper som Meta, Walmart Labs, Rakuten om e-handelssentriske ML-problemer. Siddharth tilbrakte tidlige deler av sin karriere med å jobbe med bay area ad-tech startups.

Siddharth Sharma er en maskinlæringsleder hos Science & Modeling-teamet hos Amazon Music. Han spesialiserer seg på søk, henting, rangering og NLP-relaterte modelleringsproblemer. Siddharth har en rik bakgrunn som arbeider med maskinlæringsproblemer i stor skala som er latenssensitive, f.eks. annonsemålretting, multimodal henting, søkeforståelse osv. Før han jobbet hos Amazon Music, jobbet Siddharth i selskaper som Meta, Walmart Labs, Rakuten om e-handelssentriske ML-problemer. Siddharth tilbrakte tidlige deler av sin karriere med å jobbe med bay area ad-tech startups.

Tarun Sharma er en programvareutviklingssjef som leder Amazon Music Search Relevance. Teamet hans av forskere og ML-ingeniører er ansvarlige for å gi kontekstuelt relevante og personlige søkeresultater til Amazon Music-kunder.

Tarun Sharma er en programvareutviklingssjef som leder Amazon Music Search Relevance. Teamet hans av forskere og ML-ingeniører er ansvarlige for å gi kontekstuelt relevante og personlige søkeresultater til Amazon Music-kunder.

James Park er løsningsarkitekt hos Amazon Web Services. Han jobber med Amazon.com for å designe, bygge og distribuere teknologiløsninger på AWS, og har en spesiell interesse for AI og maskinlæring. På fritiden liker han å oppsøke nye kulturer, nye opplevelser og holde seg oppdatert med de nyeste teknologitrendene. Du finner ham på Linkedin.

James Park er løsningsarkitekt hos Amazon Web Services. Han jobber med Amazon.com for å designe, bygge og distribuere teknologiløsninger på AWS, og har en spesiell interesse for AI og maskinlæring. På fritiden liker han å oppsøke nye kulturer, nye opplevelser og holde seg oppdatert med de nyeste teknologitrendene. Du finner ham på Linkedin.

Kshitiz Gupta er løsningsarkitekt hos NVIDIA. Han liker å utdanne skykunder om GPU AI-teknologiene NVIDIA har å tilby og hjelpe dem med å akselerere maskinlærings- og dyplæringsapplikasjonene deres. Utenom jobben liker han å løpe, gå på fotturer og se på dyrelivet.

Kshitiz Gupta er løsningsarkitekt hos NVIDIA. Han liker å utdanne skykunder om GPU AI-teknologiene NVIDIA har å tilby og hjelpe dem med å akselerere maskinlærings- og dyplæringsapplikasjonene deres. Utenom jobben liker han å løpe, gå på fotturer og se på dyrelivet.

Jiahong Liu er løsningsarkitekt i Cloud Service Provider-teamet hos NVIDIA. Han hjelper klienter med å ta i bruk maskinlæring og AI-løsninger som utnytter NVIDIA-akselerert databehandling for å møte deres trenings- og slutningsutfordringer. På fritiden liker han origami, DIY-prosjekter og å spille basketball.

Jiahong Liu er løsningsarkitekt i Cloud Service Provider-teamet hos NVIDIA. Han hjelper klienter med å ta i bruk maskinlæring og AI-løsninger som utnytter NVIDIA-akselerert databehandling for å møte deres trenings- og slutningsutfordringer. På fritiden liker han origami, DIY-prosjekter og å spille basketball.

Tugrul Konuk er en senior løsningsarkitekt hos NVIDIA, som spesialiserer seg på opplæring i stor skala, multimodal dyplæring og høyytelses vitenskapelig databehandling. Før NVIDIA jobbet han i energiindustrien, med fokus på å utvikle algoritmer for databehandling. Som en del av doktorgraden jobbet han med fysikkbasert dyp læring for numeriske simuleringer i skala. På fritiden liker han å lese, spille gitar og piano.

Tugrul Konuk er en senior løsningsarkitekt hos NVIDIA, som spesialiserer seg på opplæring i stor skala, multimodal dyplæring og høyytelses vitenskapelig databehandling. Før NVIDIA jobbet han i energiindustrien, med fokus på å utvikle algoritmer for databehandling. Som en del av doktorgraden jobbet han med fysikkbasert dyp læring for numeriske simuleringer i skala. På fritiden liker han å lese, spille gitar og piano.

Rohil Bhargava er en produktmarkedsføringssjef hos NVIDIA, med fokus på å distribuere NVIDIA-applikasjonsrammeverk og SDK-er på spesifikke CSP-plattformer.

Rohil Bhargava er en produktmarkedsføringssjef hos NVIDIA, med fokus på å distribuere NVIDIA-applikasjonsrammeverk og SDK-er på spesifikke CSP-plattformer.

Eliuth Triana Isaza er en Developer Relations Manager hos NVIDIA som gir Amazons AI MLOps, DevOps, Scientists og AWS tekniske eksperter mulighet til å mestre NVIDIA-datamaskinstakken for å akselerere og optimalisere Generative AI Foundation-modeller som spenner fra datakurering, GPU-opplæring, modellslutning og produksjonsdistribusjon på AWS GPU-forekomster . I tillegg er Eliuth en lidenskapelig terrengsyklist, skiløper, tennis- og pokerspiller.

Eliuth Triana Isaza er en Developer Relations Manager hos NVIDIA som gir Amazons AI MLOps, DevOps, Scientists og AWS tekniske eksperter mulighet til å mestre NVIDIA-datamaskinstakken for å akselerere og optimalisere Generative AI Foundation-modeller som spenner fra datakurering, GPU-opplæring, modellslutning og produksjonsdistribusjon på AWS GPU-forekomster . I tillegg er Eliuth en lidenskapelig terrengsyklist, skiløper, tennis- og pokerspiller.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- I stand

- Om oss

- akselerert

- akselerer

- akselerasjon

- adgang

- utrette

- nøyaktighet

- nøyaktig

- Oppnå

- oppnådd

- tvers

- aktiv

- tillegg

- adresse

- vedta

- annonser

- påvirker

- Etter

- AI

- AI-modeller

- ai brukstilfeller

- Album

- algoritmer

- Alle

- tillate

- tillatt

- tillate

- tillater

- også

- alltid

- Amazon

- Amazon Web Services

- Amazon.com

- an

- og

- Søknad

- søknader

- tilnærming

- arkitekter

- ER

- AREA

- områder

- rundt

- artist

- AS

- bistå

- bistår

- At

- gjennomsnittlig

- AWS

- Backend

- Balansere

- balansering

- Bar

- basert

- Baseline

- basketball

- bukt

- BE

- ble

- fordi

- Fordeler

- BEST

- Bedre

- øke

- øker

- både

- bringe

- bred

- bygge

- bygget

- by

- CAN

- evner

- evne

- fangst

- hvilken

- Karriere

- nøye

- saker

- utfordringer

- utfordrende

- Figur

- sjekk

- elsket

- valg

- klienter

- Cloud

- kode

- COM

- Kom

- kommunisere

- Selskaper

- sammenlignet

- beregnings

- databehandling

- samtidig

- Konfigurasjon

- Container

- innhold

- Konvergens

- Kjerne

- Kostnad

- Kostnader

- lage

- kritisk

- avgjørende

- CSP

- konservering

- skikk

- kunde

- kundeopplevelse

- Kunder

- dato

- Dato

- Dager

- redusert

- dyp

- dyp læring

- forsinkelser

- leverer

- levere

- leverer

- Etterspørsel

- utplassere

- utplasserings

- distribusjon

- utforming

- Utvikler

- utvikle

- Utvikling

- forskjellig

- vanskelig

- direkte

- dykk

- diverse

- dIY

- ikke

- drastisk

- under

- dynamisk

- e

- e-handel

- Tidlig

- utdanne

- effektivitet

- effektiv

- innsats

- forhøyet

- embedding

- følelser

- ansette

- myndiggjøring

- aktivert

- oppmuntre

- ende til ende

- energi

- Ingeniører

- Forbedrer

- nok

- sikrer

- spesielt

- etc

- evaluere

- Selv

- Hver

- gjennomføring

- erfaring

- Erfaringer

- eksperter

- FAST

- Egenskaper

- Figur

- Endelig

- Finn

- finne

- Først

- fleksibilitet

- flom

- Fokus

- fokuserte

- fokusering

- etter

- Til

- format

- Fundament

- Rammeverk

- rammer

- fra

- frustrerende

- fullt

- funksjonalitet

- videre

- fusjon

- gateway

- generasjonen

- generative

- Generativ AI

- GPU

- GPU

- Håndterer

- skje

- maskinvare

- Ha

- he

- tung

- tung løfting

- hjelpe

- nyttig

- hjelper

- Høy

- høyt nivå

- høy ytelse

- ham

- hans

- holder

- Hosting

- TIMER

- Hvordan

- Men

- HTML

- HTTPS

- identifisering

- if

- illustrerer

- Imaging

- iverksette

- viktig

- forbedre

- forbedret

- forbedring

- in

- inkluderer

- Øke

- økt

- økende

- industri

- ineffektiv

- påvirke

- Infrastruktur

- innledende

- f.eks

- øyeblikkelig

- i stedet

- interesse

- inn

- introdusere

- innføre

- IT

- DET ER

- reise

- jpg

- bare

- nøkkel

- Type

- Vet

- kjent

- Labs

- Språk

- stor

- storskala

- større

- varig

- Ventetid

- siste

- lag

- føre

- ledende

- LÆRE

- læring

- Leverage

- Bibliotek

- løfte

- i likhet med

- grenser

- laste

- ser

- Lav

- lavere

- maskin

- maskinlæring

- vedlikeholde

- større

- gjøre

- GJØR AT

- leder

- administrerende

- Marketing

- Master

- Maksimer

- Kan..

- Minner

- Minne

- Meta

- Middle

- millioner

- millioner

- millisekunder

- minimal

- feil

- blandet

- ML

- MLOps

- modell

- modellering

- modeller

- Moduler

- penger

- mer

- mest

- fjell

- multi

- flere

- musikk

- må

- navn

- nødvendig

- negativt

- nettverk

- Ny

- nlp

- Nvidia

- of

- tilby

- Tilbud

- on

- ONE

- bare

- åpen

- åpen kildekode

- drift

- operasjonell

- Drift

- optimal

- optimalisering

- Optimalisere

- optimalisert

- optimalisere

- or

- orkestrert

- rekkefølge

- Annen

- ut

- utenfor

- enestående

- enn

- samlet

- egen

- parametere

- del

- Spesielt

- spesielt

- samarbeid

- lidenskapelig

- Topp

- prosent

- ytelse

- personlig

- Personlig

- phd

- rørledning

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- spiller

- spiller

- podcast

- Podcasts

- Point

- poker

- mulig

- Post

- potensiell

- makt

- powered

- Precision

- Før

- Prioriter

- prioritet

- problemer

- prosess

- Produkt

- Produksjon

- prosjekter

- gi

- leverandør

- gir

- gi

- Python

- Rask

- Ranking

- Lesning

- sanntids

- redusere

- referere

- i slekt

- relasjoner

- relevans

- relevant

- pålitelig

- forespørsler

- Krever

- Ressurser

- svar

- ansvar

- ansvarlig

- responsive

- resulterende

- Resultater

- Rich

- ikke sant

- rennende

- går

- runtime

- sagemaker

- samme

- Spar

- besparende

- skalerbar

- Skala

- Vitenskap

- vitenskapelig

- forskere

- SDK

- sdks

- sømløst

- Søk

- søk

- søker

- Sekund

- seksjoner

- se

- søker

- tilsynelatende

- semantikk

- senior

- sensitive

- dømme

- betjene

- server

- tjeneste

- Tjenesteyter

- Tjenester

- servering

- sett

- innstillinger

- flere

- Del

- delt

- Viser

- signifikant

- betydelig

- Enkelt

- sitter

- Størrelse

- størrelser

- Smart

- Software

- programvareutvikling

- løsning

- Solutions

- sang

- kilde

- Spenning

- spesialisert

- spesialisert

- spesifikk

- fart

- TRYLLEFORMEL

- staving

- brukt

- stable

- Start

- startups

- blir

- jevn

- Trinn

- Steps

- Story

- streaming

- slik

- overlegen

- støtte

- Støttes

- sikker

- tatt

- ta

- rettet mot

- lag

- tech

- Teknisk

- teknikk

- teknikker

- Technologies

- Teknologi

- tekst

- Det

- De

- deres

- Dem

- Der.

- derfor

- Disse

- de

- ting

- denne

- Gjennom

- gjennomstrømning

- tid

- ganger

- Tittel

- til

- sammen

- tokenization

- tokens

- tok

- verktøy

- topp

- tps

- trafikk

- Tog

- trent

- Kurs

- transformator

- Trender

- Triton

- sant

- to

- forståelse

- utvilsomt

- Universe

- opplåsing

- avduket

- us

- bruke

- brukt

- Brukere

- bruker

- ved hjelp av

- utnytte

- verdi

- enorme

- allsidighet

- veldig

- venter

- gå

- Walmart

- var

- se

- måter

- we

- web

- webtjenester

- VI VIL

- var

- når

- mens

- mens

- vil

- med

- Arbeid

- arbeidet

- arbeid

- virker

- verden

- bekymring

- ennå

- ga

- Du

- Din

- zephyrnet