Introduksjon

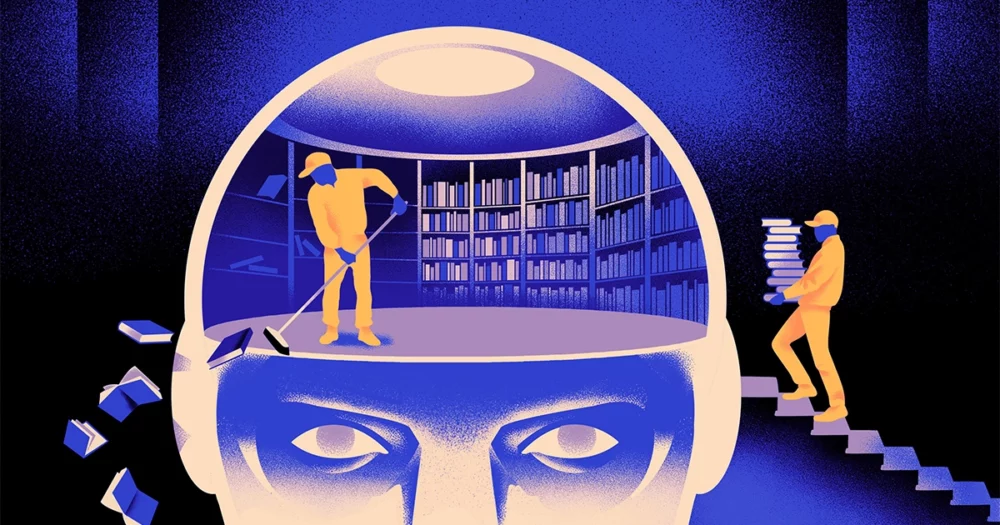

Et team av informatikere har opprettet en smidigere, mer fleksibel type av maskinlæringsmodell. Trikset: Den må med jevne mellomrom glemme det den vet. Og selv om denne nye tilnærmingen ikke vil fortrenge de enorme modellene som ligger bak de største appene, kan den avsløre mer om hvordan disse programmene forstår språk.

Den nye forskningen markerer "et betydelig fremskritt på feltet," sa Jea Kwon, en AI-ingeniør ved Institute for Basic Science i Sør-Korea.

AI-språkmotorene som brukes i dag, drives for det meste av kunstige nevrale nettverk. Hvert "nevron" i nettverket er en matematisk funksjon som mottar signaler fra andre slike nevroner, kjører noen beregninger og sender signaler videre gjennom flere lag med nevroner. Til å begynne med er informasjonsflyten mer eller mindre tilfeldig, men gjennom trening forbedres informasjonsflyten mellom nevronene ettersom nettverket tilpasser seg treningsdataene. Hvis en AI-forsker ønsker å lage en tospråklig modell, for eksempel, vil hun trene modellen med en stor haug med tekst fra begge språk, som vil justere forbindelsene mellom nevroner på en slik måte at teksten relateres til ett språk med tilsvarende ord i den andre.

Men denne treningsprosessen krever mye datakraft. Hvis modellen ikke fungerer veldig bra, eller hvis brukerens behov endres senere, er det vanskelig å tilpasse den. "Si at du har en modell som har 100 språk, men forestill deg at ett språk du ønsker ikke er dekket," sa Mikel Artetxe, en medforfatter av den nye forskningen og grunnlegger av AI-oppstarten Reka. "Du kan starte på nytt fra bunnen av, men det er ikke ideelt."

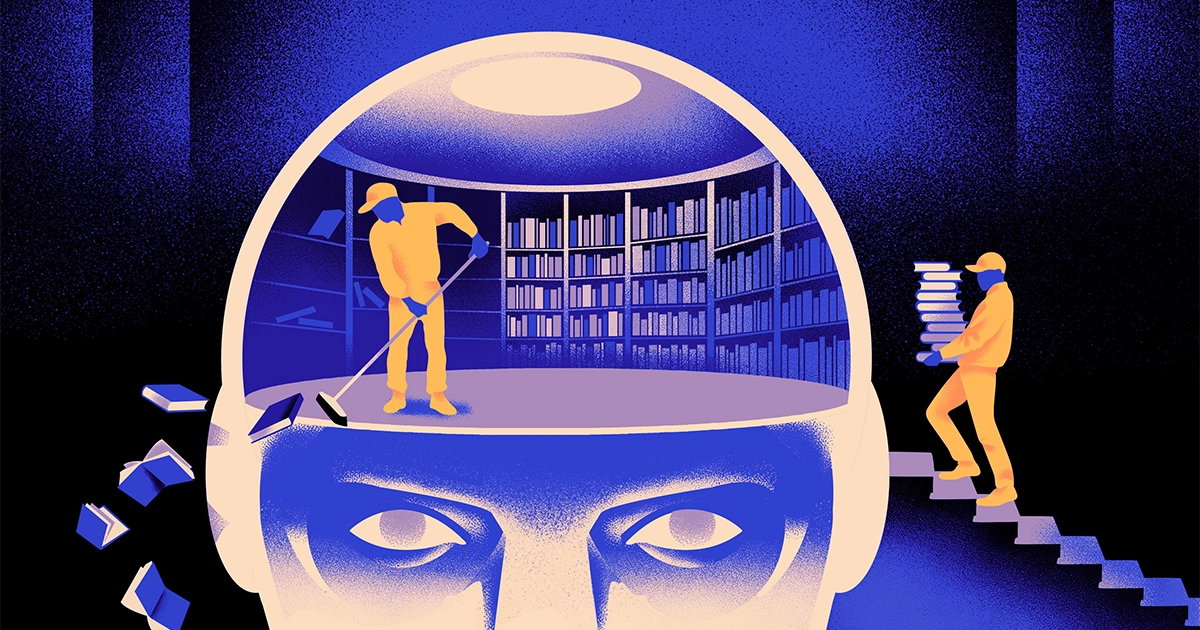

Artetxe og hans kolleger har forsøkt å omgå disse begrensningene. For noen år siden, Artetxe og andre trente et nevralt nettverk på ett språk, og slettet deretter det det visste om byggesteinene til ord, kalt tokens. Disse lagres i det første laget av det nevrale nettverket, kalt embedding-laget. De lot alle de andre lagene av modellen være i fred. Etter å ha slettet tokens til det første språket, omskolerte de modellen til det andre språket, som fylte innebyggingslaget med nye tokens fra det språket.

Selv om modellen inneholdt feilaktig informasjon, fungerte omskoleringen: Modellen kunne lære og bearbeide det nye språket. Forskerne antok at mens det innebygde laget lagret informasjon spesifikk for ordene som ble brukt i språket, lagret de dypere nivåene i nettverket mer abstrakt informasjon om konseptene bak menneskelige språk, som deretter hjalp modellen med å lære det andre språket.

«Vi lever i samme verden. Vi konseptualiserer de samme tingene med forskjellige ord" på forskjellige språk, sa Yihong Chen, hovedforfatteren av den nylige artikkelen. "Det er derfor du har det samme resonnementet på høyt nivå i modellen. Et eple er noe søtt og saftig, i stedet for bare et ord.»

Introduksjon

Selv om denne glemmetilnærmingen var en effektiv måte å legge til et nytt språk til en allerede opplært modell, var omskoleringen fortsatt krevende – den krevde mye språklige data og prosessorkraft. Chen foreslo en tilpasning: I stedet for å trene, slette det innebygde laget og deretter trene på nytt, bør de med jevne mellomrom tilbakestille innebyggingslaget under den første runden med trening. "Ved å gjøre dette, blir hele modellen vant til å tilbakestille," sa Artetxe. "Det betyr at når du vil utvide modellen til et annet språk, er det enklere, fordi det er det du har gjort."

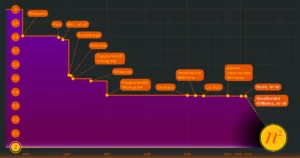

Forskerne tok en vanlig brukt språkmodell kalt Roberta, trent den ved å bruke deres periodiske glemmeteknikk, og sammenlignet den med samme modells ytelse da den ble trent med standard, ikke-forglemmelig tilnærming. Glemmemodellen gjorde det litt dårligere enn den konvensjonelle, og fikk en poengsum på 85.1 sammenlignet med 86.1 på ett vanlig mål for språknøyaktighet. Deretter omskolerte de modellene på andre språk, ved å bruke mye mindre datasett på bare 5 millioner tokens, i stedet for de 70 milliardene de brukte under den første treningen. Nøyaktigheten til standardmodellen falt til 53.3 i gjennomsnitt, men glemmemodellen falt bare til 62.7.

Glemmemodellen klarte seg også mye bedre hvis teamet påla beregningsgrenser under omskolering. Da forskerne kuttet treningslengden fra 125,000 5,000 skritt til bare 57.8, sank nøyaktigheten til glemmemodellen til 37.2 i gjennomsnitt, mens standardmodellen stupte til XNUMX, som ikke er bedre enn tilfeldige gjetninger.

Introduksjon

Teamet konkluderte med at periodisk glemsel ser ut til å gjøre modellen bedre til å lære språk generelt. "Fordi [de] fortsetter å glemme og lære på nytt under trening, blir det lettere å lære nettverket noe nytt senere," sa Evgenii Nikishin, en forsker ved Mila, et forskningssenter for dyp læring i Quebec. Det antyder at når språkmodeller forstår et språk, gjør de det på et dypere nivå enn bare betydningen av individuelle ord.

Tilnærmingen ligner på hvordan vår egen hjerne fungerer. «Menneskets hukommelse generelt er ikke særlig flink til å lagre store mengder detaljert informasjon nøyaktig. I stedet har mennesker en tendens til å huske kjernen av opplevelsene våre, abstrahere og ekstrapolere," sa Benjamin Levy, en nevroforsker ved University of San Francisco. "Å aktivere AI med mer menneskelignende prosesser, som adaptiv glemsel, er en måte å få dem til mer fleksibel ytelse."

I tillegg til hva det kan si om hvordan forståelse fungerer, håper Artetxe at mer fleksible å glemme språkmodeller også kan bidra til å bringe de siste AI-gjennombruddene til flere språk. Selv om AI-modeller er gode til å håndtere spansk og engelsk, to språk med rikelig med opplæringsmateriell, er modellene ikke så gode med hans hjemland baskisk, det lokale språket som er spesifikt for det nordøstlige Spania. "De fleste modellene fra store teknologiselskaper gjør det ikke bra," sa han. "Å tilpasse eksisterende modeller til baskisk er veien å gå."

Chen ser også frem til en verden hvor flere AI-blomster blomstrer. «Jeg tenker på en situasjon der verden ikke trenger én stor språkmodell. Vi har så mange, sa hun. «Hvis det er en fabrikk som lager språkmodeller, trenger du denne typen teknologi. Den har én basismodell som raskt kan tilpasse seg nye domener.»

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- : har

- :er

- :ikke

- :hvor

- ][s

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Om oss

- ABSTRACT

- nøyaktighet

- nøyaktig

- tilpasse

- adaptive

- tilpasser

- legge til

- tillegg

- avansere

- Etter

- AI

- AI-modeller

- Alle

- alene

- allerede

- også

- beløp

- an

- og

- En annen

- eple

- tilnærming

- apps

- ER

- AS

- At

- forfatter

- gjennomsnittlig

- basen

- grunnleggende

- fordi

- blir

- vært

- bak

- Bedre

- mellom

- Stor

- stor teknikk

- Biggest

- Milliarder

- Blocks

- Bloom

- både

- gjennombrudd

- bringe

- Bygning

- men

- by

- beregninger

- som heter

- CAN

- sentrum

- endring

- chen

- omgå

- Medforfatter

- kollegaer

- Felles

- vanligvis

- Selskaper

- sammenlignet

- beregnings

- datamaskin

- databehandling

- databehandlingskraft

- konsepter

- konkluderte

- Tilkoblinger

- inneholdt

- konvensjonell

- kunne

- dekket

- skape

- opprettet

- Kutt

- dato

- datasett

- redusert

- dyp

- dyp læring

- dypere

- krevende

- detaljert

- gJORDE

- forskjellig

- do

- ikke

- gjør

- domener

- ikke

- droppet

- under

- hver enkelt

- enklere

- Effektiv

- embedding

- ingeniør

- Motorer

- Engelsk

- Hele

- Tilsvarende

- eksempel

- eksisterende

- Erfaringer

- utvide

- fabrikk

- Noen få

- felt

- fylt

- Først

- fleksibel

- flyten

- Til

- Forward

- Grunnleggeren

- Francisco

- fra

- funksjon

- general

- generelt

- få

- GitHub

- Go

- god

- Håndtering

- Hard

- Ha

- he

- hjelpe

- hjulpet

- høyt nivå

- hans

- håper

- Hvordan

- HTTPS

- stort

- menneskelig

- menneskelig

- Mennesker

- ideell

- if

- forestille

- pålagt

- forbedrer

- in

- individuelt

- informasjon

- innledende

- i utgangspunktet

- i stedet

- Institute

- IT

- bare

- Hold

- Type

- vet

- korea

- Språk

- språk

- stor

- seinere

- siste

- lag

- lag

- føre

- LÆRE

- læring

- venstre

- Lengde

- mindre

- Nivå

- nivåer

- i likhet med

- begrensninger

- grenser

- leve

- lokal

- UTSEENDE

- Lot

- maskin

- maskinlæring

- magazine

- gjøre

- Making

- mange

- materialer

- matematiske

- betydninger

- midler

- måle

- Minne

- kunne

- millioner

- modell

- modeller

- mer

- for det meste

- mye

- flere

- må

- innfødt

- Trenger

- behov

- nettverk

- nevrale

- nevrale nettverket

- Nerveceller

- Ny

- Nei.

- of

- on

- ONE

- bare

- or

- Annen

- andre

- vår

- enn

- egen

- Papir

- ytelse

- periodisk

- plato

- Platon Data Intelligence

- PlatonData

- stupte

- makt

- powered

- prosess

- Prosesser

- prosessering

- Behandlingseffekt

- programmer

- Quantamagazin

- Quebec

- raskt

- tilfeldig

- heller

- mottar

- mottak

- nylig

- husker

- påkrevd

- forskning

- forsker

- forskere

- avsløre

- runde

- går

- Sa

- samme

- San

- San Fransisco

- sier

- Vitenskap

- forskere

- Resultat

- skraper

- Sekund

- synes

- selektiv

- sender

- sett

- hun

- bør

- signaler

- signifikant

- lignende

- situasjon

- mindre

- So

- noen

- noe

- Sør

- Sør-Korea

- Spania

- Spansk

- spesifikk

- Standard

- Begynn

- oppstart

- Steps

- Still

- lagret

- lagring

- slik

- foreslår

- søt

- tar

- Undervisning

- lag

- tech

- tech selskaper

- teknikk

- Teknologi

- tendens

- tekst

- enn

- Det

- De

- informasjonen

- verden

- deres

- Dem

- deretter

- Disse

- de

- ting

- tenker

- denne

- selv om?

- Gjennom

- til

- i dag

- tokens

- tok

- Tog

- trent

- Kurs

- trick

- prøvd

- tweak

- to

- forstå

- forståelse

- universitet

- bruke

- brukt

- ved hjelp av

- veldig

- ønsker

- ønsker

- var

- Vei..

- we

- webp

- VI VIL

- Hva

- når

- hvilken

- mens

- hvorfor

- med

- ord

- ord

- Arbeid

- arbeidet

- virker

- verden

- verre

- ville

- år

- Du

- zephyrnet