I en stadig mer datasentrisk verden må bedrifter fokusere på å samle både verdifull fysisk informasjon og generere informasjonen de trenger, men som ikke enkelt kan fange opp. Datatilgang, regulering og overholdelse er en økende kilde til friksjon for innovasjon innen analyse og kunstig intelligens (AI).

For høyt regulerte sektorer som finanstjenester, helsevesen, biovitenskap, bilindustri, robotikk og produksjon, er problemet enda større. Det forårsaker barrierer for systemdesign, datadeling (internt og eksternt), inntektsgenerering, analyser og maskinlæring (ML).

Syntetiske data er et verktøy som håndterer mange datautfordringer, spesielt AI og analyseproblemer som personvern, regeloverholdelse, tilgjengelighet, dataknapphet og skjevhet. Dette inkluderer også datadeling og tid til data (og derfor tid til marked).

Syntetiske data genereres algoritmisk. Den speiler statistiske egenskaper og mønstre fra kildedataene. Men viktigst av alt inneholder den ingen sensitive, private eller personlige datapunkter.

Du stiller spørsmål til de syntetiske dataene og får de samme svarene som du ville fått fra de virkelige dataene.

I vår tidligere innlegg, vi demonstrerte hvordan man kan bruke motstridende nettverk som Generative Adversarial Networks (GANS) for å generere tabellformede datasett for å forbedre opplæring i kredittsvindelmodeller.

For at forretningsinteressenter skal ta i bruk syntetiske data for sine ML- og analyseprosjekter, er det viktig å ikke bare sørge for at de genererte syntetiske dataene passer til formålet og de forventede nedstrømsapplikasjonene, men også for at de skal kunne måle og demonstrere kvaliteten på de genererte dataene.

Med økende juridiske og etiske forpliktelser for å bevare personvernet, er en av syntetiske datas styrker evnen til å fjerne sensitiv og original informasjon under syntesen. Derfor, i tillegg til kvalitet, trenger vi beregninger for å evaluere risikoen for privat informasjonslekkasje, hvis noen, og vurdere at generasjonsprosessen ikke "minner" eller kopierer noen av de originale dataene.

For å oppnå alt dette kan vi kartlegge kvaliteten på syntetiske data i dimensjoner, som hjelper brukerne, interessentene og oss til å bedre forstå de genererte dataene.

De tre dimensjonene ved evaluering av syntetisk datakvalitet

De syntetiske dataene som genereres måles mot tre nøkkeldimensjoner:

- Fidelity

- Utility

- Privatliv

Dette er noen av spørsmålene om genererte syntetiske data som bør besvares av en kvalitetsrapport for syntetiske data:

- Hvor lik er disse syntetiske dataene sammenlignet med det originale treningssettet?

- Hvor nyttig er disse syntetiske dataene for nedstrømsapplikasjonene våre?

- Har noen informasjon blitt lekket fra de originale treningsdataene til de syntetiske dataene?

- Har noen data som anses som sensitive i den virkelige verden (fra andre datasett som ikke brukes til å trene modellen) utilsiktet syntetisert av modellen vår?

Beregningene som oversetter hver av disse dimensjonene for sluttbrukerne er noe fleksible. Tross alt kan dataene som skal genereres variere når det gjelder distribusjoner, størrelse og atferd. De skal også være lette å forstå og tolke.

Til syvende og sist må beregningene være fullstendig datadrevne og ikke kreve noen forkunnskaper eller domenespesifikk informasjon. Men hvis brukeren ønsker å bruke spesifikke regler og begrensninger som gjelder for et spesifikt forretningsdomene, bør de kunne definere dem under synteseprosessen for å sikre at den domenespesifikke troskapen oppfylles.

Vi ser på hver av disse beregningene mer detaljert i de følgende avsnittene.

Beregninger for å forstå troskap

I ethvert datavitenskapelig prosjekt må vi forstå om en bestemt utvalgspopulasjon er relevant for problemet vi løser. Tilsvarende, for prosessen med å vurdere relevansen til de syntetiske dataene som genereres, må vi evaluere den i form av fidelity sammenlignet med originalen.

Visuelle representasjoner av disse beregningene gjør dem lettere å forstå. Vi kunne illustrere om kardinaliteten og forholdet mellom kategorier ble respektert, korrelasjonene mellom de forskjellige variablene ble holdt, og så videre.

Visualisering av dataene hjelper ikke bare med å evaluere kvaliteten på de syntetiske dataene, men passer også inn som et av de første trinnene i datavitenskapens livssyklus for en bedre forståelse av dataene.

La oss dykke inn i noen troskapsberegninger mer detaljert.

Utforskende statistiske sammenligninger

Innenfor de utforskende statistiske sammenligningene utforskes funksjonene til de originale og syntetiske datasettene ved å bruke viktige statistiske mål, slik som gjennomsnitt, median, standardavvik, distinkte verdier, manglende verdier, minima, maksima, kvartilområder for kontinuerlige funksjoner og antall. av poster per kategori, manglende verdier per kategori og de fleste forekommende tegn for kategoriske attributter.

Denne sammenligningen bør utføres mellom det originale hold-out-datasettet og de syntetiske dataene. Denne evalueringen vil avsløre om datasettene som sammenlignes er statistisk like. Hvis de ikke er det, vil vi ha en forståelse av hvilke funksjoner og tiltak som er forskjellige. Du bør vurdere å omskolere og regenerere de syntetiske dataene med forskjellige parametere hvis det er en betydelig forskjell.

Denne testen fungerer som en innledende screening for å sikre at de syntetiske dataene har rimelig troskap til det originale datasettet og kan derfor med fordel gjennomgå mer strenge tester.

Histogram likhetscore

Histogrammets likhetspoeng måler hver funksjons marginale fordelinger av de syntetiske og originale datasettene.

Likhetsskåren er avgrenset mellom null og én, med en poengsum på én som indikerer at de syntetiske datadistribusjonene perfekt overlapper distribusjonene til de originale dataene.

En poengsum nær én vil gi brukerne tillit til at holdout-datasettet og det syntetiske datasettet er statistisk like.

Gjensidig informasjonspoeng

Den gjensidige informasjonspoengsummen måler den gjensidige avhengigheten av to funksjoner, numeriske eller kategoriske, og indikerer hvor mye informasjon som kan fås fra en funksjon ved å observere en annen.

Gjensidig informasjon kan måle ikke-lineære relasjoner, noe som gir en mer omfattende forståelse av den syntetiske datakvaliteten ettersom den lar oss forstå omfanget av variabelens relasjonsbevaring.

En poengsum på én indikerer at den gjensidige avhengigheten mellom funksjoner har blitt perfekt fanget i de syntetiske dataene.

Korrelasjonsscore

Korrelasjonsskåren måler hvor godt korrelasjonene i det originale datasettet har blitt fanget opp i de syntetiske dataene.

Korrelasjoner mellom to eller flere kolonner er ekstremt viktig for ML-applikasjoner, som hjelper til med å avdekke forhold mellom funksjoner og målvariabelen og bidrar til å skape en godt trent modell.

Korrelasjonsskåren er avgrenset mellom null og én, med en poengsum på én som indikerer at korrelasjonene er perfekt matchet.

I motsetning til strukturerte tabelldata, som vi ofte møter i dataproblemer, har noen typer strukturerte data en spesiell oppførsel der tidligere observasjoner har en sannsynlighet for å påvirke følgende observasjon. Disse er kjent som tidsserier eller sekvensielle data – for eksempel et datasett med timemålinger av romtemperatur.

Denne oppførselen betyr at det er et krav om å definere visse beregninger som spesifikt kan måle kvaliteten på disse tidsseriedatasettene

Autokorrelasjon og partiell autokorrelasjonsscore

Selv om autokorrelasjon ligner på korrelasjon, viser autokorrelasjon forholdet til en tidsserie ved nåverdien i forhold til dens tidligere verdier. Fjerning av effektene av forrige tidsforsinkelser gir delvis autokorrelasjon. Derfor måler autokorrelasjonspoengsummen hvor godt de syntetiske dataene har fanget opp de signifikante autokorrelasjonene, eller delvise korrelasjonene, fra det originale datasettet.

Beregninger for å forstå nytten

Nå kan vi statistisk ha innsett at de syntetiske dataene ligner det originale datasettet. I tillegg må vi også vurdere hvor godt det syntetiserte datasettet klarer vanlige datavitenskapelige problemer når de trenes på flere ML-algoritmer.

Bruk følgende verktøyet målinger, tar vi sikte på å bygge tillit til at vi faktisk kan oppnå ytelse på nedstrømsapplikasjoner angående hvordan de opprinnelige dataene har prestert.

Prediksjonspoeng

Måling av ytelsen til syntetiske data sammenlignet med de originale virkelige dataene kan gjøres gjennom ML-modeller. Nedstrømsmodellpoengsummen fanger opp kvaliteten på de syntetiske dataene ved å sammenligne ytelsen til ML-modeller som er trent på både de syntetiske og originale datasettene og validert på tilbakeholdte testdata fra det originale datasettet. Dette gir en Tren Synthetic Test Real (TSTR) poengsum og en Train Real Test Real (TRTR) poengsum.

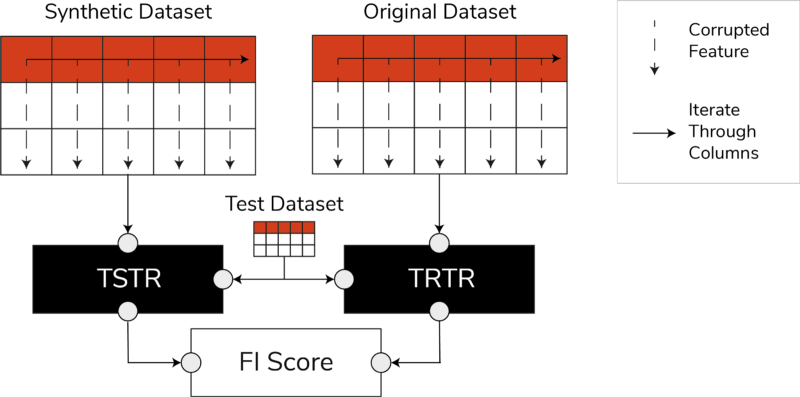

TSTR, TRTR-poeng og funksjonens betydningspoeng (bilde av forfatter)

Poengsummen inneholder et bredt spekter av de mest pålitelige ML-algoritmene for enten regresjons- eller klassifiseringsoppgaver. Bruk av flere klassifikatorer og regressorer sørger for at poengsummen er mer generaliserbar på tvers av de fleste algoritmer, slik at de syntetiske dataene kan anses som nyttige i fremtiden.

Til slutt, hvis TSTR-poengsum og TRTR-poengsum er sammenlignbare, indikerer dette at de syntetiske dataene har kvaliteten som skal brukes til å trene effektive ML-modeller for virkelige applikasjoner.

Poengsum for funksjonens betydning

Svært relatert til prediksjonsskåren, utvider funksjonens betydning (FI) poengsummen ved å legge til tolkbarhet til TSTR- og TRTR-skårene.

F1-poengsummen sammenligner endringene og stabiliteten til funksjonens viktighetsrekkefølge oppnådd med prediksjonspoengsummen. Et syntetisk sett med data anses å være av høy nytte hvis det gir samme rekkefølge av funksjonsviktighet som de originale virkelige dataene.

QScore

For å være sikker på at en modell som er trent på våre nylig genererte data kommer til å gi de samme svarene på de samme spørsmålene som en modell som er trent med de originale dataene, bruker vi Qscore. Dette måler nedstrømsytelsen til de syntetiske dataene ved å kjøre mange tilfeldige aggregeringsbaserte spørringer på både de syntetiske og originale (og holdout) datasettene.

Tanken her er at begge disse spørringene skal gi lignende resultater.

En høy QScore sørger for at nedstrømsapplikasjoner som bruker spørrings- og aggregeringsoperasjoner kan gi nesten lik verdi som det originale datasettet.

Beregninger for å forstå personvern

Med privatliv forskrifter som allerede er på plass, er det en etisk forpliktelse og et lovkrav å sørge for at sensitiv informasjon er beskyttet.

Før disse syntetiske dataene kan deles fritt og brukes til nedstrømsapplikasjoner, må vi vurdere personvernberegningene som kan hjelpe interessenten til å forstå hvor de genererte syntetiske dataene står sammenlignet med de originale dataene når det gjelder omfanget av lekket informasjon. Dessuten må vi ta kritiske beslutninger om hvordan de syntetiske dataene kan deles og brukes.

Nøyaktig kampscore

En direkte og intuitiv evaluering av personvern er å se etter kopier av de virkelige dataene blant de syntetiske postene. Den nøyaktige matchpoengsummen teller antall reelle rekorder som kan finnes blant det syntetiske settet.

Poengsummen skal være null, og angir at ingen reell informasjon er tilstede som den er i de syntetiske dataene. Denne beregningen fungerer som en screeningsmekanisme før vi evaluerer ytterligere personvernberegninger.

Naboers personvernscore

Videre måler naboenes personvernscore forholdet mellom syntetiske poster som kan være for nære i likhet med de ekte. Dette betyr at selv om de ikke er direkte kopier, er de potensielle punkter for personvernlekkasje og en kilde til nyttig informasjon for slutningsangrep.

Poengsummen beregnes ved å utføre et høydimensjonalt søk etter nærmeste nabo på de syntetiske dataene overlappet med de originale dataene.

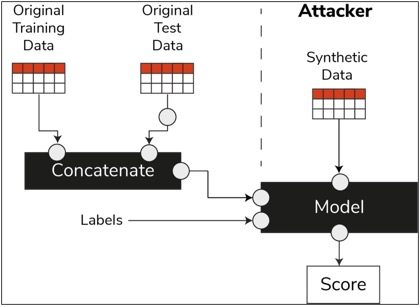

Medlemskapsslutningsscore

I datavitenskapens livssyklus, når en modell er trent, trenger den ikke lenger tilgang til treningsprøvene og kan gi spådommer om usynlige data. Tilsvarende, i vårt tilfelle, når synthesizer-modellen er trent, kan prøver av syntetiske data genereres uten behov for originaldata.

Gjennom en type angrep kalt "medlemsslutningsangrep", kan angripere forsøke å avsløre dataene som ble brukt til å lage de syntetiske dataene, uten å ha tilgang til de originale dataene. Dette resulterer i et kompromittering av personvernet.

Medlemskapsslutningsscore måler sannsynligheten for at et medlemsslutningsangrep blir vellykket.

En lav poengsum antyder muligheten for å konkludere at en bestemt post var medlem av opplæringsdatasettet som førte til opprettelsen av de syntetiske dataene. Med andre ord kan angrepene utlede detaljer om en individuell post, og dermed kompromittere personvernet.

En høy medlemsslutningsscore indikerer at en angriper neppe vil avgjøre om en bestemt post var en del av det opprinnelige datasettet som ble brukt til å lage de syntetiske dataene. Dette betyr også at ingen persons informasjon ble kompromittert gjennom de syntetiske dataene.

Holdout-konseptet

En viktig beste praksis som vi må følge, er å sørge for at de syntetiske dataene er generelle nok og ikke passer for de originale dataene de ble trent på. I en typisk datavitenskapelig flyt, mens vi bygger ML-modeller som en Random Forest-klassifisering, setter vi til side testdata, trener modellene ved å bruke treningsdataene og evaluerer beregningene på usett testdata.

På samme måte, for syntetiske data, holder vi til side et utvalg av de originale dataene – vanligvis referert til som et hold-out-datasett eller usett tilbakeholdt testdata – og evaluerer de genererte syntetiske dataene mot hold-out-datasettet.

Holdout-datasettet forventes å være en representasjon av de opprinnelige dataene, men ikke sett da de syntetiske dataene ble generert. Derfor er det viktig å ha lignende poengsum for alle beregningene når du sammenligner originalen med holdouten og de syntetiske datasettene.

Når lignende poengsummer oppnås, kan vi fastslå at de syntetiske datapunktene ikke er et resultat av memorering av de originale datapunktene, samtidig som vi bevarer den samme nøyaktigheten og nytten.

Avsluttende tanker

Verden begynner å forstå den strategiske betydningen av syntetiske data. Som dataforskere og datageneratorer er det vår plikt å bygge tillit til de syntetiske dataene vi genererer og sørge for at de har et formål.

Syntetiske data utvikler seg til å bli et must-have i utviklingsverktøysettet for datavitenskap. MIT Technology Review har bemerket syntetiske data som en av banebrytende teknologier i 2022. Vi kan ikke forestille oss å bygge AI-modeller med utmerket verdi uten syntetiske data, hevder Gartner.

Ifølge McKinsey, syntetiske data minimerer kostnader og barrierer som du ellers ville ha når du utvikler algoritmer eller får tilgang til data.

Generering av syntetiske data handler om å kjenne nedstrømsapplikasjonene og forstå avveiningene mellom de ulike dimensjonene for kvaliteten på syntetiske data.

Oppsummering

Som bruker av de syntetiske dataene er det viktig å definere konteksten for brukstilfellet som hvert utvalg av syntetiske stoffer skal brukes til i fremtiden. Akkurat som med reelle data, er kvaliteten på de syntetiske dataene avhengig av den tiltenkte brukssaken, samt parametrene som er valgt for syntetisering.

For eksempel er det nyttig å beholde uteliggere i de syntetiske dataene som i de originale dataene for bruk av svindeloppdagelse. Det er imidlertid ikke nyttig i et helsevesen med personvernhensyn, ettersom avvikere generelt kan være informasjonslekkasje.

Dessuten eksisterer det en avveining mellom troskap, nytte og personvern. Data kan ikke optimaliseres for alle tre samtidig. Disse beregningene gjør det mulig for interessentene å prioritere hva som er essensielt for hver brukssituasjon og administrere forventninger fra de genererte syntetiske dataene.

Til syvende og sist, når vi ser verdiene til hver beregning og når de oppfyller forventningene, kan interessenter være trygge på løsningene de bygger ved hjelp av syntetiske data.

Brukstilfellene for strukturerte syntetiske data dekker et bredt spekter av applikasjoner fra testdata for programvareutvikling til å lage syntetiske kontrollarmer i kliniske studier.

Ta ut en hånd for å utforske disse mulighetene eller bygg en PoC for å demonstrere verdien.

Faris Haddad er Data & Insights Lead i AABG Strategic Pursuits-teamet. Han hjelper bedrifter med å bli datadrevne.

Faris Haddad er Data & Insights Lead i AABG Strategic Pursuits-teamet. Han hjelper bedrifter med å bli datadrevne.

- Avansert (300)

- AI

- ai kunst

- ai art generator

- du har en robot

- Amazon maskinlæring

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- AWS maskinlæring

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- Teknisk fremgangsmåte

- zephyrnet