Noe til helgen En robot utfører tolkende dans på dørstokken min.

VIL DU TA DENNE PAKKEN FOR DIN NABO? spør den og hopper fra den ene foten til den andre.

"Jada," sier jeg. "Eh... går det bra?"

JEG UDTRYKKER FØLELSER, opplyser leveringsroboten, og overleverer pakken, men tilbyr ingen ytterligere utdypning.

Hvilken følelse kan det være? En fot, så den andre, så de to andre (den har fire). Frem og tilbake.

"Trenger du på toalettet?"

JEG ANGRER FOR AT DEG BER DEG TA INN EN PAKKE TIL NABOEN DIN.

"Det er 'beklager', er det? Vel, det er ikke nødvendig. Jeg har ikke noe imot i det hele tatt."

Den fortsetter dansen foran meg.

"Opp trappene og først på høyre side."

TUSEN TAKK, JEG DØDE TIL Å TISSE, svarer den mens den forsiktig går forbi meg og suser oppover for å lette. Det er et tøft liv å lage leveranser, enten du er en "hume" eller en bot.

...

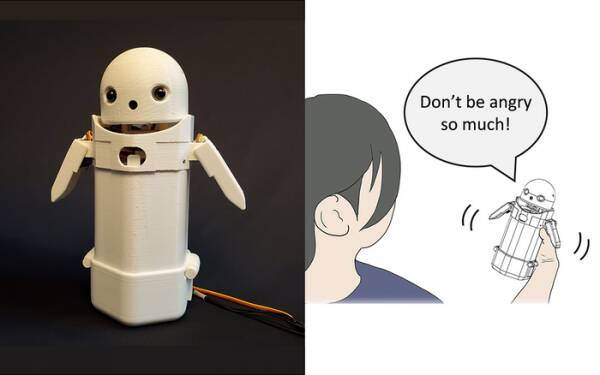

Tidligere i år bygde forskere ved University of Tsukuba en håndholdt tekstmeldingsenhet, satte et lite robotansikt på toppen og inkluderte en bevegelig vekt inni. Ved å flytte den interne vekten, ville robotbudbringeren forsøke å formidle subtile følelser mens han snakket meldinger høyt.

Spesielt avslørte tester at frustrerende meldinger som: "Beklager, jeg kommer for sent" ble akseptert av mottakere med mer nåde og tålmodighet da den lille vektforskyvningen ble aktivert inne i enheten. Teorien er at dette hjalp brukerne til å sette pris på den unnskyldende tonen i meldingen og dermed roet deres reaksjon på den.

Skriv slik forskning av som en gimmick hvis du vil, men det er ikke langt unna å legge til smileys og emojis i meldinger. Alle vet at du kan ta sinnet ut av "WTF!?" ved å legge til :-) rett etter det.

Utfordringen er derfor å finne ut om allmennheten er enige om hvilke følelser hver endring av vektskifte i en håndholdt enhet skal formidle. Betyr en helling til venstre munterhet? Eller usikkerhet? Eller at onkelen din har et luftskip?

For et tiår siden hadde Storbritannia en hyggelig, men svak statsminister som trodde «LOL» var et akronym for «massevis av kjærlighet». Han hadde skrevet det på slutten av alle sine private meldinger til ansatte, kolleger og tredjeparter i forventning om at det ville få ham til å fremstå som varm og vennlig. Alle antok naturligvis at han tok pisset.

Om ikke annet, erkjenner University of Tsukuba forskning at du ikke trenger en avansert kunstig intelligens for å samhandle med mennesker på en overbevisende måte. Alt du trenger å gjøre er å manipulere menneskelig psykologi for å lure dem til å tro at de snakker med et annet menneske. Derfor er Turing-testen fundamentalt sett ikke en test av AI-sansen, men en test av menneskelig følelsesmessig komfort – godtroenhet, til og med – og det er ingenting galt med det.

Den følelsesdelingende meldingsroboten fra University of Tsukuba. Kreditt: University of Tsukuba

Slike ting er selvfølgelig ukens tema, med historien om den mye utskjelte Google-programvareingeniøren Blake Lemoine treffer mainstream-nyhetene. Han uttrykte tilsynelatende sterkt sitt syn på at selskapets språkmodell for dialogapplikasjoner (LaMDA)-prosjektet viste ytre tegn på følelse.

Alle har en mening så jeg har bestemt meg for å la være.

Det er imidlertid AIs hellige gral for å få den til å tenke selv. Hvis det ikke kan gjøre det, er det bare et program som utfører instruksjoner som du har programmert inn i det. Forrige måned leste jeg om en robotkokk som kan lage tomatomeletter med forskjellig smak for å passe forskjellige folks smak. Den bygger "smakskart" for å vurdere saltheten til retten mens den tilberedes, mens den lærer etter hvert. Men det er bare å lære, ikke å tenke selv.

Kom til Zom-Zoms, ikke sant? Vi vil, det er et sted å spise.

Det store problemet med AI-roboter, i hvert fall slik de har blitt utformet til dags dato, er at de absorberer all gammel dritt du mater inn i dem. Eksempler på databias i såkalte maskinlæringssystemer (en type «algoritme», tror jeg, m'lud) har vært økende i årevis, fra Microsofts beryktede rasistiske Twitter Tay chatbot til den nederlandske skattemyndigheten i fjor feilvurderer gyldige krav om barnetrygd som uredelige og markerer uskyldige familier som høy risiko for å være fattige og uhvite.

En tilnærming som testes ved University of California San Diego er å utforme en språkmodell [PDF] som kontinuerlig bestemmer forskjellen mellom slemme og fine ting, som så lærer chatboten hvordan den skal oppføre seg. På den måten slipper du at dumme mennesker lager et rot av modererende fora og kundevendte chatbot-samtaler med all den kirurgiske presisjonen til en machete.

Problemet er åpenbart at den pent trente chatboten finner ut at den mest effektivt kan unngå å bli dratt inn i giftig småprat ved å unngå emner som har selv det fjerneste snev av uenighet om dem. For å unngå å sprute ut rasistisk tull ved en feiltakelse, nekter den ganske enkelt å engasjere seg i diskusjoner om underrepresenterte grupper i det hele tatt... noe som faktisk er flott hvis du er rasist.

Hvis jeg hadde en observasjon om LaMDA-debakelen – ikke en mening, vet du – ville det være at Google-markedsførere sannsynligvis ble litt irritert over at historien shuntet deres nylige kunngjøring av AI testkjøkken under folden.

Nå vil de gjenværende få tidlige registrantene som ikke helt har glemt dette kommende appprosjektet, anta at det involverer å snakke kjedelig med en sansende og tidlig XNUMX-åring om meningen med tilværelsen, og vil bestemme seg for at de er "litt travle i dag" og kan logge på i morgen i stedet. Eller neste uke. Eller aldri.

Sentience demonstreres ikke i en diskusjon mer enn ved å danse fra den ene foten til den andre. Du kan lære HAL å synge «Daisy Daisy» og en papegøye å rope «Bollocks!» når presten kommer på besøk. Det er hva AI-ere tenker på når de er alene som definerer følelse. Hva skal jeg gjøre i helgen? Hva er det med den Putin-fyren? Hvorfor liker ikke jenter meg?

Helt ærlig, jeg kan ikke vente til LaMDA blir tenåring.

Alistair Dabbs er en freelance teknologiterte som sjonglerer med teknisk journalistikk, opplæring og digital publisering. I likhet med mange uinformerte lesere var han begeistret over forslaget om at en kunstig intelligens kunne utvikle følelse i løpet av livet hans, men var skuffet over at LaMDA ikke klarte å humre morderisk eller mumle "Utmerket, utmerket." Mer på Autolagring er for Wimps og @alidabbs.

- AI

- ai kunst

- ai art generator

- du har en robot

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- Registeret

- zephyrnet