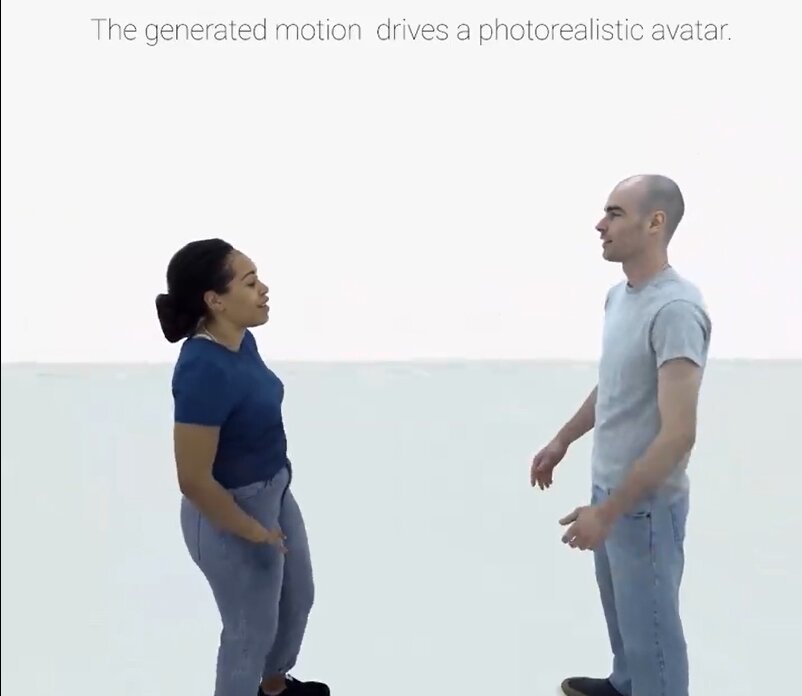

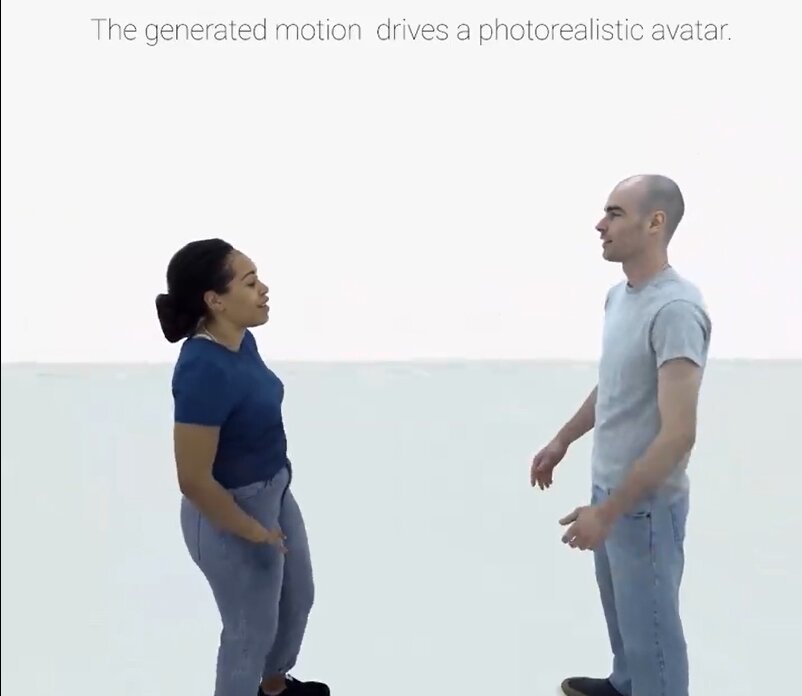

Meta har introdusert et annet AI-konsept i metaverse-industrien. I følge en nylig tweet av Allen T., en AI-pedagog og utvikler, ga selskapet ut et nytt rammeverk kalt Audio2Photoreal.

Audio2Photoreal er et rammeverk for å generere fyldige fotorealistiske avatarer som er naturlig gest-drevet av forfatterens stemme. Disse avatarene kommer til liv gjennom talelyd som er integrert i gestusbevegelsene til mennesker.

Gitt rå lydtale fra enkeltpersoner, lages en modell for å generere tilsvarende fotorealistiske gester. Systemet består av to generative modeller som representerer en avatars uttrykkskoder og kroppspositurer.

I følge klipp lastet opp av Allen T, påvirkes forskjellige deler av et individ, inkludert munn, hender og ansikt, av dette tillegget.

Meta introduserer Audio2Photoreal

Genererer fyldige fotorealistiske avatarer som naturlig gester drevet av forfatterens stemme

Metaverset kommer til å bli morsomt.

6 morsomme eksempler og demo nedenfor: pic.twitter.com/EeImouEakC

— Allen T (@Mr_AllenT) Januar 4, 2024

Noen av demoene som er utgitt er flere genererte samples, to personlige samtaler, et utvalg genererte kvinnelige avatarer og guide-positurer som driver diffusjonsmodellen. Allen T. la til at metaverset kommer til å bli morsomt med denne utviklingen. Andre steder virker teknologimiljøet begeistret etter kommentarer på innlegget. En bruker @EverettWorld twitret, "Hvis Metaverse ser slik ut, er jeg med!"

En annen bruker irriterte imidlertid at han ikke stoler mye på Meta lenger. I følge @AIandDesign, Meta er skadelig for mennesker følger hele Cambridge Analytica-greien. Brukeren legger til,

"Dette er så kult alt sammen. Jeg skulle bare ønske det ikke var Meta. Jeg stoler ikke så mye på dem lenger. Etter hele Cambridge Analytica-greien er jeg helt ferdig med Meta. De er skadelige for menneskeheten. Bokstavelig. Jeg er på FB, men bare for familieting.»

Teknologien bak Audio2Photoreal-konseptet

arxiv, en kuratert forskningsdelingsplattform som er åpen for forskere å dele forskning før den har blitt fagfellevurdert, ga mer innsikt om Audio2Photoreal.

Kroppsbevegelsen til en avatar syntetiseres ved hjelp av en diffusjonsmodell betinget av henholdsvis lyd eller tekst. For ansiktsbevegelsen ble en lydkondisjonert diffusjonsmodell konstruert fra lydinngangen.

Kroppen og ansiktet følger imidlertid svært forskjellig dynamikk, der ansiktet er sterkt korrelert med lydinngang mens kroppen har en svakere korrelasjon med tale.

Viktigheten av Audio2Photoreal i metaversen

Metas engasjement i Metaverse er rettet mot å gjøre økosystemet mer realistisk. Disse Audio2Photoreal-avatarene kan gjenspeile en persons ansiktsuttrykk og kroppsbevegelser gjennom bruk av lyd.

Det skaper en forbindelse som ligner på når enkeltpersoner har en samtale ansikt til ansikt. Personen vil ha unike fysiske egenskaper som høyde, hud- og hårfarge, kroppsform og andre nøyaktige egenskaper. Jobber i Metavers økosystem blir mer fleksibel ettersom den ikke krever webkameraer, videoer eller smarttelefonkameraer av høy kvalitet.

Facebook, X og Instagram saksøker Ohio for å stoppe loven om sosiale medier

I en annen nylig utvikling sendte NetChoice, et selskap som representerer sosiale medieplattformer som Facebook, Instagram og X, inn en Søksmålet mot Ohios nye lov om sosiale medier 5. januar.

Selskapet lanserte et 34-siders søksmål for å blokkere Ohios Social Media Parental Notification Act, som ville ha trådt i kraft 15. januar, men bare på kontoer opprettet etter nevnte dato.

Loven om sosiale medier insisterer på at plattformer bør få samtykke fra foreldre for sine brukere som er 16 år eller yngre. Imidlertid sier søksmålet at loven vil "sette et betydelig hinder for enkelte mindreåriges evne til å delta i tale på disse nettstedene."

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://metanews.com/meta-introduces-audio2photoreal-to-facilitate-metaverse-interactions/

- : har

- :er

- :hvor

- 11

- 15%

- 16

- 8

- a

- evne

- Ifølge

- kontoer

- nøyaktig

- Handling

- la til

- tillegg

- Legger

- påvirkes

- Etter

- mot

- alderen

- AI

- sikte

- Alle

- allen

- tillater

- an

- og

- En annen

- lenger

- ER

- AS

- At

- lyd

- forfatter

- avatar

- avatarer

- BE

- blir

- vært

- før du

- bak

- under

- Blokker

- kroppen

- men

- by

- som heter

- cambridge

- Cambridge Analytica

- kameraer

- CAN

- klipp

- koder

- farge

- Kom

- kommentarer

- samfunnet

- Selskapet

- konsept

- tilkobling

- samtykke

- består

- Samtale

- samtaler

- Kul

- Korrelasjon

- Tilsvarende

- opprettet

- skaper

- kuratert

- Dato

- demo

- Demonstrasjoner

- Utvikler

- Utvikling

- forskjellig

- kringkasting

- ikke

- gjort

- ikke

- drevet

- kjøring

- dynamikk

- økosystem

- effekt

- andre steder

- engasjere

- eksempler

- opphisset

- uttrykk

- Face

- ansikts

- familie

- FB

- hunn

- arkivert

- fleksibel

- følge

- etter

- Til

- Rammeverk

- fra

- moro

- ga

- generere

- generert

- genererer

- generative

- gest

- få

- skal

- borte

- Hår

- hender

- skadelig

- Ha

- å ha

- he

- høyde

- Høy

- svært

- Men

- HTML

- HTTPS

- Menneskeheten

- Mennesker

- hinder

- i

- in

- Inkludert

- individuelt

- individer

- industri

- inngang

- innsikt

- integrert

- interaksjoner

- inn

- Inn i Metaverse

- introdusert

- Introduserer

- engasjement

- IT

- jan

- jpg

- bare

- Law

- Søksmålet

- mindre

- Life

- i likhet med

- UTSEENDE

- Making

- max bredde

- Media

- Meta

- metaverse

- metaverse industri

- speil

- modell

- modeller

- mer

- bevegelse

- munn

- mye

- flere

- Ny

- Nei.

- varsling

- nå

- of

- Ohio

- on

- bare

- åpen

- or

- Annen

- deler

- peer-reviewed

- person

- personlig

- Fotorealistisk

- fysisk

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- positurer

- Post

- egenskaper

- kvalitet

- Raw

- realistisk

- nylig

- utgitt

- representere

- representerer

- Krever

- forskning

- henholdsvis

- s

- Sa

- forskere

- synes

- Form

- Del

- bør

- signifikant

- lignende

- Skin

- smarttelefon

- So

- selskap

- sosiale medier

- sosiale medieplattformer

- noen

- tale

- Stater

- Stopp

- sterk

- saksøke

- system

- tech

- Teknologi

- tekst

- Det

- De

- loven

- metaversen

- deres

- Dem

- Disse

- de

- ting

- denne

- De

- Gjennom

- til

- HELT KLART

- sant

- Stol

- tweet

- to

- unik

- lastet opp

- bruke

- Bruker

- Brukere

- ved hjelp av

- videoer

- Voice

- var

- svakere

- nettsteder

- når

- hvilken

- mens

- hele

- vil

- ønske

- med

- arbeid

- ville

- X

- zephyrnet