Å plukke ut separate objekter i en visuell scene virker intuitivt for oss, men maskiner sliter med denne oppgaven. Nå har en ny AI-modell fra Meta utviklet en bred idé om hva et objekt er, slik at det kan skille ut objekter selv om det aldri har sett dem før.

Det kan virke som en ganske prosaisk datasynsoppgave, men å kunne analysere et bilde og finne ut hvor ett objekt slutter og et annet begynner er en ganske grunnleggende ferdighet, uten hvilken en rekke mer kompliserte oppgaver ville være uløselige.

"Objektsegmentering" er ikke noe nytt; AI-forskere har jobbet med det i årevis. Men typisk har det vært en tidkrevende prosess å bygge disse modellene som krever mye menneskelig merknad av bilder og betydelige dataressurser. Og typisk var de resulterende modellene svært spesialiserte til spesielle brukstilfeller.

Nå har forskere ved Meta imidlertid avduket Segment Anything Model (SAM), som er i stand til å kutte ut ethvert objekt i en hvilken som helst scene, uavhengig av om den har sett noe lignende før. Modellen kan også gjøre dette som svar på en rekke forskjellige spørsmål, fra tekstbeskrivelse til museklikk eller til og med øyesporingsdata.

"SAM har lært en generell oppfatning av hva objekter er, og den kan generere masker for ethvert objekt i et hvilket som helst bilde eller hvilken som helst video," skrev forskerne i en blogg poste. "Vi tror mulighetene er brede, og vi er begeistret over de mange potensielle brukstilfellene vi ikke engang har forestilt oss ennå."

Nøkkelen til utviklingen av modellen var et massivt nytt datasett med 1.1 milliarder segmenteringsmasker, som refererer til områder av et bilde som har blitt isolert og kommentert for å angi at de inneholder et bestemt objekt. Den ble laget gjennom en kombinasjon av manuell menneskelig merknad av bilder og automatiserte prosesser, og er den desidert største samlingen av denne typen som er satt sammen til dags dato.

Ved å trene på et så massivt datasett, sier Metas forskere at de har utviklet et generelt konsept for hva et objekt er, som lar det segmentere ting det ikke en gang har sett før. Denne evnen til å generalisere førte til at forskerne kalte SAM en "grunnmodell", en kontroversielt begrep brukes til å beskrive andre massive forhåndstrente modeller som f.eks OpenAIs GPT serien, hvis evner visstnok er så generelle at de kan brukes som grunnlag for en rekke applikasjoner.

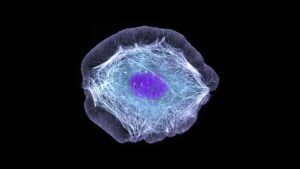

Bildesegmentering er definitivt en nøkkelingrediens i et bredt spekter av datasynsoppgaver. Hvis du ikke kan skille ut de forskjellige komponentene i en scene, er det vanskelig å gjøre noe mer komplisert med det. I bloggen deres sier forskerne at det kan vise seg å være uvurderlig i video- og bilderedigering, eller hjelpe med analyse av vitenskapelige bilder.

Kanskje mer relevant for selskapets metaverse ambisjoner, gir de en demo av hvordan det kan brukes sammen med et virtual reality-headset for å velge spesifikke objekter basert på brukerens blikk. De sier også at det potensielt kan kobles sammen med en stor språkmodell for å lage et multimodalt system som kan forstå både det visuelle og tekstlige innholdet på en nettside.

Evnen til å håndtere et bredt spekter av spørsmål gjør systemet spesielt fleksibelt. I en nettside ved å demonstrere den nye modellen viser selskapet at etter å ha analysert et bilde kan det bli bedt om å skille ut spesifikke objekter ved å klikke på dem med en musepeker, skrive inn hva det er du vil segmentere, eller bare dele opp hele bildet i separate objekter.

Og viktigst av alt er at selskapet åpner både modellen og datasettet for forskningsformål slik at andre kan bygge videre på arbeidet deres. Dette er den samme tilnærmingen selskapet tok med sin LLaMA-storspråklige modell, som førte til at den raskt ble det lekket ut online og ansporing a bølge av eksperimentering av hobbyister og hackere.

Hvorvidt det samme vil skje med SAM gjenstår å se, men uansett er det en gave til AI-forskningsmiljøet som kan akselerere fremgangen på en rekke viktige datasynsproblemer.

Bilde Credit: Meta AI

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://singularityhub.com/2023/04/10/metas-new-ai-can-identify-and-remove-objects-in-images/

- :er

- $OPP

- 1

- a

- evne

- I stand

- akselerere

- Etter

- AI

- ai forskning

- tillate

- tillater

- ambisjoner

- analyse

- analyserer

- og

- En annen

- søknader

- tilnærming

- ER

- AS

- montert

- At

- Automatisert

- basert

- BE

- før du

- være

- tro

- Milliarder

- Blogg

- Breaking

- bred

- bygge

- Bygning

- by

- CAN

- evner

- saker

- samling

- kombinasjon

- samfunnet

- Selskapet

- Selskapets

- komplisert

- komponenter

- datamaskin

- Datamaskin syn

- databehandling

- konsept

- betydelig

- inneholde

- innhold

- kunne

- skape

- opprettet

- kreditt

- Kutt

- dato

- Dato

- avtale

- helt sikkert

- beskrive

- beskrivelse

- utviklet

- Utvikling

- forskjellig

- enten

- slutter

- Hele

- Selv

- opphisset

- ganske

- fleksibel

- Til

- Foundations

- fra

- fundamental

- general

- generere

- gave

- hackere

- skje

- Hard

- Ha

- Headset

- hjelpe

- svært

- vert

- Hvordan

- HTTPS

- menneskelig

- Tanken

- bilde

- bilder

- viktig

- in

- intuitiv

- uvurderlig

- isolert

- IT

- DET ER

- nøkkel

- Språk

- stor

- største

- lært

- Led

- i likhet med

- Llama

- maskiner

- GJØR AT

- håndbok

- mange

- masker

- massive

- Meta

- metaverse

- kunne

- modell

- modeller

- mer

- mest

- Ny

- Forestilling

- objekt

- gjenstander

- of

- on

- ONE

- Annen

- andre

- side

- sammen

- Spesielt

- spesielt

- plukke

- plato

- Platon Data Intelligence

- PlatonData

- muligheter

- potensiell

- potensielt

- pen

- problemer

- prosess

- Prosesser

- Progress

- Bevis

- gi

- formål

- område

- raskt

- Reality

- refererer

- Uansett

- regioner

- forblir

- forskning

- forskere

- Ressurser

- svar

- resulterende

- Sam

- samme

- scene

- vitenskapelig

- synes

- segmentet

- segmentering

- separat

- Serien

- Viser

- ganske enkelt

- ferdighet

- So

- spesialisert

- spesifikk

- Struggle

- slik

- system

- Oppgave

- oppgaver

- Det

- De

- deres

- Dem

- Disse

- ting

- Gjennom

- tidkrevende

- til

- Kurs

- typisk

- forstå

- avduket

- us

- bruke

- variasjon

- video

- virtuelle

- Virtuell virkelighet

- syn

- Vei..

- web

- Hva

- om

- hvilken

- bred

- Bred rekkevidde

- vil

- med

- uten

- Arbeid

- trene

- arbeidet

- ville

- år

- Du

- zephyrnet