GTC Nvidias etterlengtede Hopper H100-akseleratorer vil begynne å sendes senere neste måned i OEM-bygde HGX-systemer, sa silisiumgiganten på sin GPU Technology Conference (GTC)-arrangement i dag.

De som venter på å få tak i Nvidias DGX H100-systemer vil imidlertid måtte vente til en gang i Q1 neste år. DGX er Nvidias linje med arbeidsstasjoner og servere som bruker sine GPUer og sammenkoblinger, og HGX-systemer er partnerlagde servere igjen som bruker Nvs teknologi.

Og mens Nvidia hyper sin Hopper-arkitektur i datasenteret, vil det meste av bedriftssettet som ble annonsert denne uken ikke få brikkegigantens flaggskiparkitektur med det første.

På kanten ser det ut til at Nvidia er fornøyd med å få et fullt liv fra sin Ampere-arkitektur.

I dag detaljerte Nvidia neste generasjons edge AI og robotikkplattformen den kaller IGX.

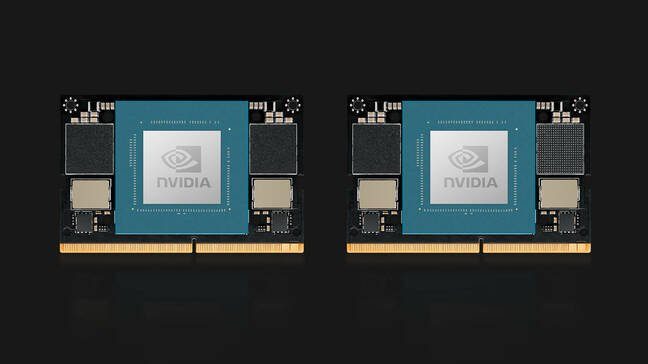

Nvidias IGX-plattform er et systemkort i full størrelse bygget rundt et Orin Industrial-system på modul

IGX er en "alt-i-ett-databehandlingsplattform for å akselerere utrullingen av sanntids intelligente maskiner og medisinsk utstyr," sa Kimberly Powell, veep of healthcare hos Nvidia. I kjernen er systemet i hovedsak en utvidet versjon av Nvidias tidligere annonserte Jetson AGX Orin-modul, kunngjorde dette vår.

"IGX er et komplett system med Nvidia Orin-robotikkprosessoren, Ampere tensor-core GPU, ConnectX streaming I/O-prosessor, en funksjonell sikkerhetsøy og sikkerhetsmikrokontroller-enhet fordi flere og flere roboter og mennesker vil jobbe i samme miljø ", la hun til.

Når det gjelder ytelse, er det ikke mye nytt her. Vi blir fortalt at plattformen er basert på et Orin industrielt system på modul med 64 GB minne som kan sammenlignes i ytelse med AGX Orin-modulen som ble lansert tidligere i år. Dette systemet inneholdt 32 GB minne, en octacore Arm Cortex A78AE CPU og Ampere-basert GPU.

IGX får en integrert ConnectX-7 NIC for høyhastighetstilkobling ved hjelp av to 200 Gbps-grensesnitt. Brettet ser også ut til å ha et komplett komplement av M.2-lagring, PCIe-spor og minst ett eldre PCI-spor for utvidelse.

Nvidia sikter IGX-plattformen mot en rekke avanserte AI- og robotikkbrukstilfeller innen helsevesen, produksjon og logistikk, der konfidensialitet eller latens gjør mer sentraliserte systemer upraktiske.

I likhet med AGX Orin, er systemet komplimentert av Nvidias AI Enterprise-programvarepakke og Fleet Command-plattform for distribusjon og administrasjon.

En av de første applikasjonene til IGX-plattformen vil være å bruke Nvidias bildeplattform for robotikk.

"Nvidia Clara Holoscan er vårt applikasjonsrammeverk som ligger på toppen av IGX for medisinsk utstyr og bildebehandlingsrobotikkrørledninger," forklarte Powell.

Tre leverandører av medisinsk utstyr – Activ Surgical, Moon Surgical og Proximinie – planlegger å bruke IGX og Clara Holoscan til å drive sine kirurgiske robotikk og telepresence-plattformer. IGX Orin-utviklersett er planlagt å sende tidlig neste år med produksjonssystemer tilgjengelig fra ADLink, Advantech, Dedicated Computing, Kontron, MBX og Onyx for å nevne en håndfull.

Når det gjelder Orin, avduket Nvidia også sine Jetson Orin Nano-databehandlingsmoduler. Orin Nano er tilgjengelig i to konfigurasjoner ved lansering, inkludert en 8GB-versjon som kan 40 TOPS av AI-inferencing og en cut-down versjon med 4GB minne som kan 20 TOPS.

Som tidligere Jetson-moduler, bruker Orin Nano en pin-kompatibel kantkontakt som minner om den som brukes for bærbar SODIMM-minne og bruker mellom 5W og 15W avhengig av applikasjon og SKU. Nvidias Jetson Orin Nano-moduler er tilgjengelige i januar fra $199.

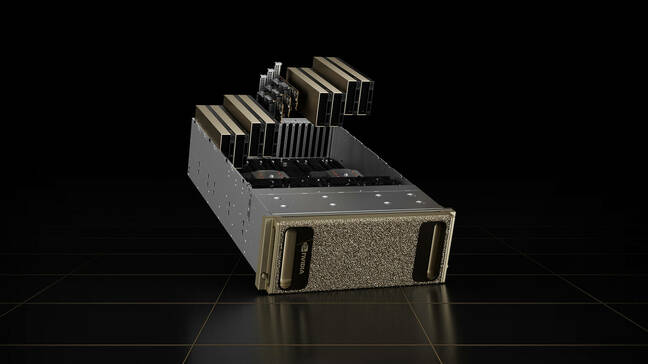

En OVX-oppdatering

Nvidias OVX-servere, som er designet for å kjøre Omniverse-plattformen, vil heller ikke kjøre på Hopper.

Selskapets andre generasjons visualisering og digitale tvillingsystemer er i stedet utstyrt med åtte L40 GPUer. Kortene er basert på selskapets neste generasjons Ada Lovelace-arkitektur og inneholder Nvidias tredje generasjons strålesporingskjerner og fjerde generasjons Tensor Cores.

GPUene er ledsaget av et par Ice Lake Intel Xeon Platinum 8362 CPUer, for totalt 128 prosessortråder på opptil 3.6 GHz.

Datasystemet er ledsaget av tre ConnectX-7 NIC-er, hver med 400 Gbps gjennomstrømning og 16 TB NVMe-lagring. Mens systemet er tilgjengelig som individuelle noder, ser Nvidia for seg at systemet blir distribuert som en del av det det kaller en OVX SuperPod, som inkluderer 32 systemer koblet sammen med selskapets 51.2 Tbps Spectrum-3-svitsjer.

Andregenerasjonssystemene vil være tilgjengelige fra Lenovo, Supermicro og Inspur fra 2023. I fremtiden planlegger Nvidia å utvide tilgjengeligheten av systemene til flere partnere.

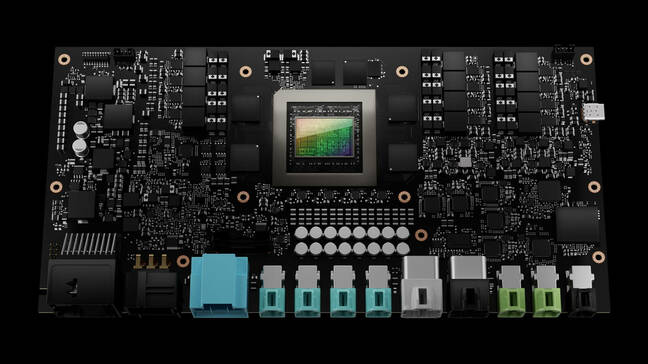

Hoppet opp på Drive Thor

Den eneste delen av settet som ble annonsert på GTC denne uken som får Nvidias Hopper-arkitektur er Drive Thors autonome kjøretøydatasystem.

Drive Thor erstatter Nvidias Atlan-plattform på sitt veikart for 2025 og lover å levere 2,000 TOPS av slutningsytelse når den lanseres.

"Drive Thor kommer fullpakket med banebrytende funksjoner introdusert i vår Grace CPU, vår Hopper GPU og vår neste generasjons GPU-arkitektur," fortalte Danny Shapiro, VP for Automotive i Nvidia, på en pressekonferanse. Han sa at Drive Thor er designet for å forene litanien av datasystemer som driver moderne biler til en enkelt sentralisert plattform.

"Se på dagens avanserte førerassistansesystemer - parkering, førerovervåking, kameraspeil, digital instrumentklynge, infotainmentsystemer - de er alle på forskjellige datamaskiner fordelt over hele kjøretøyet," sa han. «I 2025 vil imidlertid disse funksjonene ikke lenger være separate datamaskiner. Snarere vil Drive Thor gjøre det mulig for produsenter å effektivt konsolidere disse funksjonene i ett enkelt system."

For å takle all informasjon som strømmer fra bilsensorer, har brikken multi-compute-domene-isolasjon, som Nvidia sier lar brikken kjøre samtidige kritiske prosesser uten avbrudd.

Teknologien lar også brikken kjøre flere operativsystemer samtidig for å passe de forskjellige kjøretøyapplikasjonene. For eksempel kan bilens kjerneoperativsystem kjøre på Linux, mens infotainmentsystemet kan kjøre QNX eller Android.

Det er imidlertid ukjent når vi kan få se teknologien i aksjon. Som det står, er alle tre av Nvidias lanseringspartnere – Zeekr, Xpeng og QCraft – basert i Kina. ®

- AI

- ai kunst

- ai art generator

- du har en robot

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- blockchain

- blockchain konferanse ai

- coingenius

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- syntaks

- Registeret

- zephyrnet