Da Google annonserte sin kvantedatamaskin hadde løst et problem utover evne til den kraftigste superdatamaskinen, det var et landemerke for industrien. Men kinesiske forskere har nå vist at de kunne løse samme problem på en vanlig superdatamaskin på bare sekunder.

Det ultimate løftet om kvante databehandling is dens evne å utføre visse beregningsprestasjoner langt raskere enn klassiske maskiner, eller til og med løse problemer som i hovedsak ville være umulig å knekke ved bruk av tradisjonelle tilnærminger.

Feltet er imidlertid fortsatt begynt, og dagens enheter er alt for små til å bli satt i gang med noen virkelige utfordringer. Men i et forsøk på å bevise at feltet gjør fremskritt, har utviklere av kvanteprosessorer vært ivrige etter å finne problemer som kanskje ikke har så mye praktisk nytte, men som kan demonstrere de potensielle speedupene deres teknologi er i stand til.

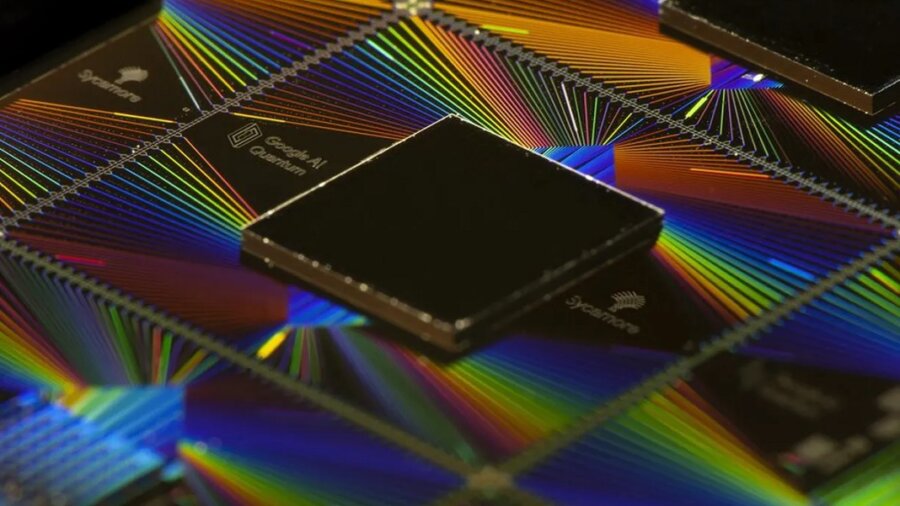

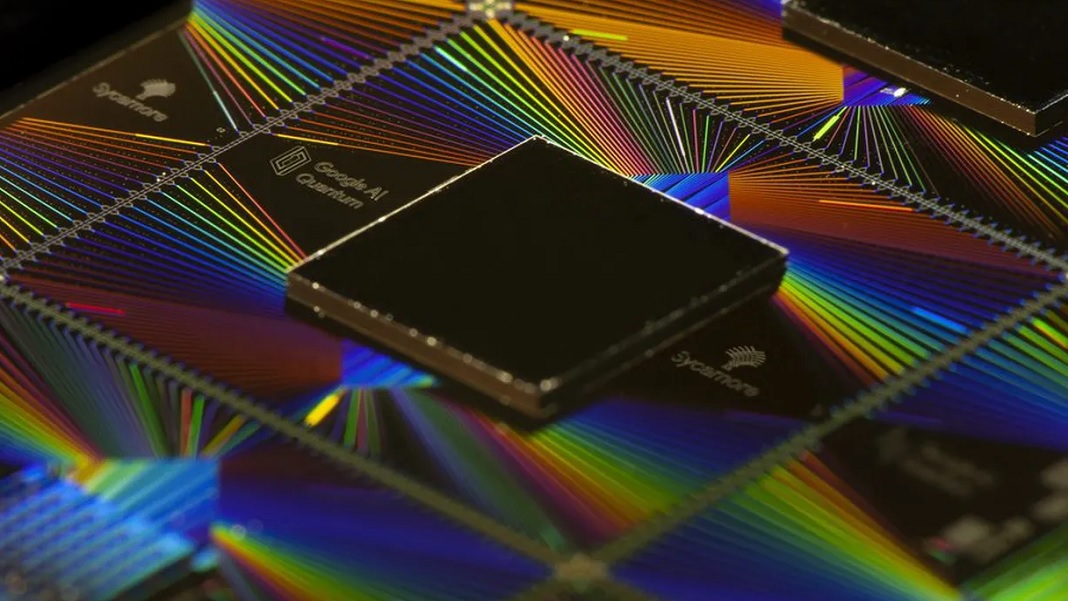

Google gjorde et stort gjennombrudd på denne fronten i 2019 da det hevdet at det Sycamore-prosessor hadde løst et problem som ville ta en superdatamaskin 10,000 200 år på bare XNUMX sekunder. Problemet ble rigget til deres favør, ettersom det i hovedsak innebar simulering av prosessorens utgang, men ved å vise at en klassisk datamaskin ville slite var de i stand til å kreve "kvanteoverlegenhet", mer kjent som "kvantefordeler" i dag.

Men nå forskere i Chinjeg har løste det samme problemet på bare 15 timer bruker ssmart algoritmisk design og en moderat stor datamaskin. Ifølge deres beregninger ville det bare tatt noen få dusin sekunder hvis de hadde tilgang til superdatamaskiner i full størrelse.

Utfordringen Google hadde satt var å simulere prosessoren som fungerer mer eller mindre som en tilfeldig tallgenerator. Den eneste forskjellen var at de gjentok algoritmen millioner av ganger, og på grunn av algoritmens natur skulle det dukke opp et visst mønster i de tilfeldige tallene som spyttes ut.

Å simulere dette på en klassisk datamaskin bør fort bli vanskelig ettersom størrelsen på prosessoren øker, fordi mengden informasjon som kodes øker eksponentielt for hver ekstra qubit. Ved å bruke konvensjonelle tilnærminger for å løse dette problemet, spådde Google at det ville ta 10,000 53 år å simulere sin XNUMX-qubit-prosessor.

Teamet fra Institute of Theoretical Physics ved det kinesiske vitenskapsakademiet fikk arunde dette ved å omarbeide den underliggende matematikken som ble brukt for å løse problemet. De representerte prosessoren som et 3D-nettverk av matematiske objekter kalt tensorer som representerer de logiske portene mellom de 53 qubitene. Dette nettverket ble gjentatt over 20 lag, designet for å representere de 20 syklusene kvantealgoritmen går gjennom før prosessorens utdata leses.

Fordelen med å bruke tensorer er at GPU-er, brikkene som har drevet dyplæringsrevolusjonen, er i stand til å behandle dem veldig raskt parallelt. Forskerne utnyttet også det faktum at Googles beregninger på Sycamore ikke var særlig presise, og oppnådde en troskap på bare 0.2 prosent. Dette tillot dem å ofre noe av nøyaktigheten til simuleringen for å øke hastigheten, noe de gjorde ved å fjerne noen av forbindelsene mellom qubits.

Resultatet var at de klarte å simulere output fra Sycamore-prosessoren til en fidelity på 0.37 prosent på bare 15 timer på 512 GPUer – betraktelig mindre prosessorkraft enn de fleste ledende superdatamaskiner. En artikkel som skisserer resultatene er for tiden i trykken kl Physical Review Letters, men en ikke-fellevurderinged pre-print ble utgitt i november i fjor.

Mens resultatet noe sprenger Googles kvanteoverlegenhetsboble, i en e-post til Vitenskap, påpekte selskapet at det hadde spådd klassiske algoritmer ville forbedre seg i 2019-artikkelen. Men de legger til at de ikke tror de vil være i stand til å holde tritt med den eksponentielle økningen i ytelsen til kvantedatamaskiner lenge.

det er ikke det eneste kvanteoverlegenhetseksperimentet som ble angret. I 2020, en kineser lag hevdet at et problem deres kvantedatamaskin kunne løse på 200 sekundernds ville ta en superdatamaskin 2.5 milliarder år, men i januar viste forskere at det faktisk bare ville ta 73 dager.

Selv om dette ikke motvirker fremskrittet som gjøres på feltet, sier et voksende kor av forskere at det å sette kvantemaskiner og klassiske maskiner opp mot hverandre på denne typen abstrakte beregningsproblemer ikke egentlig gir en klar følelse av hvor teknologien er. at.

Den virkelige testen, sier de, vil være når kvantedatamaskiner er i stand til å løse virkelige problemer raskere og mer effektivt enn klassiske. Og det virker som det fortsatt kan være et stykke unna.

Bildekreditt: Google

- AI

- ai kunst

- ai art generator

- du har en robot

- kunstig intelligens

- sertifisering av kunstig intelligens

- kunstig intelligens i bankvirksomhet

- kunstig intelligens robot

- kunstig intelligens roboter

- programvare for kunstig intelligens

- blockchain

- blockchain konferanse ai

- coingenius

- databehandling

- samtale kunstig intelligens

- kryptokonferanse ai

- dall sin

- dyp læring

- google det

- maskinlæring

- plato

- plato ai

- Platon Data Intelligence

- Platon spill

- PlatonData

- platogaming

- skala ai

- Singularity Hub

- syntaks

- temaer

- zephyrnet