Introduksjon

I maskinlæring er avveiningen mellom skjevhet og varians et grunnleggende konsept som påvirker ytelsen til enhver prediktiv modell. Det refererer til den delikate balansen mellom skjevhetsfeil og variansfeil i en modell, da det er umulig å minimere begge deler samtidig. Å finne den rette balansen er avgjørende for å oppnå optimal modellytelse.

I denne korte artikkelen vil vi definere skjevheter og varians, forklare hvordan de påvirker en maskinlæringsmodell, og gi noen praktiske råd om hvordan du kan håndtere dem i praksis.

Forstå skjevhet og varians

Før vi dykker inn i forholdet mellom skjevhet og varians, la oss definere hva disse begrepene representerer i maskinlæring.

Bias error refererer til forskjellen mellom prediksjonen til en modell og de riktige verdiene den prøver å forutsi (grunnsannhet). Bias er med andre ord feilen en modell begår på grunn av dens feilaktige antakelser om den underliggende datafordelingen. Modeller med høy skjevhet er ofte for enkle, og klarer ikke å fange kompleksiteten til dataene, noe som fører til undertilpasning.

Variansfeil refererer derimot til modellens følsomhet for små svingninger i treningsdataene. Modeller med høy varians er altfor komplekse og har en tendens til å passe til støyen i dataene, i stedet for det underliggende mønsteret, noe som fører til overtilpasning. Dette resulterer i dårlig ytelse på nye, usynlige data.

Høy skjevhet kan føre til undertilpasning, der modellen er for enkel til å fange kompleksiteten til dataene. Den gjør sterke antagelser om dataene og klarer ikke å fange opp det sanne forholdet mellom inngangs- og utdatavariabler. På den annen side kan høy varians føre til overtilpasning, der modellen er for kompleks og lærer støyen i dataene i stedet for det underliggende forholdet mellom inngangs- og utgangsvariabler. Dermed har overfitting-modeller en tendens til å passe treningsdataene for tett og vil ikke generalisere godt til nye data, mens underfitting-modeller ikke engang er i stand til å tilpasse treningsdataene nøyaktig.

Som nevnt tidligere er skjevhet og varians relatert, og en god modell balanserer mellom skjevhetsfeil og variansfeil. Bias-varians-avveiningen er prosessen med å finne den optimale balansen mellom disse to feilkildene. En modell med lav skjevhet og lav varians vil sannsynligvis gi gode resultater både på trening og nye data, og minimere den totale feilen.

Avveiningen mellom skjevhet og variasjon

Å oppnå en balanse mellom modellkompleksitet og dens evne til å generalisere til ukjente data er kjernen i avveiningen mellom skjevhet og varians. Generelt vil en mer kompleks modell ha en lavere skjevhet, men høyere varians, mens en enklere modell vil ha en høyere skjevhet, men lavere varians.

Siden det er umulig å minimere skjevheter og varians samtidig, er det avgjørende å finne den optimale balansen mellom dem for å bygge en robust maskinlæringsmodell. For eksempel, når vi øker kompleksiteten til en modell, øker vi også variansen. Dette er fordi en mer kompleks modell er mer sannsynlig å passe støyen i treningsdataene, noe som vil føre til overtilpasning.

På den annen side, hvis vi holder modellen for enkel, vil vi øke skjevheten. Dette er fordi en enklere modell ikke vil kunne fange opp de underliggende sammenhengene i dataene, noe som vil føre til undertilpasning.

Målet er å trene opp en modell som er kompleks nok til å fange opp de underliggende sammenhengene i treningsdataene, men ikke så kompleks at den passer til støyen i treningsdataene.

Bias-Variance Trade-Off i praksis

For å diagnostisere modellytelse, beregner og sammenligner vi vanligvis tog- og valideringsfeil. Et nyttig verktøy for å visualisere dette er et plott av læringskurvene, som viser ytelsen til modellen på både toget og valideringsdata gjennom hele treningsprosessen. Ved å undersøke disse kurvene kan vi finne ut om en modell er overfitting (høy varians), underfitting (høy bias) eller veltilpasset (optimal balanse mellom skjevhet og varians).

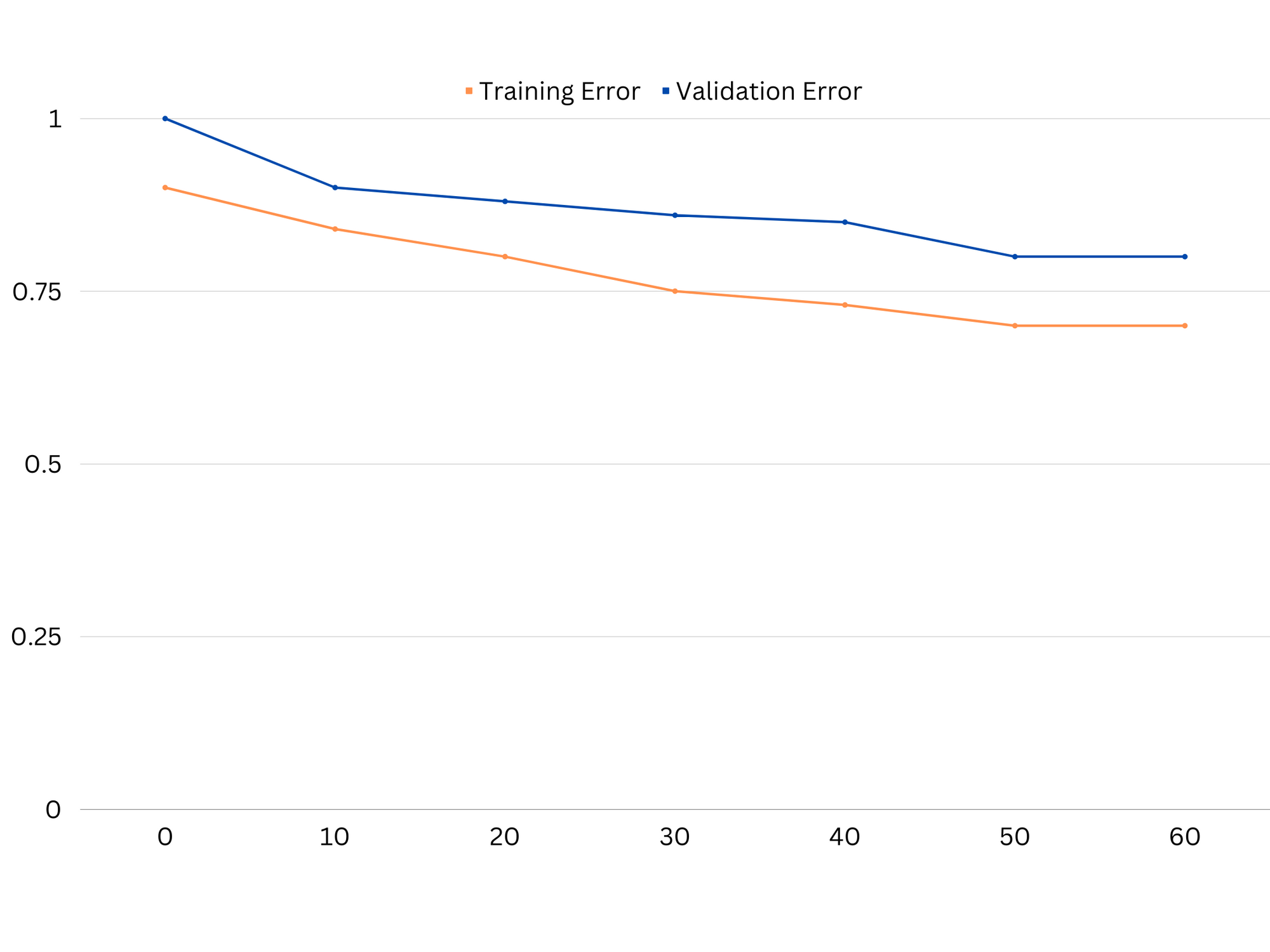

Eksempel på læringskurver for en undertilpasset modell. Både togfeil og valideringsfeil er høye.

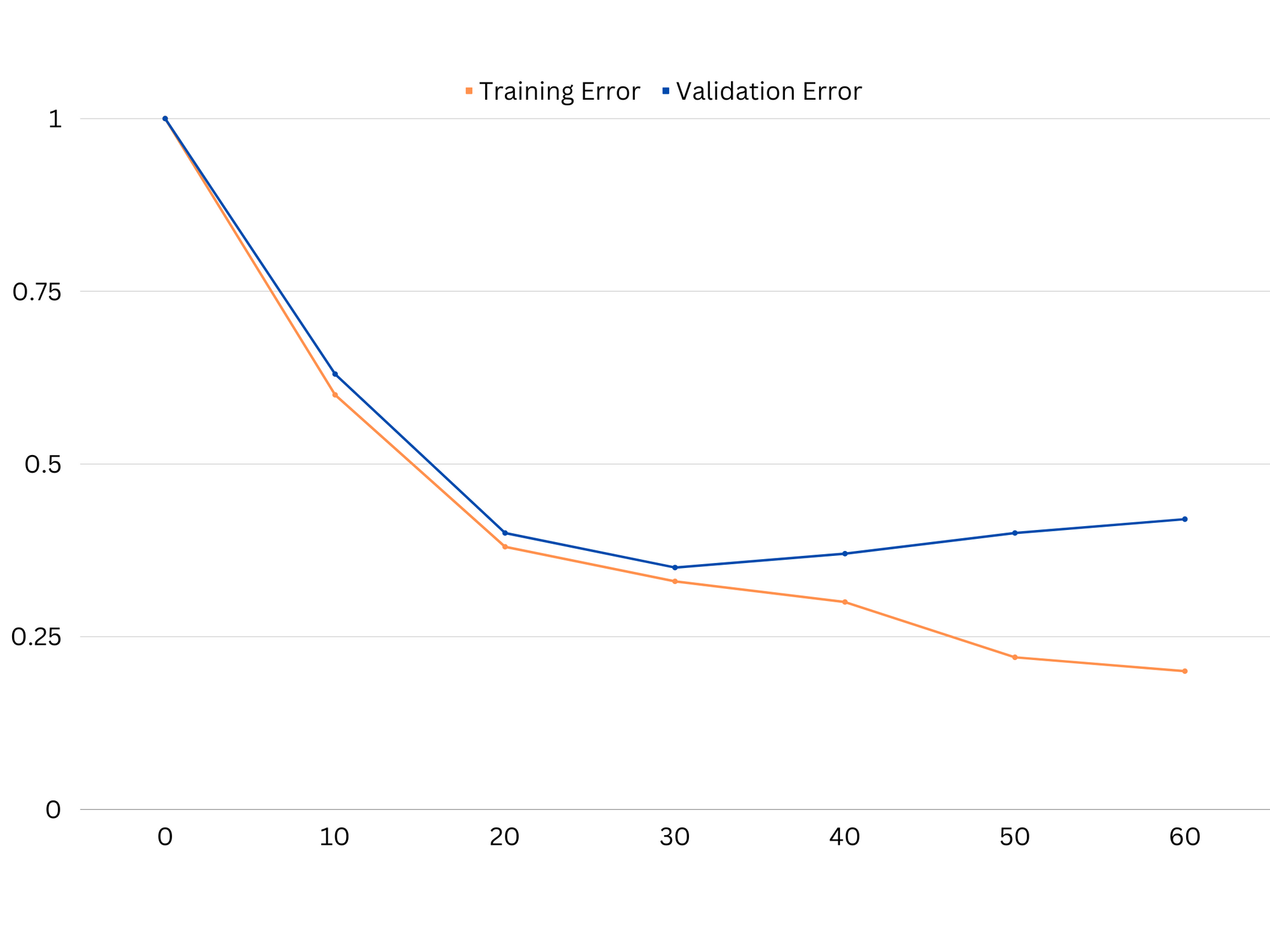

I praksis antyder lav ytelse på både trenings- og valideringsdata at modellen er for enkel, noe som fører til undertilpasning. På den annen side, hvis modellen presterer veldig bra på treningsdataene, men dårlig på testdataene, er modellens kompleksitet sannsynligvis for høy, noe som resulterer i overtilpasning. For å adressere undertilpasning kan vi prøve å øke modellens kompleksitet ved å legge til flere funksjoner, endre læringsalgoritmen eller velge forskjellige hyperparametre. I tilfelle overtilpasning bør vi vurdere å regularisere modellen eller bruke teknikker som kryssvalidering for å forbedre dens generaliseringsevner.

Eksempel på læringskurver for en overfitting-modell. Togfeil reduseres mens valideringsfeil begynner å øke. Modellen klarer ikke å generalisere.

Regularisering er en teknikk som kan brukes til å redusere variansfeilen i maskinlæringsmodeller, noe som bidrar til å adressere skjevhet-varians-avveiningen. Det finnes en rekke forskjellige regulariseringsteknikker, hver med sine egne fordeler og ulemper. Noen populære regulariseringsteknikker inkluderer ridge-regresjon, lasso-regresjon og elastisk netto-regularisering. Alle disse teknikkene bidrar til å forhindre overtilpasning ved å legge til et straffebegrep til modellens objektive funksjon, som fraråder ekstreme parameterverdier og oppmuntrer til enklere modeller.

Ryggregresjon, også kjent som L2-regularisering, legger til et straffeledd proporsjonalt med kvadratet av modellparametrene. Denne teknikken har en tendens til å resultere i modeller med mindre parameterverdier, noe som kan føre til redusert varians og forbedret generalisering. Den utfører imidlertid ikke funksjonsvalg, så alle funksjoner forblir i modellen.

Sjekk ut vår praktiske, praktiske guide for å lære Git, med beste praksis, bransjeaksepterte standarder og inkludert jukseark. Slutt å google Git-kommandoer og faktisk lære den!

Lasso-regresjon, eller L1-regularisering, legger til en straffeterm proporsjonal med den absolutte verdien av modellparametrene. Denne teknikken kan føre til modeller med sparsomme parameterverdier, som effektivt utfører funksjonsvalg ved å sette noen parametere til null. Dette kan resultere i enklere modeller som er lettere å tolke.

Elastisk nettoregularisering er en kombinasjon av både L1- og L2-regularisering, som tillater en balanse mellom ridge- og lasso-regresjon. Ved å kontrollere forholdet mellom de to straffevilkårene, kan elastisk nett oppnå fordelene med begge teknikkene, for eksempel forbedret generalisering og funksjonsvalg.

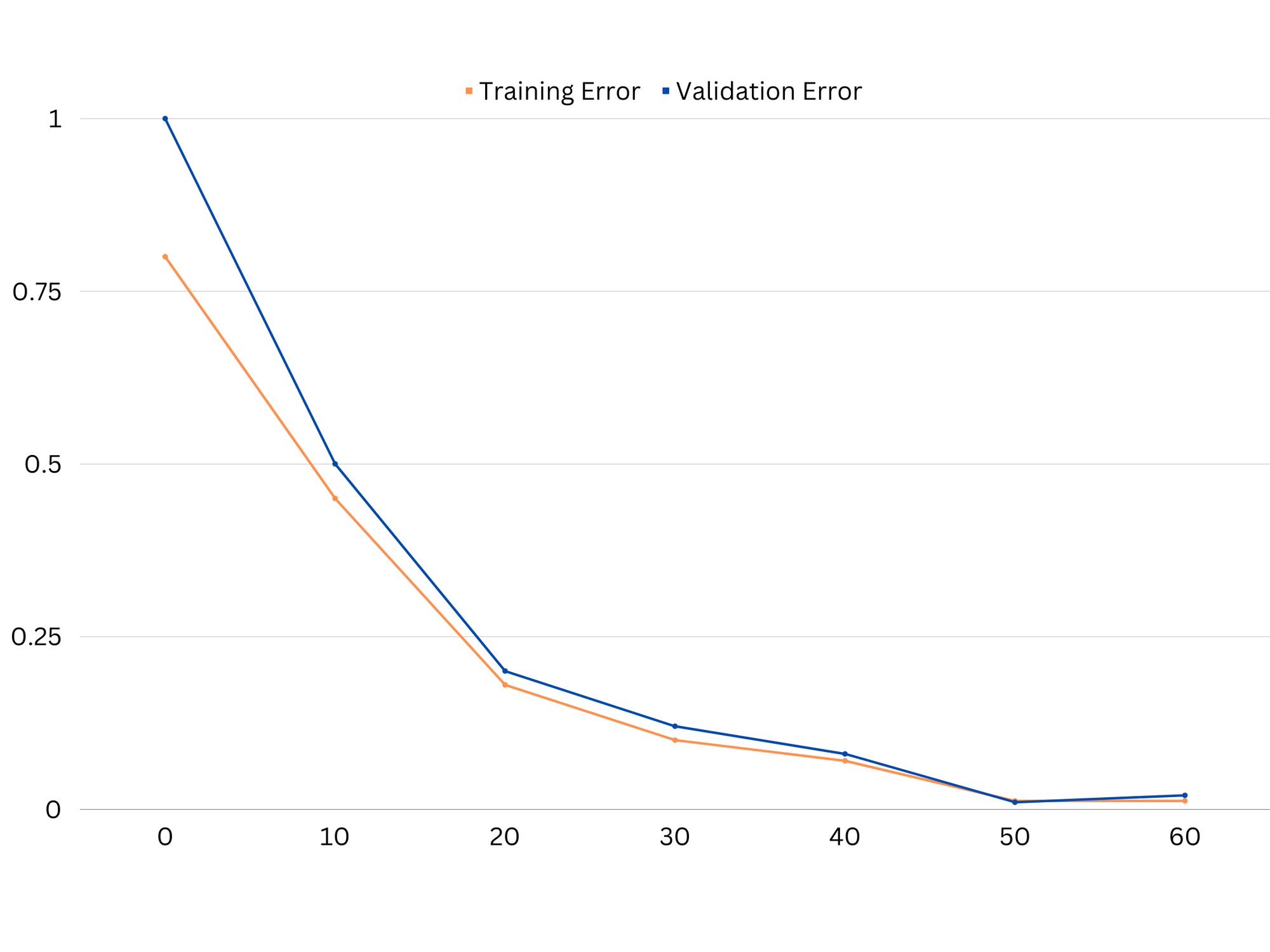

Eksempel på læringskurver av god tilpasningsmodell.

Konklusjoner

Bias-varians-avveiningen er et avgjørende konsept innen maskinlæring som bestemmer effektiviteten og godheten til en modell. Mens høy skjevhet fører til undertilpasning og høy varians fører til overtilpasning, er det nødvendig å finne den optimale balansen mellom de to for å bygge robuste modeller som generaliserer godt til nye data.

Ved hjelp av læringskurver er det mulig å identifisere overtilpasnings- eller undertilpasningsproblemer, og ved å justere kompleksiteten i modellen eller implementere regulariseringsteknikker er det mulig å forbedre ytelsen på både trenings- og valideringsdata, samt testdata.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoAiStream. Web3 Data Intelligence. Kunnskap forsterket. Tilgang her.

- Minting the Future med Adryenn Ashley. Tilgang her.

- Kjøp og selg aksjer i PRE-IPO-selskaper med PREIPO®. Tilgang her.

- kilde: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :er

- :ikke

- :hvor

- 1

- 12

- 20

- 8

- a

- evne

- I stand

- Om oss

- Absolute

- nøyaktig

- Oppnå

- oppnå

- faktisk

- legge

- adresse

- Legger

- fordeler

- råd

- påvirke

- påvirker

- algoritme

- Alle

- tillate

- også

- an

- og

- noen

- ER

- Artikkel

- AS

- Balansere

- balanserer

- BE

- fordi

- Fordeler

- mellom

- Bias

- grensen

- både

- Bygning

- men

- by

- beregne

- CAN

- evner

- fangst

- saken

- endring

- velge

- tett

- kombinasjon

- sammenligne

- komplekse

- kompleksitet

- konsept

- Vurder

- kontrollerende

- Kjerne

- korrigere

- avgjørende

- dato

- avtale

- avtar

- Bestem

- bestemmes

- forskjell

- forskjellig

- skjermer

- distribusjon

- gjør

- to

- hver enkelt

- Tidligere

- enklere

- effektivt

- effektivitet

- oppmuntrer

- nok

- feil

- feil

- Selv

- undersøke

- eksempel

- Forklar

- ekstrem

- sviktende

- mislykkes

- Trekk

- Egenskaper

- finne

- passer

- fitting

- svingninger

- Fokus

- Til

- funksjon

- fundamental

- general

- gå

- mål

- god

- Ground

- veilede

- hånd

- hands-on

- Ha

- hjelpe

- hjelpe

- Høy

- høyere

- hover

- Hvordan

- Hvordan

- Men

- HTTPS

- identifisere

- if

- implementere

- umulig

- forbedre

- forbedret

- in

- I andre

- inkludere

- inkludert

- Øke

- økende

- inngang

- inn

- Introduksjon

- IT

- DET ER

- Hold

- kjent

- L1

- l2

- føre

- ledende

- Fører

- læring

- la

- LG

- i likhet med

- Sannsynlig

- ll

- Lav

- lavere

- maskin

- maskinlæring

- GJØR AT

- nevnt

- minimere

- modell

- modeller

- mer

- nødvendig

- nett

- Ny

- Bråk

- Antall

- Målet

- of

- ofte

- on

- optimal

- or

- Annen

- vår

- ut

- produksjon

- egen

- parameter

- parametere

- Mønster

- Utfør

- ytelse

- utfører

- utfører

- plato

- Platon Data Intelligence

- PlatonData

- dårlig

- Populær

- mulig

- Praktisk

- praksis

- forutsi

- prediksjon

- forebygge

- problemer

- prosess

- gi

- heller

- ratio

- redusere

- Redusert

- refererer

- i slekt

- forholdet

- Relasjoner

- forbli

- representere

- resultere

- resulterende

- Resultater

- ikke sant

- Ringe

- robust

- s

- utvalg

- Følsomhet

- innstilling

- Shadow

- ark

- Kort

- bør

- Enkelt

- samtidig

- liten

- mindre

- So

- noen

- Kilder

- kvadrat

- Stackabuse

- standarder

- Stopp

- sterk

- slik

- foreslår

- teknikker

- begrep

- vilkår

- test

- enn

- Det

- De

- deres

- Dem

- Der.

- Disse

- de

- denne

- hele

- til

- også

- verktøy

- Totalt

- Tog

- Kurs

- overgang

- sant

- Sannhet

- prøve

- to

- typisk

- ute av stand

- underliggende

- ukjent

- brukt

- ved hjelp av

- validering

- verdi

- Verdier

- veldig

- we

- VI VIL

- Hva

- om

- hvilken

- mens

- vil

- med

- ord

- zephyrnet

- null