Ja.. jeg snakker om AI-applikasjonene - våre utallige AI-applikasjoner og kommende som hvisker til mennesker om hva de skal gjøre... hvordan gjøre det ... men ikke om hviskendene som samhandler med AI-chatbotene.

Ifølge IDC spådommer, kan det globale AI-markedet nå over 500 milliarder dollar innen 2024 – en økning på mer enn 50 % fra 2021. Dette indikerer at vi gikk fra forretningseksperimenter til å akseptere at det er en integrert del av bedriftsstrategien for alle størrelser. Det er et nødvendig verktøy for å gjøre data om til innsikt for å sette i gang handling basert på bedre beslutninger. Ingen diskuterer fordelene med AI for å redusere forretningsrisiko og forsterke avkastningen med innovasjon. Men som alltid er det en …MEN… den objektive AI er lettere sagt enn gjort.

Disse AI-modellene er kritiske for virksomheten og må fungere pålitelig med synlighet og ansvarlighet. Ellers har svikt i dette tilfellet alvorlige konsekvenser som påvirker ethvert selskaps kontantstrøm og kan til og med føre til juridiske saker. Den eneste måten å unngå dette på er automatisering og åpenhet for å svare på ett spørsmål "Kan du bevise at denne AI-applikasjonen/arbeidsmengden er bygget etisk." Aka ... hvordan styrer du? Og kan du bevise at det blir styrt kontinuerlig?

Det er her selskaper liker IBM har investert i AI-styring for å orkestrere den overordnede prosessen med å lede, administrere og overvåke AI-aktivitetene til organisasjonen. Den primære jobben er å sikre at alle forretningsenhetene holder seg proaktive og infuserer styringsrammeverket i initiativene for å styrke evnen til å møte etiske prinsipper og regelverk. Spesielt er regulerte bransjer som bank og finansielle tjenester lovpålagt å gi bevis for å tilfredsstille regulatorer.

Innflytelsen fra AI vokser eksponentielt i finanssektoren på grunn av det enorme presset fra digital transformasjon. Som sagt, det er lettere sagt enn gjort fordi:

1. Operasjonaliser AI-appene trygt:

I noen tilfeller bygges modellene uten klarhet og katalogisering; unødvendig å si, overvåking slipper unna midt i alt for å spore livssyklusen fra ende til ende. Mens banker sliter med eldre applikasjoner, ble det vanskeligere å automatisere prosessene for å skape åpenhet og forklaring, og i sin tur en svart boks. Ingen vet hvorfor/hvordan beslutninger ble tatt. De nye appene sammenfiltret med eldre apper ser aldri dagslyset, selv om det er knyttet en enorm avkastning på det på grunn av kvalitet og uopplevde risikoer.

Det bringer oss til vårt andre punkt – håndtering av omdømmerisikoen

2. Administrer omdømmerisiko sammen med den generelle risikoen

jeg har spurt #chatGPT og #Bard – hvem er Padma Chukka. #ChatGPT nektet å svare selv om jeg endret spørsmålet på flere måter. Likevel ga Bard meg et detaljert svar, inkludert LinkedIn-profilen min ... men data er fra forskjellige nettsteder der den gamle profilen min fortsatt eksisterer som en del av høyttalerbios. Fra det tidspunktet har jeg ennå ikke åpnet Bard. Så raskt ble jeg slått av, aka – Omdømmerisiko. Anta at jeg kan slå av en enkel chatbot når jeg innser at dataene kan være inkonsekvente. Hvordan kunne jeg ikke forsikre meg før jeg bestemte meg for å kjøpe en AI-infundert applikasjon for å drive kritisk virksomhet? Omdømmerisiko er en vesentlig faktor som noen ganger glemmer bedrifter. Hvis du kvantifiserer omdømmerisikoen, kan man se den enorme innvirkningen på virksomheten hvis man ikke er proaktiv.

For å øke kompleksiteten er den tredje...

3. Hvordan kan en bedrift reagere på endrede AI-regelverk?

For å unngå omdømmerisikoen, bør et vellykket og ansvarlig AI-team være klar over alle lokale og globale reguleringer, og falle som en tick-tock-video med et øyeblikks varsel. Og manglende overholdelse kan til slutt koste en organisasjon millioner av dollar i bøter rundt arbeidet som den foreslåtte EU AI-loven. Det kan være opptil 30 millioner euro eller 6 % av selskapets globale inntekter – OUCH.

Vel, ikke alt trenger å være rosenrødt i starten ... så lenge vi vet hvordan vi kan gjøre en makeover fra en skummel til en rosenrød situasjon.

Uten overraskelse ... det er alltid mennesker, prosesser og teknologi. Så først, lag et tverrfunksjonelt styringsorgan for å utdanne, lede og overvåke initiativene basert på målene. Deretter benchmark gjeldende AI-teknologi og -prosesser, forstå hullene, og korriger deretter til fremtidig bevis. Fall deretter tilbake på et sett med automatiserte styringsarbeidsflyter i tråd med samsvarskrav. Til slutt, sett opp et overvåkingssystem for å varsle eiere om den akseptable terskelen nærmer seg. Fra teknologisiden krever en godt utformet, godt utført og godt sammenkoblet AI flere byggeklosser. Og sørg for at den har noen eller alle funksjoner:

· Dataintegritet på tvers av ulike distribusjoner

· Bruk åpne, fleksible eksisterende verktøy som følger AI Governance

· Sørg for å tilby selvbetjent tilgang med personvernkontroller – en måte å spore på

· Design med automatisering og AI-styring i tankene

· Kan koble til og tilpasses for flere interessenter gjennom tilpassbar arbeidsflyt

Når vi har gjort en makeover av appen fra skummel til rosenrød … så er neste spørsmål hvordan du beviser …

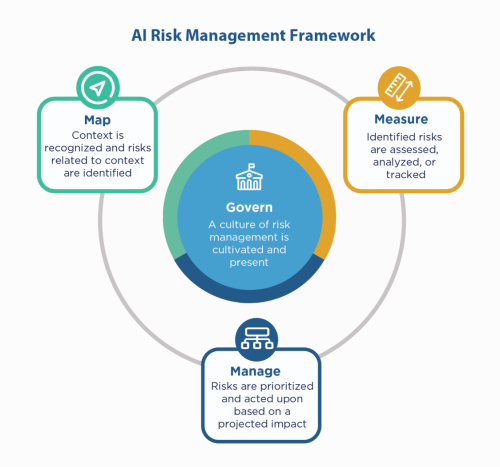

Først fall tilbake på selskapets AI-prinsipper – bygg med dem, og likevel må du fortsatt «vise» at du er kompatibel, spesielt i regulerte miljøer som Financial Services. Siden finansielle tjenester må klage til NIST 800-53, kan de se på NIST AI Risk Management Framework (AI RMF). NIST foreslo kontrollene i fire familier - Styr, Kart, Mål og Administrer. Bruk det som en veiledende faktor og stresstest applikasjonene for å identifisere hullene som skal utbedres og overvåkes.

IBM kan validere modellene dine før du setter dem i produksjon, og kan overvåkes for rettferdighet, kvalitet og drift. Den kan også gi dokumentasjon som forklarer modellens oppførsel og spådommer for å tilfredsstille regulatorers og revisorers krav. Disse forklaringene kan gi synlighet og lette revisjonssmertene, og øke åpenheten og muligheten til å bestemme mulige risikoer.

Lytt til disse AI-hviskene med selvtillit!

#Finansielle tjenester #ansvarligai #etisk #NISTAIRMF

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- Minting the Future med Adryenn Ashley. Tilgang her.

- kilde: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :er

- $OPP

- 2021

- 2024

- 7

- a

- evne

- Om oss

- akseptabelt

- adgang

- ansvarlighet

- tvers

- Handling

- Handling

- Aktiviteter

- overholde

- AI

- AI-loven

- AI-styring

- aka

- Varsle

- Alle

- alltid

- og

- besvare

- app

- Søknad

- søknader

- apps

- ER

- rundt

- AS

- assosiert

- At

- revisjon

- revisorer

- Automatisert

- Automatisere

- Automatisering

- tilbake

- Banking

- Banker

- basert

- BE

- fordi

- før du

- være

- benchmark

- Fordeler

- Bedre

- Milliarder

- Svart

- Blocks

- kroppen

- Eske

- Bringer

- bygge

- Bygning

- bygget

- virksomhet

- kjøpe

- by

- CAN

- evner

- saken

- saker

- Kontanter

- kontantstrøm

- endring

- chatbot

- chatbots

- klarhet

- lukking

- Selskaper

- Selskapet

- kompleksitet

- samsvar

- kompatibel

- Gjennomføre

- selvsikkert

- Koble

- Konsekvenser

- kontinuerlig

- kontroller

- Kostnad

- kunne

- skape

- kritisk

- Gjeldende

- tilpasses

- syklus

- dato

- debattere

- Avgjør

- avgjørelser

- redusere

- utforming

- detaljert

- Bestem

- digitalt

- Digital Transformation

- dire

- direkte

- regi

- diverse

- dokumentasjon

- dollar

- slippe

- enklere

- utdanne

- ende til ende

- sikre

- Enterprise

- miljøer

- spesielt

- avgjørende

- etisk

- EU

- euro

- Selv

- Hver

- alt

- bevis

- eksisterende

- finnes

- forklare

- eksponentielt

- Failure

- rettferdighet

- Fall

- familier

- Endelig

- finansiell

- finansielle tjenester

- bøter

- Finextra

- Først

- fleksibel

- flyten

- Til

- Rammeverk

- fra

- fra 2021

- framtid

- Gi

- Global

- styresett

- Økende

- Ha

- Hvordan

- Hvordan

- HTTPS

- stort

- Mennesker

- i

- identifisere

- Påvirkning

- in

- Inkludert

- Øke

- indikerer

- bransjer

- påvirke

- initiativer

- Innovasjon

- innsikt

- integrert

- integritet

- samhandle

- investert

- IT

- DET ER

- Jobb

- Vet

- Legacy

- Lovlig

- juridiske forhold

- Life

- i likhet med

- linje

- lokal

- Lang

- Se

- laget

- gjøre

- administrer

- ledelse

- administrerende

- kart

- marked

- Saker

- Kan..

- måle

- Møt

- kunne

- millioner

- millioner

- modell

- modeller

- øyeblikk

- Overvåke

- overvåket

- overvåking

- mer

- flere

- nødvendig

- Trenger

- Unødvendig

- Ny

- neste

- nst

- mål

- of

- tilby

- Gammel

- on

- ONE

- åpen

- betjene

- organisasjon

- ellers

- samlet

- eiere

- Smerte

- del

- Ansatte

- plato

- Platon Data Intelligence

- PlatonData

- Point

- mulig

- Spådommer

- press

- primære

- prinsipper

- privatliv

- Proaktiv

- prosess

- Prosesser

- Produksjon

- Profil

- bevis

- foreslått

- Bevis

- gi

- sette

- kvalitet

- spørsmål

- raskt

- å nå

- realisere

- regulert

- regulerte næringer

- Regulering

- forskrifter

- Regulatorer

- omdømme

- påkrevd

- Krav

- Krever

- Svare

- ansvarlig

- resultere

- inntekter

- Risiko

- risikostyring

- risikoer

- ROI

- Rosy

- s

- Sa

- Sekund

- sektor

- Selvbetjening

- Tjenester

- sett

- bør

- Vis

- side

- Enkelt

- siden

- Nettsteder

- situasjon

- størrelser

- So

- noen

- Spark

- Høyttaler

- interessenter

- opphold

- Still

- Strategi

- Forsterke

- stresset

- Sliter

- vellykket

- system

- snakker

- lag

- Teknologi

- test

- Det

- De

- Dem

- Disse

- Tredje

- terskel

- Gjennom

- til

- verktøy

- verktøy

- spor

- Transformation

- Åpenhet

- enorm

- SVING

- snudde

- Til syvende og sist

- forstå

- lomper

- kommende

- us

- bruke

- VALIDERE

- ulike

- video

- synlighet

- Vei..

- måter

- Hva

- mens

- HVEM

- med

- uten

- Arbeid

- arbeidsflyt

- Du

- Din

- zephyrnet