Har du noen gang sett en babygaselle lære å gå? En fawn, som i utgangspunktet er en pattedyrsfar med lange ben, klatrer på beina, faller, står og faller igjen. Til slutt står den lenge nok til å vippe de tannpirkerlignende bena inn i en rekke nesten fall ... ahem, trinn. Utrolig nok, noen få minutter etter denne inntagende visningen, hopper fawn rundt som en gammel proff.

Vel, nå har vi en robotversjon av denne klassiske Serengeti-scenen.

Fawn i dette tilfellet er en robothund ved University of California, Berkeley. Og det er på samme måte en overraskende rask elev (i forhold til resten av robottypen). Roboten er også spesiell fordi, i motsetning til andre prangende roboter du kanskje har sett på nettet, bruker den kunstig intelligens for å lære seg å gå.

Begynnende på ryggen, med beina vinkende, lærer roboten å snu seg, reise seg og gå på en time. Ytterligere ti minutter med trakassering med en papprull er nok til å lære den å tåle og komme seg etter å bli dyttet rundt av sine behandlere.

Det er ikke første gang en robot har brukt kunstig intelligens for å lære å gå. Men mens tidligere roboter lærte ferdighetene ved prøving og feiling over utallige iterasjoner i simuleringer, lærte Berkeley-boten helt i den virkelige verden.

[Innebygd innhold]

I en utgitt papir på arXiv preprint-serveren sier forskerne – Danijar Hafner, Alejandro Escontrela og Philipp Wu – at det ikke er enkelt å overføre algoritmer som har lært i simulering til den virkelige verden. Små detaljer og forskjeller mellom den virkelige verden og simulering kan snuble nye roboter. På den annen side er treningsalgoritmer i den virkelige verden upraktisk: Det vil ta for mye tid og slitasje.

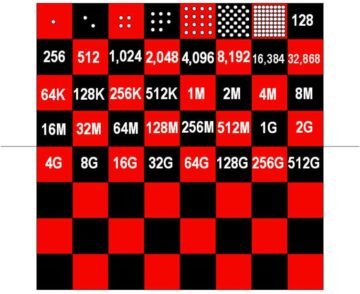

For fire år siden viste for eksempel OpenAI frem en AI-aktivert robothånd som kunne manipulere en kube. Kontrollalgoritmen, Dactyl, trengte rundt 100 års erfaring i en simulering drevet av 6,144 CPUer og 8 Nvidia V100 GPUer for å utføre denne relativt enkle oppgaven. Ting har utviklet seg siden den gang, men problemet gjenstår stort sett. Rene forsterkende læringsalgoritmer trenger for mye prøving og feiling for å lære ferdigheter til at de kan trene i den virkelige verden. Enkelt sagt, læringsprosessen ville knekke forskere og roboter før du gjør noen meningsfull fremgang.

Berkeley-teamet forsøkte å løse dette problemet med en algoritme kalt Dreamer. Konstruere det som kalles en "verdensmodell,” Dreamer kan projisere sannsynligheten for at en fremtidig handling vil nå målet. Med erfaring forbedres nøyaktigheten av anslagene. Ved å filtrere ut mindre vellykkede handlinger på forhånd, lar verdensmodellen roboten mer effektivt finne ut hva som fungerer.

"Å lære verdensmodeller fra tidligere erfaringer gjør roboter i stand til å forestille seg fremtidige utfall av potensielle handlinger, noe som reduserer mengden prøving og feiling i det virkelige miljøet som trengs for å lære vellykket atferd," skriver forskerne. "Ved å forutsi fremtidige utfall, tillater verdensmodeller planlegging og atferdslæring gitt bare små mengder interaksjon i den virkelige verden."

Med andre ord kan en verdensmodell redusere tilsvarende år med treningstid i en simulering til ikke mer enn en vanskelig time i den virkelige verden.

Tilnærmingen kan også ha større relevans enn robothunder. Teamet brukte også Dreamer på en robotarm og en robot med hjul. I begge tilfeller fant de ut at Dreamer tillot robotene deres å effektivt lære relevante ferdigheter, uten behov for sim-tid. Mer ambisiøse fremtidige søknader kan inkludere selvstyrte biler.

Selvfølgelig er det fortsatt utfordringer å ta tak i. Selv om forsterkningslæring automatiserer noe av den intrikate håndkodingen bak dagens mest avanserte roboter, krever det fortsatt at ingeniører definerer robotens mål og hva som utgjør suksess – en øvelse som er både tidkrevende og åpen for miljøer i den virkelige verden. Selv om roboten overlevde teamets eksperimenter her, kan lengre trening på mer avanserte ferdigheter vise seg å være for mye til at fremtidige roboter kan overleve uten skade. Forskerne sier at det kan være fruktbart å kombinere simulatortrening med rask læring i den virkelige verden.

Likevel fremmer resultatene AI i robotikk enda et steg. Dreamer styrker saken om at "forsterkningslæring vil være et hjørnesteinsverktøy i fremtiden for robotkontroll," Jonathan Hurst, professor i robotikk ved Oregon State University fortalte MIT Technology Review.

Bilde Credit: Danijar Hafner / YouTube