I vår søken etter å begrense det destruktive potensialet til kunstig intelligens, har en ny artikkel fra University of Cambridge foreslått å bake inn eksterne drepebrytere og lockouter, som de som er utviklet for å stoppe uautorisert utskyting av atomvåpen, inn i maskinvaren som driver det.

Avisen [PDF], som inkluderer stemmer fra en rekke akademiske institusjoner og flere fra OpenAI, sier at regulering av maskinvaren disse modellene er avhengige av kan være den beste måten å forhindre misbruk.

"AI-relevant databehandling er et spesielt effektivt intervensjonspunkt: Det er detekterbart, ekskluderbart og kvantifiserbart, og produseres via en ekstremt konsentrert forsyningskjede," hevder forskerne.

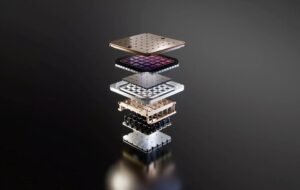

Trening av de mest produktive modellene, som antas å overskride en billion parametere, krever enorm fysisk infrastruktur: titusenvis av GPUer eller akseleratorer og uker eller måneder med behandlingstid. Dette, sier forskerne, gjør eksistensen og den relative ytelsen til disse ressursene vanskelig å skjule.

Dessuten produseres de mest avanserte brikkene som brukes til å trene disse modellene av et relativt lite antall selskaper, som Nvidia, AMD og Intel, noe som gjør at beslutningstakere kan begrense salget av disse varene til personer eller land av bekymring.

Disse faktorene, sammen med andre som forsyningskjedebegrensninger for halvlederproduksjon, gir beslutningstakere muligheten til å bedre forstå hvordan og hvor AI-infrastrukturen er distribuert, hvem som har og ikke har tilgang til den, og håndhever straffer for misbruk, hevder avisen. .

Kontroll av infrastrukturen

Artikkelen fremhever en rekke måter politikere kan nærme seg AI-maskinvareregulering. Mange av forslagene – inkludert de som er utviklet for å forbedre synlighet og begrense salget av AI-akseleratorer – spiller allerede ut på nasjonalt nivå.

I fjor la USAs president Joe Biden frem en utøvende rekkefølge rettet mot å identifisere selskaper som utvikler store dual-use AI-modeller samt infrastrukturleverandører som er i stand til trene dem. Hvis du ikke er kjent, refererer "dual-use" til teknologier som kan tjene dobbelt plikt i sivile og militære applikasjoner.

Mer nylig, det amerikanske handelsdepartementet foreslått regulering som vil kreve at amerikanske skyleverandører implementerer strengere "kjenn-din-kunde"-policyer for å forhindre at personer eller land som er bekymret, kommer utenom eksportrestriksjoner.

Denne typen synlighet er verdifull, bemerker forskere, siden den kan bidra til å unngå et nytt våpenkappløp, som det som ble utløst av kontroversen om rakettgapet, der feilaktige rapporter førte til massiv oppbygging av ballistiske missiler. Selv om det er verdifullt, advarer de om at å utføre disse rapporteringskravene risikerer å invadere kundenes personvern og til og med føre til at sensitive data lekkes.

I mellomtiden, på handelsfronten, har handelsavdelingen fortsatt å gjøre det trapp opp restriksjoner som begrenser ytelsen til akseleratorer som selges til Kina. Men, som vi tidligere har rapportert, mens denne innsatsen har gjort det vanskeligere for land som Kina å få tak i amerikanske sjetonger, er de langt fra perfekte.

For å løse disse begrensningene har forskerne foreslått å implementere et globalt register for salg av AI-brikker som vil spore dem i løpet av livssyklusen, selv etter at de har forlatt opprinnelseslandet. Et slikt register, foreslår de, kan inkorporere en unik identifikator i hver brikke, noe som kan bidra til å bekjempe smugling av komponenter.

I den mer ekstreme enden av spekteret har forskere antydet at drepebrytere kan bakes inn i silisiumet for å forhindre bruk av dem i ondsinnede applikasjoner.

I teorien kan dette tillate regulatorer å reagere raskere på misbruk av sensitive teknologier ved å avskjære tilgangen til brikker eksternt, men forfatterne advarer om at det ikke er uten risiko. Implikasjonen er, hvis den implementeres feil, at en slik kill-switch kan bli et mål for nettkriminelle.

Et annet forslag ville kreve at flere parter signerer på potensielt risikable AI-treningsoppgaver før de kan distribueres i stor skala. "Atomvåpen bruker lignende mekanismer som kalles permissive action links," skrev de.

For kjernefysiske våpen er disse sikkerhetslåsene utformet for å forhindre at en person blir useriøs og starter et første angrep. For AI er ideen imidlertid at hvis en person eller et selskap ønsker å trene en modell over en viss terskel i skyen, må de først få autorisasjon for å gjøre det.

Selv om det er et potent verktøy, observerer forskerne at dette kan slå tilbake ved å forhindre utviklingen av ønskelig AI. Argumentet ser ut til å være at selv om bruken av atomvåpen har et ganske klart utfall, er AI ikke alltid så svart-hvitt.

Men hvis dette føles litt for dystopisk for din smak, dedikerer papiret en hel del til å omfordele AI-ressurser for å forbedre samfunnet som helhet. Ideen er at beslutningstakere kan komme sammen for å gjøre AI-databehandling mer tilgjengelig for grupper som sannsynligvis ikke vil bruke det for ondskap, et konsept beskrevet som "allokering".

Hva er galt med å regulere AI-utvikling?

Hvorfor gå til alt dette problemet? Vel, avisens forfattere hevder at fysisk maskinvare iboende er lettere å kontrollere.

Sammenlignet med maskinvare er "andre input og output fra AI-utvikling - data, algoritmer og trente modeller - lett delbare, ikke-rivaliserende immaterielle varer, noe som gjør dem iboende vanskelige å kontrollere," heter det i avisen.

Argumentet er at når en modell først er publisert, enten i det åpne eller lekket, er det ingen mulighet til å sette ånden tilbake i flasken og stoppe dens spredning over nettet.

Forskere fremhevet også at innsatsen for å forhindre misbruk av modeller har vist seg å være upålitelig. I ett eksempel fremhevet forfatterne hvor lett forskerne var i stand til å demontere sikkerhetstiltak i Metas Llama 2, ment å forhindre at modellen genererer støtende språk.

Tatt til det ytterste fryktes det at en tilstrekkelig avansert modell for dobbeltbruk kan brukes for å akselerere utvikling av kjemiske eller biologiske våpen.

Artikkelen innrømmer at AI-maskinvareregulering ikke er en sølvkule og eliminerer ikke behovet for regulering i andre aspekter av bransjen.

Imidlertid er deltakelsen fra flere OpenAI-forskere vanskelig å ignorere med tanke på administrerende direktør Sam Altmans forsøk å kontrollere narrativet rundt AI-regulering. ®

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 7

- a

- I stand

- overgrep

- AC

- akademisk

- akselerere

- akseleratorer

- adgang

- tilgjengelig

- tvers

- Handling

- adresse

- avansert

- Etter

- AI

- AI-modeller

- AI-trening

- sikte

- algoritmer

- Alle

- allokering

- tillate

- tillatt

- tillate

- langs

- allerede

- også

- alltid

- AMD

- amerikansk

- an

- og

- En annen

- søknader

- tilnærming

- ER

- argumentere

- argument

- armer

- rundt

- kunstig

- kunstig intelligens

- AS

- aspekter

- At

- autorisasjon

- forfattere

- unngå

- tilbake

- BE

- bli

- før du

- være

- antatt

- BEST

- Bedre

- better

- Biden

- Svart

- bygge

- men

- by

- som heter

- cambridge

- CAN

- stand

- saken

- konsernsjef

- viss

- kjede

- kjemisk

- Kina

- chip

- chips

- sivil

- Cloud

- CO

- bekjempe

- Kom

- Handel

- Selskaper

- Selskapet

- komponenter

- Beregn

- konsentrert

- konsept

- Bekymring

- vurderer

- begrensninger

- fortsatte

- kontroll

- kontrovers

- kunne

- land

- land

- Kurs

- kunde

- skjæring

- nettkriminelle

- dato

- Avdeling

- utplassert

- beskrevet

- designet

- utviklet

- utvikle

- Utvikling

- vanskelig

- do

- doesn

- gjør

- dobbelt

- dystopisk

- hver enkelt

- lette

- enklere

- lett

- Effektiv

- innsats

- enten

- eliminere

- ansatt

- slutt

- håndheve

- Hele

- Selv

- eksempel

- stige

- utførende

- eksistens

- eksportere

- ekstrem

- ekstremt

- faktorer

- kjent

- langt

- raskere

- fryktet

- føles

- Først

- Til

- Forward

- fra

- foran

- mellomrom

- genererer

- Genie

- få

- få

- Global

- Go

- skal

- varer

- GPU

- Gruppens

- hender

- Hard

- hardere

- maskinvare

- Ha

- hjelpe

- Gjemme seg

- Fremhevet

- striper

- Hvordan

- Men

- HTTPS

- Tanken

- identifikator

- identifisering

- if

- ignorere

- enorme

- iverksette

- implementert

- implementere

- forbedre

- in

- I andre

- inkluderer

- Inkludert

- innlemme

- feil

- individuelt

- industri

- Infrastruktur

- iboende

- innganger

- institusjoner

- immaterielle

- Intel

- Intelligens

- intervensjon

- inn

- er n

- IT

- DET ER

- JOE

- Joe Biden

- jpg

- Drepe

- Type

- Språk

- stor

- lansere

- lansere

- føre

- Led

- venstre

- Nivå

- Livssyklus

- i likhet med

- BEGRENSE

- begrensninger

- begrense

- lenker

- lite

- Llama

- Låser

- laget

- gjøre

- GJØR AT

- Making

- skadelig

- produksjon

- mange

- massive

- Kan..

- midler

- ment

- mekanismer

- Meta

- kunne

- Militær

- Militære applikasjoner

- raketter

- misbruk

- modell

- modeller

- måneder

- mer

- mest

- flere

- FORTELLING

- nasjonal

- Trenger

- nett

- Ny

- Nei.

- note

- kjernekraft

- Antall

- mange

- Nvidia

- observere

- of

- off

- støtende

- tilby

- on

- gang

- ONE

- åpen

- OpenAI

- or

- opprinnelse

- Annen

- andre

- vår

- ut

- Utfallet

- utganger

- enn

- Papir

- parametere

- deltakelse

- spesielt

- parter

- straffer

- perfekt

- ytelse

- person

- personer

- fysisk

- plato

- Platon Data Intelligence

- PlatonData

- spiller

- Point

- Politikk

- beslutningstakere

- potent

- potensiell

- potensielt

- krefter

- president

- president Joe Biden

- pen

- forebygge

- hindre

- tidligere

- privatliv

- prosessering

- produsert

- produktive

- forslag

- foreslått

- utprøvd

- tilbydere

- publisert

- sette

- Sette

- kvantifiserbare

- søken

- Race

- RE

- nylig

- refererer

- registret

- Regulere

- regulerende

- Regulering

- Regulatorer

- slektning

- relativt

- avhengige

- fjernkontroll

- eksternt

- rapportert

- Rapportering

- Rapporter

- krever

- Krav

- Krever

- forskere

- Ressurser

- Svare

- begrense

- restriksjoner

- Risiko

- risikoer

- Risikabelt

- s

- sikringstiltak

- salg

- salg

- Sam

- Sam Altman

- sier

- Skala

- Seksjon

- sikkerhet

- synes

- halvledere

- sensitive

- betjene

- flere

- undertegne

- Silicon

- Sølv

- lignende

- liten

- So

- Samfunnet

- solgt

- Spectrum

- spre

- Begynn

- Stopp

- stoppe

- streik

- strengere

- slik

- foreslår

- levere

- forsyningskjeden

- Bytte om

- Target

- oppgaver

- smak

- Technologies

- titus

- Det

- De

- deres

- Dem

- teori

- Der.

- Disse

- de

- denne

- De

- tusener

- terskel

- tid

- til

- sammen

- også

- verktøy

- spor

- handel

- Tog

- trent

- Kurs

- utløst

- Trillion

- problemer

- uautorisert

- forstå

- unik

- universitet

- University of Cambridge

- usannsynlig

- us

- USAs president

- bruke

- brukt

- Verdifull

- Ve

- leverandører

- av

- synlighet

- STemmer

- ønsket

- Vei..

- måter

- we

- Våpen

- uker

- VI VIL

- var

- hvilken

- mens

- hvit

- HVEM

- hele

- med

- uten

- ville

- Feil

- skrev

- år

- Du

- Din

- zephyrnet