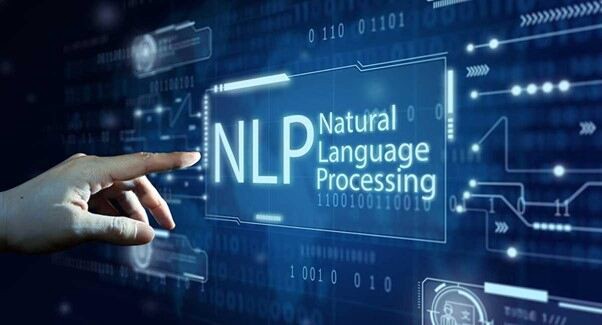

De sier "Handling taler høyere enn ord". Likevel, i noen tilfeller, kan ord (nøyaktig dechiffrert) bestemme hele handlingsforløpet som er relevant for svært intelligente maskiner og modeller. Denne tilnærmingen til å gjøre ordene mer meningsfulle for maskinene er NLP eller Natural Language Processing.

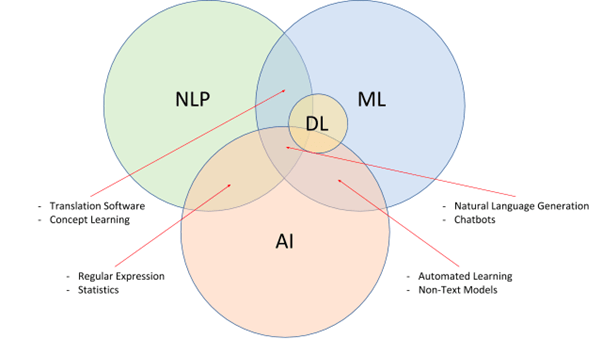

For de ukyndige er NLP et underfelt av kunstig intelligens som er i stand til å bryte ned menneskelig språk og gi de intelligente modellene grunnlaget for det samme. NLP, sammen med NLU (Natural Language Understanding) og NLG (Natural Language Generation), tar sikte på å utvikle svært intelligente og proaktive søkemotorer, grammatikkkontrollere, oversetter, stemmeassistenter og mer.

Enkelt sagt bryter NLP ned språkkompleksitetene, presenterer det samme for maskiner som datasett å ta referanse fra, og trekker også ut intensjonen og konteksten for å utvikle dem videre. Likevel, implementering av dem kommer med sin del av utfordringer.

Hva er NLP: Fra en oppstarts perspektiv?

Det er vanskelig for mennesker å lære et nytt språk, enn si maskiner. Men hvis vi trenger maskiner for å hjelpe oss gjennom dagen, må de forstå og svare på den menneskelige språkbruken. Natural Language Processing gjør det enkelt ved å bryte ned det menneskelige språket til maskinforståelige biter, som brukes til å trene modeller til perfeksjon.

NLP har også støtte fra NLU, som tar sikte på å bryte ned ordene og setningene fra et kontekstuelt synspunkt. Til slutt er det NLG som hjelper maskiner med å reagere ved å generere sin egen versjon av menneskelig språk for toveiskommunikasjon.

Startups som planlegger å designe og utvikle chatbots, stemmeassistenter og andre interaktive verktøy, må stole på NLP-tjenester og -løsninger for å utvikle maskinene med nøyaktig språk- og hensiktsdechiffreringsevne.

NLP-utfordringer å vurdere

Ord kan ha forskjellige betydninger. Slanger kan være vanskeligere å sette ut kontekstuelle. Og enkelte språk er bare vanskelige å mate på, på grunn av mangel på ressurser. Til tross for at det er en av de mer ettertraktede teknologiene, kommer NLP med følgende forankrede og implementerende AI-utfordringer.

Mangel på kontekst for homografier, homofoner og homonymer

En "flaggermus" kan være et sportsverktøy og til og med et trehengende pattedyr med vinger. Til tross for at skrivemåten er den samme, er de forskjellige når det gjelder betydning og kontekst. På samme måte høres "Der" og "Deres" like ut, men har forskjellige stavemåter og betydninger for dem.

Selv mennesker finner det til tider vanskelig å forstå de subtile forskjellene i bruk. Derfor, til tross for at NLP anses som et av de mer pålitelige alternativene for å trene maskiner i det språkspesifikke domenet, kan ord med lignende stavemåter, lyder og uttale forkaste konteksten ganske betydelig.

tvetydighet

Hvis du tror bare ord kan være forvirrende, her er en tvetydig setning med uklare tolkninger.

"Jeg knipset et barn i kjøpesenteret med kameraet mitt"- Hvis det snakkes til, kan det være slik at maskinen blir forvirret med hensyn til om ungen ble knipset med kameraet eller da ungen ble knipset, hadde han kameraet ditt.

Denne formen for forvirring eller tvetydighet er ganske vanlig hvis du stoler på ikke-troverdige NLP-løsninger. Når det gjelder kategorisering, kan tvetydigheter skilles ut som syntaktisk (meningsbasert), leksikalsk (ordbasert) og semantisk (kontekstbasert).

Feil som er relevante for hastighet og tekst

Maskiner som er avhengige av semantisk feed kan ikke trenes hvis tale- og tekstbitene er feil. Dette problemet er analogt med involvering av misbrukte eller til og med feilstavede ord, som kan få modellen til å fungere over tid. Selv om utviklede grammatikkkorrigeringsverktøy er gode nok til å luke ut setningsspesifikke feil, må treningsdataene være feilfrie for å lette nøyaktig utvikling i utgangspunktet.

Manglende evne til å passe inn i slanger og samtaler

Selv om NLP-tjenestene prøver å skalere utover tvetydigheter, feil og homonymer, er det ikke lett å tilpasse slagg eller kulturspesifikk ordrett. Det er ord som mangler standard ordbokreferanser, men som fortsatt kan være relevante for et spesifikt publikumssett. Hvis du planlegger å designe en tilpasset AI-drevet stemmeassistent eller modell, er det viktig å passe inn relevante referanser for å gjøre ressursen oppfattende nok.

Et eksempel kan være en "Big Bang Theory-spesifikk" chatbot som forstår "Buzzinga" og til og med reagerer på det samme.

Apati mot vertikal-spesifikk lingo

Som det kulturspesifikke språkbruket, bruker enkelte virksomheter svært tekniske og vertikalspesifikke terminologier som kanskje ikke stemmer overens med en standard NLP-drevet modell. Derfor, hvis du planlegger å utvikle feltspesifikke moduser med talegjenkjenningsevner, må prosessen med enhetsutvinning, opplæring og datainnhenting være svært kuratert og spesifikk.

Mangel på brukbare data

NLP avhenger av begrepene sentimental og språklig analyse av språket, etterfulgt av datainnhenting, rensing, merking og opplæring. Likevel har noen språk ikke mye brukbare data eller historisk kontekst for NLP-løsningene å jobbe rundt med.

Mangel på FoU

NLP-implementering er ikke endimensjonal. I stedet krever det hjelpeteknologier som nevrale nettverk og dyp læring for å utvikle seg til noe banebrytende. Å legge til tilpassede algoritmer til spesifikke NLP-implementeringer er en fin måte å designe tilpassede modeller på - et hack som ofte blir skutt ned på grunn av mangel på tilstrekkelige forsknings- og utviklingsverktøy.

Skala over disse problemene, i dag: Hvordan velge riktig leverandør?

Fra å fikse uklarheter til feil til problemer med datainnsamling, er det viktig å ha den rette leverandøren til din disposisjon for å trene og utvikle den forutsatte NLP-modellen. Og selv om flere faktorer må vurderes, er her noen av de mer ønskelige funksjonene å vurdere når du kobler til:

- Stor, domenespesifikk database (lyd, tale og video), uavhengig av språk.

- Evne til å implementere del-of-speech-tagging for å kutte ut uklarheter.

- Støtte for tilpassede hjelpeteknologier som flerspråklig setningsinnbygging for å forbedre kvaliteten på tolkningen.

- Sømløs datakommentar for å merke datasett i henhold til kravene.

- Flerspråklig database med hyllevarevalg å jobbe med.

Leverandører som tilbyr de fleste eller til og med noen av disse funksjonene kan vurderes for å designe dine NLP-modeller.

Wrap-Up

Det burde være unødvendig å si at NLP har utviklet seg til en av de mer allment aksepterte og hyllede teknologiene som drives av kunstig intelligens. Hvis du er i detaljer, forventes NLP-markedet å vokse med nesten 1400 % innen 2025, sammenlignet med det i 2017. I henhold til forventninger og ekstrapoleringer vil NLP-markedet bli verdsatt til nesten 43 milliarder innen utgangen av 2025 — Statista

Til tross for fordelene, kommer Natural Language Processing med noen få begrensninger - noe du kan ta tak i når du kobler til en pålitelig AI-leverandør.

Vatsal Ghiya, Grunnlegger av Shaip, er en gründer med mer enn 20 års erfaring innen AI-programvare og -tjenester for helsetjenester.

Opprinnelig publisert på https://thinkml.ai den 1. juni 2022.

![]()

Hva er utfordringene med naturlig språkbehandling, og hvordan løses? ble opprinnelig publisert i Chatbots liv på Medium, der folk fortsetter samtalen ved å markere og svare på denne historien.

- Myntsmart. Europas beste Bitcoin og Crypto Exchange.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. FRI TILGANG.

- CryptoHawk. Altcoin Radar. Gratis prøveperiode.

- Source: https://chatbotslife.com/what-are-the-natural-language-processing-challenges-and-how-to-fix-6c1e185dd95?source=rss—-a49517e4c30b—4

- "

- 20 år

- 2022

- a

- nøyaktig

- tvers

- Handling

- Handling

- adresse

- AI

- algoritmer

- tvetydighet

- analyse

- tilnærming

- rundt

- kunstig

- kunstig intelligens

- Assistent

- publikum

- lyd

- være

- Fordeler

- Beyond

- Milliarder

- pauser

- bedrifter

- evner

- stand

- saker

- viss

- utfordringer

- Velg

- samling

- Felles

- Kommunikasjon

- sammenlignet

- kompleksiteten

- forvirring

- Tilkobling

- Vurder

- Samtale

- kuratert

- skikk

- dato

- Database

- dag

- dyp

- utforming

- utforme

- Til tross for

- Bestem

- utvikle

- utvikle

- Utvikling

- utviklingsverktøy

- avvike

- forskjellig

- domene

- ned

- enhet

- Gründer

- utvikle seg

- eksempel

- forventninger

- forventet

- erfaring

- ekstrakter

- faktorer

- Egenskaper

- Endelig

- Først

- passer

- Fix

- etter

- skjema

- Grunnleggeren

- fra

- videre

- genererer

- generasjonen

- god

- flott

- Grow

- hack

- helsetjenester

- hjelpe

- her.

- svært

- historisk

- Hvordan

- Hvordan

- Men

- HTTPS

- menneskelig

- Mennesker

- iverksette

- gjennomføring

- implementere

- viktig

- forbedre

- Intelligens

- Intelligent

- hensikt

- interaktiv

- tolkning

- utstedelse

- saker

- IT

- Etiketten

- merking

- Språk

- språk

- LÆRE

- læring

- maskin

- maskiner

- gjøre

- GJØR AT

- Making

- marked

- betyr

- meningsfylt

- medium

- kunne

- feil

- modell

- modeller

- mer

- mest

- Naturlig

- behov

- nettverk

- tilby

- alternativer

- Annen

- egen

- Ansatte

- perspektiv

- planlegging

- Point

- Synspunkt

- nettopp

- problemer

- prosess

- prosessering

- kvalitet

- relevant

- pålitelig

- Krav

- Krever

- forskning

- forskning og utvikling

- ressurs

- Ressurser

- samme

- Skala

- Søk

- Søkemotorer

- Tjenester

- sett

- flere

- Del

- lignende

- på samme måte

- Software

- Solutions

- noen

- noe

- Snakker

- spesifikk

- fart

- Standard

- Still

- støtte

- Teknisk

- Technologies

- De

- derfor

- tid

- ganger

- i dag

- verktøy

- verktøy

- mot

- Kurs

- forstå

- forståelse

- forstår

- us

- bruke

- verdsatt

- leverandør

- versjon

- video

- Se

- Voice

- weed

- Hva

- om

- mens

- ord

- Arbeid

- ville

- år

- Din