Dziś Amazon Sage Maker ogłosił wsparcie wyszukiwania Grid dla automatyczne dostrajanie modelu, zapewniając użytkownikom dodatkową strategię znajdowania najlepszej konfiguracji hiperparametrów dla Twojego modelu.

Automatyczne dostrajanie modelu Amazon SageMaker znajduje najlepszą wersję modelu, uruchamiając wiele zadań szkoleniowych na zestawie danych za pomocą zasięg hiperparametrów, które określisz. Następnie wybiera wartości hiperparametrów, które skutkują modelem, który działa najlepiej, mierzonym przez a metryczny swojego wyboru.

Aby znaleźć najlepsze wartości hiperparametrów dla Twojego modelu, automatyczne dostrajanie modelu Amazon SageMaker obsługuje wiele strategii, w tym Bayesian (Domyślne) Losowy wyszukiwanie i Hiperpasmo.

Wyszukiwanie w siatce

Wyszukiwanie w siatce wyczerpująco bada konfiguracje w siatce zdefiniowanych przez użytkownika hiperparametrów, co pozwala uzyskać wgląd w najbardziej obiecujące konfiguracje hiperparametrów w siatce i deterministycznie odtwarzać wyniki w różnych cyklach strojenia. Wyszukiwanie siatkowe daje większą pewność, że zbadano całą przestrzeń wyszukiwania hiperparametrów. Ta korzyść wiąże się z kompromisem, ponieważ jest droższa obliczeniowo niż wyszukiwanie Bayesowskie i losowe, jeśli głównym celem jest znalezienie najlepszej konfiguracji hiperparametrów.

Wyszukiwanie siatki za pomocą Amazon SageMaker

W Amazon SageMaker używasz wyszukiwania w siatce, gdy Twój problem wymaga optymalnej kombinacji hiperparametrów, która maksymalizuje lub minimalizuje obiektywną metrykę. Typowym przypadkiem użycia, w którym klient korzysta z funkcji Grid Search, jest sytuacja, w której dokładność i odtwarzalność modelu jest ważniejsza dla Twojej firmy niż koszt szkolenia wymagany do jego uzyskania.

Aby włączyć Grid Search w Amazon SageMaker, ustaw Strategy pole do Grid podczas tworzenia zadania strojenia w następujący sposób:

Ponadto wyszukiwanie według siatki wymaga zdefiniowania przestrzeni wyszukiwania (siatki kartezjańskiej) jako kategorycznego zakresu wartości dyskretnych w definicji stanowiska za pomocą CategoricalParameterRanges klawisz pod ParameterRanges parametr w następujący sposób:

Zauważ, że nie określamy MaxNumberOfTrainingJobs w przypadku wyszukiwania według siatki w definicji stanowiska, ponieważ jest ona określana za Ciebie na podstawie liczby kombinacji kategorii. Korzystając z wyszukiwania losowego i bayesowskiego, należy określić MaxNumberOfTrainingJobs parametr jako sposób kontrolowania kosztu zadania dostrajania poprzez zdefiniowanie górnej granicy obliczeń. W przypadku wyszukiwania według siatki wartość MaxNumberOfTrainingJobs (teraz opcjonalnie) jest automatycznie ustawiana jako liczba kandydatów do wyszukiwania siatki w OpiszHyperParametrTuningJob kształt. Pozwala to na wyczerpujące zbadanie żądanej siatki hiperparametrów. Ponadto definicja zadania wyszukiwania w siatce akceptuje tylko dyskretne zakresy kategorialne i nie wymaga definicji zakresów ciągłych ani całkowitych, ponieważ każda wartość w siatce jest uważana za dyskretną.

Eksperyment z wyszukiwaniem w siatce

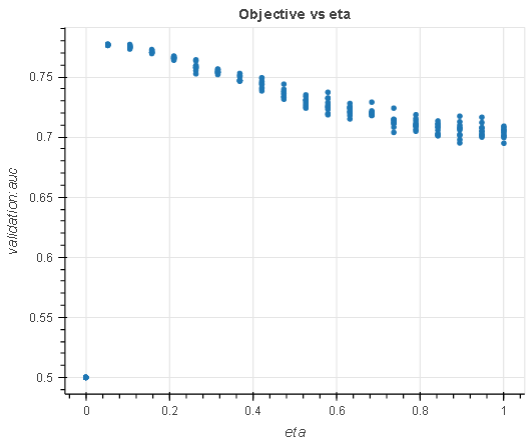

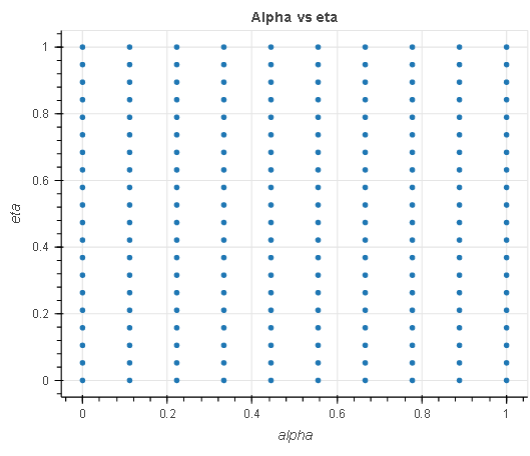

W tym eksperymencie, mając zadanie regresji, szukamy optymalnych hiperparametrów w przestrzeni wyszukiwania 200 hiperparametrów, 20 eta i 10 alpha w zakresie od 0.1 do 1. Używamy zbiór danych marketingu bezpośredniego dostroić model regresji.

- eta: Zmniejszenie rozmiaru kroku używane w aktualizacjach, aby zapobiec nadmiernemu dopasowaniu. Po każdym kroku doładowania możesz bezpośrednio uzyskać wagi nowych funkcji. The

etaparametr faktycznie zmniejsza wagi cech, aby proces wzmacniania był bardziej konserwatywny. - alfa: Termin regularyzacji L1 na wagach. Zwiększenie tej wartości sprawia, że modele są bardziej konserwatywne.

|

|

Wykres po lewej przedstawia analizę eta hiperparametr w odniesieniu do obiektywnej metryki i pokazuje, w jaki sposób wyszukiwanie siatki wyczerpało całą przestrzeń wyszukiwania (siatkę) na osiach X przed zwróceniem najlepszego modelu. Podobnie wykres po prawej analizuje dwa hiperparametry w jednej przestrzeni kartezjańskiej, aby pokazać, że wszystkie punkty w siatce zostały wybrane podczas strojenia.

Powyższy eksperyment pokazuje, że wyczerpujący charakter przeszukiwania sieci gwarantuje optymalny dobór hiperparametrów przy określonej przestrzeni przeszukiwania. Pokazuje również, że możesz odtworzyć wyniki wyszukiwania w kolejnych iteracjach dostrajania, przy czym wszystkie inne rzeczy są takie same.

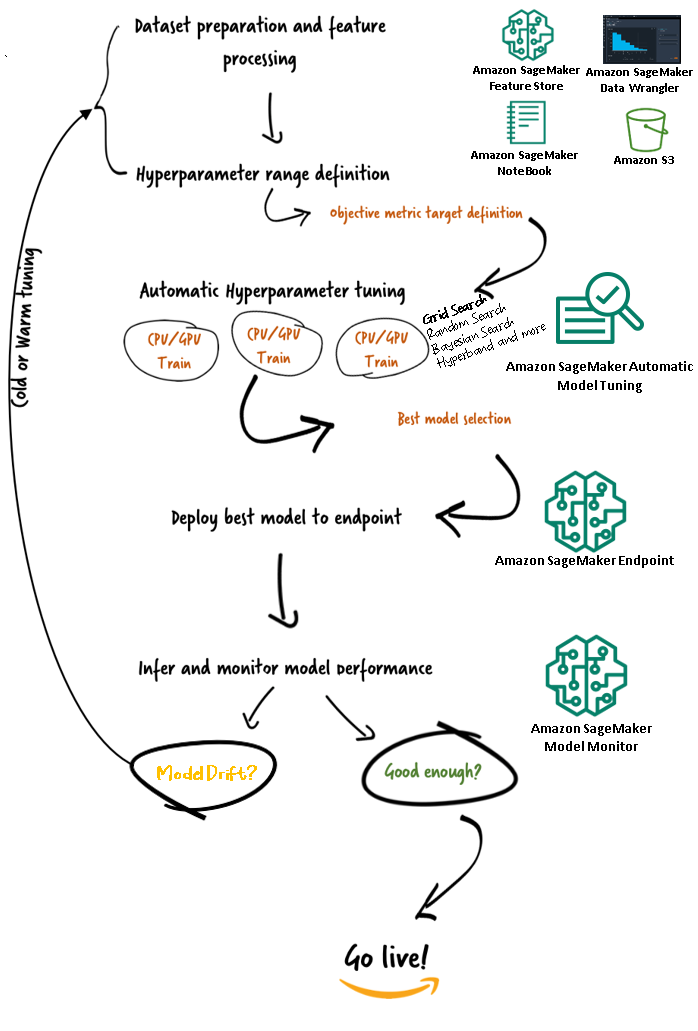

Przepływy pracy automatycznego dostrajania modeli Amazon SageMaker (AMT)

Dzięki automatycznemu dostrajaniu modelu Amazon SageMaker możesz znaleźć najlepszą wersję swojego modelu, uruchamiając zadania szkoleniowe na swoim zestawie danych za pomocą kilku strategii wyszukiwania, takich jak Bayesian, Wyszukiwanie losowe, Wyszukiwanie siatkowe i Hyperband. Automatyczne dostrajanie modelu umożliwia skrócenie czasu dostrajania modelu poprzez automatyczne wyszukiwanie najlepszej konfiguracji hiperparametrów w określonych zakresach hiperparametrów.

Teraz, gdy omówiliśmy zalety korzystania z wyszukiwania w siatce w Amazon SageMaker AMT, przyjrzyjmy się przepływom pracy AMT i zrozumiemy, jak to wszystko pasuje do siebie w SageMaker.

Wnioski

W tym poście omówiliśmy, w jaki sposób można teraz użyć strategii wyszukiwania w siatce, aby znaleźć najlepszy model i jego zdolność do deterministycznego odtwarzania wyników w różnych zadaniach dostrajania. Omówiliśmy kompromis podczas korzystania z wyszukiwania siatkowego w porównaniu z innymi strategiami oraz sposób, w jaki pozwala ono zbadać, które regiony przestrzeni hiperparametrowych są najbardziej obiecujące i deterministycznie odtworzyć wyniki.

Aby dowiedzieć się więcej o automatycznym tuningu modeli, odwiedź Strona produktu i dokumentacja techniczna.

O autorze

Douga Mbaya jest architektem Senior Partner Solution specjalizującym się w danych i analityce. Doug ściśle współpracuje z partnerami AWS, pomagając im integrować dane i rozwiązania analityczne w chmurze.

Douga Mbaya jest architektem Senior Partner Solution specjalizującym się w danych i analityce. Doug ściśle współpracuje z partnerami AWS, pomagając im integrować dane i rozwiązania analityczne w chmurze.

- Zaawansowane (300)

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Amazon Sage Maker

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- zefirnet