Dane użytkowników: Vital Food LLM

Tak! CZ @bryce uwielbiam ten cytat: „Jeśli za to nie płacisz, nie jesteś klientem; jesteś sprzedawanym produktem.” http://bit.ly/93JYCJ

— Tim O'Reilly (@timoreilly) 2 września 2010 r.

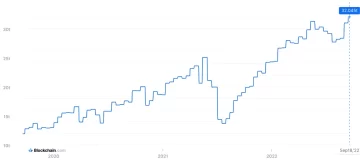

Bądź na bieżąco z wiadomościami o kryptowalutach, otrzymuj codzienne aktualizacje w swojej skrzynce odbiorczej.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :ma

- :Jest

- :nie

- 7

- 8

- a

- zdolność

- bezwzględny

- Stosownie

- dokładny

- adaptacja

- adresowanie

- Dodaje

- zaawansowany

- temu

- Zgadza się

- AI

- Usługi AI

- Systemy SI

- Cele

- Alexa

- Wyrównuje

- Wszystkie kategorie

- pozwala

- również

- zawsze

- Amazonka

- an

- i

- Antropiczny

- przewidywać

- każdy

- odpowiedni

- SĄ

- AS

- założyć

- At

- dostępny

- unikając

- świadomy

- na podstawie

- BE

- bo

- jest

- Uważa

- korzystny

- Ulepsz Swój

- pomiędzy

- by

- CAN

- roszczenia

- klientów

- handlowy

- zobowiązanie

- popełnia

- Firmy

- sukcesy firma

- konkurencyjny

- pojęcie

- Obawy

- stale

- zawartość

- kontekst

- nieustannie

- kontrola

- Wygodny

- rozmowy

- prawo autorskie

- mógłby

- istotny

- Crypto

- Crypto Aktualności

- Aktualny

- klient

- Klientów

- codziennie

- Ciemny

- dane

- prywatność danych

- debata

- lat

- Odszyfruj

- głęboko

- głęboka nauka

- Domyślnie

- Obrona

- dostarczanie

- zależy

- wyrzeczenia

- spory

- Różnorodność

- do

- dokument

- robi

- dolarów

- nie

- podczas

- Zarobek

- krawędź

- skuteczność

- bądź

- zaręczynowy

- wzmocnienie

- zapewnia

- niezbędny

- etyczny

- etyka

- przykład

- wymiana

- doświadczenie

- rozległy

- stopień

- zewnętrzny

- okładzina

- W razie zamówieenia projektu

- Dawny

- Założony

- Darmowy

- od

- zyskuje

- Generować

- wygenerowane

- generuje

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- miejsce

- gigantów

- Dać

- Go

- przyznać

- chwycić

- Rośnie

- ciężko

- uczciwy

- honor

- Jednak

- http

- HTTPS

- człowiek

- ideały

- if

- podnieść

- in

- indywidualny

- Informacja

- intelektualny

- własność intelektualna

- intencje

- Interakcje

- wewnętrzny

- IP

- IT

- JEGO

- samo

- Klawisz

- język

- duży

- firmy

- Prawo

- prowadzić

- UCZYĆ SIĘ

- nauka

- Regulamin

- Dźwignia

- lubić

- Lama

- LLM

- miłość

- robić

- Dokonywanie

- Może..

- Media

- Meta

- miliony

- model

- modele

- jeszcze

- większość

- sieci

- nerwowy

- sieci neuronowe

- Nowości

- aktualności

- uzyskiwanie

- of

- on

- OpenAI

- or

- pozornie

- Inaczej

- ludzkiej,

- na zewnątrz

- Wyjścia

- koniec

- własny

- posiada

- płatny

- strony

- przyjęcie

- wzory

- Zapłacić

- zwracając

- osobisty

- personalizacja

- Personalizowany

- ZDJĘCIA

- plato

- Analiza danych Platona

- PlatoDane

- polityka

- potencjał

- power

- mocny

- praktyki

- przewidzieć

- Przewidywania

- preferencje

- rozpowszechniony

- prywatność

- prywatny

- Wytworzony

- Produkt

- monity

- własność

- zapewniać

- zapewnia

- publiczny

- zaufania publicznego

- publicznie

- zacytować

- Bridgestone

- RE

- Prawdziwy świat

- otrzymuje

- oczyścić

- Uważać

- względny

- zwolnić

- Zgłoszone

- wywołań

- Badacze

- odpowiedzialny

- Ujawnił

- prawa

- rywale

- rt

- Ryan

- s

- powiedzieć

- mówią

- scena

- usługa

- Usługi

- zestaw

- Share

- powinien

- Sceptycyzm

- So

- Obserwuj Nas

- Media społecznościowe

- sprzedany

- Zaklęcie

- Rzecznik

- startup

- Zestawienie sprzedaży

- pobyt

- Ewolucja krok po kroku

- systemy

- Tandem

- tech

- technologiczni giganci

- Techniki

- REGULAMIN

- XNUMX

- że

- Połączenia

- ich

- Im

- Te

- one

- to

- Tim

- do

- już dziś

- Top

- Pociąg

- przeszkolony

- Trening

- Przezroczystość

- Trendy

- Zaufaj

- dla

- zrozumieć

- zrozumienie

- zbliżających

- zaktualizowane

- Nowości

- zmodernizowane

- przesłanych

- posługiwać się

- używany

- Użytkownik

- Użytkownicy

- za pomocą

- Cenny

- różnorodny

- wersja

- Filmy

- istotny

- Głos

- Tom

- była

- we

- były

- jeśli chodzi o komunikację i motywację

- czy

- który

- dlaczego

- będzie

- w

- słowo

- by

- You

- Twój

- zefirnet