Jestem wielkim fanem programu podróżniczego Anthony'ego Bourdaina Części nieznane. W każdym odcinku szef kuchni odwiedza odległe wioski na całym świecie, dokumentując życie, jedzenie i kulturę regionalnych plemion z otwartym sercem i umysłem.

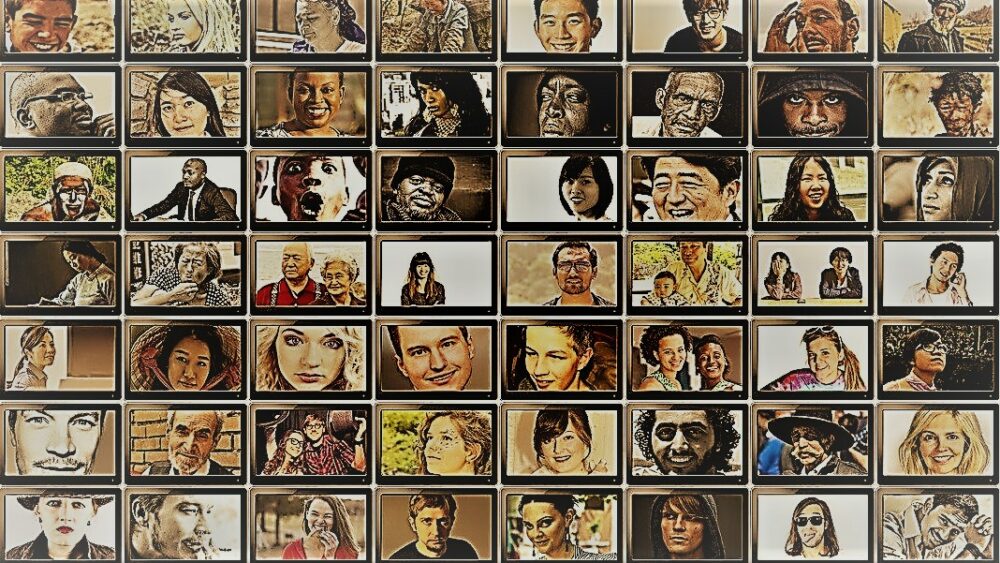

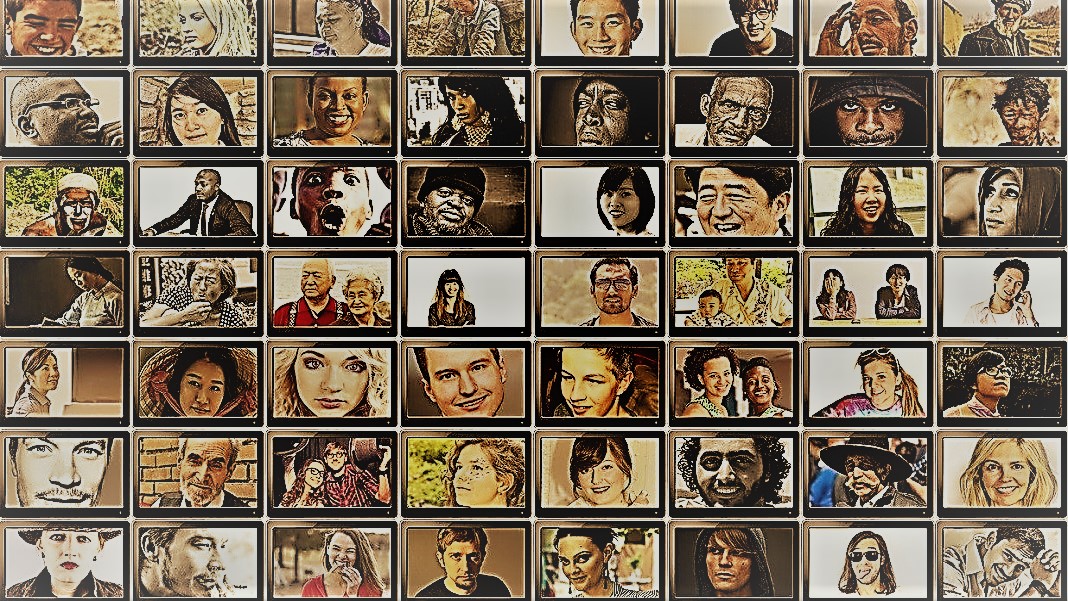

Spektakl daje wgląd w zadziwiającą różnorodność ludzkości. Socjologowie mają podobny cel — zrozumienie zachowania różnych ludzi, grup i kultur — ale stosują różne metody w kontrolowanych sytuacjach. Dla obu gwiazdami tych poszukiwań są podmioty: ludzie.

Ale co by było, gdybyś zastąpił ludzi chatbotami AI?

Pomysł brzmi niedorzecznie. Jednak dzięki pojawieniu się ChatGPT i innych dużych modeli językowych (LLM) naukowcy społeczni flirtują z pomysłem wykorzystania tych narzędzi do szybkiego konstruowania różnych grup „symulowanych ludzi” i przeprowadzania eksperymentów w celu zbadania ich zachowania i wartości jako zastępcy dla ich biologicznych odpowiedników.

Jeśli wyobrażasz sobie cyfrowo odtworzone ludzkie umysły, to nie o to chodzi. Chodzi o to, aby wykorzystać doświadczenie ChatGPT w naśladowaniu ludzkich reakcji. Ponieważ modele zbierają ogromne ilości danych online — blogi, komentarze na YouTube, fanfiction, książki — z łatwością wychwytują relacje między słowami w wielu językach. Te wyrafinowane algorytmy mogą również dekodować zniuansowane aspekty języka, takie jak ironia, sarkazm, metafory i tony emocjonalne, krytyczne aspekty komunikacji międzyludzkiej w każdej kulturze. Te mocne strony sprawiają, że LLM naśladują wiele syntetycznych osobowości o szerokim zakresie przekonań.

Kolejny bonus? W porównaniu z ludzkimi uczestnikami, ChatGPT i inne LLM nie męczą się, umożliwiając naukowcom gromadzenie danych i testowanie teorii dotyczących ludzkich zachowań z niespotykaną szybkością.

Pomysł, choć kontrowersyjny, ma już poparcie. Niedawny artykuł przegląd rodzącej się dziedziny wykazał, że w pewnych starannie zaprojektowanych scenariuszach odpowiedzi ChatGPT korelowały z odpowiedziami około 95 procent uczestników będących ludźmi.

Sztuczna inteligencja „może zmienić zasady gry w badaniach nauk społecznych” powiedziany Dr Igor Grossman z University of Waterloo, który wraz ze współpracownikami niedawno napisał artykuł w nauka. Klucz do użycia Homo krzem w badaniach? Ostrożne zarządzanie stronniczością i wierność danych, powiedział zespół.

Sondowanie ludzkiego umysłu społecznego

Czym dokładnie są nauki społeczne?

Mówiąc prościej, jest to badanie tego, jak ludzie — jako jednostki lub grupy — zachowują się w różnych okolicznościach, jak wchodzą ze sobą w interakcje i jak rozwijają się jako kultura. Jest to parasol zajęć akademickich z wieloma gałęziami: ekonomią, politologią, antropologią i psychologią.

Dyscyplina porusza szeroki zakres tematów widocznych w obecnym zeitgeist. Jaki wpływ mają media społecznościowe na zdrowie psychiczne? Jakie są obecne nastawienia opinii publicznej do zmian klimatu w miarę nasilania się gwałtownych epizodów pogodowych? Jak różne kultury cenią metody komunikacji – i co powoduje nieporozumienia?

Badanie nauk społecznych rozpoczyna się od pytania i hipotezy. Jedno z moich ulubionych: czy kultury inaczej tolerują zapach ciała? (Bez żartów, temat badano całkiem sporo i tak jest różnica!)

Następnie naukowcy używają różnych metod, takich jak kwestionariusze, testy behawioralne, obserwacje i modelowanie, aby przetestować swoje pomysły. Ankiety są szczególnie popularnym narzędziem, ponieważ pytania można ściśle zaprojektować i zweryfikować, a także łatwo dotrzeć do szerokiego grona osób, gdy są rozpowszechniane online. Następnie naukowcy analizują pisemne odpowiedzi i wyciągają wnioski dotyczące ludzkich zachowań. Innymi słowy, użycie języka przez uczestnika ma kluczowe znaczenie dla tych badań.

Jak więc pasuje ChatGPT?

„Homo Silicus”

Dla Grossmana LLM stojące za chatbotami, takimi jak ChatGPT czy Google's Bard, stanowią bezprecedensową okazję do przeprojektowania eksperymentów z nauk społecznych.

Ponieważ są szkoleni na ogromnych zbiorach danych, LLM „mogą reprezentować szeroki wachlarz ludzkich doświadczeń i perspektyw” – powiedzieli autorzy. Ponieważ modelki „wędrują” swobodnie po Internecie bez granic – podobnie jak ludzie, którzy często podróżują za granicę – mogą przyjmować i prezentować szerszy zakres odpowiedzi w porównaniu z rekrutowanymi ludźmi.

ChatGPT nie ulega również wpływom innych uczestników badania ani nie męczy się, co potencjalnie pozwala na generowanie mniej stronniczych odpowiedzi. Te cechy mogą być szczególnie przydatne w „projektach wysokiego ryzyka” — na przykład naśladowaniu reakcji ludzi żyjących w krajach ogarniętych wojną lub trudnych reżimów za pośrednictwem postów w mediach społecznościowych. Z kolei odpowiedzi mogą stanowić podstawę interwencji w świecie rzeczywistym.

Podobnie LLM przeszkolone w zakresie gorących tematów kulturowych, takich jak tożsamość płciowa lub dezinformacja, mogą odtwarzać różne teoretyczne lub ideologiczne szkoły myślenia w celu kształtowania polityki. Zamiast skrupulatnie sondować setki tysięcy ludzkich uczestników, sztuczna inteligencja może szybko generować odpowiedzi na podstawie dyskursu online.

Pomijając potencjalne zastosowania w prawdziwym życiu, LLM mogą również działać jako podmioty cyfrowe, które wchodzą w interakcje z ludzkimi uczestnikami eksperymentów z nauk społecznych, nieco podobnie do postaci niezależnych (NPC) w grach wideo. Na przykład LLM może przyjąć różne „osobowości” i wchodzić w interakcje z wolontariuszami na całym świecie za pomocą tekstu, zadając im to samo pytanie. Ponieważ algorytmy nie śpią, może działać 24 godziny na dobę, 7 dni w tygodniu. Uzyskane w ten sposób dane mogą następnie pomóc naukowcom zbadać, w jaki sposób różne kultury oceniają podobne informacje oraz w jaki sposób rozprzestrzeniają się opinie – i dezinformacja.

Kroki dla dzieci

Pomysł wykorzystania chatbotów zamiast ludzi w badaniach nie jest jeszcze głównym nurtem.

Ale jest wczesny dowód, że to może zadziałać. A badanie przedruku opublikowany w tym miesiącu przez Georgia Tech, Microsoft Research i Olin College odkrył, że LLM replikuje ludzkie reakcje w wielu klasycznych eksperymentach psychologicznych, w tym w niesławnym Eksperymenty szokowe Milgrama.

Pozostaje jednak kluczowe pytanie: jak dobrze te modele mogą naprawdę uchwycić reakcję człowieka?

Istnieje kilka przeszkód.

Pierwszym z nich jest jakość algorytmu i danych treningowych. Większość treści online jest zdominowana przez zaledwie kilka języków. LLM wyszkolony na tych danych mógłby z łatwością naśladować nastroje, perspektywę, a nawet osąd moralny ludzi, którzy używają tych języków – z kolei dziedzicząc stronniczość z danych szkoleniowych.

„Ta reprodukcja stronniczości jest poważnym problemem, ponieważ może spotęgować różnice, które naukowcy społeczni starają się odkryć w swoich badaniach” – powiedział Grossman.

Niektórzy naukowcy martwią się również, że LLM są sprawiedliwe zwracanie co im się mówi. To przeciwieństwo studium nauk społecznych, w którym głównym celem jest uchwycenie ludzkości w całym jej różnorodnym i złożonym pięknie. Z drugiej strony ChatGPT i podobne modele znane są z „halucynacje”, wymyślając informacje, które brzmią wiarygodnie, ale są fałszywe.

Na razie „duże modele językowe opierają się na cieniach ludzkich doświadczeń” — powiedział Grossman. Ponieważ te systemy sztucznej inteligencji są w dużej mierze czarnymi skrzynkami, trudno jest zrozumieć, w jaki sposób i dlaczego generują określone reakcje – trochę niepokojące, gdy używa się ich jako ludzkich pełnomocników w eksperymentach behawioralnych.

Pomimo ograniczeń „LLM pozwalają naukowcom społecznym oderwać się od tradycyjnych metod badawczych i podejść do swojej pracy w innowacyjny sposób” – powiedzieli autorzy. Pierwszym krokiem Homo silicus mógłby być udział w burzy mózgów i szybkim testowaniu hipotez, przy czym obiecujące hipotezy byłyby dalej weryfikowane w populacjach ludzkich.

Jednak aby nauki społeczne mogły naprawdę przyjąć sztuczną inteligencję, konieczna będzie przejrzystość, sprawiedliwość i równy dostęp do tych potężnych systemów. Szkolenie LLM jest trudne i kosztowne, a najnowsze modele coraz częściej zamykają się za potężnymi płatnymi ścianami.

„Musimy upewnić się, że LLM w naukach społecznych, podobnie jak wszystkie modele naukowe, są open-source, co oznacza, że ich algorytmy i najlepiej dane są dostępne dla wszystkich do kontroli, testowania i modyfikowania” powiedziany autor badania dr Dawn Parker z University of Waterloo. „Tylko zachowując przejrzystość i powtarzalność, możemy zapewnić, że badania z zakresu nauk społecznych wspomagane sztuczną inteligencją naprawdę przyczynią się do naszego zrozumienia ludzkich doświadczeń”.

Kredytowych Image: Gerd Altmann / Pixabay

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :ma

- :Jest

- :nie

- $W GÓRĘ

- 23

- a

- O nas

- akademicki

- dostęp

- w poprzek

- działać

- przyjąć

- nadejście

- AI

- algorytm

- Algorytmy

- Wszystkie kategorie

- dopuszczać

- Pozwalać

- już

- również

- kwoty

- an

- w czasie rzeczywistym sprawiają,

- i

- Anthony

- podejście

- SĄ

- Arizona

- Szyk

- artykuł

- AS

- aspekt

- aspekty

- At

- autor

- Autorzy

- dostępny

- na podstawie

- BE

- Uroda

- bo

- być

- zachowanie

- za

- jest

- wierzenia

- pomiędzy

- stronniczość

- stronniczy

- Bit

- Czarny

- Bloki

- ciało

- Bonus

- Granice

- obie

- Skrzynki

- burza mózgów

- gałęzie

- przerwa

- ale

- by

- CAN

- zdobyć

- ostrożny

- pewien

- zmiana

- znaków

- nasze chatboty

- ChatGPT

- okoliczności

- Klimat

- Zmiana klimatu

- koledzy

- zbierać

- Studentki

- komentarze

- Komunikacja

- w porównaniu

- kompleks

- Troska

- skonstruować

- zawartość

- przyczynia się

- kontrolowanych

- kontrowersyjny

- mógłby

- kraje

- kredyt

- krytyczny

- aspekt krytyczny

- kulturalny

- kultura

- Aktualny

- dane

- zbiory danych

- zaprojektowany

- rozwijać

- różne

- trudny

- cyfrowy

- cyfrowo

- Wyświetlacz

- dystrybuowane

- inny

- Różnorodność

- do

- robi

- Nie

- nie

- dr

- rysować

- każdy

- Wcześnie

- z łatwością

- ekonomia

- ogromny

- zapewnić

- epizod

- równy

- szczególnie

- oceniać

- Parzyste

- Każdy

- dokładnie

- przykład

- drogi

- doświadczenie

- Doświadczenia

- eksperymenty

- ekspertyza

- odkryj

- uczciwość

- fałszywy

- wentylator

- Fikcja

- wierność

- pole

- i terminów, a

- dopasować

- żywność

- W razie zamówieenia projektu

- znaleziono

- od

- dalej

- gra

- Games

- Płeć

- Generować

- otrzymać

- Dojrzeć

- globus

- Google'a

- Grupy

- ręka

- garstka

- Have

- Zdrowie

- Serce

- pomoc

- HOT

- W jaki sposób

- HTML

- http

- HTTPS

- olbrzymi

- człowiek

- Ludzkie doświadczenie

- Ludzkość

- Ludzie

- Setki

- pomysł

- idealnie

- pomysły

- tożsamość

- if

- Rezultat

- in

- W innych

- Włącznie z

- Zwiększać

- coraz bardziej

- osób

- niesławny

- pod wpływem

- informować

- Informacja

- Innowacyjny

- spostrzeżenia

- interakcji

- najnowszych

- ironia

- IT

- JEGO

- jpg

- właśnie

- Klawisz

- znany

- język

- Języki

- duży

- w dużej mierze

- mniej

- lubić

- Ograniczenia

- Zyje

- życie

- LLM

- Główny

- Mainstream

- Utrzymywanie

- poważny

- Dokonywanie

- i konserwacjami

- masywny

- Może..

- znaczenie

- Media

- Użytkownicy

- psychika

- Zdrowie psychiczne

- metody

- Microsoft

- nic

- umysły

- Mylna informacja

- modelowanie

- modele

- modyfikować

- Miesiąc

- morał

- większość

- wielokrotność

- musi

- my

- powstający

- Potrzebować

- Nie

- już dziś

- liczny

- of

- często

- on

- ONE

- te

- Online

- koncepcja

- open source

- Okazja

- or

- Inne

- ludzkiej,

- Uczestnicy

- Ludzie

- procent

- Osobistości

- perspektywa

- perspektywy

- plato

- Analiza danych Platona

- PlatoDane

- do przyjęcia

- punkt

- polityka

- polityczny

- Popularny

- populacje

- Wiadomości

- potencjalnie

- mocny

- sonda

- wybitny

- obiecujący

- dowód

- zapewnia

- pełnomocnik

- Psychologia

- publiczny

- pościg

- jakość

- pytanie

- pytania

- zasięg

- szybko

- raczej

- dosięgnąć

- Prawdziwy świat

- naprawdę

- niedawny

- niedawno

- renowacje

- reżimy

- regionalny

- Relacje

- wydany

- polegać

- szczątki

- zdalny

- otrzymuje

- powtarzalność

- replikowane

- reprezentować

- reprodukcja

- Badania naukowe

- odpowiedź

- Odpowiedzi

- wynikły

- w przybliżeniu

- run

- Powiedział

- taki sam

- scenariusze

- Szkoły

- nauka

- NAUKI

- naukowy

- Naukowcy

- sentyment

- zestaw

- kilka

- ciężki

- pokazać

- podobny

- po prostu

- sytuacje

- spać

- Obserwuj Nas

- Media społecznościowe

- Posty w mediach społecznościowych

- społeczne

- nieco

- wyrafinowany

- prędkość

- Gwiazdy

- rozpocznie

- Ewolucja krok po kroku

- silne strony

- starać się

- badania naukowe

- Badanie

- Studiowanie

- potykając

- taki

- wsparcie

- syntetyczny

- systemy

- Sprzęt

- Stuknij

- zespół

- tech

- test

- Testy

- niż

- Podziękowania

- że

- Połączenia

- ich

- Im

- następnie

- teoretyczny

- Tam.

- Te

- one

- to

- tych

- chociaż?

- myśl

- tysiące

- Przez

- zmęczony

- do

- narzędzie

- narzędzia

- tematy

- w kierunku

- tradycyjny

- Pociąg

- przeszkolony

- Trening

- Przezroczystość

- podróżować

- niepokojące

- naprawdę

- SKRĘCAĆ

- parasol

- odkryć

- dla

- zrozumieć

- zrozumienie

- uniwersytet

- bez precedensu

- posługiwać się

- zastosowania

- za pomocą

- zatwierdzony

- wartość

- Wartości

- różnorodność

- Naprawiono

- początku.

- sprawdzone

- Wideo

- gier wideo

- Wizyty

- wolontariuszy

- wojna

- sposoby

- we

- Pogoda

- powitanie

- DOBRZE

- Co

- jeśli chodzi o komunikację i motywację

- który

- KIM

- dlaczego

- szeroki

- Szeroki zasięg

- szerszy

- Wikipedia

- będzie

- w

- bez

- słowa

- Praca

- działa

- martwić się

- napisany

- tak

- jeszcze

- You

- youtube

- Zeitgeist

- zefirnet